图像增强水下自主机器人目标识别研究

2021-12-13郭雨青曾庆军孙啸天许赫威

郭雨青,曾庆军,夏 楠,孙啸天,许赫威

(1.江苏科技大学计算机学院,江苏 镇江 212028; 2.江苏科技大学电子信息学院,江苏 镇江 212028)

0 引 言

自主式水下机器人(autonomous underwater vehicle,AUV)在军民用领域具有广泛的运用,是开发海洋资源的重要工具。AUV不仅机动性好而且巡航范围大,在水下观测、制图、定位和深海探测中具有着重要作用[1]。其中,目标识别与跟踪作为衡量AUV控制性能的重要指标[2],是AUV自主作业的关键技术[3]。在水下目标识别方面,水下图像的质量对高级视觉识别任务有极大的影响,同时对于水下机器人对目标进行避障、抓取等运动规划起着重要决策作用[4]。

目前研究人员多围绕水下图像质量方面对AUV的目标识别开展研究。其中在基于图像融合[5-6]的图像复原方法中,合适的场景深度图是估计背景光和透射图的关键。由于光散射和颜色变化引起的水下图像的模糊效应类似于空气中的雾效应,有学者使用了暗通道先验(DCP)[7]及其变体进行深度估计和恢复。杨淼等[8]提出了一种基于色彩补偿的水下图像综合增强算法,通过色彩补偿和对比度拉伸,HSV空间γ校正和亮度通道去模糊系列方法实现了对水下图像的色彩校正,色彩对比度,饱和度和细节清晰度的综合提高。王昕等[9]利用最大强度先验图对背景光进行了估计,并利用灰度世界理论对R通道进行了校正。也有学者发现以往的估计背景光的方法对各种水下图像的鲁棒性不强,提出了一种基于图像模糊度和光吸收的方法来估计更精确的背景光和场景深度,以精确恢复彩色水下图像。随着人工智能技术的发展与运用,基于深度学习的水下图像增强算法和图像识别网络也应运而生。李爱莲等[10]将空间金字塔池化与ResNet101网络相结合,提出一种基于改进ResNet101网络下渣彩色图像的出钢状态分类识别检测方法。如YU等[11]基于生成式对抗网络的水下图像复原网络,模拟水下成像模型获得一个水下图像数据集;LI等[12]提出了一种基于水下场景先验的水下图像增强卷积神经网络(CNN)模型-UWCNN。直接重建清晰的潜在水下图像。YANG等[13]将神经网络与结合真实水下情况提出新的网络增强方法,使得水下图像增强多了新的可能性。但由于其网络训练需要大量样本及参数,同时也耗费相当多的训练时间,仍有很大的发展空间。

本文提出一种结合ULAP算法与CLAHE算法的图像增强算法与其它几种图像增强或颜色矫正算法进行实验比较,最终将各种增强图像用YOLOv4算法对水下图像数据集进行目标识别评价,实验结果发现,与原图检测相比,本文的增强方法将YOLOv4目标识别准确率(MAP)提高了33%,检测频率为25 Hz。

1 探海Ⅱ型水下自主机器人

本文采用的AUV是自主研发的“探海Ⅱ型”AUV,“探海Ⅱ型”AUV由艏段、电子舱段与艉段组成,其中艏段搭载双目视觉摄像机以供视觉导航使用,水下自主机器人装配视觉系统进行水下自主巡航时,通过视觉系统快速、准确地捕获水下目标物的相关信息,并对信息进行实时处理,将处理结果及时提供给控制系统,由控制系统控制自主式水下机器人抵近目标物并最终到达期望的作业位置。“探海Ⅱ型”AUV结构如图1所示。

图1 “探海Ⅱ型”AUV结构

2 水下图像增强

2.1 水下模型

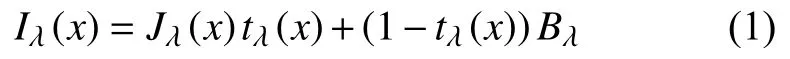

由于复杂的水下环境,水下图像复原具有挑战性,在这种环境中,图像会受到水混浊度和光衰减的影响而退化[14]。与绿光和蓝光相比,波长较长的红光受到的影响最大,因此水下图像呈现蓝绿色。一种图像恢复方法通过考虑光在水介质中传播的基本物理来恢复水下图像。恢复的目的是推导物理模型的参数,然后通过保留补偿处理恢复水下图像。简化成像模型等式如下:

x——水下图像Iλ(x)中的像素点;

Jλ(x)——x点的场景辐射率;

tλ(x)——从水下场景中的x点反射并到达摄像机后的剩余能量比;

Bλ——均匀背景光。

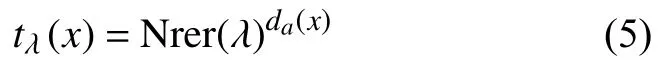

Jλ(x)tλ(x)描述了场景辐射在水中的直接衰减。此外,剩余能量比tλ(x)是 λ和场景-摄像机距离d(x)的函数,它反映了波长在水下距离 d(x)传播的光所遭受的光散射和颜色变化的整体效果。因此,tλ(x)可以表示为:

其中e−β(x)可以表示为归一化剩余能量比Nrer(λ),它是指传播的每单位距离的剩余能量与初始能量的比率。如图2所示,其中绿光和蓝光处理更短的波长和更高的频率,从而衰减得比红色对应光低得多。这就是为什么深海图像呈现普遍的蓝色调,但是浅水图像的表现不明显。

图2 水下光学衰减

2.2 基于ULAP的场景深度模型

水下光衰减先验由于水下场景信息少,恢复模糊的水下图像是计算机视觉中的一项困难任务。但是,人类可以在没有任何辅助信息的情况下快速识别水下图像的场景深度。当进行稳健的背景光估计时,深度图中对应于原始水下图像的最远点通常被认为是背景光候选点。在水下光衰减的情况下,取决于红光能量吸收大于绿光和蓝光能量吸收的波长,利用R光和G-B光的最大强度差来估计背景光。在检查了大量水下图像后,学者发现水下光衰减先验(ULAP),即水下图像的一个像素中的G-B强度(简化为MVGB)的最大值和R强度(简化为VR)的值之间的差异与场景深度的变化密切相关。当场景到达远处时,MVGB增加,虚拟现实减少,这导致场景深度与MVGB和虚拟现实之间的差异正相关。

基于ULAP的场景深度估计,为深度图的估计定义了MVGB和虚拟现实的线性模型,如下所示:

式中:x——像素;

d(x)——点x处的水下场景深度;

m(x)——MVGB;

v(x)——虚拟现实。

背景光通常被估计为水下图像中最亮的像素。然而,这个假设在某些情况下是不正确的,例如前景物体比背景光更亮。从输入水下图像的最远点选择背景光,即对应于输入水下图像的细化深度图中的最大值的位置是背景光候选值。但是直接选择最远的点作为最终的背景光,一些悬浮粒子会打断有效的估计结果。在生成精确的深度图后,首先通过选择0.1%的最远点来去除悬浮粒子的影响,然后选择原始水下图像中强度最高的像素。

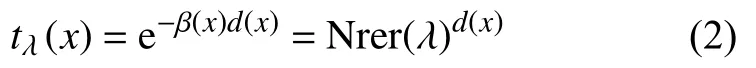

各红蓝通道的传输图估算相对深度图不直接用于估算红蓝通道的最终传输图。为了测量从摄像机到每个场景点的距离,实际的场景深度图da定义如下:

其中D∞是将相对距离转换为实际距离的比例常数,在本文中,D∞设置为10。根据估算的da,可以计算R-G-B通道的TM为:

在大约98%的世界清洁海洋或沿海水域(海洋类型I),Nrer(λ)在红光、绿光和蓝光中的认可范围分别为80%~85%、93%~97%和95%~99%[7]。在这篇文章中,设置R-G-B光的Nrer(λ)分别为0.83,0.95和0.97。

有了R-G-B通道的BLλ和tλ(x),通过等式恢复水下场景的辐射亮度Jλ(x)。tλ(x)的下限和上限根据经验分别设置为0.1和0.9。

2.3 CLAHE理论

通过研究发现,对于水下图像处理,ULAP图像恢复方法可以有效地对不同的水下图像进行去垢和去斑,提高输入图像的细节和色彩,最终生成自然的水下图像。相比何凯明提的出的暗通道先验理论得出了更优的结果,但仍然得不到足够清晰且细节足够突出的图像。因此需要对图像再做增强处理。水下图像采集过程中,由于AUV得双目摄像机感光性能会使得图像产生噪点,所以抑制图像噪点在图像增强过程中也很重要。与传统的自适应直方图均衡(AHE)算法相较而言,图像中有明显较亮或者较暗的地方时,一般的直方图均衡算法就不能描述出将该处的细节信息,CLAHE通过限制局部直方图的高度来限制局部对比度的增强幅度[15],从而将噪声的放大程度限制住。为了将图像细节特征提取出来,但也不能放大其图像噪点,本文采用CLAHE算法进行后续研究。

3 实 验

3.1 数据集准备

本文数据集组成:

1)其中Rockfish来源于美国太平洋海岸收集的岩鱼和扁平鱼。其图片背景色丰富有利于观察图像增强方法中颜色矫正的部分,填充红色背景少的数据集。偏红偏白的图像用于本文图像增强算法研究。

2)UIEBD数据集[16],跨越不同的场景/主要对象类别,包括珊瑚(例如,流苏礁石和巴里尔群),海洋生物(例如乌龟和鲨鱼)等。有着丰富的水下图片库,其中选取了偏蓝色和偏绿色的图像用于本文图像增强算法研究。

3)RUIE数据集[17],该数据集采集于真实海洋环境评测平台,包括海胆,海参,扇贝图片以及其各自在图片中的位置坐标,总共采用了其UTTS中的300张图片,其中训练集270张,测试集30张,主要用于YOLOv4网络[18]的模型训练。

3.2 图像增强效果对比

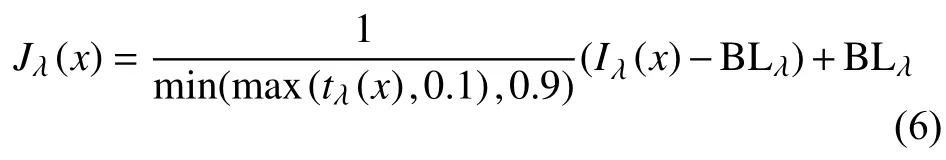

本节对比了水下暗通道算法UDCP和其他图像增强方法对偏蓝、偏绿、偏黄、偏红近岸浅滩和低对比度水下图像的处理结果。

数据集来源于UIEBD(an underwater image enhancement benchmark dataset and beyond)数据集和Rockfish中底色偏红偏白的图像做出对比,选取的比较方法主要包括:文献[19]、文献[20]、文献[21]、文献[22]、文献[23]中的方法。

图3(a)显示了5幅原始水下图像,根据水下图像数据集的色调和场景,它们具有不同的水下特征。图3(b)显示,UDCP未能恢复水下图像的场景,甚至带来色彩失真和误差恢复。图3(e)、图3(f)在图像去雾的方面效果相比较与其它效果较好,但是图3(e)偏色比较严重,在处理图片的时候,有明显的红色过补偿现象,并且图像整体偏暗了。而且图3(f)有轻微的偏色,但是其在偏蓝的图像上,表现出严重的颗粒感,图像质量不高。但在偏绿色的人物背景图,能较好矫正去除其背景绿色。图3(c)、图3(d)在偏蓝色和偏绿色的图片增强效果不错,但是在背景色红色部分较多的时候图3(c)对于红色矫正过多,导致图片红色偏重,图3(d)就出现了蓝色偏现象。在白色浅滩背景下图3(d)还出现了偏绿现象,并且黑暗区域扩张。本文方法在对于低对比度的图片有效增强并提高图像清晰度,在对各种偏色图像中的处理中,保持了图像的整体亮度和细节,没有严重的颜色失真问题,并且也能获得较好的图像质量,本文图像恢复方法可以有效地对不同的水下图像进行去垢和去斑提高输入图像的细节和色彩,最终生成自然的水下图像。再对比各个算法对以上5张图片的执行速度如表1所示。

表1 图像增强算法耗时 s

图3 水下图像增强结果对比

本文算法的速度相比较于其它算法的运行速度也是最快的,这对于需要对大量图片进行处理训练的目标检测与识别算法来说,是一项显著的优势,适用于水下机器人实时识别。

3.3 目标检测效果对比

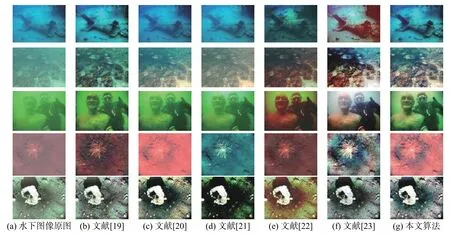

水下图像增强的目的不仅是为了主观视觉质量的改进,更主要的是为了能够完成更高级别的视觉分析任务(例如目标识别和检测)。本文通过目标检测网络模型对经过6种算法增强后的水下图像数据集进行训练与测试,对比了MAP和检测到目标数量来评估各个增强算法对于水下目标识别和检测任务中的作用。为了验证算法是否有效,本文在Windows10、CUDA10.0、CUDNN7.6.5进行训练。训练使用的服务器配置是Intel(R)Core(TM)i7-7700HQ CPU @ 2.80 GHz,利用RUIE数据集。该数据集不仅仅拥有大的数据量、多样的光散射效应程度,而且有丰富的色调和检测目标,对于衡量水下图像增强算法的性能有多个参考角度,如可见度,色偏等。而且,它提供的水下生物标注图像十分便于进行水下目标检测算法的训练和测试。RUIE数据集是国内第一个专门为多角度算法评估设计集合的大型水下真实图像数据库,为促进图像增强与复原及相关的高级水下视觉任务的相关理论、技术及应用的发展、提升相关研究水平做出了重要贡献[18]。采用YOLOv4的方法进行目标检测,检测结果如图4所示。

图4 部分测试集中水下图像增强后的目标检测结果

本文采用精确率-召回率曲线变化情况以及MAP作为评价指标来衡量模型的检测性能。从表2可以看出,以上几种方法对于水下图像复原与颜色矫正上,有利于提高目标检测的准确率,其中从文献[23]的检测结果就可以看出,颜色矫正过于严重的算法也不利于目标检测,纵向比较,文献[21]和文献[23]中第一张偏暗的图像,对于海参这种与海底环境较为相似的目标识别漏了。选取的图像中亮度较强的图像检测效果也更好,图像的对比度提高对目标识别也有显著的效果,而本文由于采用ULAP与CLAHE算法相结合,有大量训练估计深度的情况下,能够获得更清晰自然的图像,加之利用噪声较小的CLAHE算法提升图像对比度,获得了较好的目标检测效果,与其它方法比较,本文算法对海胆、海参、扇贝包括一些边角的小目标形状,识别效果较好。

表2 目标识别准确率 %

4 结束语

由于水下图像存在模糊和色偏等图像质量问题对水下目标识别造成了极大的困扰,本文提出了一种水下图像增强算法。该算法基于水下光衰减先验(ULAP)的快速有效的水下图像场景深度估计模型,并且根据其学习训练得出的模型系数得到正确的深度图,估计背景光和透射图,以恢复水下的真实场景辐射。针对恢复图像对比度欠佳的情况,本文又基于CLAHE算法提升了图像对比度,使图像进一步清晰化,达到了水下图像增强的目的。通过与UDCP等其它文献中的图像增强算法进行比较分析,表明本文算法能够实现较好的水下图像质量增强效果,得到的图像整体效果更好。最后,通过YOLOv4方法来实现目标识别任务,实验表明本文的增强方法能够有效实现对水下彩色图像进行目标识别的任务,比其原图进行识别的平均精度提高了33%,可以运用到水下自主机器人上进行目标识别,为进一步研发水下自主机器人视觉任务奠定基础。