基于Faster R-CNN的大田玉米雄穗识别及抽穗期判定研究

2021-12-04张小青樊江川郭新宇赵春江

张小青,樊江川,郭新宇,赵春江,3,*

基于Faster R-CNN的大田玉米雄穗识别及抽穗期判定研究

张小青1,2,樊江川2,3,郭新宇2,3,赵春江1,2,3,*

(1. 上海海洋大学信息学院,上海 201306;2. 北京农业信息技术研究中心,北京 100097;3. 国家农业信息化工程技术研究中心,数字植物北京市重点实验室,北京 100097)

目前田间玉米雄穗数量监测主要依靠人工进行,效率低且易出错。为了实现在复杂的田间环境下对玉米雄穗自动识别和计数的任务,使用无人机平台和田间作物表型高通量获取平台采集的田间玉米顶视图像构建数据集,使用Resnet 50作为新的特征提取网络代替原始的VGG 16来优化Faster R-CNN模型。再根据表型平台所获取的高时序、连续图像,进一步使用改进后的模型对试验小区内玉米抽穗期前后20 d的雄穗数量进行监测,以此为依据进行抽穗期判定。该方法在田间作物表型高通量平台获取的图像数据测试集中类平均精度为90.14%,平均绝对误差为4.732 8;在无人机平台获取的图像数据测试集中类平均精度为82.14%,平均绝对误差为9.694 8。试验结果表明:该模型在田间作物表型高通量获取平台上的检测结果优于无人机平台,且具备一定的应用价值。

大田玉米;雄穗检测;计数;Faster R-CNN;抽穗期判定

玉米作为世界主要粮食作物之一,其稳定生产是世界粮食安全的关键任务。快速、无损并准确地获取大面积玉米产量数据,能够为当前农业决策管理及生产提供有效的数据和技术支撑[1]。玉米雄穗是玉米育种过程中的重要农艺性状,是指示玉米生长阶段的典型标志。国内外已有大量研究揭示了雄穗性状与高产的关系。例如,Shekoofa等的研究指出玉米雄穗性状特征是改善田间耕作以及提高产量的重要线索,其数量与产量呈正相关关系[2]。因此对玉米雄穗进行准确地识别和计数,是玉米产量预测的前提。

目前,田间玉米雄穗数量监测主要依靠人工进行。但人工测量具有主观、繁琐、易出错和效率低等特点。因此,传统的方法不能满足大规模精准农业中作物性状的广泛定量分析。近年来,计算机视觉技术在精准农业领域的应用越来越广泛,亦取得了较好的成绩,涉及到的方面有作物分割[3]、作物检测[4]和作物计数[5]。其中,基于图像的方法可以通过非接触的方式获取整个场地的信息,从而减少人工测量所面临的环境风险。同时,设备成本相对较低,观测的连续性得到保证,更有利于从时间序列上进行时空分析[6]。

然而,在农业和计算机视觉领域,基于图像的玉米穗检测和计数方面的研究相对较少。研究者采用基于HSI颜色空间分割结合形态学中区域生长的方式实现了玉米雄穗的检测[7];也有学者尝试将提取潜在的雄穗区域和消除假阳性相结合的方法来解决雄穗检测问题[8];而在其他研究中,采用了方向特征对象检测框架实现了玉米雄穗的识别,并通过时间序列分析进一步获得了抽穗阶段的信息[9]。Lu等提出了一种名为TasselNet的卷积神经网络,使用高分辨率相机拍摄的可见光图像构建新的数据集MTC,通过局部回归网络实现了玉米雄穗的计数[10]。分析当前研究,各类方法虽可以用来表征总穗数的性状,但由于品种、图像获取方式和光照条件的变化以及背景的复杂性,准确度并不高。

基于空间颜色分布的方法可以检测出与背景有较大颜色差异的物体[11],但由于田间环境下图像观测面临更多挑战[12],基于颜色分布的方法在田间图像中的处理效果并不理想。首先,刚萌发的雄穗与玉米叶片颜色基本相同,几乎无法采用基于阈值的方法实现区分;其次,由于图像采集平台需要覆盖足够的面积以收集大量的样本。因此,图像中的雄穗可能只占整个图像中的一小部分像素,在低空间分辨率下的图像中检测雄穗仍具有挑战;另外,图像颜色随光照等自然条件的变化显著;最后,图像中除作物外还存在一些其他背景的干扰,如土壤、阴影或稻草等。因此,需要一种既能适应不同光照条件又能适应复杂环境的新型雄穗检测算法。

根据已有研究面临的问题,本研究探讨了基于深度学习技术的田间玉米雄穗自动检测计数方法和抽穗期判定的可行性。以田间作物表型高通量采集平台[13](plant high-throughput phenotypic platform,HTTP)和无人机为数据获取平台,进行时序可见光图像的采集,提出一种利用卷积神经网络对玉米雄穗识别及计数并进一步判定玉米抽穗期的方法。通过Faster R-CNN训练玉米雄穗识别模型,并依据单行玉米植株抽雄比例判定玉米的抽穗期。该方法能够实现在复杂的背景下玉米雄穗的准确识别和计数,结合有效的抽穗期判定,有助于农业管理和产量估算,同时为农业机器人提供有用的信息反馈。

1 材料与方法

1.1 图像采集

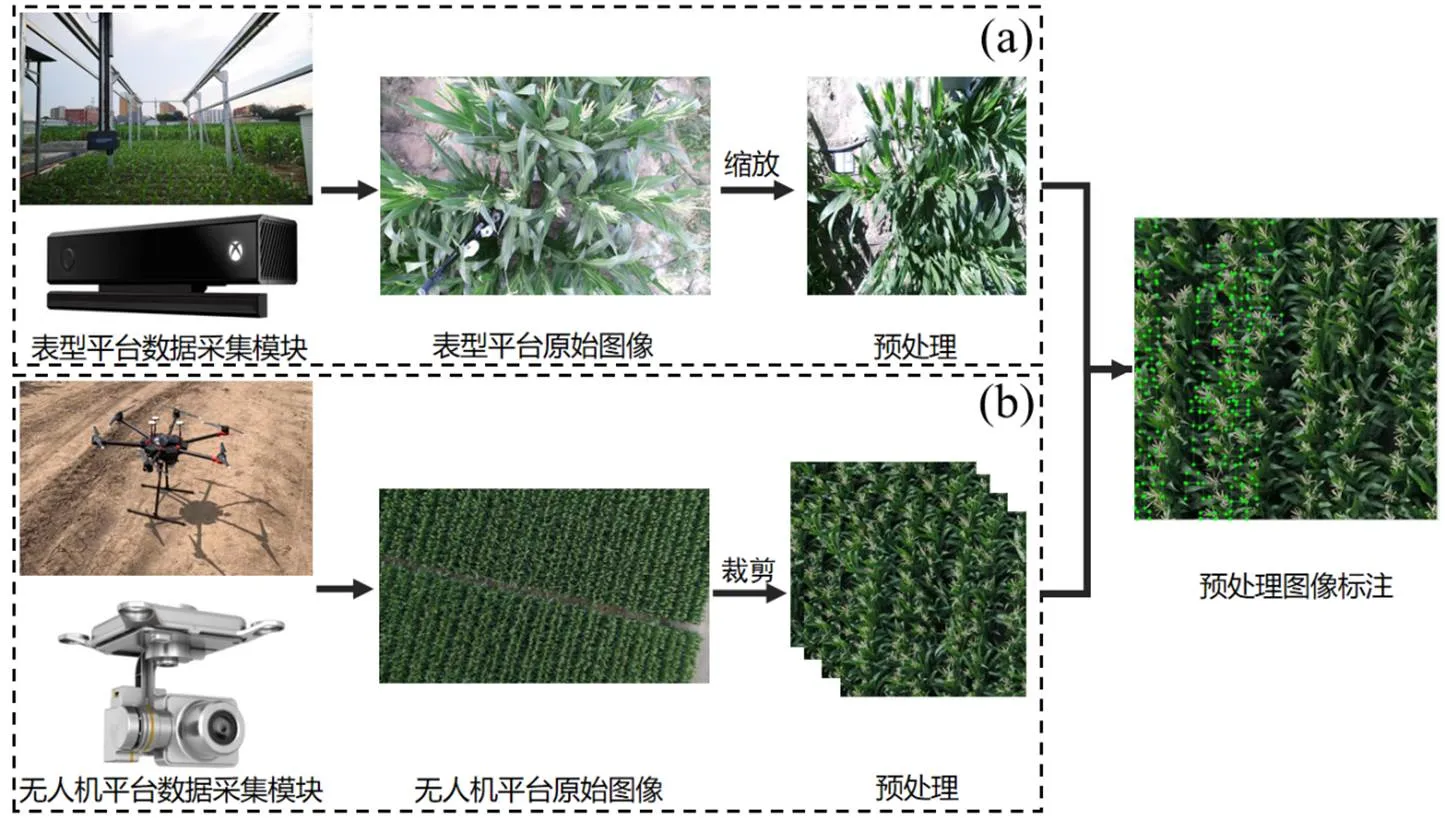

本研究使用的图像数据包括田间作物高通量表型平台和无人机搭载可见光传感器所获取的田间玉米顶视图像。因此,图像采集试验分为两个部分,其中试验一部分使用田间作物表型平台进行图像获取,试验二使用无人机平台进行图像获取。

1.1.1 基于田间作物表型高通量获取平台的图像数据采集 在北京市农林科学院试验田内开展(39°56′ N,116°16′ E)。试验一地块(长15 m,宽6 m)上方搭建了数字植物北京市重点实验室自主研发的田间轨道式作物表型高通量获取平台图1(a)为田间表型平台图像采集装置的示意图。在田间轨道式表型平台的覆盖范围内种植了AD268、MC670、JNK2010、JNK728等13个玉米品种,每个品种一行,行长1.5 m。播种日期为2019年6月21日,种植行距为60 cm,种植后以正常水肥管理。使用Kinect 2.0 (Microsoft,Kinect V2.0)作为成像单元图像采集设备,设备有效像素500万,图像的分辨率为1 920×1 080像素。在本次试验中,采用自动曝光模式进行数据采集,镜头垂直向下,获取玉米冠层图像。试验从2019年8月15日起到2019年9月22日止,选择每天上午9:00、下午15:00两个时间点分别进行图像采集,获取小区内玉米的可见光图像。

1.1.2 基于无人机平台的图像数据采集 试验二在吉林省公主岭市中国农科院公主岭试验基地开展(43°11′ N~44°09′ N,124°02′ E~125°18′ E)。使用六旋翼小型电动无人机(大疆,M600 PRO)作为低空遥感平台,考虑到地面的分辨率和无人机的续航能力,将飞行高度设置为30 m,航向重叠度为70%,旁向重叠度为65%。在无人机上安装型号为SONY-5100(定制20 mm机械镜头)的相机对大田玉米进行可见光图像采集。本次试验的图像采集时间从2018年7月21日(抽雄期)起到2018年8月25日止,分别选择晴天和阴天且无风或者微风的天气,在上午10:00到下午14:00期间进行一次大田玉米冠层无人机数据的获取。所获取的无人机可见光图像的分辨率为5 280×3 956像素。图1(b)为无人机平台图像采集装置的示意图。

1.2 图像预处理

试验二中所获取的无人机可见光原始图像的分辨率为5 280×3 956像素,为了提高模型后期训练的效率和精度,将其裁剪为960×960像素大小。之所以选择试验区样本大小为960×960是因为无人机平台采集图像时距离玉米冠层较远,图像中存储的信息较多即图像中的玉米雄穗过于密集,如果选择过大的样本区域会造成样本标记时的困难。而试验一中田间作物表型高通量平台获取图像时成像设备距离玉米冠层1.5 m,所获取图像中包含目标大约20至30个,即图像中玉米雄穗不会过于密集,为了对两类平台获取数据的精度进行比较,故选择缩放的方式将其图像大小统一至960×960像素。

使用图像注释工具LabelImg对裁剪及缩放后的图像进行雄穗边界框标注,通过最小外接矩形将样本中的雄穗标出,记录该矩形的左上、右下的顶点坐标并设置类别标签为tassel。图1展示了数据采集到标注的整体流程。

图1 数据采集及预处理示意图

Figure 1 Schematic diagram of data acquisition and preprocessing

Figure 2 RGB images and their annotated images under different lighting conditions

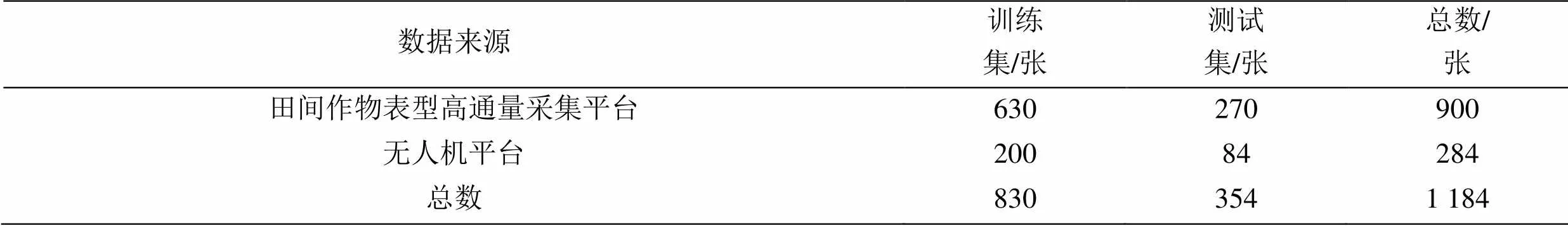

1.3 数据集构建

为了保证不同光照条件下模型的泛化性能,本研究所有数据集分别选取晴天和阴天的图像构成数据集进行模型训练。其中,田间表型平台数据集包括玉米抽雄后晴天和阴天的图像数据各450张,按照7∶3划分为训练集和测试集,即训练集共630张,测试集共270张;无人机平台获取的图像数据同样选取不同光照条件下(晴天、阴天)的图像。考虑到图像的质量,手动剔除了一些由于曝光或玉米雄穗之间相互遮挡过多等质量较低的图像,最终的数据集共284张,将数据集按照7∶3划分为训练集和测试集。图2中展示了不同光照条件下的可见光图像以及其标注图像。(a)为不同光照条件表型平台获取的图像及其标注,(b)为不同光照条件无人机平台获取的图像及其标注。整体的数据集组成如表1所示。

表1 整体数据集组成情况

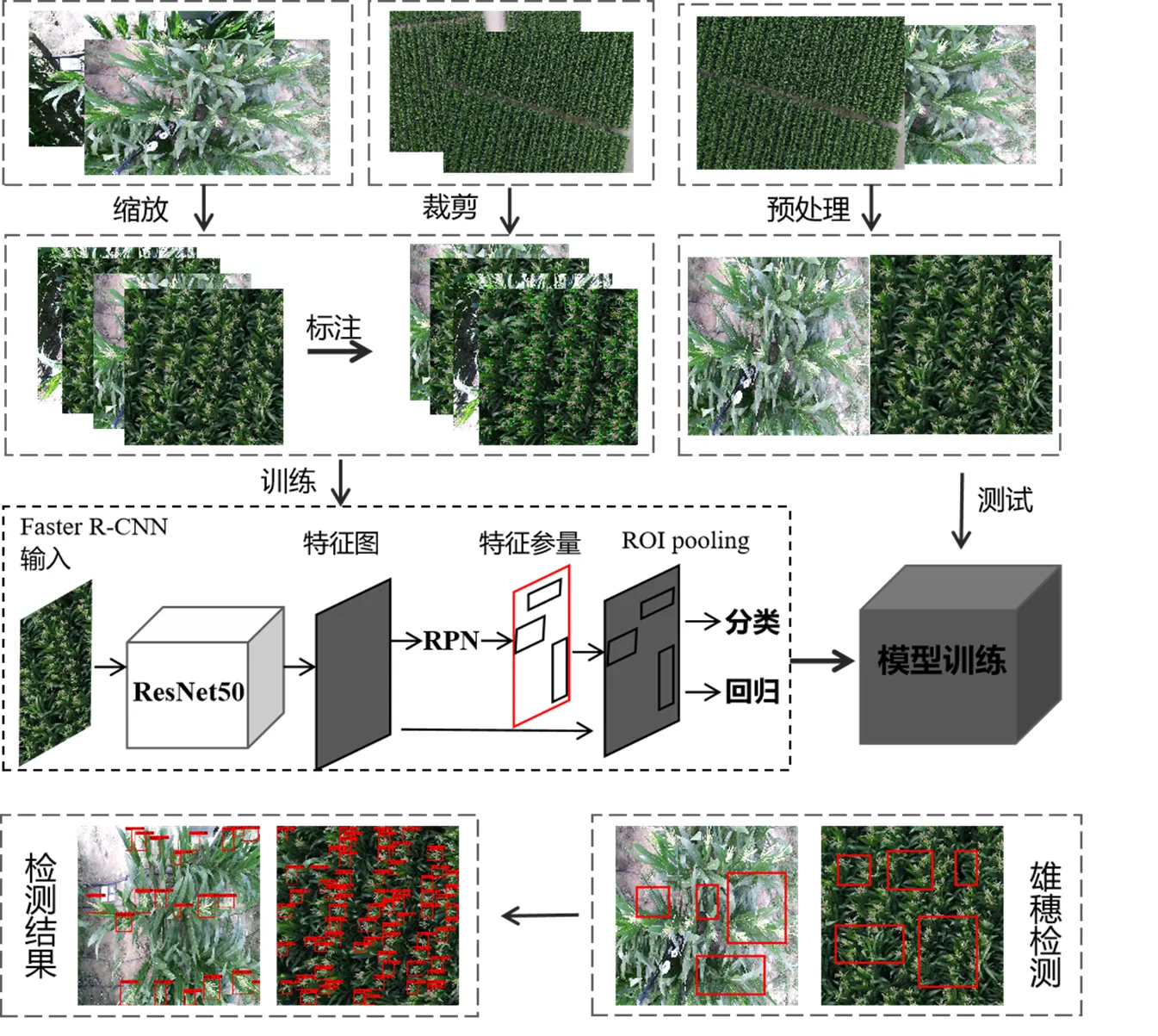

1.4 雄穗识别网络

1.4.1 Faster R-CNN模型框架 本研究用于田间玉米顶视图像中雄穗检测的深度学习网络构建思路来自于Faster R-CNN网络。Faster R-CNN是Ren等[14]在2015年提出的一种目标检测算法,该算法自提出以来已经在许多领域得到了广泛的应用。

原始的Faster R-CNN网络采用VGG 16作为特征提取网络,本研究中考虑大田环境复杂性以及户外光照不均匀等问题的存在,直接使用传统的Faster R-CNN模型难以实现准确的识别和计数。如果直接加深网络的深度会存在梯度消失以及梯度爆炸等问题,从而导致模型训练难度的增加;如果引入批归一化层(batch normalization)则会导致“退化问题”,表现为网络层数增加,但是在训练集上的准确率饱和甚至下降[15]。因此,本研究以Resnet50替换VGG16特征提取网络,形成改进的Faster R-CNN目标检测框架,进行玉米雄穗的识别和计数。基于改进的Faster R-CNN框架的玉米雄穗的检测过程如下:

使用特征提取网络Resnet 50对输入模型中的图像进行特征提取,所提取的特征图分别被用于RPN层和池化层;

RPN网络作为第一部分用来生成候选框,通过激活函数softmax判断anchors属于前景或者背景即判断是否包含雄穗;

利用边界框回归来修正anchors或者相对准确的候选框,且ROI Pooling层作为第二部分把RPN网络生成的候选框resize到相同尺寸送入全连接层;

经过全连接层,利用分类函数计算出候选框的类别即是否为雄穗,同时再次对边界框进行回归得到可见光图像中玉米雄穗的精确位置。改进后的Faster R-CNN网络的整个检测过程如图3所示。

图3 Faster R-CNN网络检测过程

Figure 3 Detection process of Faster R-CNN

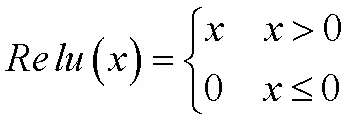

1.4.2 主要函数 本研究中网络训练时选取修正线性单元(rectified linear unit,ReLu)作为激活函数,当输入值为负时,ReLu函数[16]的输出值恒为0;当输入值为正时,ReLu函数的值与输入值相等,即:

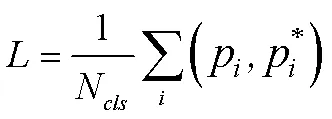

本研究模型的损失函数主要由两部分组成,其中第一部分是分类损失[14],其具体公式如下:

式中P为第个检测框的预测值,当预测值与标注区域的重叠区域大于0.7时P=1,当预测值与标注区域的重叠区域小于0.3时P=0,N表示网络训练过程中生成的256个检测框。

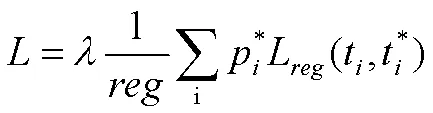

第二部分是回归损失,用于确定网络训练过程中的偏移量,其具体公式为:

式中t表示训练阶段预测值的便宜量,t表示训练阶段相对于实际的偏移量,是平衡回归损失和分类损失的参数。

1.4.3 网络训练及参数设置 在机器学习中需要有大量的已标注样本和相互独立且具有相同分布的训练集和测试集数据才能训练出一个泛化性很好的模型。对于本研究中的小样本图像数据集,选择迁移学习的方法来对Faster R-CNN模型进行训练。迁移学习是通过从已经学习的相关任务中迁移其知识来进一步提高新的任务,而不需要从零开始学习[16]。在神经网络模型中,卷积层在模型中的深度决定了其所提取的特征是否具有通用性,模型中更靠近顶部的卷积层提取的是类别轮廓、形状等抽象的特征,而更靠近模型底部的卷积层提取的是颜色、纹理等局部的、通用的特征信息。根据以上分析,本研究选择在大型图像数据集VOC 2007上训练好的ResNet 50模型参数来初始化修改后的ResNet 50网络,再在本研究所获取的两种可见光数据集中继续训练顶层卷积网络,使其能更好地适应在田间环境下识别玉米雄穗的任务。

模型的训练是在处理器为Intel(R) Xeon(R) CPU E5-2683 v3,内存大小为128 GB,显卡为两块GTX 1070Ti,显存为8GB的硬件平台上完成的。在Windows 10操作系统下进行环境配置,cuDNN的版本是7.4,CUDA的版本是10.0,TensorFlow的版本是1.13.2。选择随机梯度下降法(Stochastic Gradient Descent, SGD)来更新学习率从而对网络进行训练。训练时将初始学习率设置为1×10-4,迭代20次后通过人为设定使学习率更改为1×10-5。网络训练时epoch 值设置为1 500,步长为200,batchsize值为6。

1.5 评价指标

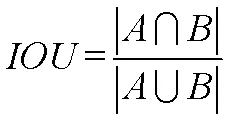

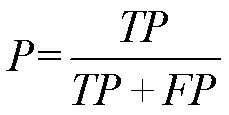

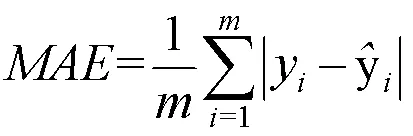

对训练结束之后的模型进行性能判断,对于分类模型通常采用交并比(intersection over union,IOU)、类平均精度(mean average precision,mAP)作为评价指标[17],而平均绝对误差(mean absolute error, MAE)通常被用来评价计数模型的性能[18]。本研究采用以上3个评价指标来对模型的检测计数性能进行客观的评估。所涉及的公式如下:

式中A表示预测出的ROI检测框,B表示人工标注的ROI检测框。

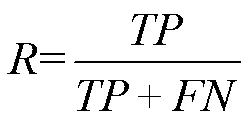

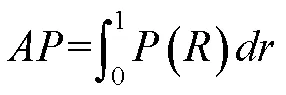

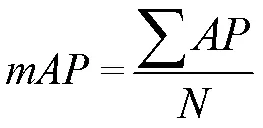

式中true positive (TP)表示正阳性,false positive (FP)表示假阳性,false negative (FN)表示假阴性,true negative (TN)表示正阴性。而Precision (P)和Recall (R)分别表示精确度和召回率。

式中N表示目标检测中所有的类别个数,本研究中N=1。

本研究中,交并比是指模型预测的边界框和真实的边界框的交集和并集的比值;平均绝对误差即绝对误差的平均值,能更好地反映预测值误差的实际情况,平均绝对误差越小,则说明模型的训练效果越好。

1.6 抽穗期判定方法

根据农学领域定义,相同种植条件下,同一品种玉米抽穗数量超过总数的一半即可定义该品种玉米进入抽穗期[19]。以此为依据,通过文章提出的改进的Faster R-CNN框架,对抽雄前后共20 d的图像进行了雄穗的检测识别,并依据雄穗数量进行不同品种玉米抽穗期的判断。

2 结果与分析

2.1 模型训练结果

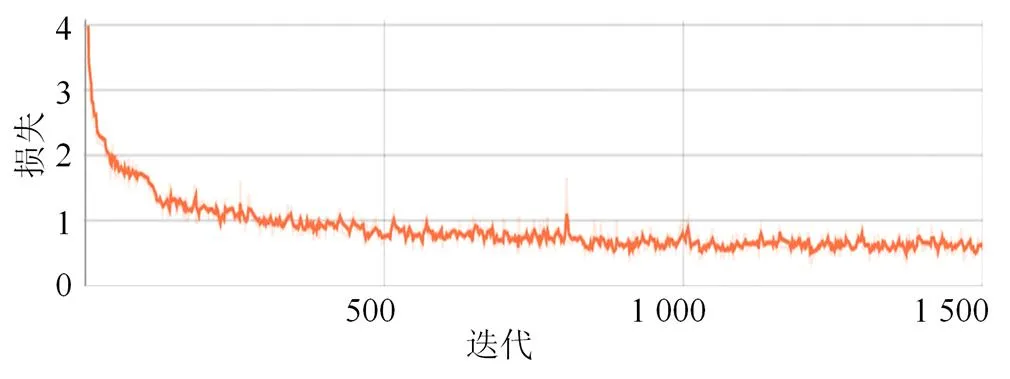

用构建的训练集对本模型进行迭代训练,图4为本研究中优化后模型的训练曲线图,模型在迭代200次之后曲线开始趋于平缓,模型在迭代1 500次后停止。

为了与原始的以VGG 16为特征提取网络的Faster R-CNN模型做对比,用本研究中构建的训练集以同样的参数设置对原始模型进行迭代训练。下图分别为两种模型对不同平台下所获取的可见光图像的预测效果图,其中,图5(a)为表型平台不同光照条件下检测效果图,图5(b)为无人机不同光照条件下检测效果图。

图4 优化后模型的训练损失

Figure 4 Loss value of the improved model

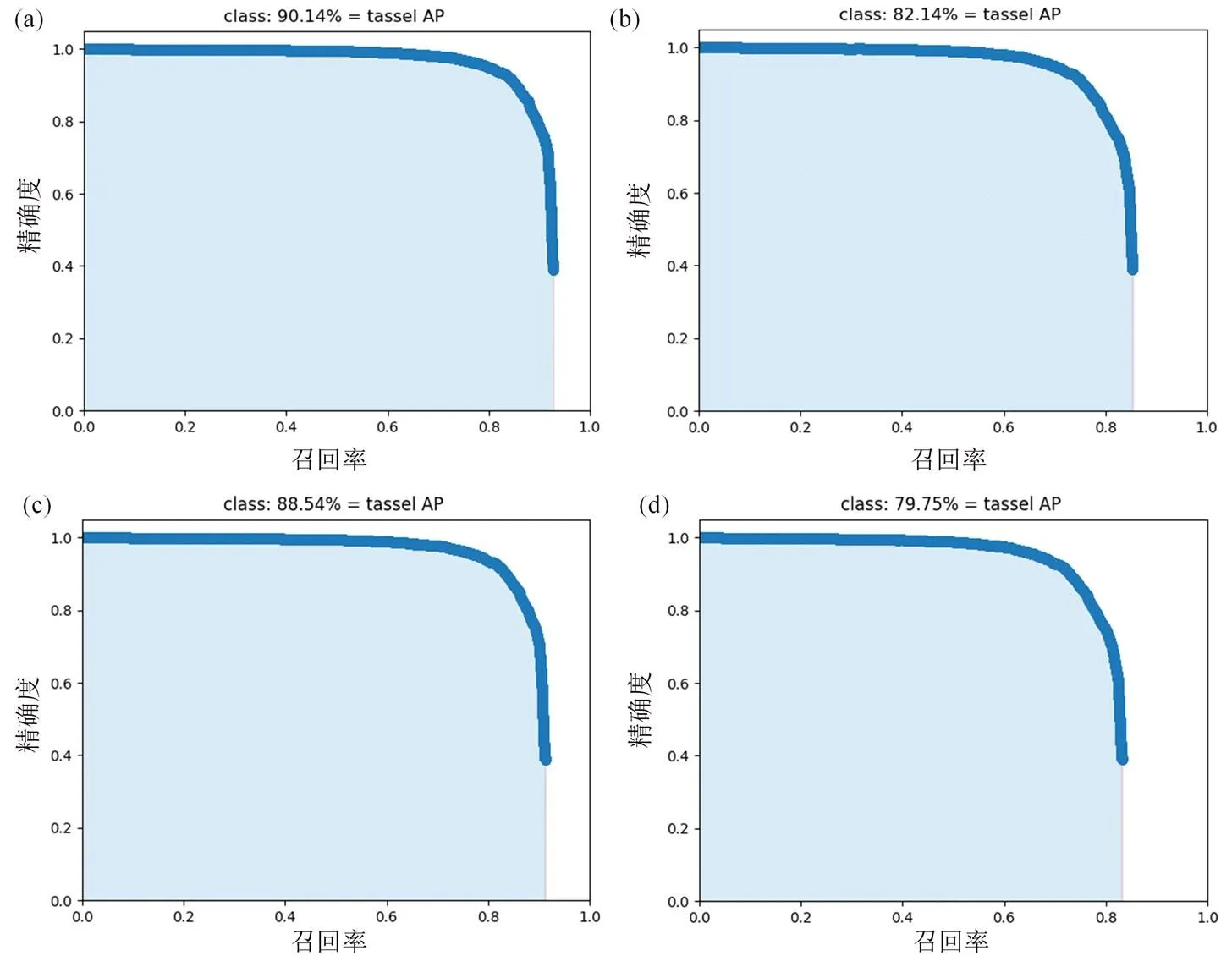

从图5(a)中可以看出,两种模型对于表型平台可见光图像的预测效果几乎没有太大差异,都能够在不同的光照条件下准确识别出完整的玉米雄穗,而且对于图像边缘的雄穗也可以准确检测出来。而图5(b)能够反映出,本研究中改进后的Faster R-CNN模型对于无人机可见光的预测效果更好。再结合图5(a)(b)可以看出,两种模型对于表型平台图像的检测效果相对于无人机图像而言都更好。根据1.5小节中叙述的评价指标分别输出两种模型对表型平台图像和无人机图像的测试集检测结果并进行分析,具体分析结果如表2所示。

Figure 5 Comparison of the detection results of the two models

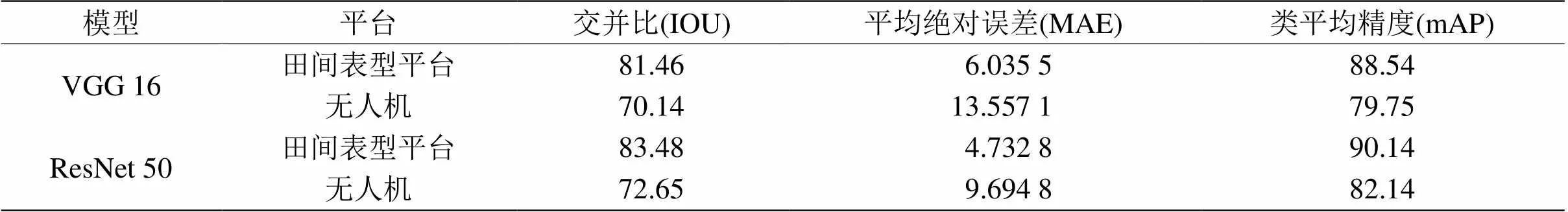

进一步输出两个模型分别在表型平台和无人机平台测试集上的P-R曲线图,如图6所示。结合表2和图6可以看出,本研究中改进后的Faster R-CNN模型能更好地适应在田间环境下对玉米雄穗进行检测和计数的任务。

2.2 抽穗期判定

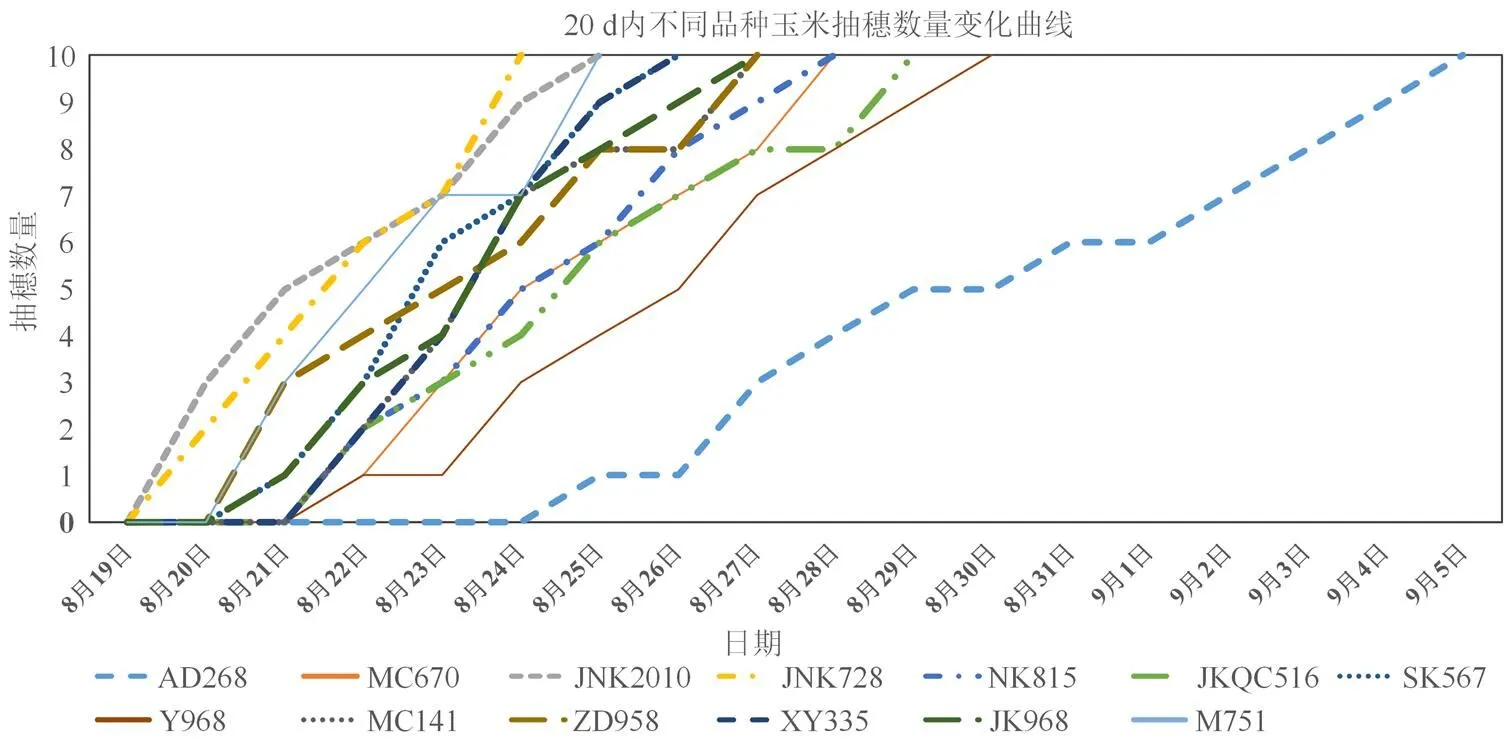

考虑到表型平台能够获取时序的可见光图像,本研究采用其所获取的连续图像进行不同品种玉米植株的抽穗期判定试验。表型平台覆盖地块中种植了13个品种的玉米植株,除去保护行植株,每个品种玉米种植了10棵。使用本研究训练的模型对该地块从8月17日至9月5日连续20 d的顶视图像玉米雄穗进行识别计数。检测时根据表型平台运行轨迹的位置坐标信息以及试验小区内玉米植株的种植示意图来判断所获取图像中分别对应的玉米品种。从监测起直至8月20日各品种玉米开始陆续抽穗,以下分别统计并绘制了13个品种玉米植株抽穗数量的变化曲线如图7所示。

表2 田间表型平台图像和无人机图像的测试集在两种模型上输出结果比较

(a)(b)分别为改进后的Faster R-CNN模型在表型平台和无人机平台测试集上的输出结果,(c)(d)为原始Faster R-CNN模型在表型平台和无人机平台测试集上的输出结果。

Figure 6 P-R diagrams of the two models, P-R diagrams of improved Faster R-CNN model on HTTP and UAV platform test sets

图7 监测期不同品种玉米抽穗数量变化曲线

Figure 7 Change curve of tasseling quantity of different maize varieties in monitoring period

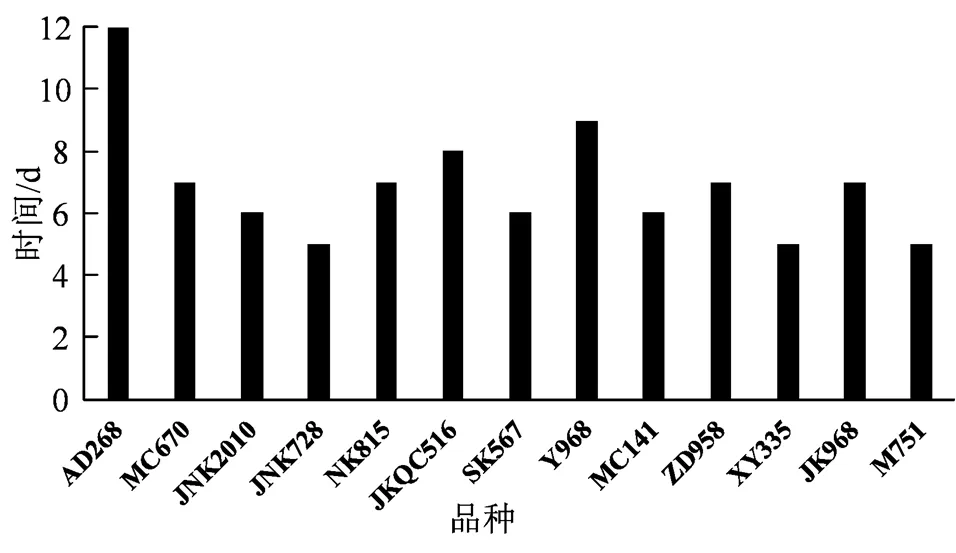

图8 不同品种玉米进入抽穗期所需时间

Figure 8 The number of days needed for different varieties of maize to enter tasseling stage

为了更加直观地展示各品种玉米进入抽穗期的情况,统计不同品种玉米从开始抽穗至结束所需要的天数,如图8所示,品种柱形越高表示进入抽穗期所需天数越多,表明该品种进入抽穗期较慢;反之,表示该品种玉米进入抽穗期较快。

结合图7和图8可以看出:在本研究试验中,不同品种玉米植株在相同种植条件下进入抽穗期的前后20 d抽穗数量变化存在明显差异。JNK2010和JNK728是最早开始抽穗品种,于8月19日监测第3天起开始抽穗。其不仅是进入抽穗期较早的品种,同时也是抽穗时间较短的品种;而AD268是开始抽穗最晚的品种,于8月24日监测第8天起才开始抽穗,且抽穗时间最长共计12 d。大部分玉米品种在监测的第4~6天开始抽穗,且抽穗持续时间普遍为5~7 d。

3 结论

本研究以田间作物表型高通量平台的可见光图像以及无人机平台的可见光图像两种数据源构建了不同光照条件下玉米冠层图像数据集。使用Resnet 50作为特征提取网络代替原始的VGG 16,在Faster R-CNN模型中对数据集进行了训练和预测。该模型在田间作物表型平台和无人机平台测试集上的类平均精度分别达到了90.14%和82.14%,达到了可观的效果。

在此基础上,应用此模型继续对检测出的玉米雄穗进行计数。选取了田间作物表型高通量采集平台地块中13个不同品种的玉米,使用表型平台对其连续获取抽穗期前后20 d的玉米冠层图像。再应用本研究中的模型对所获取图像中的玉米雄穗进行计数并作出曲线图,从而判断出不同品种玉米植株进入抽穗期所需时间。本研究方法具备一定的准确性和科学性,同时也为使用无人机平台和田间作物表型高通量采集平台获取的顶视图进行目标检测及抽穗期识别提供一定理论依据和借鉴价值。

[1] LUNDUKA R W, MATEVA K I, MAGOROKOSHO C, et al. Impact of adoption of drought-tolerant maize varieties on total maize production in south Eastern Zimbabwe[J]. Clim Dev, 2019, 11(1): 35-46.

[2] SHEKOOFA A, EMAM Y, SHEKOUFA N, et al. Determining the most important physiological and agronomic traits contributing to maize grain yield through machine learning algorithms: a new avenue in intelligent agriculture[J]. PLoS One, 2014, 9(5): e97288.

[3] DU Z R, YANG J Y, OU C, et al. Smallholder crop area mapped with a semantic segmentation deep learning method[J]. Remote Sens , 2019, 11(7): 888.

[4] KHAKI S, PHAM H, HAN Y, et al. Convolutional neural networks for image-based corn kernel detection and counting[J]. Sensors, 2020, 20(9): 2721.

[5] FERNANDEZ-GALLEGO J A, KEFAUVER S C, GUTIÉRREZ N A, et al. Wheat ear counting in-field conditions: high throughput and low-cost approach using RGB images[J]. Plant Methods, 2018, 14: 22.

[6] 张倩. 基于深度学习的图像目标检测研究[J]. 信息与电脑(理论版), 2021, 33(1): 56-58.

[7] LIU Y L, CEN C J, CHE Y P, et al. Detection of maize tassels from UAV RGB imagery with faster R-CNN[J]. Remote Sens , 2020, 12(2): 338.

[8] KURTULMUŞ F, KAVDIR İ. Detecting corn tassels using computer vision and support vector machines[J]. Expert Syst Appl , 2014, 41(16): 7390-7397.

[9] LU H, CAO Z G, XIAO Y, et al. Region-based colour modelling for joint crop and maize tassel segmentation[J]. Biosyst Eng , 2016, 147: 139-150.

[10] LU H, CAO Z G, XIAO Y, et al. TasselNet: counting maize tassels in the wild via local counts regression network[J]. Plant Methods, 2017, 13(1): 1-17.

[11] RAHNEMOONFAR M, SHEPPARD C. Deep count: fruit counting based on deep simulated learning[J]. Sensors (Basel), 2017, 17(4): E905.

[12] 刘永娟. 基于计算机视觉技术的玉米发育期识别研究[D]. 无锡: 江南大学, 2017.

[13] FAN J C, ZHANG Y, WEN W L, et al. The future of Internet of Things in agriculture: Plant high-throughput phenotypic platform[J]. J Clean Prod , 2021, 280: 123651.

[14] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Trans Pattern Anal Mach Intell, 2017, 39(6): 1137-1149.

[15] 郭心悦, 胡沁涵, 刘纯平, 等. 基于迁移学习和批归一化的菜肴图像识别方法[J]. 计算机应用与软件, 2021, 38(3): 124-133.

[16] 张琴. 基于CNN的图像分类中激活函数的研究[J]. 现代计算机, 2020(32): 43-47.

[17] 王跃, 王卫东, 赵蕾, 等. 基于迁移学习的胃镜图像自动识别多分类系统的研究[J]. 中国医疗设备, 2021, 36(3): 81-84.

[18] ZOU H, LU H, LI Y, et al. Maize tassels detection: a benchmark of the state of the art[J]. Plant Methods, 2020, 16: 108.

[19] MADEC S, JIN X L, LU H, et al. Ear density estimation from high resolution RGB imagery using deep learning technique[J]. Agric For Meteorol , 2019, 264: 225-234.

[20] 陆昊. 玉米雄穗发育状态自动观测中的图像理解与分析[D]. 武汉:华中科技大学, 2018.

Research on male ear detection and tasseling stage identification of field maize based on faster R-CNN

ZHANG Xiaoqing1, 2, FAN Jiangchuan2, 3, GUO Xinyu2, 3, ZHAO Chunjiang1, 2, 3

(1. College of Information Technology, Shanghai Ocean University, Shanghai 201306; 2. Beijing Research Center for Information Technology in Agriculture, Beijing 100097; 3. Beijing Key Lab of Digital Plant, National Engineering Research Center for Information Technology in Agriculture, Beijing 100097)

At present, the monitoring of the number of tassel of maize in the field mainly depends on manual work, which is inefficient and error-prone. In order to realize the task of automatic identification and counting of male ear in complex field environment, this paper used the images collected by UAV platform and the Plant High-throughput phenotypic Platform (HTTP) to build the data set, and used RESNET 50 as the new feature extraction network instead of the original VGG 16 to optimize the Faster R-CNN model. According to the high time sequence and continuous images obtained by the HTTP, the number of male ears before and after tasseling stage in the experimental field was further monitored by using the improved model, and the tasseling stage was identified on this basis. The mean average precision and mean absolute error of the image data obtained by the method in the HTTP were 90.14% and 4.732 8 respectively. The mean average precision of the image data obtained from the UAV platform is 82.14%, and the mean absolute error is 9.694 8. The experimental results show that the model has better detection results on the HTTP than the UAV platform, and the model proposed in this paper has certain application value.

maize; male ear detection; counting; Faster R-CNN; tasseling stage identification

S24; S513

A

1672-352X (2021)05-0849-08

10.13610/j.cnki.1672-352x.20211105.004

2021-11-8 9:27:40

[URL] https://kns.cnki.net/kcms/detail/34.1162.S.20211105.1128.008.html

2020-12-09

国家自然科学基金面上项目( 31871519 ),国家重点研发计划 ( 2017YFD0201510 ),北京市农林科学院作物表型协同创新中心项目( KJCX201917 ),现代农业产业技术体系专项资金( CARS-02 )和北京市农林科学院改革与发展项目共同资助。

张小青,硕士研究生。E-mail:15151935830@163.com

通信作者:赵春江,博士,研究员,博士生导师。E-mail:zhaocj@nercita.org.cn