监控视频中交通标线的强鲁棒性定位与重建(以双黄线为例)

2021-11-17申小虎安居白

申小虎,安居白

(1. 大连海事大学信息科学与技术学院,辽宁 大连 116026;2. 江苏警官学院刑事科学技术系,江苏 南京 210031)

1 引言

双黄线等交通标线定位与重建在交通违章行为的智能判定、统计车道线污损率等研究领域具有基础性研究价值。但由于受到建设条件的限制,交通监控视频中车道线目标容易受到污损、遮挡、恶劣天气等复杂监控场景的影响,现有检出与分割方法容易产生较大概率的漏检与错检,鲁棒性不强。

在交通监控视频中的车道线分类检出领域,学者钱将传统图像增强算法与深度网络模型训练相结合,端到端的解决复杂道路场景下的车道线目标检出问题[1]。庞等人则提出一种语义分割神经网络,通过逐层融合车道线边缘特征同时建立跨层的语义连接实现了车道线的准确分类[2]。目前基于深度学习方法下提取的高维特征在目标检测分类上具有良好的性能,但在目标精确分割问题上主流算法仍是依赖于低层统计特征。学者徐等人通过变形Sobel算子扩充双黄线区域纹理得到双黄线区域位置,进而使用Hough直线变换方法对双黄线进行分割[3]。熊等人提出了一种基于彩色检测线的线间差分与灰度帧差统计法相结合的改进混合型方法,减少阴影对双黄线检测精度的影响[4]。上述方法在目标定位均取得了不错的效果,但在目标边缘分割抗噪性较差。同时,基于纹理特征提取和基于词袋(BOW)模型的对象分类分别在海冰分割、输电线检测、地形测绘等领域下的目标分割与分类领域取得过良好的结果[5-11],为解决本文问题提供了丰富的思路。

基于上述讨论,本文使用一种由粗至精的策略,依次利用了运动关系特征、局部特征、颜色纹理特征和形状特征来提升监控视频目标分割重建的鲁棒性。首先,利用基于混合高斯模型的方法去除运动目标干扰,得到输入视频的静态背景图像。其次,为去除背景图像中的环境噪声干扰,采用词袋BOW模型提取双黄线目标Sift特征,并使用多核支持向量机(SVM)分类器[5]进行监督学习得到仅包含双黄线目标与周边路面的感兴趣区域。接着,使用基于颜色纹理特征聚类的方法对感兴趣区域图像中的双黄线目标进行分割,并通过形态学处理消除磨损式双黄线的影响。最后,采用基于最小二乘法的曲线拟合方法对双黄线的截断部分进行定位重建。本文使用Python进行了仿真实现,并对现有方法进行了实现并比较。实验结果表明,该方法能够在残缺双黄线条件下有效完成定位与重建,提升了目标分割精度与鲁棒性。

2 相关关键技术

2.1 混合高斯模型

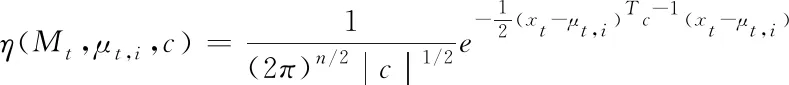

在智能交通场景中,由于背景像素点具有多峰特性,为解决光线变化、视频画面抖动带来的干扰,常常利用混合高斯模型进行背景建模。由于任何分布函数均可由多个高斯分布函数的线性的加权组合进行描述,假定视频帧中坐标为(x,y)的像素点p在t时刻的像素值为Mt,并用k个高斯分布的加权混合来描述像素值随时间变化的随机过程,则其概率分布可表示如下

(1)

其中wt,i为t时刻混合高斯模型第i个高斯分布的权重,η为高斯分布的概率密度函数,具体公式如下

(2)

上述公式中的μ为各彩色通道分量组成的矢量,c为各颜色分量的协方差矩阵,可具体表示为

(3)

其中E为单位矩阵。与Mt相匹配的高斯分布的各参数更新过程为

μt,i=(1-ρ)·μt,i+ρ·Mt

(4)

(5)

(6)

其中ρ为参数更新速率,λ为高斯分布权值的更新速率,取值范围均为[0,1]。

2.2 词袋Bow模型

Bow模型最初应用于大规模文档集的文本统计建模,后延伸至图像目标分类研究领域[9]。Bow模型在图像分类中,将目标图像分成若干区域块,并将它们量化为离散的“视觉单词”,得到图像中所有待识别目标的特征向量直方图后进行分类,具体步骤如下:

1)图像块的检测与描述

通常使用SIFT、SUFR等算法提取训练样本图像块中的特征向量,得到具有光照不变性的高鲁棒性图像特征。

2)词典构建

采用非监督学习的K均值算法构建词典。该方法首先随机初始化K个聚类中心,并计算各特征点到K个聚类的欧式距离最小值

(7)

根据距离计算结果将特征点Xi赋与聚类Yk。针对生成的各个聚类,重新计算聚类中心。迭代重复上述操作,直至算法收敛。

3)计算图像特征直方图

将图像的特征点聚类到生成的聚类中心(词典),同时统计落入每个词典中的特征点的个数,特征匹配上采用快速滑动窗口策略,窗口滑过目标区域的同时,提取该目标区域的特征描述符并依次与Bow模型中的视觉单词进行匹配,统计词表中每个单词在滑动窗口区域图像中出现的次数,得到词频直方图,即图像特征直方图。同时构造视觉单词到图像的索引,根据索引结果进行直方图匹配得到图像的分类。

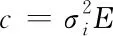

2.3 颜色共生矩阵(CCM)

基于灰度级的图像分割方法仅适用于灰度图像,但面对信息更丰富的彩色图像,可分别处理不同的彩色图像通道,然后通过各种策略获得分割结果。图像纹理反应了图像灰度在空间维度上的变化关系,因此在图像处理领域,颜色共生矩阵往往被用于提取彩色图像的局部纹理特征信息[15]。

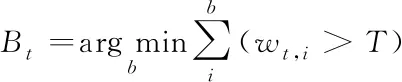

颜色共生矩阵通过计算水平、垂直、双方向对角线上的像素对出现的联合概率密度来定义一个二阶统计特征,反映了图像颜色、亮度与相同颜色亮度的像素间的分布特性,即计算不同独立颜色分量的联合概率密度的共生矩阵,类似于颜色直方图特征。颜色共生矩阵可由各颜色空间下的不同分量组成,假定同一颜色空间下的任意两个颜色分量为α、β,颜色共生矩阵需对像素颜色分量α中分量值为i,同时像素颜色分量β中分量值为j的像素点进行计算,具体公式如下

(8)

其中Δx和Δy分别表示像素原点在横坐标和纵坐标上的增量。得到颜色纹理特征后,需要对各特征矩阵进行统计。典型常用的四个不具备相关性的特征统计值分别为逆差矩(I)、对比度(C)、能量(S) 和熵(E)[13],其实现算法如下

(9)

(10)

(11)

(12)

其中p(i,j)代表相同颜色空间下像素对出现的联合概率密度,D为各颜色分量的量化级数,μ和σ分别表示均值和方差。

3 视频监控中双黄线目标的定位与重建方法

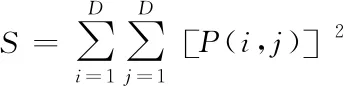

本文设计使用的双黄线目标定位重建算法(MG-BCF)流程如图1所示,该方法主要分为视频处理与图像处理两个部分。其中视频处理部分主要提取视频场景背景图像,图像处理部分则依次执行提取ROI区域、双黄线分割、目标重建三个步骤。其中在感兴趣区域提取步骤,需对双黄线样本进行有监督的学习训练建模。

图1 本文提出的双黄线定位与重建方法(MG-BCF)

3.1 视频背景图像提取

设计使用基于混合高斯模型的平均背景法从动态视频中提取静态背景去除运动前景目标,减少背景图像中干扰因素,有效提升双黄线等静态目标的检测精度。视频中各视频帧图像的每个像素点的值随时间呈现高斯分布,即像素值均围绕某一中心值(均值)并在一定距离(方差)内分布。同时为应对视频画面抖动、光照短时间内缓慢变化等问题,通常选择使用混合高斯模型来解决背景像素点的多峰特性问题,主要步骤:

1)取输入视频的第一帧图像的各像素点灰度值设定为均值的初始值,同时设定方差初始值为15,高斯分量个数初始值为1,权重为0.001;

2)将当前图像帧像素点p在t时刻的像素值Mt与已有的高斯分量依次进行匹配

|Mt-μt,i|<2.5σt,i

(13)

如满足上述匹配条件,参照式(4)-(6)根据当前像素值不断迭代更新调整第i个高斯模型的参数和权重。如果不满足,则进入步骤3);

3)建立新的高斯分量模型,并初始化参数。同时判断当前高斯分量个数是否达到高斯分量个数上限,如果i=k,删除最小权值w所对应的高斯分量模型;

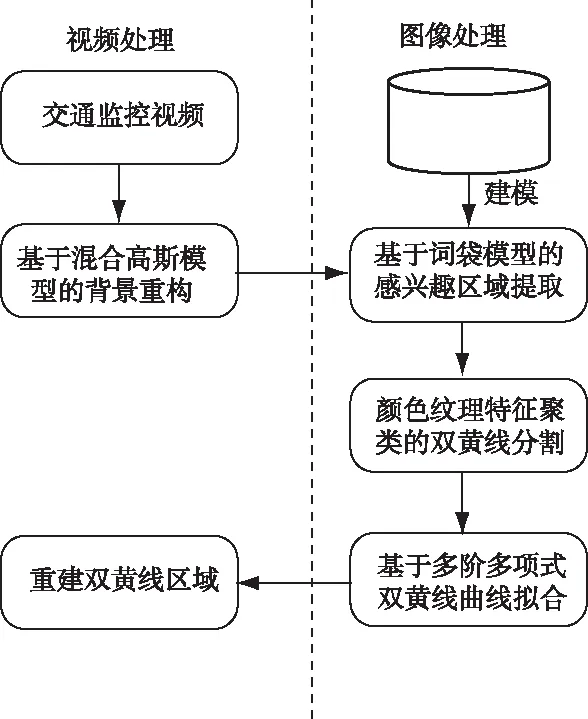

4)通过判断各高斯分量的权值与阈值T得到t时刻的背景图像Bt,阈值T设定为0.75

(14)

5)得到不同时刻的多个背景模型后,求多帧背景图像平均得到最终的视频背景静态图像。

B=Avg(Bt)

(15)

图2 从监控视频中提取到的静态背景图像

3.2 提取感兴趣区域(ROI)

通过视频的背景图像提取,时序视频帧计算问题转变为静态图像处理的问题。针对监控视频背景图像,本文设计使用基于Sift特征的Bow词袋模型对背景图像的ROI区域进行检索,即对双黄线目标位置进行粗略估计。由于BOW模型主要基于目标的局部特征进行检索分类,而不考虑局部特征间的空间关系,因此对各类污损条件下不完整车道线图像漏检率较低,并且可消除双黄线目标周围的图像噪声。

在目标检索问题上传统SIFT特征优于Dense-SIFT特征的表现,因此利用Opencv提取标准Sift特征生成局部特征描述子并利用K均值算法进行聚类,迭代计算得到聚类中心个数(词典中的视觉单词个数)为5。作为SVM分类器输入,所有词频直方图均通过min-max方法进行了归一化处理。同时ROI区域匹配上采用滑动窗口操作,以1920×1080分辨率的图片条件下,采用240×120的区域滑动窗口,窗口依照从上至下,从左至右的方向依次滑过背景图像。对于每一个滑动区域,使用训练好的SVM进行分类;如匹配成功则该窗口区域定义为ROI区域。图3显示了某候选区域的匹配过程与最终得到的感兴趣ROI区域。

图3 从背景图像中提取感兴趣双黄线区域

将线性不可分的数据映射到高维特征空间并可分时,SVM核函数的选择决定了系统的分类精度。作为主流核函数,多项式核函数和高斯RBF核函数间存在互补特性,实验证明,通过将泛化能力较强的多项式核函数与学习能力较强的高斯核函数结合起来,得到的混合高斯函数兼备良好的外推能力和内推能力[5]。如式(16)所示,在SVM核函数的选择上,本文使用了由多项式核函数、高斯核函数组合构建混合核函数用于解决非线性划分和二维模式分类问题。

Kcom=αKp+(1-α)Kr

(16)

其中Kp、Kr分别表示多项式核函数和高斯RBF核函数,表示多项式核函数的权重系数。利用交叉验证方法进行权值优化,得到=0.89时,验证精度最高。ROI区域提取结束后,去除了图像中例如周边建筑、路灯等非路面目标,得到了主要由双黄线目标与路面背景组成的区域图像,为下一步进行目标分割减少了干扰因素。

3.3 双黄线目标分割

双黄线等交通标线由于受到对受光照不均匀、污损、积水反光等情况的影响,背景图像中的双黄线目标可能会具有不同的颜色信息,同时还造成二值化图像中车道线边缘极不规则,因此传统的Candy检测与Hough变换方法在直线检出上精确度不高,本文设计使用颜色共生矩阵(CCM)提取双黄线目标特征,并进行边缘分割。计算颜色共生矩阵时,本文将图像空间颜色分量的量化级数定义为16,得到16×16的共生矩阵。为增加纹理特征的光照不变性,未采用亮度颜色分量,同时考虑到RGB颜色空间下三种颜色分量存在线性相关,本文最终选用RGB空间的R、G,Lab空间的a *、b *与HSI空间的H和S共9个颜色分量作为颜色聚类空间的组成,定义为[Frr,Frg,Fgg,Faa,Fab,Fbb,Fhh,Fhs,Fss]。图4展示了双黄线目标图片的各颜色分量。

图4 双黄线目标图片各颜色分量

通过对双黄线图像样本的分析,提取ROI区域内有效区分双黄线和路面背景的颜色特征。在中心像素的0°、45°、90°与135°四个方向上分别计算CCM可得到各颜色分量直方图,进一步根据式(9)-(12)计算4个特征统计值[14],最终得到36维的特征向量。最后再根据K均值非监督聚类算法,通过计算不同区域(点)的CCM特征矩阵之间的欧式距离进行图像区域的分割。

针对分割后图像中仍存在噪点且部分双黄线目标像素分布较离散的问题,可利用形态学处理中的开操作消除分散的路面噪点,闭操作来将某些区域连接在一起扩大颜色联通区域集面积,避免因双黄线磨损所导致的纹理特征不清晰造成目标丢失的情况。使用的形态图像处理依次进行1次开操作与2次闭操作的方式,采用椭圆核结构元素,核大小定义为6×6。双黄线目标的最终分割效果如图5所示。

图5 双黄线部分污损区域分割的细节效果

3.4 双黄线目标的重建

经过颜色纹理特征聚类与形态学处理后,虽然能够消除双黄线磨损部位对于目标分割带来的影响,但是双黄线截断式部位依然存在,因此需要根据已有的双黄线封闭区域进行重建。双黄线几何形状在大多数条件下为直线,也会存在弯曲双黄线的情形,因此本文采用基于最小二乘法的曲线拟合对截断部位进行回归计算。设分割后各连通区域的质心集合为T,离散的质心点个数为N

T={(xi,f′i)}i∈(1,N)

(17)

拟合多项式函数与误差函数分别为

(18)

(19)

代码实现上使用Numpy库的polyfit函数,同时为防止高阶多项式出现曲线拟合问题,根据所得到的双黄线样本的几何形态,多项式阶数m设定为3,质点的个数不小于4,得到的曲线方程为

y=ax3+bx2+cx+d

(20)

其中a、b、c、d为求得三次多项式函数的参数实数,当双黄线图像为直线时,a=b=0。根据前图例中所得到的拟合曲线如图6所示。

图6 计算得到的三次多项式拟合曲线例

接着通过Hough直线检测[17]得到双黄线的边缘基点,根据基点可将拟合曲线平移投影到双黄线的边缘,即

y=a(x±Δx)3+b(x±Δx)2+c(x±Δx)+(d±Δy)

(21)

其中Δx,Δy分别是双黄线各边缘与拟合曲线间的偏移横坐标与纵坐标。重建后的双黄线图像如图7所示。

图7 双黄线重建效果

4 对比实验

本文实验所用双黄线图像来源于宿迁市公安局视频专网与北京多维视通公司提供的交通监控视频数据,数据集对象均为CCD摄像机采录的高清视频,分辨率为1980×1020像素。

4.1 双黄线定位重建结果

使用自定义的数据集中的视频进行测试,图8中分别为残缺弯曲双黄线与残缺直线双黄线条件下的定位重建结果。这部分实验验证表明,本文的算法可针对视频集中存在遮挡、阴影、磨损等条件下的双黄线进行有效的定位重建,取得了较好的视觉效果。

图8 双黄线重建效果

4.2 参数设定讨论

基于BOW模型的ROI区域检出是本文所提出的双黄线定位重建的第一步,特别是当双黄线区域缺损区域较多时,其作用非常关键。而感兴趣ROI区域提取的一个重要参数是BOW模型中视觉单词个数。视觉单词数量决定着目标识别的精确度,而感兴趣区域提取的结果则直接影响下一步纹理特征提取范围。本文针对视觉单词数量为2~8的条件下,评估其性能,如图9所示。

图9 算法准确率与计算时间的交叉验证

可以看出,召回率和精确度与视觉单词数个数均呈现正相关关系。同时使用本文所提算法依次测试其性能和计算时间。图9同时也表明,计算时间会随着视觉单词数量的增加而迅速增加。因此,基于权衡考虑算法精度与计算成本的前提下,根据上述交叉验证方法最终确定视觉单词的数量为5。

4.3 算法检测准确性评估

为验证本文所提出双黄线定位与重建方法的有效性,将部分视频中的清晰完整的双黄线作为基准模板,并对其进行了遮挡或软件处理模拟残缺双黄线用于实验测试,同时利用现有数据集对重建效果的与精度值(Precision) 与召回率(Recall)进行了评估

Precision=T P/(T P+F P)

(22)

Recall=T P/(T P+F N)

(23)

其中TP为重建后坐标预测正确的像素点数,TP+FP为重建双黄线范围内的像素点总数,而TP+FN为实际双黄线范围内的像素点总数。

实验中将本文所提出的算法(MG-BCF)与基于变形Sobel算子扩充区域与霍夫直线变换方法(SO-HLT)[3]、基于线间差分与灰度帧差的统计算法(LD-GFD)[4]进行了比较分析。上述所有算法均使用相同实验视频,视频根据不同的监控点位与双黄线的几何形状进行分组,从视频数据集中得到存在缺损的直线双黄线与弯曲双黄线的实验视频各10组。最终的实验结果如图10所示。

图10 三种算法的性能比较

图10表明,本文所提出的算法的分割性能与其它两种算法相比较,召回率与精度值都有一定程度的提升。其中,针对常见的直线双黄线,三种算法的精度值均取得了不错实验结果。但SO-HLT算法在弯曲双黄线的实验中召回率与精度值都较低,这是由于其在算法设计中未考虑双黄线的弯曲形状所导致。同时由于LD-GFD算法针对缺损目标检出的鲁棒性较低,导致部分缺损区域未被正确重建,因此虽精度值尚可但召回率不佳。除此之外,通过对召回率与精度值在90%以下的部分实验组的数据集进行分析后发现,这是由于监控视频建设安装过程中水平俯视角度过大,造成了视频中的远景重建目标存在一定的几何变形。针对这种情况,可通过透视变换原理[15]将原视频背景图像进行校正,将原图像坐标映射至俯视图坐标,进一步提升双黄线重建的精确度。

5 结论

本文针对视频监控中存在缺损的双黄线目标提出了一种强鲁棒性定位与重建方法。该方法采用一种由粗至精的分割策略,依次去除运动目标信息、周边环境信息的干扰,通过颜色纹理特征进行精确分割后对破损区域进行了拟合重建。

实验结果表明,该方法在直线、弯曲双黄线条件下的正确检出率分别达到了94.7%与93.1%,定位重建性能良好,准确率优于现有方法。该方法适用于各种复杂场景下双黄线目标定位与重建,在交通违章行为检测、事故定责等领域具有一定的实用推广价值。