基于瞬时幅度和相位的深度学习调制识别

2021-11-15陈观业

陈观业 侯 进 张 姬

(西南交通大学信息科学与技术学院 四川 成都 611756)

0 引 言

自动调制识别是信号检测和解调之间的重要中间步骤,在各种民用和军用应用中起着关键作用。对于民用应用,它用于频谱管理、信号确认和干扰识别;在军事应用中,它用于电子战、监视和威胁分析。目前传统的调制识别有两个主要的研究方向:基于最大似然的估计方法和基于特征工程的方法。文献[1]提出了一种用于连续相位调制的混合最大似然分类器。文献[2]结合连续相位调制分解和最大期望算法,提出信道参数可估计的连续相位调制信号似然函数方法。然而,最大似然算法同时有着较高的计算复杂度和需要较多先验信息的缺点,这成为该类方法应用的主要瓶颈。基于特征的调制识别算法则需要从数据中提取信号的时域特征或变换域特征,选取合适的分类器来完成信号的调制识别任务。文献[3]利用小波域中接收信号的循环平稳特征、估计的符号速率对接收的信号特征的直方图来识别调制类型。文献[4]使用输入信号的瞬时幅度作为特征向量对不同ASK信号进行分类,并使用8阶的高阶累积量对不同PSK信号进行分类。文献[5]结合离散小波变换和广义自回归条件异方差模型,对六种不同类型的数字调制进行识别。在分类决策中,传统的分类器包括随机森林[6]、多层感知器[7]和支持向量机[8]等。然而,上述调制识别方法很大程度上依赖于人工对信号特定特征的提取。

随着深度学习在图像识别和语音识别领域的快速发展,利用深度学习技术实现信号自动调制识别逐渐受到了重视。深度学习具有自动提取目标特征的优点,可以直接学到数据的特征,不需要依赖于人为特征提取。O’Shea等[9]提出了一个用于调制识别研究的不同信噪比下11类复杂调制信号的IQ数据集,并在文献[10]中利用卷积神经网络(Convolutional Neural Networks,CNN)对该数据集进行分类,在低信噪比条件下具有更加稳定的性能,证明了深度学习在调制识别领域的可靠性。文献[11]利用卷积神经网络ReSENet对时频图的特征进行自动提取和调制识别。West等[12]得出调制识别领域中的深度神经网络的性能不受网络深度的限制,且需要进一步发展改进训练方法和网络架构来提升识别效果。

本文在研究分析调制识别领域深度学习模型的基础上,设计一种结合一维卷积神经网络和长短期记忆网络(Long Short Term Memory Networks,LSTM)的深度学习模型(One-dimensional Convolutional Neural Network and Long Short Term Memory Networks,OCLN)。该方法更加适合对时序信号进行调制识别,在识别信号原始IQ数据集上得到了很好的发挥。针对调制信号QAM16和QAM64难识别问题,将IQ数据转化为瞬时幅度和相位数据,并利用OCLN在幅度和相位的AP(Amplitude and Phase)数据集上识别,从而提高了QAM16和QAM64识别区分度,也提升了总体的识别精度。

1 调制信号采集及转换

1.1 IQ数据采集

本文研究的调制信号数据来源于文献[10]中生成并公开的RadioML2016.10b数据集,其包括了10种调制信号类型:8种数字调制和2种模拟调制,包括用于数字调制的BPSK、QPSK、8PSK、QAM16、QAM64、BFSK、CPFSK和PAM4,以及用于模拟调制的WBFM和AM-DSB。整个数据集是在GNU Radio中生成的序列长度为128的复杂时域向量。数据集生成的详细信息可以在文献[9]中找到。总样本数为1 200 000,训练示例以2×128个向量的形式输入网络,其中:2表示的是同相I和正交Q;128表示每个样本信号序列长度为128。IQ向量是原始复数样本到两组实值数据向量的映射,其中一组携带同相样本,另一组保留正交分量值。输入数据中的标签包括信噪比基本信息和相应的10种调制类型。样本的信噪比一共有20种,从-20 dB到18 dB均匀分布。

1.2 瞬时幅度和相位数据及数据预处理

通常来讲一个调制信号公式如下:

r(t)=s(t)*c(t)+n(t)

(1)

式中:s(t)是接收信号的无噪声复基带包络;n(t)是均值为零的加性高斯白噪声;c(t)是发射无线信号时变脉冲响应渠道;*代表卷积运算。为了让接收信号r(t)在数学运算和计算机硬件设计方面具有更好的适应性和简便性,通常以IQ格式表示信号数据。

同相分量I表示为:

I=Acos(φ)

(2)

正交分量Q表示为:

Q=Asin(φ)

(3)

式中:A和φ分别为接收信号r(t)的瞬时幅度和相位。因此由信号IQ数据通过转换,也能得到信号的幅度和相位数据。其计算式为:

(4)

(5)

式中:Xφn为相位数据的元素;XAn为幅度数据的元素;rin为IQ数据的同相分量;rqn为IQ数据的正交分量值。

将变换后的幅度和相位存储为AP数据,格式与IQ数据一样,样本都是2×128,相应的信噪比和调制类型基本信息也对应地存储在新的数据集上。

在输入模型训练之前,对获得的幅度和相位数据使用L2范数正则化进行数据预处理。数据正则化将样本的范数归一化,对于每个样本,将样本范数缩放成单位范数。这样能在计算点积或其他核函数的相似度时对样本向量具有统一的标准。向量x(x1,x2,…,xn)的L2范数定义为:

(6)

L2范数归一化就是向量中每个元素除以向量的范数,归一化公式表示为:

(7)

通过对AP数据做L2范数处理,解空间得到了缩小,进而控制模型复杂度,降低结构化风险。对模型空间实施了控制,从而避免了模型的过拟合,并在一定程度上提高了模型的泛化能力。

2 调制识别的深度学习模型

2.1 卷积神经网络和优化的结构

2.1.1卷积神经网络结构

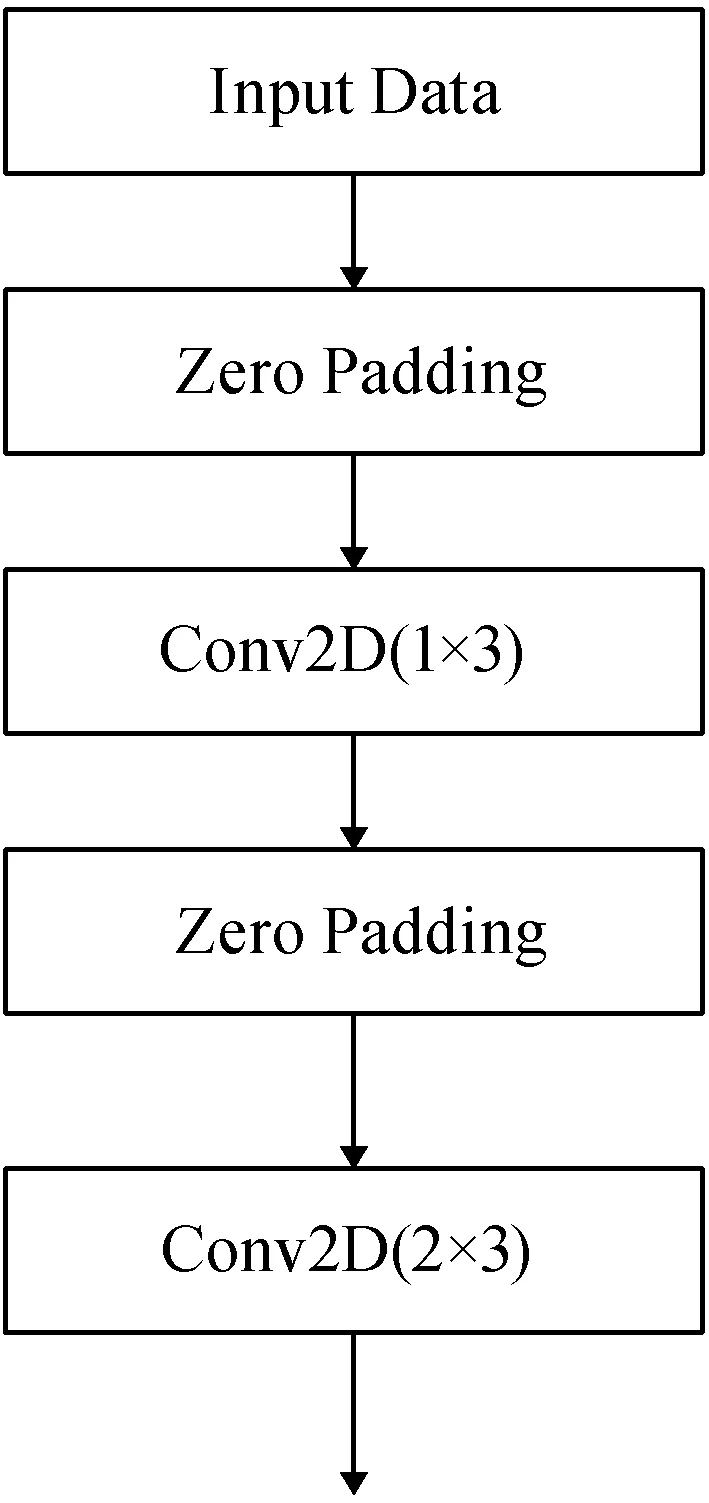

目前在调制信号IQ数据识别上一般采用卷积神经网络比较多。而传统的CNN模型采用3×3或者更小的1×1的卷积核,针对调制信号数据和图像识别领域的差异,卷积神经网络模型的卷积核选择使用了1×3和2×3的卷积核,基础网络结构如图1所示。

图1 卷积神经网络基本结构

使用这样的卷积核在更有效地减少模型参数的同时,使得模型的收敛速度加快和训练时间缩短,有利于训练效果的提升。在每一层卷积层之前,都加入了零填充(Zero Padding)层,保持边界信息,避免卷积过后的矩阵变得越来越小,让更深层的输入依旧保持有足够多的信息量。跟传统的卷积神经网络卷积层之间周期性地插入池化层相比,调制识别的卷积神经网络模型取消了池化层。虽然池化层会减小参数的空间大小,在一定程度上减少了模型过拟合的情况,但是IQ信号序列的相邻位置信息对于调制类别之间的区分是很重要的,需要给予必要的关注。

本文训练模型都使用了早停(Early Stopping)的方法,监视模型验证的损失函数的变化。当其在5个epoch不变时则停止模型训练,进而减少模型过拟合的情况。训练模型时使用丢弃法(Dropout),在每个训练批次中,忽略一部分隐藏的神经元。本文使用的Dropout层加在卷积层后面,Dropout的取值都是0.5。网络同时加入了批正则化[13](Batch Normalization,BN),这有利于加速神经网络训练的收敛速度和减少梯度爆炸,同时也减轻了对参数初始化的依赖和允许使用较大的学习率,大大地增加模型泛化能力。

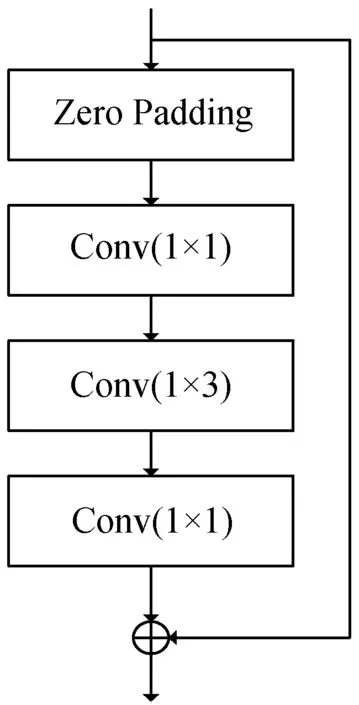

2.1.2ResNet网络结构

在深度学习模型的训练集上,传统神经网络并不是越深效果就越好,盲目地增加网络的层数会导致网络模型梯度消失现象。而随着网络层数越深,训练参数也会越多,训练随之变得更难,网络优化也会越来越难。文献[14]提出的残差结构能有效地解决这个问题。残差模块如图2所示。

图2 基本的残差网络结构

本文在CNN模型卷积层优化成残差模块,网络每层卷积层的卷积核的数目都为50,模型的其他层选择维持跟CNN模型一样。借助ResNet网络能够加深模型深度而不会梯度消失的优势,分析在加深网络深度的同时,模型能否更好地学习到更多的参数特征,对信号调制识别精度是否有提升。

2.1.3DenseNet网络结构

文献[15]提出DenseNet,相比于ResNet参数量更少,同时也缓解了梯度消失的问题,加强了特征传播和特征复用,减少了参数量。DenseNet模块如图3所示。

图3 基本的DenseNet网络模块

该结构每一层的输入来自前面所有层的输出。本文DenseNet网络卷积层的卷积核数目分别选择80和256,模型的其他层也维持跟CNN模型一样。在全连接层前将各层的输出权重叠加在一起作为输出,再将特征映射到独立空间。

2.2 长短期记忆网络

递归神经网络(Recurrent Neural Networks,RNN)被大量用于从时间序列数据中学习持久特征。LSTM是一种特殊的RNN,可以有效地学习长期依赖关系。

LSTM单元具有内部状态门Ct、输入门it、忘记门ft和输出门ot。这种门控机制有助于LSTM单元将信息存储更长的时间,从而实现持久的特征学习。计算公式如下:

it=σ(Wxtxt+Whiht-1+bi)

(8)

ft=σ(Wxfxt+Whfht-1+bf)

(9)

ot=σ(Wxoxt+Whoht-1+bo)

(10)

C-int=(Wxcxt+Whcht-1+bC-in)

(11)

Ct=ft·Ct-1+it·C-int

(12)

ht=ot·tanh(Ct)

(13)

式中:W为权重;b为偏差。

长短期记忆的输入门、遗忘门和输出门可以控制信息的流动。长短期记忆可以解决循环神经网络中的梯度衰减问题,并更好地捕获时间序列中时间步距的依赖性。本文LSTM网络中选择了两层LSTM模型,输出维度选择为64,LSTM后面直接连接展平(Flatten)层,把多维的输入一维化。之后将一维化的输入直接传递给分类器,不需要借用全连接层来进一步映射。

2.3 OCLN模型的设计

就模型性能而言,CNN擅长减小频域方面的变化,LSTM可以提供长时间的记忆,所以在时域上有着广泛应用,而DNN(Deep Neural Networks)则更适合将特征映射到独立空间。CLDNN[16]同时使用卷积结构、循环结构、全连接结构构建神经网络模型。CLDNN已被广泛用于涉及时域信号的识别任务,因为其固有的存储特性可识别输入信号中的时间相关性。CLDNN网络的通用结构从输入层输入时域相关的特征,连接若干层CNN来减小频域变化,CNN的输出接着若干层LSTM来减小时域变化,LSTM最后一层的输出输入到全连接DNN层,目的是将特征空间映射到更加容易分类的输出层。

本文在CLDNN网络基础上设计OCLN深度学习模型来契合AP数据的训练,比起常规的CLDNN模型,OCLN在幅度和相位数据上能学习到更多的特征,模型识别性能也更加好。本文设计的OCLN模型结构如图4所示。

图4 OCLN网络模型基础结构

深度学习模型在调制识别应用中,卷积神经网络的卷积层一般使用二维卷积(Conv2D),而OCLN模型在卷积神经网络的卷积层选择了一维卷积(Conv1D),卷积核数目为50,卷积核长度为8。二维卷积是将一个特征图在水平和垂直两个方向上进行窗口滑动操作,对应位置进行相乘并求和;而一维卷积则是只在水平或者垂直方向上进行窗口滑动并相乘求和。一维卷积可以在整个数据集的固定长度段中获得感兴趣的信号调制特征,并且该特征在数据段中的位置不跟高度相关,相比二维卷积,能更好地用于分析具有固定长度周期的信号数据。

一维卷积层后使用一维的最大池化层,池化的窗口大小为2,池化步长为2,这将减少输出的复杂度并防止数据的过拟合,同时加入了BN层加速训练和减少梯度爆炸。在循环卷积网络中选择了3层LSTM网络,输出维度都选择为64。在LSTM层后面也加上Dropout层,其取值为0.5。CLDNN需要借助重塑(Reshape)层来连接CNN模块和LSTM模块,而OCLN不需要使用Reshape层就可以使CNN模块直接连接LSTM模块,加速了网络的训练,这也是选择一维卷积带来的一个优势。

CLDNN会在LSTM后使用DNN全连接层,综合全局信息,把图像降维成一维序列。全连接层存在参数冗余,这导致了训练速度的降低和模型容易过拟合。目前越来越多的神经网络放弃全连接层,使用全局平均池化或者全卷积来代替。卷积层相当于局部连接,它根据卷积核的感受野确定提取的特征范围。当卷积核的感受野覆盖整个图时,其作用类似于全连接层。目前大多数任务不需要提取全图特征,而只需要可以覆盖目标对象大小的感受野特征即可。全卷积网络的情况表明,用卷积层代替全连接层,简化网络的同时而不会造成明显的性能下降。本文通过一维卷积得到的一维信号特征,不需要全连接层对其降维,提取到的特征也足以覆盖信号的感受野。OCLN模型去掉了全连接层,最后仍使用Softmax分类器来指导分类过程,也能达到原来的效果。

3 实验与分析

3.1 实验环境和参数配置

本文实验所使用的硬件配置为:Inter Xeon CPU,48 GB内存,NVIDIA GTX 1080Ti 580 3 GB GPU显卡。软件运行环境为64位Ubuntu16.04操作系统,网络模型由Python调用Keras API编写,以TensorFlow作为计算框架并由CUDA8.0加速计算。数据集使用RadioML2016.10b调制信号数据集,分别以原来IQ信号格式和转换后的幅度相位信号格式作为数据。本文将1 200 000个信号样本划分成900 000个训练样本和300 000个测试样本,并将划分的数据打乱顺序输入。数据的批量大小为1 024,优化器使用自适应矩估计(Adam),初始学习率设为0.001。

3.2 基于IQ数据的模型对比实验

将信噪比-20 dB到18 dB,信噪比间隔为2的原始IQ信号输入到本文的CNN、ResNet、DenseNet、LSTM和专为调制信号设计的OCLN模型中进行训练。不同模型在20种信噪比下的10类调制信号识别准确率曲线如图5所示。网络模型的各项平均准确率如表1所示。

(a) 各信噪比下模型的识别精度曲线

(b) 0 dB以上混淆部分放大后的曲线图5 IQ数据各模型识别准确率曲线

表1 基于IQ数据的模型平均准确率(%)

在IQ信号数据中,本文的OCLN在-20 dB到18 dB信噪比下平均准确率达到了62.82%,与其他模型相比均是最高。这也说明了OCLN模型在IQ信号中有着良好的识别性能。表现最差的网络模型ResNet总体平均准确率只有46.92%,而浅层的CNN模型为56.41%。DenseNet的总体平均准确率56.24%比CNN稍低,但高于0 dB信噪比的平均准确率却比CNN稍高,说明了DenseNet在高信噪比下比CNN识别性能稍好。这也反映了卷积网络中卷积层数的增加和在其上面的优化对于IQ信号调制识别提升不大。LSTM的效果比卷积神经网络要好,仅次于OCLN模型,反映了在时序IQ信号识别中LSTM比卷积神经网络更加具有优势,单纯地对卷积神经网络结构的优化并没达到理想的结果,这也是OCLN模型设计重心偏向LSTM的原因之一。

3.3 基于AP数据的模型对比实验

在维持信噪比、调制类别和信号长度不变的基础上,将IQ信号转换成具有瞬时幅度和相位信息的数据,数据格式依然为2×128,但这里的2表示瞬时幅度和瞬时相位。不同模型在20种信噪比下的10类调制信号识别准确率如图6所示。网络模型的各项平均准确率如表2所示。

图6 AP数据各模型识别准确率曲线

表2 基于AP数据的模型平均准确率(%)

在瞬时幅度和相位数据集下,对于所有信噪比平均准确率和0 dB以上的平均准确率比较,虽然ResNet性能提升不大,效果仍然比不上浅层的CNN,但是其优化版的DenseNet却分别达到了59.22%和89.21%,在识别性能上远好于浅层的CNN。这也一定程度上表明了在瞬时幅度和相位数据中,DenseNet具有非常好的抗过拟合性能和对于卷积网络识别性能利用的提高。值得一提的是LSTM依然具有良好的识别性能,总体平均准确率达到了62.66%。对比可以看出即使在AP数据集下,LSTM对于时序信号的识别依然好于卷积神经网络。本文设计的OCLN模型表现仍然优秀,总体平均准确率和0 dB以上的平均准确率分别达到了64.40%和93.21%,与其他模型相比识别效果最高。这也表明了融合一维卷积和LSTM优点的OCLN在信号AP数据集上识别的有效性,识别效果也比其他模型要好。

3.4 与其他文献方法比较

为了进一步验证本文OCLN模型的性能,与其他文献提出的方法进行对比分析。文献[12]使用结合ResNet的CLDNN模型;文献[17]使用了基本的CLDNN模型;文献[18]使用基于CNN的多任务学习模型;文献[19]提出了基于贝叶斯优化算法和CNN结合的模型。表3给出了基于IQ数据的本文OCLN方法和其他文献的各项平均准确率对比。

表3 本文OCLN方法与其他文献的准确率对比(%)

对比文献都基于原始的IQ数据,只是各自的模型方法不同。本文OCLN模型的各项指标的平均准确率均最高,说明了本文设计的OCLN模型在IQ数据上识别效果要好于其他方法。而且在AP数据集上OCLN效果会更加好,在0 dB以上平均准确率相比文献[19]提高了3.4百分点。尽管OCLN模型在0 dB到18 dB的平均准确率达到了90.81%,但是OCLN基于IQ数据有着与其他文献方法一样的通病。图7为OCLN模型在0 dB信噪比的混淆矩阵。

图7 OCLN模型在0 dB信噪比的混淆矩阵

可以看出,在QAM16和QAM64之间的识别还不是很高。WBFM超过一半识别为AM-DSB,这些在高信噪比条件下也没有得到很好的改善。这也是总体的平均准确率不高的原因之一,另一方面信噪比在-6 dB以下低信噪比的识别效果较差。

3.5 基于AP数据的OCLN模型分析

通过将调制信号的IQ数据转化为AP数据,OCLN模型的识别准确率得到了进一步的提高。表4给出了OCLN模型在IQ和AP数据的各项平均准确率对比。

表4 本文OCLN模型在IQ和AP数据的平均准确率(%)

AP数据集下各项准确率指标分别提高了1.58百分点、2.40百分点和0.76百分点。虽然总体上提升不够明显,但可以进一步分析它在两种不同数据集上的混淆矩阵,挖掘基于AP数据给OCLN模型调制识别带来的作用。图8为信噪比为16 dB下AP和IQ数据的混淆矩阵。

(a) 基于AP数据的混淆矩阵

(b) 基于IQ信号的混淆矩阵图8 信噪比在16 dB下OCLN模型的混淆矩阵

除了WBFM信号外,OCLN模型在高信噪比下瞬时幅度和相位数据有着非常好的识别效果,OCLN在数字调制信号上识别准确率更是超过了99%。相比在IQ信号识别效果,OCLN模型在AP数据中对于QAM16和QAM64两者识别效果有着显著提升,对QAM16和QAM64识别率分别达到了98%和99%,相比IQ数据下分别提高了13百分点和11百分点。这也表明了转化后AP的数据相比IQ数据更有助于提高OCLN模型对于QAM16和QAM64的识别区分度,有效地解决了QAM之间的调制识别问题。但基于AP数据并没有很好地提高对WBFM和AM-DSB的辨别效果,只有2百分点的提升,而且还有53%WBFM的样本被识别为AM-DSB。

OCLN模型在信噪比不是很高的情况下就达到了很好的识别效果。图9是AP数据集信噪比为0 dB时候的OCLN模型的混淆矩阵。

图9 OCLN模型在AP数据集0 dB时的混淆矩阵

此时相对于IQ数据难以区分的QAM16和QAM64,其识别率就分别达到了96%和97%。虽然8PSK识别率只有87%,WBFM识别精度也还是有所欠缺,但是从图6可知0 dB时准确率达到90.43%。对于模拟调制信号AM-DSB和WBFM之间的区分,WBFM容易被识别为AM-DSB,虽然在高信噪比16 dB时准确率比在0 dB时提高了约8%,但WBFM依然难识别,这主要是由于音频的静音期所致,调制信号是从真实音频流中生成的。

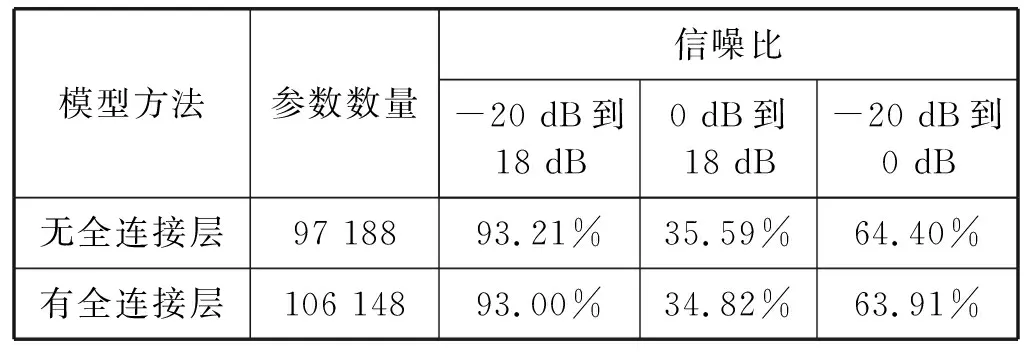

本文在OCLN模型全连接层的选择上进行了实验,实验使用了AP数据,有无全连接层的平均准确率和模型参数实验结果如表5所示。

表5 本文OCLN模型在有无全连接层的比较

添加了全连接层的模型参数要比无全连接层的要多,训练所用时长也相应要多。另一方面无全连接层的模型跟添加全连接层的准确率相差不大,甚至要好一点。在性能和效率平衡的角度上,本文放弃使用了全连接层。

4 结 语

本文先是基于信号的原始IQ数据,通过比较一些在自动调制识别领域经常应用的深度学习模型,选出能提取信号低维度特征的一维CNN和擅长于长时间的记忆LSTM网络,将两者结合,同时去掉参数冗余的全连接层,平衡了模型的性能和效率。与传统的模型以及改善性能的模型相比,本文的OCLN模型进一步提高了调制信号的识别能力。在此基础上,通过将IQ数据转化为信号的瞬时幅度和相位数据,OLCN模型显著提高了QAM的类间识别。应用于信号的瞬时幅度和相位数据,本文模型在信噪比大于0 dB时平均准确率达到了93.21%,高信噪比条件下数字调制信号识别率达到了99%。但该方法依然存在着模拟信号WBFM和AM-DSB识别不高的问题,如何进一步解决模拟信号的识别并提高模型的总体识别精度,将是下一步研究的方向。