基于EAST改进的任意方向场景文本检测

2021-11-08张焱杰林金朝蔡元奇

庞 宇,张焱杰,林金朝,蔡元奇

(重庆邮电大学 光电信息感测与传输技术重庆市重点实验室,重庆 400065)

0 引 言

提取视觉特征是计算机视觉领域的前提,无论是在目标检测[1]还是图像分类[2]中,提取图像特征都是最重要的步骤[3]。近几年,计算机视觉领域的技术突飞猛进,自然场景图片中文本信息的提取也应用于智能交通、图片检索以及可穿戴视觉系统等多个领域[4]。这一发展更是进一步推动了自然场景文本检测与识别技术的研究与发展。而准确检测出文本区域则是识别场景图片中文本的前提。

传统算法主要是通过人工设计如HOG(histogram of oriented gradient)、平均方向偏差等特征[5]进行训练,但整个算法过程繁琐,不但容易出现特征丢失或提取错误特征的情况,且最终模型鲁棒性较差。而与传统算法相比,基于深度学习的文本检测模型如全卷积神经网络[6]、SSD(single shot multibox detector)[7]等方法则可避免这些繁琐过程,通过训练后模型可自行提取特征。在过去的几年里,用于目标检测的深度卷积网络已经取得了巨大进展[8],Faster R-CNN算法的出现主要是减少了在候选区域提取上耗费的时间。输入整张图片后通过卷积层提取图片特征,通过区域生成网络(region proposal network, RPN)推荐候选区域后,再利用感兴趣区域池化(region of interest pooling, ROI pooling)将不同大小的输入转换为固定长度的输出,最终分类回归后得出最终结果[9]。以Faster R-CNN为代表的这类Two-stage网络模型一般都会先经过RPN网络滤去大多数背景样本,在下一阶段网络里负样本的数量会大量减少,减小了类别失衡带来的影响,提高了检测准确度[10]。但是这种模型方法计算量大,且对倾斜文本检测效果不好。而后续的EAST算法[11]的出现则弥补了这一缺点。EAST算法结构简单,不但利用特征金字塔网络(feature pyramid network,FPN)充分提取不同级别特征图,还利用了U-Net的思想逐步合并特征图减小计算量,最终生成为任意四边形的文本区域检测框。这类以EAST算法为代表的One-stage网络模型则摒弃繁琐中间过程,只用一级网络就获得文本框,虽然速度较快,但准确率却远远比不上前者。这2种方法的出现是文本检测技术发展史上的2个重大进步。并且特征金字塔网络[12]也是生成用于目标检测的金字塔特征表示的代表模型架构之一。

1 文本检测所面临的挑战

图1是对ICDAR2013数据集的统计结果。图1中,自然场景图像中绝大部分文本区域所占面积比例都小于3%,宽度大部分也集中在全宽的0~0.3,高度占比则集中在0~0.15,由此可以看出,自然场景图片中文本区域的占比普遍较小,且形状呈现为狭长状[13]。

图1 ICDAR2013数据库文本区域特征分析

与预测图像类别可能性的图像分类不同,自然场景文本检测在多种尺度和位置上检测和定位多个文本目标依旧是当前研究的重点和难点。此外,虽然EAST算法通过对语义上强但分辨率低的高级特征进行上采样,并且与高分辨率特征相结合用以生成语义强且分辨率高的特征表示,但是面对复杂场景文本的多样性,文本结构和尺寸的多样性,人为设计的FPN结构依旧可能不是最佳的体系结构[14]。近期也有许多著作[15-16]提出了各种跨尺度连接或操作用于生成金字塔特征表示。而在输出层,文本框的回归效果也并不理想。

针对这些问题,本文提出一种新的更加准确的文本检测模型。这种模型首先设计一个能够覆盖所有跨尺度连接产生多尺度特征的搜索空间,然后采用强化学习训练一个循环神经网络(recurrent neural network, RNN)控制器,并通过RNN控制器选出最优的FPN结构。再将其导入输出模块用广义交并比(generalized intersection over union, GIOU)来评估Bounding box增强文本框的回归效果,并通过对损失函数的修改保证正负样本类别均衡,最后获得最终文本检测结果。

2 任意方向文本检测模型

改进的自然场景文本检测模型如图2。本文所提出的文本检测模型主要分为2个模块:①采用NAS-FPN网络的空间特征提取模块,获取最优FPN结构;②将最终提取到的特征图通过若干1×1卷积核进行卷积操作,生成分数得分图和任意方向的矩形检测框图。但是在输出模块要通过GIOU算法指导文本框回归,提高文本框的回归效果,并通过Focal Loss保证正负样本类别均衡。

图2 改进的自然场景文本检测模型

2.1 NAS-FPN网络特征提取模块

通过图1对ICDAR2013数据集的分析可以得,自然场景图片中文本区域具有多尺度和多目标的特点,则将低分辨率、强语义的特征与高分辨率、低语义的特征通过自顶而下的路径和横向连接相结合构成的FPN结构就是场景图片特征提取的必然选择。又因为自然场景图片中文本区域所占面积只占很少比例,且形状大都为狭长状的结构特性与其他的目标检测中目标尺寸结构有很大不同,所以人工设计的FPN并不一定是最优的结构。此外,在不同尺度上融合特征的组合数也会随着网络层数的增大而增大,本文采用神经网络架构搜索的方式构建FPN。通过设计一个能够覆盖所有跨尺度连接,且能够获取多尺度特征的搜索空间,然后通过强化学习训练获取一个RNN控制器来选出最优的FPN结构。搜索的目标则是发现具有相同输入和输出特征级别并且可以被重复应用的微粒架构。通过模块化搜索空间的方式也可使得金字塔架构变得易于管理。

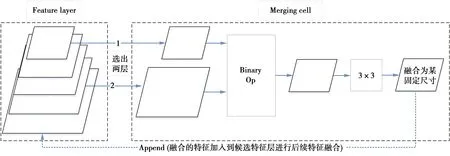

FPN网络的多种跨连接方式可以构成巨大的搜索空间。在搜索空间中,一个FPN网络是由许多的Merging cells组成,然后与那些通过不同特征层融合后得到的特征表示进行合并。其中的Merging cells是将来自2个不同级别特征层的特征图进行连接并融合后获取一个特征输出,而这样的单元结构就是构成FPN网络的元结构,然后所有可能的特征组合方式由Merging cells组建化表示后,就构成了本文所需搜索空间(模块化)。其中,Merging cell的结构如图3。

图3 特征融合过程

由图3可得,Merging cell中包含有3个过程:①需要从后选项中选定2个特征层;②选定输出特征的维度;③决定采用Sum或Global pooling,将①中被选定的2个特征层合并到特定尺度。这里的特征融合方式主要分为Sum和Global pooling 2种类型。

NAS-FPN网络是通过强化学习训练RNN控制器的方式在给定的搜索空间中选择出最优的模型架构。RNN控制器则是通过子模型在搜索空间中的准确度作为奖励信号来更新参数。通过反复训练后,控制器会逐步学习如何组合获取最优架构模型。其结构如图4。

图4 强化学习循环神经网络控制器过程

将RNN控制器预测一系列结果对应为一系列的操作a1:T去设计子网络。生成的网络在验证集上测试得到一个准确率R,将R作为反馈信号并使用强化学习机制训练这个控制器。为了优化网络结构要求控制器最大化它的期望,其计算公式为

J(θc)=EP(a1:T;θc)[R]

(1)

由于反馈信号是R不可微分的,所以使用policy梯度算法去迭代更新θc,其近似计算公式为

(2)

(2)式中:m是控制器训练过程中一批采样中不同神经网络体系结构的数量;T是控制器设计网络结构中预测的超参数的数量;Rk则是第k个神经网络训练完后在验证集上测试的准确率。当控制器生成一个网络结构后,用训练数据进行训练直到收敛,然后在验证集上进行测试得到一个准确率。生成网络结构的终止条件则是当网络层数达到一个值时就会停止。优化控制器RNN中的参数θc使得产生的网络结构能够在验证集上取得比较好的准确率。

NAS-FPN的优点之一是设计出覆盖所有可能的跨尺度连接的搜索空间,能够用来生成多尺度特征表示。并且在搜索过程中发现具有相同输入和输出特征级别并且可以被重复应用的微粒架构。模块化搜索空间还可以使搜索金字塔架构变得易于管理。此外,NAS-FPN网络模型可在任何给定金字塔网络的输出处获得特征金字塔表示,网络模型不需要完成所有金字塔网络的前向传递,提供了可以动态分配计算资源来生成检测的解决方案。由此,可以获取最优的特征金字塔网络结构提取文本区域特征。

2.2 GIOU

现存的文本检测方法中边界框的优化主要是通过减小边框(bounding box, BBOX)的回归损失。本文首先提出通过交并比(intersection over union, IOU)作为直接指标进行回归任务的训练。IOU作为目标检测的一个重要概念,在anchor-based的方法中,它既可以用于确定正样本和负样本,还可以用于判断预测框的准确性。此外,IOU还有个较好的特点就是对尺度不敏感。其损失函数为

(3)

LIOU=1-IOU

(4)

但是,直接用IOU作为损失函数会出现2个问题:首先,如果2个框不存在交际时,根据定义可得IOU=0,则不可以用于反映两框的重合度。此外当Loss=0时,没有梯度回传,也无法进行学习训练。再者,当IOU值相同,预测框的检测效果也可能存在差异。

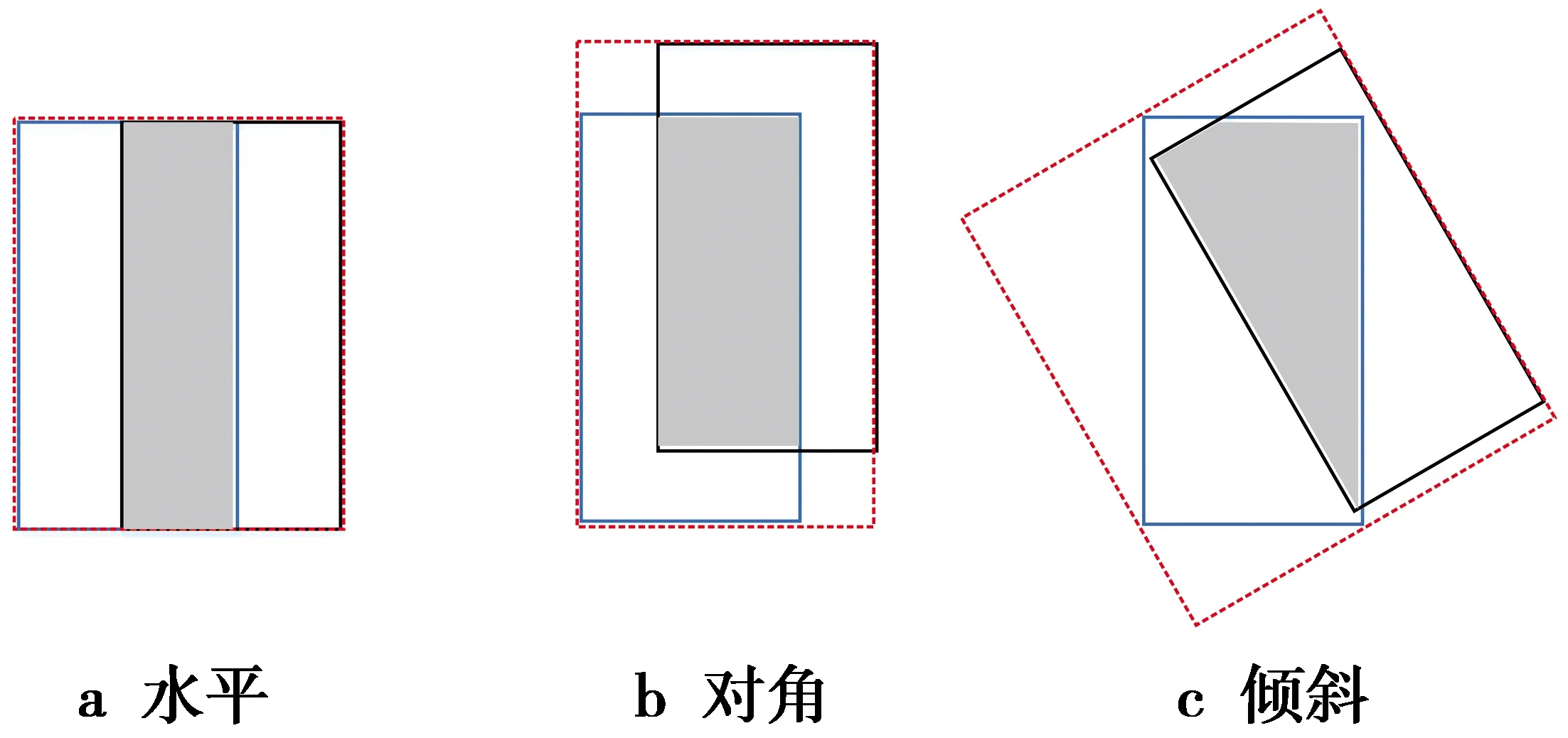

相同交并比值的预测框回归效果如图5。

图5 相同交并比值的预测框回归效果

如图5中,3种情况IOU值都相等,但也可以看出其回归效果也是存在差异的,图5a的预测框图回归的效果最好,图5c的最差。

针对IOU上述存在的弊端,本文提出使用另一个指标GIOU为

(5)

(5)式中,GIOU就是先计算A、B两框的最小矩形闭包区域面积C,通过IOU再计算得到闭包区域中不属于2个框的区域占总面积的比重,然后用IOU减去这个比重得到GIOU。当GIOU作为损失函数时,则LGIOU=1-GIOU,能够符合损失函数的基本要求。此外,GIOU对尺寸同样不敏感,GIOU作为IOU的下界,当2个框无限重合时,则IOU=GIOU。IOU取值为[0,1],但GIOU的取值为[-1,1]。当2个框完全重合时取最大值为1,在两者完全无重合时取最小值-1,由此可得,GIOU是一个特别好的距离度量标准。但是与IOU只计算重叠区域面积不同,GIOU不仅仅只计算重叠部分,还计算了非重合区域,由此才能更加准确计算两框的重合效果。此外,GIOU在文本检测时的计算方式同样简单,计算重合区域的方式和计算IOU值相同,而计算最小闭包区域则只需获得两者max和min坐标,坐标围成的最小矩形就是最小闭包区域。

2.3 类别平衡

类别失衡是指目标分类中不同种类的训练样例数目差别很大的情况。由于一张图片里Box为目标类别的样本数量有限,从图1对ICDAR2013数据集统计分析可知,大部分图像中文本区域只占整个文本图像的30%。因此,当检测器评估每个图像中文本区域的候选位置时,只有少数位置包含文本,训练样本就会出现类别失衡现象。

4种样例的示意图如图6,将计算损失的BBOX分为Positive和Negative 2类。当BBOX与Ground Truth间的GIOU大于上门限时(一般是0.5),会认为该BBOX属于Positive BBOX,如果GIOU小于下门限就认为该BBOX属于Negative BBOX。在一张输入图片中,目标所占比例一般都远小于背景占的比例,所以,2类BBOX中以Negative为主,且大多Negative BBOX不在前景和背景的过渡区域上,这种分类明确的Negative称为Easy Negative,而Easy Negative占大多数。这将引发2个问题:一方面,Negative BBOX过多造成它的损失值太大,以至于把Positive的Loss都淹没掉了,不利于目标的收敛;另一方面,Easy Negative训练时对应的背景类Score会很大,即单个BBOX的损失值很小,反向计算时梯度小。梯度小造成Easy Negative BBOX对参数的收敛作用很有限,因此,文本检测过程中更需要损失值大的对参数收敛影响也更大的BBOX,即Hard BBOX。

图6 4种样例的示意图

本文认为EAST算法检测效果不好的另一因素就是由于类别失衡导致的。因此,文本检测过程中需要尽量减小简单样本损失所占的比例,将置信度大于0.5以上的样本损失压低。

首先,二元分类的CE-Loss为

(6)

(6)式中,y=1代表正样本,而p值则是模型对带有y=1标签的类别的估计概率。为方便起见,定义pt为

(7)

CE(p,y)=CE(pt)=-log(pt)

(8)

为使正负样本所占的比例均衡,在CE-Loss前面添加一个参数α用于控制正负样本Loss所占的比例。

CE(pt)=-αtlog(pt)

(9)

此外,尽管α平衡了正负样本比例,但它并未区分简单/困难例子。在CE-Loss上添加一个调制因子(1-pt)γ,其中,γ≥0。本文将损失函数定义为焦点损失(focal loss, FL)。

FL(pt)=-(1-pt)γlog(pt)

(10)

损失函数变化曲线如图7。即为γ=0,1,2,5值时的焦点损失。

图7 损失函数变化曲线

CE损失可以看作是曲线1。由图7可发现,当示例分类错误并且pt小时,调制因子接近1,并且损失不受影响。当pt→1时,该因子变为0,并且对分类良好的示例的损失进行了加权。此外,聚焦参数γ平滑地调整了简单示例的权重。当γ=0时,FL等效于CE,并且随着γ的增加,调制因子的作用也会增加,且由图7可发现第3条线,即γ=2时效果最好。

直观地,调制因子减少了简单示例的损耗贡献,并扩展了示例接收低损耗的范围,使用Focal Loss的α平衡变体为

FL(pt)=-αt(1-pt)γlog(pt)

(11)

因为与非α平衡形式相比,它产生的精度略有提高。

3 实验结果与分析

3.1 实验环境与评价指标

本文实验是在Linux系统下,运用谷歌开发的Tensorflow深度学习框架进行实验,具体文本检测模型运行环境参数信息如表1。

表1 实验环境

由于ICDAR文本检测和识别竞赛都具有通用的文本检测评估标准和在线评估系统,本文分别在ICDAR2013和ICDAR2015数据集中与常见的自然场景文本检测方法进行对比,评价指标主要分为召回率(recall, R)、准确率(precision, P)和综合指标F。准确率是指被准确检测到的文本目标,而召回率则是指应该被检测到的文本目标。其计算公式分别定义为

(12)

(13)

(14)

(12)—(14)式中,D和G分表代表自然场景图片中文本检测区域和真实文本框区域。而参数tr,tp则是用于控制两者之间的匹配程度的,通常分别设置为0.8和0.4。Match则为D和G的匹配函数。

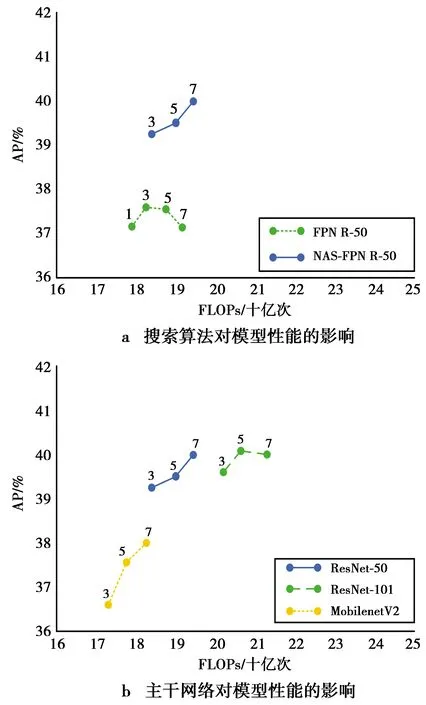

3.2 特征金字塔网络对模型性能的影响

金字塔网络具有很好的属性,可以通过堆叠多个重复的体系结构将其扩展为更大的体系结构。本文首先通过改变特征金字塔网络的个数,测试其对文本检测效果的影响,实验结果如图8a,标记上方的数字表示金字塔网络的数量。试验结果表明,堆叠FPN体系结构对模型性能提升效果不稳定,但堆叠NAS-FPN可以显著提高准确性。该结果突出表明,搜索算法可以找到可伸缩的适合于文本检测的金字塔网络体系结构。

图8 特征金字塔网络对文本检测效果的影响

另一方面,采用不同的骨干架构对金字塔网络的也会产生巨大影响,因此,通过改变骨干架构,分别以ResNet-50,ResNet-101以及MobilenetV2网络为主干架构进行实验对比,实验结果如图8b。实验结果显示了NAS-FPN在不同主干架构之上的性能,证明了该文本检测模型可以在不同架构之间良好地转移,但在ResNet网络上,文本检测效果更好。

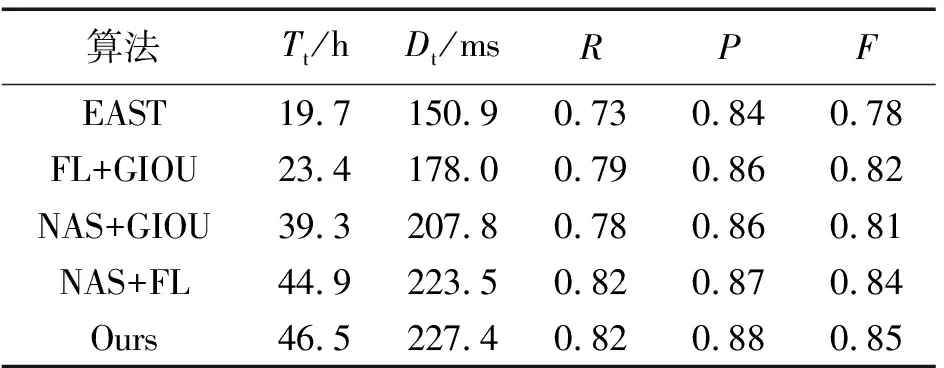

3.3 消融实验

本文所提出的文本检测模型主要是在3个方面对EAST算法进行改进。因此,本小节通过在ICDAR2015数据集上对模型进行消融实验,通过对比模型训练所需时间,文本检测所用时间以及文本检测效果,验证每个部分对模型性能的影响。其实验结果如表2。其中,Tt代表模型训练所用时间,Dt则代表检测文本所用时间。

通过对表2实验结果分析可知,NAS-FPN特征提取网络能够对算法的召回率和准确率都能进一步提升。Focal Loss解决了类别失衡问题,改善了目标检测过程中召回率偏低的问题。而GIOU算法则能够对文本检测的准确率进一步提升。但通过对比模型训练时间和文本检测所用时间,可发现NAS-FPN网络和类别均衡过程都会产生大量参数,增加模型复杂度,但对文本检测的准确率和召回率也能起到较大改善。GIOU算法虽产生额外参数较少,但对文本检测模型准确度提升也较小。

表2 各部分对实验结果的影响

3.4 文本检测效果对比

本文将改进后的模型与几种常见的文本检测算法分别在ICDAR 2013 和ICDAR 2015数据集上进行对比,通过采用不同数据集进行对比评估其适用性和泛化能力,对比结果如表3和表4。

通过对表3,表4的数据对比可知,本文提出的文本检测算法在不同数据集中均能达到较好的检测效果,面对复杂背景具有较好鲁棒性。但在ICDAR 2015数据集下文本检测效果更好,所以文本检测算法进行模型训练时,数据集越大,文本检测模型效果越好。

表3 与其他算法在ICDAR 2013数据集的对比

表4 与其他算法在ICDAR 2015数据集的对比

3.5 效果图展示

本文在ICDAR2015数据集中选择3张背景复杂度高,文本倾斜,且存在多种尺度共存的自然场景图片。然后分别在EAST算法改进前后的模型中进行实验,以此证明本文提出的文本检测算法性能相比于EAST算法效果得到了提升。实验结果如图9。

图9 文本检测效果展示

图9即为本文提出的文本检测模型与EAST算法在ICDAR2015数据集上的文本检测效果对比。从图9中可以看出,本文所提出的文本检测模型能够准确检测出水平方向和倾斜方向的文本区域,对长文本的检测效果也更加理想。本文的检测方法通过针对性的训练,可以更加准确排除非文本区域,提高最终检测结果的准确率。

4 结束语

本文通过对自然场景图片中文本区域特征的分析,在EAST文本检测算法的基础上,进行了改良,提出了一种新的自然场景文本检测方法。该模型主要包含NAS-FPN网络特征提取模块、输出模块部分。通过在输出模块的损失函数进行调整后在ICDAR 2015数据集中,本文提出的检测模型召回率、准确率和综合评价指标F值分别是0.82,0.88和0.85。并在ICDAR2013的标准数据集与几种常见的文本检测方法进行对比,可得本文检测方法在准确率上取得明显提升,达到了预想效果,由此可证明了本文模型的有效性。另一方面,本文提出算法在一定程度上增加了模型复杂度,因此,在下一步的研究工作中可进一步研究最优金字塔网络生成过程和类别均衡过程,在保证准确率的前提下,优化模型复杂度,提高模型效率。