基于激光雷达与红外图像融合的车辆目标识别算法

2021-11-05战荫泽张立东

战荫泽,张立东,秦 颖

(长春理工大学光电信息学院,吉林 长春 130000)

1 引 言

目标识别技术广泛应用于军事、工业等领域,常见的目标识别的方法有激光雷达、红外成像[1-4]等。基于激光雷达的主动成像技术具有分辨率高、可获取距离向信息等优势,但由于目标表面反射效果不同,照射角度、遮挡等都会对测试数据带来很大的影响[5-6];基于红外成像的目标识别主要取决于被测目标辐射特性,照射角度、遮蔽等对目标识别结果影响小,但其空间分辨率低,没有距离向信息,无法实现目标三维图像重建[7-8]。

针对激光雷达数据中的目标识别成为了一个研究热点,Cao L H[9]提出了一种基于辐射能量守恒的单点目标辐射特性测量的优化算法,提高了单点目标的识别概率。Kumar等人[10]通过对特征数据分配权值的方法构建分类器,从而优化分类规则,最终实现了提高组合分类效率的目的。杨帆等人[11]将数据挖掘算法应用于激光雷达图像中完成目标识别,相比传统目标识别算法,提高了目标检出率。李春苗等人[12]对激光雷达数据进行特征提取,从而降低了目标的误检率。薛培林等人[13]通过激光雷达与可见光图像融合技术完成了城市中自主车辆识别技术,在可见光充分的条件下得到了很好的应用。仝选悦等人[14]将激光雷达数据融合到红外图像中,并对三种典型坦克目标进行了分析,结果显示其识别精度得到了提升。由此可见,基于激光雷达与二维成像的数据融合是提高目标识别精度的一种新途径,其优势在于可以利用工作机理的不同抑制不同类别的噪声及干扰,从而提高目标识别精度。

本文将红外图像与激光距离向图像进行配准,然后以待测区域中的目标红外特征区域作为限定条件,结合待识别目标的先验知识,完成噪声抑制和目标提取。该算法适用于目标与背景存在光谱特征差异的待测目标,具有很好的鲁棒性。

2 数据特征的表达

目标的特征提取是目标识别的先决条件,目标特征的提取规则直接影响了噪声的抑制效果。融合红外图像特征与激光雷达距离向图像特征的提取方法可以兼容两种方法的优势,实现对不同类型噪声的有效抑制。

2.1 红外特征

采用小波不变矩提取红外图像数据特征,设图像函数为g(x,y),其笛卡尔坐标系中(s+t)阶原点矩Mst有:

(1)

其中,s和t的取值范围是非负整数;x和y是图像直角坐标系中的二维位置,其极坐标关系可以表示为:

(2)

将式(2)带代式(1)可得:

(3)

由此获得红外图像中用于表征目标的原点矩参量,即红外特征的表达。

2.2 激光雷达点云特征

利用标准目标模型的点云距离特征与激光雷达测试点云进行配准拟合分析,为了获取识别被测目标。虽然实测过程中存在遮挡等会造成数据不完整,但目标点云结构中存在相应的位置特征关系,仍可以用于判断,判断依据为匹配相似度F(x,y),其可表示为:

(4)

其中,p(x,y)为测试点云投影得到的图像;T(x,y)为模板图像;x和y分别表示图像的横轴和纵轴坐标值;X和Y表示最大值。F()为匹配相似度,Ft为预设的相似度阈值。当F(x,y)

3 算法设计

当激光雷达系统与红外系统采用共光路设计时,就可以认为其图像经平移、旋转、尺度对齐就能够实现图像匹配了。图像配准步骤有:

(1)将激光雷达图像与红外图像的基准坐标进行对齐,从而使两组数据使用相同坐标系。设激光雷达系统测试距离为d,激光雷达图像在x轴和y轴上的视场角和长度分别是θx、Mx和θy、My。红外图像在x轴和y轴上的视场角和长度分别是φx、Nx和φy、Ny。由此激光雷达距离分辨率可表示为:

(5)

红外图像的距离分辨率可表示为:

(6)

(2)依据图像范围,计算图像之间的尺度变换因子,完成图像尺度换算。对两类图像得分辨率进行计算可以将图像之间的尺度关系求解出来,从而用该尺度关系完成图像之间的尺度变换,x和y轴两个方向的比例取值有:

(7)

由此可见,要实现两类图像的配准,在将两组图像中心对准的基础上,将待配准图像乘以相应的尺度变换因子即可。

(3)在激光雷达图像中寻找目标特征点,从而以对齐的坐标原点为中心将激光雷达图像匹配到红外图像的相应位置上,完成图像融合。

4 算法实现

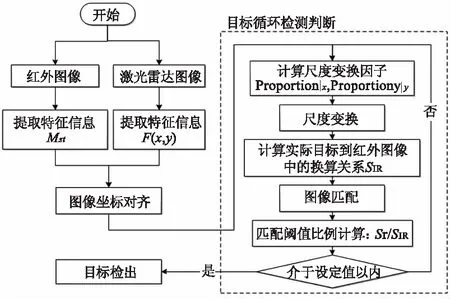

若红外图像的尺寸IIR=X×Y,目标尺寸为I目标=X目标×Y目标,设检测目标的实际尺寸为S实际=x×y,则红外图像中的尺寸为SIR=(X目标/X)x×(Y目标/Y)y。则SIR可以作为滤波函数的边界条件。故算法流程如图1所示。

图1 目标识别算法流程图Fig.1 Flow chart of target recognition algorithm

算法流程中主要分为两个部分,左侧为数据采集与识别结果输出,对输入的红外图像和激光雷达图像进行图像信息采集,再提取相应的特征信息;右侧为目标循环检测判断部分,用于完成对符合目标特征但信息不完整的目标图像进行筛选,实现目标增强并消除伪目标。工作步骤如下:

(1)红外与激光雷达图像数据采集;

(2)完成图像特征提取,获得Mst和F(x,y),实现对目标特征信息的采集;

(3)图像坐标对齐,包括原点重合和轴系对齐;

(4)计算x和y轴的尺度因子,完成尺度变换;

(5)计算实际目标与红外图像之间的换算关系SIR;

(6)完成图像匹配;

(7)利用匹配比例阈值完成对整个图像中所有目标的筛选。

5 实验与结果分析

5.1 测试结果

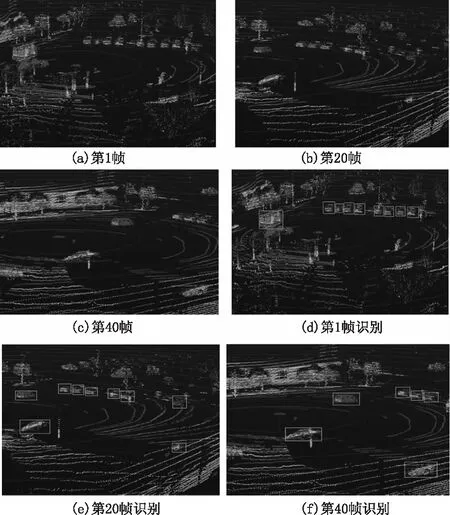

为了验证激光和红外融合目标检测算法的性能,首先测试地面移动目标汽车的红外图像和激光图像数据。图2(a)~(c)分别示出了帧1、20和40的检测结果。图2(d)~(f )分别示出了帧1、20和40的检测和识别结果。

图2 汽车目标识别算法对比图Fig.2 Comparison of cars target recognition algorithms

由图2(a)和图2(d)、图2(b)和图2(e)和图2(c)和图2(f )可以看出,不同帧采集的激光雷达图像与红外图像融合后按照特征条件可以将汽车目标进行有效提取。由图2(a)、图2(b)和图2(c)可知,由于采集帧图像是发生在不同时刻的,所以虽然是针对同一个区域采集的,但是图像发生了变化,其中第1帧中没有的汽车目标是后来运动驶入的,而第20和40帧中采集到了,并且在图2(e)和图2(f )实现了目标识别。可见算法具有数据实时更新迭代的能力。对比图2(a)和图2(d)可知,其中从左向右第一辆汽车存在树叶遮挡,单纯的红外二维像是不能有效识别的,但由于采用了激光雷达点云特征的边界条件,将目标与树叶在二维图像中进行了分离,故目标被有效识别。对比图2(d)和图2(e)可知,其中一辆目标车由于激光雷达照射角度问题使其在图2(d)中仅获取了一个反射面的融合图像,这是由于激光雷达照射角度导致的数据丢失,如果仅采用激光雷达图像会导致漏检,而融合图像中该目标由于符合红外目标边界条件,故被有效识别。由此可见,本文所使用的激光和红外融合目标检测算法可以有效地提高目标识别效率,适应不同测试环境造成偏差。

5.2 测试数据统计对比分析

为了验证算法的普适性,实验将1000帧图像数据的目标识别结果进行了统计分析。假设在测试过程中,车辆目标静止且无遮挡的情况为条件A,车辆目标静止存在小于总面积1/3的遮挡的情况为条件B,车辆运动且无遮挡的情况为条件C,车辆运动且存在小于总面积1/3的遮挡的情况为条件D。测试数据分别采用激光雷达目标识别算法(距离向数据分类)、红外成像目标算法(光谱谱段数据分类)以及本融合算法对四类目标进行提取与识别,并通过漏检率(目标存在但未被检出的次数与总检测次数的比值)与误检率(并非目标而被误判为目标检出的次数与总检测次数的比值)对三种识别方法进行评价,测试结果如表1所示。

表1 车辆目标测试结果分析Tab.1 Analysis of vehicle target test results

由表1数据可知,当测试为条件A时,三种测试方式的漏检率和误检率相近,都能够很好地完成目标的识别;当测试为条件B时,光谱分类法的漏检率显著增大,即仅以光谱分类的目标识别受到明显影响。分析认为虽然目标仍为静止,即数据采集比较稳定,但由于存在部分遮挡,待测区域的光谱交叠程度增强,故造成目标分离困难,从而漏检率与误检率的大幅增加。相比之下,由于仍是静态,基于激光雷达的距离向数据分类法要略优于光谱分类法;当测试为条件C时,虽然不存在遮挡但是由于目标运动,故使数据采集存在抖动误差,此时可以看出,距离向数据分类法受影响较大,分析认为是由于车辆运动使不同帧的点云拼接存在较大误差造成的;当测试为条件D时,由于目标在移动,同时还伴随部分遮挡,故两种传统识别方法的漏检率均超过20.0 %,误检率也大幅增加,超过10.0 %。在整个四种条件下,本融合算法的漏检率均小于10.0 %,误检率均小于5.0 %,检测效果随环境条件的复杂而有所降低,但总体测试效果明显优于传统方法,对不同测试条件具有更好的鲁棒性。

6 结 论

本文针对目标静止、存在遮挡等不同测试条件下目标识别效果下降的问题,提出了一种基于激光雷达与红外图像融合的车辆目标识别算法。该算法将点云特征与红外特征进行图像融合,再通过目标匹配阈值迭代的方式降低系统漏检率与误检率。结果显示,在1000帧图像分组实验中,本算法的漏检率均小于10.0 %,误检率均小于5.0 %,明显优于两种传统算法,具有更好的应用价值。