高比例光伏微网无功均分控制中的Q 学习方法

2021-09-24史建勋张冲标宣绍琪高丽青

史建勋,张冲标,吴 晗,宣绍琪,高丽青,沈 珺

(1.国网浙江嘉善县供电有限公司,嘉兴 314100;2.南京理工大学自动化学院,南京 210094)

随着工业化进程的向前,国内外电力建设的发展日渐强盛,大规模风能、光能等新能源以分布式电源的形式并网,使得电网更加复杂化、先进化,同时,电网的安全稳定运行面临着更严峻的考验,以光伏PV(photovoltaic)发电为代表的新能源分布式发电DG(distributed generation)技术的有力推广正在快速推进微电网发展成未来能源互联网的重心[1]。微电网能对分布式电源有效控制和灵活管理[2],是现代智能电网的关键组成部分。

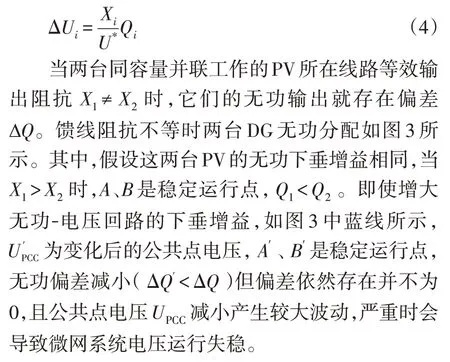

微电网有脱网工作和并网工作两种模式[3]。微网在并网运行状态时,频率和电压由主网决定,容易实现功率均分。当微网脱离主网独立运行时,并联运行的DG为了有效、合理分配功率,一般都采用下垂特性控制[4-6]。系统线阻不一致时,会引起传统简单下垂控制下DG输出的无功功率有偏差。偏差过大时会产生微网内无功环流,甚至致使系统运行失稳。微网中受接入高比例光伏后的影响方面不仅涉及到并网节点处电压波动,还涉及到输送功率的波动,往往会使得负荷电压也产生变化。用户光伏通常分散接入微电网的各节点,其并网功率若不能完全被本地负荷利用将会导致反向潮流和电压升高[7-8]。越高比率的户用光伏接入微网中,系统内的反向潮流就越明显,则节点电压升高甚至越限,微电网系统损耗显著增加[9]。因此,必须实现精确的无功功率均分,抑制无功环流,从而维持孤岛交流微电网稳定运行。

通过调节微电网中各分布式电源无功功率平均分配来抑制系统无功环流和提高电压质量是保障电网安稳运行的决定性举措之一。深远探究无功均分技术是促进孤岛交流微电网发展不可或缺的使命,能带来不可小觑的经济效益和社会效益。为了克服传统下垂控制下无功分配不均的弊端,文献[10]对逆变器下垂系数进行自适应修正,传送基准逆变器的输出功率到别的逆变器进行输出有功、无功功率的作差,进而改变各自对应的下垂系数,最终实现DG输出功率平均分配。但是该方案必需DG 间连接信息进行调节下垂系数,并要求有一定的通信带宽;文献[11]介绍了一种考虑复阻抗影响的下垂控制方案,具有高效的动态性能,最终实现了高精度的功率均分,但是增加DG 输出阻抗后会造成较大的电压偏差;文献[12]提出了一种基于本地信息精确辨识线阻实际值的线路观测器,利用该辨识值补偿线路电压降,实现DG 输出无功均分。但是该方法不能应用在网状、多维度等复杂微电网结构中。

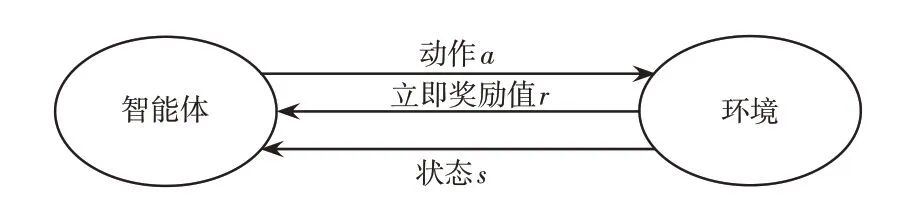

强化学习算法是一种人工智能算法,不依赖具体的数学模型、全局搜索能力强、应用简单,适用于解决非线性、离散、大规模的问题,广泛应用于电力系统优化等多领域。Q学习是目前应用最为广泛的强化学习算法,具有所需参数少、可以采用离线实现方式、收敛到最优策略等优点。由此,为了改进无功分配不均并控制电压在合理范围内,本文提出一种高比例光伏微网无功均分控制中的Q学习方法,借助其渐进学习寻优特性,对孤岛工作的微电网无功电压控制过程进行优化,获取系统最佳控制策略,实现对高比例光伏孤岛微电网的无功均分,并保证算法具有一定的鲁棒性。

1 微网控制理论基础

1.1 孤岛运行微网的结构

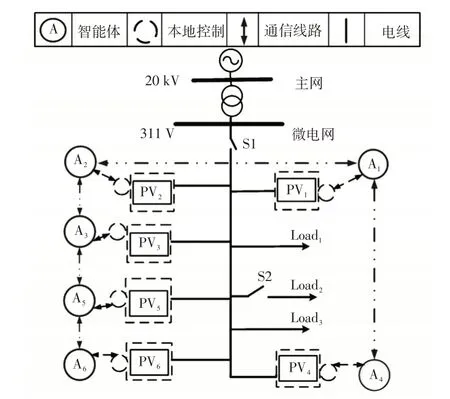

如图1 所示,含高比例光伏孤岛运行的微网结构中包含了分布式光伏、负荷以及储能单元。

1.2 传统下垂控制理论

图1 的简化形式等效为如图2 所示的系统结构[13]。

图1 微电网的结构Fig.1 Structure of microgrid

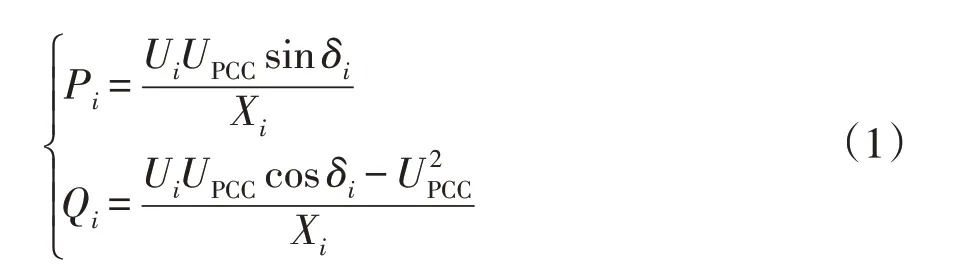

图2 中的分布式电源逆变器的接入点连接LC滤波器,忽略线阻可近似视作感性的线路参数。第i个PV向公共母线输送功率为

图2 微电网的等效结构Fig.2 Equivalent structure of microgrid

式中:UPCC为在各PV并联公共连接点PCC(point of common coupling)量测到的电压幅值;Ui为PVi输出的电压幅值;δi为PVi输出电压的相角与PCC电压相角的差;Xi为PVi到PCC等效的电抗。

PVi的下垂控制方程为

式中:U为参考电压;fi为PVi输出频率;f为系统参考频率;kp和kq为相应下垂系数。

根据图2可得

式中,ΔUi近似视作PVi所在馈线的电压降落,忽略线阻Ri可表示为

图3 馈线阻抗不等时两台DG 无功分配Fig.3 Reactive power sharing of two DGs with unequal feeder reactance

1.3 Q 学习算法

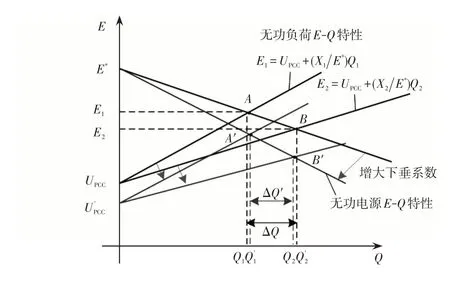

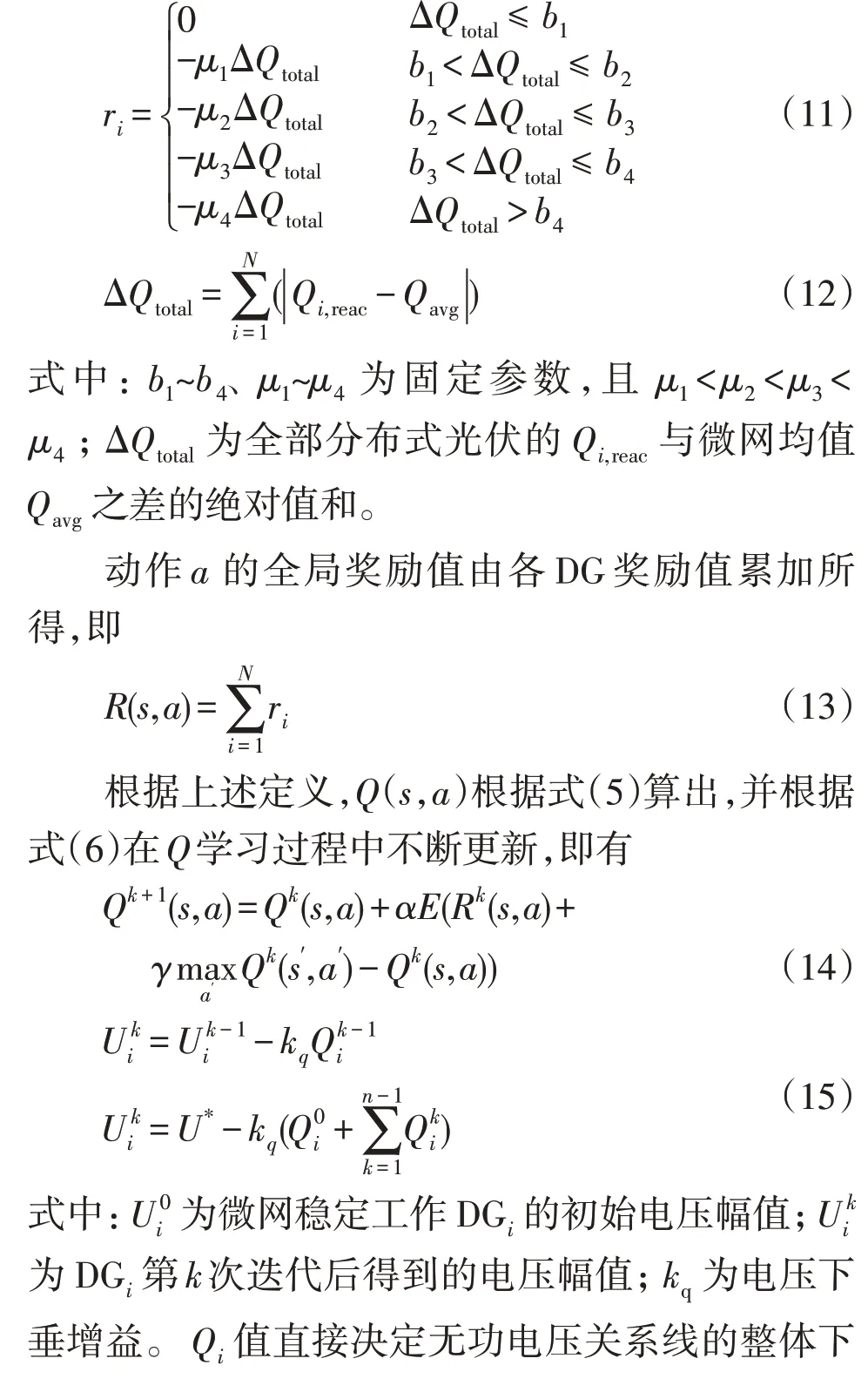

强化学习的两大主体是智能体与环境,智能体一直探索所有可能的动作,每次动作后给环境一定奖励值作为动作的反馈,依据某种动作选择策略在彼此的交互过程中渐趋得到最优控制方案。智能体动作选择依据是最大化其累计期望奖励值。基本模型如图4所示。

图4 强化学习基本模型Fig.4 Basic model of reinforcement learning

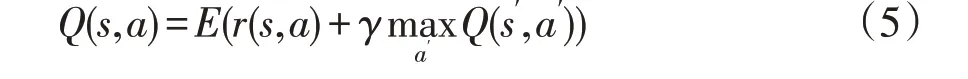

Q学习是由Watkins提出的一种与模型无关的强化学习算法,是一种基于值函数迭代的在线学习和动态最优技术。比强化学习中的Sarsa、Sarsa(λ)、深度Q学习DQN[13](deepQ-learning)等算法,Q学习算法具有所需参数少、架构简单、预学习简单等突出优势。Q学习法作用于状态-动作对对应的值函数Q(s,a),该值函数的含义是在状态s时采用动作a后所得累计奖励,表示为

式中:s为当前时刻状态;s′为动作后的新状态;a、a′为各自状态中采取的动作;γ为折扣率,γ∈[0,1],当γ=0 时,系统只考虑立即奖励;当γ=1 时,长期奖励和立即奖励地位一样。可以通过在线学习获得上述的Q值。

进入新状态后,得到奖励值反馈并更新Q值。其更新公式为

式中:Qi为第i次迭代的Q值;α为学习因子,0<α<1。α较大,算法的收敛速度快,而α值较小,则能保证算法有一定的搜索空间,提升了算法收敛稳定性。

在Q学习过程中,Q值不断进行更新一直到稳定收敛为最大Q*(s,a)为止。对于每个系统状态一般使用贪婪选择策略进行最优动作a*,即有

2 基于Q 学习的高比例光伏孤立微网无功均分协调控制策略

光伏逆变器的无功控制是一种有效的电压调节手段,相比控制光伏有功、分布式储能有功以及分接头设备等,该方案控制经济性最优。

2.1 环境状态集S 定义

微网中各分布式光伏发出的无功功率视作环境状态。无功偏差ΔQreac可以划分为一系列的离散区间,如{ΔQ1,ΔQ2,…,ΔQm},其对应的状态集S为{s1,s1,…,sm}。每个DG的状态集表示为

式中:Qi,reac为PVi的无功输出;Qavg为微电网稳定运行时平均无功;Qload为系统无功负荷;N为分布式电源总数。显然,集合S设置元素越多,微网运行状态就划分的越细密越精度高;然而集合中元素数过多,会大大拉长学习周期,进而影响在线分析控制。

2.2 动作集A 定义

当交流微电网脱离主网,稳态工作状况下的频率是一个全局量,并联运行的分布式光伏有功功率输出依据下垂系数精确分配,即有功与等效阻抗无关。考虑到输出电压是局部变量,各PV 间的无功偏差则由PV 输出电压幅值差、线阻差以及微电网结构等因素决定。本文中无功电压下垂控制动作集A含义是:使微网当下时刻的某状态s过转变到更佳状态s′的动作策略的集合。故每个PV的动作集定义为

式中:ajj=kqQjj,jj∈{1,2,…,L};L为动作数目。

2.3 奖励函数R 和Q 值函数的定义

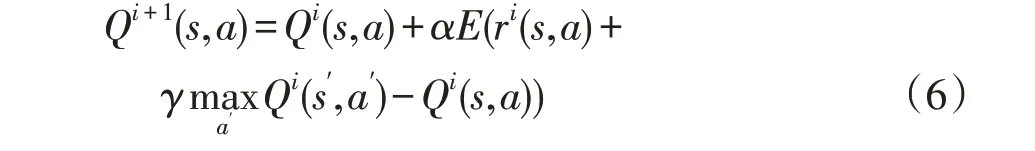

动作执行后的立即奖励值会直接影响Q值,而Q值大小可以直接体现所选动作执行效果的好坏。对于考虑电压不越限的无功均分问题,执行基于Q算法所选动作后,会产生两种差异显著的结果:一是系统仍存在未实现无功均分,说明Q学习还未完成,为此,将总无功偏差ΔQtotal对应的奖励值ri设置为负值,即进行惩罚。二是系统实现无功均分,对此,将ΔQtotal对应的奖励值置0。

使用ΔQtotal定义奖励值,则有

2.4 无功均分控制策略流程

传统下垂控制下微电网无功不均分,就需要本地无功电压控制器下垂算法进行改进。微网进入新的稳态后,系统内无功偏差将减小。为使Q值较快收敛,保证较快速地跟踪微网实时状态,本文将式(2)中α设为0.9。又考虑到系统状态在迭代过程时前后两次状态交互影响小,令γ=0.1。无功均分流程如图5所示。

图5 基于Q 学习的无功均分控制过程Fig.5 Reactive power sharing control process based on Q-learning

智能体一直监测微网状态,当无功功率不均分,智能体则根据当前策略选出最优动作作用于所辖微网进行控制,再根据Q值最大时对应的动作转变到新状态,并更新策略和下一步的动作。该Q学习过程如此反复,直到所辖区域内实现基于高比例光伏微网无功电压下垂控制下的无功均分效果的最佳化为止。

3 算例分析

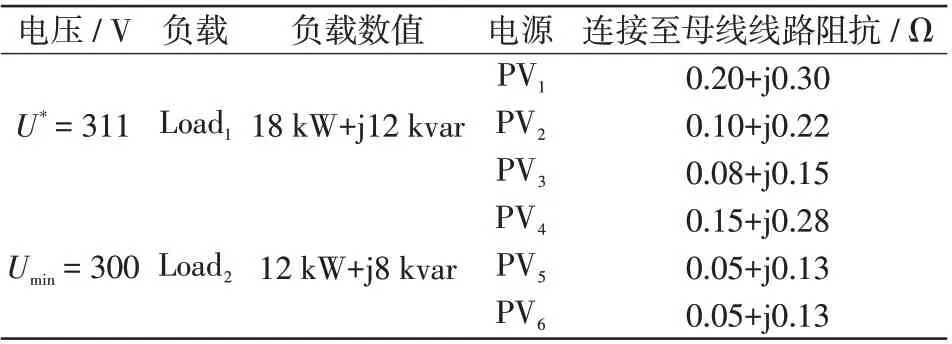

以图6 所示的微电网为例,验证所提方案的有效性和正确性。微电网电压等级为311 V。6 个光伏的有功、无功容量相同。在节点1、2、4、5处分别连接了户用光伏发电,出力均为kW 级。其余各节点为负荷节点。图6 中各光伏连接至母线的线路阻抗不完全相同,系统仿真参数见表1。其中,各PV逆变器的电压-无功下垂系数都是1×10-6。

图6 含高比例光伏的微电网Fig.6 Microgrid with high-proportion photovoltaic

表1 系统仿真参数Tab.1 Simulation parameters of system

3.1 场景1:正常运行

在场景1 中,在0~0.3 s 时间t内6 个PV 工作在传统下垂模式下正常运行,稳态时,PV1~PV6输出的无功功率分别为2 238、3 394、4 068、2 211、3 918、3 918 var。显然,无功不均分产生无功偏差,而有功功率自行均分。

6 个PV 的出力分配仿真结果如图7 所示。在t=0.3 s,采用本文的无功均分控制策略,各PV无功偏差逐渐减小;在t=0.6 s 输出无功基本相等都为3 350 var,实现无功均分。在Q学习策略下,每个PV选择最大Q(s,a)值对应的最优电压变化量进行动作,并反馈到其下垂控制单元里,从而使无功输出一致,减小了系统内的环流,保证了微网运行的稳定性。

图7 场景1 仿真结果Fig.7 Simulation results under scenario 1

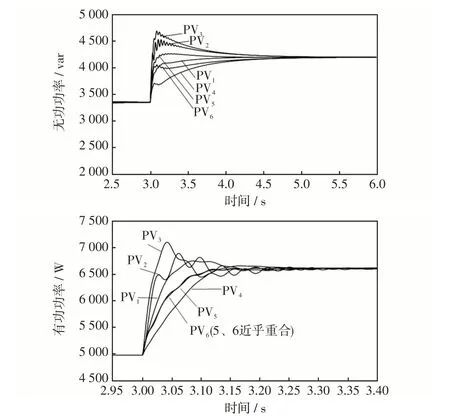

3.2 场景2:系统负荷突变

系统中负荷1 和2正常工作,在t=3 s 时,给系统增加负荷Load3= 10 kW+j5 kvar,并采用本文的无功均分控制策略,仿真结果如图8 所示。可知,在t=5 s时系统状态又一次稳定,再次实现无功均分为4 192 var。在Q学习策略下,各PV将最大Q值对应最优电压变化量反馈到其下垂控制单元里控制电压幅值,再通过无功均分策略环节使无功输出达到一致,减少系统环流,保证了系统运行的稳定性。而有功功率出力在3 s时受到扰动后很快自行均分,并不受扰动影响。

图8 场景2 仿真结果Fig.8 Simulation results under scenario 2

场景2 验证了所提方法能提高微网运行场景变化下的适应性。如果Q学习采集到的状态值即无功偏差量越多,Q表能训练得更完善,从而能更好更快地实现对微网的无功均分控制。

4 结 语

本文提出了一种高比例光伏微网无功均分控制中的Q学习方法,利用强化学习的在线学习优点和良好的收敛特性,以系统总无功偏差设计的奖励函数作为电压幅值和无功功率之间的反馈量,根据最大Q值对应的动作控制输出电压的变化,进而控制无功功率,最终实现无功均分。该策略减少了系统无功环流,提高了系统运行的稳定性,并具有一定的控制鲁棒性。最后通过对含高比例光伏微网系统的仿真,验证了方法的有效性。