基于混合3D-2D CNN的多时相遥感农作物分类

2021-09-16卢元兵李华朋张树清

卢元兵,李华朋,张树清

基于混合3D-2D CNN的多时相遥感农作物分类

卢元兵1,2,李华朋1※,张树清1

(1. 中国科学院东北地理与农业生态研究所,长春 130102;2. 中国科学院大学,北京 100049)

准确的农作物分类图是农业监测和粮食安全评估的重要数据来源,针对传统的深度学习模型在多时相农作物遥感分类方面精度较低的问题,该研究将卷积维度单一的卷积神经网络(Convolutional Neural Networks,CNN)进行改进,提出了一种混合三维和二维卷积的神经网络识别模型(Hybrid Three Dimensional and Two Dimensional Convolutional Neural Networks,3D-2D CNN)。该模型首先通过多个三维卷积层提取时空特征,其次将输出的特征降维压缩后通过二维卷积层执行空域特征分析,最后将高层特征图展平后通过全连接层进行类别预测。试验以Landsat8多时相影像为数据源,将美国加利福尼亚州北部研究区的地块按照2:2:6分层随机划分为训练集、验证集和测试集。试验结果表明3D-2D CNN对13种农作物分类的总体精度(89.38%)、宏平均1值(84.21%)和Kappa系数(0.881)均优于三维卷积神经网络(Three Dimensional Convolutional Neural Networks,3D-CNN)、二维卷积神经网络(Two Dimensional Convolutional Neural Networks, 2D-CNN)、支持向量机(Support Vector Machines,SVM)和随机森林(Random Forest,RF)等方法,并在参数量和收敛时间方面比3D CNN大幅度减小。同时,在较小样本训练集下3D-2D CNN仍表现最优。该模型综合利用空间-光谱-时间特征并具有较高的分类精度和较强的鲁棒性,这为解决多时相遥感农作物分类问题提供了一个有效且可行的方案。

遥感;农作物;多时相地块;分类;深度学习;卷积神经网络

0 引 言

农作物的种植类型和空间分布是表征农业资源合理利用的科学指标,也是农作物种植结构的综合反映[1]。传统的农作物种植类型制图主要采用人工实地调查的方法,该方法易受主观因素影响,并且不能动态监测农作物种植类型的变化。遥感影像能够提供及时准确的农作物空间分布、长势以及产量等农业信息,为数字化精准农业提供基础数据[1]。随着遥感卫星采集影像频率的提高,多时相地球观测能力在农作物监测中发挥着越来越重要的作用,如何充分利用密集多时相数据中隐含的物候规律显得越来越重要[2]。因此,及时了解农作物种植结构对于调控农产品市场、辅助决策和保障农业可持续发展具有重要意义[1]。

基于遥感影像的作物或植被分类,通常有两种方法。一种方法是将光谱带聚合成代表植被物理特性的植被指数,其中归一化植被指数(Normal Difference Vegetation Index,NDVI)是最常用的方法;二是直接利用原始多时相图像进行分类[3]。Guerschman等利用多时相Landsat TM数据对土地覆盖进行分类,结果表明利用原始图像比NDVI可以获得更高的精度[4]。光谱、空间和时间特征是遥感提取农作物种植类别信息的基础[5]。季节性是农作物最显著的特征之一,多时相遥感是监测农作物生长动态并进行分类的有效途径[6]。随着遥感技术和大数据分析技术的快速发展,国内外学者使用不同空间分辨率的遥感数据,从特征筛选、分类器选择和参数优化等方面,对农作物类型空间分布开展了广泛的研究[1]。支持向量机(Support Vector Machines,SVM)、随机森林(Random Forest,RF)等浅层机器学习算法经过的非线性变换组合层较少,受特征工程(Feature Engineering, FE)影响较大,对影像中复杂异质特征的分辨效果较差[7]。近年来,深度学习被认为是机器学习和数据挖掘(包括遥感)研究领域的一项突破性技术,由于它具有对特征的层次化表示、高效率运算以及端到端地自动化学习等优点,因此它逐渐成为图像模式识别领域的主流算法[8]。卷积神经网络(Convolutional Neural Networks,CNN)是深度学习方法中最成功的网络结构之一,研究表明在大多数图像分类问题中CNN比其他模型表现更好[9]。对于多时相遥感影像或时间序列NDVI,3D CNN特别适合提取农作物生长的动态特征,并优于2D CNN、SVM和最邻近分类等主流方法[3]。国外学者基于多光谱时间序列数据比较了CNN、递归神经网络(Recursive Neural Network,RNN)和混合神经网络(CNN+RNN)的分类性能,并得出效果最好的方法是混合配置网络的结论[10]。Li等借鉴了自然语言处理(Natural Language Processing,NLP)知识中的transformer结构来挖掘多时间序列模式,提出了一种显著提升农作物分类精度的混合模型CNN-transformer[2]。Gadiraju等提出了联合利用空间、光谱和物候特征来识别农作物类型的多模态深度学习方案,使得预测误差降低60%[11]。国内部分学者的研究表明一维CNN为长时间序列遥感图像农作物种类识别提供了一种有效且高效的方法[12]。解毅等认为长短时记忆网络(Long Short-Term Memory,LSTM)对多源遥感数据融合的时序NDVI进行农作物分类优势明显[13]。深度学习的主要优点是能够有效地逼近高度复杂的问题,而不需要预先进行特征工程[9]。遥感图像能够提供动态或时间信息,虽然已有研究在农作物遥感理论、技术方法和实践应用方面取得了显著的进展[14-15],但是二维CNN缺乏准确提取三维特征的能力,在第三个维度(即时间维)提取的信息被平均化并折叠为标量,因此没有充分挖掘该维度特征[8]。三维卷积的结构设计非常适用于时空表示,然而3D CNN计算复杂度高,参数较多不易被训练[8],而且单独处理多光谱波段上具有相似纹理的类时表现不佳[16],因此3D CNN在分类中的应用相对较少。

农业区作物景观的异质性和破碎化,使得以田块为单元的农作物对象特征不易于被中低分辨率影像有效地捕捉,因此增加了错分地可能[1]。针对农作物分类过程中时间序列遥感信息利用不足、中分辨率影像地物特征表现相似,以及多数研究以较少农作物类别提取为主等问题,本文基于混合3D-2D CNN对多时相遥感影像进行农作物分类,探讨模型的优化流程,分析时间信息和纹理信息在模型分类中的作用,为深度学习使用较少训练样本对多种混合农作物分类提供新思路。

1 研究区与试验数据

1.1 研究区概况

加利福尼亚州是美国一个高产的农业州,其农作物种类丰富,农业收入全国排名第一(https://www.cdfa.ca.gov/ statistics/)。研究区域位于美国加州西部,主要由Solano县北部和Yolo县东部大部分地区,以及Sacramento县西部和Sutter县南部小部分地区构成(图1)。研究区地理坐标范围为38°11′9″N~38°55′25″N,121°23′44″W~122°4′3″W,地势平坦,范围约覆盖4 650 km2。该地区属地中海气候,夏季炎热干燥,冬季凉爽,7月最热,12月最冷,土壤层较厚,灌溉条件理想,年平均降雨量500 mm以下,多发生在春、冬两季,是加州降雪最少的地区之一(https://www.bestplaces.net/climate/county/california/solano)。该研究区农业景观类型主要为耕地(包括旱地、稻田、果园和菜地)、草地、裸地、聚落和水体,农业景观以灌溉农业为主(例如苜蓿和水稻作物),并形成了小麦、玉米和其他谷物轮作,以及番茄、紫花苜蓿、红花、向日葵等轮作两种常见的方式(https://aic.ucdavis.edu/ solano/econroots.pdf)。本文选择该研究区主要考虑该区遥感数据和地面调查数据作为公共数据集的完备性,便于模型验证以及与其他研究者的试验结果对比。

1.2 试验数据

1.2.1 土地利用调查数据

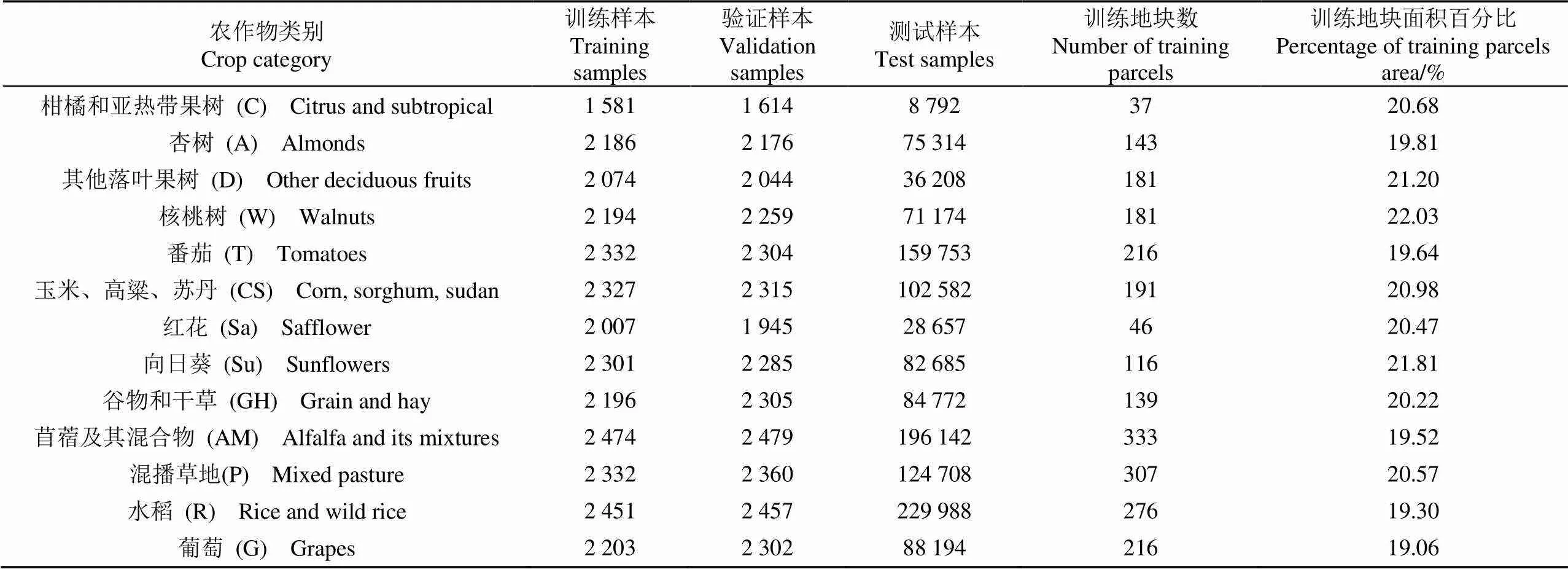

本文使用的是2014年加利福尼亚州水利部对县级土地利用的调查数据(https://databasin.org/datasets/ 6cc5b24e401043a899a6db6eef5c86db/)。工作人员在实地调查期间,记录了各种土地利用属性。在这项研究中,作物种类是根据加州水资源计划(California Water Plan, CDWR)确定的[8]。本试验在ArcGIS中为每个观察到的属性创建一个标签,然而某几个标签只适用于少数几个地块,所以有必要将这些标签合并到感兴趣的农作物类别中。本文选择了13个夏季农作物类别进行分类和分析(表1),由于气象或气候因素的影响,不同年份和地理区域的种植或播种和收获日期可能会有一些轻微的变化。另外,所有非农作物土地利用类型汇总为其他用地类(包括城镇、闲置地和湿地)。

表1 样本集中农作物类别及其比例

1.2.2 遥感卫星影像

本文采用的遥感数据是由Landsat8陆地成像仪(Operational Land Imager, OLI)获取的地表反射率,多光谱波段空间分辨率为30 m,可从美国地质调查局(USGS, http://glovis.usgs.gov/)开发的Landsat二级产品获得。研究发现使用Landsat8原始影像的分类精度高于植被指数NDVI[17],因此输入数据选择2014年云量低于5%的原始影像,轨道号为044/033。生育期内所有可用的遥感数据的时间点分别为2014-05-21、2014-06-06、2014-06-22、2014-07-24、2014-08-09、2014-08-25、2014-09-10、2014-09-26、2014-10-12、2014-10-28。根据农作物特征在2014-08-25和2014-09-26两期影像与其他时相影像上的区分度和数据冗余度,本研究选择其余8个时相多光谱遥感地表反射率数据(不包括以上两期影像)作为模型的试验数据。

1.2.3 数据集划分和数据预处理

在大多数农田中,同一地块的像素是十分同质且高度相关,将一个地块中的像素分配到不同的数据集合(训练集、验证集和测试集)将违反独立性原则[8]。考虑到单个地块的耕作方式和管理方式通常不同,不同地块的农作物类型相对独立,在数据集划分时,本文将同一地块视为一个整体,并对非农作物用地进行了掩膜。整个研究区域采用分层随机采样的方法,按照2:2:6将农作物地块划分为训练区、验证区和测试区。由于同一地块内像元归属的农作物类型相同,在训练区和验证区中,分别对每一类地物进行2 000左右的随机点采样得到典型样本集,由于各类别地物所占面积大小不一样,最终的训练集、验证集和测试集如表1所示。为了验证算法的稳定性,在所选的训练区中分别按照50%和25%两种比例分层随机选取地块,形成新的小样本训练集,并各自占农作物总地块数据的10%和5%(每类地物样本点分别在1 000和500左右)。另外,在图像输入模型之前,需要对数据进行归一化处理,将原始数据映射到[0,1]区间,加速模型的收敛。根据研究区内农作物的生长物候特征,本文选取成像时间2014-07-24的单时相遥感影像分析时相信息和纹理信息在CNN分类中的作用。该时相的植被生长旺盛,与其他地物光谱差异显著,具有较好的区分度;同时农作物之间物候特征明显,有利于分类识别。

2 研究方法

2.1 深度神经网络(DNN)

2.1.1 卷积神经网络(CNN)

卷积神经网络(CNN)是一种多层前馈神经网络,它是通过考虑局部和全局的平稳特性,为处理多阵列形式的大规模图像或传感数据而设计的[18]。CNN通常由多个层组成,层与层之间通过一组可学习的权重和偏差相互连接。每个层输入图像的斑块,这些斑块扫描整个图像以捕获局部和全局尺度的不同特征。在CNN框架内,这些图像斑块通过交替的卷积层和池化层进行泛化,直到获得高层特征,并在此基础上执行全连接的分类[19]。另外,在每个卷积层中可以存在多个特征图,并且同一特征图中共享卷积节点的权重。这种设置使网络能够学习不同的特征,同时保持参数的数量易于处理。而且,在卷积层外采用非线性激活函数来加强非线性。具体而言,在CNN中执行的主要操作可以概括[20]:

式中O-1表示第层的输入特征图,W和b分别表示该层的权重和偏差,它们通过线性卷积*对输入特征图进行卷积,(·)表示卷积层外的非线性函数。然后使用s×s窗口大小的最大池化(P)操作,以聚合特定区域内特征的统计信息,从而在第层输出特征图O。

2.1.2 混合卷积神经网络(3D-2D CNN)

本文提出了一种新的基于CNN的架构,结合了空间和时间分析,模型架构如图2所示。模型由相互连接的3个部分组成,第一部分使用3D卷积来执行时空分析,通过多个3D CNN层提取时空特征,而不折叠时间维度。第二部分使用2D卷积引入空域分析,将3D CNN的输出压缩后再输送给2D CNN,进一步只从空间维度提取重要信息,这种时空分析之后的空间分析有助于消除噪声。3D卷积模块和2D卷积模块与传统CNN卷积基本相同,3D-2D混合卷积模式集成二者优点可以充分挖掘遥感影像的空间和时间特征,并提高计算效率。前两个部分从输入中提取特征,第三部分是一个全连接的神经网络,它可以从多时相输入的图像中预测标签。图2中每一层正方形图块代表图像不同的通道或特征图,每个卷积块在激活前都有一个批处理归一化层,通过批处理归一化,模型收敛速度更快,精度更高[21]。由于CNN的池化层可能会丢失大量有价值的信息,忽略整体和部分之间的关系[22],因此本研究所使用的神经网络结构中不包括池化层。

图3对二维(2D)卷积和三维(3D)卷积运算进行了比较,例如,在5月、6月、7月、8月和9月分别捕捉同一区域的单通道图像斑块,U表示卷积算子,Å表示折叠特征的求和运算符(图3)。

5幅多时相影像经过2D卷积运算变成单通道特征图(图3a),也就是二维卷积运算在时间维度提取的特征被平均并折叠成标量。与2D卷积不同,5幅多时相影像经过连续的3D卷积运算后变成3通道特征图(图3b),其中操作符U3在时间方向上连续执行3次卷积(用实线、虚线和点划线箭头表示),由相同线型的箭头指向的特征包含时间信息。也就是连续的3D卷积运算能提取多时相遥感影像的时空信息(图3b)。在实践中,多时相遥感图像由多光谱通道组成,即由空间维、光谱维、时间维构成,2D卷积运算所提取的特征在时间方向上不存在关系,而3D卷积运算能保留时间动态特征[3]。

2.2 损失函数

目前,在图像语义分割任务中常用的方法是利用交叉熵损失函数(CEloss)对模型进行训练,交叉熵损失函数(CEloss)公式如下[23]:

实际上,由于主要是解决难分类和易分类样本的不平衡,正负样本的不平衡问题主要由权重因子α进行调整,并且有试验证明Focalloss的平衡形式取得的分类精度略高于其非平衡形式。因此本文采用Focalloss的平衡形式作为损失函数[24]:

聚焦参数平稳地调整易分类样本权重下降的速率。当=0时,Focalloss相当于CEloss,当增加时,调整因子的效果也随之增加。

2.3 分类精度评价指标

分类器的性能是影响其分类泛化能力的关键前提,为了定量化模型在测试集数据中的分类精度表现,本文采用混淆矩阵、总体精度(Overall Accuracy,OA)、精确率(Precision)、召回率(Recall)、1分数的宏平均(宏平均1值)、Kappa系数等指标对试验结果进行评价,其中宏平均1值由精确率和召回率计算得到[25]。

2.4 其他分类器

为了进行比较,本文还尝试了2D CNN、3D CNN以及另外两种典型传统的机器学习分类器:SVM和RF,它们通常作为分类任务的基线模型[8]。随机森林是基于装袋技术(Bagging)的决策树集成算法[26],支持向量机是通过分离超平面而定义的分类器模型,一般使用核函数进行非线性分类[27]。SVM和RF在遥感应用中得到了广泛的应用,并在复杂的分类任务中取得了巨大的成功[28]。本研究以SVM和RF的分类结果为参考基准,它们代表目前流行的非深度学习算法的性能。对于SVM和RF,本文使用Python中的机器学习库实现。每个分类器都需要一组超参数,本文采用随机搜索策略并根据验证集的分类精度来优化所选分类器的主要超参数。具体方法为反复多次训练分类器,每次运行都基于所有超参数值集合中的随机组合[8]。经过试验,SVM超参数C和gamma最优值分别为20和3,RF超参数n_estimators、max_depth、min_samples_split、min_samples_leaf、max_features最优值分别为300、25、2、1、’sqrt’。两种深度学习模型3D CNN和2D CNN参数设置与本文采用的混合3D-2D CNN模型一致。为了处理数据集类别之间的不平衡问题,本文将类别权重参数设置为与类丰度成反比,以使每个类的贡献度相等。

2.5 试验环境和预试验

本文试验基于Python3.6软件平台和TensorFlow2.0深度学习框架,采用Intel i7-9700处理器和NVIDIA RTX2080 GPU运算,运行内存32 G。

本文采用具有Adam优化器的随机梯度下降算法[29]对所有神经网络进行训练,经过试验,本研究使用的CNN模型均为四层卷积层,混合3D-2D CNN前三层为3D卷积,第四层为2D卷积。窗口尺寸过大易致卷积神经网络模型对线条特征提取不清晰,类别间边界不够细腻,影响图像分类效果[30]。在综合考虑计算效率和分类精度的基础上,本文经过对邻域窗口{9×9,11×11,15×15,19×19,21×21}的多次尝试,当α=0.25,=2,以样本点为中心像元生成11×11×32邻域窗口的图像块作为输入数据时模型的分类效果最好。由于小卷积核进行一次卷积运算覆盖的像元数少,对密集特征表示效果较好,本文所用数据为中等分辨率遥感影像,识别地物类型为农作物,在遥感影像中呈密集分布状态[31],因此所有CNN模型每层卷积核大小设置相同均为3×3,卷积核个数均设置为32、64、128、256。为了提高模型的泛化能力,特征图展开后经过两个全连接层,最后进入分类决策层。批大小设置为512,初始学习率从0.001开始,当验证样本的准确率停止提高时,学习率下降5倍。对选定的模型进行训练,直到验证精度达到稳定水平不再明显变化为止。

3 结果与分析

3.1 模型训练

本文采用100轮次训练模型,由于不同的模型,参数量不等,因此3D CNN训练时间最长,SVM训练时间最短。相比2D-CNN和3D-CNN,混合3D-2D CNN收敛速率最快,并取得最大验证精度值(图4a)和最小验证损失值(图4b)。

3.2 模型分类结果评价

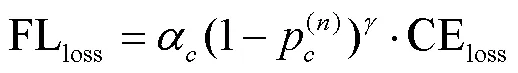

本文计算了测试集的总体精度和混淆矩阵以评估所有分类器的性能。总体精度与正确制图的面积成正比,适用于面积估计。在本试验测试集中,制图精度为1%时,大概对应于1 160 hm2农作物面积。另外,评价标准还使用宏平均1值(所有类别1值的简单平均)作为分类能力的指标,对于每个类,宏平均1值是生产者准确率和使用者准确率的调和平均数。宏平均1值的大小反映了模型识别农作物空间分布的能力,特别是对数量相对较少的农作物类型[8]。如表2所示,经过20%地块上随机采样的样本训练的混合3D-2D CNN在测试集上取得了各个评价指标的最优值,总体精度、宏平均1值和Kappa系数分别为89.38%、84.21%、0.881,而SVM均取得了最小值。混合3D-2D CNN与3D CNN及2D CNN模型的各个评价指标相比均有一定程度的提高,其总体精度分别提高1.35和5.46个百分点,宏平均1值分别提高1.33和6.78个百分点,Kappa系数分别提高0.015和0.061。与传统机器学习模型SVM和RF相比,所有CNN模型的评价指标均有所提高,而本文所提出的混合3D-2D CNN提高最为明显,其总体精度分别增加8.02和7.23个百分点,宏平均1值分别增加10.54和10.02个百分点,Kappa系数分别增加0.089和0.081(表2)。

表2 不同模型在测试集上的分类精度比较

图5显示了不同分类器对不同农作物分类结果的归一化混淆矩阵。总体而言,CNN模型(包括混合3D-2D CNN(图5a)、3D CNN(图5b)、2D CNN(图5c))对不同农作物类型的识别精度优于传统机器学习模型(包括SVM (图5d)、RF (图5e)),特别是本文所提出的混合3D-2D CNN模型表现最为优异,其中农作物类型核桃树(W)、其他落叶果树(D)、苜蓿及其混合物(AM)和混播草地(P)比SVM分类精度分别提高14.09、18.00、12.78和13.02个百分点,而在农作物类型杏树(A)、其他落叶果树(D)、核桃树(W)和混播草地(P)的识别精度分别比RF提高了15.96、18.32、14.78和12.91个百分点。在深度学习模型中,混合3D-2D CNN对不同农作物类型的分类精度均高于3D CNN及2D CNN,其中相对3D CNN,其他落叶果树(D)、番茄(T)、玉米类(CS)和苜蓿及其混合物(AM)识别精度分别提高了2.46、3.64、2.10和3.11个百分点;相对2D CNN,杏树(A)、核桃树(W)、番茄(T)、玉米类(CS)、红花(Sa)、向日葵(Su)、苜蓿及其混合物(AM)和混播草地(P)的分类精度分别提高了6.76、8.92、7.54、11.23、8.33、5.25、6.17和6.60个百分点。在传统机器学习模型中,RF对农作物玉米类(CS)、谷物和干草(GH)和苜蓿及其混合物(AM)的识别精度比SVM分别提高了2.66、3.97和6.37个百分点。

为了验证混合3D-2D CNN在小数据集上的稳定性和普适性,本文随机选取训练地块中50%和25%的地块,分别得到占总数据10%和5%的两种小样本训练集,并在此基础上保持验证集和测试集不变(仍然占总数据的20%和60%)。五种分类器在测试集上的分类精度如表2所示,不同比例的训练集训练得到的混合3D-2D CNN均取得了分类精度的最优值。所有模型经过10%的训练样本训练后,在相同测试集上混合3D-2D CNN比其他深度学习模型3D CNN和2D CNN的分类精度分别提高了1.40和5.92个百分点;而相对于浅层机器学习模型SVM和RF,3D-2D CNN的分类精度提升更为显著,分别达到了7.80和7.01个百分点(表2)。所有模型经过5%的训练样本训练后,在相同测试集上混合3D-2D CNN比其他深度学习模型3D CNN和2D CNN的分类精度分别提高了1.27和6.94个百分点;而相对于浅层机器学习模型SVM和RF,3D-2D CNN的分类精度提升更为显著,分别达到了7.77和7.09个百分点(表2)。另外,就模型稳定性而言,训练数据集由20%减少至10%,模型稳定性大小顺序为:SVM=RF>3D-2D CNN> 3D CNN > 2D CNN;训练数据集由10%减少至5%,模型稳定性大小顺序为:3D CNN > SVM>3D-2D CNN>RF>2D CNN。

为了分析农作物物候信息在CNN分类中的作用,本试验以2014-07-24单时相遥感影像为例对农作物进行识别,分类结果显示2D CNN在该单时相遥感影像测试集上的总体精度、宏平均F1值和Kappa系数分别为64.14%、57.84%、0.601。

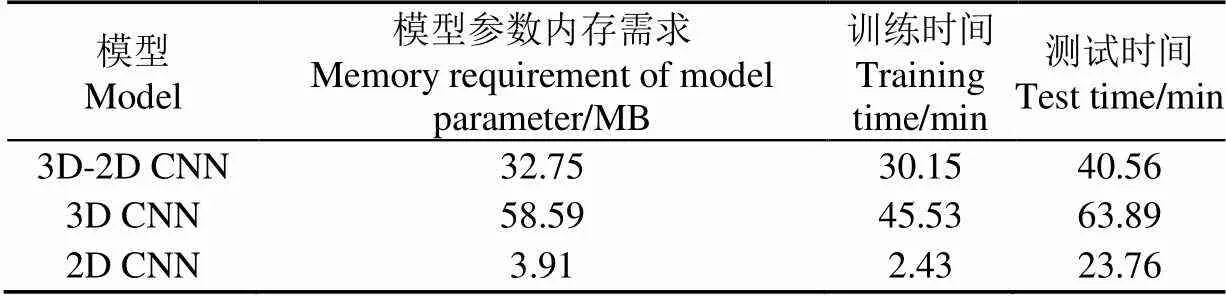

本文对模型复杂度(模型参数内存需求)和计算时间(训练时间和测试时间)进行了比较(表3)。在3种深度学习模型混合3D-2D CNN、3D CNN和2D CNN中,3D CNN模型参数内存需求最大,计算时间最长,而2D CNN模型参数内存需求最小,计算效率最快,分类精度相对较低。混合3D-2D CNN模型在保持相对较高分类精度的情况下,比3D CNN模型具有相对较小的参数内存需求和较快的训练时间和推断时间,这是因为该模型没有将最后一层卷积层进行3D 卷积,而是将其降维后输入到2D卷积中,这样较大程度地减少了参数的数量,提高了模型性能。

表3 不同CNN模型性能比较

4 讨 论

多时相农作物遥感具有光谱与空间高度异质性特征,这给大范围农作物遥感制图分类带来挑战,本文使用时间序列遥感数据作为分类器的输入进行研究。农作物的生长变化信息具有关联性,但这些时间特征往往被部分忽略或用简单化的模型来表示。对于支持向量机(SVM)和随机森林(RF),序列中的每一个时间步都被视为一个独立的维度,一般会采用过于简化的的经验规则来表示时间特征[3],没有利用序列关系。2D CNN仅在空间维卷积,在一定程度上由于其卷积的限制会丢失时间信息,对于光谱相似但物候信息差异较大的农作物不能准确分类[32]。SVM和RF虽然利用光谱信息,但无法有效纳入空间信息,而以图像块作为输入单元的卷积神经网络(CNN)能够提取空间相关信息和深层次特征,但由于2D CNN未能充分利用拼接后的多时相多光谱图像的时间变化特征,与传统模型SVM和RF相比,其分类精度提高幅度并非显著。这表明如果忽略分类器的差异,拼接的多时相多光谱图像具有很好的时空变化特征,并且与传统CNN学习的最先进的多层次表示相匹配。与2D CNN不同,3D CNN中的三维卷积核分别在空间和时间维上进行卷积,它可以更好地提取多时相遥感数据的时空特征,因而3D CNN分类精度明显优于2D CNN、SVM和RF模型。

本文中3D CNN模型的输入数据需是多时相遥感影像,而2D CNN模型的输入数据可以是单时相或多时相遥感影像。试验以2014-07-24单时相遥感影像为例,2D CNN在该单时相遥感影像上的农作物分类精度(OA=64.14%,1=57.84%,Kappa=0.601)远低于采用的多时相遥感影像(OA=83.92%,1=77.43%,Kappa=0.820)。结果表明时相因素在农作物影像分类中具有重要的作用,在农作物物候期内提高遥感影像的时间分辨率可以获得更高的农作物分类精度[33]。为了减少空间关系信息对分类结果的噪声影响,本文将纹理信息作为分类的辅助特征,并基于二阶概率统计的滤波(Co-occurrence Measures)考虑了8种纹理特征[34]:均值(Mean)、方差(Variance)、协同性(Homogeneity)、对比度(Contrast)、相异性(Dissimilarity)、信息熵(Entropy)、二阶矩(Second Moment)、相关性(Correlation)。上述纹理特征是由全向64位阴影灰度图像生成的,本文使用的内核大小为11×11,并以2D CNN模型和2014-07-24单时相遥感影像为例分析纹理特征对农作物分类精度的影响。试验结果显示,相比该单时相影像(未叠加纹理特征),2D CNN在叠加纹理特征的影像上的分类精度仅提高了0.68个百分点。Yang等[35]利用CNN(一维CNN和二维CNN)和多时相Sentinel-2数据对农作物进行分类,结果表明多时相遥感影像纹理信息对农作物分类精度的贡献并不明显。在基于CNN模型的多时相遥感农作物分类中,纹理信息主要用于辅助增强较小地物的特征表达,光谱信息对农作物分类精度贡献最大[36]。由于添加纹理特征后的输入数据量较大,且对农作物分类精度提升不显著,因此本文模型输入数据仅使用未叠加纹理特征的多时相遥感影像。

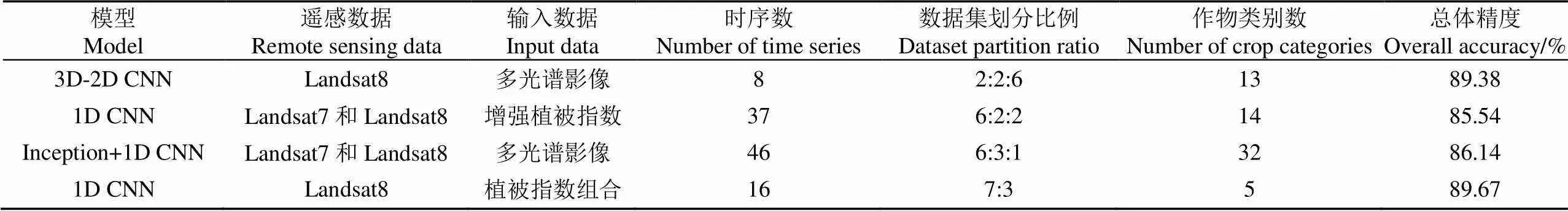

为了评估所提方法的分类性能,本文搜集了国内外不同学者利用加利福尼亚州县级土地利用调查数据和Landsat影像对农作物进行分类的试验结果,并对几种先进的分类方法1D CNN(+增强植被指数)[8]、Inception+1D CNN(+多光谱影像)[17]、1D CNN(+植被指数组合)[37]进行了比较,如表4所示。以1D CNN(+增强植被指数)为例,该模型复杂度相对较小,该研究中农作物类别数为14(与本文试验类别数接近),其中有两类农作物分类精度低于60%。虽然本文采用的混合3D-2D CNN模型参数量较大,但是试验仅使用了8景多时相Landsat8数据以及相对较小的训练集便获得了与其他先进模型相当的分类精度。由于时空三维卷积模型复杂度高且对样本数据量要求大,一般来说,由于受野外调查条件等限制,遥感分类模型中的大样本数据集难以获取[38],大样本数据要求难以满足,因而难以保证3D CNN模型的高精度分类。如何保证小样本情况下深度学习模型的分类精度及稳定性是当前遥感领域亟需解决的重要问题[39-40]。本研究提出的混合3D-2D CNN模型,既保留了3D CNN时空三维特征,同时又降低了模型复杂度及时空维度,因而与其他模型相比取得了较高的分类精度。试验也表明即使在10%和5%的小样本训练集上,混合3D-2D CNN模型仍然表现最为优异,并且也降低了模型计算的时间复杂度,因而它为复杂农作物遥感分类识别提供了一种重要的参考与借鉴。

表4 3D-2D CNN模型与其他先进模型分类性能对比

注:最后一个模型数据集划分为训练集、测试集,其他的为训练集、验证集、测试集。

Note: The last model dataset is divided into training set and test set, and the others are training set, validation set and test set.

在实际应用中,确定多时相农作物制图任务的输入数据时,常常会遇到一个两难的问题。原始时间序列在分类中的使用是简单而直接的,但是序列中的信息可能没有被充分挖掘,特别是对于那些本来就不具备处理时间关系的分类器;通过拟合预定义曲线函数进行物候提取,可以提供具有物理意义的有用特征,但其应用受到曲线函数选择的限制[8]。在某种程度上,基于时间卷积特征的混合3D-2D CNN模型在以上两难问题之间取得了平衡,它能够有效地利用空间信息和时间特征以改进分类效果。因此,混合3D-2D CNN模型在时空特征表示方面具有可行性和有效性。未来的工作将继续研究基于深度学习技术的农作物制图,挖掘不同输入尺度下模型在农作物分类制图精度中的潜力,在面向对象的基础上以地块为单元进行分类,并对不同的算法进行集成或决策融合以达到优势互补,从而提高分类精度,以期为中国农业监测提供支持辅助决策的农作物类型空间分布信息。

5 结 论

如何充分利用多时相遥感数据,有效挖掘农作物生育期内物候规律,提高农作物遥感分类识别与制图精度是当前农业遥感领域研究的重要课题。本文以加利福尼亚州北部农业区为试验区域,利用Landsat8时间序列遥感数据,提出了一种混合3D卷积和2D卷积为构建块的时空卷积深度网络模型3D-2D CNN,并利用该模型实现了地块尺度多种农作物的精细分类。主要结论如下:

1)针对研究区内13种农作物识别,混合3D-2D CNN模型取得了相对较高的分类结果,其分类精度(总体精度(Overall Accuracy,OA)=89.38%)优于其他深度卷积模型3D CNN(OA=88.03%)、2D CNN(OA=83.92%),以及传统浅层机器学习模型支持向量机(Support Vector Machines,SVM)(OA=81.36%)、随机森林(Random Forest,RF)(OA=82.15%),表明该模型融合了3D CNN模型的时空特征挖掘能力,不需要额外的特征工程去构建纹理特征,并实现端到端的农作物自动分类。

2)在保证较高分类精度的情况下,混合3D-2D CNN模型相比3D CNN模型的参数内存需求和计算时间分别下降了44.10%和35.38%,表明该模型具有较低的模型复杂度以及较高的计算效率。

3)本文开展以不同大小训练样本的模型试验与验证研究,在占总数据10%和5%的两种小样本训练集上,混合3D-2D CNN模型(10%,OA=86.49%;5%,OA=82.99%)均取得了优于其他模型3D CNN(10%,OA=85.09%;5%,OA=81.72%)、2D CNN(10%,OA=80.57%;5%,OA=76.05%)、SVM(10%,OA=78.69%;5%,OA=75.22%)、RF(10%,OA=79.48%;5%,OA=75.90%)的农作物分类精度,表明该模型在小数据集上的稳定性和适用性。

本文所提出的混合3D-2D CNN模型可有效挖掘多时相遥感信息,并取得了较优的农作物遥感分类结果,表明在时间序列分类中该模型结构设计的合理性及重要性,这为农作物遥感制图应用提供了一种灵活和高度自动化的方法。此外,3D-2D CNN模型有助于利用遥感数据进行其他与变化、趋势或动态相关的建模过程。例如,在冰川融化、气候变化和季节性森林动态等研究的模型中嵌入三维卷积和二维卷积信息。总之,在使用时间序列遥感数据进行分类任务的众多方法中,混合3D-2D CNN模型是一个可行且有效的选择。

[1] 张鹏,胡守庚. 地块尺度的复杂种植区作物遥感精细分类[J]. 农业工程学报,2019,35(20):125-134.

Zhang Peng, Hu Shougeng. Fine crop classification by remote sensing in complex planting areas based on field parcel[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(20): 125-134. (in Chinese with English abstract)

[2] Li Z, Chen G, Zhang T. A CNN-Transformer hybrid approach for crop classification using multitemporal multisensor images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13: 847-858.

[3] Ji S, Zhang C, Xu A, et al. 3D convolutional neural networks for crop classification with multi-temporal remote sensing images[J]. Remote Sensing, 2018, 10(1): 75.

[4] Guerschman J P, Paruelo J M, Bella C D, et al. Land cover classification in the Argentine Pampas using multi-temporal Landsat TM data[J]. International Journal of Remote Sensing, 2003, 24(17): 3381-3402.

[5] 胡琼,吴文斌,宋茜,等. 农作物种植结构遥感提取研究进展[J]. 中国农业科学,2015,48(10):1900-1914.

Hu Qiong, Wu Wenbin, Song Qian, et al. Recent progresses in research of crop patterns mapping by using remote sensing[J]. Scientia Agricultura Sinica, 2015, 48(10): 1900-1914. (in Chinese with English abstract)

[6] Xie Y, Sha Z, Yu M. Remote sensing imagery in vegetation mapping: A review[J]. Journal of Plant Ecology, 2008, 1(1): 9-23.

[7] Sheykhmousa M, Mahdianpari M, Ghanbari H, et al. Support vector machine vs. random forest for remote sensing image classification: A meta-analysis and systematic review[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13: 6308-6325.

[8] Zhong L, Hu L, Zhou H, et al. Deep learning based multi-temporal crop classification[J]. Remote Sensing of Environment, 2019, 221: 430-443.

[9] Kamilaris A, Prenafeta-Boldú F X. A review of the use of convolutional neural networks in agriculture[J]. The Journal of Agricultural Science, 2018, 156(3): 312-322.

[10] Garnot V S F, Landrieu L, Giordano S, et al. Time-Space tradeoff in deep learning models for crop classification on satellite multi-spectral image time series[C]//IGARSS 2019-2019 IEEE International Geoscience and Remote Sensing Symposium. Yokohama: IEEE, 2019: 6247-6250.

[11] Gadiraju K K, Ramachandra B, Chen Z, et al. Multimodal deep learning based crop classification using multispectral and multitemporal satellite imagery[C]//Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: Association for Computing Machinery, 2020: 3234-3242.

[12] 屈炀,袁占良,赵文智,等. 基于多时序特征和卷积神经网络的农作物分类[J]. 遥感技术与应用,2021,36(2):304-313.

Qu Yang, Yuan Zhanliang, Zhao Wenzhi, et al. Crop classification based on multi-temporal features and convolutional neural network[J]. Remote Sensing Technology and Application, 2021, 36(2): 304-313. (in Chinese with English abstract)

[13] 解毅,张永清,荀兰,等. 基于多源遥感数据融合和LSTM算法的作物分类研究[J]. 农业工程学报,2019,35(15):129-137.

Xie Yi, Zhang Yongqing, Xun Lan, et al. Crop classification based on multi-source remote sensing data fusion and LSTM algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(15): 129-137. (in Chinese with English abstract)

[14] Li H, Zhang C, Zhang S, et al. A hybrid OSVM-OCNN method for crop classification from fine spatial resolution remotely sensed imagery[J]. Remote Sensing, 2019, 11(20): 2370.

[15] Li H, Zhang C, Zhang S, et al. Crop classification from full-year fully-polarimetric L-band UAVSAR time-series using the Random Forest algorithm[J]. International Journal of Applied Earth Observation and Geoinformation, 2020, 87: 102032.

[16] Roy S K, Krishna G, Dubey S R, et al. HybridSN: Exploring 3-D–2-D CNN feature hierarchy for hyperspectral image classification[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 17(2): 277-281.

[17] García Pereira A, Porwol L, Ojo A, et al. Exploiting the temporal dimension of remotely sensed imagery with deep learning models[C]//Proceedings of the 54th Hawaii International Conference on System Sciences. Hawaii: HICSS, 2021: 5317.

[18] LeCun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[19] Schmidhuber J. Deep learning in neural networks: An overview[J]. Neural Networks, 2015, 61: 85-117.

[20] Zhang C, Sargent I, Pan X, et al. An object-based convolutional neural network (OCNN) for urban land use classification[J]. Remote Sensing of Environment, 2018, 216: 57-70.

[21] Li J, Liang B, Wang Y. A hybrid neural network for hyperspectral image classification[J]. Remote Sensing Letters, 2020, 11(1): 96-105.

[22] Li H, Huang J, Ji S. Bearing fault diagnosis with a feature fusion method based on an ensemble convolutional neural network and deep neural network[J]. Sensors, 2019, 19(9): 2034.

[23] Kampffmeyer M, Salberg A B, Jenssen R. Semantic segmentation of small objects and modeling of uncertainty in urban remote sensing images using deep convolutional neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops. Las Vegas: IEEE, 2016: 1-9.

[24] Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice: IEEE, 2017: 2999-3007.

[25] Bayr U, Puschmann O. Automatic detection of woody vegetation in repeat landscape photographs using a convolutional neural network[J]. Ecological Informatics, 2019, 50: 220-233.

[26] Liaw A, Wiener M. Classification and regression by randomForest[J]. R news, 2002, 2(3): 18-22.

[27] Cortes C, Vapnik V. Support-vector networks[J]. Machine learning, 1995, 20(3): 273-297.

[28] Zhang J, Feng L, Yao F. Improved maize cultivated area estimation over a large scale combining MODIS–EVI time series data and crop phenological information[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 94: 102-113.

[29] Kingma D P, Ba J. Adam: A method for stochastic optimization[EB/OL]. arXiv preprint arXiv: 1412.6980, 2014.

[30] 马凯,罗泽. 基于卷积神经网络的青海湖区域遥感影像分类[J]. 计算机系统应用,2018,27(9):137-142.

Ma Kai, Luo Ze. Classification of remote sensing images in Qinghai lake based on convolutional neural network[J]. Computer Systems and Applications, 2018, 27(9): 137-142. (in Chinese with English abstract)

[31] 汪传建,赵庆展,马永建,等. 基于卷积神经网络的无人机遥感农作物分类[J]. 农业机械学报,2019,50(11):161-168.

Wang Chuanjian, Zhao Qingzhan, Ma Yongjian, et al. Crop identification of drone remote sensing based on convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(11): 161-168. (in Chinese with English abstract)

[32] Kussul N, Lavreniuk M, Skakun S, et al. Deep learning classification of land cover and crop types using remote sensing data[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(5): 778-782.

[33] Qiong H U, Wu W, Qian S, et al. How do temporal and spectral features matter in crop classification in Heilongjiang Province, China?[J]. Journal of Integrative Agriculture, 2017, 16(2): 324-336.

[34] Zhou H, Fu L, Sharma R P, et al. A hybrid approach of combining random forest with texture analysis and VDVI for desert vegetation mapping based on UAV RGB data[J]. Remote Sensing, 2021, 13(10): 1891.

[35] Yang S, Gu L, Li X, et al. Crop classification method based on optimal feature selection and hybrid CNN-RF networks for multi-temporal remote sensing imagery[J]. Remote Sensing, 2020, 12(19): 3119.

[36] 周壮,李盛阳,张康,等. 基于CNN和农作物光谱纹理特征进行作物分布制图[J]. 遥感技术与应用,2019,34(4):694-703.

Zhou Zhuang, Li Shengyang, Zhang Kang, et al. Crop mapping using remotely sensed spectral and context features based on CNN[J]. Remote Sensing Technology and Application, 2019, 34(4): 694-703. (in Chinese with English abstract)

[37] 屈炀,袁占良,赵文智,等. 基于多时序特征和卷积神经网络的农作物分类[J]. 遥感技术与应用,2021,36(2):304-313.

Qu Yang, Yuan Zhanliang, Zhao Wenzhi, et al. Crop classification based on multi-temporal features and convolutional neural network[J]. Remote Sensing Technology and Application, 2021, 36(2): 304-313.

[38] Elmes A, Alemohammad H, Avery R, et al. Accounting for training data error in machine learning applied to Earth observations[J]. Remote Sensing, 2020, 12(6): 1034.

[39] Karpatne A, Ebert-Uphoff I, Ravela S, et al. Machine learning for the geosciences: Challenges and opportunities[J]. IEEE Transactions on Knowledge and Data Engineering, 2018, 31(8): 1544-1554.

[40] Tian T, Li C, Xu J, et al. Urban area detection in very high resolution remote sensing images using deep convolutional neural networks[J]. Sensors, 2018, 18(3): 904.

Multi-temporal remote sensing based crop classification using a hybrid 3D-2D CNN model

Lu Yuanbing1,2, Li Huapeng1※, Zhang Shuqing1

(1.,,130102,; 2.,100049,)

Reliable and accurate classification of crop types can greatly contribute to data sources in agricultural monitoring and food security. Remote sensing can be used to rapidly and accurately extract the planting areas and distribution of main crops, thereby optimizing the spatial pattern of crops, grain production, and management. However, it is extremely difficult to identify and then map different types of crops with high accuracy and efficiency, especially for traditional machine learning. The reason is that there are highly complex and heterogeneous spectral data in crop space on time-series remote sensing images. Fortunately, three-dimensional convolution neural networks (3D CNN) are suitable for the spatio-temporal information in the time-series remote sensing imagery. Nevertheless, the high complexity of the 3D CNN model often requires a large number of training samples. In this study, a novel hybrid classification model (called 3D-2D CNN) was proposed to integrate 3D CNN and two-dimensional convolution neural networks (2D CNN) in the trade-off among accuracy, efficiency, and ground sample acquisition. The specific procedure was as follows. The spatio-temporal features were first extracted from the multiple 3D convolutional layers, then the output features were compressed for the spatial feature analysis in the 2D convolutional layer, and finally the high-level maps of features were flattened to predict the category in the fully connected layer. Batch normalization was performed on the input data of each layer to accelerate the network convergence. As such, the complex structure of the original 3D CNN was reduced, while the capacity of 3D-2D CNN remained in spatio-temporal feature extraction. Taking northern California, USA, as the study area, Landsat8 multi-temporal images were utilized as the remote sensing data source in the test to verify the model. Landsat images presented specific characteristics, compared with the natural. The spectral and texture features of the same type varied greatly along with the imaging time and conditions. California agricultural investigation was used as sampling data. Accordingly, the land plots in the study area were randomly divided into a training, validation, and test region, according to 2:2:6 stratification, where the training and validation sample datasets were randomly selected. Since the overflow easily occurred, when the training dataset was limited in actual work, it was necessary for the deep learning model to require a large number of data samples to train a CNN. Correspondingly, two small sample sets of different proportions were randomly selected from the training sample set of 50% and 25% to verify the feasibility of the model. The trained models were then used to predict the test region. The experimental results showed that the overall accuracy (89.38%), macro-average1 value (84.21%), and Kappa coefficient (0.881) of 3D-2D CNN for 13 crop classifications performed better than other deep learning, including 3D CNN and 2D CNN, as well as traditional machine learning, such as Support Vector Machines (SVM) and Random Forest (RF). It should be mentioned that the proposed 3D-2D CNN also achieved the best performance in the small training set, where the highest recognition rate of classification was obtained, compared with the benchmark models. Meanwhile, the convergence time of 3D-2D CNN was reduced greatly, compared with the 3D CNN, thanks to a significant reduction of parameters. It was found that there was a greater effect of temporal features of crops that were hidden in multi-temporal remote sensing imagery on CNN classification, compared with texture features. Consequently, the highest accuracy and strongest robustness were obtained in the 3D-2D CNN model, due mainly to the comprehensive utilization of spatial-temporal-spectrum features. The finding can provide a highly effective and novel solution to crop classification from multi-temporal remote sensing.

remote sensing; crops; multi-temporal field parcel; classification; deep learning; CNN

卢元兵,李华朋,张树清. 基于混合3D-2D CNN的多时相遥感农作物分类[J]. 农业工程学报,2021,37(13):142-151.

10.11975/j.issn.1002-6819.2021.13.017 http://www.tcsae.org

Lu Yuanbing, Li Huapeng, Zhang Shuqing. Multi-temporal remote sensing based crop classification using a hybrid 3D-2D CNN model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(13): 142-151. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.13.017 http://www.tcsae.org

2020-12-02

2021-06-29

中科院战略性先导科技专项项目课题(XDA28010500);国家重点研发计划项目(2017YFB0503602)

卢元兵,博士生,研究方向为农业遥感、遥感信息智能化提取与分析。Email:luyuanbing@iga.ac.cn

李华朋,博士,副研究员,研究方向为农业遥感、遥感信息智能化提取与分析、时空大数据挖掘。Email:lihuapeng@iga.ac.cn

10.11975/j.issn.1002-6819.2021.13.017

TP79; S127

A

1002-6819(2021)-13-0142-10