基于特征融合的U-Net肺自动分割方法

2021-07-06李雪周金治莫春梅余玺

李雪,周金治,莫春梅,余玺

1.西南科技大学信息工程学院,四川绵阳621000;2.特殊环境机器人技术四川省重点实验室,四川绵阳621000

前言

自20 世纪60年代神经认知机(Neocognitron)模型[1]出现以来,学者们就开始将神经网络与肺部医学图像异常诊断相结合,其中卷积神经网络(Convolutional Neural Network, CNN)[2]和计算机断层扫描(CT)技术[3]在肺癌诊断中起着至关重要的作用。作为一种新兴、复杂且涉及多学科的交叉技术,卷积模型的研究热点是肺部CT 图像中关键信息的提取,但面对高质量医学数据缺乏和双肺边界特征信息难以准确提取等问题,如何从肺部CT 图像中提取肺轮廓特征成为一个重要的研究课题。

在肺分割过程中可以考虑灰度、颜色、运动、形状、纹理特征信息等,关于如何分析肺部各种特征的有效性并选择最具有代表性的特征,曹蕾等[4]根据胸部CT 图像的影像学和解剖学特征,结合最佳阈值法、数学形态学方法,先后对肺部图像进行了粗分割、细分割并得到不错的分割效果,但是肺部特征需手动选取,工作量大而复杂;Deepa等[5]提出了一种基于肺部Haralick 纹理特征的提取方法,该方法的分割准确率为86%,分割性能远远优于未经特征优化选择的结果,但是分割精确度还不是很高;Rajnnt 等[6]提出了使用主成分分析(Principal Component Analysis,PCA)进行肺部特征提取,提取的特征通过PCA 数据挖掘进行分类,但是特征矩阵经过PCA 降维后易出现特征丢失的问题,导致分割并不理想,因此分割结果也不够精确;Anifah 等[7]使用反向传播神经网络(Back-propagation Neural Network, BNN)自动提取灰度直方图特征,不用人为选取特征,但灰度特征并不是最有效的肺部特征,因此分割效果还有待提高;曲彦等[8]提出了一种基于超像素的细化分割与模糊C 均值聚类相结合的自动分割算法,主要利用肺部CT图像的灰度、纹理特征对肺进行分割,其准确率为98.32%,远远超过单一特征的肺实质分割效率,但是仅采用了128 名肺病患者共60 幅肺部图像且未进行数据增强;Han 等[9]提出一种基于三维Haralick 纹理特征的肺分割方法,与二维方法相比能获得更为有效的特征,双肺分割十分精确,但三维特征提取存在计算量大和存储资源过多占用的问题,分割准确度受到一定限制。

为弥补医学数据缺乏和双肺边界特征难以准确提取的缺陷,本文从肺部颜色和纹理两大特征出发,提出一种将融合特征作为分割模型的输入获取肺实质的方法。该方法将U-Net模型[10]改进后作为肺实质分割工具,同时采用深度卷积生成对抗网络(Deep Convolution Generative Adversarial Network,DCGAN)[11]解决肺部CT数据匮乏的问题,通过强大的数据扩充训练分割网络,因此所提方法非常适用于数据稀缺的医学领域。实验结果表明,该方法既提高了肺实质分割准确率,又能解决肺部CT数据匮乏的问题。

1 颜色特征与纹理特征的融合

1.1 颜色特征

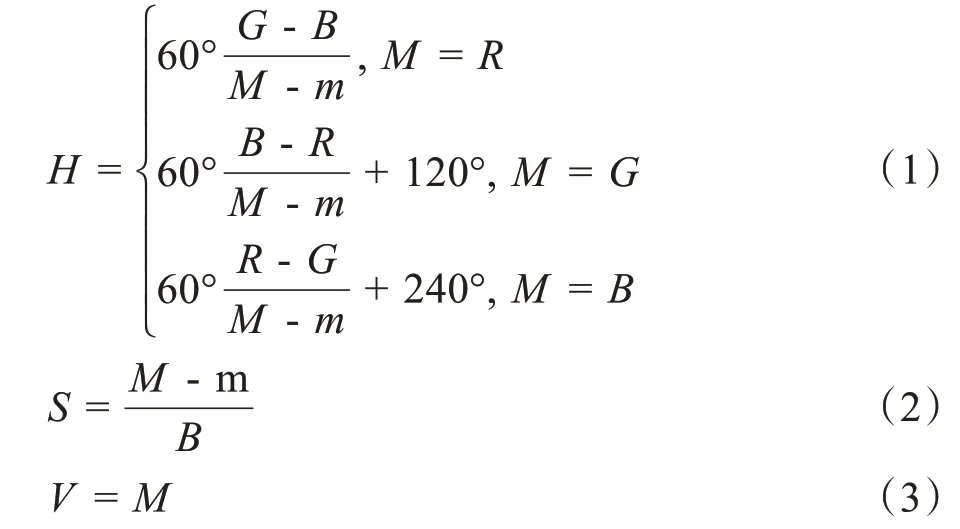

RGB是数字图像中最常见的颜色格式,但RGB空间的主要缺点是它在感知上不统一,其他颜色空间(如LAB、HSV)则提供了更好的感知一致性[12]。为获得LAB和HSV颜色空间的特征,先在每个肺部图像平面上以等距网格上的每个像素为中心构建正方形窗口的直方图,最后计算平均直方图,如图1所示。

图1 颜色特征向量构造过程Fig.1 Color feature vector construction

本文使用5×5 窗口大小提取3 个图像通道的直方图。RGB与HSV的转换如下式所示:

其中,M取(R,G,B)3 个通道的最大值,m取(R,G,B)3 个通道的最小值。与HSV 不同的是RGB、LAB颜色空间的转换需要将XYZ颜色空间作为媒介。假设RGB 为像素3 个通道,取值范围均为[0, 255],RGB与XYZ转换关系如下式所示:

完成RGB 到XYZ 的转换后,再由XYZ 转换到LAB,如下式所示:

将肺部图像进行5×5分块划分,假设分为m块。对每个分块的像素进行量化合成后可得颜色矢量,提取其中像素点数目最多的颜色作为此分块的主色,最后获得图像的综合主色颜色特征向量C=(c1,c2,…,cm),其中ck(k= 1, 2,…,m)为第k块的主色。

1.2 纹理特征

图像分割过程常用Gabor 滤波器提取纹理特征[13]。Gabor 滤波器首先将图像变换到频域,然后将频域分成几个频率子带计算纹理特征。但是,该滤波器在特征提取过程中会引入大量冗余,导致特征通道过多,从而影响对目标特征的提取。该文提出了一种基于高阶图像统计的彩色纹理特征提取方法,该方法定义了邻域结构中纹理的规则性,有利于纹理特征的提取。图像统计可以通过无监督学习恢复,整个图像被认为是具有一组格点S的随机场X,其中{Ss}∈S是整个图像中像素的集合。本文为了提取这些纹理特征,还使用了无监督自适应滤波器。该滤波器通过降低每个像素邻域对的条件概率分布函数的熵h(X|Y=y)提高像素强度的可预测性。(X=x,Y=y)通过控制每个中心像素x值,熵减少在局部降低了随机性,从而为不同的纹理区域生成均匀的强度区域。假设采用5×5 邻域,坐标(a,b)的点像素的颜色特征为C(a,b),为此,在每次迭代和每个图像区域中,Zm通过下式计算:

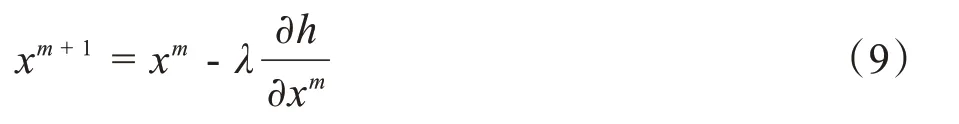

利用梯度下降的有限向前差分法进一步构造图像im+1,强度如下所示:

其中λ是时间步长。当||im+1-im||2<σ(σ是一个小阈值)时,像素更新过程在几次迭代后停止。为了提取彩色纹理特征,对图像通道进行滤波处理。在5×5窗口中心提取每个像素,并使用高斯滤波器进一步平滑,最后计算局部直方图,如图2所示。

图2 纹理特征向量构造过程Fig.2 Texture feature vector construction

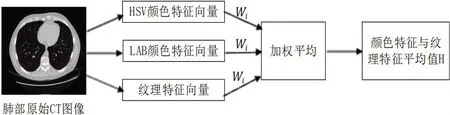

1.3 特征融合

颜色特征侧重于图像整体信息的描述[14],而纹理特征更偏重于局部[15]。仅基于一种特征只能表达图像的部分属性,对图像内容的描述比较片面。本文将前面所获取的颜色特征和纹理特征进行融合,以获取更为全面有效的肺部轮廓特征信息。由于这两类特征属于不同类型的特征向量,取值范围不同,因此本文采用局部窗口提取颜色特征和纹理特征,结合直方图表征图像区域的旋转不变性使它们具有内在的相似性,进而可以对每个特征合理地分配相等的权重。权重计算如下式所示:

其中Wi(i= 1, 2,…,k)表示每类特征的权重,x是特征类别,y是特征总数,即:

局部直方图的计算可以通过平均加权直方图过程来实现,如图3所示:

图3 特征融合过程Fig.3 Feature fusion

由于彩色纹理图像中的颜色和纹理在图像分割中起着互补的作用,通过局部直方图使两种特征结合,最终的分割结果更加准确[16]。设N个特征直方图中存在f个通道,加权平均直方图可按公式(13)计算得到:

其中,Wi是分配给每个直方图的权重。直方图的平均值H由通道加权平均直方图计算,如下式所示:

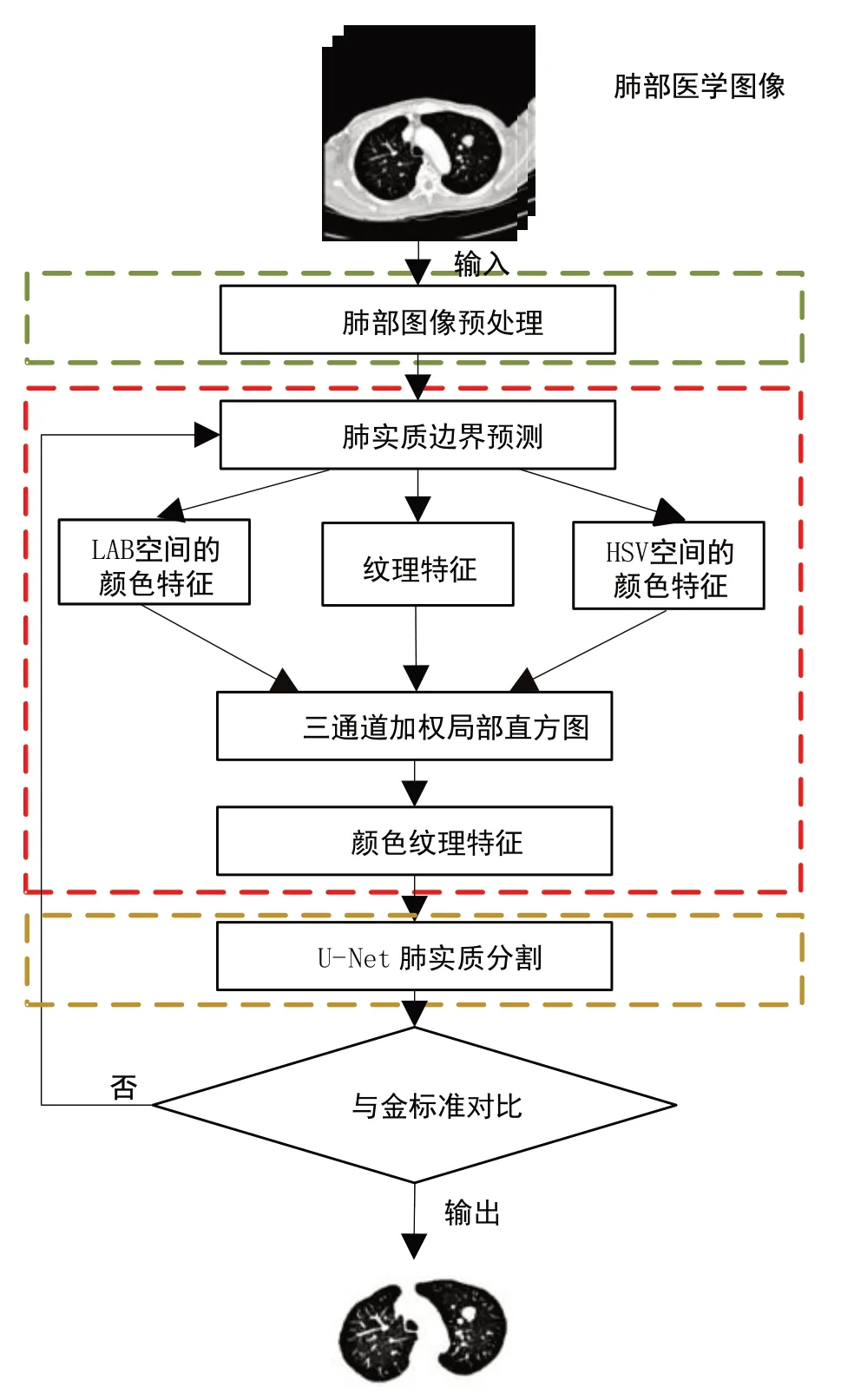

2 肺实质分割

基于颜色和纹理特征的肺实质区域完整分割的整体过程如图4所示,主要由3 部分构成:第一部分是肺部图像的预处理过程;第二部分是肺实质边缘特征的提取与融合过程;最后一部分是用改进后的U-Net进行肺实质分割的过程。

图4 肺实质分割流程图Fig.4 Flow chart of lung parenchyma segmentation

2.1 肺部图像预处理

本文采用边缘保留滤波和拉普拉斯算子对图像进行预处理,前者用于减少输入CT 肺部图像中的噪声和伪影,后者用于锐化增强肺部边缘,有利于下一步肺部边缘检测的进行。肺的原始图像及其预处理图像如图5所示。

图5 肺部CT图像预处理结果Fig.5 Results of lung CT image preprocessing

2.2 肺部颜色纹理特征提取

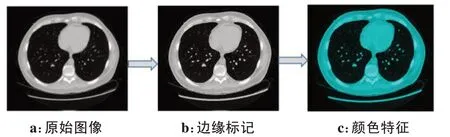

肺轮廓的检测采用改进的Canny边缘检测器[17],它采用自适应滤波器对图像进行滤波。这种自适应滤波算法将根据每个像素灰度值的性质选择灵活的权重,同时对边缘进行锐化,避免了边缘检测结果中孤立边缘的出现,使边缘像素更接近真实边缘。肺边缘检测与标记图像如图6所示。

图6 肺部边缘检测结果Fig.6 Results of lung edge detection

为了获得图像的颜色和纹理特征,采用第1节提到的LAB、HSV 颜色空间和邻域统计获得颜色纹理特征(图7)。

图7 CT肺部图像的颜色形成过程Fig.7 Color forming process of CT lung images

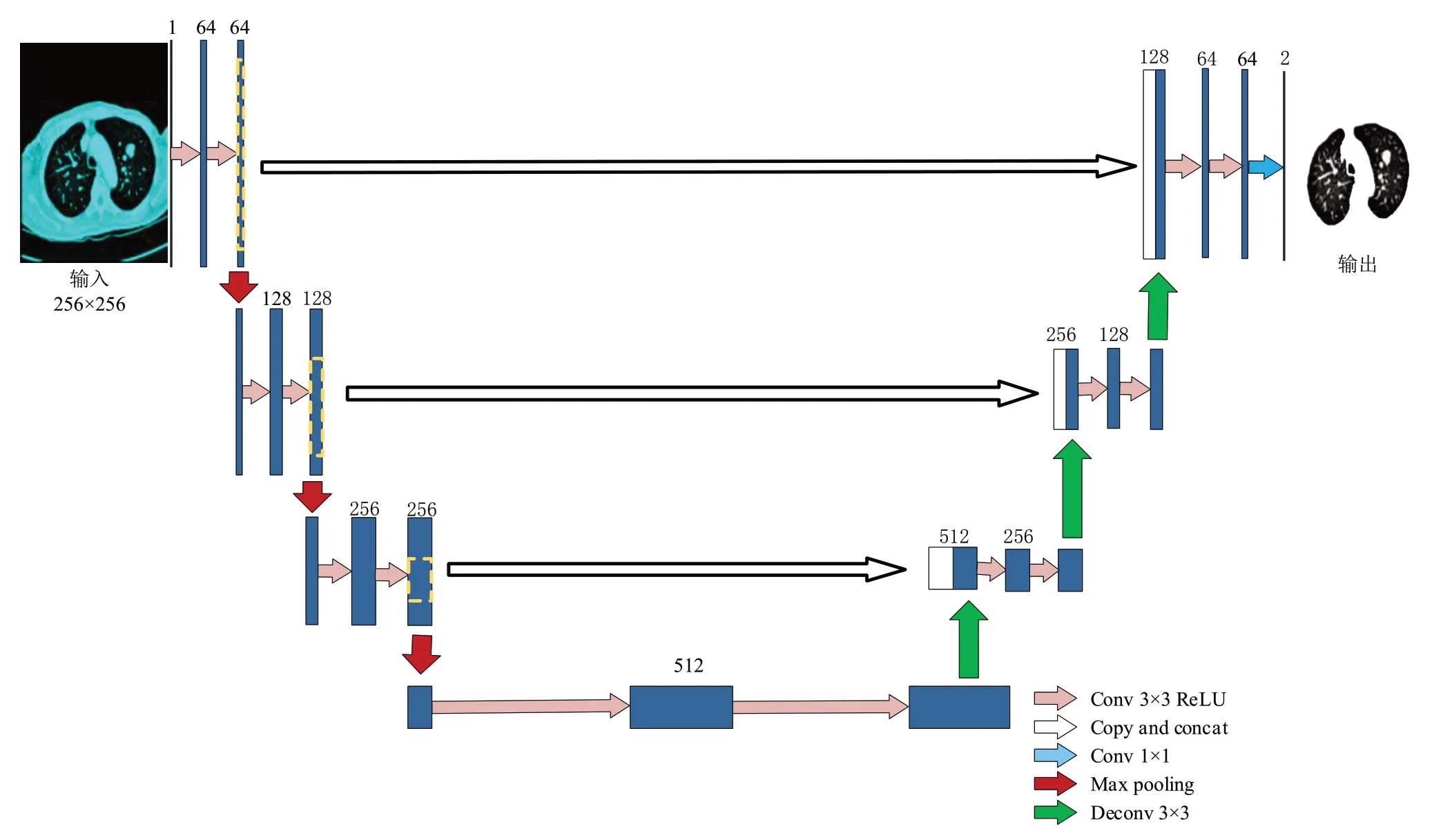

2.3 改进U-Net肺实质分割

U-Net依赖于强大的数据扩充来更有效地使用可用的注释样本,解决了肺部数据短缺的难题,但是由于不同数据集的特征层次的重要性不一样,需要的U-Net分割模型的深度也不一样。因此对原始U-Net进行一定裁剪,改进后的U-Net肺实质分割如图8所示。

图8 U-Net肺实质分割Fig.8 U-Net lung parenchyma segmentation

裁剪后的U-Net 网络总共有18 个卷积层,其体系结构的设计包括两部分:第一部分是收缩路径(红色箭头部分),第二部分是扩展路径(绿色箭头部分),且两部分完全对称,使体系结构呈U形。收缩路径由两个重复使用的3×3 卷积、一个整流线性单元(ReLU)和一个步长为2 的2×2 最大池化层组成。扩展路径用2×2卷积得到特征通道数的一半,与收缩路径中相应剪切的特征映射进行合并,以及两个3×3卷积,每个卷积后面都有一个ReLU 函数。在最后一层,使用1×1卷积生成最终的分割图。

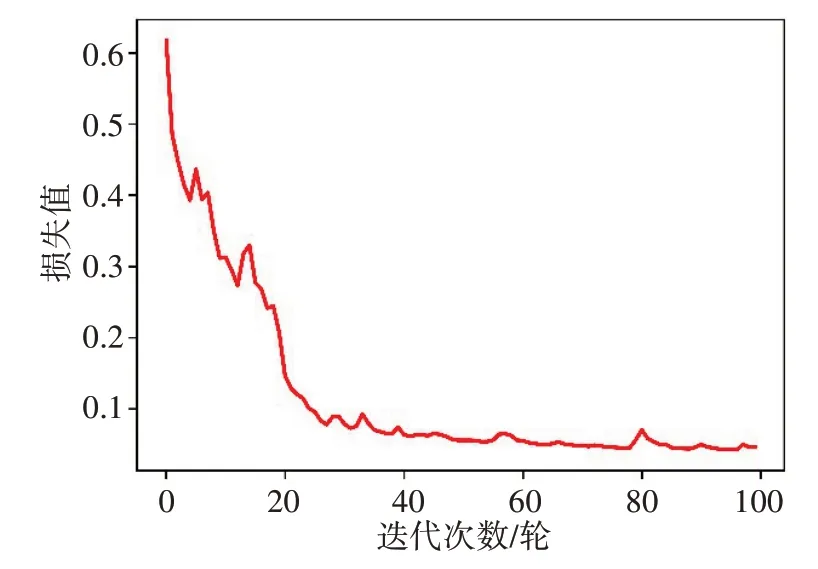

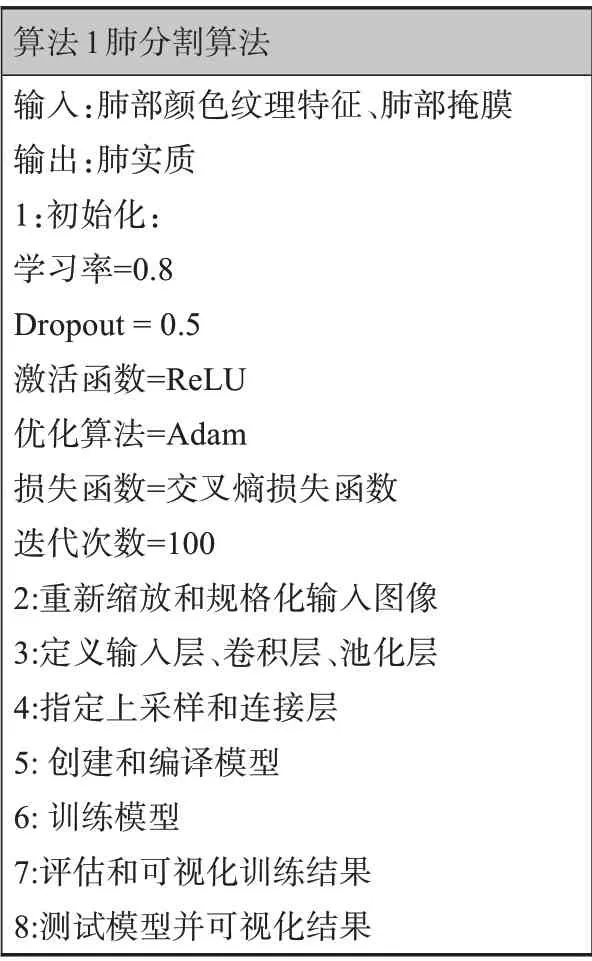

该架构使用LIDC-IDRI数据集进行了训练,并在1 000 幅图像上进行了测试,训练进行了100 次迭代。表1列出在CT图像中分割肺部区域的步骤以及参数设置。图9和图10分别是是模型训练和验证的损失值变化图,从图中可以看出损失值在训练过程中越来越小,其中训练与验证过程的损失值最终稳定在0.036 5,说明经过训练所得的模型稳定性较好。

图9 训练损失值与迭代次数的关系Fig.9 Relationship between training loss and number of iterations

图10 验证损失值与迭代次数的关系Fig.10 Relationship between verification loss and number of iterations

表1 肺分割算法Tab.1 Lung segmentation algorithm

3 实验结果

3.1 实验数据

本文的肺部CT 图像来源于LIDC-IDRI 数据集[18],包括从7 个学术中心和8 个医学影像公司合作创建包含1 398 个病例的数据集,每个病例包括1 个mhd 文件和1 个同名的raw 文件,如图11所示。原始数据大小为512×512,考虑到图像太大浪费存储空间,因此将数据裁剪为256×256。其中mhd 文件需要借助python 的SimpleITK 包来处理。由于肺部CT 切片厚度会影响肺实质最终分割结果,本文采用其中16个病例作为数据集,每个病例的切片数量在418~538之间,为增加数据多样性,选取厚度在0.5~2.5 mm 范围内的肺部CT切片。采用DCGAN网络进一步增强数据使模型分割结果更加准确,该模型由两个基础神经网络即生成器神经网络(Generator Neural Network)和判别器神经网络(Discriminator Neural Network)所组成,前者用于生成内容,后者则用于判别生成的内容,两个网络在对抗中进步,在进步后继续对抗,由生成式网络得到的数据也就越来越逼近真实数据,从而可以生成想要得到的数据。最终使用的数据结构如表2所示。

表2 肺部数据Tab.2 Lung data

图11 LIDC-IDRI数据集Fig.11 LIDC-IDRI data set

DCGAN 网络增加了训练样本的数量与多样性,有助于网络在更大的样本量上训练并有效地减少了过拟合情况,使改进的U-Net 训练更有效,分割结果更精确。

3.2 评估指标

本文采用骰子系数(DSC)、灵敏度(Sen)、特异性(Spe)以及正确率(Acc)4 个指标[19-20]对实验结果进行评估,计算方法如下:

其中θtp是真阳性像素值,θtn是真阴性像素值,θfp是假阳性像素值,θfn是假阴性像素值。

其中,真阳性(TP)是系统正确识别的非实质性像素结构的数量,假阳性(FP)是标记为非实质性像素结构的实质像素数量,真阴性(TN)是正确识别的实质像素数量,假阴性(FN)是标记为实质像素的非实质性像素结构的数量。

3.3 肺实质分割结果

该方法采用8 600张来自LIDC-IDRI数据库不同病人的CT肺图像,利用DCGAN网络得到1 400幅肺图像。这个由10 000幅图像组成的数据集以8:1:1比例分成训练集、测试集和验证集等3 部分并进行100次迭代。部分原始图像、预处理、边界检测、颜色形成、金标准及其分割结果如图12所示。将分割后的图像与金标准进行比较,并计算了该方法的性能。金标准是用Adobe Photo Shop手工绘制的。

图12 肺实质分割结果Fig.12 Lung parenchyma segmentation results

3.4 分割评估

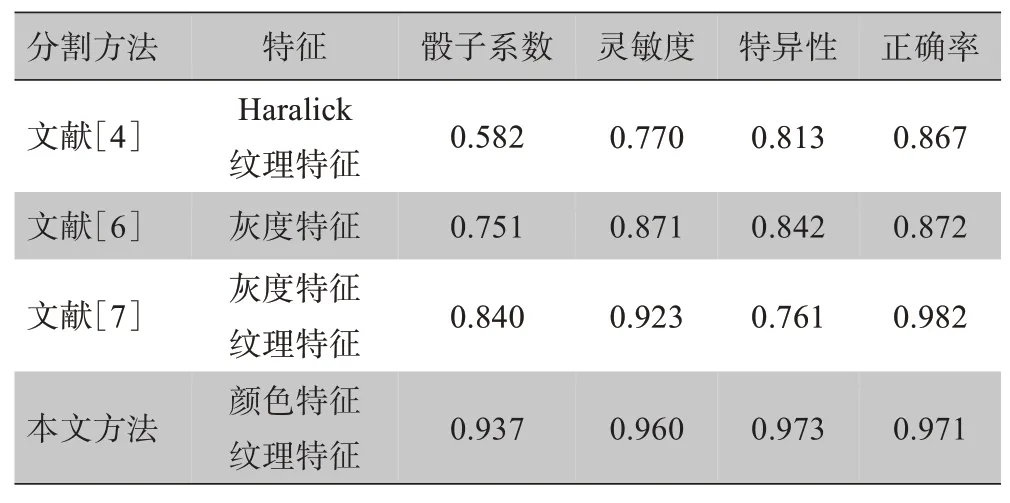

为了证明所提出的肺实质分割方法的有效性,对文献[4]、[6]、[7]中的方法进行实现、测试,并与LIDC-IDRI 数据集的同一组图像样本进行比较。从骰子系数、灵敏度、特异性、正确率等方面对其性能进行评价,结果见表3。

表3 不同方法肺分割性能比较Tab.3 Comparison of lung segmentation performance among different methods

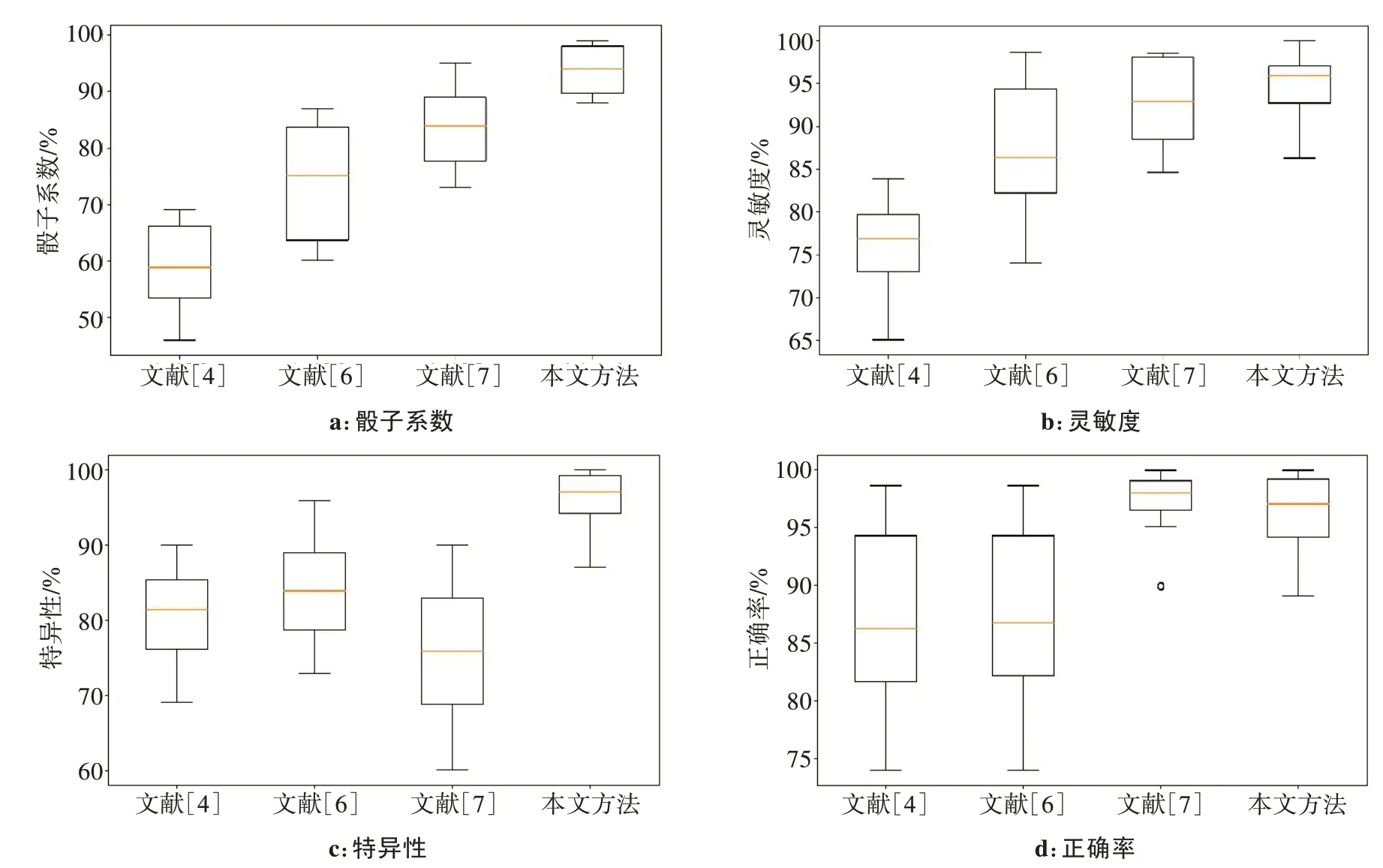

在LIDC-IDRI数据集上,本文提出的方法在所有评价指标上都取得了较好的结果。为了更加直观地对不同特征在分割过程中的结果进行分析,骰子系数箱型图、灵敏度箱型图、特异性箱型图、正确率箱型图如图13所示。从箱型图中可以直观地看出,各个指标上四分位数与下四分位数的距离较小,表明数据比较集中,中位数都偏向于上四分位数,数据分布偏向于上分位数区域。对比不同评价指标发现,本文方法的正确率略低于文献[7],但其他指标更好,综合优于文献[7]。与文献[4]和[6]单一特征的分割方法相比,本文方法的性能指标明显优于其分割指标,说明融合颜色特征与纹理特征在分割肺实质时可以使准确度大幅度提高,平均骰子系数也提高至0.937。

图13 不同评价指标箱型图Fig.13 Box charts of different evaluation indicators

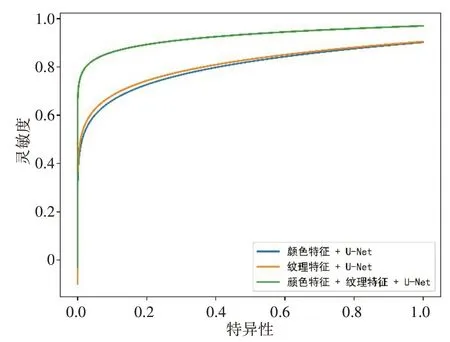

为了进一步验证颜色纹理特征与改进后的UNet 结合的方法能否有效提高肺实质的分割准确度,本文将单一特征和融合特征分别与该模型结合进行肺实质分割,不同特征肺分割性能比较结果如图14所示。从图14可以看出,使用单一颜色特征进行分割,特异性为0.92,灵敏度为0.86;使用单一纹理特征进行分割,特异性为0.92,灵敏度为0.87;使用融合特征时,特异性与灵敏度都达到0.96 以上,表明融合特征能有效提高肺实质的分割精度。

图14 不同特征肺分割性能比较Fig.14 Comparison of lung segmentation performance among methods using different features

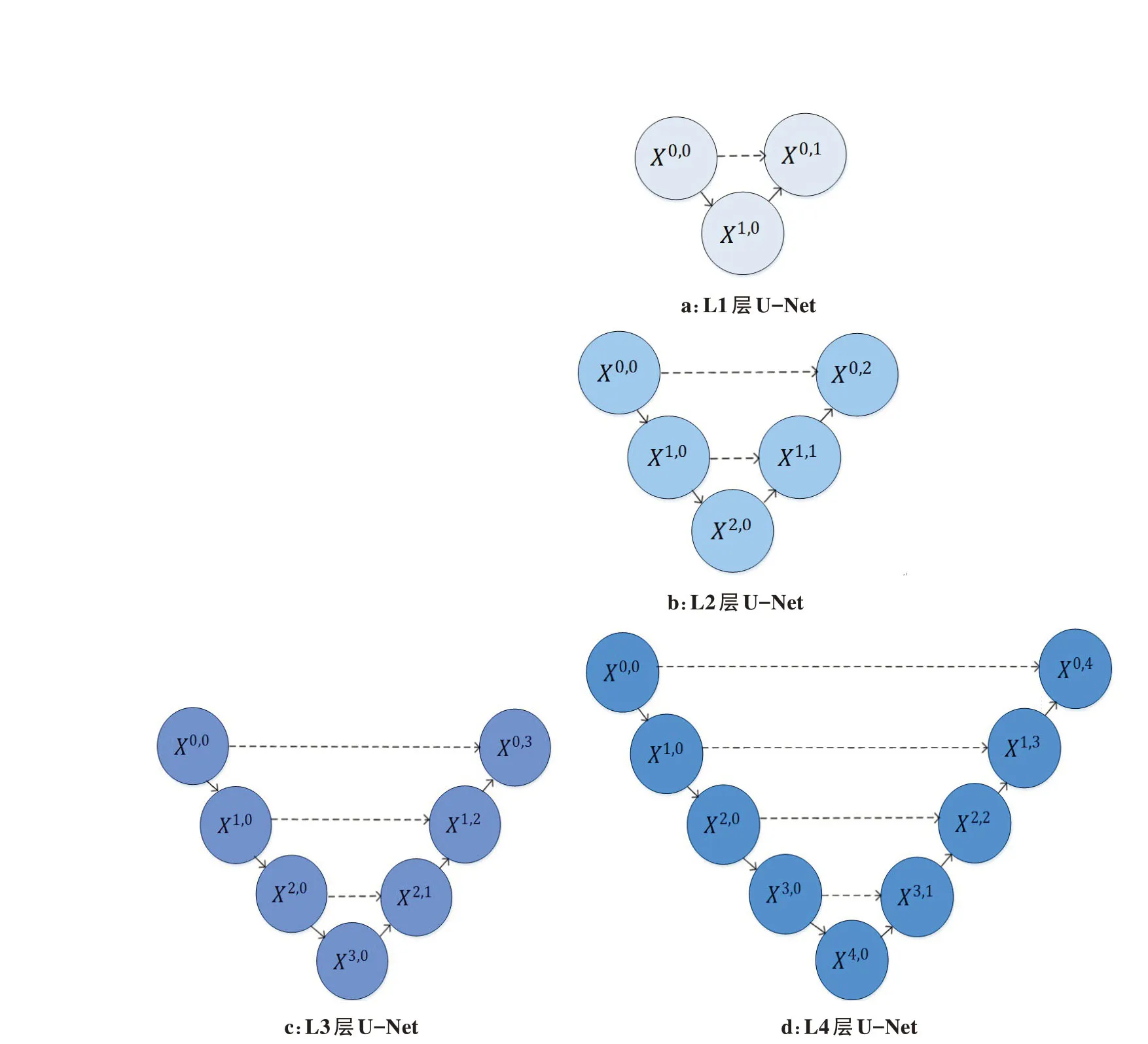

为了验证裁剪后的U-Net 深度用于肺实质分割的优越性,将融合后的颜色特征、纹理特征与其他不同深度的U-Net结合并对分割表现进行对比,不同深度的U-Net 结构如图15所示。采用相同的数据集进行不同深度的U-Net 分割实验,最终L1、L2、L3 和L4层的肺实质分割平均准确率分别为0.860、0.882、0.971、0.953。由此可见,随着U-Net 深度的增加,分割效果并非越深越好,当深度为3时,分割效果最优,当深度为4 时,分割精确度反而下降了,这是因为不同层次特征的重要性对于不同的数据集是不一样的,原始4 层的U-Net 对于细胞数据集分割效果最优,但在进行肺部数据分割时,浅层结构可以抓取图像简单的特征,比如边界、纹理和颜色等,而深层结构随着感受野增大,卷积操作也随之增多,能抓取到图像更多抽象的特征,导致特征冗余问题,降低了分割精度,因此本文将原始U-Net 裁剪成深度为3 的模型对肺实质进行分割并得到了不错的效果。

图15 不同深度的U-NetFig.15 U-Net of different depths

4 结论

本文提出了一种新的肺实质CT 图像分割方法,提出了一种高阶图像统计的纹理特征提取方法,将其与颜色特征融合用于肺轮廓边缘的增强,最后把DCGAN 网络增强的数据与原始数据混合作为改进后的U-Net模型的输入样本,通过训练模型得到肺实质分割结果,U-Net 模型结构简单,通过少量带有标注的肺部图像就能得到较好效果,是深度学习框架中最适用肺实质分割的模型。实验结果证明,所提出的方法在肺实质分割方面有显著改善。与仅依靠单一特征(如灰度、颜色、运动、形状、纹理特征等)的方法相比,特征融合有助于描绘更完整的肺轮廓,不会造成特征信息缺失而无法准确分割肺实质的问题。与原始的U-Net模型相比,裁剪后的模型更适于肺实质分割。该方法在验证性实验中获得了最高的骰子系数、灵敏度和特异性。未来工作将寻求与医学专家和研究人员的合作,将本文方法应用于临床诊断和外科导航,如用于COPD定量评估和辅助肺结节检测。