基于深度学习的双通道夜视图像复原方法

2021-07-02牛康力谌雨章沈君凤曾张帆潘永才王绎冲

牛康力,谌雨章,沈君凤,曾张帆,潘永才,王绎冲

(湖北大学计算机与信息工程学院,武汉 430062)

(∗通信作者电子邮箱zengzhangfan@hotmail.com)

0 引言

随着军事的发展和监控领域对于夜视需求的提高,夜视成像技术一直是研究者们关注的焦点。目前,由于新型的夜视仪或双目红外摄像头往往存在着购置成本较高的问题,使得很多领域仍然广泛使用着基于主动红外技术的红外摄像头[1],并往往依赖于算法来实现夜视图像的去模糊与清晰化。

夜视领域处理算法主要分为红外夜视图像处理、微光夜视图像处理和红外微光图像融合三大板块。对于红外图像处理板块,陈军等[2]提出了一种平稳小波域的红外图像增强算法,有效解决了红外图像对比度低、噪声大的问题;曹海杰等[3]提出了一种自适应逆直方图均衡化细节增强算法,避免了增强的红外图像产生过亮或过暗的问题;Liu 等[4]提出了一种基于四元数全变分法的红外图像超分辨率重建方法,利用相邻点之间的相关性,提高图像的抗噪能力和重建效果。对于微光夜视图像处理板块,王瑞尧等[5]提出了最大差值图决策的低照度图像自适应增强算法,能够对夜间等弱光源条件下的彩色图像有效增强;刘小园等[6]提出了一种适用于夜视环境的视频图像去噪和增强算法,能够有效增强夜视图像的可视性和清晰度;Bu 等[7]采用正则化恢复模型解决了夜视遥感图像亮度较低的问题,提高了恢复图像的质量;Ma 等[8]提出了一种基于HSI 颜色模型的微光传感器图像增强算法,不仅显著提高了图像的亮度和对比度,而且避免了颜色失真。对于红外微光图像融合板块,朱浩然等[9]提出了基于灰度变换与两尺度分解的夜视图像融合方法,融合后的图像能够适合人眼感知,具有较好的视觉效果;杨钒等[10]提出了红外与微光图像开窗配准融合处理方法,通过红外与微光图像各个像素点的对应匹配关系来完成窗口图像的快速配准与融合;Bamrungthai 等[11]开发了一个红外相机和可见光相机组成的图像融合系统;Liu等[12]结合新的分解、特征提取和融合方案,提出了一种新的融合方法来保持红外和可见光图像的细节。但是普遍存在以下问题:1)运行效率低和过度依赖退化模型,导致夜视图像处理效果并不理想,虽然在评价数值上有所提升,但是并没有起到实质性效果;2)对图像的处理时间较长,且对硬件性能要求较高,使算法在实用范围和实时性方面受到了极大的限制。因此,提出一种不受硬件条件限制、能够快速处理夜视图像的方法,从而得到高分辨率、高质量的夜视图像显得尤为迫切和必要。

随着深度学习的发展,越来越多的学者将深度学习引入到夜视图像处理的领域当中。针对夜间图像存在光照不均匀、色偏严重的现象,邹鹏等[13]提出了基于神经网络的光照分布预测夜视复原算法,这种算法解决了夜视图像的模糊问题,提高了夜视图像的成像质量,但是在光线弱、亮度低的环境下却显得有些乏力。红外图像能够很好解决夜视环境下低照度的成像问题,王丹等[14]也提出了对于红外图像的超分辨率重建方法,虽然这种方法很好地凸显了红外图像的细节信息,但是所用模型只能对红外图像进行处理,不适用于彩色夜视图像。

针对以上问题,本文提出了一种基于红外微光图像融合的深度学习夜视图像复原方法。该方法不仅解决了单一图像信息不足的问题,也通过引入深度学习的方法,对两种图像进行端到端的重建和复原。本文建立了两个深度卷积神经网络:一个是对红外图像进行超分辨率重建,意在得到细节信息丰富的红外图像;另一个是对微光图像进行图像增强,意在得到亮度较高的夜视图像。最后通过融合算法将两种处理后的图像进行融合,得到成像质量高、清晰度好的夜视图像。

1 本文方法

本文采用深度学习的方法,对红外进行超分辨率重建,对微光图像进行亮度增强,最后融合得到清晰的夜视图像。本文方法的结构如图1所示。

图1 本文方法的结构Fig.1 Structure of proposed method

1.1 基于全连接多尺度残差分块的两种网络建立

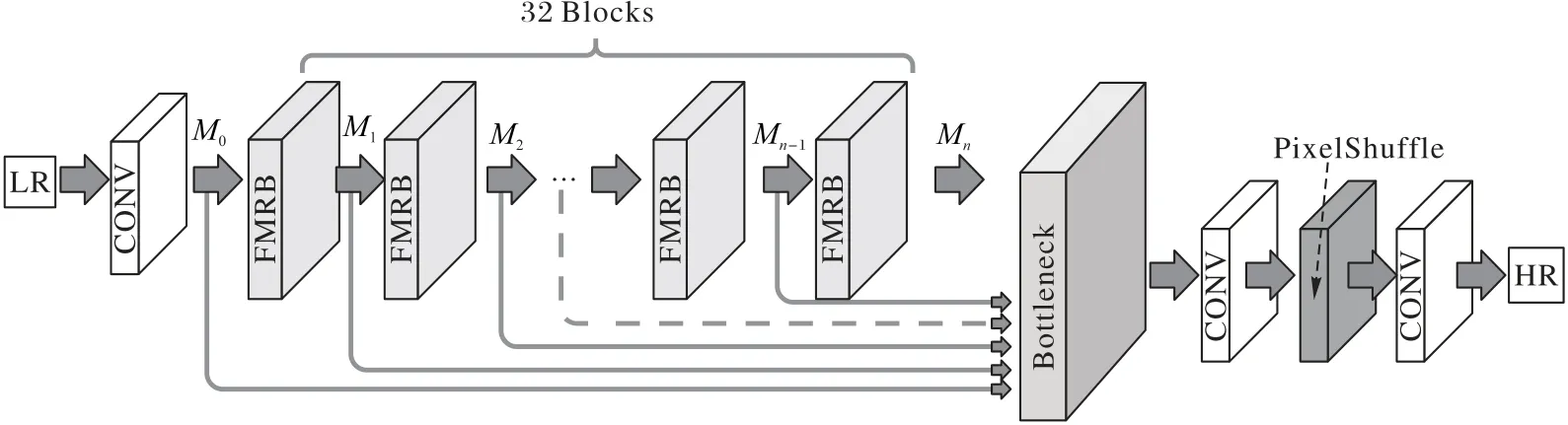

针对红外图像分辨率低、对比度低、视觉效果模糊的特点,本文建立了基于全连接多尺度残差分块(Fully connected Multi-scale Residual learning Block,FMRB)的图像超分辨率重建方法,对夜视红外图像进行超分辨率重建,网络结构如图2所示。

图2 红外图像的超分辨率重建网络结构Fig.2 Super-resolution reconstruction network structure of infrared images

本文所提出模型的网络结构如图2 所示。本文的模型将未经处理的低分辨率图像(Low-Resolution image,LR)作为输入,通过网络传输上采样获取较高的分辨率。模型的结构主要包括:

1)提取LR 低层信息的卷积层,由1 个卷积层(CONVolution layer,CONV)组成;

2)用于学习高层信息的多尺度残差学习网络,包含32个FMRB;

3)用于层次特征融合的结构,由1 个瓶颈层(Bottleneck)组成;

4)高分辨率(High-Resolution,HR)图像重建层,包含1个上采样层(PixelShuffle)和2个卷积层。

其中FMRB为本文提出的全连接多尺度残差分块,能够对图像信息进行多尺度的分解和提取,使得网络能够获得更好的学习效果。现有的卷积神经网络超分辨率(Super-Resolution Convolutional Neural Network,SRCNN)重建算法,网络深度较浅,不能对图像信息进行较好的提取,而本文算法具有更深的网络深度,由32 层FMRB 组成的多尺度残差学习网络能够使处理后的图像具有较好的重建效果。针对普通超分辨率重建网络由于层数过多引起的梯度弥散现象,本文所提网络通过FMRB 中各个单元全连接的方式,避免了弥散问题,同时也降低了计算的复杂度,极大提升了网络的运行速度。

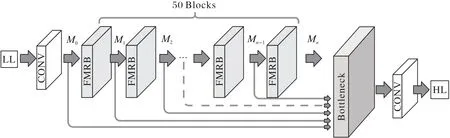

针对微光图像信噪比低、可见效果差的特点,本文建立了基于深度学习的图像增强网络,从而对微光图像进行增强处理,提高图像的亮度和可见度,使得图像具有更好的视觉效果。其网络结构对图像信息的提取部分和上文网络基本相同,但是图像重建模块换成了色彩复原模块,具体网络结构如图3所示。

图3 微光图像的增强网络结构Fig.3 Enhancement network structure of low-light-level images

微光图像增强网络将低亮度图像(Low-Light image,LL)作为输入,通过网络进行信息提取和颜色复原,得到最终的高亮度图像(High-Light image,HL)。模型的结构主要包括:

1)提取LL图像低层信息的卷积层,由1个CONV组成;

2)用于学习高层信息的多尺度残差学习网络,包含50个FMRB;

3)用于层次特征融合的瓶颈层,由1个Bottleneck组成;

4)HL颜色复原层,包含1个三通道输出的卷积层。

目前基于深度学习对图像进行亮度增强的网络模型并不多见,本文建立了“多尺度残差学习”加“颜色复原”网络模型对微光图像进行亮度增强。相较于普通的物理模型算法,本文模型能够进行端到端的图像增强,FMRB 信息提取层使微光图像特征被更好地学习,增强后的图像经过一层三通道输出卷积层处理,使最终输出图像具有更好的颜色效果。

1.2 两种深度学习网络的异同点

图2 所示网络,是专门针对红外夜视图像进行超分辨率重建的模型结构,其考虑了红外图像分辨率差、视觉效果模糊的特点,运用多尺度残差学习网络进行图像的特征提取。图3 所示网络,是专门针对微光夜视图像进行图像增强的模型结构,其考虑了微光图像信噪比低、可见效果差的特点,同样运用本文所提出的多尺度残差学习结构来进行图像信息的提取。但不同的是,相较于红外图像包含的细节信息,微光图像一般包含了更多的人物轮廓和场景信息,含有的信息更加丰富,因此对于微光图像的处理需要更深的网络进行处理,以得到更好的增强效果。两个网络在图像信息提取部分结构相同,都使用了相同的瓶颈层来进行图像的层次特征融合,但是微光图像对应的网络深度更大。

图2 网络和图3 网络后半部分完全不同。图2 网络后半部分,是对红外图像进行超分辨率重建的结构,两个卷积层和一个上采样结构提高了图像的分辨率,使得红外图像的细节信息更加具体,图像更加清晰;图3 网络的后半部分,是对微光图像的颜色复原结构。由于在微光图像经过50 层FMRB学习处理后,其对比度和信噪比已经得到提升,但是颜色却不够自然,具有一定的失真。因此本文使用一个具有三通道输出的卷积层来对处理后的微光图像进行颜色复原,以得到可见度高、清晰度好的微光图像。

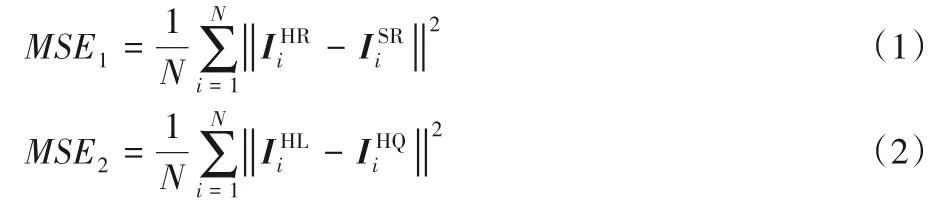

超分辨率重建网络通过对源图像ISR下采样得到低分辨率图像ILR,经过网络处理后得到高分辨率图像IHR;图像增强网路随机降低源图像IHQ的亮度和对比度从而得到低亮度图像ILL,经过网络处理后得到高亮度图像IHL。而误差函数的目的就是计算ISR与IHR以及IHL与IHQ之间的差别。因此选取一个好的误差函数,可以尽可能地降低差别,从而使两个网络同时达到较好的学习效果。本文采用均方误差(Mean Square Error,MSE)作为误差函数:

其中:MSE1是图2 网络的误差函数表达式;MSE2是图3 网络的误差函数表达式。

1.3 图像特征的提取

两种网络对红外夜视图像和微光夜视图像的特征提取主要由两部分组成:层次特征融合结构(Hierarchical Feature Fusion Structure,HFFS)和全连接多尺度残差分块(FMRB)。

文献[15]研究表明,随着网络深度的增加,网络对图像的重建能力会越来越好。但是如果由于网络的弥漫现象,导致随着网络深度的增加,图像特征在传输过程中逐渐消失,重建的效果还不如浅层的网络结构。在这一问题的驱使下,许多学者提出了相应的解决方法,其中最为简单的解决方法是建立密度连接的卷积神经网络,如文献[16]方法,该方法使得网络中任意的两层都有直接的连接,每一层的输入都是之前所有层的并集,有效地解决了梯度弥散的现象。但是这种方法不能充分利用输入图像的特征,并且在处理时会产生过多的冗余信息。

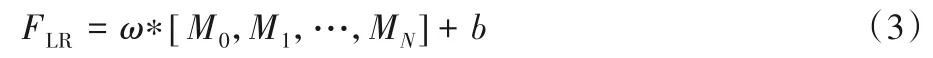

本文提出了多尺度的残差学习网络,不仅通过残差分块的方式有效解决了梯度弥散问题,在分块中也同样采取了全连接的方式,使图像信息能够受到不同尺度卷积层的处理和提取,有效地避免了现有方法不能充分利用图像信息的问题。并且对于信息冗余现象,本文提出了一种简单的层次化特征融合结构,引入了一个以1×1的卷积核为结构关键的瓶颈层,从所有层次特征中自适应地提取有用的信息,极好地解决了信息冗余的问题,减少了网络计算的复杂度。层次特征融合结构(HFFS)的输出可以表示为:

其中,M0是第一卷积层的输出,Mi表示第i个FMRB 的输出,[M0,M1,…,MN]表示级联操作。

全连接多尺度残差分块(FMRB)能够学习不同卷积下图像的特征,充分利用了图像的信息,其结构如图4 所示。FMRB 包含两部分:多尺度特征融合和局部残差学习。全连接多尺度残差分块的具体结构如图4所示。

图4 FMRB结构Fig.4 Structure of FMRB

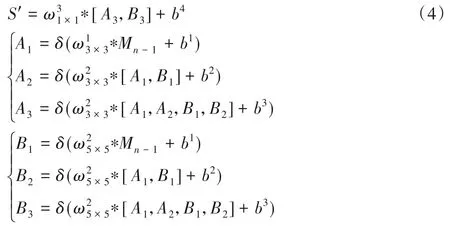

对于多尺度特征融合,不同于以往的工作,本文构造了一个双旁路网络,不同的旁路使用不同的卷积核。这些旁路之间的信息可以相互共享,从而能够检测出不同尺度下的图像特征,可以用公式表示为:

其中,ω和b分别表示权重和偏差,上标表示它们所在的层数,下标表示该层中使用的卷积核的大小;δ(x)=max(0,x)表示ReLU(Rectified Linear Unit)函数;A1、A2、A3、B1、B2、B3分别表示不同尺度下的特征,[A1,B1]、[A1,A2,B1,B2]表示这些特征图像的融合;M表示发送到FMRB 的特征映射的数量。因此,第一卷积层的输入和输出具有M个特征映射,第二卷积层有2M个特征映射,这些特征映射被连接起来并发送到1×1 卷积层。该层将这些特征映射的数目减少到M,因此FMRB 的输入和输出具有相同数目的特征映射,这种特别的体系结构使得多个FMRB能够同时使用。

对于局部残差学习部分,为了提高网络的效率,本文对每个FMRB 都采用残差学习,在形式上,全连接多尺度残差分块(FMRB)可以表示为:

其中:Mn-1和Mn分别代表FMRB 的输入和输出;S′+Mn-1通过在各个元素间快捷连接而执行。这种局部残差学习的方法使用使得计算的复杂性极大降低,同时也提高了网络对图像信息的提取性能。

1.4 自适应加权平均融合算法

当采集的红外图像和微光图像分别通过对应的深度卷积神经网络处理之后,得到了细节增强的红外夜视图像和亮度提高的微光图像。此时如何将两者进行融合显得尤为关键。为了使红外图像的细节信息和微光图像的场景信息完美融合,不产生过多冗余信息,本文采用自适应加权的平均融合算法,通过图像的显著性来进行图像的加权融合。

图像的显著性是指在图像的像素值和均值之间的差别,当像素值与均值相差越远时,其显著性越高,图像在融合时所占权重也就越大。高斯函数能够根据偏离均值的远近得到不同的结果,从而能对图像显著性进行定量的分析。自适应加权平均融合算法是分别计算红外夜视图像和微光图像在像素(i,j)处的显著性。

融合分三种情况进行,若红外图像更为显著,根据图像的显著性以及高斯函数可构建出微光图像的权重为:

根据微光图像wvis可得红外图像的权重为wir(i,j)=1-wvis(i,j)。因此,最终的融合图像可以表示为:

其中:VIS(i,j)、IR(i,j)分别代表微光图像、红外图像在像素点(i,j)处的权值;δir代表红外图像方差;μn代表图像均值。若可见光图像更为显著,则红外图像的权重可以表示为:

根据wir可得wvis(i,j)=1-wir(i,j),此时融合图像的表达式为:

其中δvis为可见光方差。若红外图像和微光图像两者的显著性相同,此时将两者权重同时赋值为0.5,则融合后的图像表达式为:

分析可知,自适应加权平均方法能够将微光图像和红外图像包含的主要结构融合到结果图像中,使得融合图像包含的场景信息更加完整。在实验过程中,分别采用公共数据集、室内图像、室外图像进行实验验证,此时三种图像的差异性具有明显的区别,因此自适应加权融合算法能够更好地处理不同环境下的图像融合,使融合图像的质量达到最好。

2 实验与结果分析

2.1 数据集的选取与建立

对于超分辨率重建网络和图像增强网络,本文选用不同的图像进行网络的学习和训练。对于图像增强网络,构造了一个包含大量高质量图像(High-Quality image,HQ)和低亮度图像(LL)的数据集来学习FMRB网络中的参数。本文方法在UCID[17]数据集和BSD 数据集中初步选取了20 000多张图像,但是这些图像往往存在着对比度较低、曝光不足或模糊失焦等问题。因此需对图像进行进一步的筛选,排除清晰度低、尺寸太大或太小,以及计算机生成的图像,从而获得了10 000张质量高、清晰度好的HQ 图像。之后将这些图像通过Photoshop 进行随机亮度降低操作,并采用Gamma 矫正,使每幅HQ 图像生成1 幅LL 图像。因此,本文一共拥有了10 000个训练样本对。将这10 000 个样本对分成10 组,每组含有1 000 个样本对,采用交叉训练的方法投入网络中进行训练,即每一轮训练都会选取9 组样本对作为训练集,剩下的1 组将用作测试集,并用其对网络参数进行调节,每一轮的测试集都不同,以此种方式循环10 轮,便构成了交叉训练。通过此方式,能有效地筛选出对网络训练更有利的数据集,防止因为部分训练集效果不佳而对网络整体效果产生影响。

对于红外图像超分辨率网络的训练,本文在FLIR 数据集中筛选了10 000张分辨率较高的红外图像(HR),对每张图像进行下采样,获得一张对应的低分辨率图像(LR)。因此,红外数据集总共含有10 000 个训练样本对,依旧使用上述交叉训练方法进行网络参数的学习和训练。

2.2 训练过程及参数设置

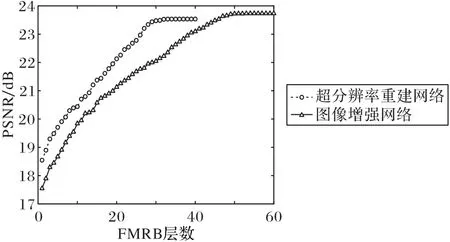

本文参数设置的重点是FMRB 层数的设置。为了找到最合适的层设置,本文实验做了很多尝试来设置FMRB 的层数。为了节省训练时间,不需要使用所有的数据集。在数据集中随机选取100 张图像作为训练集,10 张图像作为每个实验的测试集。不同FMRB层设置的测试结果如图5所示。

图5 不同FMRB层数设置的测试结果Fig.5 Test results of different FMRB layer settings

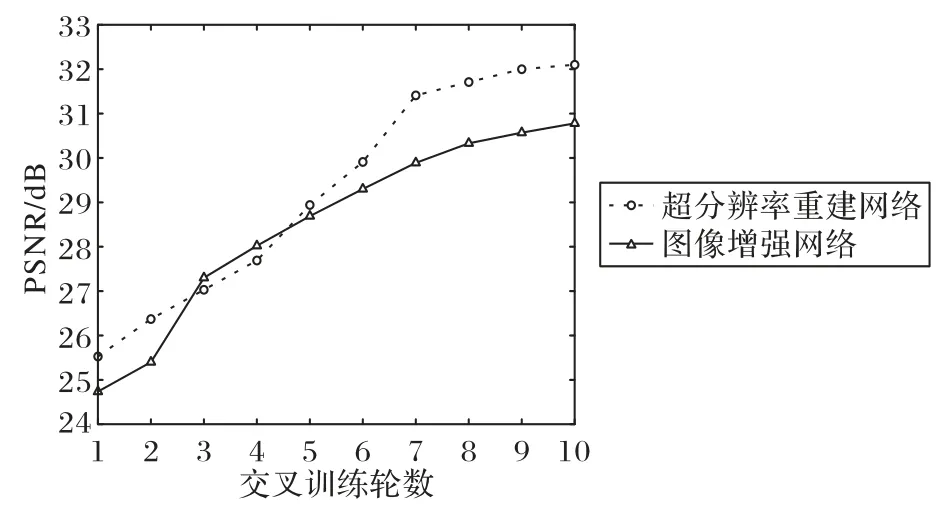

通过峰值信噪比(Peak Signal to Noise Ratio,PSNR)来判断训练效果。根据结果,本文将重构网络的FMBR 层设置为32 层,并将增强网络的FMRB 层设置为50 层。接下来,对网络进行交叉训练。本文将10 000 个样本对分成10 组,每组包含1 000个样本对,并采用交叉训练的方法进行网络训练。也就是说,每轮训练将选择9 组样本对作为训练集,剩下的1 组作为测试集,可以调整网络参数。每轮测试集不同,周期为10 轮。这样可以有效地筛选出更有利于网络训练的数据集,防止一些训练集效果不佳而影响网络整体效果。交叉训练结果如图6所示。

由图6可以看出,经过10轮交叉训练,本文中的两个网络都取得了良好的训练效果。超分辨网络的PSNR 值达到了32.20 dB,增强网络的PSNR值达到了30.79 dB。

图6 交叉训练结果Fig.6 Cross training results

2.3 实验配置

本文实验的训练平台为:操作系统为Ubuntu 14.04,CPU 为Core i7-7700K(Quad-core 4.2 GHz),显卡为NIVID GTX 1080ti。训练测 试平台 为CUDA8.0,cuDNN5.1,Pytorch0.4,Python3.6。在主要参数学习率的设置上,本文采用的是学习率衰减的办法,这样能有效防止训练时间过长。设定初始学习率为0.001,每迭代100 000次,学习率降为原来的1/10,采用随机梯度下降(Stochastic Gradient Descent,SGD)法对网络进行训练。

2.4 评价指标的选取

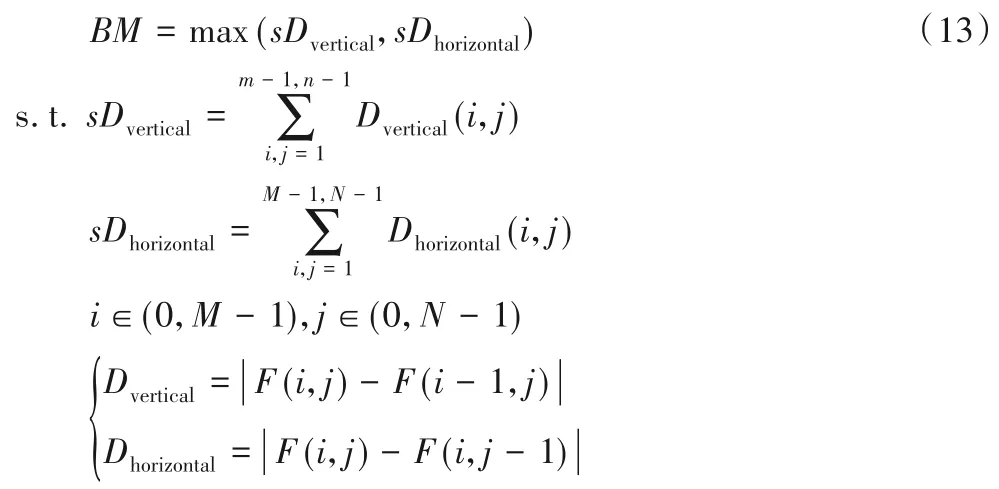

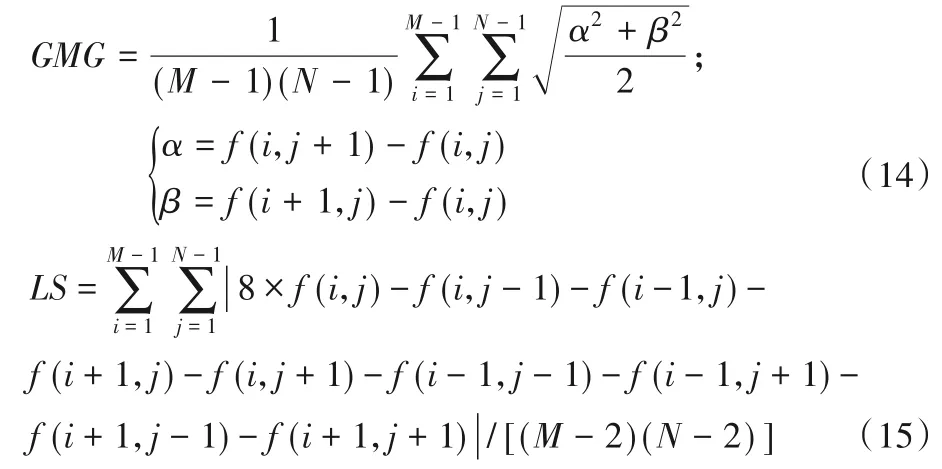

峰值信噪比(PSNR)和结构相似度(Structural SIMilarity,SSIM)是衡量图像重建和增强质量最常用的两个指标。前者定量计算处理结果与原始图像之间的误差。PSNR越高,失真越小,而SSIM 越接近1,恢复效果越好。因此,本文将这两个指标用于公共数据集实验,客观评价各种重建方法的优缺点。但在现场实验中,由于没有参考图像,无法使用PSNR 和SSIM。因此本文选择模糊度量(Blur Measure,BM)[18-19]、灰度平均梯度(Grayscale Mean Gradient,GMG)和拉普拉斯和(Laplace Sum,LS)[18]作为评价指标。BM 值越小,图像越清晰;GMG和LS值越高,图像质量越高。BM的表达式为:

其中:Dvertical和Dhorizontal表示垂直和水平方向上的不同图像;F(i,j)是图像平面上(i,j)点的像素;(M,N)是图像的大小。BM 可以在0~1 的范围进行规范化。GMG 和LS 的表达式如下:

2.5 结果分析

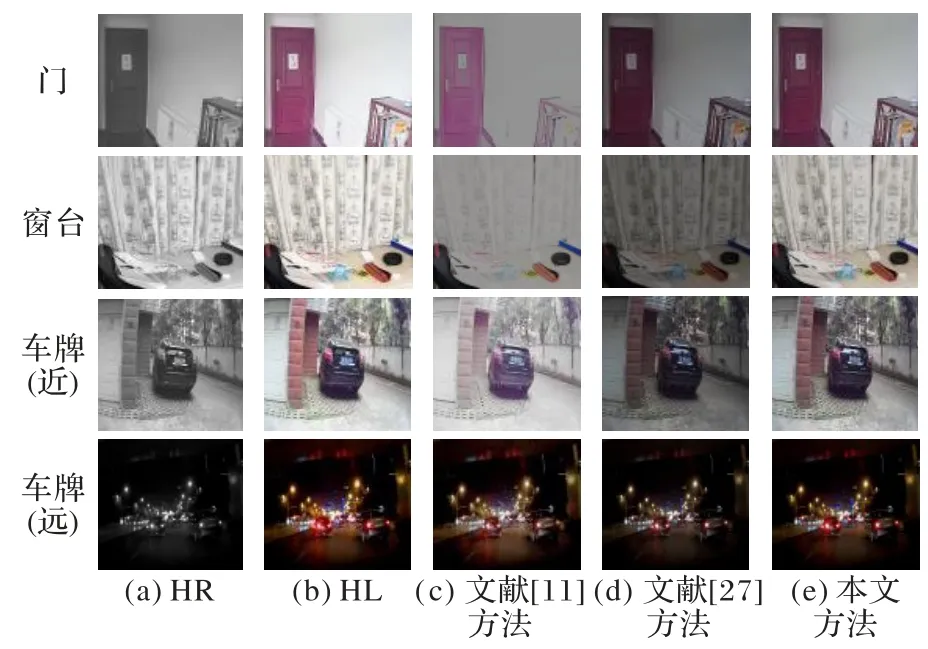

为了客观地评价本文方法性能,首先进行公共数据集实验,分别测试了两种网络模型对图像的处理水平;然后,进行了现场实验,测试融合后图像对夜视的复原效果。在公共数据集实验中,本文从NTE 公共数据集中选取红外图像,进行下采样操作,再通过本文重建网络进行处理,并将本文方法实验结果和SRCNN[20]、VDSR(accurate image Super-Resolution using Very Deep convolutional networks)[21]、DRCN(Deeply-Recursive Convolutional Network for image super-resolution)[22]、EDSR(Enhanced Deep residual networks for single image Super-Resolution)[23]四种超分辨率重建算法进行对比;从NTE 中选取高清图像,进行亮度降低操作,再通过本文增强模型进行处理,将其实验结果和现有图像增强算法SRIE(a weighted variational model for Simultaneous Reflectance and Illumination Estimation)[24]、MSRCR(Multi-Scale Retinex with Color Restoration)[25]、LIME(Low-light image enhancement via Illumination Map Estimation)[26]进行对比。在现场实验中,选取了红外摄像头拍摄的红外图像和微光图像,经过本文方法进行图像的重建、增强及融合,并和现有的融合算法如文献[11]算法和文献[27]算法进行对比。

将本文方法与其他对比方法进行训练时间的比较,具体的训练时间如表1 所示。本文方法训练时间最少,具有一定优势。

表1 不同方法训练时间对比Tab.1 Comparison of training time of different methods

对于超分辨率重建网络的测试,本文选取了两张NET 公共数据集中的红外图像,将下采样后的图像进行超分辨率重建,意在将低对比度、低信噪比的红外图像重建为高分辨率、细节效果好的清晰图像。PSNR 和SSIM 由原图和处理后的图像计算得出,具体的测试结果如图7~8所示。

图7 红外图像重建效果对比(林荫道)Fig.7 Reconstruction effect comparison of infrared images(avenue)

图8 红外图像重建效果对比(房子)Fig.8 Reconstruction effect comparison of infrared images(house)

从图像的重建效果来看,SRCNN 方法消除了一定程度的模糊,但是引入了较大的振铃效应。VDSR 减弱了振铃效应,但图像失真没有得到很好的改善。DRCN 提高了图像的分辨率,但图像的失真问题仍旧没有得到实质性的改善。可见,对比方法在提高分辨率和去模糊方面有着显著的效果,但是不能有效地纠正图像失真。本文方法不仅能消除一定的图像噪声,而且能显著改善图像的失真度,验证了本文重建算法的有效性。

从评价结果来看,相比之下SRCNN方法的PSNR值最小,表明图像失真情况最为严重;VDSR 方法的SSIM 值比SRCNN方法的SSIM 值要大,但增幅很小。从各项评价指标来看,本文方法处理的图像均取得了最好的结果,可见本文方法重建图像的质量较高。在运行时间方面,本文方法所需时间最短,优势明显。

对于图像增强网络的测试,本文选取了两张NET 公共数据集中的高清图像,将亮度降低后的图像进行超分辨率重建,将信噪比低、可见效果差的红外图像增强为高亮图,获取视觉效果好的清晰图像。PSNR 和SSIM 由高清图像和处理后的图像计算得出,结果如图9~10所示。

图9 微光图像增强效果对比(雨棚)Fig.9 Enhancement effect comparison of low-light-level images(canopy)

从图像的增强效果看,SRIE 方法处理后的图像较原图像亮度有所增强,但是仍然较暗。MSRCR 方法对图像的亮度进行过度的提升,虽然图像亮度很高,但是曝光度过大,不适于人眼观察。LIME 方法相较于前两种方法处理效果更佳,并且拥有较短的处理时间,但是其仍然存在图像亮度较暗的问题。本文方法不仅使图像具有了较好的亮度,图像的颜色也没有失真,具有更好的视觉效果。

从评价结果上看,本文方法处理的图像PSNR 值最大,可见本文方法对失真问题的处理效果最佳;其SSIM 值最小,可见本文方法增强的图像质量最佳,更逼近于原高清图像。

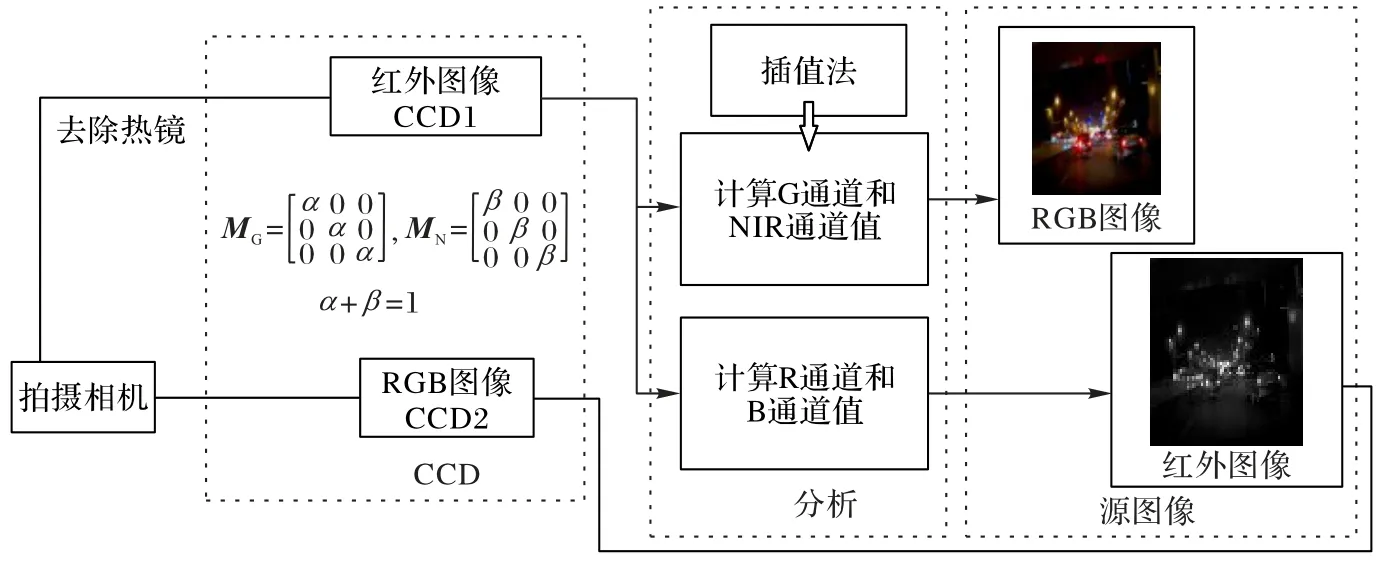

对于现场实验,实验设备配置如下:镜头焦距为6 mm,监控角度为60°,监控距离为15~25 m,供电电压为12 VDC。相机两侧的挡板尺寸为高1.2 m、宽1 m,用于模拟夜间的弱光条件。捕获的图像被传送到计算机进行处理和显示。实验系统的具体硬件结构如图11所示。

图10 微光图像增强效果对比(街道)Fig.10 Enhancement effect comparison of low-light-level images(street)

图11 实验系统图像采集结构Fig.11 Image acquisition structure of experimental system

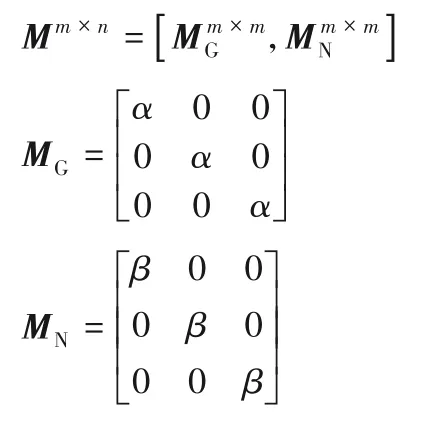

测量矩阵M由Bayer 阵列的定义确定。由于M包含G 通道值和NIR通道值的数据,其表示如下:

参数α和β是分别形成G 通道值和NIR 通道值的相机滤波器的相对感光系数。所以α+β=1且0 <α<1,0 <β<1。

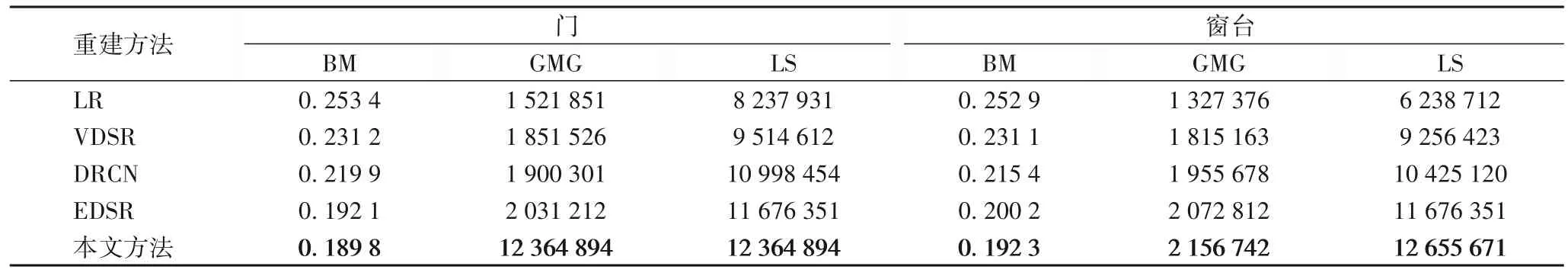

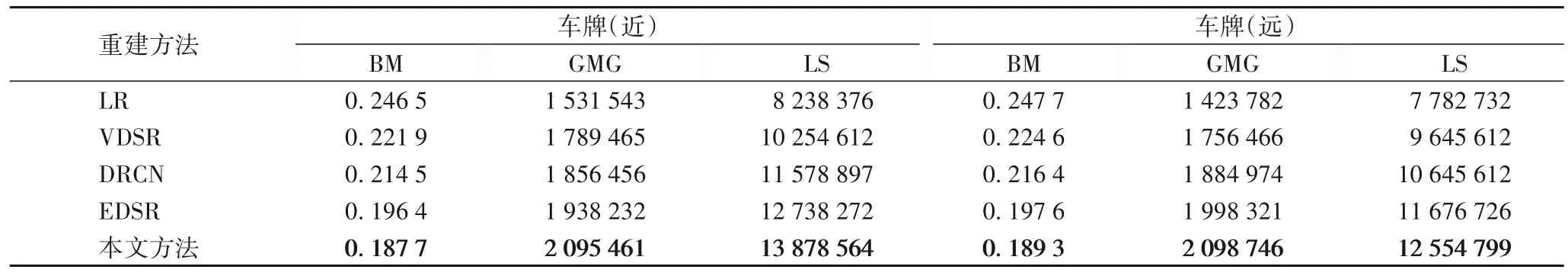

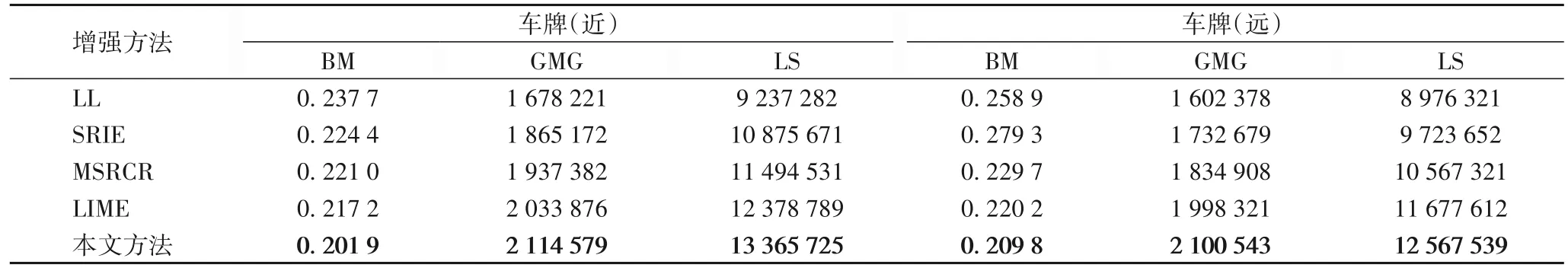

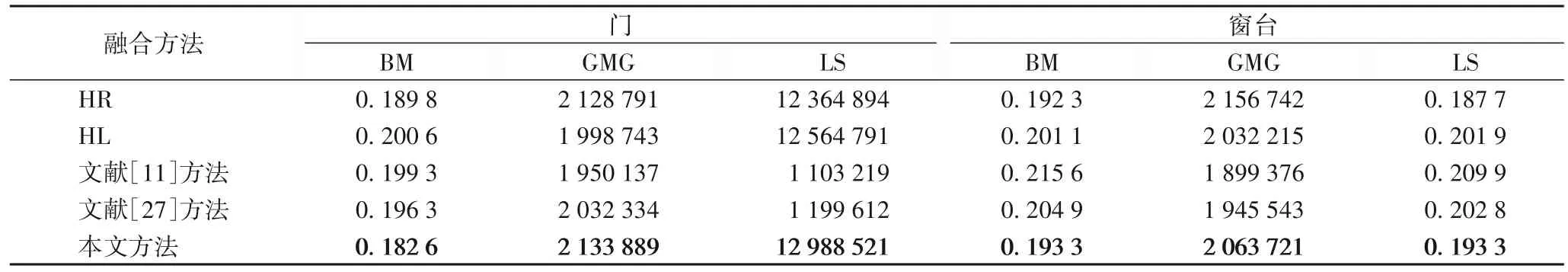

在现场实验中,本文分别在室内和室外进行实验,测试本文方法对于夜视图像的复原效果。对于室内夜视图像测试,实验的目的是让拍摄的物体细节更加具体,达到增加夜视监控的识别效果;对于室外夜视图像测试,实验的目的是让拍摄的车牌信息更加清晰明显,达到增加监控探头获取车牌信息的能力和效果。由于现场测试中没有高清晰度的原始图像来计算PSNR 和SSIM,因此本文选择BM、GMG 和LS来评估恢复图像。超分辨率重建图像如图12 所示,增强图像如图13 所示,融合图像如图14所示。具体评价值见表2~7。

图12 现场红外图像超分辨率重建结果Fig.12 Super-resolution reconstruction result of infrared images in field test

图13 现场微光图像增强结果Fig.13 Enhancement results of low-light-level images in field test

图14 现场图像融合结果Fig.14 Image fusion results in field test

表2 现场室内红外图像超分辨率重建评价结果Tab.2 Evaluation results of super-resolution reconstruction of infrared indoor images in field test

表3 现场室外红外图像超分辨率重建评价结果Tab.3 Evaluation results of super-resolution reconstruction of infrared outdoor images in field test

表4 现场室内微光图像增强评价结果Tab.4 Evaluation results of enhanced indoor low-light-level images in field test

表5 现场室外微光图像增强评价结果Tab.5 Evaluation results of enhanced outdoor low-light-level images in field test

表6 现场室内融合图像评价结果Tab.6 Evaluation results of indoor fusion images in field test

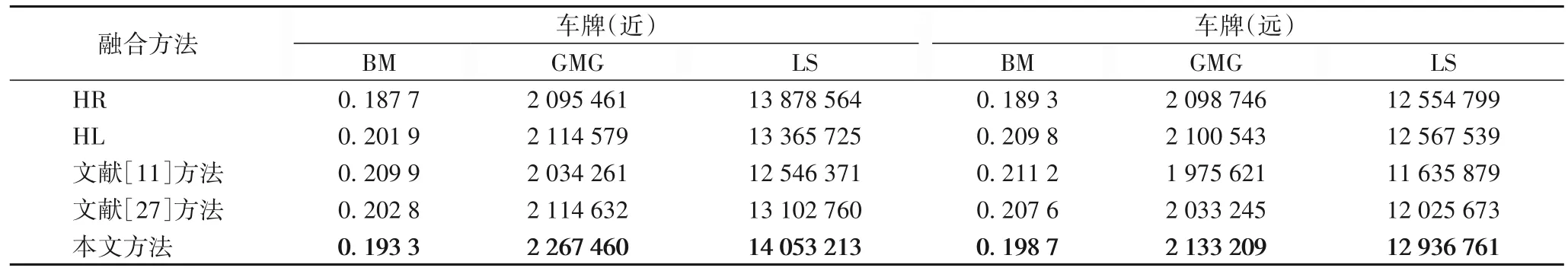

表7 现场室外融合图像评价结果Tab.7 Evaluation results of outdoor fusion images in field test

从图像效果看,对于室内夜视图像的复原,红外图像的重建使物体的细节更加具体化,微光图像的增强使场景视觉效果更适于人眼观察。经过自适应加权平均融合算法计算,在室内夜视图像的融合中,红外图像每个像素点的显著性普遍优于微光图像,因此在融合时红外图像所占的权重更大,融合后的室内图像所包含红外图像的信息也更多。复原后的图像能够更好看清物体的具体信息和特征,表明本文方法对室内夜视图像具有较好的复原效果;对于室外夜视图像,红外图像的重建使车牌信息更加清晰,微光图像的增强使室外场景信息更加突出。在室外夜视图像的融合中,微光图像每个像素点的显著性普遍更优,因此融合后的室外图像包含更多微光图像的信息。复原后的图像车牌信息更加清晰可见,表明本文方法对室外夜视图像具有较好的复原效果。

从评价结果看,BM 值越小,图像越清晰,GMG 和LS 值越大,图像质量越高。无论是室内还是室外的夜视复原图像都具有很小的BM值和很大的GMG、LS值,可见本文方法复原后的夜视图像质量较高。

3 结语

基于深度学习的思想,本文提出了两种基于全连接多尺度残差分块(FMBR)的深度学习网络,能分别对红外图像和微光图像的特征提取和学习训练。通过公共数据集实验可知,相较于SRCNN,使用融入FMRB 的深度学习网络得到的红外夜视重建图像的PSNR 和SSIM 平均值分别提升3.56 dB和0.091 2;相较于MSRCR,得到的微光夜视增强图像的PSNR 和SSIM 平均值分别提升6.82 dB 和0.132 1,重建图像的清晰度明显得到改善,增强图像的亮度也明显得到提升,融合后的夜视图像具有较好的复原效果。

不可否认的是,由于红外图像属于灰度图像,在和微光图像融合后难免会出现颜色失真的现象,但是本文方法致力于夜视图像的细节凸显和信息复原,颜色的轻度失真有时不仅不会影响复原图片的质量,反而会增强图像的视觉效果,因此对本文方法的可行性方面并无影响。同时在现场实验中,本文发现对于室内夜视图像,红外图像往往更为显著;而对于室外夜视图像,微光图像往往更为显著。因此对于以后的夜视复原方法,可以更多地对不同场景夜视图像的复原做进一步研究,以便得到更好的复原效果。