一种利用类别显著性映射生成对抗样本的方法

2021-06-24叶启松戴旭初

叶启松,戴旭初

(中国科学技术太学 网络空间安全学院,安徽 合肥 230026)

0 引言

深度学习技术在计算机视觉、语音识别、自然语言处理等各个领域有着广泛的应用,然而有研究表明,深度神经网络具有一定的脆弱性[1],该脆弱性使得深度神经网络容易受到攻击,这一问题引起了广泛的重视。对抗样本攻击是攻击深度神经网络的主要方法,该方法通过对原样本添加微小的、不可察觉的扰动生成对抗样本,使得深度神经网络对该样本做出错误的预测。

对抗样本的迁移性指针对结构已知的深度神经网络模型生成的对抗样本,能使得结构未知的深度神经网络模型对该样本做出错误预测。如果对抗样本有更好的迁移性,其就能更好地攻击结构和参数未知的模型,这也是利用对抗样本进行攻击的主要应用场景。攻击者在拥有深度神经网络模型的结构和参数信息的前提下进行的对抗样本攻击,称为在白盒条件下的对抗样本攻击。现有的白盒条件下的对抗样本攻击方法虽然有较高的攻击成功率,但是其生成的对抗样本的迁移性较差,在主要的应用场景中并不适用。 迁移性差的主要原因在于,这类方法所生成的对抗样本与模型的结构和参数高度耦合,其扰动难以对结构和参数不同的其他模型进行有效的干扰。迁移性差的这一缺点在目标神经网络引入了防御方法时表现得更为明显。

为了提升对抗样本的迁移性,文献[2]通过训练生成式神经网络,同时针对多个目标模型生成对抗样本以提升对抗样本的迁移性,该方法在对抗样本的生成阶段不涉及任何梯度计算,生成过程较快。文献[3]以对抗训练的方式训练生成式对抗网络,对抗训练使得生成器能够学习到攻击结构未知模型的策略,利用该生成器生成对抗扰动,添加在原样本中得到对抗样本,该对抗样本具有较好的迁移性。 文献[4]利用演化算法,得到关键位置(在样本中对结果影响较太的像素位置),并在关键位置添加扰动得到对抗样本,该对抗样本在扰动量较小的同时拥有较好的迁移性。

基于梯度权重的类别显著性映射(Gradient-weighted Class Activation Map,Grad-CAM)[5]能够提取出样本的关键特征信息,该关键特征信息在不同模型中有较高的相似度,并且对模型的预测结果影响较太。 利用Grad-CAM 这一重要特性,本文提出一种生成对抗样本的新方法——基于Grad-CAM 和生成式神经网络的对抗样本生成方法(Adversarial Example Generator by Using Class Activation Map,AEG-GC),该方法的特点是生成的对抗样本与原样本相差较小,但它们的显著性映射相差较太。 另外,实验表明,该方法所得到的对抗样本具有很好的迁移性。

1 相关工作简介

1.1 基于梯度权重的类别显著性映射

提取样本的关键特征信息的主要方法有Guided-Backprop[6]、 CAM[7]、 Grad-CAM[5]。 Guided-Backprop 获取关键特征信息的过程涉及两步:(1)在卷积神经网络中,利用卷积层替换池化层。 (2)利用反向传播算法,计算模型的输出结果对输入的梯度。该梯度信息能够表示所提取的关键特征。 该方法提取出的关键特征信息示意图如图1(b)和图1(d)所示,这两张图分别以猫和狗作为研究对象,虽然Guided-Backprop 能够较好地提取出样本的关键特征信息,但是所提取出的特征信息也容易受到非研究对象的干扰,例如图 1(b)中以猫作为研究对象,仍然受狗这一类别的影响严重。 CAM 方法获取关键特征信息的过程涉及两步:(1)将卷积神经网络中的全连接层替换为全局平均池化层(Global Average Pooling,GAP)[8]。 (2)以全局平均池化层的结果作为系数,对最后一层卷积层的每个通道进行加权求和,加权求和的结果即为CAM 所提取的关键特征信息。CAM 方法提取的关键特征信息如图1(c)和图1(e)所示,由图可见猫和狗的轮廓信息更加清晰。 然而,Guided-Backprop 和 CAM 方法都有一个共同的缺点,它们在提取关键特征信息时,需要对原模型进行改造,并重新训练新的卷积神经网络,这破坏了原网络模型的结构和参数信息,同时这一过程也需要花费较太的计算代价。Grad-CAM 在 CAM 的基础上进行改进,其建立显著性映射的过程,不需要重新训练原卷积神经网络。 本文将在2.1 节详细介绍Grad-CAM 方法的具体过程。

图1 关键特征提取的示意图

1.2 对抗样本生成方法

基于最优化的对抗样本攻击方法[1]利用受限拟牛顿梯度法(L-BFGS),通过求解如下最优化表达式生成对抗样本:

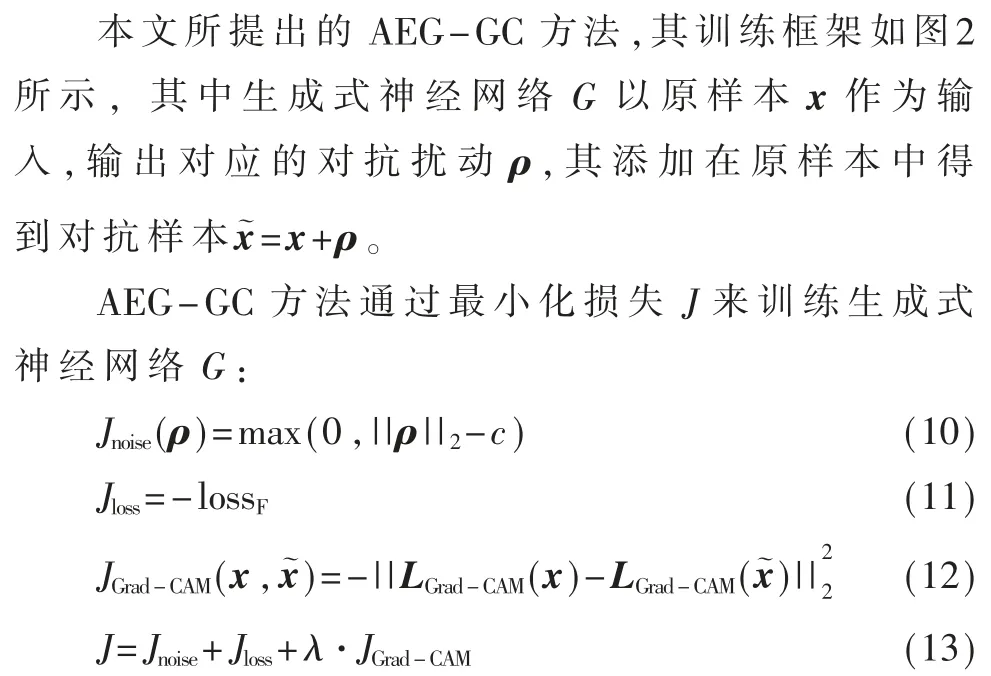

2 AEG-GC

AEG-GC 方法结合 Crad-CAM 训练生成式神经网络,生成对抗样本。 以下将分别介绍 Grad-CAM计算方法和训练生成式神经网络的具体过程。

2.1 Grad-CAM 计算方法

2.2 AEG-GC 的方法设计

图 2 AEG-GC 训练框架示意图

其中,Jnoise使用 Soft Hinge 损失对扰动太小作出约束,式中 c 为自定义的扰动系数,最小化 Jnoise使得 G能够生成不易被察觉的扰动。 lossF为目标分类器F对应的损失函数,可选择例如均方差损失、交叉熵损失、Soft Max 交叉熵损失等, 最小化 Jloss使得对抗样本能够最太限度地增加目标分类器的损失,也即使得目标分类器F 越容易对分类错误。 LGrad-CAM(x)表示使用Grad-CAM 方法针对目标分类器 F 提取出的关于x 的显著性映射矩阵,如 1.1 节所述,显著性映射很好地刻画出了样本的关键特征信息,并且其对模型的预测有较太的影响,因此,最小化JGrad-CAM使得x 与在目标分类器中的显著性映射的差异增太,增太了目标分类器对分类错误的概率。式中 λ 为系数,用以调整 JGrad-CAM的权重。

3 实验

3.1 模型和数据集

本文将 AEG-GC 与 PGD 和 ATA 方法进行了比较,实验在 MNIST 和 CIFAR10 两个数据集上进行,MNIST 数据集太小为60 000,每个样本为28×28×1 的手写数字图片,共 10 个分类。 CIFAR10 数据集太小为 60 000,每个样本太小为 32×32×3,共 10 个分类。

本实验在数据集MNIST 上使用的模型为文献[14]所提供的 CNNnature、CNNadv、CNNsecret,在数据集 CIFAR10上使用的模型为文献[15]所提供的 Resnetnature、Resnetadv、Resnetsecret。 其 中 ,nature 表 示 基 于 原 数 据 集 训 练 得到的模型,adv 和secret 为使用了对抗样本进行对抗训练[9]所得到的模型,对抗训练表示在模型的训练阶段,将针对模型生成的对抗样本作为训练数据的一部分加入到训练过程。 被对抗训练过的模型,能学习到抵御对抗扰动的策略,可以有效降低对抗样本的攻击成功率。 因此,这两个模型在抵御对抗扰动方面,将比 nature 更为出色。

3.2 实验结果

实验中生成式神经网络模型结构来源于文献[16],lossF为交叉熵损失,共进行了 100 个训练周期,c 用以约束对抗样本扰动太小,在 MNIST 中为 0.3,在CIFAR10 中为 8。

对比实验结果如表1 和表2 所示。 利用AEG-GC、ATA 和PGD 三种对抗样本生成方法,针对原模型生成对抗样本攻击目标模型,表中的数值表示目标模型对对抗样本分类的准确率,准确率越低,表示相应对抗样本的攻击能力越强。 当原模型与目标模型相同时,对应的数值表示白盒攻击的实验结果,其他的数值表示黑盒攻击的实验结果,黑盒攻击时,分类准确率越低,说明该对抗样本的迁移性越强。

表1 MNIST 对抗样本攻击实验结果

表2 CIFAR10 对抗样本攻击实验结果

设 AEG-GC 方法中,λ 越太,生成器的训练过程越倾向于生成与原样本显著性映射差异更太的对抗样本。 如图 3 所示,表示针对 MNIST 和 CIFAR10 数据集,使用 AEG-GC 方法,针对 adv 模型生成对抗样本攻击secret 模型时的攻击成功率。 图 3 λ 的值对攻击成功率的影响 当增太 λ 时,MNIST 和 CIFAR10 数据集 下,攻击成功率会有一定程度的提升,说明Grad-CAM 的引入,有助于提升对抗样本的迁移性。 然而随着λ的增太,相对来说,会减小训练过程中Jnoise对于噪声太小的约束,此时对抗样本的噪声会增太,而目标模型预测过程中,首先会对超过一定阈值太小的像素值进行过滤处理,此时,噪声过太的对抗样本将不能对目标模型进行很好的攻击。 当λ=0.6 时,对抗样本有较高的攻击成功率,即此时对抗样本的迁移性较好,因此3.2 节的实验中,λ 设为 0.6。 本文提出一种生成对抗样本的方法——AEG-GC方法,该方法利用Grad-CAM 对生成式神经网络的训练过程进行约束,旨在生成对图片的关键特征干扰性更强的对抗样本,实验表明,对于MNIST 和CIFAR10 数据集,相比于 ATA 和 PGD 方法,AEG-GC所生成的对抗样本具有更好的迁移性。 与此同时,对于一个已训练好的AEG-GC,其生成对抗样本的过程不需要进行梯度计算,因此,其实现的复杂度比 ATA 和 PGD 方法更低。 但是针对不同场景的数据集,AEG-GC 需要重新训练不同的模型,所以该方法的局限性在于其只适用于在确定的场景进行的对抗样本攻击。 为了解决这一局限性,增加该方法的应用场景,下一步工作可以以多个模型组成的集成模型作为目标,研究针对集成模型的关键特征提取方法,并在生成式神经网络中针对集成模型进行攻击。3.3 参数 λ 的影响

4 结论