基于深度学习的表格检测识别算法综述

2021-04-01孔令军包云超王茜雯李华康

孔令军 包云超 王茜雯 李华康

摘要:信息时代的高速发展导致数据的大量产生与频繁传输,单单依靠人力很难处理这些数据。依托于人工智能的兴起与发展,数据的利用变得更加高效。表格作为一种特殊的数据形式,逐渐引起了广泛关注。概述了表格识别技术的发展,介绍了传统的表格识别技术及其缺点;介绍了基于深度学习技术的表格检测、表格结构识别、端对端检测与识别以及字符识别,重点阐述了表格检测与结构识别算法;给出表格数据的数据集以及在其上的最新指标,展望了表格检测识别技术的发展前景。

关键词:人工智能;深度学习;表格检测;表格结构识别;光学字符识别

中图分类号:TP391.4文献标志码:A文章编号:1008-1739(2021)02-65-9

0引言

表格是一种特殊的信息表达方式,是人们为了让数据的组织形式更加标准和结构化而使用的一种数据类型。表格的特点是信息高度精炼集中[1],方便信息的检索和比较。表格识别的目的是获取图像中的表格并访问其数据,是文档分析与识别领域的一个重要分支。

日常生活中,人们对于表格数据的处理方式一般是:人工使用展示表格的工具打开表格,然后进行信息处理。基于人工处理表格的方式,产生了诸多问题:①因为表格数量众多,类型繁多复杂,人工对數据进行更新的过程中,可能会在不同的表格中写入相同的内容,或者有些单元格里的内容没有得到更新。一旦产生错误,使用人力查找错误的时间非常有限。因此人工处理表格数据往往会造成表格内容错误、信息不一致等问题,这种错误和不一致可能会有损公司声誉,甚至带来经济损失。②由于人工提取表格信息是一个繁琐而耗时的过程,为此需要投入大量人员同时进行这项工作,产生了额外费用。③在一些特殊的行业如金融业和制造业,表格往往是以非结构化的数字文件如可移植文档格式(PDF)公开的,人工难以对这些文件进行提取和处理。

因此,如何高效地从文档或图像中找到表格区域,同时有效地提取表格中的结构信息和数据内容,成为了一个亟待解决的问题。Hu等人[2]将表格识别分为2个主要任务:表格检测和结构识别。表格检测是指定位表格载体中的表格区域,以避免识别过程中非表格区域的干扰;表格识别是指对表格进行结构识别获得其行列、层次等逻辑结构,再对单元格里的内容进行光学字符识别(Optical Character Recognition,OCR),最终将完整的表格信息写入可编辑文件中。通过提取表格框架,定位表格单元格,最后利用OCR技术实现表格文档内容的识别,不仅提高了工作效率,而且极大地降低了信息录入的错误率。

1表格检测与识别技术的发展

国内的OCR技术研究开始于19世纪70年代末[3],随着科学技术的快速发展,OCR技术得到了长足的进步。表格检测与识别技术的研究滞后于OCR技术的研究,得益于识别技术的进步,该技术逐渐被研究者重视。

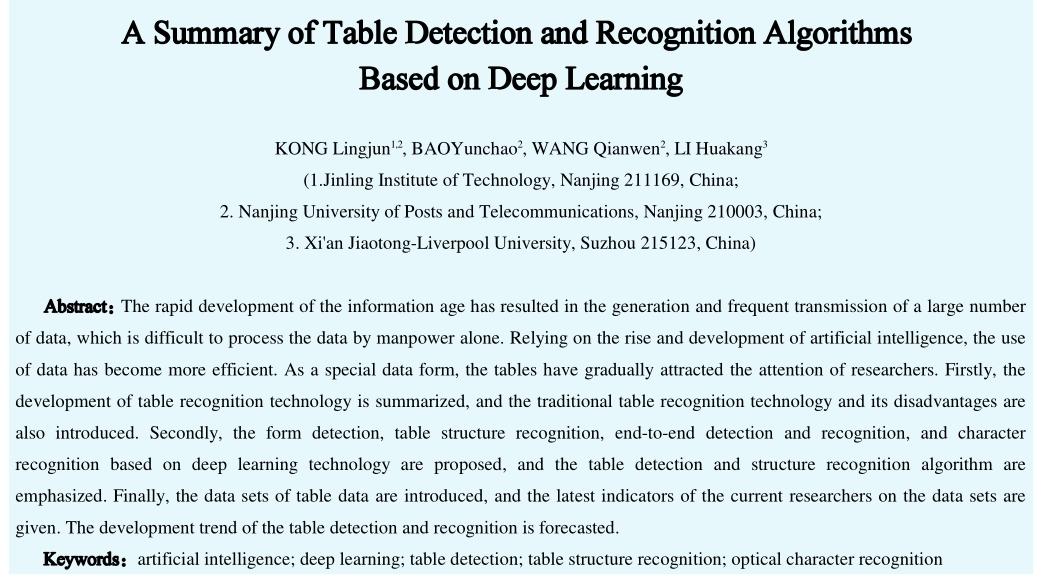

早期的表格检测与识别研究主要是基于启发式规则的方法,即指定一组规则来进行决策,以便识别出满足特定条件的表格。Chandran等人[4]以水平和垂直方向为线索,设计了一个以树的形式表示表格结构的系统。Kieninger等人[5]提出的T-Recs系统使用自底向上的方法对文档图像进行连通分支分析,再按照定义的规则进行合并,得到逻辑文本块。Zanibbi等人[6]将表格识别过程定义为观察、转换和推理的过程,如图1所示。Yildiz等人[7]提出的pdf2table是一种在PDF文件中只利用文本元素在文件中的绝对位置来提取表格信息的方法。在近期的研究中,Koci等人[8]将页面中的布局区域表示为图的形式,使用遗传算法从中将表格作为一个子图识别出来。然而,基于启发式规则的表格识别方法设计起来较为复杂,在各种场景的表格识别中难以获得较高的准确度,而且鲁棒性相对较差。

近年来,国内外研究者对表格识别问题进行了大量研究,尝试引入Faster R-CNN[9]、YOLOv3[10]、全卷积神经网络(Fully Convolutional Networks,FCN)[11]、图卷积神经网络(Graph Convolutional Network,GCN)及可变形卷积(Deformable Convolution)[12]等深度学习方法和网络。表格识别也逐渐演变成了多个子研究领域,包括表格检测、表格结构识别、端对端的表格检测与结构识别等。

2基于深度学习的表格检测

表格是一种非结构化的物体,因此基于深度学习的物体检测技术可以应用到表格检测任务上。现阶段,大多数研究者使用目标检测方法进行表格检测。

目前主流目标检测算法大致分为以Faster R-CNN为代表的基于候选区域的算法和以YOLO为代表的基于回归的算法两类,前者的检测过程可分为2步:由RPN(Region Proposal Network)生成若干个候选框,再通过后续网络对候选框进行精确回归;后者则直接回归目标的类别概率和坐标位置,这样做会损失精度,但比前者有更快的速度。

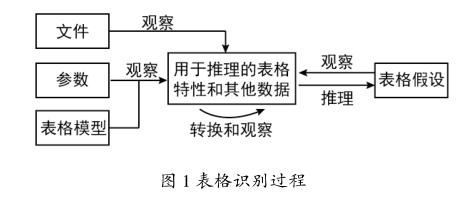

在表格检测任务上,Gilani等人[13]和Sun等人[14]使用并改进Faster R-CNN网络,取得了不错的效果。前者对在大型数据集ImageNet上训练好的Faster R-CNN模型进行微调。针对表格图像与自然图像之间差距大的问题,提出了一种将表格图像变换为类似自然图像的图像变换算法。该变换算法将输入图片转换为二值图像,再对图像的蓝、绿、红通道分别计算欧氏距离变换、线性距离变换和最大距离变换。进行图像变换的表格检测流程如图2所示[13],输入图像经过骨干网提取特征,其输出特征图输入用于生成含有表格区域的区域建议网络,最后网络判断输入区域是否含有表格对象。经过此方法微调后的模型不受表格结构和布局变化的影响,并且可以对任何数据集进行微调。

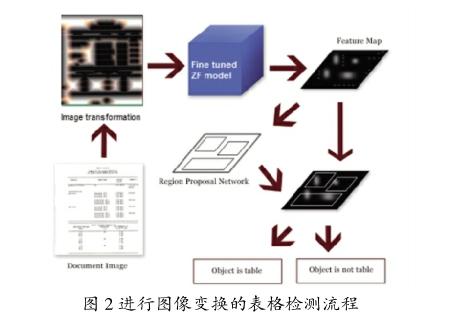

后者引入了角點的概念:表格4个顶点周围的部分区域称为角点,角点除位置不同外,大小形状相同,属于同一个表格的角点组成一个角组。基于Faster R-CNN网络,将角点定位结合到表格检测中。加入角点定位的表格检测流程如图3所示[14],骨干网络VGG-16[15]从文档图像中提取特征图,RPN和Faster R-CNN实现表格检测和角点定位,通过坐标匹配的方式对角进行分组,并通过分组和先验规则过滤掉不可靠的角点。针对大多数少线表没有竖直线却存在水平线的特点,使用可靠的角点组对检测出来的表格横坐标进行校准,得到精准的表格区域。但角点属于小对象,拥有较高的漏检率,而且角点尺寸采用固定值,不利于表格边界的细化,可以设置自适应的角点尺寸解决这一问题。

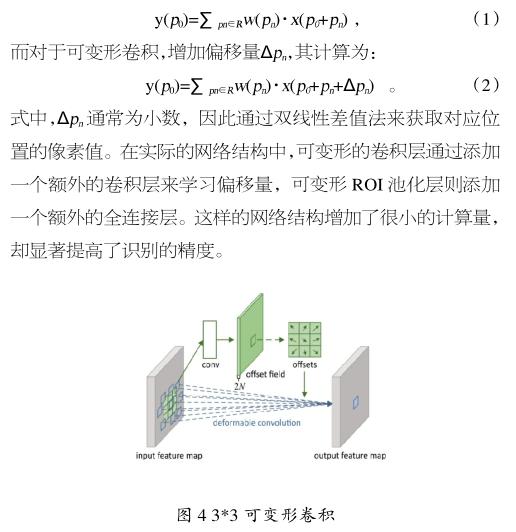

图像中的目标可以在任意位置,以任意尺寸出现。传统的卷积网络存在一个固定的感受野,不能根据目标的几何变化做出改变,神经网络中的池化层同样存在这个问题。为了解决这一问题,Dai等人[12]提出了可变形卷积神经网络以及可变形ROI池化,3*3可变形卷积如图4所示。可变形卷积可以根据其输入改变感受野,当目标在进行几何变换时,能作出适应性的改变。对于二维卷积,定义为感受野区域,对于输出特征图y的任意位置0,传统卷积的计算为:

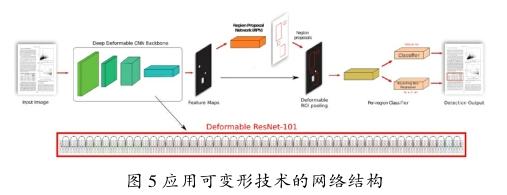

在文档页面中,表格对象拥有较高的类内方差和较低的类间方差,很难对任意布局的表格进行检测。Siddiqui等人[16]在Faster R-CNN以及FPN(Feature Pyramid Networks)[17]上应用可变形卷积技术完成表格检测任务。分别将Faster R-CNN骨干网ResNet-101[18]中的res5a_branch2b, res5b_branch2b和res5c_ branch2b三层以及FPN骨干网ResNet-101中的res3b3_branch2b和res4b22_branch2b两层传统卷积层变为可变形的卷积层,并分别将ROI池化用可变形ROI池化代替。经过变换后的网络如图5所示[16],使用在ImageNet上训练好的预训练模型进行迁移学习。

与上述做法不同,Huang等人[19]使用基于回归的目标检测模型YOLOv3进行表格检测。考虑到文档中表格对象和自然对象之间存在巨大差异,对YOLOv3引入了一些自适应调整,包括一种锚框优化策略和2种后处理方法。针对锚框的优化,使用k-means聚类来寻找更适合表格而不是自然对象的锚框,使训练模型更容易找到表格的确切位置。后处理方法其一是消除预测区域的空白,即擦除预测区域4个方向上的空白,该方法能提高查准率和查全率。后处理方法其二是过滤有噪声的页面对象,即将一些被识别为假阳性样本的页眉、页脚和分隔线对象过滤掉。该方法大大提高了计算精度。

3基于深度学习的表格结构识别

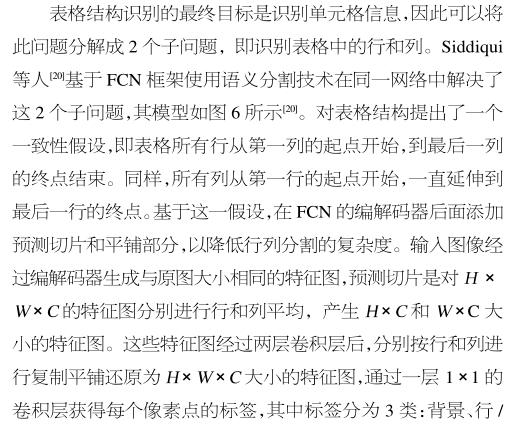

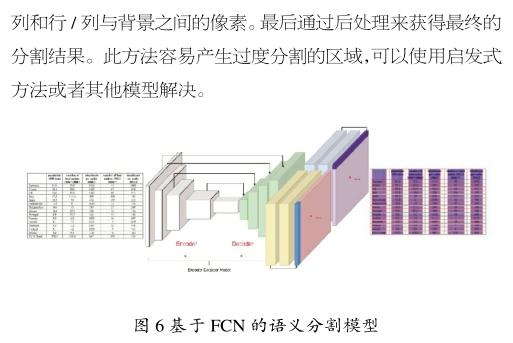

目前,研究者大多使用目标检测、图像分割和图神经网络等深度学习方法进行表格结构识别。由于表格的特殊结构,因此既可以将行列作为目标检测的对象,也可以将行之间和列之间的分隔符作为目标检测的对象。同样,这些对象也可以用图像分割方法进行分割。

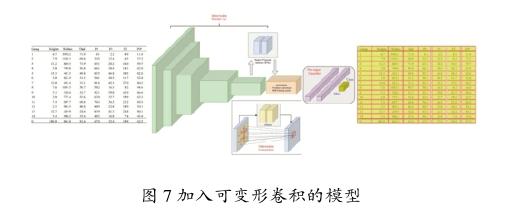

为了避免基于FCN的表格结构识别方法[20]严重依赖后处理的缺点,Siddiqui等人[21]将表格结构中的行、列识别视为目标检测问题,其中文档可被视为场景,行、列可被视为对象,并分别在Faster R-CNN、R-FCN[22]和FPN上使用可变形卷积技术搭建模型。加入可变形卷积的模型如图7所示[21]。3种模型都使用在ImageNet上进行过预训练的ResNet-101进行特征提取,其中分别将Faster R-CNN、R-FCN网络的顶部3层卷积层转换为可变形卷积层,对于FPN则额外转换了第4层,以进一步提高提取特征的质量。还将变换后的Faster R-CNN的ROI池化层转换为可变形ROI池化层。

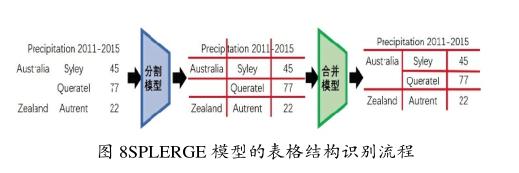

Tensmeyer等人[23]提出了表格结构识别的深度学习模型SPLERGE,由分割模型和合并模型2个模型组成,分割模型又分为行分割模型和列分割模型。SPLERGE模型的表格结构识别流程如图8所示。表格中单元格和单元格分隔符都包含大量空白区域,因此仅仅使用局部信息通常难以识别表格单元格边界。为了解决这一问题,分别在分割模型和合并模型中使用投影池化和网格池化,使局部特性在整个图像中传播。分割模型以裁剪好的只包含表格区域的任意×大小的图像作为输入,进行多尺度特征提取,通过投影池化操作,即在特征图上按行或列求取均值,最后以行分隔符和列分隔符的形式在整个图像上生成表格的网格结构,即产生2个表示每行(列)像素属于行(列)分隔符区域的概率的一维信号:∈[0,1]和∈[0,1]。合并模型将分割模型的预测结果和原图作为输入,判断单元格在上下左右4个方向是否需要合并。其中网格池化是对每个预测单元格区域取均值。

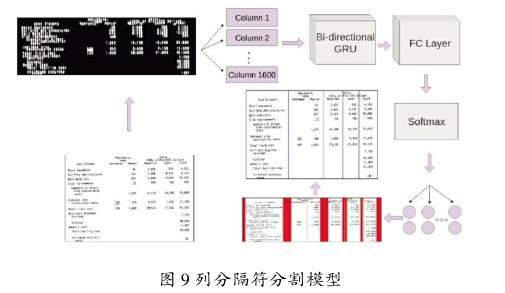

使用FCN网络进行表格结构识别受到感受野的限制,难以关注单元格下一个和前一个行列元素的信息,Khan等人[24]提出了使用循环卷积网络进行表格结构识别的方法。整个识别过程分为3个部分:预处理、行列分隔符分割和后处理。预处理步骤将原始表格图像转换为更简单的形式以使表格的布局和结构更明显,具体操作包括去除非文本前景对象,自适应二值化,三次膨胀变换和归一化。行列分隔符分割模型以预处理结果为输入,分别使用2个分割网络实现表格行列分隔符分割。在网络的选择上,通过实验发现,相比较于LSTM[25],使用GRU可以取得更好的效果。对于列分隔符分割模型,模型以×大小的图像作为输入,经过2层双向GRU网络后输出同样大小的特征图。GRU会关注当前列的左侧和右侧的所有列的信息,以及当前列中包含的正在计算的像素值的信息。特征图经过一个全连接层,最后通过softmax层将每一列分类为列或列分隔符。行分隔符分割模型执行类似的操作。其中列分隔符分割模型如图9所示[24]。后处理部分对行列分隔符分割模型生成的分割空间进行解析,得到最终的行列预测结果。

近年来,越来越多的研究者将深度学习技术应用到图数据领域。Qasim等人[26]将表格结构识别问题描述为一个与图神经网络兼容的图问题,利用图神经网络解决这一问题。将每一个单词区域作为一个顶点,并将真值定义为使用矩阵描述的3个图,3个矩阵分别是:单元格、行和列共享矩阵。如果2个顶点共享一行,即2个单词区域属于同一行,则这些顶点视为彼此相邻(单元格和列也是如此)。基于上述定义,将模型分为4个部分:特征提取、信息交互、随机采样和分类。在特征提取部分,输入图像经过自设计的浅层卷积神经网络生成视觉特征。在其输出端,经过OCR得到的顶点位置通过聚集操作映射到特征图上,将视觉特征与位置特征结合形成聚集特征。收集所有顶点特征后,将其输入到信息交互部分进行特征的交互融合,得到每个顶点的结构特征。在这一部分尝试修改了Wang等人[27]和作者之前[28]提出的图卷积神经网络,并且把应用了常规卷积的全连接稠密网络作为基线模型以进行性能比较,其流程如图10所示[26]。在训练阶段,模型会在随机采样部分随机对顶点对采样,在分类部分使用DenseNet[29]分别对顶点对进行是否同行、同列、同单元格的结构关系分类。在测试阶段,则对图中每一个顶点对进行3种分类,得到最终的测试结果。

4端对端的表格识别

表格识别任务往往被分为2个单独的任务来解决,首先进行表格检测,定位出图像中的表格区域,再对分割出的表格进行结构检测,最终获取完整的表格结构信息。单一的模型很难解决实际问题,端对端的表格识别系统同样重要。

为了克服传统的基于启发式规则进行表格识别方法复杂且泛化能力低的缺点,Schreiber等人[30]提出了一个以数据为驱动的端到端表格识别系统DeepDeSRT。该系统由2个独立的部分组成,分别用于表格检测和结构识别。在表格检测部分,选择Faster R-CNN模型进行微调。在表格结构识别任务上,使用图像分割模型分割表格行、列和单元格目标。调整了FCN网络,添加2个额外的跳过连接,合并pool2和pool1层的特性,形成了FCN2s网络。

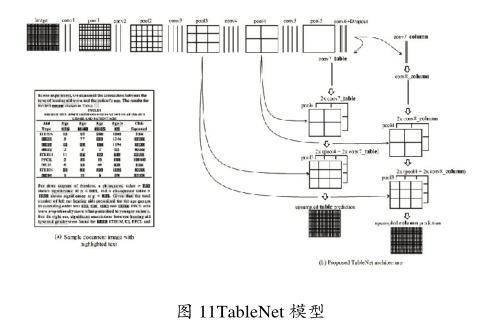

在同时解决表格检测和结构识别任务上,Paliwal等人[31]提出了一种基于FCN的端对端图像语义分割模型TableNet。基本思想是利用表格检测和表格结构识别这2个任务之间的相互依赖关系来分割表格和列区域。在FCN的编码器部分,使用在ImageNet上预训练的VGG-19模型进行提取特征。解码器部分将编码器的输出分为2个分支分别进行上采样,同时将下采样过程中对应大小的特征图拼接到上采样对应层的特征图中,最后特征图恢复到原图大小得到表格区域和列区域的分割图,其模型如图11所示[31]。通過定制规则的方法获取表格的行结构,结合表格区域分割和列区域分割,得到完整的表格结构信息。在实验中,尝试给模型输入空间信息和数据类型信息。具体做法是用tesseract OCR[32]进行处理,得到图像中的所有字块。再通过正则表达式处理这些单词,确定其数据类型,为每种数据类型赋予一种独特的颜色。

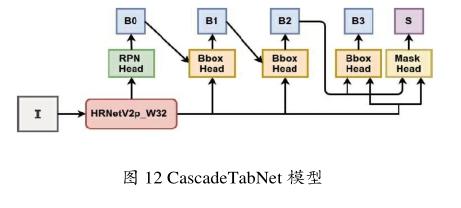

同样使用图像分割技术,不同的是Prasad等人[33]利用实例分割技术完成表格识别任务,为此提出了一个基于深度学习的端对端卷积神经网络模型CascadeTabNet,模型如图12[33]所示。通过一次推理,此模型实现在像素级别上识别图像中的每个表格实例和单元格实例。为了实现高精度的实例分割,选择组合Cascade RCNN[34]和HRNet[35]作为网络的主体。模型先预测输入图像的表格分割,并分类为有边界表和无边界表。如果是无边界表,则进入模型的下一部分进行单元格实例分割。如果是有边界表,则使用传统方法识别单元格。为了增加训练数据的数量,作者使用两种数据增强方法:膨胀变换和模糊变换。

5字符识别

经过表格检测与结构识别,提取出了表格的物理结构,表格数据处理的下一步是对单元格内的字符进行字符识别,这一部分一般使用常规的OCR技术。字符识别模型一般分为2个主要部分:特征提取和序列转化。特征提取大部分使用卷积神经网络,如VGG,ResNet,DenseNet等。序列转化最常用的2种方法是CTC[36]和基于注意力机制的序列到序列(Sequence-toSequence,Seq2Seq)模型。

5.1通用字符识别

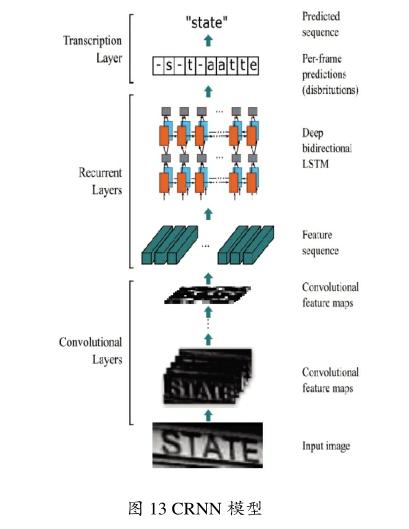

Convolutional Recurrent Neural Network(CRNN)模型[37]是最经典的字符识别模型,可以识别较长的文本序列。其结构是由CNN、RNN和CTC模块级联而成,如图13CRNN模型[37]所示。RNN部分使用BiLSTM序列模型,与CNN部分共同完成特征提取功能。RNN部分可以学习字符的上下文信息,以提高识别的准确。预测过程中,前端使用标准的CNN网络提取文本图像的特征,利用BiLSTM将特征向量进行融合以提取字符序列的上下文特征,得到每列特征的概率分布,最后通过CTC序列转化层进行预测得到文本序列。

RARE[38]是针对弯曲文本而设计的文字识别模型,能较好地识别透视和弯曲的图像文本。由空间变形网络(SpatialTransformer Network,STN)和序列识别网络(Sequence Recognition Network,SRN)组成,其结构如图14所示[38]。图像先经过空间变换网络,再将矫正后的图像送入字符识别网络。空间变换网络包含定位网络、网格生成器、采样器。可以根据输入图像特征动态的产生空间变换网格,采样器通过网格核函数从原始图像中采样获得矩形文本图像。RARE中支持一种称为TPS(thin-plate splines)的空间变换,从而能够比较准确地识别透视变换过的文本、以及弯曲的文本。

5.2手写体字符识别

有些表格单元格内包含手写体字符,加大了表格内容识别的难度。针对手写体字符识别,近年来很多研究取得了不错的成果。针对序列手写字符识别问题,比较有效的方法是应用深度学习方法中的RNN模型,特别是LSTM和BiLSTM等模型,由于对序列数据有很好的建模能力,因此更适合于解决包含时序先后顺序信息的文字行识别问题。

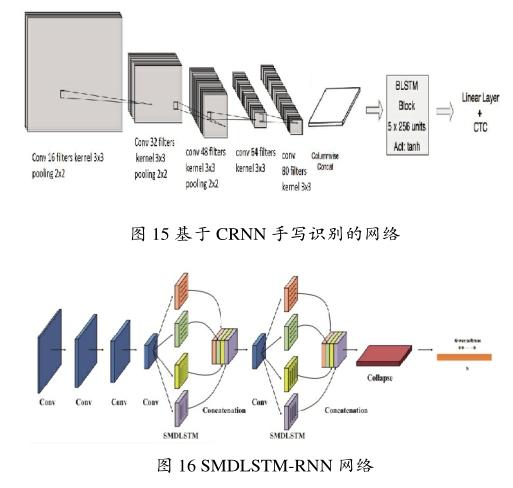

基于CRNN的模型[39]可以在手写字符识别任务上取得很好的效果,一种基于CRNN手写识别的网络如图15所示[39]。

Messina等人[40]首次将MDLSTM-RNN[41]应用到手写汉字文本行识别,字符识别的准确率为83.5%。Wu等人[44]在MDLSTM-RNN的基础上做了改进,将4个方向的LSTM输出结果从原来的相加改成拼接,形成新的网络称为SMDLSTM-RNN,如图16所示[42],字符识别率进一步提升。

6表格识别数据集和性能比较

6.1表格识别数据集

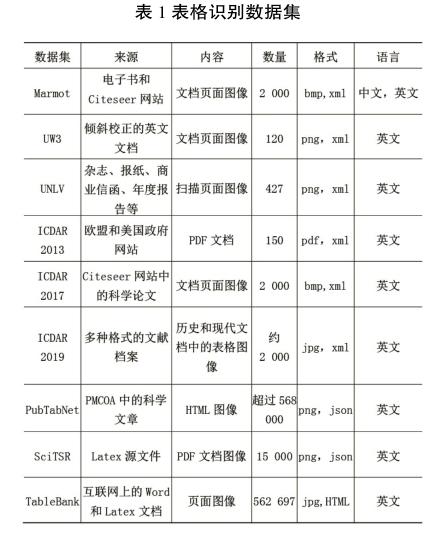

常用的表格识别数据集如表1所示。

Marmot:该数据集由中英文两部分组成。中文页面来自方正阿帕比图书馆中120多本不同学科领域的电子书,而英文页面则来自Citeseer网站。该数据集源于PDF,存储了所有文档布局的树形结构,其中叶是字符、图像和路径,根是整个页面。内部节点包括文本行、段落、表格等。

UW3和UNLV:UW3数据集来自1 600页倾斜校正的英文文档,其中120页至少包含一个标记的表区域。UNLV数据集从2 889页扫描的文档图像收集得到,其中427幅图像包括表格。

ICDAR 2013:该数据集共包含了150个表格,包括27个欧盟摘录中的75个表格、40个美国政府摘录中的75个表格,即总共包含67个PDF文档的共238个英文页面。

ICDAR 2019:此數据集是用于ICDAR 2019年表格检测和识别比赛的数据集。既包含历史文档表格又包含现代文档表格。

PubTabNet:该数据集包含56.8万张表格数据的图像,这些图像用表格对应的HTML标签形式进行了注释。

SciTSR:该数据集是一个综合性的数据集,由15 000个PDF格式的表格图像及标签文件组成。数据集分出12 000张图像用于训练,3 000张用于测试。TableBank:该数据集是基于图像的表格检测和结构识别数据集。收集了Word和Latex文档中的表格图像。提供HTML格式的表格标注文件。

6.2性能比较

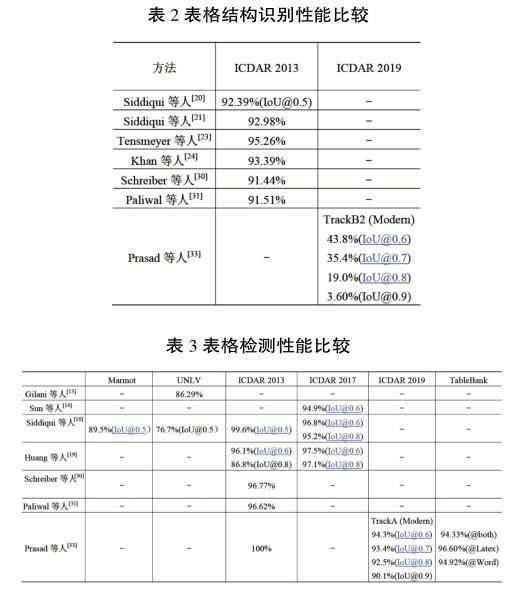

表格结构识别与检测性能(只针对F1值)比较如表2和表3所示。

從表2和3中可以看出,ICDAR 2013数据集是表格识别最受欢迎的数据集,几乎所有研究者都在此数据集上进行评估。Prasad等人[33]在此数据集的表格检测任务中取得了没有人能超越的效果,F1值达到了100%。在此数据集的表格结构识别任务上Tensmeyer等人[25]取得了最好的效果,F1值达到了95.26%。在ICDAR 2017表格检测任务上Huang等人[19]取得了最好的效果,F1值都在97%以上。ICDAR 2019表格结构识别任务是目前最富有挑战的任务。

7结束语

Faster R-CNN,YOLO等目标检测算法、FCN图像分割算法、循环神经网络、图神经网络等网络及其级联,以及可变形卷积等是表格识别领域最主要的应用技术。随着人们的关注,表格识别的方法也变得更加丰富。工业界和学术界越来越多地投入到更加复杂的端对端表格识别任务中,并提出了一系列有效解决方案。手写字符识别是目前表格内容识别的难点,计算机视觉和自然语言处理的交叉研究得到广泛关注。随着深度学习的发展,相信会有更多的技术应用到表格识别任务上来,从而将更好的效果反馈到生活中。

参考文献

[1]郑冶枫,刘长松,丁晓青,等.基于有向单连通链的表格框线检测算法[J].软件学报,2002(4):790-796.

[2] HU J,KASHI R S,LOPRESTI D,et al.Evaluating the Performance of Table Processing Algorithms[J]. International Journal on Document Analysis & Recognition,2002,4(3): 140-153.

[3]丁晓青.汉字识别研究的回顾[J].电子学报,2002,30(9): 1364-1368.

[4] CHANDRAN S,KASTURI R. Structural Recognition of Tabulated Data[C]//2nd International Conference on Document Analysis & Recognition. Tsukuba Science City:IEEE, 1993:516-519.

[5] KIENINGER T, DENGEL A.The T-Recs Table Recognition and AnalysisSystem[J]. Lecture Notes in Computerence, 1999,1655:255-269.

[6] ZANIBBI R,BLOSTEIN D,CORDY J R.A Survey of Table Recognition: Models, Observations, Transformations, and Inferences[J]. International Journal on Document Analysis & Recognition,2003,7(1):1-16.

[7] YILDIZ B, KAISER K, MIKSCH S. pdf2table: A Method to Extract Table Information from PDF Files[C]// Indian International Conference on Artificial Intelligence. Pune: DBLP, 2005:1773-1785.

[8] KOCI E,THIELE M , ROMERO O,et al. A Genetic-Based Search for Adaptive Table Recognition in Spreadsheets[C]// International Conference on Document Analysis and Recognition (ICDAR). Sydney:ICDAR, 2019:1274-1279.

[9] REN S,HE K,GIRSHICK R,et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence,2017,39(6):1137-1149.

[10] REDMON J,FARHADI A.YOLOv3: An Incremental Improvement[J]. arXiv e-prints,2018:1804.02767.

[11] SHELHAMER E,LONG J,DARRELL T. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence,2017,39(4): 640-651.

[12] DAI J,QI H, XIONG Y,et al. Deformable Convolutional Networks[C]//2017 IEEE International Conference On Computer Vision.Venice:IEEE,2017:764-773.

[13] GILANI A, QASIM S R,MALIK I,et al. Table Detection Using Deep Learning[C]// 2014 14th IAPR International Conference on Document Analysis and Recognition.Kyoto: IEEE, 2017:771-776.

[14] SUN N,ZHU Y,HU X.Faster R-CNN Based Table Detection Combining Corner Locating[C]//2019 International Conference on Document Analysis and Recognition(ICDAR).Sydney:IEEE, 2019:1314-1319.

[15] SIMONYAN K,ZISSERMAN A. Very Deep Convolutional Networks for Large-Scale Image Recognition[J]. arXiv preprint arXiv:1409.1556, 2014.

[16] SIDDIQUI S A,Malik M I,Agne S,et al. DeCNT: Deep Deformable CNN for Table Detection[J].IEEE Access, 2018:1-1.

[17] LIN T Y, DOLLáR, P,GIRSHICK R,et al. Feature Pyramid Networks for Object Detection[J]. IEEE Trans. Pattern Anal. Mach Intell.,2014,36(8):1532-1545.

[18] ANON. IEEE Conference on Computer Vision And Pattern Recognition(cvpr 2020)[J].智能系統学报,2019,14(6):1137.

[19] HUANG Y,YAN Q,LI Y, et al.A YOLO-Based Table Detection Method[C]//2019 International Conference on Document Analysis and Recognition (ICDAR). Sydney :IEEE ,2020:813-818.

[20] SIDDIQUI S A,KHAN P I, DENGEL A,et al.Rethinking Semantic Segmentation for Table Structure Recognition in Documents[C]//2019 International Conference on Document Analysis and Recognition (ICDAR).Sydney :IEEE 2019: 1397-1402.

[21] SIDDIQUI S A,FATEH I A,RIZVI S T R,et al.DeepTabStR: Deep Learning Based Table Structure Recognition[C]// 2019 International Conference on Document Analysis and Recognition (ICDAR)., Sydney :IEEE, 2020: 1403-1409.

[22] DAI J,LI Y,HE K,et al. R-FCN:Object Detection via Region-based Fully Convolutional Networks[J]. arXiv preprint arXiv:1605.06409, 2016.

[23] TENSMEYER C,MORARIU V I,PRICE B,et al.Deep Splitting and Merging for Table Structure Decomposition[C]// 2019 International Conference on Document Analysis and Recognition (ICDAR). Sydney :IEEE, 2019:114-121.

[24] KHAN S A,KHALID S M D,SHAHZAD M A,et al. Table Structure Extraction with Bi-Directional Gated Recurrent Unit Networks[C]//2019 International Conference on Document Analysis and Recognition (ICDAR). Sydney: IEEE, 2019:1366-1371.

[25] SUNDERMEYER M,RALF S,NEY H. LSTM Neural Networks for Language Modeling[C]// 13rd Annual Conference of the International Speech Communication Association. Portland, 2012:194-197.

[26] QASIM S R,MAHMOOD H,SHAFAIT F.Rethinking Table Recognition using Graph Neural Networks[C]//2019 International Conference on Document Analysis and Recognition (ICDAR). Sydney :IEEE, 2019:142-147.

[27] WANG Y,SUN Y,LIU Z,et al. Dynamic Graph CNN for Learning on Point Clouds[J].ACM Transactions on Graphics,2019,38(5):1-12.

[28] QASIM S R,KIESELER J,IIYAMA Y,et al. Learning Representations of Irregular Particle-detector Geometry With Distance-weighted Graph Networks[J]. The European Physical Journal C, 79(7), 1-11.

[29] HUANG G,LIU Z,LAURENS V D M,et al.Densely Connected Convolutional Networks[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu :IEEE,2017:4700-4707.

[30] SCHREIBER S,AGNE S,WOLF I,et al. DeepDeSRT: Deep Learning for Detection and Structure Recognition of Tables in Document Images[C]//2017 14th IAPR International Conference on Document Analysis and Recognition(ICDAR). Kyoto :IEEE, 2017:1162-1167.

[31] PALIWAL S S,VISHWANATH D, Rahul R,et al.TableNet: Deep Learning Model for End-to-end Table Detection and Tabular Data Extraction from Scanned Document Images[C]// International Conference on Document Analysis and Recognition (ICDAR). Sydney :IEEE, 2019:128-133.

[32] SMITH R.An Overview of the Tesseract OCR Engine[C]// Document Analysis and Recognition, 2007. ICDAR 2007. Ninth International Conference on Document Analysis and Recognition(ICDAR 2007). Parana:IEEE, 2007(2): 629-633.

[33] PRASAD D,GADPAL A,KAPADNI K,et al.CascadeTabNet: An Approach for End to End Table Detection and Structure Recognition From Image-Based Documents[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops Seattle:IEEE, 2020:2439-2447.

[34] CAI Z,VASCONCELOS N.Cascade R-CNN: Delving Into High Quality Object Detection[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City :IEEE, 2018:6154-6162.

[35] SUN K,XIAO B,LIU D,et al.Deep High-Resolution Representation Learning for Human Pose Estimation[J]. IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach:IEEE, 2019:5686-5696.

[36] GRAVES A.Connectionist Temporal Classification: Labelling Unsegmented Sequence Data with Recurrent Neural Networks[C]// International Conference on Machine Learning. New York:IEEE 2006:993-1000.

[37] SHI B,BAI X,YAO C.An End-to-End Trainable Neural Network for Image-Based Sequence Recognition and Its Application to Scene Text Recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence,2016,39(11): 2298-2304.

[38] SHI B,Wang X, Lyu P,et al.Robust Scene Text Recognition with Automatic Rectification[C]// IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas:IEEE, 2016:4168-4176.

[39] NISA H,THOM J A,CIESIELSKI V,et al. A Deep Learning Approach to Handwritten Text Recognition in the Presence of Struck-out Text[C]//2019 International Conference on Image and Vision Computing New Zealand (IVCNZ). Dunedin: IEEE,2019:1-6.

[40] MESSINA R, LOURADOUR J. Segmentation-free Handwritten Chinese TextRecognition with LSTM-RNN[C] // 2015 13th International Conference on Document Analysis and Recognition (ICDAR). Tunis :IEEE, 2015:171-175.

[41] GRAVES A,JüRGEN S. Offline Handwriting Recognition with Multidimensional Recurrent Neural Networks[C]// International Conference on Neural Information. Vancouver:IEEE, 2009:545-552.

[42] WU Y C,YIN F,CHEN Z,et al. Handwritten Chinese Text Recognition Using Separable Multi-Dimensional Recurrent Neural Network[C]//2017 14th IAPR International Conference on Document Analysis and Recognition(ICDAR). Kyoto :IEEE,2017(1):79-84.