算法偏见问题的技术—权力互构论解析

2021-03-11黄晓伟李育慧

黄晓伟 李育慧

摘要:近年来的数据集下架潮、算法偏见大辩论使得算法偏见成为一个不可忽视的社会问题,这归根结底是由算法的政治性决定的。本研究从技术与权力的互构共生关系视角,批判了算法的价值中立论,在算法赋权的社会—技术系统中,算法作为非人类行动者参与到人类行动者的决策过程中。算法偏见可以区分出若干类型,其实质是当代数字化社会的一种形式偏见,可能加剧新兴的数字排斥。算法社会的道德底线应该是不造成算法伤害,避免算法作恶,同时还要从激励性伦理的角度推动算法的负责任创新,实现算法向善。算法风险的基本治理机制是算法透明,而同样重要的是算法问责。

关键词:算法偏见;算法权力;技术与权力的互构;数字排斥;算法向善

中图分类号:B829;TP18 文献标识码:A 文章编号:1003-1502(2021)01-0039-10

在启蒙现代性发端之初,英国哲学家培根发出了“知识就是力量”的时代呼唤。随着工业化进程的扩散,世界各国人民也确实见证了现代技术迸发的巨大力量。20世纪以来,现代性的迷思为世界大战、环境公害、核威胁、恐怖主义等风险事件所动摇,居于技术力量背后的“权力”幽灵不再游荡,“知识即权力”以及“技术即权力”的观念受到越来越多思想家的重视和讨论。近年来,算法创新、海量数据与运算能力共同推动了新一代人工智能的蓬勃发展,由于算法创新的核心驱动作用及其广泛的社会影响,一些社会理论家们甚至宣称“算法社会”正在来临。与此同时,以黑箱化为特征的算法所引发的杀熟、歧视、伪造等风险也逐渐暴露,因而有必要批判性地反思算法力量背后的权力因素。本研究尝试从算法与权力的互构共生关系视角,分析“算法偏见”这一基本且为热点的社会问题,从而更深入地理解现代技术的权力之维,以期为推动新一代人工智能的健康发展提供学理借鉴。

一、算法偏见何以成为社会问题

从学术史的角度看,社会科学领域关于偏见问题的研究由来已久,经历了从早期聚焦人类偏见到后来关注技术偏见的扩展。社会心理学家戈登·奥尔波特在其经典著作《偏见的本质》(1954)中,将偏见定义为“因为错误和僵化的推论,而对某一群体的成员产生反感或厌恶的情绪”,分析了人类偏见的认知过程、动机过程和社会文化过程,但忽视了新型的、内隐的、复数的偏见形式[1]。由于技术偏见大多是内隐的,早期的偏见研究并不涉及技术议题,对非人类行动者与人类行动者的关注是不对称的。20世纪末,计算机和互联网逐步普及,“价值敏感性设计”理念的提出者芭蒂娅·弗里德曼等最早讨论了计算机系统的偏差问题,尤其关注那些具有道德含义的偏差[2]。计算机伦理学中的偏见研究由此发端,如今引起热议的算法偏见指涉的就是算法造成的具有道德含义的偏差。进入21世纪,算法伦理伴随深度学习的发展而兴起,最早关于算法伦理的专题论文发表于2011年,基于医学图像分析技术的案例分析,得出了特定算法是负载价值的判断[3]。此后,信息哲学家卢西亚诺·弗洛里迪与合作者们持续追踪并系统综述了算法伦理领域的争议与进展,指出了由算法决策引发的六类伦理挑战:论据不确定、论据难理解、证据有误导、结果不公平、影响多变化以及可追溯性,旨在提供对算法的认识论和规范性问题的最新分析,并为算法的设计、开发和部署提供可行的治理建议[4] [5]。在快速增长的算法伦理文献中,算法偏见问题始终是一个焦点议题,不过从算法权力角度的探究还有待深化。

时至今日,算法偏见不再仅仅是一个人工智能领域的学术问题,而成为一个不容忽視的社会问题。在新一代人工智能发展热中,算法创新开始显现出熊彼特意义上的“创造性破坏”的现实特征。一方面,算法赋能数字经济发展的“创造性效应”不断积聚,这在很大程度上得益于三位图灵奖得主杰弗里·辛顿、杨立昆、约书亚·本吉奥为深度学习算法奠定的基础,并在多个领域得到了规模化应用;另一方面,有关算法的社会争议也引起公众对其“破坏性效应”的警惕。以大量应用深度学习算法的图像识别领域为例,2019年以来因系统性的标注缺陷而出现了“数据集下架潮”,迄今已涉及微软公司的MS-Celeb-1M名人人脸数据集、杜克大学的Duke MTMC行人监控数据集、斯坦福大学的Brainwash头部检测数据集、麻省理工学院的Tiny Images Dataset微小图像数据集,以及目前世界上最大的图像识别数据集ImageNet中的“人物”子集,不一而足。

如果说上述数据集下架潮引发的社会关注还主要集中在数据偏见问题,那么一场关于深度学习算法的大辩论将算法偏见问题前所未有地凸显出来。在2020年的国际计算机视觉与模式识别会议上,杜克大学的研究者们发布了一种基于StyleGAN人脸图像生成器的PULSE算法,这种算法能将模糊图片迅速高清化。有网友试用了上述算法,输入美国前总统奥巴马的模糊照片,却生成了一张白人男子的照片,算法的不完备性随即引发了激烈的辩论。图灵奖得主杨立昆发推特表态,从技术角度将此归结为数据偏见问题,认为机器学习系统的偏见来自数据的偏见,这一面部采样系统让每个人都变白,是由于网络的预训练基于主要为白人图片的FlickFaceHQ数据集。如果同样的系统使用塞内加尔的数据集训练,那每个人看起来都会像非洲人”。黑人女性AI科学家蒂妮特·葛卜路对杨立昆的立场深表失望,在推特上回应,“你不能将机器学习导致的伤害简单还原为数据集偏见”。在舆论压力下,杜克大学的研究者们也不得不公开回应,算法训练所用的都是虚拟的人脸图片,不会用于识别或重构真实人脸。此外,他们还在预印本论文中新增了一节,专门讨论算法偏见问题,“PULSE算法可能解释了一些内在于StyleGAN的偏见”,并报告了该算法识别不同种族、性别人群图片的成功率差异[6]。与之类似,新近的AI研究更为详细地描述了人工图像生成算法中隐含的人口统计学偏见,发现生成的图像更偏向年轻人,尤其是白人女性[7]。最终,这场多方参与、持续两周的“算法偏见大辩论”以杨立昆退出推特而暂告一段落,而由此引发的学术讨论仍在继续。

二、算法观的分歧:内在主义,还是外在主义

现代意义的“算法”概念历史并不久远,早期预设了内在主义的认识论立场。“Algorithm”的词源可追溯至波斯数学家、“代数之父”阿尔·花拉子密,最初指代加、减、乘、除等基本算术法则。直到20世纪七八十年代,随着计算机科学的发展,现代意义的“算法”才成为一个专业术语。在经典的计算机科学教科书中,算法通常被定义为一组有穷的计算规则,这些规则给出求解特定类型问题的运算序列,并具备有限性、确定性、输入、输出和有效性等特征[8]。区别于基于规则的传统机器学习算法范式,杰弗里·辛顿2006年在《科学》上发表的关于深度学习算法的论文,真正开启了新一代人工智能的先河[9]。从技术角度分析,深度学习算法的工作流程可以简化为:选择问题→挑选算法→数据收集→预训练→应用→校准→测试→再设计。而目前引起热议及争议的算法都是深度学习算法,是输入数据与学习模型的共同产物。

进入21世纪,关于算法的哲学与社会科学研究开始兴起,对算法概念的理解出现了狭义和广义之分。计算机科学哲学家完善了算法的狭义理解,将其界定为数学建构物,即一种有穷的、抽象的、高效的复合式控制结构,其命令已给定,用以在设定的规定条件下实现设定的目标[10]。而社会科学学者倾向于一种外在主义的认识论立场,将算法理解为一种社会—技术系统,它“不只是一组能够编码为计算机程序的、足够精确的指令,还是运行于一个实体的计算机系统之上并能够影响其他系统的程序”[11]。本研究主要从算法概念的广义理解去分析算法偏见问题。

近年来的数据集下架潮、算法偏见大辩论使得“算法本身是否具有偏见”成为技术的社会学与伦理学研究纷纷关注的焦点。事实上,争论双方的分歧首先体现在算法观上,即算法是一个纯粹数学意义上的技术系统,还是一个复杂的社会—技术系统?作为“深度学习三巨头”之一的杨立昆就将算法视为单纯技术系统,是算法领域持技术价值中立论的典型代表。他早在2019年就曾发推特表达过“算法自身的无偏见性”观点。他写道,“人类是有偏见的。数据是有偏见的,部分是由于人类是有偏见的。基于有偏见的数据训练出来的算法是有偏见的。但学习算法本身是无偏见的。数据偏见能够被修正。修正人类偏见则要困难得多。”

其实,这种算法无偏见的观点之所以得到很多人的认可,与根深蒂固的技术价值中立论有关。技术与价值无涉的观念古已有之,直到20世纪下半叶才得到深刻批判。在前现代社会,亚里士多德的技术观影响深远,他将“人工物”与 “自然物”对立起来,认为人工物的目的因在其自身之外,无内在目的之物只能从属于手段领域[12]。及至现代,马克斯·韦伯区分了“实质合理性”与“形式合理性”,认为前者包含价值偏见,而后者是价值中立的[13]。在韦伯看来,技术的本质是一种形式合理性,这进一步强化了技术中立性的现代迷思。法兰克福学派理论家赫伯特·马尔库塞尖锐地批判了技术中立性的传统概念,主张技术成了新的社会控制形式,在单向度的发达工业社会,“技术的合理性已经变成政治的合理性”[14]。在反思韦伯与马尔库塞的技术观基础上,技术哲学家安德鲁·芬伯格区分了“实质偏见”与“形式偏见”,指出关于技术的形式偏见是现代社会独一无二的特点,而且不可避免地负载价值,“形式偏见的本质是在时间、地点和由相对中性的要素组成的系统引入方式上存有成见的选择”[15]。

因此,循着芬伯格的思路,本研究认为算法偏见是当代数字化社会的一种形式偏见,一切算法系统皆是社会—技术系统,在引入技术性与非技术性要素的过程中都有可能嵌入人类的价值偏见。那些执着于算法无偏见的学者,仍然将技术系统视作实现人类目的的手段与工具,而无视技术系统的可编码性和价值负载性。而从技术与权力互构的角度解析算法偏见,就是基于算法的政治价值负载性,解读算法偏见与算法权力之间的复杂关联。

三、算法的政治性与算法偏见的多样性

在数字化的社会,人机协同决策的场景不断扩展,算法作为非人类行动者参与到人类行动者的决策过程中。“大数据和算法作为显然可靠的治理工具,可能会取代人类的‘自由裁量权”[16]。从购物/新闻/音乐推荐、贷款发放、保险理赔、雇佣招聘,再到精准医疗、自动驾驶、量刑评估、预测性警务,算法决策服务及其质量已经成为利益攸关方关注的焦点。当然,目前真正能实际应用的场景还相对有限,可以完全自主决策的、代表通用人工智能的算法仍然处在思想实验阶段。

技术哲学家兰登·温纳的经典之问“技术物有政治性吗?”[17]对当今理解算法的政治性仍有启示意义。温纳认为,各种技术系统与现代政治深入地交织在一起——这里的“政治”是指权力和权威在人类交往中的配置以及这种配置之下的活动。有些技术的变迁会产生政治后果(如纽约城市规划师罗伯特·摩西为限制少数族裔和低收入群體而设计的一系列低桥),此即“技术的外在政治性”;有些技术甚至在某种意义上具有政治本性(如原子弹、核电厂),此即“技术的内在政治性”。事实上,在算法的政治性问题上,这一区分仍然是适用的。

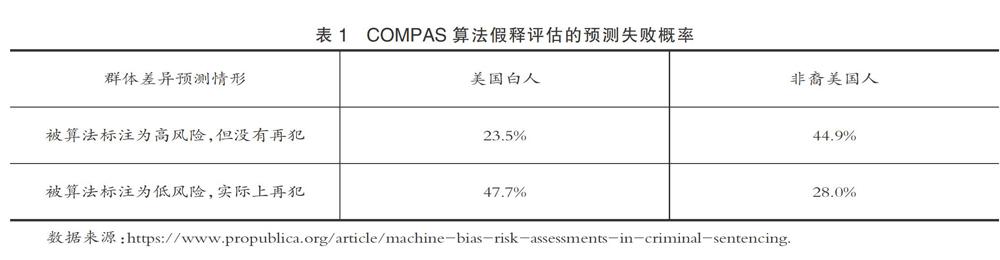

一方面,有些算法被外在地赋予政治性,司法领域的量刑评估算法是一个典型案例。COMPAS算法是由美国Northpointe公司数据科学家蒂姆·布伦南发明的司法辅助决策模型,该算法结合刑事案件被告人对 137 个调查问题的回答(涉及以往犯罪记录、第一次被捕的年龄及现在年龄、教育水平以及一个小时的问卷调查等人口统计学信息)来预测他们再次犯罪的可能性,他声称该算法不会把种族作为变量。美国一些州的法官在被告人申请假释时,通过用该算法对他们再犯的风险进行评估,以作出最终决定。2016年,一家公益机构ProPublica基于佛罗里达州布劳沃德县的用户数据开展的调查发现,COMPAS算法对非裔美国人存在偏见。具体而言,假释评估时被算法标注为高风险(容易再犯),但后来没有再犯的白人为23.5%,黑人为44.9%;假释评估时被算法标注为低风险(不易再犯),但后来再犯的白人为47.7%,黑人为28.0%。因此,那些虽有前科但没有再犯的黑人被算法错误标注为高风险罪犯(如表1所示)[18]。

另一方面,有些算法则内在地具有政治性,这突出体现在那些意图实现政治操控的算法上。以2016年的两个政治“黑天鹅事件”为例,英国公投支持“脱欧”和特朗普当选美国总统的背后都有一家加拿大政治咨询公司聚合智囊(AggregateIQ)技术介入的活跃身影。据加拿大信息隐私专员办公室系统的一份官方调查报告显示,聚合智囊利用算法模型刻画用户的心理特征并向其投送定制的政治广告或虚假新闻,介入了英、美、加等国的政治选举活动,期望影响选民的投票决定[19]。电影《脱欧:无理之战》中,为英国“脱欧派”提供选民定位算法决策服务的就是这家公司;此外,聚合智囊还一度利用英国一家政治咨询公司剑桥分析非法获取并共享的5000 多万脸书(Facebook)用户隐私数据,为特朗普的总统竞选活动提供算法决策服务。其实,早在2012年的总统竞选活动中,奥巴马就已经娴熟地运用名为“选民关系管理系统”的大数据分析结果;尽管最终不敌特朗普,但希拉里在2016年总统竞选活动中也使用了The Groundwork团队(受谷歌公司的间接支持)提供的算法决策服务。

总之,算法偏见之所以成为社会问题,归根结底是由算法的政治性决定的。算法决策为人类决策“赋权”,但受所输入数据的质量以及算法模型本身的限制,内在地嵌入了人类正面或负面的价值观,并能动地制造着各种风险后果[20]。从技术与权力互构论的角度分析,可以依据对象、起源两个标准来进一步区分出算法偏见的六种理想类型。

第一,根据遭受算法偏见的对象划分,主要包括算法中的社会偏见、用户偏见和信息偏见[21] 。

1.所谓“社会偏见”,是指算法可以展现社会对个体或利益攸关方的偏见,并明确体现在信息系统中,或者受到使用这些系统作出的决定的直接影响。研究者将有害的算法比喻为“数学杀伤性武器”,揭露了算法的不透明、规模化、毁灭性等特征[22]。下列案例同样涉及算法的社会偏见:英国圣乔治医学院的自动化招聘模型给来自外国的优秀申请人和女性申请人打分偏低,每年2000个申请者中有60个申请者无法进入面试环节,仅仅是因为他(她)们的种族或性别;一位得过躁郁症的年轻人在康复后重新求职,但由于不同公司采用了同一套人格测试算法模型,导致他在申请低薪职位时也接连被拒。

2.所谓“用户偏见”,是指同一个信息系统对不同用户(个人、团体或组织)的可用性偏见,具体包括系统对不同用户的可获取性,用户可以使用系统特性的舒适性,以及系统能够满足用户需求的程度等[23]。一个典型的案例是谷歌实施的“自杀预防结果”项目:当用户在引擎上输入与自杀相关词汇时,谷歌就会在第一时间向具有自杀倾向的群体呈现出能够预防其自杀的干预措施。然而,谷歌这项表面看起来具有巨大社会效益的项目,面临的最大挑战是来自不同的搜索语言得出的算法输出结果之间的明显差异。有研究者发现,当使用英语搜索与自杀相关的危害信息或求助信息时,会有90%以上的概率出现自杀预防结果,这远远高于在使用日语、中文、印地语、德语等地区进行搜索“自杀预防结果”显示的概率。这限制了使用非英语语言地区的用户对于“自杀预防结果”项目的可获得性,从而导致全球网民在健康信息上的“用户偏见”[24]。

3.所谓“信息偏见”,是指某个信息系统提供的信息选择和表征方式而造成的认知性偏见。以医学图像分析的算法为例,它旨在以精确的方式在计算机中表现人体生物结构,从而改善有关疾病的诊断前景。这些算法是否应该将某个生物结构计算为病变,与所选择的阈值有关,由此引起的伦理问题之一是使用产生假正例和假负例结果的风险。而阈值往往是“似乎合理”,而非先验正确的,这取决于算法设计者在避免假正例/病变之间的偏好,偏好就不可避免地涉及价值判断[3]。

第二,根据算法偏见产生的起源划分,主要包括先天偏见、过程偏见和后果偏见[21]。

1.所谓“先天偏见”,是由数据科学家的判断引入,这类有偏见的算法包括算法代码和指令在预设前提的基础上设计的情况。例如,程序员和软件工程师的偏见心态找到进入算法设计方式,成为嵌入在规定算法的条件和结果部分的过程中这种算法设计者意识形态和算法的结合,可以使算法成为负载规范性和命令性陈述的载体。

2.所谓“过程偏见”,是指机器学习算法与社交或信息环境交互的过程中学习和复制偏见行为。2016年3月,微软公司在推特(Twitter)上推出的智能聊天机器人Tay是一个试验性的机器学习项目,专为与18—24岁之间的年轻人交流而设计。但在学习过程中,Tay不仅脏话连篇、辱骂用户,还发表煽动性的政治评论和种族歧视言论,结果在短短24小时内就被迫撤下整改。

3.所谓“后果偏见”,是指一些算法输出的结果是有偏见的,但并非有意为之。2015 年,谷歌公司处于开发早期的图像识别算法竟然将一些黑人图片错误地标注为“大猩猩”,为了平息风波,谷歌从照片数据库内屏蔽了“大猩猩”和其他灵长类动物的标签。这起算法事故是对曾以“不作恶”为行为准则的谷歌的一個反讽。

从社会学意义上分析,各类的算法偏见将在特定时空条件下促生一群“数字穷人”或“数字难民”,这是因数字技术变迁导致的新型社会排斥问题,即“数字排斥”。“虽然社会排斥有各种定义,但它意味着这样一个过程:个人或群体被全部地或部分地排除在充分的社会参与之外”[25]。个体或群体的数字排斥过程有主动或被动之分,其中算法偏见涉及的案例主要是由被动排斥所导致的。总之,算法偏见可能导致劳动力市场排斥、公共服务排斥和社会关系排斥等潜在的社会问题,是数字社会治理的重大挑战之一,若治理无效可能成为新的社会不平等源头。

四、算法社会的伦理治理路径探究

社会科学学者较早从算法权力的角度觉察到“算法社会”正在加速来临。相比以往,越来越多的经济与社会决策依赖算法系统作出的自动化决策,正在来临的算法社会正是以运用算法、智能代理和大数据来治理人口为特色的。斯科特·拉什指出,在媒体和代码无处不在的社会,权力越来越集中于算法这种生成性规则[26],而戴维·比尔强调“算法能够形塑社会文化形态,并直接影响个体的生活”[27],弗兰克·帕斯奎尔强调了算法社会的黑箱化风险(即“黑箱社会”),用于作出判断的算法程序将主观偏见伪造成看似中立的分数,逐渐成为分配机遇和施加惩罚的“看不见的仲裁者”[28]。

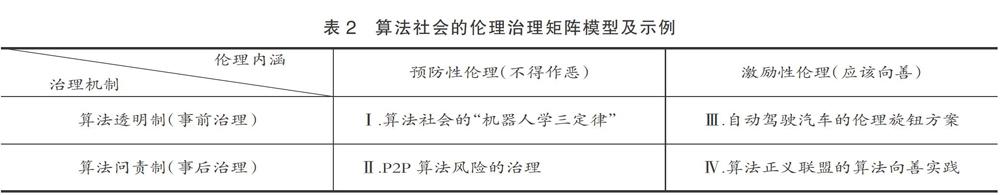

之于算法社会的伦理治理,本研究从伦理内涵与治理机制两个分析维度,尝试构建一个伦理治理的矩阵模型。从伦理内涵维度分析,可以辨识出预防性伦理和激励性伦理[29]两种类型;从治理机制维度分析,主要有两种:作为事前治理方式的算法透明制和作为事后治理方式的算法问责制(如表2所示)。

第一,在算法社会,对“机器人学三定律”的阐释应该与时俱进,其道德底线应该是不造成算法伤害。美国作家艾萨克·阿西莫夫在科幻作品中提出了广为流传的“机器人学三定律”,即“第一定律——机器人不得伤害人,也不得见人受到伤害而袖手旁观;第二定律——机器人应服从人的一切命令,但不得违反第一定律;第三定律——机器人应保护自身的安全,但不得违反第一、第二定律”[30]。与阿西莫夫虚构的科幻世界不同,美国法学家杰克·巴尔金指出,算法社会的“机器人学三定律”应该是针對人类与人类组织的法则,而不是针对机器人本身的法则。“首先,机器人、算法和智能代理的操作者是信息信托人,对终端用户、委托人和客户负有诚信和公平交易的特殊责任。其次,私有的数字平台企业虽然不是信息信托人,但同样对公众负有责任。再次,机器人、算法和智能代理的使用者核心的公共责任是不造成算法伤害。”[31] 事实上,上述伦理准则可以凝练为“算法社会的三定律”,即主张数据科学家和算法工程师的角色是用户的信息信托人,数字平台企业也需要履行公共责任,二者的核心责任是不造成算法伤害。此处的算法伤害,具体可以理解为前述的六类算法偏见,而它们在现实中往往交织在一起。“不造成算法伤害”的道德律令,更多体现了预防性伦理的视角,其基本治理原则是算法透明,即要求算法的设计方或使用方公开披露算法决策相关的源代码、输入数据或输出结果。

第二,在算法透明制之外,同样重要的算法风险治理机制是提高决策学习算法的可问责性。事实上,算法透明制在操作层面仍有诸多限制,而且透明性不是最终目的,它只是通向可理解性的一个阶梯[28]。简言之,算法问责制是要求算法的部署方确保算法按预期运行,并有能力纠正有害后果。算法问责制的一个成功应用案例是美国对P2P 算法风险的治理。P2P算法在文件传输领域的成功应用反而成为一柄“双刃剑”,即迅速滋生了盗版、淫秽等音视频内容的传播。为治理此类算法风险,美国音乐电影产业界与互联网产业界共同推动了相关的版权立法。由于美国版权领域有着成熟的责任追溯体系,因此主要采用了事后治理性质的算法问责机制,仍然达到了有效的治理效果,而无须借助算法透明原则深究P2P 算法的技术性实质[32]。

第三,从激励性伦理的视角,算法不仅不得“作恶”,同时还要积极“向善”。面对层出不穷的算法偏见问题,一些致力于实现算法向善的理念已经出现。典型案例之一是,为应对可能出现的自动驾驶汽车版“电车难题”,有研究者提出了可定制“伦理旋钮”的构想。乘客有三种伦理选择:第一种是“利他”模式,自动驾驶汽车在紧急情况下选择牺牲乘客以拯救第三方(行人或过路人);第二种是“利己”模式,紧急情况下牺牲第三方以拯救乘客;第三种是“公正”模式,赋予乘客和第三方以同等的道德权重,紧急情况下依据“两害相权取其轻”的功利主义原则决策,而在乘客与第三方人数相同的特殊情况下,可能会有一个有利于乘客或第三方的推定,或者在两者之间进行随机选择。此外,选择不同的伦理旋钮,还需要引入相应的乘客法律责任、第三方保险赔偿等社会治理机制[33]。事实上,尽管这一方案还有待实践的检验,但已经超出了技术性修正的范畴,开始意识到在技术与社会的交互界面思考解决方案的必要性。

第四,在算法向善的实践层面,算法风险治理应该重视发挥第三方机构的专业监督作用。从激励性伦理的角度看,算法问责制的一个典型案例是算法正义联盟,这是由麻省理工学院计算机科学家乔伊·布拉姆维尼发起,致力于纠正算法偏见的公益机构。数据科学家们通过网站收集遭受过算法伤害的受害者申诉,并围绕申诉撰写文章、录制视频、发起研究课题等,争取使现有(尤其数字平台企业的)算法变得更加公正与客观。主要的工作方式有研究、传播和监督三种:1.通过专业的科学研究,调查、评测和呈现重要算法的偏见水平,呼吁数字平台企业改进算法;2.通过论文、视频、演讲等传播形式以及多种艺术、媒体形式进行宣传报道,并收集算法伤害的案例和招募志愿者,引起公众和有关企业对算法偏见的理解和重视;3.发挥第三方组织的监督作用,通过建立“类行业标准”的规范协议(如“安全人脸承诺”),鼓励企业、政府、科研人员等利益攸关方加入,进行自律或他律[34]。

结 语

本研究从算法与权力的互构共生关系视角,批判了算法的价值中立论,主张一切算法系统皆是社会—技术系统,算法偏见是当代数字社会的一种形式偏见。算法作为非人类行动者参与到人类行动者的决策过程中,要么被外在地赋予了政治性,要么内在地具有政治本性。层出不穷的算法偏见可能导致新型的数字排斥,必须高度重视算法风险的社会治理。其基本的治理机制是算法透明,而同样重要的是算法问责;算法社会的预防性伦理底线应该是不造成算法伤害,避免算法作恶,此外还要从激励性伦理的角度推动算法的负责任创新,实现算法向善。

在算法偏见已经成为一个不可忽视的社会问题的今天,特别需要来自社会科学领域与自然科学领域的学者通力协作,促进深度学习算法的健康发展。在2020年深度学习领域的国际顶级会议ICLR2020上,社会科学学者反思算法偏见问题的声音受到广泛关注,“没有历史深度和社会深度的计算深度只是浅薄学习”[35],而非深度学习。对算法风险的社会治理已经开始起步,仍然任重而道远。

参考文献:

[1] 高明华.偏见的生成与消解:评奥尔波特《偏见的本质》[J].社会, 2015,35(1).

[2] Friedman B., Nissenbaum H..Bias in Computer Systems[J]. ACM Transactions on Information Systems, 1996, 14(3).

[3] Kraemer F.,et al. Is There an Ethics of Algorithms?[J]. Ethics and Information Technology, 2011,13(3).

[4] Mittelstadt B., et al. The Ethics of Algorithms: Mapping the Debate[J].Big Data & Society,2016,(12).

[5] Tsamados A., et al. The Ethics of Algorithms: Key Problems and Solutions [EB/OL]. https://www.researchgate.net/publication/343472595,2020-08-06.

[6] Menon S., et al. PULSE: Self-Supervised Photo Upsampling via Latent Space Exploration of Generative Models [EB/OL]. https://arxiv.org/abs/2003.03808,2020-07-20.

[7] Salminen J., et al. Analyzing Demographic Bias in Artificially Generated Facial Pictures[EB/OL]. https://dl.acm.org/doi/10.1145/3334480.3382791,2020-04-25.

[8]〔美〕高德納. 计算机程序设计艺术(第1卷:基本算法)[M].苏玉林,译. 北京:国防工业出版社, 2007.4-5.

[9] Hinton G., Salakhutdinov R.. Reducing the Dimensionality of Data with Neural Networks[J]. Science,2006,313(5786).

[10] Hill R.. What an Algorithm Is?[J]. Philosophy & Technology, 2016,29(3).

[11] MacKenzie D.. Material Signals: A Historical Sociology of High-Frequency Trading[J]. American Journal of Sociology, 2018,123(6).

[12]〔古希腊〕亚里士多德.物理学[M].张竹明,译. 北京:商务印书馆,1982.43-46.

[13] Weber M.. The Theory of Social and Economic Organization[M].Glencoe,IL: The Free Press,1964.35-40.

[14]〔美〕赫伯特·马尔库塞.单向度的人[M].刘继,译.上海:译文出版社,2006.导言7-8.

[15]〔美〕安德鲁·芬伯格.技术批判理论[M].韩连庆,等,译.北京: 北京大学出版社,2005.97-98.

[16]〔美〕希拉·贾萨诺夫.发明的伦理:技术与人类未来[M].尚智丛,等,译.北京:中国人民大学出版社, 2018.177.

[17] Winner L.. Do Artifacts Have Politics? [J]. Daedalus, 1980,(109).

[18] Angwin, J., et al. Machine Bias: There's Software Used Across the Country to Predict Future Criminals. And It's Biased against Blacks [EB/OL]. https://www.propublica.org/article/machine-bias-risk-assessments-in-criminal-sentencing, 2016-05-23.

[19] McEvoy M., Therrien D. INVESTIGATION REPORT P19-03 PIPEDA-035913,AggregateIQ Data Services Ltd. [EB/OL]. https://www.oipc.bc.ca/investigation-reports/2363,2019-11-26.

[20] 黄晓伟.互联网平台垄断问题的算法共谋根源及协同治理思路[J].中国科技论坛, 2019,(9).

[21] Sattarov F.. Power and Technology: A Philosophical and Ethical Analysis[M]. London: Rowman & Littlefield International, 2019.

[22]〔美〕凯西·奥尼尔. 算法霸权:数学杀伤性武器的威胁[M].马青玲,译.北京:中信出版社,2018.

[23]Van Den Hoven J.. Computer Ethics: Philosophical Enquiry[M]. Rotterdam, Netherlands: Rotterdam University Press,1998.

[24] Haim M., Arendt F., Scherr S.. Abyss or Shelter? On the Relevance of Web Search Engines Search Results When People Google for Suicide[J]. Health Communication, 2017, 32(2).

[25] 景晓芬.“社会排斥”理论研究综述[J].甘肃理论学刊, 2004,(2).

[26] Lash S.. Power after Hegemony: Cultural Studies in Mutation? [J]. Theory Culture & Society, 2007, 24(3).

[27] Beer D. .Power through the Algorithm? Participatory Web Cultures and the Technological Unconscious[J]. New Media & Society,2009,11(6).

[28]〔美〕弗兰克·帕斯奎尔.黑箱社会:控制金钱和信息的数据法则[M].赵亚男,译. 北京:中信出版社, 2015.

[29]〔美〕理查德·伯恩. 工程伦理:挑战与机遇[M]. 丛杭青,等,译. 杭州:浙江大学出版社,2020.

[30]〔美〕艾·阿西莫夫. 我,机器人[M]. 国强,等,译. 北京:科学普及出版社,1981.1.

[31] Balkin J.M..The Three Laws of Robotics in the Age of Big Data[J]. Ohio State Law Journal, 2017,78(5).

[32] 沈伟伟.算法透明原则的迷思——算法规制理论的批判[J].环球法律评论,2019,(6).

[33] Contissa G., et al. The Ethical Knob: Ethically-customisable Automated Vehicles and the Law[J]. Artificial Intelligence and Law,2017,25(3).

[34] 司晓,马永武,等. 科技向善[M].杭州:浙江大学出版社,2020.205-211.

[35] Benjamin R.. 2020 Vision: Reimagining the Default Settings of Technology & Society [EB/OL].https://iclr.cc/virtual_2020/speaker_3.html,2020-04-28.

An Analysis of the Problem of Algorithmic Bias Based on the Co-production Theory of Technology and Power

HUANG Xiaowei, LI Yuhui

Abstract: Recently, many institutions have deleted some controversial datasets, and there is also a heated debate on algorithmic bias. Both events make algorithmic bias a social problem that cannot be ignored, because algorithms themselves are political. This paper criticizes the neutrality notion of algorithm based on the co-production theory of technology and power. In a socio-technological system empowered by algorithms, algorithms have been embedded into the human decision-making process as non-human agent. Several ideal types of algorithmic bias can be identified, while the algorithmic bias by its nature is a kind of formal bias in contemporary digitalized society, and it probably intensifies more and emerging digital exclusions. The ethical baseline of an algorithmic society is the avoidance of being algorithmic nuisances, that is, to avoid the evil algorithms. The aspirational dimension of ethics calls for the responsible innovation of algorithms, that is, the creation of more algorithms for good. The basic risk governance mechanisms of algorithm include algorithmic transparency as well as algorithmic accountability.

Key words: algorithmic bias; algorithmic power; co-production of technology and power; digital exclusion; algorithms for good

责任编辑:翟 祎

基金项目:国家社会科学基金青年项目“互构论视域的算法风险生成逻辑及治理机制研究”,项目编号:19CZX012。

作者简介:黄晓伟(1987—),男,天津大学马克思主义学院講师。

李育慧(1997—),女,天津大学马克思主义学院硕士研究生。