小样本图像语义分割综述

2021-02-12陈琼杨咏黄天林冯媛

陈琼,杨咏,黄天林,冯媛

华南理工大学,计算机科学与工程学院,广东 广州 510006

引 言

语义分割作为计算机视觉的基本任务之一,广泛应用于医学图像识别、自动驾驶、地质勘探等领域[1-2]。使用卷积神经网络能极大地提高语义分割的性能。基于卷积神经网络的语义分割模型需要大量具有像素级别标注的数据,获取大量的、高质量的像素级别标注数据费时费力,限制了语义分割在很多领域的应用。为了缓解语义分割模型需要大量标注数据的压力,研究通过使用少量的带标注样本完成语义分割任务的小样本语义分割问题被提出并受到广泛关注[3]。

小样本语义分割,也称小样本分割(Few-shot semantic segmentation, FSS)。小样本分割主要采用基于度量的元学习方法进行[4-5]。利用度量的思想,使用度量工具(例如,余弦相似度、卷积等)度量少量带标签样本特征和待分割图片特征在高维空间的距离,为待分割图片中的每个像素点做出预测。目前基于元学习的小样本分割方法占据主导地位,仅有少数研究工作摒弃元学习的办法[6]。本文对当前基于元学习的小样本分割研究工作做了归纳与整理,并在此基础上依据度量工具的不同将小样本分割方法划分为基于参数结构的小样本分割方法和基于原型结构的小样本分割方法,分析比较了这两类小样本分割方法的性能,介绍了这些方法的应用场景。最后,通过分析目前小样本分割算法存在的主要问题,给出了将来可能的发展趋势与展望。

1 小样本分割介绍

1.1 元学习

深度学习方法在很多领域都获得了成功,然而其局限性也在大量计算资源及数据的使用中暴露出来。元学习(meta learning)提供了另一种范式,在这种范式中,机器学习模型通过多个学习阶段获得经验,并利用这种经验来提高其未来的学习性能。元学习或者称为“学习如何学习”(learning to learn),是在多个学习任务中改进一个学习算法的过程。“学习如何学习[7-8]”就是使模型可以利用以往的知识经验来指导新任务的学习,具有学会学习的能力。在元学习中,通过一批训练任务训练元学习算法,算法在被训练解决这些任务的过程中得到的经验被用于解决最终的任务T。

采用元学习方法,模型先在大量易获得的、带标注的数据集上构造一批训练任务,训练模型学习如何解决实现某类任务,如图像分类[9-10]、语义分 割[11-12]、目标检测[13-15]等。元学习方法构造的学习任务集是利用极少样本学习的任务,因此这种方法被广泛应用于小样本学习任务,包括小样本语义分割。

当前的小样本语义分割方法的一般训练步骤如下:首先,在训练和测试时都是以小样本任务为基本单位,每个任务单独划分训练集和测试集,也被称为支持集和查询集。训练时,模型将每个任务看成一个训练样本,利用每个任务的支持集信息对查询集样本做出预测。通过在训练阶段大量小样本任务的训练,使得模型在测试时也能对此种小样本任务产生比较好的预测效果。

1.2 基于元学习的小样本分割范式

小样本语义分割和一般的语义分割的任务设定不同,当前小样本语义分割任务的研究重点是两类分割,即分割前景类别和背景类别,而一般的语义分割任务是分割出多种类别的物体。

基于元学习的小样本分割算法设计中,引入大量训练类别的带标签图片样本构造训练任务集。在每个训练任务上通过训练阶段(也被称为meta-train)和测试阶段(也被称为meta-test)用带标签图片来训练和测试模型。这里的测试类别图片和训练类别图片(也被称为未见过类和已见过类)来自同一数据集。按照未见过类和已见过类划分数据集 为两个数据集,分别记为

和小样本图像分类任务类似,小样本分割也采用N-Way-K-Shot的设定来为meta-train 和metatest 划分每一个小样本分割任务,这种情况意味着待分割类别为N类,可使用的样本数为K。以相应的N-Way-K-Shot的形式从中分别多次采样构成小样本分割任务,来获得训练集和测试集其中表示支持集、查询集、训练阶段和测试阶段的需要抽取的批次数。每一个支持集-查询集对组成了一个小样本分割任务,任一支持集包含K张图片-掩码对作为小样本分割任务中的带标签样本信息;任一查询集包含一个图片-掩码对,作为小样本分割 任务中的待分割图。

1.3 相似的语义分割方法

在语义分割领域有很多解决标注样本数量不足的研究工作,这里汇总了这些研究方法,说明了各类方法的特点,以及和小样本语义分割方法的区别。

1.3.1 半监督语义分割

有监督语义分割需要像素级别标记的数据,这些数据的获取是相当昂贵和费时的。半监督语义分割利用未标记的数据,从未标记和已标记的混合样本中学习最优分割模型,可以大大减少像素级别注释的工作,也可以保持相当高的准确性[16-17]。区别于半监督语义分割,小样本分割问题所需要的标注数据量远比半监督语义分割要少,针对不同的任务,半监督语义分割模型需要提前收集大量相关数据。因而小样本分割模型相比半监督语义分割模型更具有灵活性。

1.3.2 弱监督语义分割

弱监督学习是指,利用已知数据和其对应的弱标签,如图像级别标签、边界框标注等,训练一个模型将数据映射到一组更强的标签的过程,此处标签的强弱即为标签蕴含信息量的多少[18-19]。在语义分割任务上,常见半监督分割方法解决的是数据标注数量问题,而弱监督语义分割方法解决的是对于图像的精细的像素级标注造成的时间人力成本问题。通过弱监督学习,可以大大减轻对像素级标签的高度依赖性。但弱监督学习仍然需要大量弱标签来训练模型,而小样本分割只需要极少的像素级标签,便可以完成得到良好的分割结果

1.3.3 零样本语义分割

零样本语义分割可以说是目前语义分割领域极具挑战性的学习方式之一。零样本语义分割[20]将每个图像像素分类为可见类(即带有训练标签的测试类)和未见类(即没有任何训练标签的测试类)。通过利用可见类训练模型,完成对未见类的语义分割任务(狭义零样本语义分割)或同时对已见类和未见类的分割任务(广义零样本语义分割)。零样本语义分割的现行策略,是使用类别高级语义描述的嵌入让未见类别与可见类别建立联系,常见的思路[21]是将语言本体之间的语义相似性从一些合适的文本嵌入空间转移到视觉表示空间。虽然同属迁移学习范畴,零样本语义分割更加侧重于在高级语义中实现模型的知识迁移,对于新类(未见类)的样本并没有依赖性;而小样本分割更加侧重于对于语义信息的补充,增强模型从较少样本中学习的能力。小样本分割可以从零样本分割的学习策略中加以借鉴,从而开拓新的研究思路。

2 小样本分割算法

2.1 小样本分割的方法分类

自论文“One-Shot Learning for Semantic Segmentation”[3](OSLSM)提出了小样本分割的任务后,大量优秀的工作也不断涌现[22-27]。这些小样本分割方法都是利用基于度量的元学习思想,根据其度量工具是否有需要学习的参数,本文将这些小样本分割方法分为两种类型:基于参数结构的小样本分割模型和基于原型结构的小样本分割模型。

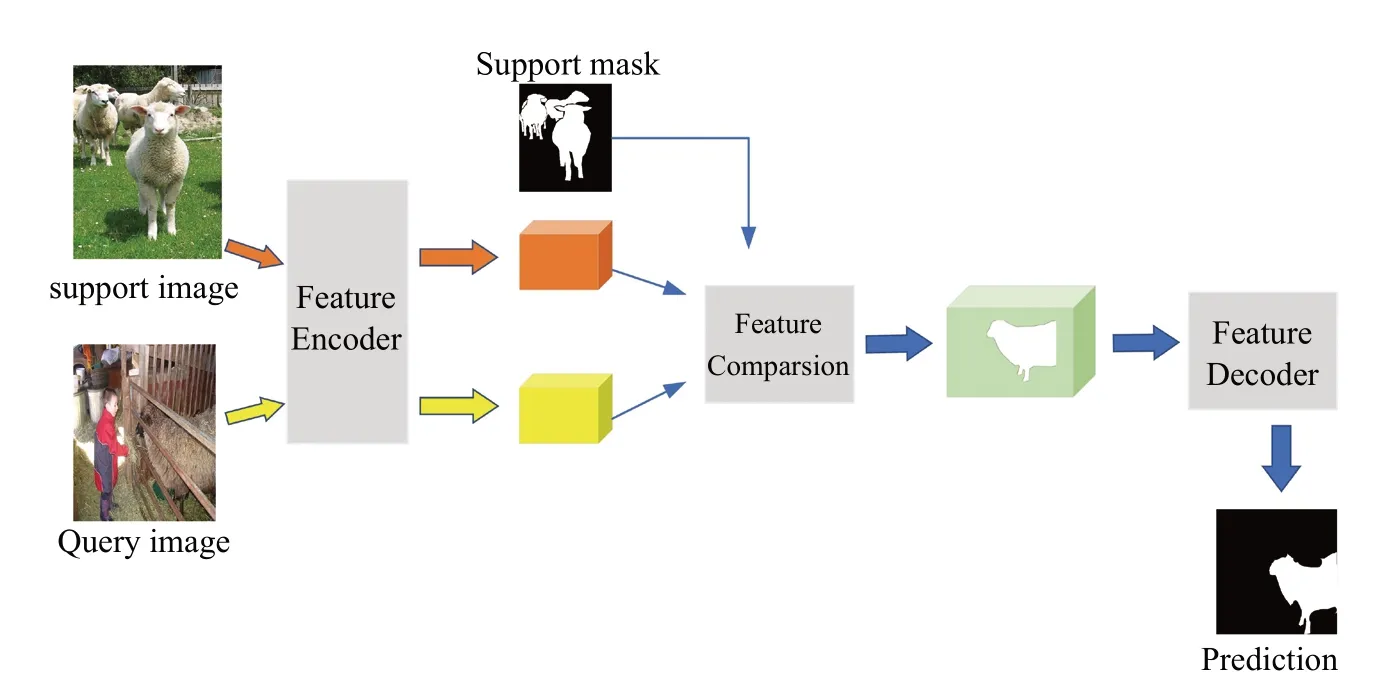

基于参数结构的小样本分割方法的一般模型如图1 所示。这种方法通常采用卷积作为度量工具,通过在训练集上的学习,为度量工具学习一个合适的参数配置。该方法首先利用特征编码器(Feature Encoder)编码查询图片(Query image)和支持图片(Support image),得到特征图,再利用特征比较模块(Feature Comparison)将查询图片中的同类别特征“激活”,最后利用特征解码器(Feature Decoder)优化前一阶段的比较结果,扩大感受野,捕捉上下文信息,进而得到预测图。

图1 基于参数结构的小样本分割模型Fig.1 The pipeline of parameter-based FSS method

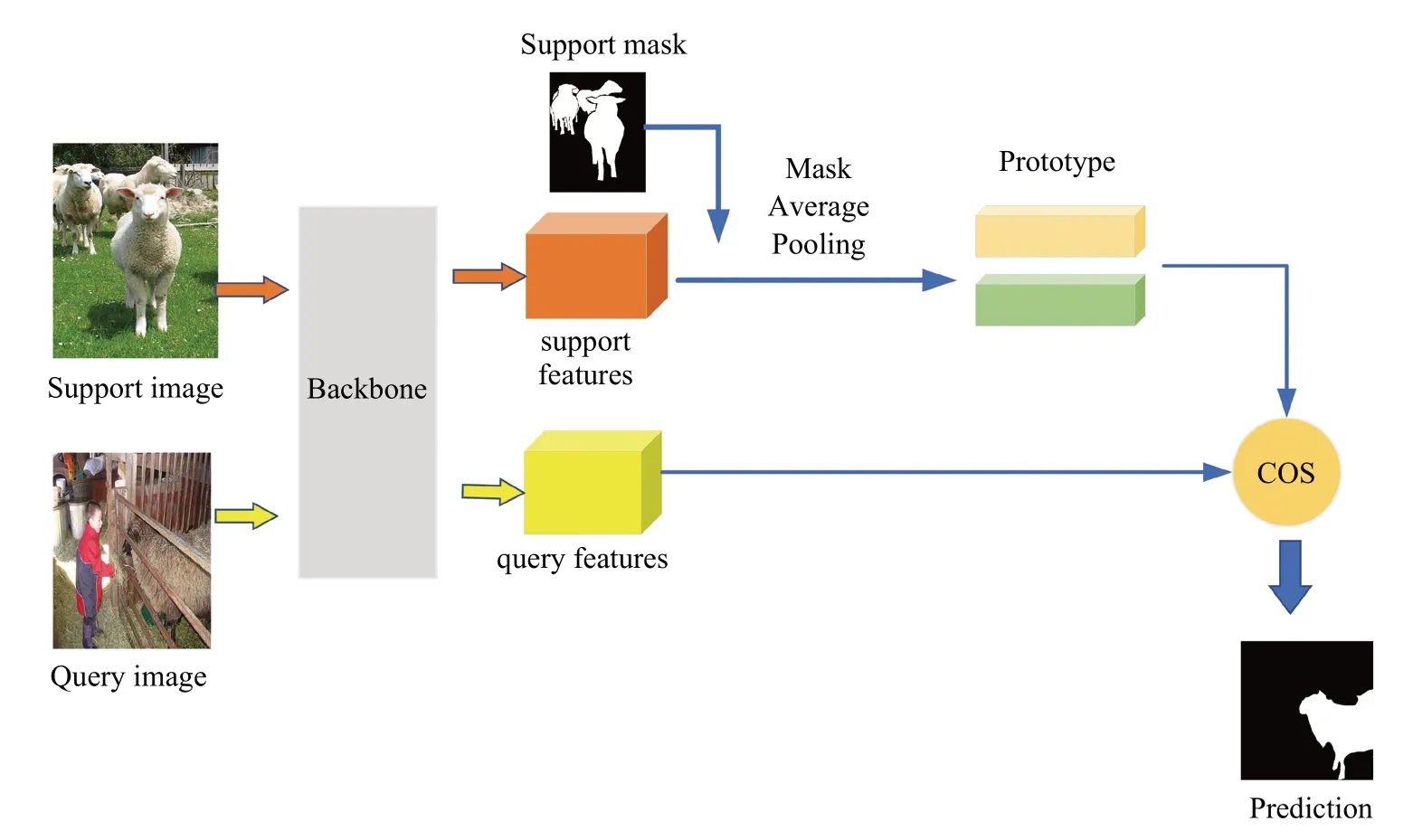

基于原型结构的小样本分割方法的一般模型如图2 所示。这种办法利用原型网络[29]的思想,先提取类别的原型,然后使用度量函数等无参的度量工具进行度量与分类。首先通过骨干网络(Backbone)将支持图片和查询图片编码并投影到一个高维空间,得到特征,再利用掩膜全局平均池化(Mask Average Pooling, MAP)分别从前景和背景特征提取前景原型和背景原型,原型表示在这个高维空间中的类中心。最后利用度量函数(例如:余弦函数,欧式距离)度量样本特征与原型在高维空间的距离进行分类,得出预测图。

图2 基于原型结构的小样本分割模型Fig.2 The pipeline of prototype-based FSS method

基于参数结构的小样本分割算法利用或设计许多卷积结构来提高感受野或捕捉上下文信息和空间信息,在语义信息量大的数据集上的性能优于基于原型结构的方法。但是过多的卷积结构使模型容易出现过拟合的现象。

基于原型结构的小样本分割算法利用无参的度量工具度量代表全局的特征原型和特征之间的距离,这种做法具有很强的解释性、抗噪声能力[30]。由于全局的类原型过滤掉许多干扰信息的同时也忽视许多局部信息,这种方法获得的原型有时不能很好地指导分割,也就是基于原型结构的小样本分割算法存在原型偏置问题[31],普遍通过解决偏置问题来提升分割性能。

2.2 基于参数结构的小样本分割

基于参数结构的小样本分割算法使用有参度量方法来比较支持集图像特征和查询集图像特征,通常采用卷积网络或全连接网络来实现。基于参数结构的小样本分割算法通常将骨干网络权重固定,而对特征比较模块和特征解码器进行改进。例如,利用迭代更新策略[32]对特征解码器进行优化;利用多尺度感知[33]和注意力机制[34]对特征比较模块进行优化。

2.2.1 迭代更新预测

迭代更新预测通过连续的迭代过程,逐步对模型的预测结果进行更新。该方法[32]的灵感来源于半自动分割任务。

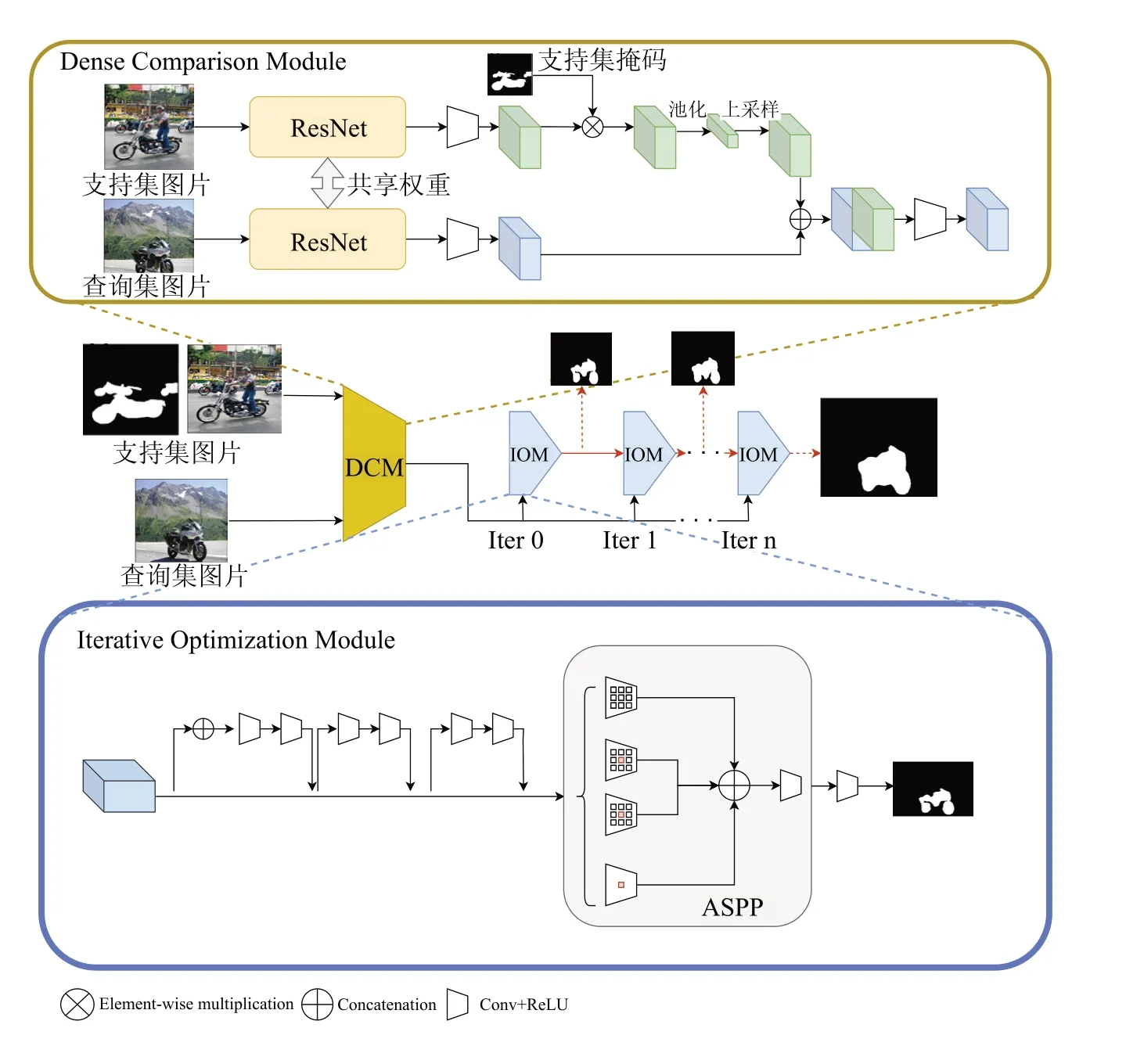

如图3,Zhang 等人提出了一个类别无关的小样本分割模型(Class-Agnostic Segmentation Networks, CANet[32])。该模型延续模型OSLSM 的双分支结构,两个分支是完全相同且共享权重的孪生网络。该论文的主要创新点是提出了一个密集比较模块(Dense Comparison Module, DCM)和迭代更新模块(Iterative Optimization Module, IOM)来分别改进Feature Comparison 模块和Feature Decoder 模块。密集比较模块的灵感来源于图像分类中度量学习的距离函数,其作用是衡量图片之间的相似度。迭代更新模块则和半自动分割的思想类似。在迭代更新过程中,IOM 的输入为DCM 的输出或上一阶段IOM 的输出,利用多次的迭代过程,IOM 的输出期望能不断地被优化。为了避免过拟合,每一轮IOM 的输出在训练阶段都会借鉴Dropout 的思想,以一定概率输出空值。

图3 CANet[32]模型结构Fig.3 The pipeline of CANet[32]

CANet 的分割性能相比以往的方法有了很大的提升,并且CANet 做出了以下的分析,为后续的方法奠定了基础:(1)采用提取原型的方法来进行点对点的密集比较,并使用卷积作为度量工具,相较以往的工作,极大地提升了分割性能。(2)低层特征图关联一些低层特征,如色彩、线条纹理,高层特征图关联于具体的类别。因此,如果要将模型泛化到未见类,应使用中层特征,如提取车轮的特征,可能在检测车类的时候发挥作用。CANet 不使用骨干网络ResNet[35](layer1-4)的layer4 作为输出,采用将layer2 和layer3 的输出拼接并进行卷积操作的方式作为骨干网络的输出,通过这种方式合理地利用中层特征。(3)网络直接得到的分割结果是不准确的,通过反复的迭代操作能有效地提升分割性能。(4)将骨干网络权重固定,仅仅用来将图片特征投影到高维特征空间。这种做法减少了学习参数的数量,缓解了模型学习压力。

文献[36]提出了交叉参考网络(Cross-Reference Networks, CRNet)来改善小样本分割的预测性能。之前的工作仅能对查询集图片做出预测,而CRNet不仅可以预测查询集图片,还能对支持集图片做出预测。借助同时预测查询集和支持集的对照预测机制,CRNet 能够更好地发现两类图片中存在的共现特征,并利用这些特征来增强生成的图像特征。同时,CRNet 还提出一个掩膜强化模型(Mask Reinforcement Module, MRM)来完成迭代更新策略。在最初的预测中,网络预测一个高置信度的种子区域,这个高置信度区域(概率图)以cache 的形式在模型中存在,在后续的操作中被用来做预测。每次预测后,模型会更新一次cache。经过多次迭代,模型便能利用多次更新的cache 进行精确的预测。在K-shot 的场景,CRNet 能够借助文中提出的对照预测机制使用张图片进行finetuning。实验显示在K-shot 领域,CRNet 的性能提升较大。

2.2.2 多尺度感知

由于语义分割任务是对图片像素的预测任务,因此聚合多尺度信息和上下文信息能有效地提高模型的预测能力[37-39]。小样本分割任务属于语义分割任务的一个分支,所以小样本分割模型的设计也考虑了聚合多尺度信息和上下文信息。

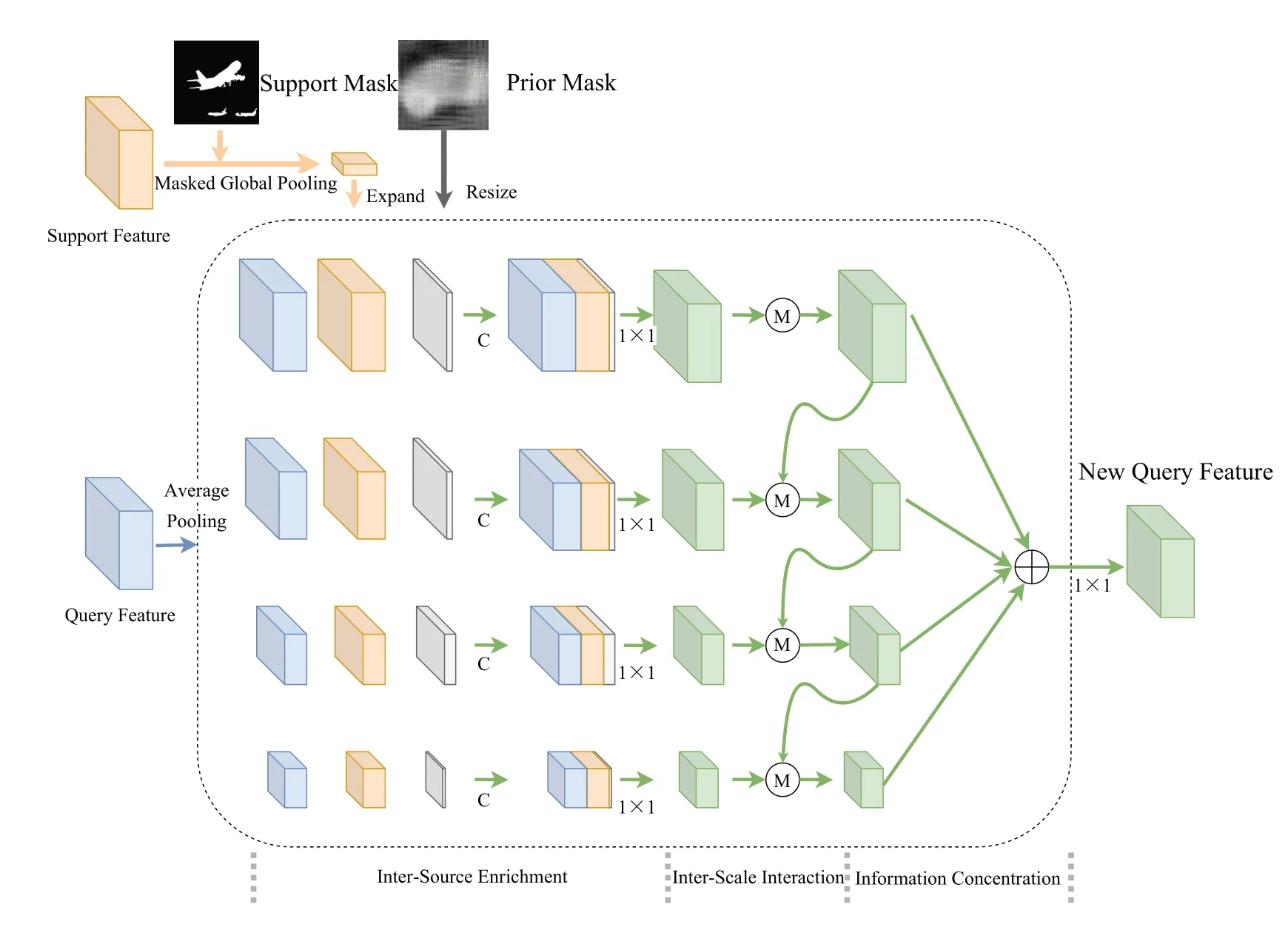

PFENet[32](Prior Guided Feature Enrichment Network)借鉴模型PSPNet[40]提出的金字塔池化,设计了FEM 模块(Feature Enrichment Module)来聚合不同尺度的上下文信息,以达到提高分割性能的目的。同时,PFENet 也采取和CANet 相同的做法,骨干网络权重固定并且输出采用与CANet 一致的形式。此外,PFENet 认为高维特征(即ResNet 的layer4 输出)仍然具有指导意义,提出使用余弦相似度来发掘支持集图片和查询集图片高维特征之间的关系,用以输出一个粗略的分割结果,记为Prior Mask。接下来,FEM 模块聚合多尺度的支持图片特征、查询图片特征和Prior Mask 来建立不同分辨率信息之间的传递通路,并输出最终的分类结果,如图4。

图4 FEM[33]模型结构Fig.4 The pipeline of FEM[33]

PFENet 结合以往的工作和语义分割模块对特征比较模块和解码模块做了很大的优化,使得小样本分割性能有了较大的提升,启发了后续的一些优秀工作。模型SCL_PFENet[41](Self-Guided and Cross-Guided Learning)在PFENet 的基础上采用一种自引导的机制来改进由于MAP 操作造成的信息损失。模型SAGNN[42](Scale-Aware Graph Neural Network)意识到多尺度信息的重要性,结合图卷积神经网络,将不同尺度的特征当作图神经网络中的一个节点,并利用注意力机制来代替PFENet 中的多尺度融合去发掘多尺度特征之间的关系。

2.2.3 注意力机制

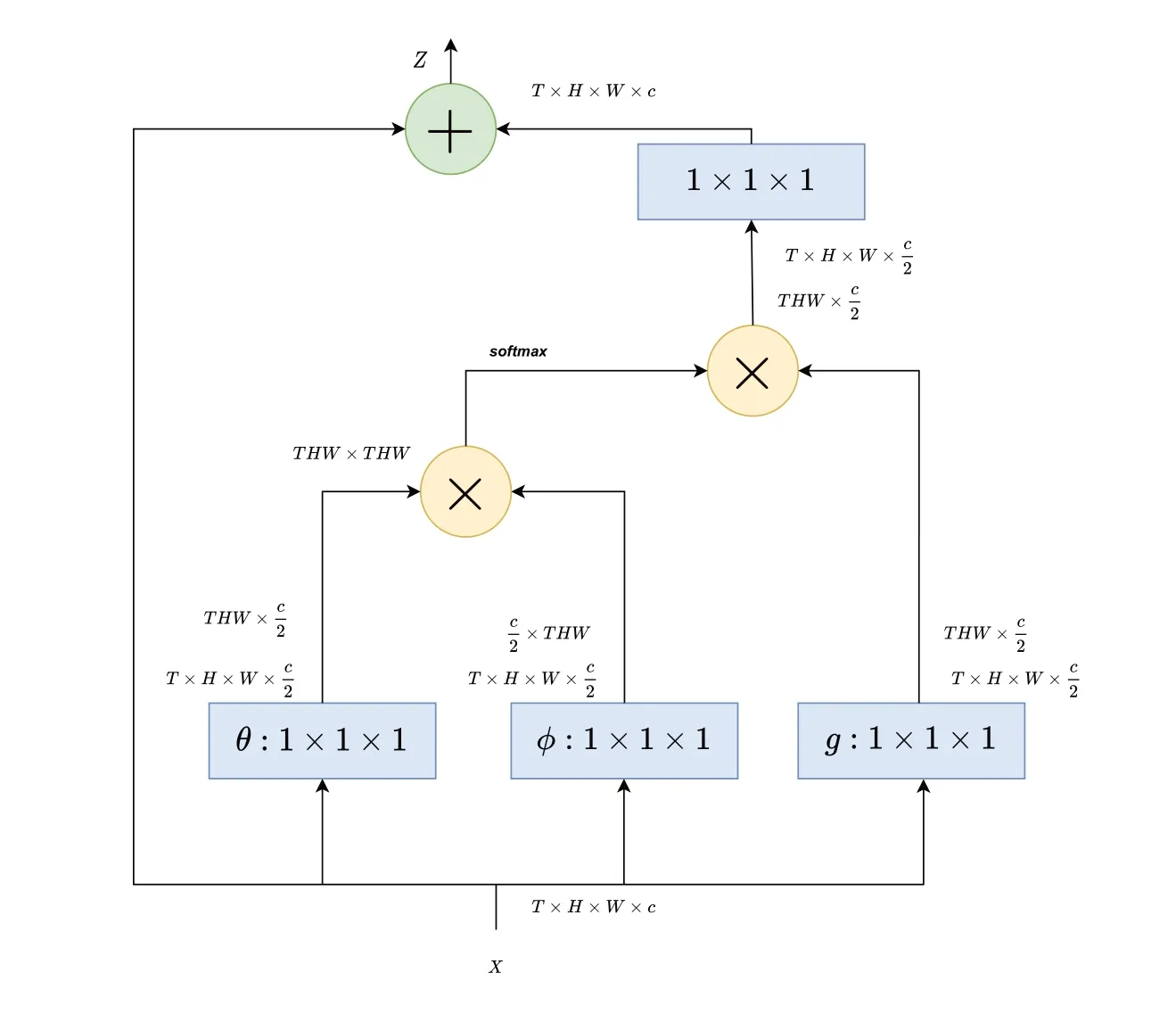

注意力机制同样是语义分割中常用到的方法,大量语义分割文章都利用了注意力机制[43-44]。最近的一些语义分割工作[45-47]也注意到了自注意力机制的作用,自注意力机制利用矩阵乘法,可以发现共现的特征或是从长距离依赖中捕捉上下文信息,如图5。很多小样本分割算法也借鉴注意力机制来设计模型。

图5 Non-local[49]自主注意力机制结构Fig.5 The pipeline of Non-local[49] networks

模型PGNet[48](Pyramid Graph Networks)将特征 表示为图结构,利用注意力加权的方式建立图节点之间的关系。此外,模型BriNet[34]借鉴Non-local[49]自注意力机制,提出了IEM(Information Exchange Module)。该模块能将查询图片特征和支持图片特征作为输入,经过自注意力机制激活,能够发现二者的共现特征,从而得到已激活的查询图片和支持图片特征。这种利用自注意力机制来完成特征比较的方法,也被后续工作所学习。SAGNN[42]设计了一种多尺度的图神经网络结构。其中,图的节点之间信息传递过程利用BriNet 提出的IEM 模块。在模型CMN[50](Cyclic Memory Network)的网络设计中,同样使用了和IEM 模块相似的自注意力机制的结构来聚合多尺度特征之间的关系。

在最近的工作中,CWT[51](Classifier Weight Transformer)提出了一个简单、新颖的transformer结构。该结构动态地将在支持集训练的分类器权重迁移到查询集图片上做预测,有效地减少了支持集图片和查询集图片之间的类内差异。另外,该网络甚至不需要进行元训练便可达到不错的效果。

2.3 基于原型结构的小样本分割

文献[29]提出利用类原型与特征进行度量分类作为一种新的小样本分类方法。其中,类原型可以看作是在某个嵌入空间(高维空间)的类中心。随着后续一些工作[52-55]的成功,基于原型结构的网络已经成为小样本分割领域的重要方法。基于原型的方法通常存在原型偏置问题,目前主要采取两种办法来解决,分别是增强单个原型的表达能力和生成多个原型作为单个原型的补充。

2.3.1 单原型方法

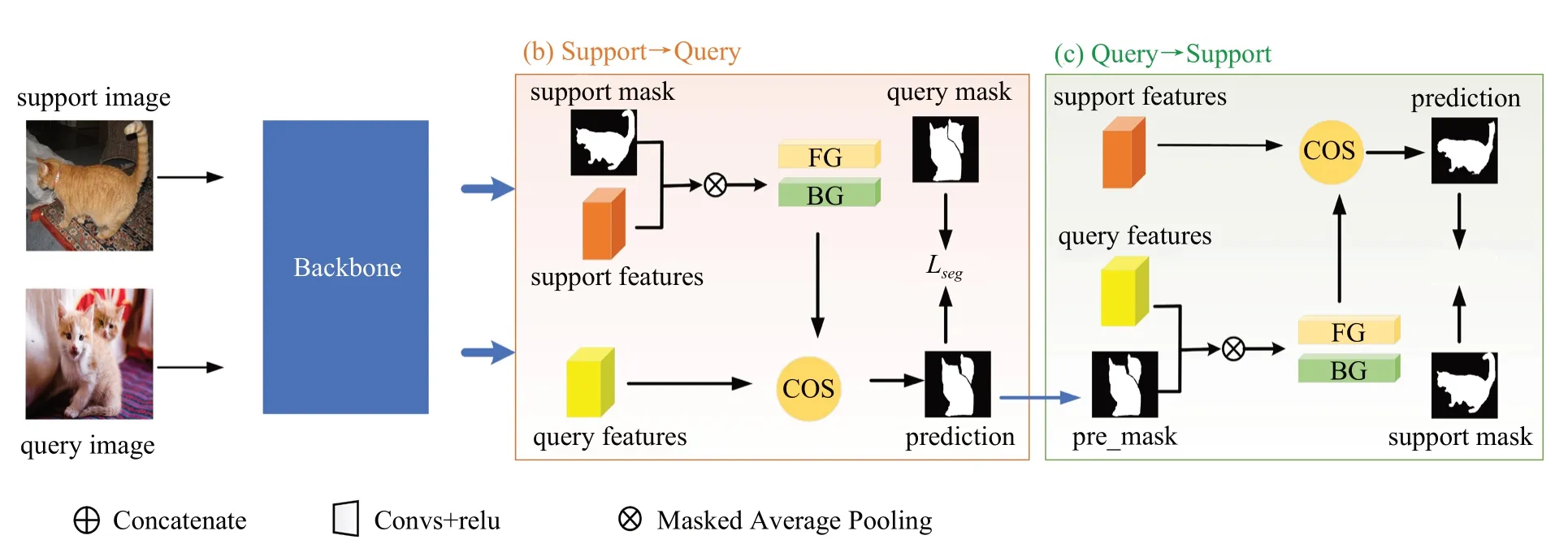

如图6,文献[54]提出了一种原型对齐的方法以及一种用于小样本分割的模型,原型对齐网络(Prototype Alignment Networks, PANet)。原型对齐主要是通过添加额外的任务来完成,目的是为了提升单个原型的表达能力。在前向传播得到查询图片的预测图后,将其作为查询图片的伪标签,交换支持集和查询集的位置,再进行一次前向传播过程得到支持图片的预测图,利用两个预测图来计算出两个损失值便完成了原型对齐的过程。该方法不易过拟合,分割过程利用度量函数,没有额外的参数需要学习;只在训练阶段使用原型对齐,减少了计算量,提升了测试速度。

图6 PANet[54]的结构图Fig.6 The pipeline of PANet[54]

另外,SimProNet[56]通过研究数据集图片特征,发现包含同类别物体的不同图片的背景区域仍然具有比较大的相似性,提出使用基于前景背景相似性的注意力机制来增强原型的表达能力。算法FWB[53](Feature Weighting and Boosting)在模型SG-One[52]的研究基础上做出改进。SG-One 中利用余弦相似度得到相似度图来指导分割,FWB 则改进这一方法,在计算余弦相似度时引入一个正则化项来提高前景特征的激活值并抑制背景特征的激活值,从而达到充分发掘原型和特征之间关系的目的。由于查询图片的部分特征可能并未在支持图片中出现,因而增强单个类的表达能力只能部分解决类的偏置问题。这种方法计算量小,容易实现并能迁移到其它基于原型结构的小样本分割算法中。

2.3.2 多原型方法

为了更好地解决原型偏置问题,部分工作提出通过生成多个局部/全局原型来补充单个全局原型的方法。文献[31]提出了部分注意网络(Part-aware Prototype Network, PPNet)来解决小样本分割问题。该方法是基于原型结构的方法,通过提取特征和原型,利用度量函数对查询图片中的每个像素点分类。以往的基于原型结构的小样本分割方法对每个语义类别使用一个原型来表示其在嵌入空间的类中心,但是这不足以应付类别多变的外观和不同的场景。并且以往的方法都将支持集图片限制在数量很小的范围内,不能很好地捕获丰富的、细粒度的特征。鉴于以往的小样本分割方法存在的缺点,PPNet 使用额外的、来自测试类别的无标注图片,利用传统的语义分割方法SLIC[57],得到多个区域标签掩码,进而可以将单个类原型扩展到多个。最后,将多个局部原型与注意力机制结合,利用加权的思想来提升最后的分割性能。

模型ASGNet[30](Adaptive Prototype Learning and Allocation)认为单一的类原型会导致语义不明确并且不可避免地丢失空间信息,另外,原型数量应该根据图片内容适应性地改变。因此,该方法先利用传统语义分割方法SLIC 对单张支持图片根据图片内容适应性地提取出多个掩膜,进而得到多个局部原型。然后利用余弦相似度得到多个局部原型和查询图片特征之间的关系,作为引导概率图,最后利用引导概率图对支持特征进行引导重建。借助重建后的支持特征与查询特征,便可利用卷积分类器得到最终的分割预测图。算法MLC[58](Mining Latent Classes)则考虑到不同类别之间的特征联系,利用K-means 算法生成多个局部原型,这时的原型不再表示全局的类原型,而表示局部特征原型。然后利用局部原型生成伪标签,将使用伪标签的分割任务作为额外任务,与正常训练过程结合起来,通过联合训练,使各种类别物体的局部特征在分割中发挥作用。

使用多个原型来解决原型偏置问题后模型的性能都有比较大的提升,但是该方法的计算量和复杂性都高于单原型的办法。此外,通过对未标注图片加以有效利用,理论上可以消除原型偏置问题。

3 小样本分割算法的应用

3.1 医疗影像

医疗与人们的生活息息相关,医疗图像是临床诊断的重要依据。医疗图像分割是对医疗图像进行分析,将感兴趣的部分从照片中自动提取出来,是后续诊断与治疗的基础。但在医疗领域,某些病属于特殊病例,难以收集病例资料,或是样本的收集涉及到病人隐私,得不到医院的支持。这些困难都是目前基于深度学习的语义分割方法在该领域的应用瓶颈。随着深度学习的发展,小样本分割被提出并且应用在医疗领域[59-60],大大缓解了带标签样本过少引起的问题。由于医疗图像含有较多噪声,并且训练样本较少,因此目前应用在医疗领域的小样本分割算法都采用了基于原型结构的模型。

3.2 3D 点云图像

点云是物体表面特征的大量点的集合,它是3D数据的表现形式之一[61],一般是通过3D 传感器获取的,如3D 激光扫描仪和3D 相机。受益于3D 扫描技术的发展,点云数据的获取变得低成本化和高速化,这也为3D 点云技术的研究提供了基础[62]。目前,3D 点云已经在很多领域得到应用,如自动驾驶、森林监测、增强现实和虚拟现实等。3D 点云分割在计算机视觉领域是非常基础的一项任务,其目标是预测点云中每一个点所属的类别。一些基于监督学习的方法[63-65]在3D 语义分割上实现了高效的性能,但这些方法都是基于大数据集的,因而可以将小样本分割技术应用于3D 点云分割,减少点云数据获取和数据标注的代价。在小样本3D 点云分割中,只有少量带标注的点云数据,在这些少量标注数据上训练一个网络,使用训练好的网络在新的点云数据上进行语义分割。

3.3 高分图像

高分辨率遥感图像,简称高分图像,对土地使用、城市规划、资源勘测等方面具有重要意义,通过对高分图像进行语义分割,提取图像中不同的物体,可以进一步对图像进行分析。另外,在农业领域,利用遥感图像分割可以监测农作物种植面积、农业病虫害、农作物生长态势等。高分图像分割在多个潜在的实际应用中发挥着重要作用[66]。虽然高分图像获取的渠道很多,但对这些数据的标注需要投入大量的人力和物力,且周期长、效率低,这也成为限制深度学习在高分辨率遥感领域广泛应用的一个原因。监督学习模型需要在大规模标注数据集上训练,所以并不能很好地解决这个问题。而小样本分割技术对数据的依赖度不高,它可以在几个甚至没有标注数据的情况下完成对图像中物体的分割,这大大减少了数据获取和标注的成本,为深度学习广泛应用于高分辨率遥感领域提供了一个新的思路。文献[67]中提到的迁移学习就是小样本学习中的一种策略。

3.4 车道线检测

全自动驾驶是当前计算机视觉和机器人研究的主要焦点之一,不管在学术界还是工业界都受到了广泛的关注[68]。在自动驾驶中,系统需要让目标车始终准确地位于车道线内,这对于自动驾驶中的车道偏离和路径规划都具有重要的意义。因此,基于摄像头的车道线检测对于自动驾驶具有十分重要的意义。车道线检测被一些现有的工作[69-70]看作多分类的语义分割任务,并且得到了比较好的解决方案。但对于世界各地复杂多变的路况,采集大量带标签图片来训练语义分割网络是不切实际的。据我们所知,目前尚无小样本车道线检测的研究。由于车道线检测是自动驾驶的第一步,针对此方面的研究是具有意义和重要的。因此,本文认为可将现有的小样本语义分割技术与车道线检测相结合来实现小样本车道线检测,在实现过程中结合车道线本身的特点(如车道线位置)来设计模型。

4 小样本分割算法性能分析

4.1 实验设置

4.1.1 数据集

小样本语义分割的研究主要使用三个数据集:PASCAL-5i、COCO-20i、FSS-1000。PASCAL-5i来自PASCAL VOC 2012[71]和SBD[72],共包含20 个类,平均分为4 个测试包(fold),每次选取1 个测试包中的5 类作为测试类,其它3 个包中的15 个类作为训练类。COCO-20i来自MSCOCO[73]数据集,共有80 个类,是一个更有挑战性的数据集。类似PASCAL-5i的划分方法,将所有类分为4 个测试包,每个包有20 个类。FSS-1000[74]共包含1000 个类别,是专用于小样本分割实验的数据集,由于当前小样本分割算法在COCO 数据集上性能仍然有较大提升空间,许多文章并未在该数据集上实验,因此本文只列举出前两个数据集上的算法性能对比结果。

4.1.2 评价指标

当前的小样本分割算法用固定的模型性能评估指标以便公平比较,主要采用前景背景交并比(Foreground-Background Intersection over Union, IoU, 也被称为FB-IoU[22])和平均交并比(Mean Intersection over Union, MIoU[3])。先计算出每个类别l 的交并比为:其中TP,FP,FN 代表真阳性、假阳性、假阴性。假设共有n类,FB-IoU和MIoU 的计算公式均为计算FB-IoU时,只考虑前景和背景类别,n取2。计算MIoU 时,不考虑背景类别。当实验数据集为PASCAL-5i时,n取5,为COCO-20i时,n取20。由于测试时,各测试类别图片数量不一致,而MIoU 考虑到了多类的情形,因此对模型的性能评估更为准确。

4.2 性能分析

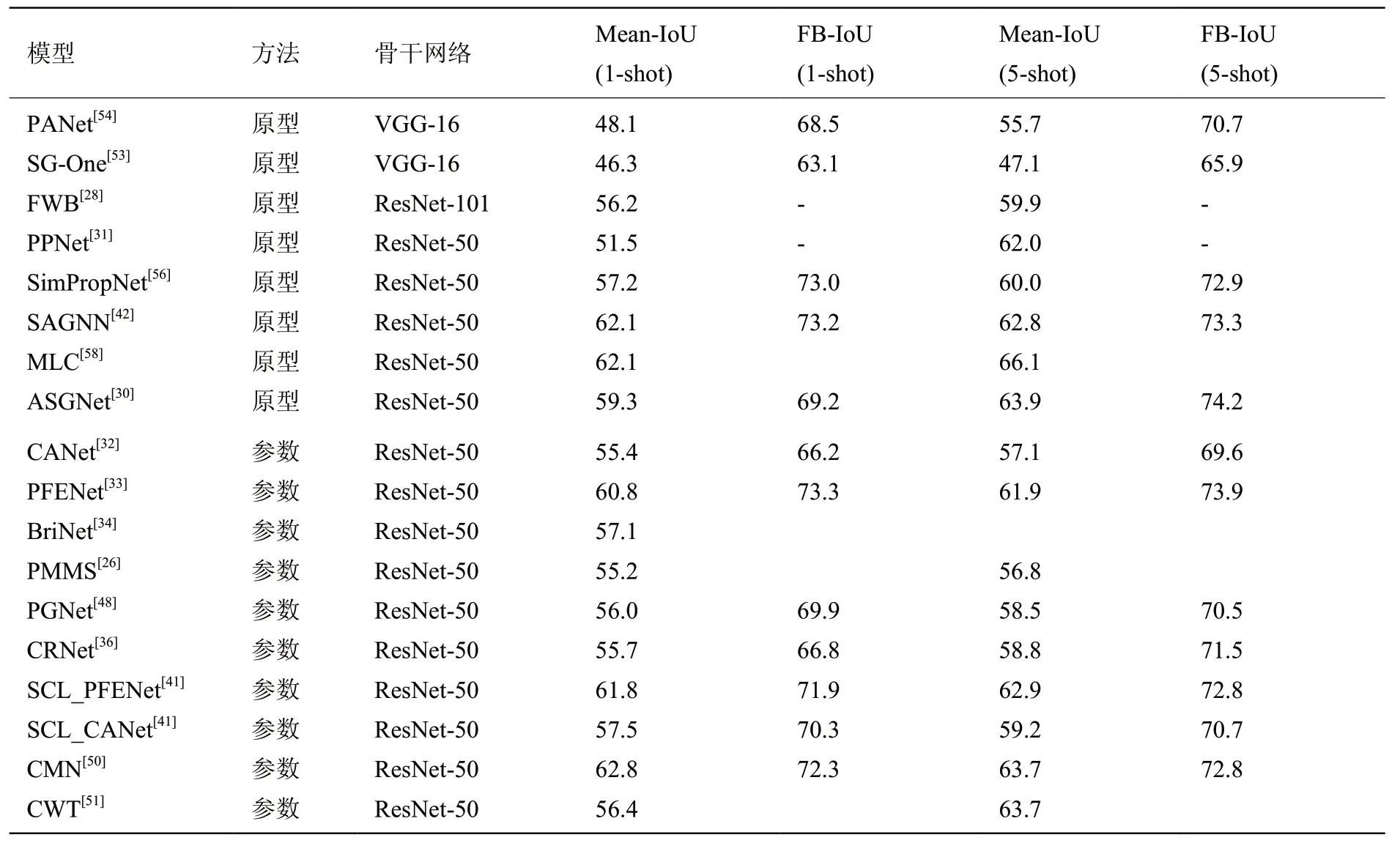

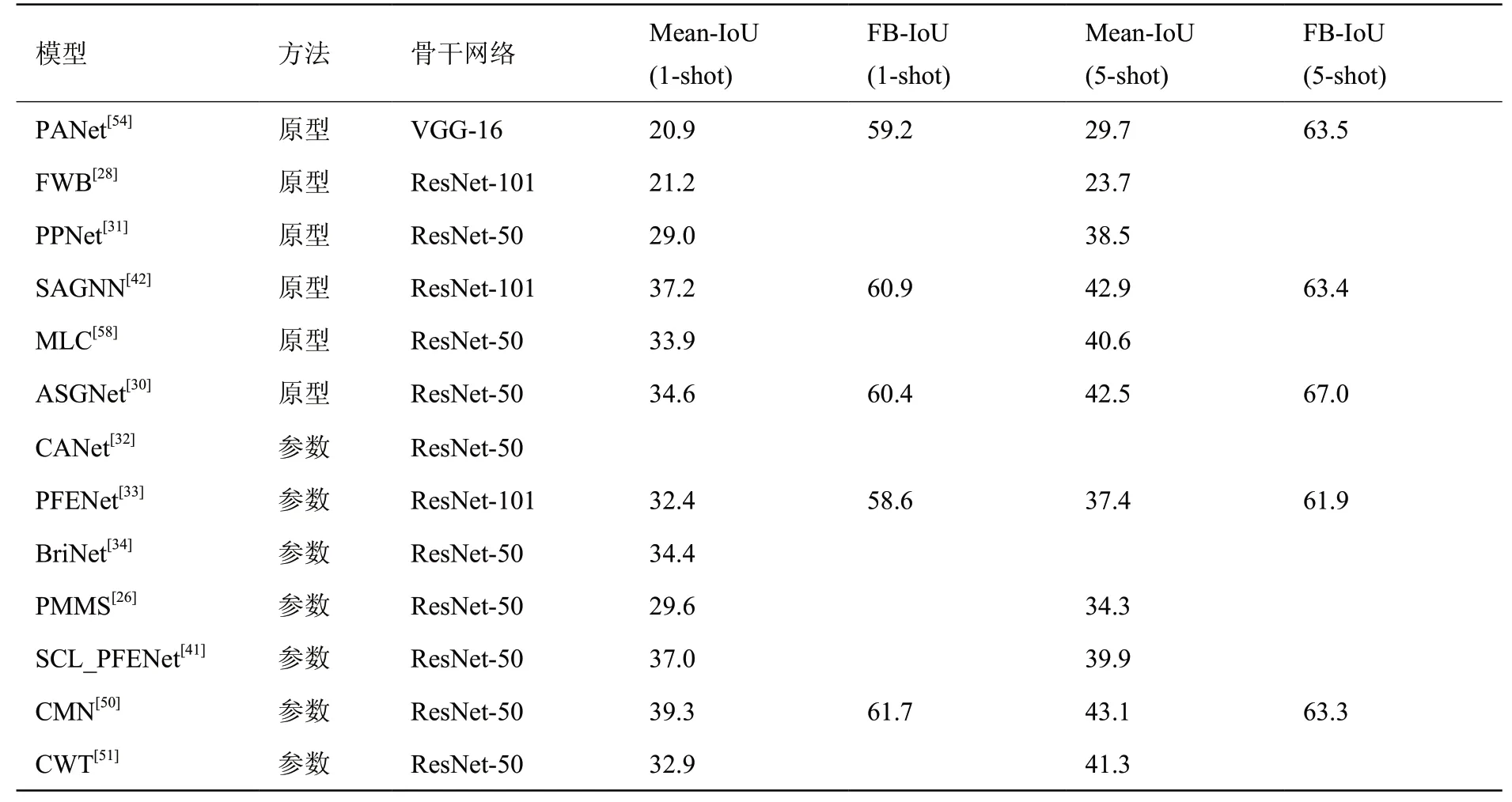

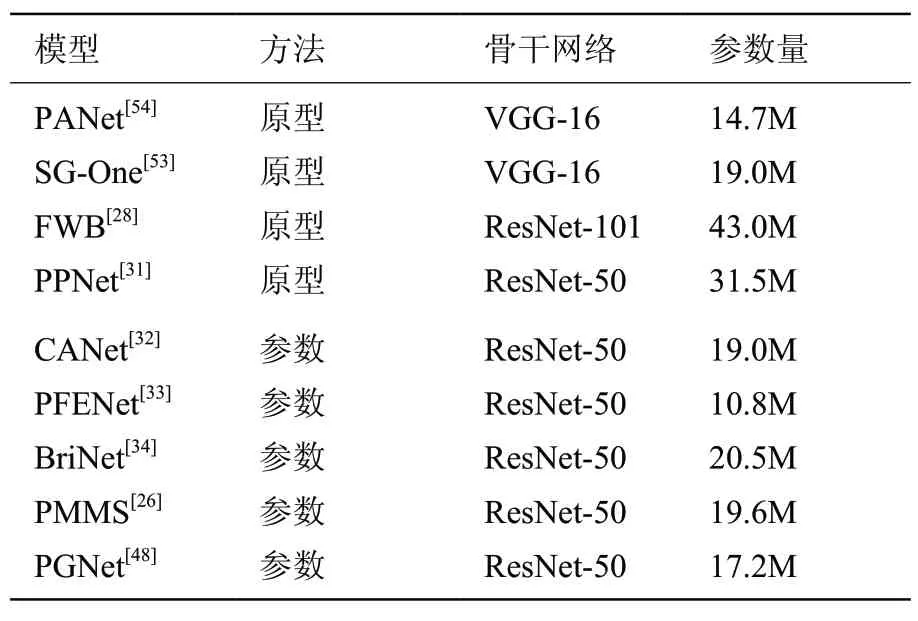

表1、表2 分别是小样本分割算法在数据集PASCAL-5i和COCO-20i上的性能对比。在两个数据集上,性能最优的基于参数结构的模型均为CMN[50],性能最优的基于原型结构的模型均为SAGNet[57]。而在两个数据集上,CMN 的one-shot 性能均高于SAGNet,分别为3.5%和4.7%。表3 是一些小样本分割算法模型需要学习的参数量。基于参数结构的小样本分割算法通常将骨干网络权重固定,只训练其它的部分,因而该类模型需要训练的参数数量更少。

表1 小样本分割算法在PASCAL-5i 的分割性能Table 1 Segmentation performance of few-shot algorithms on PASCAL-5i

表2 小样本分割算法在COCO-20i 的分割性能Table 2 Segmentation performance of few-shot algorithms on COCO-20i

表3 不同小样本分割算法的参数量Table 3 Number of learnable parameters of few-shot algorithms

由于实验涉及的两个数据集都包含丰富的语义信息,基于参数结构的小样本分割模型在这种情形下更有利。一方面,有参数的度量工具更能够发现特征之间的关系。另一方面,卷积结构的叠加可以扩大感受野,捕捉远距离特征之间的依赖关系,获得多尺度信息和上下文信息,这些信息对于语义分割的性能提升是有效的。而基于原型的小样本分割模型具有更好的解释性,更多地关注如何获得能代表类别的高质量原型。该方法采用无参的度量函数虽然不容易过拟合,但在语义信息量大的数据集上表现不如有参数的、可学习的度量工具,而更适合医学图像领域[59-60]。

由于COCO-20i数据集含更多的测试类别,这使得所有的模型表现都不尽人意,但该数据集更贴近生活,具有重要的现实意义,更多的工作应该聚焦于此。

4.3 关键问题与挑战

当前的小样本分割已经取得了较大的成功,并且在多个通用数据集上表现良好,但还存在一些亟待解决的问题。

首先,目前的小样本分割和传统的语义分割有一些关键的区别。小样本语义分割是二类分割,即区分前景类别与背景类别,而语义分割能够一次对一张图片分割多个类别。小样本分割只关注区分特定类别与其他类别(除特定类别外都作为背景类)。因而,当前的小样本分割任务并没有完成传统的语义分割所需要实现的内容。尽管有一些研究涉及到了多类别的情形[54],但是,相较于两类别的情况,多类别的分割性能下降剧烈。因此,如何在保证分割效果的前提下解决小样本分割中的多类分割问题,是一个需要探索的问题。

其次,当前的小样本分割采用元学习的方法,抽取多个和测试任务相同的小样本分割任务,通过在任务集上训练模型,让网络学习如何解决此类任务。但使用基于卷积网络的模型时,训练好的网络会更多地关注训练类别的关键特征,使得模型泛化性能变差,造成在新任务上的性能下降。如何减少在新任务上模型对于已见过类别的偏置,是需要深入探讨的问题。

最后,当前的模型要求训练数据集和测试数据集是同一分布,否则分割性能会受到损害,这就对训练数据规模和质量又提出了新的要求。假如使用易于获得的数据集构造训练任务集训练的模型,对任意数据集上的新任务都能获得比较好的性能也将是一个令人振奋的结果,即可以考虑小样本分割的跨域场景。

5 结论与展望

本文对当前的小样本分割研究工作做了归纳和总结,依据不同小样本分割算法使用的度量工具,将这些算法分为基于参数结构的模型和基于原型结构的模型。基于参数结构的模型通常使用可学习的度量工具来度量特征之间的关系,而基于原型结构的模型使用无参分类器来度量特征之间的关系。针对不同类型的算法,本文分析了各自的优缺点和性能,指出了当前算法的优化的方向。最后,针对当前小样本分割算法存在的不足,分析了小样本分割算法面临的挑战和关键问题,以及将来可能的研究问题。总的来说,语义分割是对图片内容的解析,是大量图像识别工作的基础。但是由于获取大量带标签的样本在很多场景下都是困难的,所以小样本分割能够解决语义分割在这些场景下的窘境,具有很高的研究价值。

利益冲突声明

所有作者声明不存在利益冲突关系。