基于深度学习网络的医学核磁共振成像超分辨率重构实验

2021-02-05刘家奇刘环宇李君宝

刘家奇,刘环宇,李君宝

前言

核磁共振成像(Magnetic Resonance Imaging,MRI)是断层成像的一种,它利用磁共振现象从人体中获得电磁信号,并重建出人体信息[1]。MRI通过对静磁场中的人体施加某种特定频率的射频脉冲,使人体中的氢质子受到激励而发生磁共振现象。停止脉冲后,质子在弛豫过程中产生核磁共振(Magnetic Resonance,MR)信号。通过对MR 信号的接收、空间编码和图像重建等处理过程,生成MR图像。MRI已应用于全身各系统的成像诊断,包括颅脑、脊髓、心脏大血管、关节骨骼、软组织及盆腔等。MR 与PET和SPECT 不同的是其不用注射放射性同位素就可成像,同时MRI 可以得到任何方向的断层图像,三维立体图像,甚至可以得到空间-波谱分布的四维图像。但由于MR成像的特殊性,硬件成像分辨率已经达到极限,磁场和辐射时间的增加将会带来蛋白灭活等对人体不可逆转的伤害。而高分辨率的MR 图像有助于医生对病灶的定位及疾病的诊断。

因此,面向MR 图像超分辨的软件方法具有重大意义,在不对人体造成伤害的情况下,实现MR 图像分辨率的提升。图像进行超分辨重建的方法主要包括基于插值[2]、基于重建[3-5]、基于字典学习[6]以及基于深度学习[7]的方法。无论哪种方法都需要MR 数据集作为支撑。目前,开源的MR图像数据主要包括或来源:NYU FastMRI[8]、IXI Dataset[9]、TCIA[10]以及mridata.org[11]。为什么开源的MR 数据也不少,还需要再构建一个新的MR图像数据集?

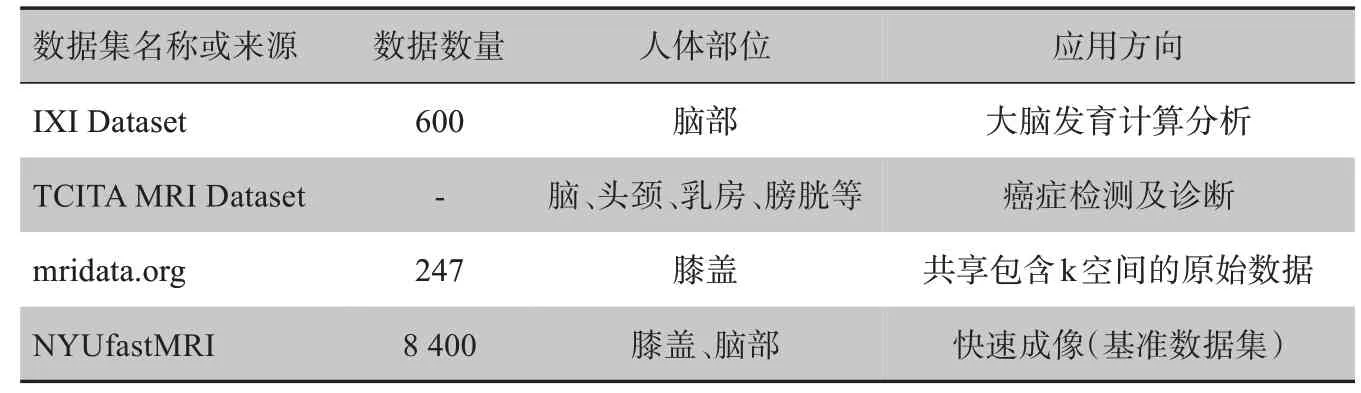

从表1可以看出,目前开源的MR 图像具有以下局限:(1)开源MR图像虽然应用方向众多,但是缺少针对图像超分辨方向的数据集;(2)开源MR 图像涵盖人体器官单一,不利于不同器官超分辨情况的分析;(3)缺少面向MR图像超分辨的基准数据集。

表1 开源的MR图像数据集Tab.1 Open source MR image data set

本文希望有一个具备以下优点的数据集:具备一定规模、不同尺度的真实MR图像超分辨的数据集并具备不同器官超分辨难易程度说明。本文的数据集名字为MRSR-D,其涵盖3种超分辨尺度×2、×3、×4,4个人体器官:500个头颈高低分辨率对,600个乳房高低分辨率对,1 000 个膝盖高低分辨率对,2 200 个头颅高低分辨率对,其中超分辨的难度为:头颅>乳房>头颈>膝盖。在此基础上,本文的数据集是在不断成长的。此外本文在构建的MR 图像数据集上对比分析 了bicubic、RDN、EDSR、SRGAN、ESRGAN、DDBPN、SRFBN、ESRFBN 算法,涵盖传统超分辨率学习以及一批超分辨表现优异的深度学习网络。根据实验结果可以看出深度学习网络在MR 图像上进行超分辨的效果表现良好,并且同一算法不同部位的超分辨效果波动较大。

本文的贡献包括以下3 点:(1)本文建立了用于MR 图像超分辨重建的数据集,包括4 300 个高低分辨率对,涉及头颅、乳房、膝盖、头颈4 个部位;(2)本文对不同部位的MR 图像超分辨率重建难度进行统计分析,为不同部位的MR图像超分辨率重建提供建议;(3)本文将传统超分辨重建、深度学习超分辨重建方法在MR 图像超分辨重建的数据集上进行了实验分析,可以看出深度学习方法在MR图像超分辨率重建上具有良好表象,为后续基于深度学习的MR图像超分辨率重建提供了参考。

1 相关工作

1.1 MRI数据集

近几年由于深度学习的大热,研究者们将从自然图像的超分辨逐步扩展到了医学图像超分辨,包括CT、PET-CT 以及MR 图像等。但是医学图像由于其伦理性与隐私性的限制,初期难建立像自然图像超分辨所用大规模、标准化的数据集,如DIV2K、Set5、Set14、BSD100、URBAN100、MANGA109 等数据集[12]。

目前开源的MR 图像数据集包括伦敦帝国理工的IXI Dataset、Facebook AI 与纽约大学医学院共同创建的fastMRI Dataset[8]、TCIA 中用于癌症研究的MR Cancer Dataset 以及mridata.org 中包含k 空间(寻常空间在傅利叶转换下的对偶空间)的原始MR Dataset。看似开源的MR 图像数据渠道不少,但是都有它们的局限性:IXI Dataset收集了来自正常健康受试者的近600 张MR 脑图像,致力于大脑发育计算分析。该数据集仅包含一个人体器官,不具有多样性。TCIA 是癌症研究的医学图像的开放获取数据库,其中的MR 图像用于对癌症的研究,包括癌症诊断、癌症的分割等研究。mridata.org 是研究人员共享MRI原始k 空间数据集的开放平台,仅公开获得的247 张膝盖MR数据集。但是,这些现有数据集的大小仍然很小。

这里不得不提到加速MR 重建速度的Benchmark Dataset:NYU fastMRI Dataset,其包括膝部和脑部两个部位,其中膝部MRI 在1.5T 和3.0T 磁场强度下获取1 500幅完全采样MRI数据以及10 000幅临床膝部MRI的DICOM图像。脑部MRI在1.5T和3.0T的磁场强度下获得6 970个全采样数据,包括原始数据集,如轴向T1加权、T2加权和FLAIR图像。

目前开源的MR 图像数据集没有一个是特定应用于图像超分辨领域的,并且部分数据集如IXI dataset、mridata.org 开源的MR 图像中,其中原始k 空间域的数据数量少、仅具有单一部位;较大型的TCIA MR dataset和fastMRI Datase 数据量较大、包含部位两或3 个,但都不针对图像超分辨方向,不具备人体多部位的高低分辨率MR图像对,难以直接用于图像超分辨领域。

1.2 深度学习超分辨网络

目前由于医学图像中具备特殊的成像机制,尚未有一种适应于医学图像的深度网络[13],但针对自然图像超分辨率重建(Natural Image Super Resolution,NISR)的网络已发展成熟。NISR 使用的网络主要包括:基于前馈深度网络、基于反馈深度网络、基于生成对抗网络。D-DBPN 属于前馈深度网络,其提供了一种错误反馈机制在每个阶段,并构建了相互依赖的模块,这类模块代表了不同的图像退化和高分辨组件,使得在上下采样阶段的特征连接起来,提升SR 结果[14]。RDN 属于反馈深度网络,它提出了残差密集模块(RDB),该模块主要通过密集连接的卷积层,通过卷积运算,提取图像内的局部特征[15]。SRFBN 也属于反馈深度网络,此类模型是通过约束的RNN 中使用隐藏状态来实现这种反馈方式[16]。EDSR 也属于反馈深度网络,在结构上它与SRResNet 相比,就是把批规范化处理(Batch Normalization,BN)操作去掉了[17]。SRGAN[18]属于生成对抗式网络,它是在SRResnet 的基础上加上一个鉴别器,其作用是额外增加一个鉴别器网络和2个损失,用一种交替训练的方式训练两个网络。三大类具有代表性的网络在自然图像的超分辨率重建上具有良好的贡献。

2 高质量医学MR数据集构建

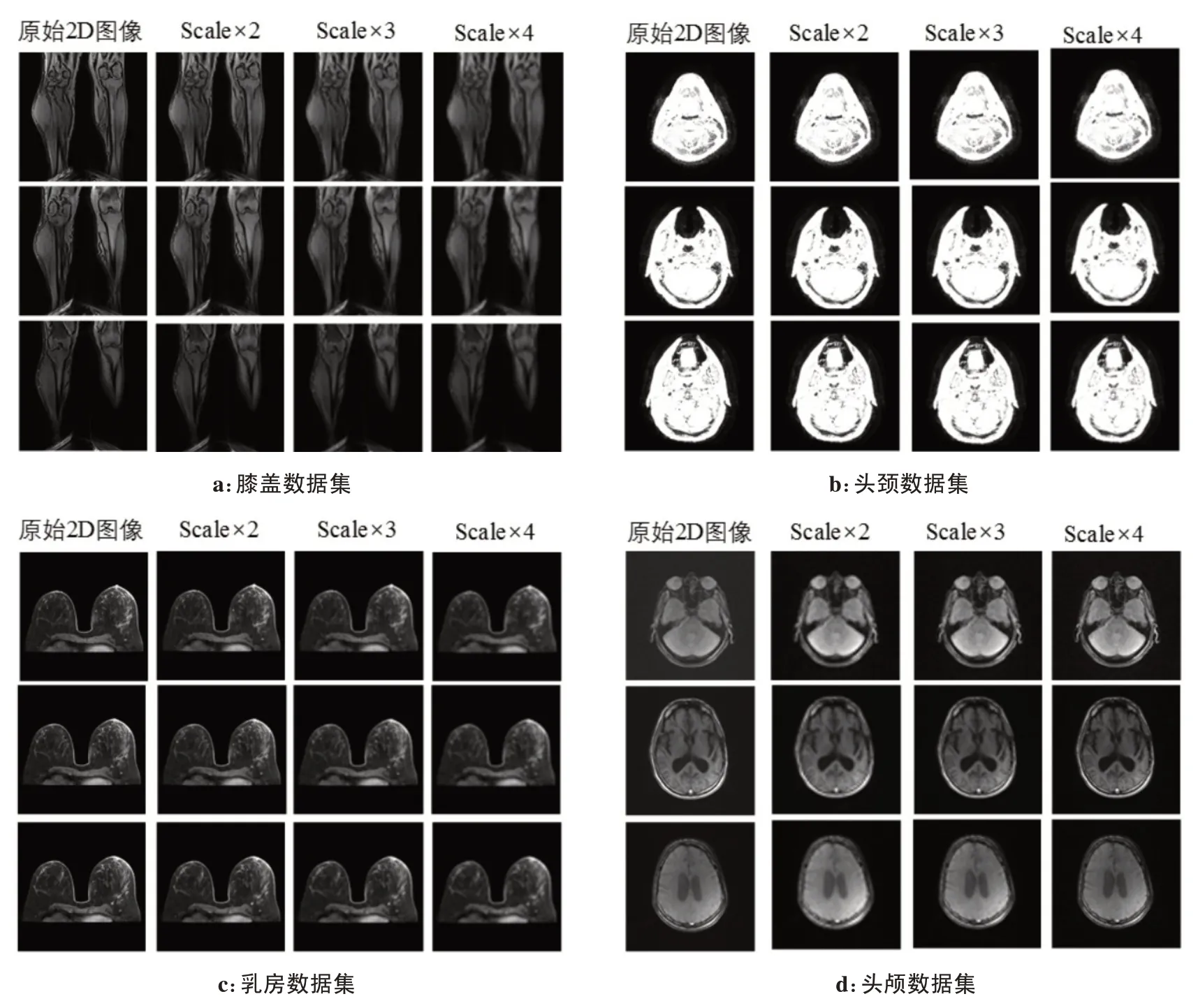

图1总结了本文建立的MR 图像数据,本文在开源的网站上对头颈、乳房、骨骼、头颅4个人体部位的MR 图像数据进行收集,并采用双三次方降采样方法构建了×2、×3、×4 尺度的高低分辨率MR 图像对,并且按照7:2:1划分了训练集、验证集以及测试集[19-20]。

2.1 原始数据收集及质量评估

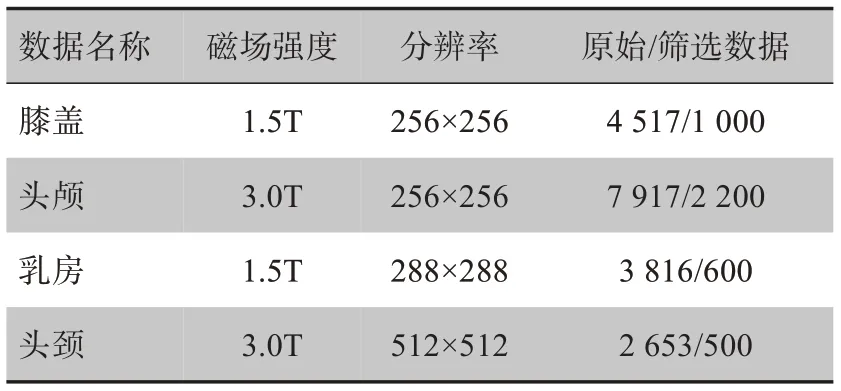

本文的数据来源于开源的MR 图像数据,主要包括NYU fastMRI Dataset、IXI Dataset、TCIA MRI Dataset 以及mridata.org 等。由于不同数据集包括的部位不同,并且部分数据仅包含一个人体部位。如NYU fastMRI Dataset包含头颅和膝盖,IXI Dataset仅包含头颅,而TCIA MRI Dataset包含乳房、头颅、头颈以及膀胱等。因此,本数据集主要以TCIA 中下载的MRI 图像数据为主,其中头颅数据还来源于NYU fastMRI Dataset 和IXI Dataset;膝盖部位来源于mridata.org 和NYU fastMRI Dataset。MR图像数据以DICOM 格式进行存储,DICOM 格式是医学图像的国际标准。通过Python 的第三方库pydicom 对获取的原始MR 数据进行解析,获取到各个器官的MR图像。各个部位的MR 图像信息如表2所示。为了减少由于图像的信噪比、对比度、运动伪影和化学伪影而造成的影响,另外考虑MRI 设备所承担的成本,本文收集采用主流的磁场强度;由于本文获取不同部位的数据过程中,根据医用靶器官不同的成像标准,分别获取不同分辨率的原始图像。

2.2 数据质量评估

如表2所示,本文获取了大量的原始MR 图像数据,但并不是所有的数据都适合应用于MR图像超分辨,质量不合格的数据反而会降低图像超分辨的效果。因此,本文对各器官数据进行了质量评估,将不符合要求的数据剔除。本文通过人工和机器两种方法对MR图像进行了筛选。

首先,本文根据专业医生的建议,对明显存在质量问题的MR图像数据进行人工剔除。其次,训练样本越多相对来说得到的先验知识更丰富,训练出的深度学习网络能够使得重建的图像更接近实际的图像,但是样本的丰富不一定能够保证是有效的训练样本,质量较差的样本不仅无法提高图像重建质量,有可能还会拉低了超分辨重建的PSNR 值。本文采用基于灰色一致性和梯度联合的方法对MR 图像的质量进行评估[21]。灰度的空间分布是针对图像所特有的,灰度的空间分布状况可以用于描述图像的相关性和对称性等,具体可以反映灰度分布是集中还是分散的,灰度一致性怎样,是否存在重复性,对称性怎么样等信息,而梯度方法可以体现局部信息的复杂性,详细信息描述如下:

图1 含有3种不同的MR图像高低分辨率对Fig.1 Containing three different pairs of high and low resolution MR images

表2 原始MR数据的整理Tab.2 Collation of original MR data

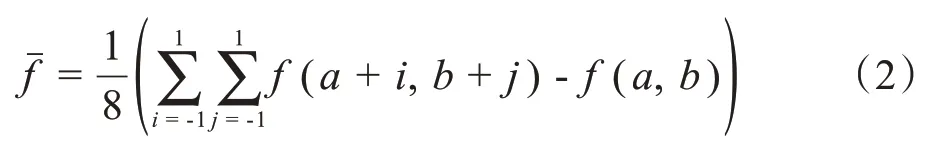

其中,f(a,b)是图像(a,b)位置的像素值,fˉ是其中心8 个像素的平均值。灰度一致性表示每个像素的差异和像素灰度值的累计。

经过筛选后的MR 图像数量如表2所示。可以看出经过人工、灰色一致性和梯度联合的筛选方法,图像数量下降较多。但是仍然具备大规模特性,并且数据质量提升,更有助于深度学习网络的训练性能提升。在本文构建公开的MR 数据集中不仅包含原始MR 数据,同时包含经过本文筛选后的高质量MRI数据。

2.3 高低分辨率图像对生成

各类深度学习网络都需基于先验知识,而针对先验知识,则是需要高低分辨率对,对于高低分辨率图像对的生成。本文直接使用与NI图像相同的降采样方法-基于双三次方的降采样方式,对原始图像对进行下采样[22]。基于三次方插值的下采样首先是需要构造BiCubic函数,其表达式为:

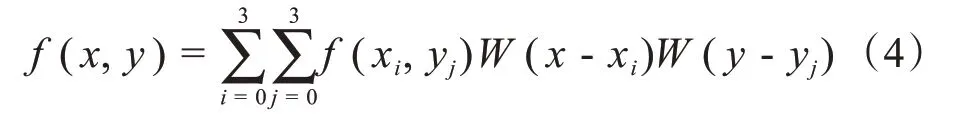

第二,对待插值图像点(x,y),取附近的4×4领域(xi,yj),i= 0,1,2,3。按如下公式进行插值:

第三,将上采样得到的图像通过下采样的方式对其处理,得到对应的降采样后为:

其中,g(x,y)为降采样获取的LR 图像。而HR 为原始图像。

在基于双三次方插值的下采样中,本文采用不同的低分辨率图像的生成方法,分别为:

(1)直接下采样方法:直接下采样方法就是将原始图像进行下采样,在此过程中不需要添加任何噪声,保证图像的原本质量。

其中,↓s为对应分辨率变化尺寸,本文分别设置×2、×3、×4这3种尺寸,从而验证各类算法在不同尺寸上面的适应程度。LRs表示对应尺寸的低分辨率图像。

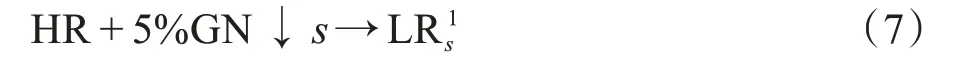

(2)基于HR高斯噪声的下采样:基于HR加5%高斯噪声的下采样方法就是将原始图像加入5%的高斯噪声[23],为了减少采集原始图像的误差,加入噪声后的原始图像通过下采样的方法获取到低分辨率图像。

其中,5%GN 代表5%的高斯噪声。LR1s为此类方法对应s尺寸的低分辨率图像。

(3)基于LR 高斯噪声的下采样:基于LR 加噪声的下采样方法就是将不加噪声的原始图像,下采样后所得的LR 图像加入5%的高斯噪声,为了减少所利用的LR 图像的真实误差,加入噪声后的原始图像通过下采样的方法获取到低分辨率图像之后,对LR图像加入误差。

其中,5%GN代表5%的高斯噪声。LRs+5%GN代表此类方法对应s尺寸的低分率图像。

本文采用基于三次方插值的原始图像直接下采样的方法,生成MR-SR高低分辨率对,作为深度学习网络的输入。本文主要利用双三次方降采样实现HR->LR过程。数据集的降采样的尺度分别为×2、×3、×4。针对适应于MR-SR 数据集,作为训练和测试的统计进行详细列举,如表3所示。

表3 高低分辨率对生成的PSNR(dB)Tab.3 PSNR generated by high and low resolution pairs(dB)

2.4 数据集性能

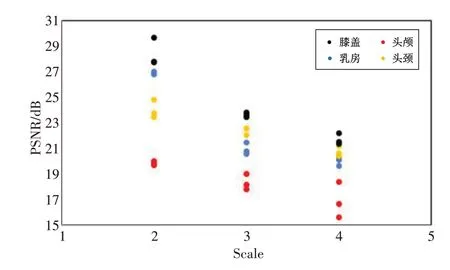

临床医学过程中,各器官内的组织液与自由水的比重和MR 成像过程中设备条件不同,MR 图像进行超分辨操作过程中也会出现不同的结果。MR-SR数据集性能主要体现在对不同器官进行SR操作过程中的难易程度分析,首先,各器官的HR 经过降采样成LR,LR经过双三次方插值生成MiddleR,求取器官的MiddleR与HR图像进行计算PSNR和SSIM。

根据对图像进行双三次方插值不可逆的原理,若计算出图像评估结果越小,则验证该器官恢复越困难,间接说明该器官超分辨越困难。本文可以从图2中看出,头颅部位进行重建过程中,其对应的PSNR值最小,说明该部位超分辨重建相比其他部位要困难。

图2 不同部位的3类方法的PSNR值Fig.2 PSNR of three types of methods in different parts

临床医学上不同部位的SR 难易程度不同,使得不可能应用一个深度学习模型解决所有部位的超分辨,本文在第三章节中的网络结构分别采用了前馈式、反馈式、对抗式网络对各个部位进行超分辨率重建,获取深度网络在不同部位的超分辨的性能[24]。

本文以上述图像质量评价方法为基础,通过基于双三次方的方法降采样获取高低分辨率对,构建一个标准、完备的适用于MR 图像的超分辨数据集,并对各个部位的超分辨率重建难易程度做出分析。

3 实验结果与讨论

3.1 网络结构

本文分别采用了在NI-SR效果最好的5种网络应用于MR-SR 中,其中5 种网络包括:D-DBPN、RDN、SRFBN、SRGAN、EDSR,它们的结构图如图3所示。

3.1.1 D-DBPND-DBPN 结构如图3a 所示,可分为3部分:特征提取部分(initial feature extraction)、反射(projection)、重构(reconstruction)。令conv(f,n)表示卷积层,f表示滤波器尺寸,n为滤波器数量。

图3 深度网络的总体结构Fig.3 The overall structure of the deep network

针对Initial feature extraction:利用conv(3,n0)从输入构建最初的LR 特征图L0,然后conv(1,nR)用来实现进入反射单元之前的从n0到nR的维度缩减。n0是最初LR 特征提取阶段滤波器使用的数量。nR是在每个反射单元用到的滤波器数量。

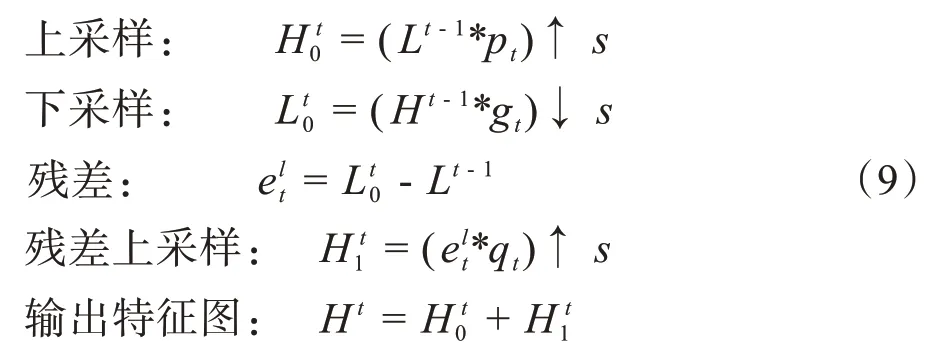

对于Back-projection stages:本文可以从图3a 看出,DBPN 结构的主要组成就是反射单元projection unit,作为训练SR 系统的一部分,映射LR 特征到HR特征,或者映射HR 特征到LR 特征两种相反的映射关系。其中两种映射关系分别为:

其中,*代表空间卷积操作,而↑s和↓s分别为尺度因子为s的上-下采样operator。pt、gt、qt为阶段t的(反)卷积层。而down-projection与之类似,只不过是任务为映射HR 的特征图H t到LR 的特征图Lt。Isr=fRec([H1,H2,…,Ht]),fRec使用conv(3,3)作为重构,[H1,H2,…,Ht]为每个反射单元产生的特征图的连结。

3.1.2 RDN本文可以从图3b 中看出该网络主要包含 4个模块:Shallow Feature Extraction Net(SFENet)、Redidual Dense Blocks(RDBs)、Dense Feature Fusion(DFF)、Up-Sampling Net(UPNet)。对于SFENet 模块,它主要表示前2 个卷积层。对于RDBs 模块,主要将残差模块residual block 和dense block 模块进行整合,将两者集合起来,形成residual dense block。该模块有助于更大增快模型训练速度。对于DFF 模块,该模块包含Global feature fusion 和Global residual learning 两部分。对于DFF 模块,该模块表示网络最后的上采样+卷积操作。实现了输入图片的放大操作。

3.1.3 SRFBN本文可以从图3c 中看出该网络主要是基于DRCN 大框架的一个反馈机制的改进,相当于把DRCN 中的权重共享层成了权重共享模块,并加入了skip connection。主要由3 部分组成:特征提取、权重共享模块、学习策略。(1)特征提取:该网络主要针对浅层特征提取,即浅层特征提取为=fLRFB;(2)权重共享模块:第t个权重共享模块的输出应为:,而对应中间监督输出:,其中,;(3)学习策略:该模型采用的学习监督函数如下:

中间监督的真值会根据任务难度进行选择,比如单一的bicubic 降采样退化,所有的真值都是一样的。而对于BD(bicubic+blur)退化,前两个中间监督输出用带高斯模糊的真值,之后的中间监督则采用不带高斯模糊的真值。

3.1.4 EDSR可以从图3e 看出,它与SRResnet 相似,但结构上缺少了relu 层和batchnorm 层,主要由于批归一化层对功能进行了归一化,因此通过对功能进行归一化,可以摆脱网络的范围灵活性。由于该方法采用的结构过深,训练过程容易引起数值的不稳定性,为了解决这个问题,该模型采用了redisual scaling 的方式进行处理,即在残差模块的最后一个卷积层的输出上乘以一个系数0.1。

3.1.5 SRGANSRGAN 主要是在SRResnet的基础上加了一个鉴别器,它的作用是额外增加一个具有鉴别的器网络和2 个损失(g_loss 和d_loss),用一种交替训练的方式训练两个网络。该模型主要包括:生成器、判别器、loss函数3部分。

生成器是在生成网络(SRResNet)部分包含多个残差块,每个残差块中包含两个3×3 的卷积层,卷积层后项BN 和PReLU 作为激活函数,两个2×亚像素卷积层(sub-pixel convolution layers)被用来增大MR数据集中的特征尺寸。

判别器则是在判别网络部分包含8个卷积层,随着网络层数加深,特征个数不断增加,特征尺寸不断减小,选取LeakyReLU 作为激活函数,最终通过两个全连接层和最终的sigmoid 激活函数得到预测为MR图像的概率。

SRGAN 中Loss 函数相比其他网络较为特殊,它采用两种损失函数Gloss和Dloss分别表示为:

从上式看出为内容loss,10-3为对抗loss。内容loss 包括了mseloss 和vggloss。两者的loss 分别为:

3.1.6 ESRGAN

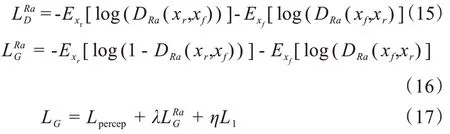

它与SRGAN 结构相似,只是在SRGAN 基础上对抗损失,感知损失,其中的每一个进行了改进,得到了一个增强的SRGAN(ESRGAN)[25]。该网络提出了RRDB(Residual in Residual Dense Block)结构。图4左侧为SRGAN 中常用的基本结构,右侧为本文使用的RRDB 结构块。该改进模型选用了一种基于相对鉴别器(Relativistic Discriminator)的改进网络。和传统SRGAN 中的鉴别器D不同的是,原本鉴别器仅针对输入图判断其是否是真实且自然,而相对判别器则是尝试去预测真实图像相对虚拟生成结果,其结果相对真实的概率。具体生成器损失函数LRaD、鉴失函数LRaG、总损失别器的损函数LG分别为:

3.2 实验设置

训练过程中采用的硬件配置为:Core i9-9900K处理器和双路交过的1080ti显卡,32 G内存。软件配置为:采用pytorch 框架进行超分辨网络训练。本文对7 类网络的参数进行设置,分别迭代200 轮。设置学习速率为0.01,其网络参数设置如表4所示。

图4 RRDB模块结构Fig.4 Structure of RRDB modul

表4 各个网络的参数设置Tab.4 Parameter settings of each networks

3.3 指标评价

本文采用峰值信噪比和结构相似度两个指标综合衡量MR图像超分辨重建的效果。

(1)峰值信噪比:该评价标准最为常用,峰值信噪比值越高,表示重构的图像质量好,其计算公式如下:

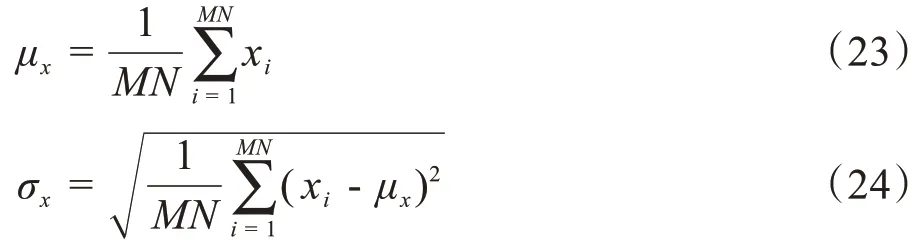

其中,X表示原始图像,Y表示重构图像,M和N分别表示图像高和宽,L表示灰度级别中最大的灰度值,这里L= 255。

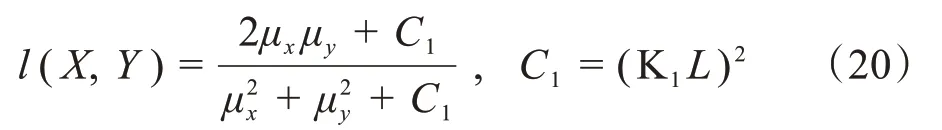

(2)结构相似性度量:该评价表示重构图像Y和原始图像X之间的结构相似程度,其值越大,表明重构图像与原始图像越相似,则重建效果越好,其计算公式为:

其中,l(X,Y)表示亮度对比算子,c(X,Y)表示对比度对比算子,s(X,Y)表示结构对比度算子,且α、β、γ>0用来调节3种算子权重,其计算公式分别如下:

亮度对比算子:

对比度对比算子:

结构对比算子:

其中,μ代表图像均值,即图像平均亮度;σ代表信号标准差,估计信号的对比度;C表示克服零值的规范化因子,K 是常量,L表示像素的动态范围,其均值μ和方差σ计算公式为:

3.4 实验结果及分析

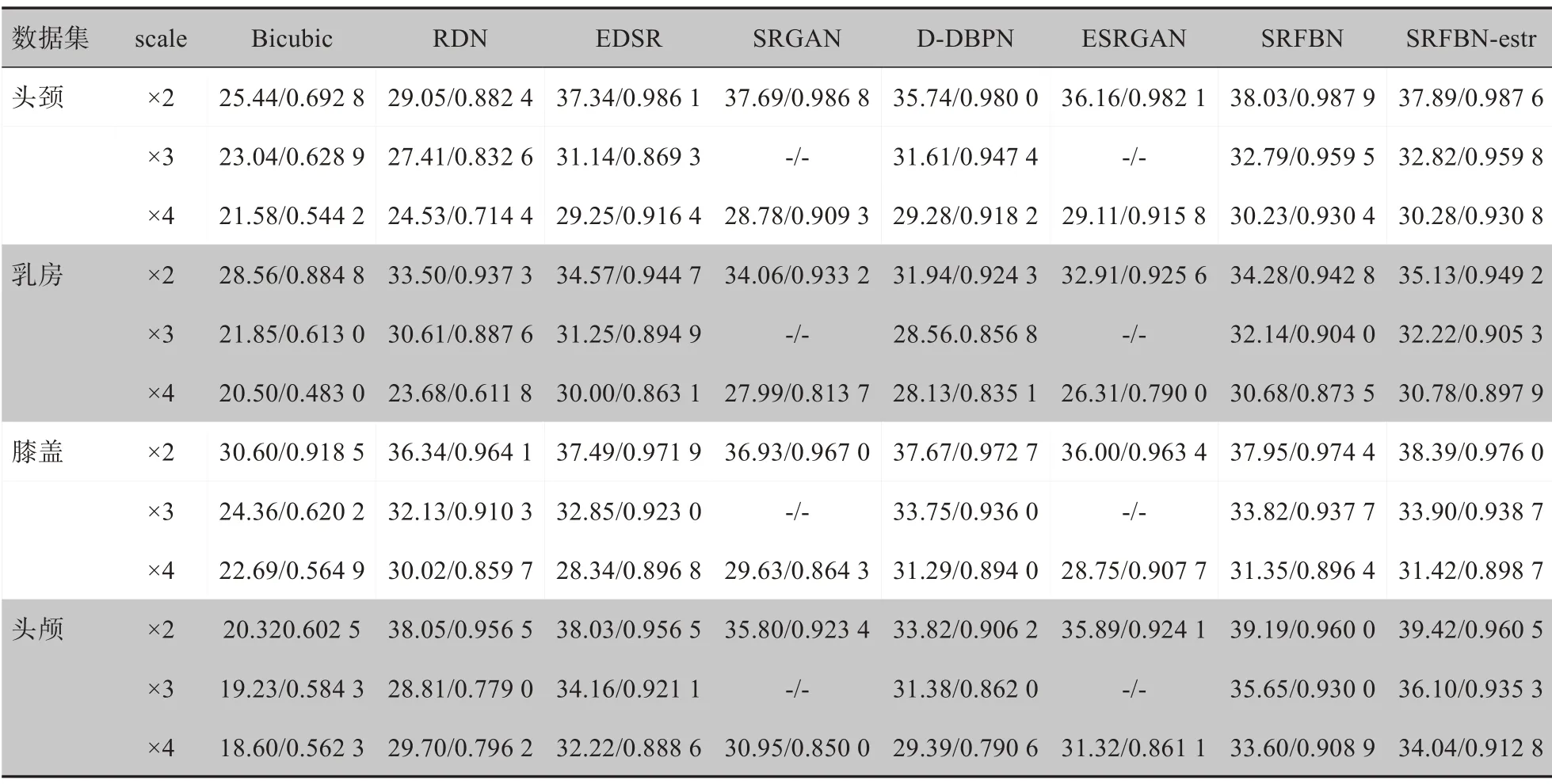

3.4.1 深度网络超分辨网络在MR数据集上的表现经过各个深度网络模型的训练,各个模型在本文的MR数据集中得出结果具有明显的体现。从图5和表5可以看出,ESRGAN 算法从视觉上的纹理更加丰富。SRFBN 算法的PSNR 指标和SSIM 指标相对其他算法的指标更加突出。本文可以得出这样的结论:首先,针对同一个网络,不同的器官部位的SR 效果明显不同,这主要是由于各个器官的原始分辨率,采集过程中的磁场强度,以及该器官自由水和结合水的比重等多原因引起。其次,本文可以针对不同部位,定制化设计出一种专门适应于此器官的网络。表5中虽然RDN 网络在头颈、乳房、膝盖等器官中表现并不突出,但该网络明显在头颅中的PSNR/SSIM为38.05/0.9565,较其他网络更好,这说明不同靶器官可以定制化设计超分辨率网络。

图5 scale=4的各MRI数据不同超分辨深度网络的HR对比Fig.5 HR comparison of different super-resolution deep networks of each MRI data with scale=4

表5 MRI数据集在不同网络上的PSNR/SSIMTab.5 PSNR/SSIM of MRI data sets on different networks

3.4.2 深度超分辨网络在NI 图像数据集和MR 数据集上结果对比分析深度网络可以从不同的数据集转移到其他数据集,在NI 数据集的效果与MR 数据集的PSNR 和SSIM 指标相差并不是太多。从表5和表6可以看出,在SRFBN 网络中,两者结果基本相近。从图5看出,该算法所呈现的PSNR 指标序列图中,Manga109(NI)数据集和头颅(MRI)数据集在SRFBN 算法上基本相近,深度网络在MR 超分辨率中是有意义的。

从表5和表6可以看出,传统的Bicubic算法和深度网络之间的PSNR/SSIM 指标差异特别大,基本为3.61~12.59/0.189 6~0.295 1 之间,这也说明深度网络不管在NI-SR 还是MR-SR 上面,都具有更优的图像超分辨重建效果。通过实验可以看出直接套用深度学习网络可以取得一定的效果,说明深度网络在MR图像超分辨具有一定作用,并且比传统方法效果好,但是相比于自然图像超分辨的效果还是有些差距,主要在于自然图像和MR图像成像机制不同,因此还需结合不同人体部位MR图像特性,设计更加有针对性的MR图像深度超分辨网络。

表6 NI数据集在不同网络上的PSNR/SSIMTab.6 PSNR/SSIM of NI data sets on different networks

4 结论

本文提出并构建一个大规模的用于MR 图像超分辨的数据集,涵盖了头颅、膝盖、乳房以及头颈4个部位。本文通过数据质量筛选和不同低分辨率图像生成方式,形成3 种不同形式高低分辨率对MR 图像数据集,同时给出不同部位超分辨难易程度分析。本文还将7种超分辨深度学习网络在数据集上验证,不仅证明了数据集的性能,同时也表明深度学习网络在MR 图像超分辨性能优异。本研究希望可以对深度学习网络在MR超分辨上的应用提供数据支撑,同时对未来MR图像超分辨研究有所启发。