无人驾驶汽车环境感知与定位技术

2021-01-16徐文轩李伟

徐文轩 李伟

摘要:环境感知与定位技术是无人驾驶汽车技术的关键组成部分。在概括介绍无人驾驶汽车系统总体架构基础上,首先介绍各类环境感知传感器的原理和特点,比较各技术优缺点。然后阐述了传感器的标定方法,并综合论述了车道线检测、障碍物检测、红绿灯检测等环境感知中的关键技术;同时,从高精度地图环境定位、汽车自身定位、多传感器融合定位以及无线通信辅助定位等方面,对汽车定位技术进行了分析。最后,剖析了无人驾驶汽车环境感知与定位技术的难点,并展望了未来研究的发展趋势。

关键词:无人驾驶;环境感知;定位;难点;发展趋势

中图分类号:TP242.6 文献标识码:A 文章编号:1005-2550( 2021) 06-0053-08 Environment Perception And Location Technology Of Driverless

Vehicles

XU Wen-xuan l, LI Wei 2

(1. College of Electrical Engineering, Chongqing University, Chongqing 400000, China;

2. College of information science and Engineering Chongqingjiaotong University,

Chongqing 400074, China)

Abstract: Environment perception and location technology is the key component ofdriverless vehicles. Based on the overall architecture of the driverless vehicle system, thispaper first introduces the principles and characteristics of various environmental sensors, andcompares the advantages and disadvantages of each technology. Then, the calibration methodof the sensor is described, and the key technologies of environment perception, such as lanedetection, obstacle detection, traffic light detection, are comprehensively discussed; Besides,from the high-precision map environment positioning, vehicle positioning, multi-sensor fusionpositioning and wireless communication aided positioning, the vehicle positioning technology isanalyzed. Finally, this paper analyses the difficulties of environmental perception and locationtechnology for driverless vehicles, and forecasts the development trend of future research.

Key Words: Driverless Vehicles; Environmental Perception; Location; Difficulties; DevelopmentTrend

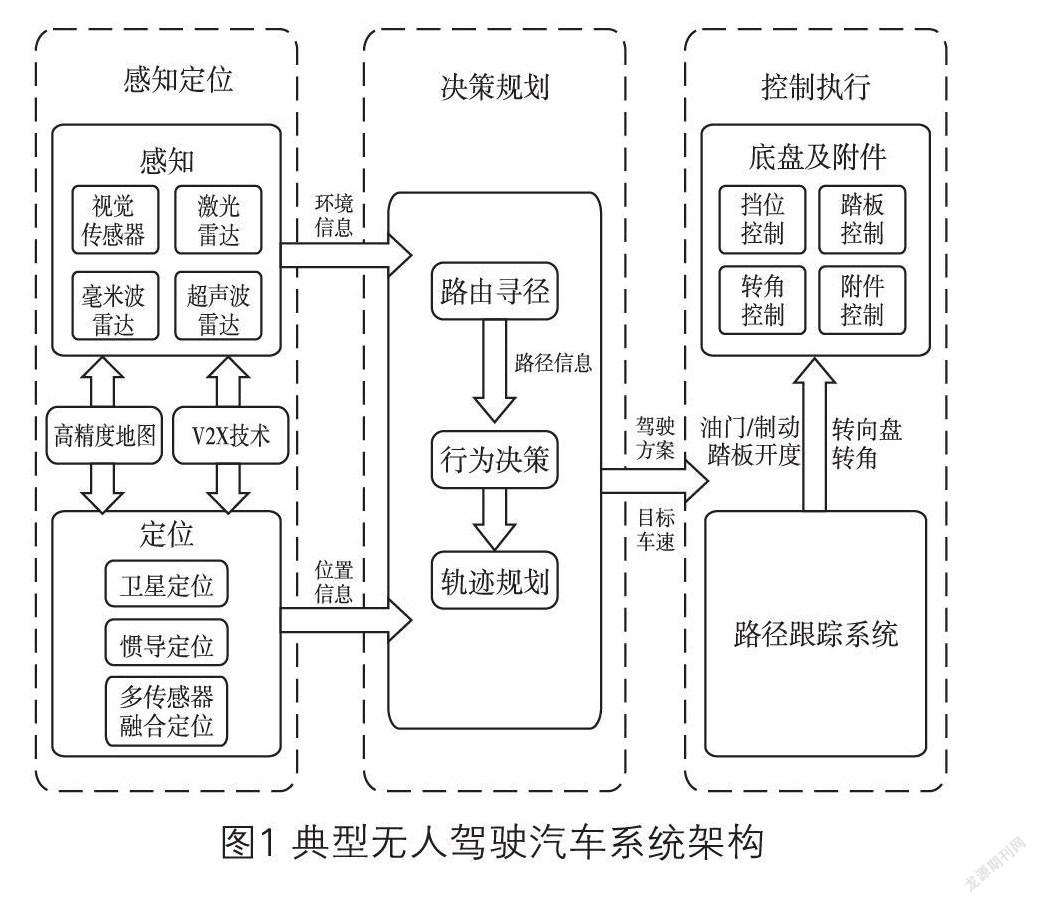

1 無人驾驶汽车系统架构

无人驾驶是一个软硬件结合的复杂系统,主要分为感知定位、决策规划、控制执行三大技术模块。感知模块主要通过摄像头、雷达等传感器探测周围环境,定位模块主要包括卫星定位、惯性导航定位和多传感器融合定位。同时,新兴的高精度地图技术和V2X协同技术都为无人驾驶汽车的环境感知和定位提供了较大的帮助。规划模块利用传感器探测的环境信息和定位系统获得的位置信息进行路由寻径,规划一条最适合的道路,以实现从起始地到目的地。决策模块会接收路由寻径产生的寻径结果并决定无人汽车该如何驾驶,包括如何正常跟车、当遇到交通标志时怎么处理,遇到行人时如何避让等。决策规划是对外在的道路进行判断,而车内的具体操作将由控制执行模块来实现。下图1是一个典型无人驾驶汽车系统的架构图,对三大技术模块进行了详细描述。

2 无人驾驶汽车环境感知

2.1 环境感知传感器技术

无人驾驶汽车环境感知采用的传感器主要有

徐文轩

重庆大学电气工程学院,本科学历,主要研究方向为无人驾驶汽车、自动控制技术。车载摄像头、激光雷达、毫米波雷达和超声波雷达几种类型[1],分别如下图2所示。表1从各个传感器的实现原理、优缺点等方面进行了技术比较。

2.2 环境感知关键技术

2.2.1 传感器标定

传感器标定是无人驾驶汽车环境感知的必要环节,也是多传感器数据源融合的关键前提。其目的是进行各种传感器坐标之间的转换,将两个或多个传感器变换到统一的时间和空间坐标系,从而实现多传感器的融合。

1)摄像头的标定

车载摄像头以一定的角度和位置安装在车辆上,为了找到车载摄像头所生成的图像像素坐标系的点坐标与摄像机环境坐标系中的物点坐标之间的转换关系,需要进行摄像头标定,从而实现把摄像机采集到的环境数据与车辆行驶环境中的真实物体相对应[3]。

车载摄像头标定分为单目摄像头和双目摄像头的标定两大类。单目摄像头的标定称为内参数标定,其本质是建立图像坐标系中的坐标与物体在环境坐标系中的坐标之间的关系。在无人驾驶汽车中,采用双目摄像头可以减少感知盲区,对其标定称为外参数标定,即两个摄像头之间需要确定它们之间的相对位置关系。

2)激光雷达的标定

与摄像头标定类似,激光雷达在使用前也要对其内外参数进行标定。内参标定是指其内部发射器坐标系与雷达坐标系两者间的转换关系,在出厂前已经完成,可直接使用。无人驾驶汽车需要进行的是外参数标定,即建立起激光雷达自身坐标系与车体坐标系之间的关系点[4]。

3)摄像头与激光雷达的联合标定

摄像头与激光雷达的联合标定,是指通过提取标定物在单线激光雷达和图像上的对应点,完成单线激光雷达坐标、摄像机坐标、图像像素坐标等多个传感器坐标的统一,从而实现激光雷达与摄像机的空间校准[5]。摄像头与激光雷达的联合标定问题是当前学术界研究的热点。

2.2.2 环境感知与识别

环境感知的对象包括行驶路径、周边物体、驾驶环境和驾驶状态。行驶路径包含车道线、道路边缘等,周边物体包含了汽车周围的行人、车辆以及其它可能阻碍车辆的障碍物。以下主要从车道线检测、障碍物检测、红绿灯的检测等角度,简述无人驾驶汽车的环境感知方式[6]。

1)车道线检测

车道线检测能快速、准确地检测出车道线,帮助车辆进行路径规划和偏移预警。目前较为常见的检测方案是基于传统计算机视觉的检测,近年来也兴起了基于深度学习的车道线检测和基于激光雷达等高精度设备的检测方式。

传统计算机视觉的车道线检测:传统的检测方法是利用车道线颜色的不同来进行判断。在路面与车道线的交汇处颜色变化较剧烈,可以利用边缘增强算子突出图像的局部边缘。但这种方法仅适用于道路平整、车道线清晰的情况,当光照较强、车道线较为模糊时,检测效果会大打折扣。

基于深度学习的车道线检测:传统的车道线检测需要人工对道路场景进行特征提取和模型建立。而基于深度学习的检测方法可以把车道线检测看作分割或分类问题,利用神经网络去代替传统视觉中的手动调节滤波算子。

激光雷达融合的车道线检测:激光雷达照射到不同介质上时,其反射波强度也不同。因此可以通过扫描得到点云,通过对比反射强度值来区分出道路和车道线,但这种方法成本较高,较难得到推广。

2)障碍物检测

基于图像的障碍物检测:该方法是将得到的图像进行预处理,然后提取特征,如颜色、纹理、边缘形状等,并与已有的障碍物特征进行对比,从而识别出障碍物。

激光雷达的障碍物检测:激光雷达测距是通过激光发射器发射激光,遇到障碍物后,激光经过漫反射返回部分能量,再分别进入激光接收机,最后进入信号处理系统进行数据处理。目前基于几何特征的聚类算法较为常见,通过将数据与障碍物的几何特征进行对比,可实现对障碍物的检测和分类。

视觉和激光雷达融合的障碍物检测:激光雷达和摄像头各有优劣,可将这两种方法融合使用,以获得更好的检测效果[7]。融合方法主要分为空间融合和时间融合两类。空间融合以前向视觉系统为主,将激光雷达坐标系下的测量值转换到摄像机对应的像素坐标系下,即可实现多传感器的空间同步;同理,时间融合需要将两者的采样时刻调整一致,即完成共同采样一帧雷达与视觉融合的数据,保证了雷达数据与摄像机数据时间上的同步。

3)红绿灯检测

红绿灯检测就是获取红绿灯在图像中的坐标及其类别。不同的检测结果意味着不同的决策,红绿灯的检测状态,决定着无人驾驶汽车的安全。

传统计算机视觉的红绿灯检测:传统的检测步骤是将图像从RGB转换为CIE Lab颜色域,增强红绿差距,通过候选区域检测和候选区域验证后做出判断。该方法检测速度快,在一些简单场景中取得了较好效果。

基于深度学习的红绿灯检测:深度神经网络在目标检测方面都是采用了金字塔结构,如FastRCNN、Faster RCNN,都是在最后一层卷积层进行检测。该方法由于采用深度学习技术,对于较小目标的检测效果比传统方法更好。

与高精度地图相结合:以上两种算法只能获取红绿灯在图像中的位置,而要获得它的世界坐标则需要结合高精度地图。有了高精度地图,无人驾驶汽车就可以预知红绿灯出现的位置,而不是等待图像的识别。当无人驾驶汽车由于遮挡或算法错误而无法检测红绿灯时,高精度地图就能告知红绿灯的相关信息,从而保证行车安全。

4)基于V2X的道路环境感知技术

V2X( Vehicle-to-Everything)是将车辆与其它事物相连接的新一代通信技术。V代表车辆,X代表其它与车进行信息交互的对象,可以是车、人、道路设施等等。V2X构建了一个智慧的交通体系,促進了汽车和交通服务的新模式发展,对提高交通效率起到了重要的作用。车路协同系统基于无线通信、传感器等技术获取车辆和道路信息,通过V2X实现信息交互和共享,从而实现了优化道路资源、提高交通安全、缓解拥堵等目标。这也是欧、美等交通发达国家和地区的研究热点。

3 无人驾驶汽车定位技术

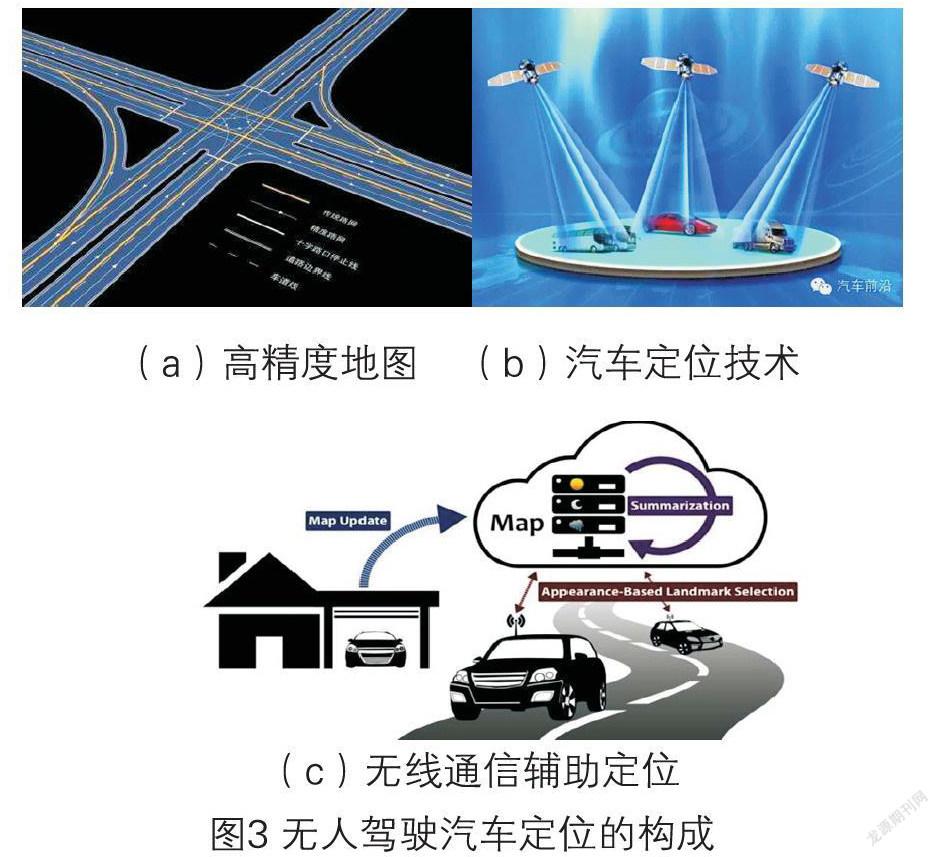

对无人驾驶汽车而言,准确可靠地掌握汽车位置和姿态等定位信息是实现无人驾驶汽车导航功能的前提和基础。无人驾驶汽车对定位技术的可靠性和安全性要求较高,对定位精度的要求达到厘米级。然而采用普通的导航地图、卫星定位很难满足其需求。因此新的定位技术,如高精度地图、多感知技术融合定位和无线通信辅助定位就成为无人驾驶汽车定位技术的发展趋势。

从无人驾驶汽车定位时间应用角度,可将定位分为基于高精度地图的环境定位、汽车定位技术和基于无线通信的辅助汽车定位三大方面[8]。

3.1 高精度地图

3.1.1 概念與作用

同普通导航地图相较,高精度地图的精度更高、数据维度更广。普通导航地图面向的是人类驾驶员,而高精度地图则是面向自动驾驶系统。因此它需要包含更多的数据,如车道线类型、宽度,护栏、标志牌、红绿灯等详细信息。此外,为保证自动驾驶的安全性,对于其静态地图数据要求周级或天级更新。而对于动态数据,如路况和交通事件等信息要求实时更新。对于无人驾驶汽车而言,高精度地图主要起辅助作用。其辅助功能体现在:一是当卫星定位不够精确时,可以利用高精度地图进行修正,用以提高定位精度;二是高精度地图的路径规划能力达到了车道级,它还可辅助无人驾驶汽车进行路径规划。

3.1.2 高精度地图关键技术

高精度地图关键技术主要涉及道路元素图像处理、激光点云处理、同步定位与地图构建,以及高精度地图云端服务体系等四个方面。

1)道路元素图像处理:高精度地图的制作需要对各种道路元素,诸如交通标志、红绿灯、车道线和隔离带等进行识别,并标注名称。在识别前,由于光线、雨水、车速等内外因素影响,图像可能会失真,因此要先进行降噪和增强预处理,以提高图片质量。然后需要提取这些道路元素的特征,再进行分类和标注。最后,便可将这些图片输入到深度学习的模型中进行训练和识别。

2)激光点云处理:激光雷达获取的原始数据以激光点云的形式进行存储;而所采集到的数据通常包含噪声,具有散乱、重复的特点。此时需要采用特征提取、配准以及分割等方法来处理点云。特征提取可提高数据的抗噪声能力;配准可以将多个角度采集到的同一个数据进行融合、消除误差并统一到同一坐标系下;点云分割可以将路灯、标志牌的点云从大量杂乱无序的激光点云中识别出来。

3)同步定位与地图构造:在卫星信号薄弱或丢失的情况下,可以依靠同步定位与地图构建技术( SIAM)进行高精度地图的构建以及无人驾驶汽车的定位。目前SLAM有两种形式,以激光雷达为主的激光SLAM和以摄像头为主的视觉SLAM。激光SLAM通过激光雷达获取汽车周围的点云数据,能精确地测出周围物体的角度和距离;视觉SLAM采集的图像信息要比激光雷达的信息更丰富,更利于后期的处理。

4)高精度地图云端服务体系:空中下载技术( OTA)能够实现高精度地图的云端更新。它通过收集终端采集的数据,包括汽车状态、道路情况、路面标注等数据加以处理并发布,从而提升高精度地图的准确度和鲜度。

3.1.3 高精度地图的解决方案

其解决方案主要包括高精度地图的采集、制作与编译、质量控制与发布等步骤。

目前高精度地图主要采用激光雷达、摄像头、IMU(惯性测量单元)、轮测距仪的组合进行数据采集。其中,激光雷达和摄像头用于获取采集车周围的环境数据,IMU和轮测距仪用于获取采集车的绝对位置;传感器所采集到的环境数据可分为激光点云和图像两大类。由于自动识别可能存在误差和错误,需要进一步实施车道线识别是否正确、标志牌以及红绿灯的逻辑是否合理等人工验证。最后还需要进行编译,即规定了对地图统一的表述;当上述理论操作执行完后,还需要设计高效的评估标注及测试标准来检验高精度地图的质量。

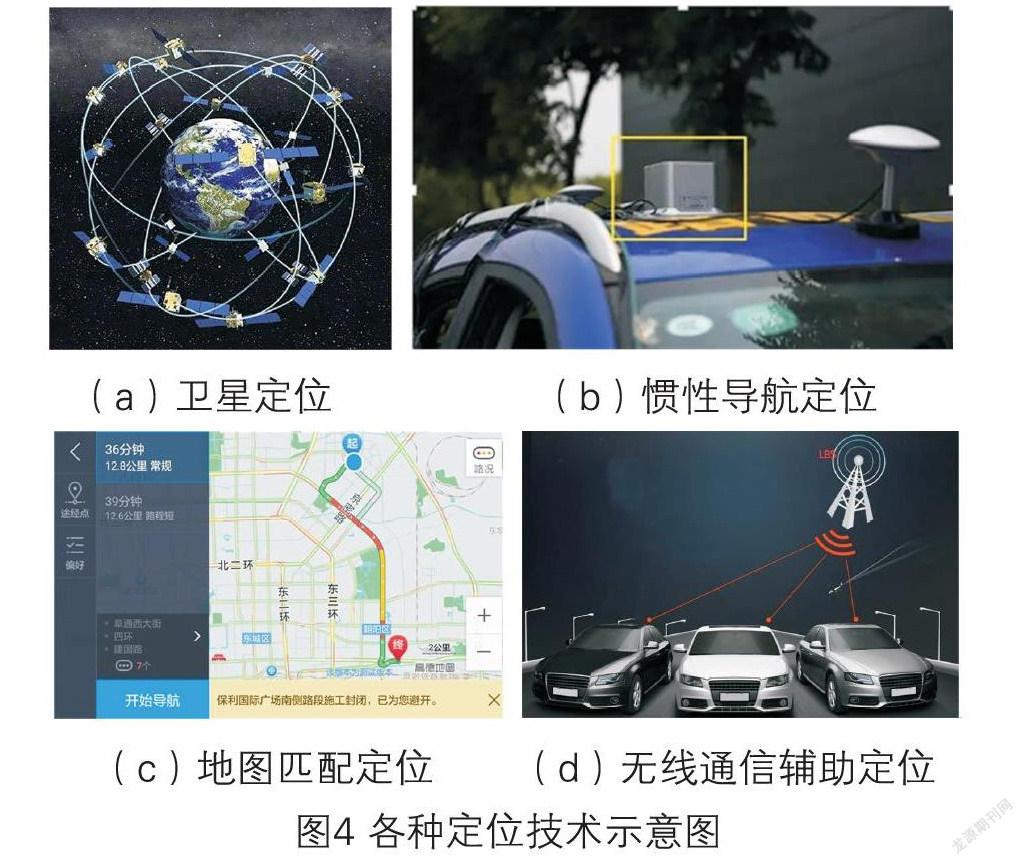

3.2 定位技术

定位技术是在汽车自动驾驶过程中确定其具体所在位置的一项重要技术。汽车定位主要包括卫星定位、惯性导航定位、地图匹配定位和多传感器融合定位等技术,分别见下图4。不同的定位方法获取汽车的位置信息方式有所不同,所涉及到的多种传感器类型及其相关技术,具体的功能、原理和分类对比如下表2所示:

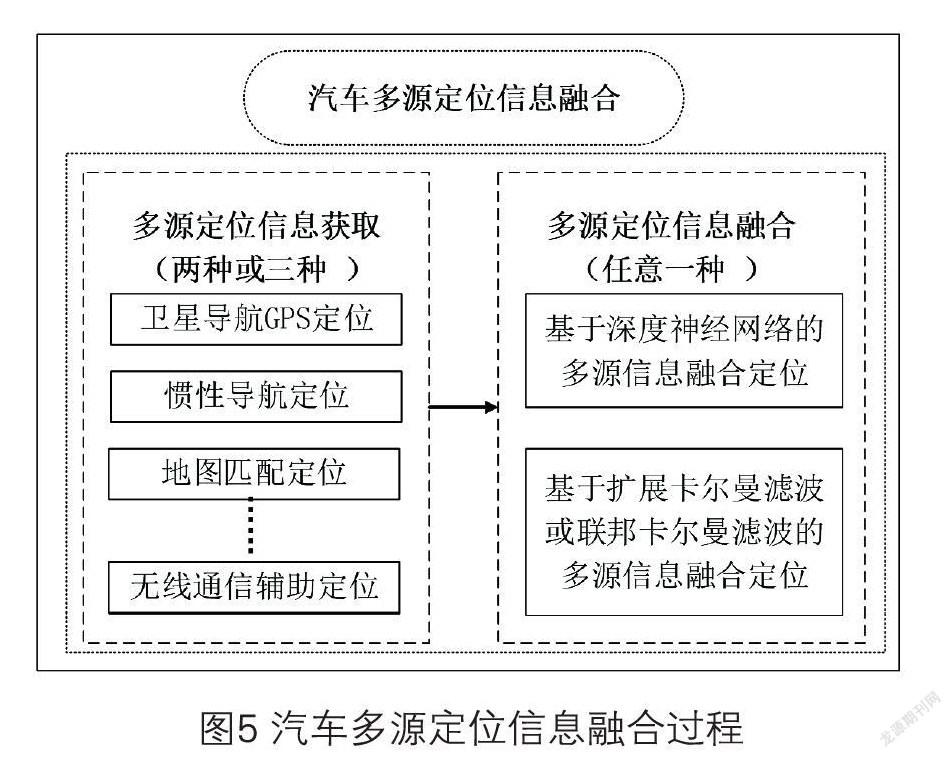

3.3 多传感器融合定位技术

汽车在实际行驶中,采用卫星定位和惯性导航定位都有各自的缺点。比如,卫星定位信号会因隧道、建筑群的遮挡而中断。而惯性导航定位虽然在短时间内可以提供连续的、精度较高的汽车位置、速度和航线信息,但其定位误差会随着时间的积累而持续增加。鉴于多种传感器技术各具有不同的优、劣势,尚不存在某单一传感器可以满足所有工况需求的方案。因此,可考虑将多传感器进行数据融合,这样就可大幅提高汽车定位精度。

目前,可以从卫星导航GPS定位,惯性导航定位,航位推算系统定位等方式中获取多源定位信息。再利用深度神经网络或扩展卡尔曼滤波等方式实现多源信息的融合定位。如下图5所示。

特别地,卫星定位与惯导融合的低成本、高精度、高可靠定位传感器是实现厘米级定位的重要手段。其中,基于差分GPS+惯性导航IMU的组合是最为常见的定位方法,其精度为米级。对于低精度的定位要求,差分GPS+惯性导航IMU可谓是一对黄金组合:在GPS信号良好时,GPS起主导作用。当GPS信号暂时中断(例如隧道环境),惯性导航则可在短时间依靠航位推算继续提供较高精度的定位。但是,对于自动驾驶车辆来说,这样的定位精度显然不够。于是在差分GPS+IMU的基础上,使用激光雷达或者双目视觉进行地图匹配,获取当前车辆在高精地图中的局部具体位置,此时定位精度则可达到更为精确的厘米级。

4 环境感知与定位技术难点与发展趋势

4.1 面临的问题

1)深度学习对无人驾驶环境的感知存在局限性。

深度学习是当前新兴起的人工智能技术之一,被认为是解决无人驾驶环境感知的一种有效方案。但它仍然面临着巨大的挑战,大量的问题亟待解决,现有的算法仍需提高。目前深度学习存在三大局限:一是需要海量样本数据,二是标准测试集外难以取得较好的效果,三是对数据微小变化过于敏感。后两点局限可以认为是第一点中样本“不够”导致的结果。在某些背景和主体相互关系比较稳定的场景,深度学习会有较好的效果,比如医疗影像,器官相对位置总是固定的。但交通场景却不符合这个条件,很难达到较好的效果。真实世界的图像都是组合的。对应现实场景,尤其是我国交通状况中路况较为复杂,吊车、摩托车,像乡村小路牲禽乱窜,卡车拉树等是我们生活中经常遇到的现象。这些样本永远都是不够的,现实交通场景中不同元素会出现无数种组合的可能。上述深度学习的三个局限究其根源,均是来源于它的关键能力缺失,即无法有效应对“组合爆炸”的问题。以上场景对机器视觉是一个难题,提高在复杂情况下的感知精度是对无人驾驶汽车研究的挑战。

同時,虽然基于深度卷积神经网络的机器视觉技术在无人驾驶汽车任务中取得了巨大的成功,但对视频的分析能力却相对薄弱。因为无人驾驶汽车面对的通常是视频流,而不是单个的静态图像。分析视频的深度学习算法,通常是从图像领域直接迁移过来的,缺乏时序性的有效描述,还未能形成独立的科学问题。

2)环境感知能力直接决定无人驾驶汽车智能化的水平。

目前的传感器技术及布置方案可以保证在特定工况下实现有效的感知,但是对于复杂交通环境以及雨雪极端天气、光照、噪声强干扰环境,感知与信息融合的准确性难以得到有效保证,其鲁棒性有待加强;与此同时,涉及到汽车安全方面的控制系统,需要感知系统提供快速更新的感知融合信息,先进信息融合算法的快速实现仍然是亟待解决的问题。

3)当汽车在高速行驶、密集场景和立交桥高低位置时,无人驾驶定位技术存在着需要解决的难题。

首先,室外告诉行驶的车辆可依靠GPS或北斗定位,移动站通过对所采集到的卫星数据和接收到的数据链进行实时载波相位差分处理,其历时不到一秒,得出厘米级的定位结果。车辆速度达到120km/h后,每秒移动33米,加之CPS的数据传输时延较高,需要车载专用短程通信以及V2X等技术车路协同,这才能支持无人驾驶的安全需要。

其次,对于大型地下停车场等车辆聚集密集场景,众多车辆进出停车场,需要对所有车辆实时定位和路径规划调度导航,才能保证有序。此时没有GPS或北斗信号,WIFI/BLE等定位技术适合寻车等简单业务,传统UWB定位系统无法适应大量车辆的定位精度及服务器位置信息处理导致的时延,因此无人驾驶依然有较大的缺陷与隐患。

最后,对于立交桥、涵洞、隧道等场景,由于无法收到GPS或北斗信号,且在某些场景下,如立交桥需要定位区分上下层,现有技术难以满足这样的精度需求,无法对车辆定位,需要其它方式的定位手段,尤其是需要无盲区定位,以确保车辆平滑稳定的自动行驶。

4.2 展望

1)“几何深度学习”的出现为汽车无人驾驶环境感知提供了更为广阔的前景。

随着深度学习的发展,人们并不仅满足于深度学习应用于传统的图像处理,而是更进一步地对空间点云、曲面和网络等几何对象应用深度学习算法,将这一领域称为“几何深度学习”。研究者在不规则的非欧氏数据集上对卷积神经网络模型进行扩展,这便有了图卷积神经网络、PointNet等新技术的出现。这些新技术的出现拓展了神经网络在智能驾驶感知环境中的应用。

2)视觉识别和激光雷达将逐渐成为感知技术的核心。

在实际驾驶过程中,驾驶员获取的绝大部分信息来自于视觉。摄像头拥有十分丰富的线性密度,其数据量远超其他类型的传感器。基于图像信息密度最高的优势,使得视频视觉识别处于整个感知融合的中心地位。而摄像头需要识别和估算的目标复杂繁多,这使得基于目标监测与识别的学习算法的优化研究成为必然趋势。另外,激光雷达相对于毫米波雷达等其他传感器具有识别效果好、分辨率高等优势,已逐步发展成为主流的自动驾驶汽车用传感器。目前,激光雷达正在向着小型化、低成本的固态扫描或机械固态混合扫描形式发展。

3)基于多传感器信息融合的环境感知技术可以发挥各传感器的优势,使采集的信息有一定的冗余度。

在提高系统容错率的同时,也能够精确感知和精准定位,以保证决策的快速性和准确性,这是目前的研究热点,也是无人驾驶汽车的必然趋势。与此同时,智能驾驶汽车通过摄像头、雷达、定位导航系统等获取环境信息,其数据形式包括图像,视频和点云等。如何有效地挖掘利用这些感知数据,摒弃与无人驾驶无关的冗余信息,抽取并融合对无人驾驶有用的信息,正确指导车辆的驾驶,这也是无人驾驶车辆的环境感知与定位的核心问题和今后的发展方向。此外,多传感器的融合其实是商业化自动驾驶达到高可靠性的必由之路。多传感器融合如何同时在车载系统和路侧系统实现,更是未来值得研究的关键问题之一。

4)融合北斗卫星和路侧设施的高精度高可靠定位逐渐将成为主流。

普通导航地图的精度低,没有反映道路的细节信息,无法准确获取车辆所在位置。而高精度地图的绝对精度要求优于Im,包括车道、车道限制信息、车道中心线等丰富的信息。随着智能交通和自动驾驶领域的飞速发展,现有的普通导航地图在精度和完整性等方面都不能满足车路协同自动驾驶的应用需求。而北斗卫星导航系统可在全球部分范围内全天候、全天时为用户提供高精度、高可靠定位、导航、授时服务,并可进行短报文通信。因此,未来将融合北斗卫星和路侧设施,构建车路协同自动驾驶高精度地图。

5)人机协同共驾技术尚处于研究阶段,如何考虑人机耦合与驾驶环境的复杂性、驾驶员驾驶习性与行为不确定性,是人机共驾面临的挑战性问题。

对人机协同共驾研究刚刚起步,除了车辆运动控制系统之间存在协同问题,驾驶员与车辆之间也存在交互与协同,人机协同的实现难度大,需要进一步协调人机混合驾驶决策控制系统和人类驾驶员的权重,形成人机动态交互,从而实现驾驶员和控制系统的驾驶权最优化分配和切换操纵。因此,结合人类智能与机器智能各自优势,采用人机智能混合增强技术,可进一步促进汽车智能化的发展,这也是未来无人驾驶汽车的发展趋势。

参考文献:

[1]王建,徐国艳,陈竞凯,冯宗保著,自动驾驶技术概论[M].北京:清华大学出版社,2019.

[2]赵爽.汽车毫米波防撞雷达的研究与实现[D].长春:长春理工大学,2013.

[3]王世峰,戴祥,徐宁,张鹏飞.无人驾驶汽车环境感知技术综述[J]长春理工大学学报(自然科学版),2017,40 (1):1-6.

[4]谌形童.三维激光雷达在自主车环境感知中的应用研究[D].长沙:国防科学技术大学,2011.

[5]叶春兰,基于图像颜色与激光点云信息的智能车辆行驶环境三维重建[D].北京:北京理工大学,2013.

[6]甄先通,黄坚,王亮,夏添著,自动驾驶汽车环境感知[M].北京:清华大学出版社,2020.

[7]唐智威,基于视觉的无人驾驶汽车研究综述[J]制造业自动化,2016,38 (8):134-140.

[8]李晓欢,杨晴虹,宋适宇,马常杰著.自动驾驶汽车定位技术[M].北京:清华大学出版社,2020.

基金项目:重庆大学大学生科研训练计划项目(CQU-SRTP-2019318)