改进Faster R-CNN的群养猪只圈内位置识别与应用

2021-01-14曾雅琼裴宏亮龙定彪徐顺来杨飞云刘作华王德麾

王 浩,曾雅琼,裴宏亮,龙定彪,徐顺来,杨飞云,刘作华,王德麾

改进Faster R-CNN的群养猪只圈内位置识别与应用

王 浩1,曾雅琼1,裴宏亮2,龙定彪1,徐顺来1,杨飞云1,刘作华1,王德麾3※

(1. 重庆市畜牧科学院,重庆 402460;2. 四川大学机械工程学院,成都 610065;3. 四川大学空天科学与工程学院,成都 610065)

群养圈栏内猪只的位置分布是反映其健康福利的重要指标。为解决传统人工观察方式存在的人力耗费大、观察时间长和主观性强等问题,实现群养猪只圈内位置的高效准确获取,该研究以三原色(Red Green Blue,RGB)图像为数据源,提出了改进的快速区域卷积神经网络(Faster Region Convolutional Neural Networks,Faster R-CNN)的群养猪只圈内位置识别算法,将时间序列引入候选框区域算法,设计Faster R-CNN和轻量化CNN网络的混合体,将残差网络(Residual Network,ResNet)作为特征提取卷积层,引入PNPoly算法判断猪只在圈内的所处区域。对育成和育肥2个饲养阶段的3个猪圈进行24 h连续98 d的视频录像,从中随机提取图像25 000张作为训练集、验证集和测试集,经测试该算法识别准确率可达96.7%,识别速度为每帧0.064 s。通过该算法获得了不同猪圈和日龄的猪群位置分布热力图、分布比例和昼夜节律,猪圈饲养面积的增加可使猪群在实体地面的分布比例显著提高(<0.05)。该方法可为猪只群体行为实时监测提供技术参考。

卷积神经网络;机器视觉;图像识别;算法;群养猪;位置识别

0 引 言

群体散养是生猪标准化规模养殖的主要饲养方式之一。当前,中国规模化养猪场在母猪后备选育和商品猪哺乳、保育、育成、育肥等饲养阶段均采用群体散养的方式,仅在母猪配种、妊娠、分娩阶段猪采用个体限位饲养,虽然个体限位饲养可以防止群体打斗和方便个体饲喂管理,但严重限制了猪只活动空间和行为表达,导致猪只刻板行为、慢性应激、跛行、皮肤损伤等不利影响[1-3],降低母猪福利水平和生产性能[4-5],近年来,随着福利养殖理念的不断深入,妊娠母猪群体散养工艺逐步在规模化猪场中得到应用,特别是欧盟理事会指令2001/88/EC明确提出[6],欧盟国家从2013年1月开始禁止妊娠母猪限位饲养,母猪配种后4周至预产期前1周必须采用群体散养的方式。因此,群体散养将是未来养猪场绝大多数猪只的饲养方式,也将是生猪设施养殖工艺及配套设备领域的技术研究重点。

猪只在群养猪圈内具有主动将躺卧位置和排泄位置分开的自然行为[7-9],并在固定区域形成躺卧、排泄、采食、活动等空间功能区[10-11]。猪只在群养圈栏内的空间位置与猪舍温度、风速、光照、饲养密度、猪圈设计等多种因素密切相关[12],并对猪舍清洁卫生和猪只福利产生影响。温度升高会使半漏缝地板猪舍内更多猪只选择在漏缝地板区域躺卧[13],导致躺卧区粪尿污染程度增加[14-15];Randall等[16]发现猪圈内风速分布会影响猪群功能分区,当新鲜空气先经过躺卧区再流向排泄区时,躺卧区粪便污染风险更高;Larsen等[17]发现饲养密度较高时,猪只在躺卧区排泄的情况增加;光照强度会影响猪只休息位置的选择[18-19],且更偏向于在光照强度较低的区域进行休息;圈栏形状、面积、分隔方式、地面和设备布置等猪圈设计因素对猪只排泄位置和猪圈清洁卫生有明显影响[20-23]。因此,掌握猪只在群养圈栏内的位置分布及其随环境的变化情况,对猪圈优化设计、设备研发和猪舍局部环境调控均有重要借鉴意义。

以往针对群养猪只圈内位置的研究大多采用人工观察视频录像的方式[24-25],但普遍存在人力耗费大、观察时间长、主观性强等不足。近年来,机器视觉和深度学习技术在生猪养殖领域的应用快速发展[26-30],其中卷积神经网络(Convolutional Neural Networks, CNN)中以快速区域卷积神经网络(Faster Region Convolutional Neural Networks,Faster R-CNN)为代表的算法由于其在目标检测任务中性能优越,受到广大研究者的关注,为群养猪只自动识别与分析提供了新的解决思路。大量学者研究了群养猪的图像分割[31-33]、生猪个体身份识别[34-36]、运动轨迹追踪[37-39]和侵略行为识别[32]等,为群养猪只的识别、定位、追踪提供了技术借鉴,但大多以猪只数量盘点和特定行为判定为研究目标,从猪群位置识别及分布的角度进行研究和分析的还比较少。Zheng等[40]利用深度图像和Faster R-CNN实现了开放式分娩栏中母猪姿态及其圈内位置的自动识别,获得了母猪在分娩栏中24 h的位置分布情况,并发现母猪躺卧位置的选择与猪圈地面设计相关,该文为猪只圈内位置识别和分布奠定了技术基础,但分娩栏中母猪为单体饲养,无法直接应用于群养猪只,且深度图像的获取成本较普通三原色(Red Green Blue, RGB)图像更高。

本研究针对猪只群体散养这一福利饲养模式,利用普通网络摄像机获得的猪群饲养RGB图像为数据源,通过改进Faster R-CNN算法和引入PNPoly算法等途径,实现群养猪只圈内位置及分布情况的自动识别,提高识别准确率、减少识别时间,为猪圈空间功能优化设计和局部环境精准调控提供技术支撑。

1 材料与方法

1.1 数据采集

1.1.1 试验条件

试验数据于2018年8-11月采集于重庆市畜牧科学院试验猪场某生长育肥舍,该猪舍共有12个群养猪圈,分上下2排布置,猪圈地面包含漏缝地板和实体地板2个区域,综合考虑猪圈的舍内位置、面积大小和福利玩具配置等因素,选取猪圈3、4、12作为数据采集猪圈,其中猪圈3、4的面积均为12.59 m2,长、宽、高分别为4.01、3.14、0.9 m,猪圈12的面积为16.20 m2,长、宽、高分别为5.16、3.14、0.9 m,所有猪圈的漏缝地板宽度为1.5 m,实体地板宽度为1.64 m,猪圈4、12在漏缝地板区2个角落装有猪用咬链,猪圈3没有配置猪用咬链,具体布置如图1所示。猪舍采用“湿帘+风机”纵向通风方式进行环境调控,猪只饮水采用碗式饮水器自由饮水,饲料由饲养员每天8:00和14:00定时投放到各猪圈的圆形料槽内供猪只自由采食。试验猪只共饲养98 d,涵盖生长、育肥2个饲养阶段,其中生长阶段42 d,每圈饲养猪只18头,育肥阶段56 d,每圈饲养猪只12头,猪只品种为三元杂交猪(杜洛克×长白×大白),猪只初始平均质量为(23.5±3.5)kg,结束平均质量为(104.2±7.5)kg,体表颜色以白色为主。

1.1.2 视频采集

试验在猪圈3、4、12上方的猪舍顶棚分别安装大华摄像头进行猪圈区域RGB视频的俯视拍摄和录制(图1),摄像头安装高度距离猪圈地面2.8 m,视角范围可覆盖猪圈内全部猪只的所有活动区域,试验对98 d饲养期进行24 h连续视频录制,录制视频帧率为每秒24帧,存储像素为1 920×1 080,存储为.dav格式。

注:1~12表示猪圈的编号。

1.1.3 图像获取

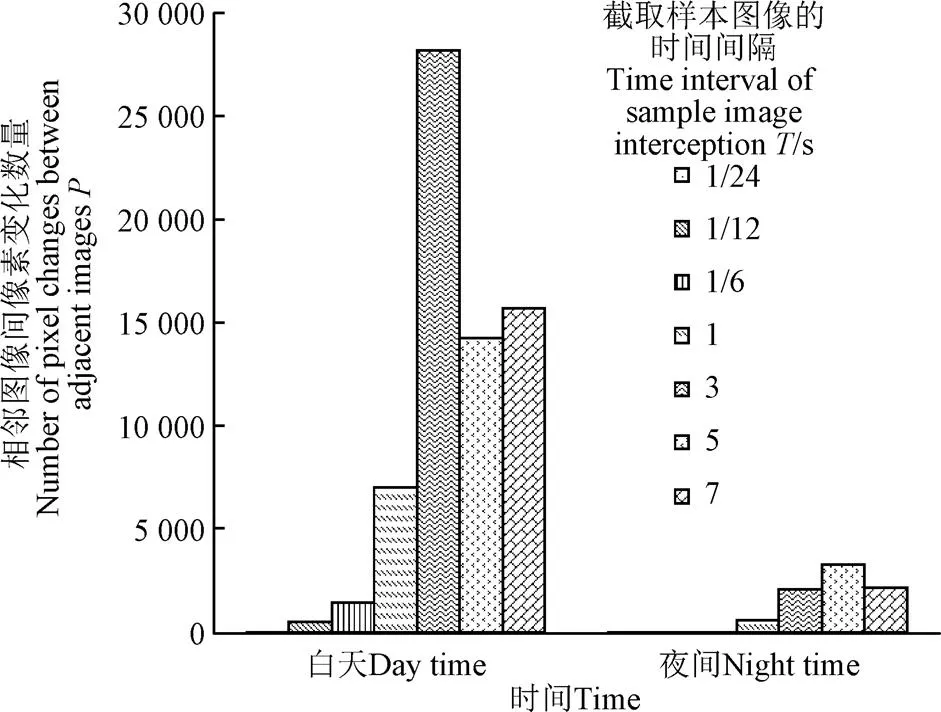

试验采用大华.dav文件播放器从采集到的视频中截取图像,考虑到猪群夜间活动频率低于白天,试验将视频分为夜间(20:00-08:00)和白天(08:00-20:00)2部分进行区别处理,视频文件帧率为每秒24帧,理论上将视频中所有图像进行标定和训练所获取的网络的泛化能力及鲁棒性都是最佳的,但这样会大幅增加样本标定的工作量,且由于猪只在较短时间内移动距离有限,相邻图像之间并无明显差异,这样作为样本图像就存在重复和无效的可能。为兼顾样本总量和样本间差异性这2项要求,确定适宜的截取样本图像的时间间隔(,s),随机选取试验期间某猪圈某天每个小时的前5 min视频段,分析了夜间和白天2个时段8种时间间隔分别为1/24、1/12、1/6、1/3、1、3、5和7 s下相邻图像间像素变化数量(),如图2所示,夜间和白天的值分别在值为5和3 s时达到最高值,即在该条件下相邻图像间像素变化数量最大,因此确定夜间和白天截取样本图像的时间间隔分别为5和3 s。按该方法从全部视频中截取图像,并从中随机抽取25 000张用于算法研究。

图2 截取样本图像的不同时间间隔(T)对应的相邻图像间像素变化数量(P)

1.1.4 数据集介绍

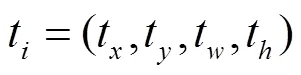

试验将获取的25 000张图像随机分配成3组,即训练集S为20 000张、测试集S为3 000张、验证集pre为2 000张,利用Github开源软件make_VOC2007对训练集S和测试集S中的每张图像内的所有猪只进行矩形标注,标注范围为任意姿态下各个猪只的最小包络矩形,标注完成后使用图像坐标系,以像素为单位,记录该矩形区域的左上角坐标(t,t),以及矩形区域的长度和宽度(t,t)。

1.2 群养猪只圈内位置识别算法构建

1.2.1 改进Faster R-CNN的群养猪只识别与定位算法设计

本研究针对传统Faster R-CNN存在的识别速度较慢的问题,提出了改进Faster R-CNN的群养猪只识别与定位算法,即轻量化CNN和基于残差网络特征提取的Faster R-CNN的混合体,其网络结构如图3所示。

注:代表融合层,用于将输入和输出采取相加进行合并;二维卷积层(3,3,1,32)表示32个大小为3×3×1的卷积核;全连接层(512)表示大小为512的全连接层;全连接层(1)表示大小为1的全连接层。

通过对每头猪只候选区域进行滑窗法计算,将等比例猪只大小区域的图片进行归一化处理得到150×100像素的图片,并将其输入轻量化CNN网络进行判断,根据经验,若猪只判断网络输出阈值>97%,则判定当前位置为猪只所在位置,否则判定为非猪只区域,最终获得猪只位置{ω0, ω1, …,ω,…,}和数量n,其中ω表示时刻图像中第个猪只的中心位置;3)判断通过轻量化CNN获得的猪只数量相对于上一帧图像的猪只数量是否有变化,如果否,则将轻量化CNN获得的结果直接作为当前帧图像的猪只位置和数量,如果是,则使用基于残差网络特征提取的Faster R-CNN对当前帧图像进行重新识别,并将其结果作为当前帧图像的猪只位置和数量。

轻量化CNN由3个卷积块和全连接层构成,每个卷积块中包含1个二维卷积层,为32个3×3×1大小的卷积核,用于提取图像中存在的特征,1个正则化层用于防止过拟合,1个激活函数层用于构建非线性的特征,和1个提取网络步长为2的最大池化层,用于降低特征数量,提取到关键信息。卷积层后添加了2个全连接层,大小分别为512和1,以及归一化函数用于分类。

经典Faster R-CNN通常采用浅层网络堆叠卷积层,其提取特征能力有限,往往通过增加卷积层的层数来提高特征提取能力,但同时会产生网络梯度消失或梯度爆炸等问题,造成网络结构不收敛,本研究为解决此问题,选用残差网络(Residual Network, ResNet)作为特征提取网络,残差网络采用跳跃连接,即在神经网络的输入为,要拟合的函数映射(即输出)为()的情况下,构建一个残差映射()为()−,则原始的函数映射()可以表示为()+,残差网络的引入提高了输入和输出的相关性,从而保证在深层网络良好的收敛性。本研究设计的残差网络特征提取模块主要由4个残差模块构成,每个残差模块由1个二维卷积层、2个正则化层和2个激活函数构成,其中每个卷积层由32个3×3×1卷积核构成,用于提取图像中的特征,正则化层用于防止网络过深过拟合,激活函数用于对网络模型中的特征进行整流,每个残差模块的输入和输出均采取相加进行合并,用于解决深层网络训练的梯度消失和训练退化的问题。

1.2.2 猪圈区域划定与猪只所在区域判定

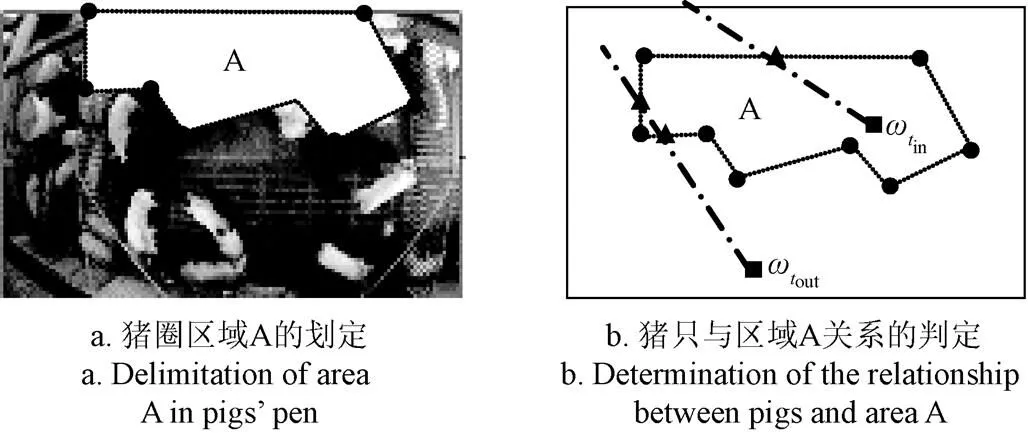

本研究基于猪圈图像构建了以像素为单位、水平方向为轴、竖直方向为轴的图像坐标系im(,),通过有序的点集合{0,1,…,p}连接成由多段线构成的任意形状的区域,其中一个坐标系中可以设定多个区域。图4a是在某图像中划定的区域A,图4b展示了基于PNPoly算法判定猪只与区域A的关系,其原理为从猪只中心点ω点向区域A边界线上的任意一点引出一条射线,计算该射线与区域A边界线交点的个数,当交点个数为奇数时,判定ω点所代表的的猪只在区域A内部,当交点个数为偶数时,则判定ω点所代表的的猪只在区域A外部。按此方法判定图像中全部猪只与全部区域的关系,最终计算该图像各个区域内的猪只数量。

注:图4b中,实线是图像边界,虚线是区域A边界,圆点是构成区域A的人为设定的点,方点是猪只中心点;ωtin为区域A内部某猪只的中心点,ωtout为区域A外部某猪只的中心点;点划线是从猪只中心点向区域A边界任意一点引出的射线,三角点是射线与区域A边界的交点。

1.2.3 算法训练

1)训练平台介绍:内存32 GB,显卡为Nvidia GTX2080型号的GPU,I5型号CPU的硬件平台和Win10操作系统,在Keras深度学习框架上,采用Python 作为编程语言实现本研究改进的 Faster R-CNN 算法。

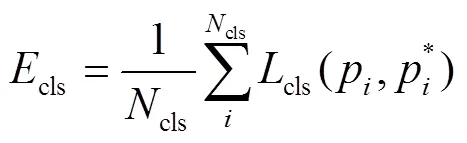

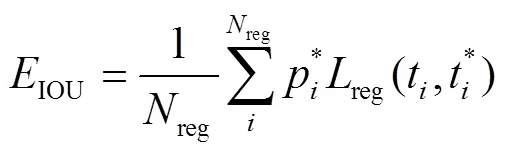

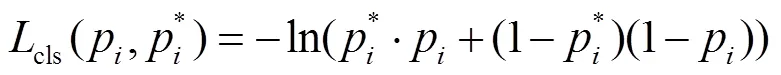

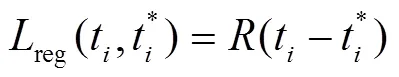

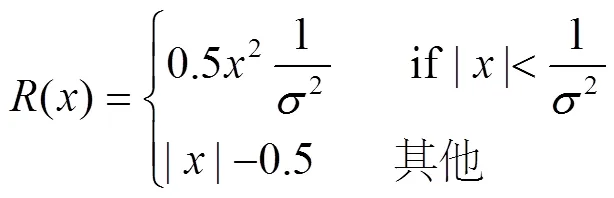

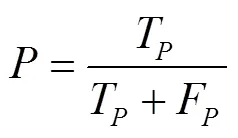

2)训练方法及条件设置:本研究使用小批量的随机梯度下降法,对改进Faster R-CNN以端对端的联合方式进行训练,设置mini-batch大小为256,冲量为0.9,权值的衰减系数为0.1,每隔 100×1 000次保存一个模型,最终选取精度最高的模型。在模型的初始化中,对轻量化CNN进行随机初始化,而对Faster R-CNN的卷积层以及网络中的全连接层则以0为均值、0.01为标准差的高斯分布随机初始化。算法训练的迭代终止条件为损失值loss<0.02,损失值loss的计算方法如式(2)所示:

loss=IOU+cls(2)

其中IOU和cls的计算方法如式(3)~式(9)所示

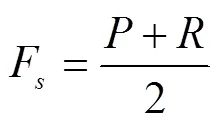

1.2.4 算法评价指标

该研究采用准确率(F,%)和检测时间(t,s)作为算法性能的评价标准,其中准确率F是类别准确率(,%)和召回率(,%)的平均值,类别准确率是衡量模型对猪只类别的识别能力,是算法识别出的猪只占所有类别的比例,召回率是衡量猪只模型对正确样本的覆盖能力,检测时间t是衡量猪只位置检测的速度。其计算如式(10)~(12)所示:

式中T表示正确样本数量,F表示错误样本数量,T表示预测出样本位置,P表示真实位置。

2 结果与分析

2.1 模型训练结果

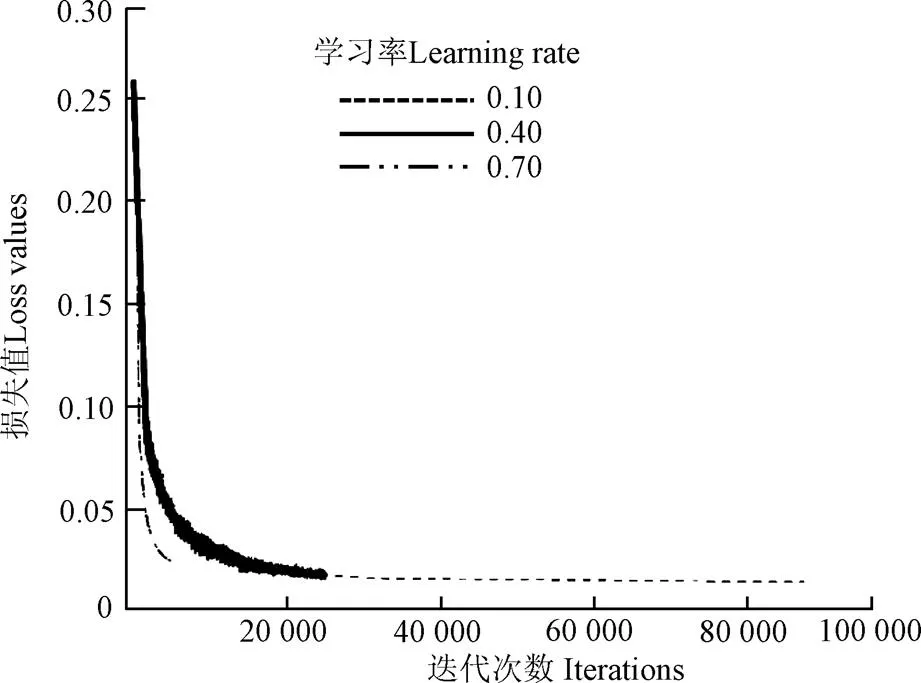

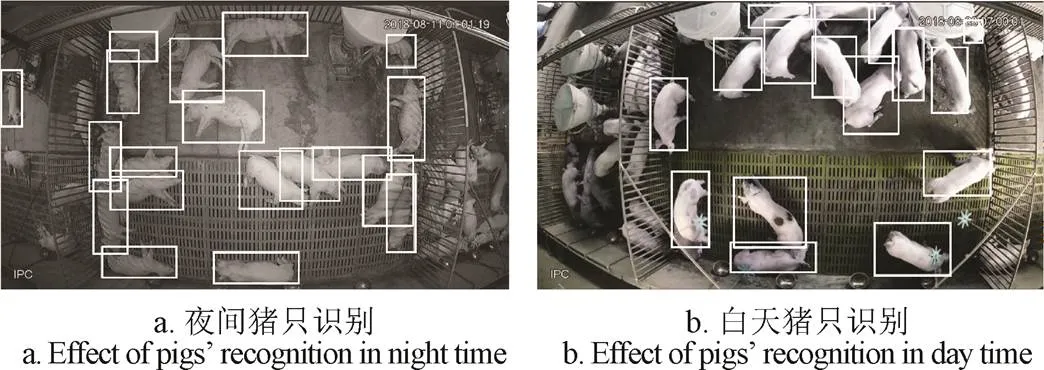

选用128层残差网络,分别以0.1、0.4、0.7为学习率,其损失值loss变化如图5所示。其中,损失值降低速度随着迭代批次增加而变得缓慢,当学习率较大时,损失值降低速度下降较快,较容易收敛,但同时容易停止不前,相比之下,学习率较小的训练,则容易达到拟合要求,因此本研究将算法学习率设置为0.1。本研究算法对群养猪只的识别效果如图6所示。

图5 不同学习率时的损失值变化

注:矩形框为识别到的猪只位置。

2.2 网络参数对模型识别性能的影响

2.2.1 基础网络结构对模型识别猪只的性能影响

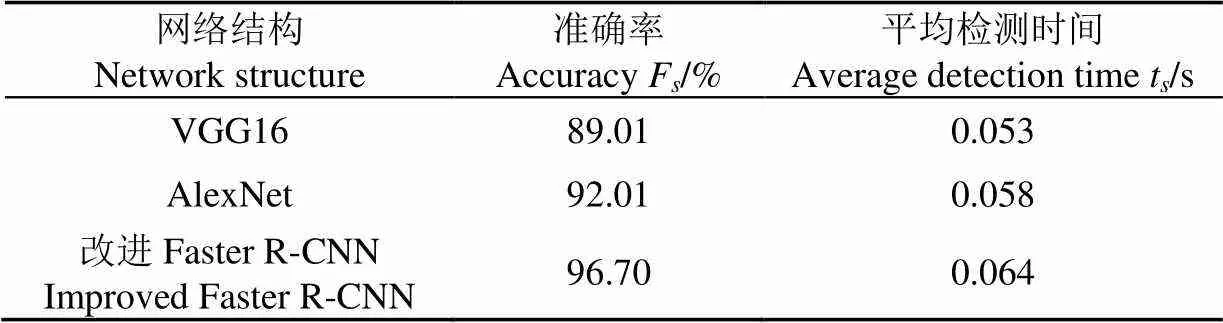

为了确定本研究提出的改进Faster R-CNN与其他基础网络结构模型之间识别猪只的性能差异,当共享卷积层层数为128时,将其与VGG16和AlexNet这两种常用基础网络结构模型进行对比,如表1所示,选用VGG16网络作为特征提取层时模型的准确率为89.01%,平均检测时间为0.053 s,当选用ALexNet网络作为特征提取层时模型的准确率为92.01%,平均检测时间为0.058 s,而本研究提出的改进Faster R-CNN模型的准确率可达96.70%,平均检测时间为0.064 s,在平均检测时间相差不多的情况下,准确率较前2种模型分别提高了8.64%和5.10%,具有更优的识别性能。

表1 不同网络结构模型识别猪只的性能对比

2.2.2 网络深度对模型识别猪只的性能影响

为了确定适宜的网络深度,本研究对比了5种残差网络层数下模型的识别性能,如表2所示,随着网络层数的增加模型识别准确率不断提高、平均检测时间也持续增加,但对比128、256、512三种网络层数可以发现,网络层数为128时模型的准确率相比网络层数为256和512时仅分别提高了0.21%和0.41%,但检测时间却分别增加了56.25%和87.5%,为了兼顾准确率和检测时间,本研究设定残差网络层数为128。

表2 不同网络深度模型识别猪只的性能对比

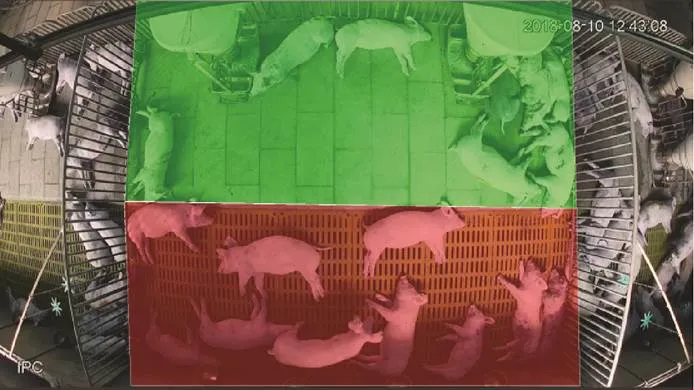

2.3 群养猪只圈内位置识别的应用效果

为测试本研究构建的改进Faster R-CNN算法的应用效果,以群养猪只圈内位置的时空分布和昼夜节律为研究案例进行应用方法及效果的展示,针对3个试验猪圈(猪圈3、4和12),分别选取2个饲养阶段(生长和育肥)的第3天、第10天、第24天的视频录像进行猪只圈内位置识别及区域分布统计,从每天的视频录像中以1 min为时间间隔在白天(9:00-17:59)和夜间(21:00-6:59)2个时段分别选择400张图片作为试验图像,利用本研究提出的算法识别出每张图像中所有猪只的中心点坐标。利用猪只坐标数据进行2个方面的数据统计,1)使用Python官方软件包索引PyPI提供的热力图包(PyheatMap-0.1.12)生成各猪圈每天的猪群位置分布热力图;2)将猪圈划分为实体地板和漏缝地板2个区域(图7),通过PNPoly算法获得各图像中2个区域内的猪只数量,并计算得到不同猪圈、饲养阶段、饲养日龄时猪群在实体地板区域的分布比例。

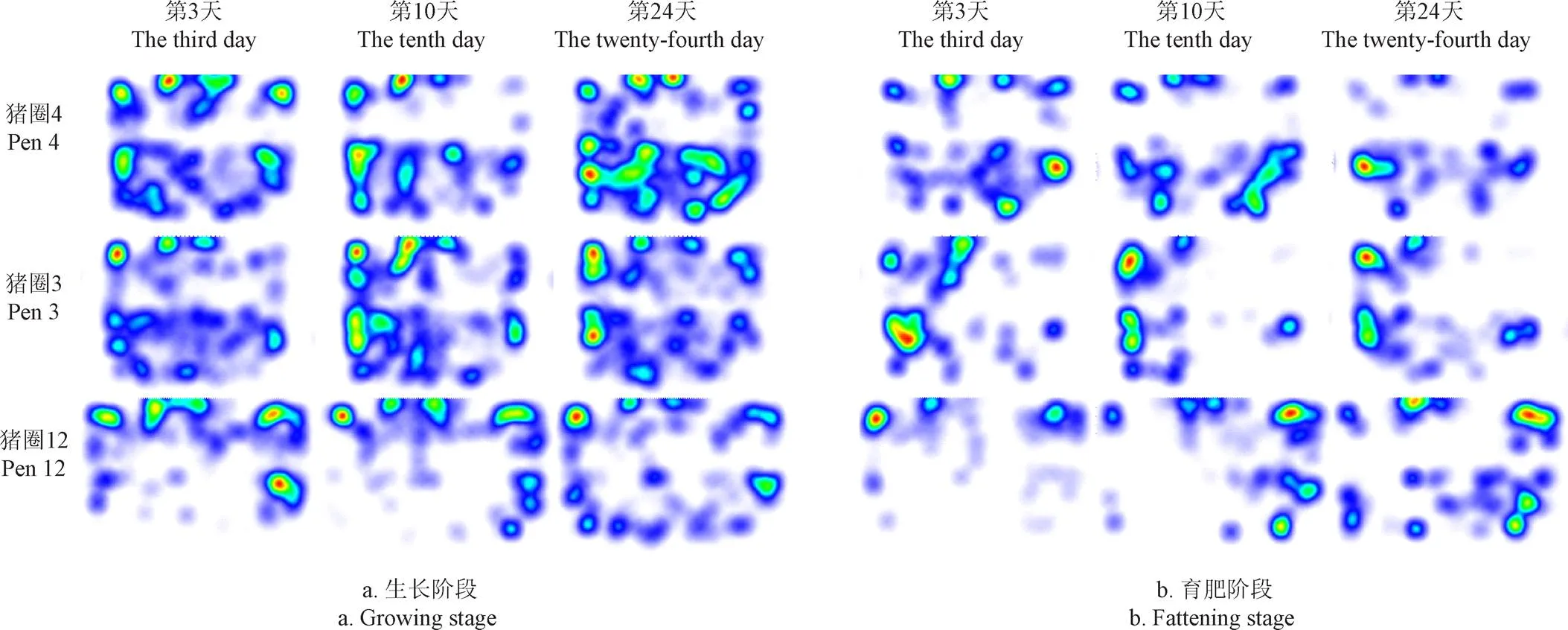

2.3.1 不同猪圈大小、饲养阶段和日龄下群养猪只圈内位置分布与区域判断

由图8可知,所有猪圈和饲养天数内猪群分布热力图在实体地面和漏缝地板之间均存在明显的分界线,说明猪舍地面类型的差异对猪只位置分布有明显的影响,猪圈12相比猪圈3和猪圈4,猪群分布更加集中在实体地面区域,说明在饲养规模一致的前提下,饲养空间越大猪只在位置选择上更加倾向于实体地面,同时,通过不同饲养日龄的热力图对比可以发现,猪圈12随着饲养日龄的增加,猪只在生长、育肥2个饲养阶段均呈现出在漏缝地板区域分布增加的趋势,这可能是由于猪只体重的增长导致猪只实际使用空间的相对降低,进而影响猪只空间位置的选择。

注:绿色部分为实体地板区域,红色部分为漏缝地板区域。

图8 不同猪圈和饲养阶段生长和育肥猪的位置分布热力图

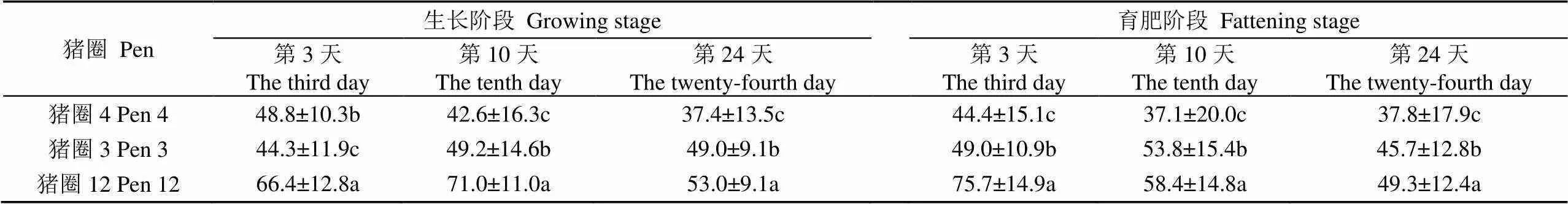

由表3可知,3个试验猪圈内猪群在实体地面上的分布比例均存在显著差异,在生长阶段后期猪圈12内猪群在实体地面的分布比例比猪圈3和4的分别显著提高了8.2%和41.7%(<0.05),在育肥阶段后期猪圈12内猪群在实体地面的分布比例比猪圈3和4的分别显著提高了7.9%和30.4%(<0.05),且随着饲养天数的增加,猪圈内12猪只在实体地面的分布比例呈下降趋势。

表3 不同猪圈和饲养阶段生长和育肥猪在实体地面区域的分布比例

注:不同小写字母表示同列数据差异显著(<0.05)。

Note: Different lowercases indicate significant difference among the same columns, at 0.05 level.

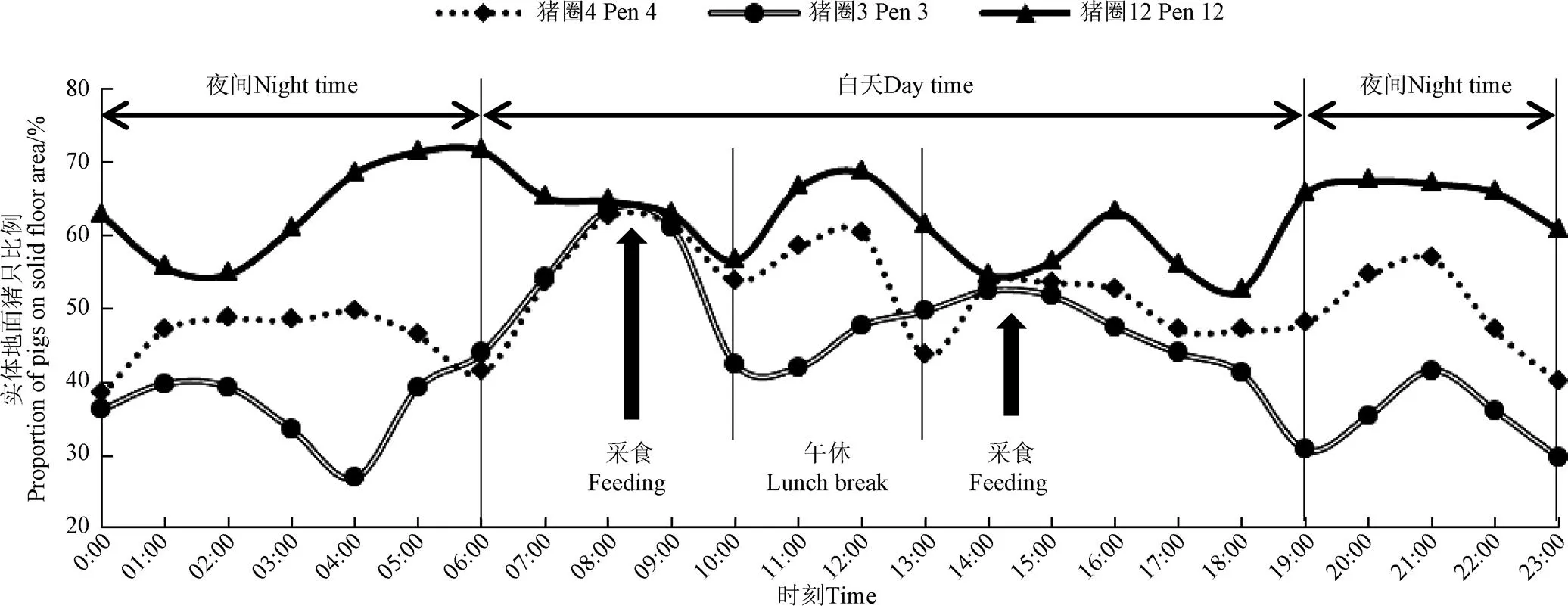

2.3.2 群养猪只圈内位置的昼夜节律变化

图9为3个试验猪圈在生长阶段末期实体地面上猪只数量占比的昼夜节律变化情况,可知在夜间(19:00-6:00)休息和午休(10:00-13:00)2个时段内,猪只在3个试验猪圈实体地面的分布比例呈现一致的梯度规律,即猪圈12最高、猪圈4次之、猪圈3最低,这与表3中的结果一致,猪圈3和4虽然空间大小一致,但猪圈4在漏缝地板区域增加了猪用咬链,而猪圈3没有设置,这说明在在漏缝地板区域增加猪用咬链可以有助于猪群区分休息区和活动区。另外,从图9中可以看出白天有2次明显的采食时段(8:00-9:00,14:00-15:00),这与饲养员开始投料的时间相吻合(8:00和14:00),这2个时段内猪只在3个试验猪圈实体地面的分布比例基本一致,这也说明料槽这种刚需性设备在猪圈的位置布局是影响猪只圈内分布的关键因素,其具有被动性和特殊性,在分析猪只圈内自由分布规律时应将其剔除或单独分析。

图9 不同猪圈内实体地面猪只比例的昼夜节律变化

3 结 论

1)以普通三原色(Red Green Blue,RGB)图像为数据源,提出了改进的快速区域卷积神经网络(Faster Region Convolutional Neural Networks,Faster R-CNN)的群养猪只圈内位置识别算法,将时间序列引入候选框区域算法,设计了Faster R-CNN和轻量化CNN网络的混合体,将残差网络(Residual Network, ResNet)作为特征提取卷积层,引入PNPoly算法判断猪只在圈内的所处区域,试验发现适宜的算法学习率为0.1,当残差网络层数为128时,该算法的识别性能最佳,其识别准确率可达96.7%,识别速度为每帧0.064 s。

2)由本研究算法获取的猪群位置分布热力图和区域分布比例发现,猪只在群养猪圈内的位置分布受地板类型的显著影响,在所有猪圈的猪群位置分布热力图中,漏缝地板和实体地板之间均存在清晰的分界线,猪圈大小对猪群位置分布影响显著,在生长阶段后期,猪圈12与猪圈3、4相比,猪只在实体地板上的分布比例分别显著提高了8.2%和41.7%(<0.05),在育肥阶段后期,猪圈12与猪圈3、4相比,猪只在实体地板上的分布比例分别显著提高了7.9%和30.4%(<0.05),且随着饲养日龄的增加,猪只在实体地板上的分布比例呈降低趋势,对于半漏缝地板猪圈,在漏缝地板区域设置猪用咬链有助于猪群主动将休息区和活动区分开。

3)从猪只位置分布的昼夜节律可以快速确定猪群的休息、活动和采食时间段,夜间休息时间段为19:00-6:00,午休时间段为10:00-13:00,采食时间段为8:00-9:00和14:00-15:00,猪只圈内位置分布受饲喂器位置的显著影响,建议在后续的研究中将饲喂器附近的区域进行特殊处理。

4)本研究可为猪圈优化设计和局部环境控制等方面的研究提供数据高效获取的技术基础,在猪群圈内位置与猪圈空间参数的相关性方面提供了定性和定量结果,丰富了生猪养殖设施研究过程中对猪群行为方面的评价指标,有助于促进生猪养殖智能化和福利化转型升级。

[1] Chapinal N, Ruiz de la Torre J L, Cerisuelo A, et al. Evaluation of welfare and productivity in pregnant sows kept in stalls or in 2 different group housing systems[J]. Journal of Veterinary Behavior: Clinical Applications and Research, 2010, 5(2): 82-93.

[2] Von Borell E, Broom D M, Csermely D, et al. The welfare of intensively kept pigs[R]. Brussels: Directorate General XXIV of the European Commission, Scientific Veterinary Committee, Animal Welfare Section, 1997.

[3] 李伟,刘作华,王朝元,等. 猪床单元宽度及群体位次对妊娠母猪行为的影响[J]. 农业工程学报,2017,33(22):248-254.

Li Wei, Liu Zuohua, Wang Chaoyuan, et al. Impact of unit width of swine bed and social hierarchy on behavior of pregnant sows[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(22): 248-254. (in Chinese with English abstract)

[4] Jensen K H, Pedersen B K, Pedersen L J, et al. Well-being in pregnant sows: Confinement versus group housing with electronic sow feeding[J]. Acta Agriculturae Scandinavica, 1995, 45(4): 266-275.

[5] Bates R O, Edwards D B, Korthals R L. Sow performance when housed either in groups with electronic sow feeders or stalls[J]. Livestock Production Science, 2003, 79(1): 29-35.

[6] European Commission Council. Council directive 2001/88/EC of 23 October 2001 amending directive 91/630/EEC laying down minimum standards for the protection of pigs[J]. Official Journal of the European Communities, 2001(88): 1-4.

[7] Whatson T S. Development of eliminative behaviour in piglets[J]. Applied Animal Behaviour Science, 1985, 14(4): 365-377.

[8] Simonsen H B. Behaviour and distribution of fattening pigs in the multi-activity pen[J]. Applied Animal Behaviour Science, 1990, 27(4): 311-324.

[9] Andersen H M, Kongsted A G, Jakobsen M. Pig elimination behavior: A review [J]. Applied Animal Behaviour Science, 2020, 222: 1-9.

[10] 施正香. 健康养猪的空间环境构建与养殖技术模式研究[D]. 北京:中国农业大学, 2014.

Shi Zhengxiang. Study on Spatial Environmental Building and Healthy Raising Technologies in Pig Loose Housing System[D]. Beijing: China Agricultural University, 2014. (in Chinese with English abstract)

[11] 刘安芳,阮蓉丹,李厅厅,等. 猪舍内粪污废弃物和有害气体减量化工程技术研究[J]. 农业工程学报,2019,35(15):200-210.

Liu Anfang, Ruan Rongdan, Li Tingting, et al. Research progress of in-house reduce engineering technology for piggery manure wastes and poisonous gas[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(15): 200-210. (in Chinese with English abstract)

[12] Jackson P, Nasirahmadi A, Guy J H, et al. Using CFD modelling to relate pig lying locations to environmental variability in finishing pens[J]. Sustainability, 2020, 12(5): 1-16.

[13] Aarnink A J A, Schrama J W, Heetkamp M J W, et al. Temperature and body weight affect fouling of pig pens[J]. Journal of Animal Science, 2006, 84(8): 2224-2231.

[14] Savary P, Gygax L, Wechsler B, et al. Effect of a synthetic plate in the lying area on lying behaviour, degree of fouling and skin lesions at the leg joints of finishing pigs[J]. Applied Animal Behaviour Science, 2009, 118(1/2): 20-27.

[15] Huynh T T T, Aarnink A J A, Gerrits W J J, et al. Thermal behaviour of growing pigs in response to high temperature and humidity[J]. Applied Animal Behaviour Science, 2005, 91(1/2): 1-16.

[16] Randall J M, Armsby A W, Sharp J R. Cooling gradients across pens in a finishing piggery: II. Effects on excretory behaviour[J]. Journal of Agricultural Engineering Research, 1983, 28(3): 247-259.

[17] Larsen M L V, Bertelsen M, Juul P L. How do stocking density and straw provision affect fouling in conventionally housed slaughter pigs?[J]. Livestock Science, 2017, 205: 1-4.

[18] Taylor N, Prescott N, Perry G, et al. Preference of growing pigs for illuminance[J]. Applied Animal Behaviour Science, 2006, 96(1/2): 19-31.

[19] Opderbeck S, Keßler B, Gordillo W, et al. Influence of increased light intensity on the acceptance of a solid lying area and a slatted elimination area in fattening pigs[J]. Agriculture, 2020, 10(3): 1-14.

[20] Hacker R R, Ogilvie J R, Morrison W D, et al. Factors affecting excretory behavior of pigs[J]. Journal of Animal Science, 1994, 72(6): 1455-1460.

[21] Wechsler B, Bachmann I. A sequential analysis of eliminative behaviour in domestic pigs[J]. Applied Animal Behaviour Science, 1998, 56(1): 29-36.

[22] Wang Hao, Zeng Yaqiong, Pu Shihua, et al. Impact of slatted floor configuration on manure drainage and growth performance of finishing pigs[J]. Applied Engineering in Agriculture, 2020, 36(1): 89-94.

[23] Ocepek M, Goold C M, Busančić M, et al. Drinker position influences the cleanness of the lying area of pigs in a welfare-friendly housing facility[J]. Applied Animal Behaviour Science, 2018, 198: 44-51.

[24] Guo Yuguang, Lian Xinming, Yan Peishi. Diurnal rhythms, locations and behavioural sequences associated with eliminative behaviours in fattening pigs[J]. Applied Animal Behaviour Science, 2015, 168: 18-23.

[25] Vermeer H M, Altena H, Vereijken P F G, et al. Rooting area and drinker affect dunging behaviour of organic pigs[J]. Applied Animal Behaviour Science, 2015, 165: 66-71.

[26] 李丹,张凯锋,李行健,等. 基于Mask R-CNN的猪只爬跨行为识别[J]. 农业机械学报,2019,50(增刊1):261-266.

Li Dan, Zhang Kaifeng, Li Xingjian, et al. Mounting behavior recognition for pigs based on mask R-CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(Supp.1): 261-266. (in Chinese with English abstract)

[27] 沈明霞,太猛,Cedric O,等. 基于深层卷积神经网络的初生仔猪目标实时检测方法[J]. 农业机械学报,2019,50(8):270-279.

Shen Mingxia, Tai Meng, Cedric O, et al. Real-time detection method of newborn piglets based on deep convolution neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(8): 270-279. (in Chinese with English abstract)

[28] 薛月菊,朱勋沐,郑婵,等. 基于改进Faster R-CNN 识别深度视频图像哺乳母猪姿态[J]. 农业工程学报,2018,34(9):189-196.

Xue Yueju, Zhu Xunmu, Zheng Chan, et al. Lactating sow postures recognition from depth image of videos based on improved Faster R-CNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(9): 189-196. (in Chinese with English abstract)

[29] 杨秋妹,肖德琴,张根兴. 猪只饮水行为机器视觉自动识别[J]. 农业机械学报,2018,49(6):232-238.

Yang Qiumei, Xiao Deqin, Zhang Genxing. Automatic pig drinking behavior recognition with machine vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(6): 232-238. (in Chinese with English abstract)

[30] 杨阿庆,薛月菊,黄华盛,等. 基于全卷积网络的哺乳母猪图像分割[J]. 农业工程学报,2017,33(23):219-225.

Yang Aqing, Xue Yueju, Huang Huasheng, et al. Lactating sow image segmentation based on fully convolutional networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(23): 219-225. (in Chinese with English abstract)

[31] 韩书庆,张建华,孔繁涛,等. 基于边界脊线识别的群养猪黏连图像分割方法[J]. 农业工程学报,2019,35(18):161-168.

Han Shuqing, Zhang Jianhua, Kong Fantao, et al. Group-housed pigs image segmentation method by recognizing watershed ridge lines on boundary[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(18): 161-168. (in Chinese with English abstract)

[32] 高云,陈斌,廖慧敏,等. 群养猪侵略性行为的深度学习识别方法[J]. 农业工程学报,2019,35(23):192-200.

Gao Yun, Chen Bin, Liao Huimin, et al. Recognition method for aggressive behavior of group pigs based on deep learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(23): 192-200. (in Chinese with English abstract)

[33] 孙龙清,李玥,邹远炳,等. 基于改进Graph Cut 算法的生猪图像分割方法[J]. 农业工程学报,2017,33(16):196-202.

Sun Longqing, Li Yue, Zou Yuanbing, et al. Pig image segmentation method based on improved graph cut algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(16): 196-202. (in Chinese with English abstract)

[34] 刘岩,孙龙清,罗冰,等. 基于改进CNN的多目标生猪检测算法[J]. 农业机械学报,2019,50(增刊1):283-289.

Liu Yan, Sun Longqing, Luo Bing, et al. Multi-target pigs detection algorithm based on improved CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(Supp.1): 283-289. (in Chinese with English abstract)

[35] Kashiha M, Bahr C, Ott S, et al. Automatic identification of marked pigs in a pen using image pattern recognition[J]. Computers and Electronics in Agriculture, 2013, 93: 111-120.

[36] 燕红文,刘振宇,崔清亮,等. 基于改进Tiny-YOLO 模型的群养生猪脸部姿态检测[J]. 农业工程学报,2019,35(18):169-179.

Yan Hongwen, Liu Zhenyu, Cui Qingliang, et al. Detection of facial gestures of group pigs based on improved Tiny-YOLO[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(18): 169-179. (in Chinese with English abstract)

[37] 高云,郁厚安,雷明刚,等. 基于头尾定位的群养猪运动轨迹追踪[J]. 农业工程学报,2017,33(2):220-226.

Gao Yun, Yu Hou'an, Lei Minggang, et al. Trajectory tracking for group housed pigs based onlocations of head/tail[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(2): 220-226. (in Chinese with English abstract)

[38] Kashiha M A, Bahr C, Ott S, et al. Automatic monitoring of pig locomotion using image analysis[J]. Livestock Science, 2014, 159: 141-148.

[39] Lind N M, Vinther M, Hemmingsen R P, et al. Validation of a digital video tracking system for recording pig locomotor behaviour[J]. Journal of Neuroscience Methods, 2005, 143(2): 123-132.

[40] Zheng Chan, Zhu Xunmu, Yang Xiaofan, et al. Automatic recognition of lactating sow postures from depth images by deep learning detector[J]. Computers and Electronics in Agriculture, 2018, 147: 51-63.

Recognition and application of pigs’ position in group pens based on improved Faster R-CNN

Wang Hao1, Zeng Yaqiong1, Pei Hongliang2, Long Dingbiao1, Xu Shunlai1, Yang Feiyun1, Liu Zuohua1, Wang Dehui3※

(1.,402460,; 2.,610065,; 3.610065,)

Pigs’ positional change in the group pens is a key indicator reflecting the behavioral expression and welfare of pigs. In this study, RGB (Red Green Blue) images were used as data sources, and an improved Faster R-CNN (Faster Region Convolutional Neural Networks) algorithm for pigs’ position recognition in group pen was proposed. The algorithm introduced the time series into the candidate box region algorithm, designed a hybrid of Faster R-CNN and lightweight CNN network, and improved the recognition accuracy and recognition speed. The Residual Network (ResNet) was used as the feature extraction convolutional layer to deepen the network depth, thereby improving the feature extraction ability to improve the algorithm robustness. The area of the pigs in the pen was judged by the PNPoly algorithm. The experiment was carried out 24 h of continuous 98 d of video recording on 3 pens (pen 3, 4, and 12) in 2 breeding stages (growing and fattening). Pen 3 and 4 had a smaller area and the size was 4.10 m×3.14 m. Pen 12 had a larger area and the size was 5.16 m×3.14 m. Bite chains had been equipped on the slatted floor area in pen 4 and 12. The experiment randomly extracted 25 000 pictures from the video for algorithm research, and 20 000 images from it as the training set, 3 000 as the verification set, and 2 000 as the test set. Through testing, when the network depth was 128 layers, both recognition accuracy and detection time could be considered. The recognition speed was 0.064 s/frame and the recognition accuracy was 96.7%. The optimal number of shared convolutional layers and neighborhood range rate were 128 and 0.3, respectively. The algorithm was used to obtain the heat map, position distribution ratio, and diurnal rhythm changes of the position distribution of pigs of different pens and feeding days. It was found that the locations of the pigs in all pens were significantly affected by the type of floor. There was a clear dividing line between the solid floor and the slatted floor in the heat map of all pens on all feeding days. The size of the pen had a significant effect on the position distribution of pigs. At the end of the growing stage, the proportion of pigs on the solid floor area in pen 12 was significantly increased by 8.2% and 41.7% compared with pen 3 and 4, respectively (<0.05). At the end of the fattening stage, the proportion of pigs on the solid floor area in pen 12 was significantly increased by 7.9% and 30.4% compared with pen 3 and 4, respectively (<0.05). And the distribution ratio of pigs on the solid floor area decreased with the increase of feeding days. From the change of diurnal rhythm, the rest period, activity period, and feeding period of the pigs were determined quickly, the night sleep time was 19:00-6:00, the lunch break time was 10:00-13:00, and the feeding time was 8:00-9:00 and 14:00-15:00 which coincided with the time of the manager added to feed. The distribution of pigs in the feeding period was affected by the installation position of the feeder, and therefore, when analyzing the free distribution pattern of pigs’ position in group pens, it was recommended to exclude them or analyze them separately. Installing pig bite chains in the slatted floor area could help pigs distinguish the activity area from the lying area. This method realized the rapid and accurate identification of the position within the pigpen in the growing and fattening group mode. The result could also help to enrich the evaluation indicators of the herd behavior in the research of pigs' breeding facilities and environment control.

convolutional neural network; computer vision; image recognition; algorithms; group pigs; position recognition

王浩,曾雅琼,裴宏亮,等. 改进Faster R-CNN的群养猪只圈内位置识别与应用[J]. 农业工程学报,2020,36(21):201-209. doi:10.11975/j.issn.1002-6819.2020.21.024 http://www.tcsae.org

Wang Hao, Zeng Yaqiong, Pei Hongliang, et al. Recognition and application of pigs’ position in group pens based on improved Faster R-CNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(21): 201-209. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2020.21.024 http://www.tcsae.org

2020-04-27

2020-07-06

国家重点研发计划项目(2017YFD0701601);重庆市技术创新与应用发展专项重点项目(cstc2019jscx-gksbX0093);现代农业产业技术体系建设专项资金(CARS-35)

王浩,助理研究员,主要从事畜禽养殖设施与智能化研究。Email:wanghaocau@163.com

王德麾,博士,高级工程师,主要从事机器视觉与智能算法研究。Email:35424743@qq.com

10.11975/j.issn.1002-6819.2020.21.024

TP391.41; S818.9

A

1002-6819(2020)-21-0201-09