国际视阈下计算思维评价研究的理论和实践

2020-12-21朱珂徐紫娟陈婉旖

朱珂 徐紫娟 陈婉旖

[摘 要] 计算思维评价是计算思维教育领域中一项非常重要且十分复杂的活动。鉴于计算思维评价研究的重要性、抽象性和多因素性,其在国际上受到了高度关注。计算思维已纳入我国高中信息技术新课程标准之中,成为学科四大核心素养之一,如何科学评价计算思维素养水平已成为国内发展计算思维的迫切需要。研究通过梳理国际上计算思维评价理论研究的发展脉络、目标内容及内在逻辑,分析典型计算思维评价工具功能类型及适用范围,结合应用案例明晰不同教育情境中计算思维评价的实施情况,阐明和探讨计算思维评价各要素的概念、内涵及素养水平评价的分级与实施,并结合国内计算思维的发展现状提出建议:重视国内计算思维教育的发展、构建计算思维评价的理论框架、自主研发计算思维评价工具、开发计算思维评价的实践案例。

[关键词] 计算思维; 计算思维评价; 计算思维教育; 三维框架; 评价工具

[中图分类号] G434 [文献标志码] A

[作者简介] 朱珂(1982—),男,河南南阳人。副教授,博士,主要从事学习分析、 STEM 教育和计算思维研究。E-mail:ezhuke@qq.com。

一、引 言

自2006年周以真提出计算思维[1]后,计算思维教育逐渐受到了国际教育领域的广泛支持和关注。美洲、欧洲和亚洲的许多国家为了在K-12阶段开展计算思维教育,先后发布了有关计算思维的政策文件。2011年,美国将计算思维纳入《CSTA K-12标准(2011修订版)》;2013年,英国将计算思维纳入“新课程计划”;2015年,澳大利亚将计算思维作为“新课程方案”的重要内容[2];2017年,我国制定的《普通高中信息技术课程标准(2017年版)》将计算思维作为学科核心素养[3]。

评价作为计算思维教育中的重要环节,能够让学生的计算思维的学习成果得到及时监控和评估,从而促进计算思维教学的有效发生。计算思维评价如果得不到充分重视,那么计算思维在K-12教育中进行扩展的机会就很渺茫。范文翔等人通过文献综述发现,对于计算思维的应用研究层面,国内主要聚焦于计算思维的培养策略,国外则主要聚焦于计算思维教育的工具以及计算思维的评价[4]。尽管目前各国已相继推出有关计算思维的政策文件,但仅从评价这一角度而言,由于其自身的复杂性,将计算思维真正融入学校教育仍面临着诸多问题和挑战:(1)计算思维评价的理论基础是什么,评价内容和评价体系是什么;(2)计算思维评价的典型工具有哪些,其功能和应用如何体现,是否可以综合起来对计算思维进行评价;(3)计算思维评价过程是如何具体实施的[5]。

为此,文章通过梳理国际上计算思维评价的理论研究及发展脉络,分析典型计算思维评价工具的功能类型及适用范围,结合应用案例进行分析,意在进一步阐明和探讨计算思维评价各要素的概念、内涵及不同维度的设计与实施,以期为计算思维能力水平评价的理论框架构建、评价量表设计、评测工具开发等提供参照。

二、计算思维评价的理论基础及发展演变

(一)理论基础

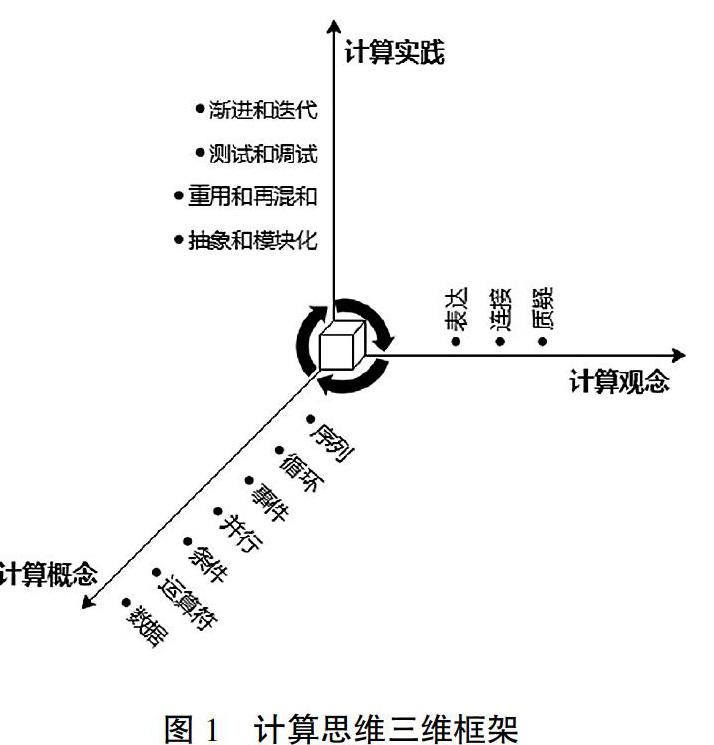

迄今为止,国内外学者对计算思维的定义尚未统一,但其观点大致可分为三种。第一种观点认为,计算思维是解决问题的过程,可以简称为“过程思维”。该观点以周以真的表述为核心,她认为计算思维是运用计算机科学的基础概念去求解问题、设计系统和理解人类的行为[1]。第二种观点认为,计算思维是一种重要的表达形式,强调了在现代数字媒体背景下,信息主要通过视觉媒体表达,因此,该观点将计算思维称之为“可视化思维”[6]。第三种观点是Brennan和Resnick提出的计算思维三维框架,该框架将计算思维描述为一种由概念、实践和观念组成的三维能力[7]。

如果对计算思维的定义或对一个全面的计算思维框架没有达成共识,那么顺利地开展计算思维评价的可能性就会比较低。这是因为计算思维评价必须与计算思维定义或理论框架相一致。例如:Chen等采用计算机科学教师协会(CSTA)标准,开发了23项测量内容,通过五个方面来评价五年级学生的计算思维[8];Marcos Román-González等基于计算思维的运算定义,构建了28项CTt(计算思维测试)[9]。每种计算思维定义都有其优势或不足,即使有了全球统一的定义,因知识结构和关注焦点不同,大家对它的理解也未必相同。但鉴于第三种定义不仅强调计算思维的过程,而且在教育实践中具有较强的可操作性,所以,国际上诸多研究将Brennan和Resnick提出的计算思维三维框架作為计算思维评价的理论基础。该框架具体包括三个维度:计算概念、计算实践和计算观念,如图1所示。

计算概念是指学习者在编程过程中所涉及的概念。当学习者使用Scratch设计交互式媒体时,他们会采用编程语言中常见的一组计算概念来映射到Scratch编程块,包括序列、循环、事件、并行、条件、运算符、数据这七个概念元素。计算实践是指学习者在涉及计算概念时开发的实践,即采用哪些策略和方法来开发交互式媒体,包括渐进和迭代、测试和调试、重用和再混合、抽象和模块化四种形式。计算观念表示的是学习者围绕他们自身和周围环境所形成的观念,这与学习者和他人的关系以及周围世界的不断发展有着密切的关系,包括了表达、连接和质疑三种方式。关于计算思维三维框架的组成要素及描述见表1。

(二)发展演变

Catherine等通过文献综述发现,在已有的计算思维评价研究中,Brennan和Resnick的计算思维三维框架是被引用最多的,该框架不仅得到了许多国内外研究人员的认可,还有了演变和发展[10]。2016年,Zhong等对Brennan和Resnick的三维框架进行了探索,设计了三维综合评价(TDIA)框架,扩展并阐明每个维度的能力,并特别强调了计算观念维度[11]。2017年,Shute、Sun和Asbell-Clarke对文献进行了元回顾,他们认为Brennan和Resnick提出的框架有着一定的局限性,只是关注了一个特定主题领域,所以,他们构建了一个分层的三维框架[12]。该框架支持并可以通过各种K-12学科领域来证明,包括数学、科学、英语和艺术等。2018年,借鉴英国计算学校的实践结论,Grover和Pea提出了一个基于能力的计算思维框架,该框架包括六个计算概念和五种计算实践[13]。在此框架中,Brennan和Resnick的计算观念主要包含在计算实践中,而Brennan和Resnick的某些计算实践(如抽象)在Grover和Pea框架中则作为计算概念出现。2019年,Catherine等对先前学者们提出的诸多框架进行了分类与整合,针对各种框架的优缺点,提出了一个混合计算思维三维框架,该框架涵盖了更广泛的内容与应用领域[10]。

三、计算思维评价工具

(一)计算思维评价工具的类型

考虑到计算思维评价的重要性和可操作性,近年来,从计算思维评价角度出发,国外已经开发了多種评价工具。这些评价工具大致可分为诊断工具、总结性工具、形成性迭代工具、数据挖掘工具、技能转移工具、感知态度量表与词汇评价七大类。

诊断工具。该类工具的目的在于测量受试者的计算思维能力水平变化,可用于教育干预前后进行前测和后测。常见的计算思维诊断工具有CTt [9]、基本编程能力测试[14]和交换评价测试[15]。

总结性工具。该类工具主要用于测试后,它们的目标是评价学习者在接受一些计算思维技能方面的指导或培训后能否获得足够的学科知识,或者是否能够正确地将学习内容应用于实践。例如Quizly[16]和The Fairy Assessment[17]。

形成性迭代工具。该类工具主要在学习过程中使用,目的在于为学习者提供自动反馈,以便发展和提高学习者的计算思维技能。从已有的文献中可以找到以下几种:Dr.Scratch[18]、Ninja Code Village[19]、Code Master[20]、CTP-Graph[21]、REACT[22]。

数据挖掘工具。该类工具也是针对学习过程的,可以实时地检索和记录学习者的活动,并提供有价值的数据和学习分析。例如:Shuchi和Grover团队在基于块的编程环境中所做的研究[23],以及Eguiluz团队使用Kodetu(具有细粒度记录功能的在线平台)所做的研究[24]。

技能转移工具。该类工具的目的是评价学习者在多大程度上能够将他们的计算思维技能转移到不同类型的问题、背景和情境中,特别适用于干预前后。例如:Bebras Tasks[25],重点测量计算思维能力向现实问题的转移;CTP-Quiz[26],评价计算思维能力如何转移到科学问题和模拟环境中。

感知态度量表。该类工具的目的是评价受试者对计算思维的感知(如自我效能感)和态度。在这类工具中,有CTS[27](计算思维量表)、CTSS[28](计算思维技能量表)和CPSES[29](计算机编程自我效能量表)。这些量表工具可以在计算思维教育干预前后使用。

词汇评价。该类工具用于评价受试者口头表达的计算思维元素,这些口头表达可以视为是一种计算思维语言。正如Lye所言,“为了更好地研究包括计算实践和计算认识在内的深度学习,可以通过记录学习者在编程时口头表达的思维过程,捕捉和分析他们的编程过程”[30]。

每种类型的工具都有其相对固定的特点,这使得它们都以特定的方式对计算思维进行评价。例如,诊断和总结性工具是基于学习者对预先确定的计算思维项目或问题的回答,而形成性迭代和数据挖掘工具分别依赖于学习者编程创作和学习者在开发计算思维时的活动分析。因此,只有将不同类型工具提供的信息加以协调和三角化,才能对个人的计算思维进行全面的评价。

(二)计算思维评价工具的综合应用

为了更好地利用计算思维评价工具辅助计算思维教育,从而实现对学生的综合评价,Marcos Román-González等对CTt、Bebras Tasks和Dr.Scratch这三种评价工具能否综合应用进行了探索,为计算思维评价工具的综合应用提供了一种思路和方法[31]。

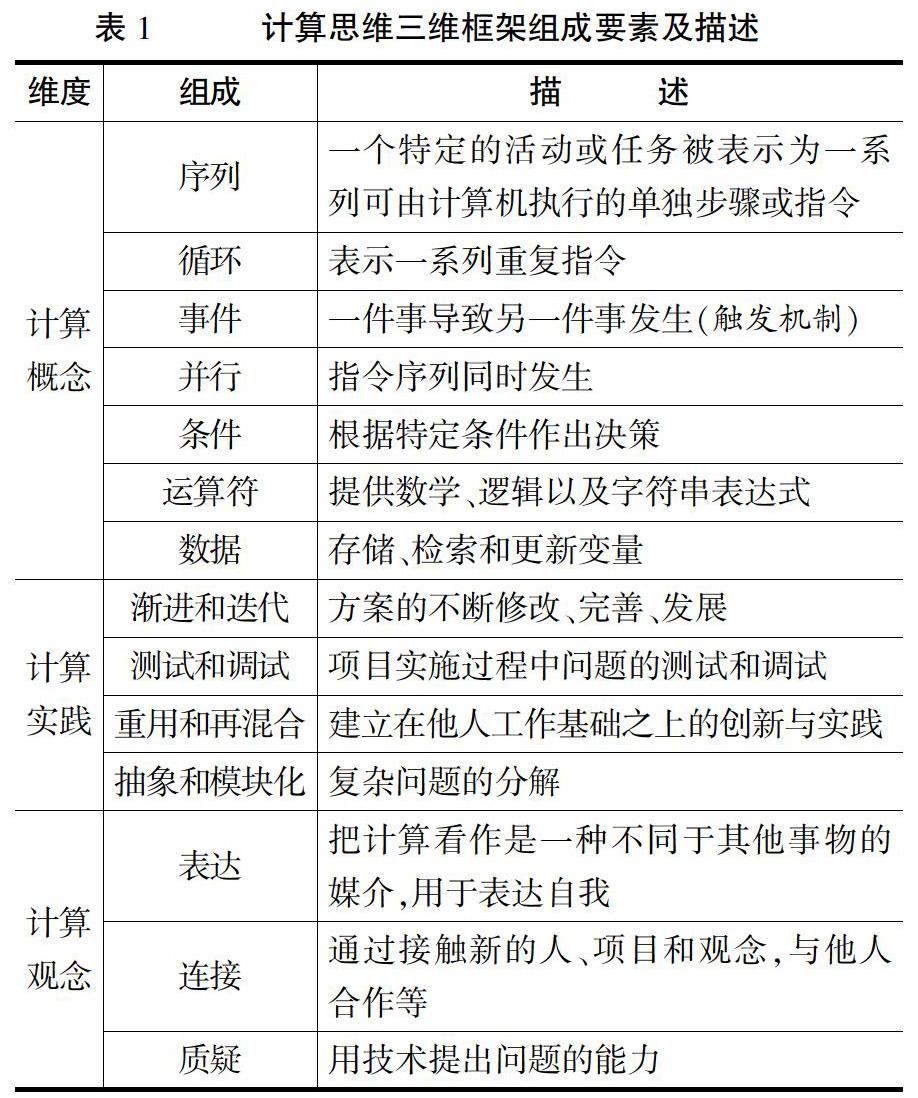

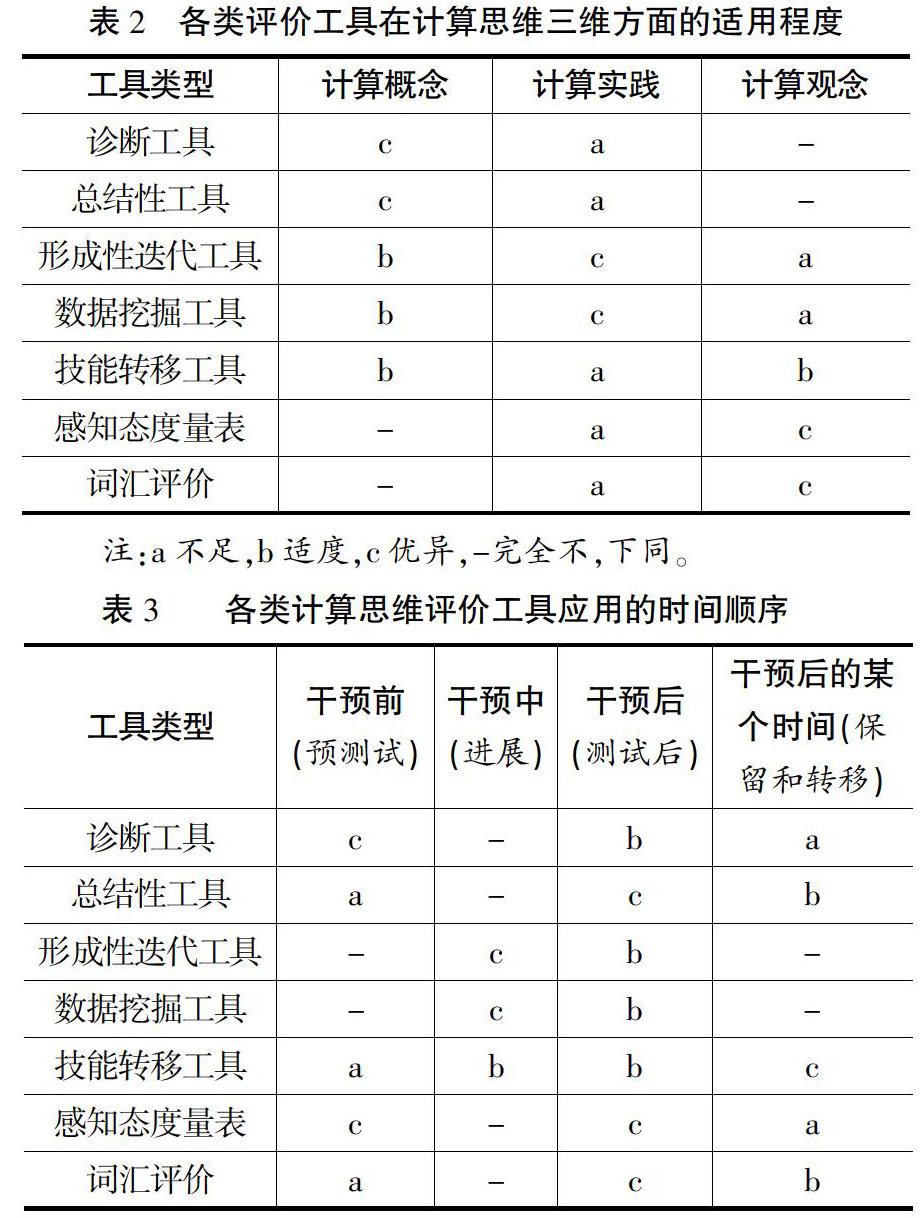

研究结果表明,CTt、Bebras Tasks和Dr.Scratch之间的相似度非常小[31]。这在一定程度上说明了不同类型的评价工具之间只有很少的关联性,在教育实践中应综合应用。同时,Marcos Román-González等结合各类计算思维评价工具的特点以及Brennan和Resnick的三维框架,进一步总结出各类评价工具在计算思维各维度方面的适用程度和应用于计算思维教育不同阶段的时间顺序,分别见表2、表3。

此外,Marcos Román-González等还总结了每种类型的评价工具在布鲁姆认知目标分类法中的水平,帮助研究者从认知层面更好地把握评价工具的应用,如图2所示。诊断工具提供关于学习者如何“识记”和“理解”一些计算概念的信息;技能转移工具可以帮助学习者在不同的情境中“运用”和“分析”他们的计算思维技能;形成性迭代工具允许学生“评价”自己和他人的项目,以及“创造”更好、更复杂的项目;总结性工具和词汇评价工具充当分类法中低级和中级之间的转换工具;数据挖掘工具则在中级和高级之间进行转换。尽管如此,仍可能存在一些计算思维问题,如可用性、原创性、界面设计等,这些问题不可能用工具来衡量,是要用人的敏感性来衡量。最后,感知态度量表不评价认知过程,而评价非认知过程,因此,这类工具针对的是布鲁姆认知目标分类法以外的计算观念。

四、计算思维评价活动的典型案例

(一)基于可视化编程环境下的计算概念评价

编程是美国K-12教育中计算机科学入门课程的关键要素。为了使计算机科学课程的学习能够满足K-12学习者应对未来学习和工作的需求,学习者需要学习编程中解决计算问题的基本概念。Grover等发现,学习者在基于文本编程背景下对诸如变量、表达式和循环等计算概念的理解面临若干挑战[32]。因此,他们探究了学习者在基于块的编程环境下对计算机科学课程中的关键计算概念(变量、表达式、循环,简称VEL)的理解。案例采用以证据为中心的设计(ECD)原则设计评价项目,从领域分析、领域建模到形成概念性评价框架,对通过Scratch平台完成了与本案例项目无关的入门编程和计算机科学课程学习的100名中学生进行试点研究,从而获取学生对VEL理解的整个过程。此外,通过收集到的数据,研究者还讨论了如何对评价项目进行修订的问题。

案例在一定程度上给出了计算思维与STEAM学科融合的方向。在评价方面,采用以证据为中心的设计(ECD)原则,为计算概念评价以及计算思维其他维度的评价应用研究提供了一种新的思路和方法。

(二)基于任务场景下的计算实践评价

计算实践是评价中需要测量的一个很重要的方面,它反映了其他领域(如科学和工程)的转变情况,从测量实际知识转向应用知识和技能解决问题。Basu等发现,过去很少有人了解计算实践的有效评价,尤其对于低年级来说,这些评价更为稀少[33]。因此,他们探究如何为计算实践设计有效的评价工具,并使其可以在香港4~6年级的学生中大规模使用。案例采用以证据为中心的设计(ECD)流程来开发评价任务。在Brennan和Resnick描述的框架基础上,选择“重用和再混合”“算法思维”“抽象和模块化”“测试和调试”作为评价内容。对这四种计算实践进行阐述和定义,并在每个模块下定义参与计算实践的学习者应具备的重点知识、技能和能力(FKSA)。

案例中,研究者描述了一项有效、可靠的计算实践评价工具的设计流程,其中至关重要的是清楚地阐明了评价目标和内容。此外,案例针对香港4~6年级学生提供了一项评价研究的结果,并且该评价工具已在香港约15000名学生中使用,这对研究者开展大规模计算思维教学、开展多轮研究具有较大的参考价值[34]。

(三)基于非正式环境下的计算观念评价

《构建计算思考者》是一项为期三年的研究,探讨教育工作者和设计师们如何最有效地支持计算思维能力的发展,以及如何将这些学习经验制定成项目以满足不同学习者的需求。作为《构建计算思考者》研究的一部分,该案例由Mesiti等在非正式学习环境(波士顿科学博物馆)中开展,研究集中在三种具体的展品设计方法上,展品介绍了皮克斯创新电影背后的计算机科学、数学和科学,以传达“皮克斯背后的科学”中的问题分解内容。整个研究分为两个阶段:第一阶段调查了如何支持新手学习者与展品互动,并理解解决问题的策略,以应对复杂的、创造性的计算机编程挑战;第二阶段调查这些展品对中学生分解问题内容的能力、效能感和兴趣的影响[35]。

计算观念更多关注的是学习者的非认知能力,相对于认知能力而言,在测评方面存在更大的难度,因此,以往对于计算观念评价的研究并不多。该案例与其他研究的不同之处在于,研究环境是在博物馆这类非正式环境中开展,采用观察、访谈等形式,研究学习者对特定展品的理解和学习情况。评价和发展学习者的计算观念能力,不仅可以激发学习者对计算思维的兴趣,而且有利于学习者创造性思维的形成。案例为研究者对学习者在非正式环境下计算观念方面的评价提供了新的探索方向。

(四)游戏化教学情境下面向计算思维的综合评价

近几年来,包括英国在内的许多国家都将编程纳入了小学课程,这使人们对教孩子如何编码产生了兴趣。计算机游戏设计是一种有趣而有效的引入编程学习的方法。因此,英国伦敦大学学院Yasemin Allsop选择来自伦敦一所小学的30名10—11岁的学生,让他们使用Scratch和Alice 2.4平台参加了为期八个月的游戏制作项目,从而回答“游戏化教学情境下评价计算思维能力的最佳方法是什么”这一研究问题。整个研究过程分三步:第一步,定义模型。评价模型从计算概念、元认知实践和学习行为三个方面进行构建。因为评价是在游戏制作环境中实施,所以计算机游戏设计也被纳入评价模型中。第二步,选择方法。评价方法基于民族志研究方法,具体包括对参加者的观察和非正式对话、半结构化访谈、提供日记和问题解决表以及检查学生在平台上所完成的游戏。第三步,过程实施。第一阶段,30名学生在9月至次年1月期间使用Scratch平台进行了四个月的学习,每周一次,每次1小时,作为他们每周计算课程的一部分,总共进行了14小时的学习。第二阶段,30名学生在1月至4月期间使用Alice平台进行游戏,课程安排与第一阶段一致。第三阶段,课程结束后,分析学生的问题解决表、完成的游戏、访谈数据和现场笔记等[36]。

该案例探索了游戏化教学情境下计算思维的构成要素,并使用多种方法收集学生完成游戏项目过程中的数据,进而深入理解游戏化教学情境下计算思维的构成要素和评价这些要素的方法。研究结果证明了评价计算思维各方面内容应该采用多元化的评价方法,并提出在该环境下的最佳评价方法组合。评价方法的选择与评价工具的选择在一定程度上是不谋而合的,都要将研究对象、研究目的、研究内容和环境等多方面因素考虑在内。因此,该案例在评价方法和评价工具方面为计算思维能力的综合评价提供了重要参考。

五、启示与建议

(一)重视国内计算思维教育的发展

世界上大部分发达国家已经在政策和资金的支持下,开展了计算思维教育的各类研究计划和项目。然而,目前国内的计算思维研究还不够成熟,尤其对计算思维教育还不够重视。因此,我国应从多角度出发加强对国内计算思维的人才培养。首先,从国际层面做好沟通协作,政府应加强与重要的国际投资者,包括外国政府、工业界、学术界和其他机构联盟的互动,以便在计算思维研发方面进行国际交流和合作[37]。其次,从国家层面做好计算思维教育应用的顶层设计,注重发挥政府各部门优势,通过协作为教育部门解决困难和实现发展提供指导性框架[37]。最后,从学校层面做好计算思维的科研和人才培养工作,成立计算思维研究院和实验室等,加强计算思维相关领域课程的内容建设[38],重点培养计算思维、人工智能、大数据等方面的人才,开展计算思维领域的科学研究和技术研发。

(二)构建计算思维评价的理论框架

计算思维评价作为计算思維教育中非常重要且十分复杂的一项活动,需要通过构建完善的计算思维评价理论框架来更好地开展和实施。首先,应从计算思维的定义出发,确定计算思维评价的维度和要素。目前国外学者对计算思维的定义尚未统一,但已提供了很大的参考价值。因此,对于国内研究者而言,可以通过对比和学习国外研究成果,确定本土化的计算思维定义,确定计算思维的评价维度和要素。其次,要分析每个维度包含要素的内涵,并对各要素进行详细的描述,从而有利于研究者在后期课堂教学中观察和记录学生的计算思维外显行为表现。同时,也便于教师在实际教学中按照各要素提出的标准去评价学生的计算思维水平。最后,教师或教育研究者要在实践中根据研究对象、研究目的等对构建的框架进行修改和完善,对框架中包含的元素进行灵活的调整和科学的权重分配。

(三)自主研发计算思维评价工具

良好的计算思维评价工具可以为计算思维教育营造有益的教学环境。目前,国内尚缺乏科学权威的K-12阶段学生计算思维能力评价工具[39],部分研究也是直接采纳和编译国外的评价工具。基于此,我国在评价工具的自主研发方面存在着很大的发展空间。首先,要客观看待国外研发的计算思维评价工具。由于国内外教育理念不同,在课程设置方面也有诸多差异,因此,从国外直接编译的评价工具并不能很好地适应国内计算思维教育的发展。其次,要扎实地进行计算思维评价的理论学习与研究。对当前国际上计算思维教育教学理论进行细致梳理和分析,以前沿的科学本质和科学探究作为工具开发的参照,从而更加科学高效地开展计算思维评价工具的研发工具。最后,开发者应从多角度、多方位出发,拓宽思维,充分发挥想象力和创新精神,自主研发更具针对性的评价工具,进而促进中小学计算思维教育的发展[40]。

(四)开发计算思维评价的实践案例

开展计算思维教育不仅需要大量的教育政策支持,还需要诸多优秀的案例和评价手段支撑。目前,我国需要一些计算思维评价的实践案例来推动计算思维教育的发展。首先,从教师角度而言,教师的计算思维能力水平直接影响计算思维教育的质量,对计算思维教育的发展起着十分关键的作用。因此,教师应具备计算思维方面的知识和评价能力。其次,从学校角度而言,一方面要大力支持計算思维评价案例的开发工作,另一方面做好教师培训工作的投资和安排,寻找合适的培训课程和资源,如通过邀请讲师讲解计算思维评价的理念和方法,引进成功且成熟的案例,以观摩和实地学习的形式,使教师把握计算思维评价的整体流程[41]。最后,从研究者角度而言,可以将优秀的国外计算思维评价实践案例与我国现有的学校资源相结合,选择合适的试点学校进行研究,待研究效果成熟后再进行普及。

[参考文献]

[1] WING J M. Computational thinking[J]. Communications of the ACM, 2006, 49(3): 33-35.

[2] 肖广德,高丹阳.计算思维的培养:高中信息技术课程的新选择[J].现代教育技术,2015,25(7):38-43.

[3] 任友群,黄荣怀.高中信息技术课程标准修订说明 高中信息技术课程标准修订组[J].中国电化教育,2016(12):1-3.

[4] 范文翔,张一春,李艺.国内外计算思维研究与发展综述[J].远程教育杂志,2018,36(2):3-17.

[5] 朱珂,贾彦玲,冯冬雪.欧洲义务教育阶段发展计算思维的理论与实践研究[J].电化教育研究,2019,40(9):89-96,121.

[6] National Research Council. Report of a workshop on the scope and nature of computational thinking[R]. Washington D C: National Academies Press,2010.

[7] BRENAN K, RESNICK M. New frameworks for studying and assessing the development of computational thinking[C]//Proceedings of the 2012 annual meeting of the American educational research association. Canada:Vancouver, 2012: 25.

[8] CHEN G, SHEN J, BARTH-COHEN L, et al. Assessing elementary students' computational thinking in everyday reasoning and robotics programming[J]. Computers & education, 2017, 109(6):162-175.

[9] ROMAN-GONZALEZ M, PEREZ-GONZALEZ J C, JIMENEZ-FERNANDEZ C. Which cognitive abilities underlie computational thinking? Criterion validity of the computational thinking test[J]. Computers in human behavior, 2017, 72(7):678-691.

[10] ADAMS C, CUTUMISU M, LU C. Measuring K-12 computational thinking concepts, practices, and perspectives: an examination of current CT assessments[J]. Interactive learning environments, 2019, 26(3): 386-401.

[11] ZHONG B, WANG Q, CHEN J, et al. An exploration of three-dimensional integrated assessment for computational thinking[J]. Journal of educational computing research, 2016, 53(4): 562-590.

[12] SHUTE V J, SUN C, ASBELL-CLARKE J. Demystifying computational thinking[J]. Educational research review,2017,22:142-158.

[13] GROVER S, PEA R. Computational thinking: a competency whose time has come[J]. Computer science education: perspectives on teaching and learning in school, 2018, 19:19-38.

[14] MHLING A, RUF A, HUBWIESER P. Design and first results of a psychometric test for measuring basic programming abilities[C]//Proceedings of the workshop in primary and secondary computing education. New York: ACM, 2015:2-10.

[15] WEINTROP D, WILENSKY U. Using commutative assessments to compare conceptual understanding in blocks-based and text-based programs[C]//Proceedings of the eleventh annual International Conference on International Computing Education Research. New York: ACM, 2015:101-110.

[16] MAIORANA F, GIORDANO D, MORELLI R. Quizly: a live coding assessment platform for App Inventor[C]//2015 IEEE Blocks and Beyond Workshop (Blocks and Beyond). Atlantan: IEEE, 2015:25-30.

[17] WERNER L, DENNER J, CAMPE S, et al. The fairy performance assessment: measuring computational thinking in middle school[C]//Proceedings of the 43rd ACM Technical Symposium on Computer Science Education.New York: ACM, 2012: 215-220.

[18] MORENO-LEN J, ROBLES G, ROMN-GONZLEZ M. Dr. Scratch: automatic analysis of scratch projects to assess and foster computational thinking[J]. Revista de Educación a Distancia, 2015 (46): 1-23.

[19] OTA G, MORIMOTO Y, KATO H. Ninja code village for scratch: function samples/function analyser and automatic assessment of computational thinking concepts[C]//2016 IEEE Symposium on Visual Languages and Human-Centric Computing (VL/HCC). Cambridge: IEEE, 2016: 238-239.

[20] Von WANGENHEIM C G, HAUCK J C R, DEMETRIO M F, et al. Code master—automatic assessment and grading of app inventor and snap! Programs[J]. Informatics in education, 2018, 17(1): 117-150.

[21] KOH K H, BASAWAPATNA A, BENNETT V, et al. Towards the automatic recognition of computational thinking for adaptive visual language learning[C]//2010 IEEE Symposium on Visual Languages and Human-Centric Computing. Leganes: IEEE, 2010: 59-66.

[22] KOH K H, BASAWAPATNA A, NICKERSON H, et al. Real time assessment of computational thinking[C]//2014 IEEE Symposium on Visual Languages and Human-Centric Computing (VL/HCC). Melbourne: IEEE, 2014: 49-52.

[23] GROVER, SHUCHI, et al. A Framework for using hypothesis-driven approaches to support data-driven learning analytics in measuring computational thinking in block-based programming environments[J]. ACM Transactions on computing education,2017,17(3): 1-25.

[24] EGULUZ A, GUENAGA M, GARAIZAR P, et al. Exploring the progression of early programmers in a set of computational thinking challenges via clickstream analysis[J]. IEEE transactions on emerging topics in computing, 2017, 8(1): 256-261.

[25] DAGIENDE V, FUTSCHEK G. Bebras international contest on informatics and computer literacy: criteria for good tasks[C]//International Conference on Informatics in Secondary Schools-evolution and Perspectives. Berlin: Springer, 2008: 19-30.

[26] BASAWAPATNA A, KOH K H, REPENNING A, et al. Recognizing computational thinking patterns[C]//Proceedings of the 42nd ACM Technical Symposium on Computer Science Education. New York: ACM, 2011: 245-250.

[27] KORKMAZ , CAKIR R, ZDEN M Y. A validity and reliability study of the computational thinking scales (CTS)[J]. Computers in human behavior, 2017, 72: 558-569.

[28] DURAK H Y, SARITEPECI M. Analysis of the relation between computational thinking skills and various variables with the structural equation model[J]. Computers & education, 2018, 116: 191-202.

[29] KUKUL V, GKEARSLAN , GNBATAR M S. Computer programming self-efficacy scale (CPSES) for secondary school students: development, validation and reliability[J]. Egitim Teknolojisi Kuram ve Uygulama, 2017, 7(1): 158-179.

[30] LYE S Y, KOH J H L. Review on teaching and learning of computational thinking through programming: what is next for K-12?[J]. Computers in human behavior, 2014, 41: 51-61.

[31] ROMN-GONZLEA M, MORENO-LEN J, ROBLES G. Combining assessment tools for a comprehensive evaluation of computational thinking interventions[M]. Singapore: Springer Nature Singapore Pte Ltd,2019: 79-98.

[32] GROVER S, BASU S. Measuring student learning in introductory block-based programming: examining misconceptions of loops, variables, and boolean logic[C]//Proceedings of the 2017 ACM SIGCSE Technical Symposium on Computer Science Education. New York: ACM, 2017: 267-272.

[33] BASU S, RUTSTEIN D, XU Y, et al. A principled approach to designing a computational thinking practices assessment for early grades[C]//Proceedings of the 51st ACM Technical Symposium on Computer Science Education. New York: ACM, 2020: 912-918.

[34] 梁云真,朱珂,趙呈领.协作问题解决学习活动促进交互深度的实证研究[J].电化教育研究,2017,38(10):87-92,99.

[35] MESITI L A, PARKES A, PANETO S C, et al. Building capacity for computational thinking in youth through informal education[J]. The journal of museum education, 2019, 44(1):108-121.

[36] ALLSOP Y. Assessing computational thinking process using a multiple evaluation approach[J]. International journal of child-computer interaction, 2019, 19: 30-55.

[37] 袁利平,陈川南.美国人工智能战略中的教育蓝图——基于三份国家级人工智能战略的文本分析[J].比较教育研究,2020,42(2):9-15.

[38] 马玉慧,柏茂林,周政.智慧教育时代我国人工智能教育应用的发展路径探究——美国《规划未来,迎接人工智能时代》报告解读及启示[J].电化教育研究,2017,38(3):123-128.

[39] 白雪梅,顾小清.K12阶段学生计算思维评价工具构建与应用[J].中国电化教育,2019(10):83-90.

[40] 梁云真,曹培杰.我国基础教育信息化融合指数的调查研究——来自12省2500余所学校的数据[J].电化教育研究,2019,40(11):41-47.

[41] 孙立会,刘思远,李曼曼.面向人工智能时代儿童编程教育行动路径——基于日本“儿童编程教育发展必要条件”调查报告[J].电化教育研究,2019,40(8):114-120,128.