基于改进谱残差显著性图的红外与可见光图像融合

2020-12-14李辰阳

李辰阳,丁 坤,翁 帅,王 立

〈图像处理与仿真〉

基于改进谱残差显著性图的红外与可见光图像融合

李辰阳1,丁 坤1,2,翁 帅1,王 立1

(1. 河海大学,江苏 常州 213022;2. 常州市光伏系统集成与生产装备技术重点实验室,江苏 常州 213022)

为了将可见光图像与红外图像中的细节信息更多的呈现在融合图像中,突出目标特征并获得更好的图像视觉效果,本文提出一种基于改进谱残差显著性图的红外与可见光图像融合方法。首先用改进的谱残差显著性检测算法提取红外图像的显著性图并获得融合图像的显著性系数,然后对源图像进行双树复小波分解,并根据特定的融合规则分别对图像的低频部分以及高频部分进行融合,最后采用双树复小波逆变换重构获得最终的融合图像。实验表明,本文融合方法相较于传统融合方法融合质量更高并且在视觉效果上有显著提升。

谱残差显著性;图像融合;双树复小波分解;融合规则

0 引言

图像融合是指将多源信道对同一目标采集到的多幅图像综合成一幅高质量图像[1]。红外成像传感器根据测量目标本身与背景红外辐射的差异成像,抗干扰能力强,但分辨率较低,容易丢失细节信息;而可见光图像通常具有较高的对比度以及分辨率,能体现更多细节信息。因此红外图像与可见光图像有着良好的互补性,红外图像与可见光图像的融合也成为图像融合技术的研究热点,在军事、遥感等领域已取得了广泛的应用[2]。

基于多尺度分解的方法一直是图像融合技术研究的热点。余美晨等人在梯度金字塔变换[3]的基础上采取不同的层次融合策略生成融合图像。Ashish等人将多尺度局部形状算子与拉普拉斯金字塔变换[4]相结合提出了一种新型的图像融合方法。但常用的金字塔变换缺乏方向性且数据冗余度高,融合后图像不够清晰,图像信息量较少。Gonzalo等人提出了基于小波变换[5]的图像融合算法,克服了数据冗余的问题,但缺乏方向选择性以及平移不变性。Seal等人将Curvelet变换[6]应用于多尺度图像融合,虽然能够分析任意角度的方向,但计算量太大,图像处理效率较低。双树复小波变换[7]在小波变换的基础上进行改进,保留小波变换优点的同时,具有多方向选择性以及近似平移不变性,其计算效率高、重构效果好,融合图像质量较高,因此本文使用双树复小波变换进行多尺度变换。

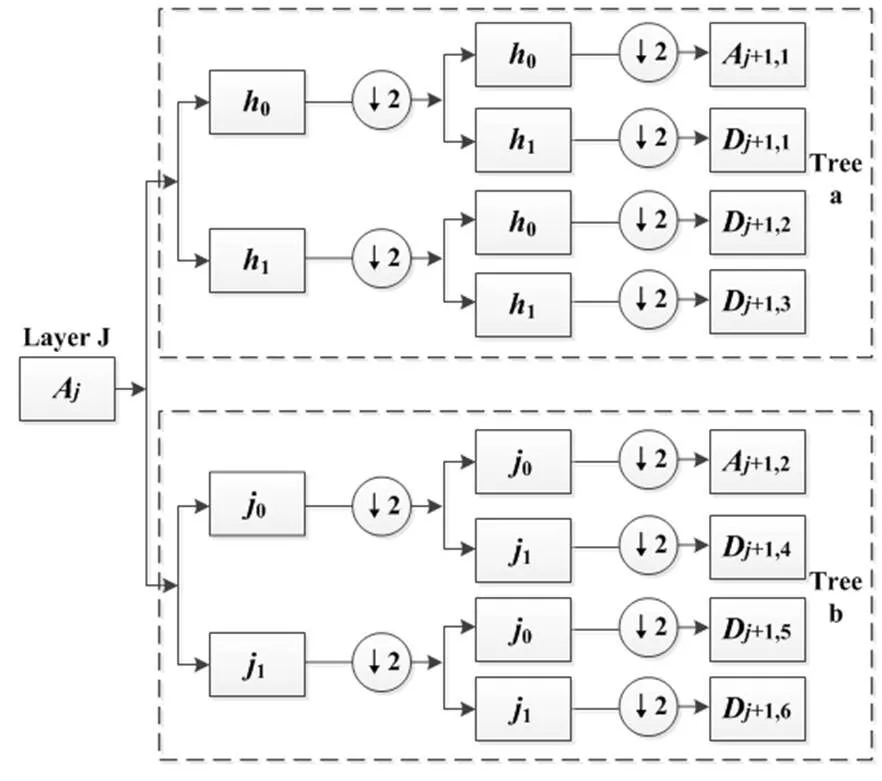

图像融合规则也是影响融合图像质量的重要因素,传统基于平均(AVE)的融合规则往往会降低图像的对比度,融合图像的视觉效果较差[8]。针对这一问题,本文提出一种基于改进谱残差(Spectral Residual,SR)显著性图的融合算法,应用改进的谱残差显著性模型对红外图像进行显著性分析获得融合图像的显著性权重,并根据显著性权重设计低频部分的融合规则,高频部分则采用局部方差最大值融合规则。

1 算法思想

1.1 红外图像的谱残差显著性分析

视觉显著性是指针对某一特定场景,人类的视觉系统会选择性地忽略不感兴趣的区域,并自动关注感兴趣区域[9]。而如何对图像中的显著性区域进行量化已经成为近年来计算机视觉领域的研究热点。

从信息论的角度,图像信息(Image)可以分成两部分:

(Image)=(Innovation)+(Prior) (1)

式中:(Innovation)表示图像中显著的部分,而(Prior)表示图像中的冗余信息。Spectral Residual算法[10]就是基于这种思想,分析处理输入图像的对数谱,去除图像中的冗余部分,得到输入图像的显著部分。

首先对输入图像进行傅里叶变换,获取振幅谱()以及相位谱()作为先验信息:

()=R(Á[()]) (2)

()=S(Á[()]) (3)

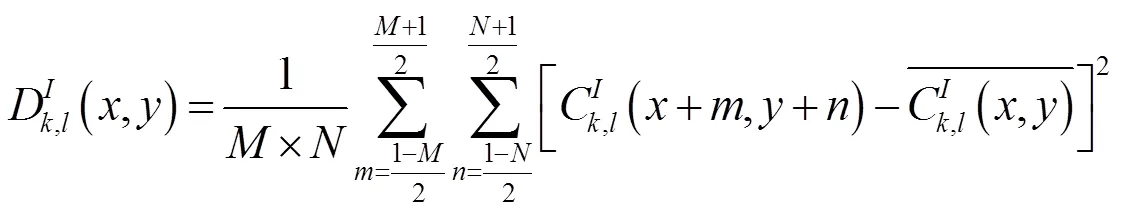

然后根据振幅谱()求输入图像的残差谱,谱残差为图像Log谱与平均频谱的差值,计算公式如下:

()=log(()) (4)

()=()*h() (5)

()=()-() (7)

式中:()表示图像的Log谱;()表示平均频谱;h()表示局部×均值滤波器;()表示输入图像的残差谱。

最后根据残差谱()与先验信息中的相位谱()进行傅里叶逆变换,就能够得到输入图像的显著性谱(),计算公式如下:

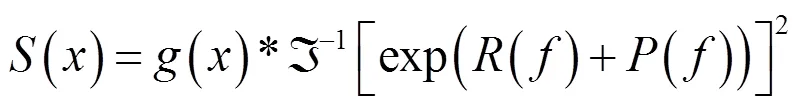

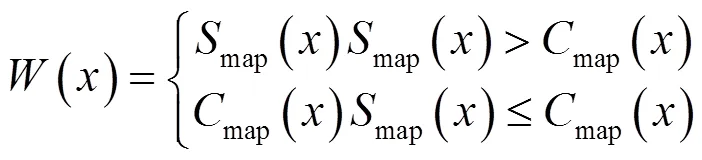

虽然Spectral Residual显著性检测算法运算效率高,但其只能在一定程度上给出显著性区域的位置,并不能得到视觉效果良好的显著性图,如图1~图2所示。

图2 场景2红外图像以及显著性图

为了得到视觉效果更好的显著性图,本文在SR显著性检测算法的基础上进行改进,引入输入图像中每个像素点的全局对比度,计算公式如下:

式中:contrast(I)表示输入图像中像素点的全局对比度;I表示像素点的灰度值;I表示输入图像中任意像素点的灰度值;I与I的取值都在[0,255]范围内,||×||表示灰度距离度量。然后分别对残差谱()与全局对比度contrast(I)进行归一化处理:

在map()与map()中,系数越大表示显著性越强,因此在对map()与map()进行融合时,采用最大值选择规则,具体的融合规则如下:

改进前后的显著性图如图3~图4所示:

图3 场景1算法改进前后显著性图

图4 场景2算法改进前后显著性图

经过改进后的显著性图不仅有效地保留了红外图像中显著性目标的边缘信息,显著性图的视觉效果也有了明显的提升。

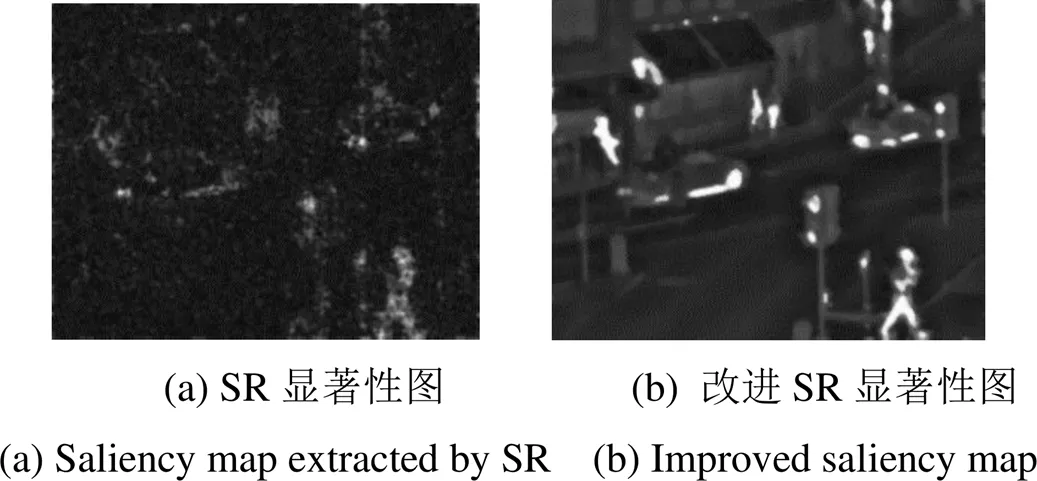

1.2 双树复小波变换

为了克服传统小波变换在方向选择性以及平移不变性上的局限,Kingsbury对传统小波变换进行了改进,提出双树复小波变换[7]:双树复小波变换对输入图像的行和列分别进行独立的离散小波变换(两个独立的离散小波变换也称为双树复小波变换中的树a和树b),最终形成一种双树结构。

如图5所示,树a作用于输入图像的行,树b作用于输入图像的列,0表示树a对应的低通滤波器,1表示树a对应的高通滤波器,0表示树b对应的低通滤波器,1表示树b对应的高通滤波器,¯2表示降采样(隔点采样)。每一级分解能够得到两个低频子带(+1,1)、(+1,2),低频子带还可以继续分解从而得到不同尺度下的高、低频成分;每一级分解获得低频子带的同时,还能够得到6个不同方向上的高频子带(+1,),(=1, …, 6),高频子带的方向分别为±15°、±45°、±75°。

相较于传统小波变换,双树复小波变换不仅保留了传统小波变换的优点,还具备方向选择性(6个方向:±15°、±45°、±75°)以及近似平移不变性,能有效提高输入图像分解以及重构的精度,提高图像融合的质量。

图5 双树复小波分解示意图

1.3 图像融合规则设计

本文图像融合算法主要分为低频部分融合以及高频部分融合两部分,具体的融合算法流程如图6所示。

图6 融合算法流程图

1.3.1 低频系数融合

经过双树复小波变换后,源图像的能量主要集中在低频部分,为使融合后的图像具有高对比度以及良好的视觉效果,本文在上述工作的基础上利用红外图像的显著性图进行低频系数的融合,具体的融合规则如下:

F()=()×IR()+[1-()]×Ⅵ() (13)

式中:F()表示融合图像的低频部分;IR()表示红外图像低频部分;Ⅵ表示可见光图像低频部分;()为改进后的显著性系数。

1.3.2 高频系数融合

经过双树复小波变换得到的源图像的高频部分反映图像的边缘信息,会对融合图像的细节产生较大影响。局部方差是度量高频部分不同区域包含源图像信息量多少的常用方法[11],局部方差计算公式如下:

局部方差越大表明对应区域所包含的源图像的信息量越多,因此可以根据局部方差极大值规则进行图像高频部分的融合,具体的融合规则如下:

2 实验结果及分析

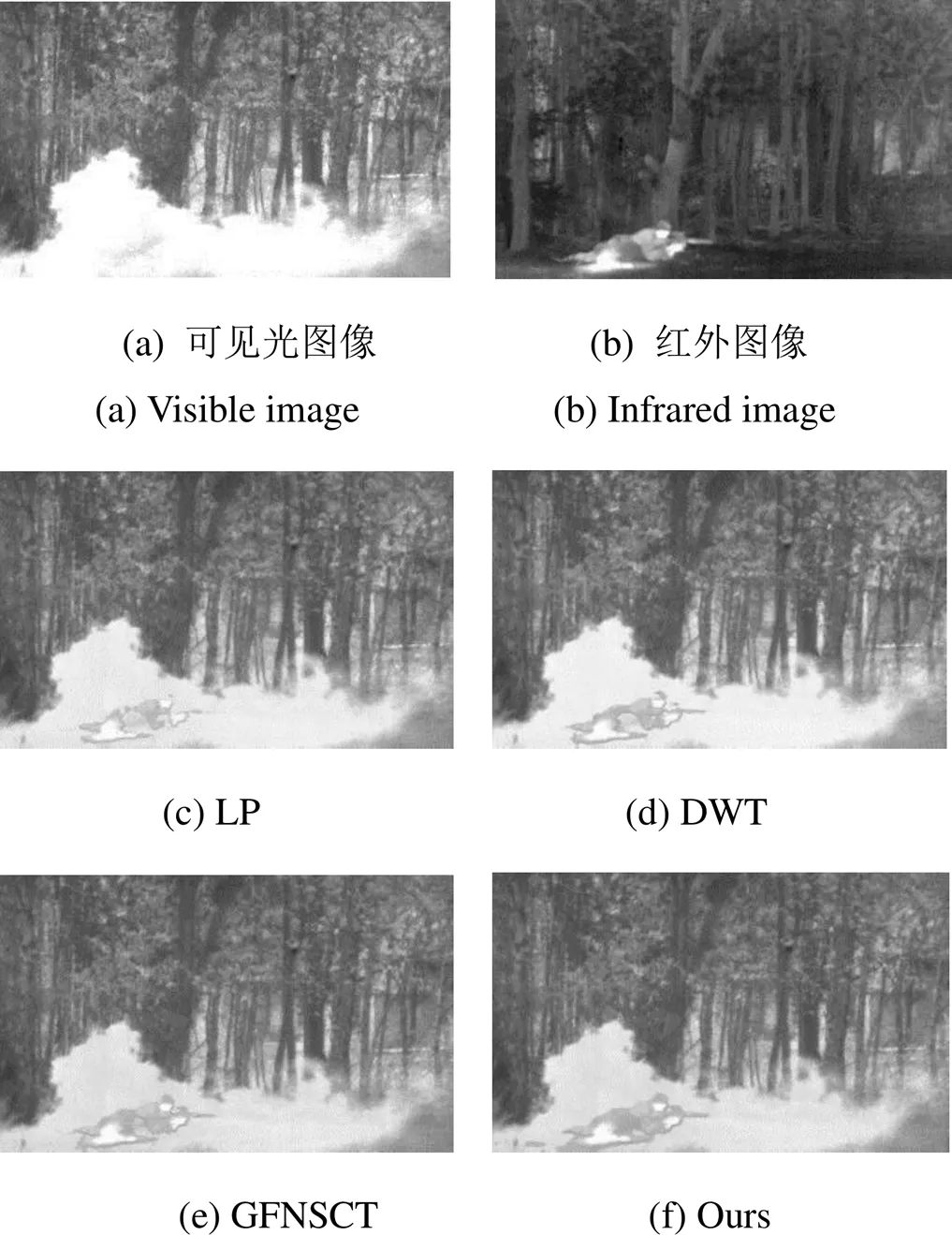

为了验证本文基于改进谱残差显著性图的红外与可见光图像融合算法的有效性,本文选取3组已配准的红外与可见光图像,并使用多种经典的融合算法对选取的图像进行融合,评估不同融合算法的融合效果。本文使用的对比融合方法包括:拉普拉斯金字塔变换(Laplacian Pyramid,LP)、离散小波变换(Discrete Wavelet Transform,DWT)、基于视觉显著性与对比度增强的图像融合(Guided-filtering Nonsubsample Contourlet Transform,GFNSCT)[12]以及本文提出的基于改进谱残差显著性图的红外与可见光图像融合算法,其中用于对比实验的拉普拉斯金字塔变换、离散小波变换,在低频部分直接进行算术平均,高频部分取绝对值最大系数。

2.1 图像主观评价

各种对比算法融合结果如图7~图9所示。

图7 场景1融合结果

图8 场景2融合结果

图9 场景3融合结果

从主观上评价,本文提出的融合算法呈现了更多的图像细节,在图7中车辆以及商铺轮廓清晰,图8、图9中树枝处的纹理细节也清晰可见。与此同时本文提出的融合算法在对比度方面也有着明显的提高,并且在融合图像的视觉效果方面明显优于传统的融合算法,这点在图7中体现得最为明显。

2.2 图像客观分析

在本文中采用标准差(Standard Deviation,SD)、信息熵(Information Entropy,IE)、空间频率(Spatial Frequency,SF)、互信息(Mutual Information,MI)[13]以及c[14]5个客观评价指标对融合结果进行量化评价。

式中:表示图像灰度的平均值,SD反映融合图像的对比度,标准差越大融合图像对比越明显。

式中:RF与CF分别为图像的行频率与列频率;空间频率体现融合图像频谱的丰富度;空间频率越大融合图像越清晰。

式中:R,F(,)为理想图像R与融合图像F的归一化联合直方图分布;R()与F()分别为图像的归一化边缘直方图分布;为灰度级数。互信息反映融合图像从源图像中获取信息的丰富程度,互信息越高,表明融合图像与源图像关联度高。

式中:p表示图像中灰度值为的像素所占的比例。图像信息熵是一种特征的统计形式,能够反映图像平均信息量的多少。

c是基于人眼视觉系统提出的融合图像评价标准,c值越大表明融合图像的视觉效果越好。

本文所有运算均在同一台电脑上运行,配置1.8GHz四核CPU,16GB运行内存,所有实验都建立在Matlab 2014a平台上。

客观评价指标如表1所示。从表中可以看出,本文算法在信息熵、空间频率、互信息以及c等5方面明显优于传统算法,证明其在图像信息量、对比度以及人眼视觉效果等方面比传统融合算法有着显著提升,与上文主观评价所得到的结果一致。与GFNSCT融合算法相比,对于空间频率这一指标的差距并不明显,这是因为本文算法所选择的双树复小波变换方法虽然具有近似平移不变性,但仍需进行上、下采样,导致融合图像清晰度不高,最终体现于空间频率这一指标并不突出;但对其他4个指标而言,本文算法均有明显提升,其中c的提升最为明显,说明本文算法在融合图像视觉效果方面的提升尤为明显。

3 结语

本文在改进谱残差显著性模型的基础上,提出了一种基于显著性图的红外与可见光图像融合方法。首先对红外图像进行显著性分析,提取显著性图,接着对源图像进行双数复小波变换,并根据显著性图设计低频部分的融合规则,最终得到质量更高的融合图像。实验结果表明,本文方法有效可行,且得到的融合图像在图像信息、图像对比度尤其是视觉效果这些方面有着显著提升。

表1 融合图像客观评价结果

Table 1 The objective evaluation results of fused images

[1] 敬忠良, 肖刚, 李振华. 图像融合——理论与应用[M]. 北京: 高等教育出版社, 2007.

JING Zhongliang, XIAO Gang, LI Zhenhua.[M]. Beijing: Higher Education Press, 2007.

[2] 刘信乐. 热红外图像与可见光图像融合方法研究[D]. 成都: 电子科技大学, 2013.

LIU Xinle. Research on Fusion Method of infrared image and visible image[D]. Chengdu: University of Electronic Science and Technology of China, 2013.

[3] 余美晨, 孙玉秋, 王超. 基于拉普拉斯金字塔的图像融合算法研究[J].长江大学学报: 自然科学版, 2016, 13(34): 770-776.

YU Meichen, SUN Yuqiu, WANG Chao. Image fusion algorithm based on Laplacian pyramid[J]., 2016, 13(34): 770-776.

[4] Ashish V Vanmali, Vikram M Gadre. Visible and NIR image fusion using weight-map-guided Laplacian–Gaussian pyramid for improving scene visibility[J]., 2017(6): 1063-1082.

[5] Gonzalo P, Jesus M A wavelet-based image fusion tutorial[J]., 2004, 37(9):1855-1872.

[6] Seal Ayan, Bhattacharjee Debotosh, NasipuriMita. A trous wavelet transform based hybrid image fusion for face recognition using region classifiers[J]., 2018(12): 2185-2188.

[7] 王少杰, 潘晋孝, 陈平. 基于双树复小波变换的图像融合[J]. 核电子学与探测技术, 2015, 35(7): 726-728.

WANG Shaojie, PAN Jinxiao, CHEN Ping. Image fusion based on DT-CWT[J].2015, 35(7): 726-728.

[8] 林子慧, 魏宇星, 张建林, 等. 基于显著性图的红外与可见光图像融合[J]. 红外技术, 2019, 41(7): 640-645.

LIN Zihui, WEI Yuxing, ZHANG Jianglin, et al. Image fusion of infrared image and visible image based on saliency map[J]., 2019, 41(7): 640-645.

[9] TIAN Huawei, FANG Yuming. Salient region detection by fusing bottom-up and top-down features extracted from single image[J]., 2014, 23(10): 4389-4397.

[10] HOU X, ZHANG L. Salient detection: A spectral residual approach[C]//, 2007: 18-23.

[11] 郭玲, 杨斌. 基于视觉显著性的红外与可见光图像融合[J]. 计算机科学, 2015, 42(6): 211-214.

GUO Ling, YANG Bin. Image fusion of infrared image and visible image based on visual saliency[J]., 2015, 42(6): 211-214.

[12] 张承鸿, 李范鸣, 吴滢跃.基于视觉显著性与对比度增强的红外图像融合[J]. 红外技术, 2017, 39(5): 421-426.

ZHANG Chenghong, LI Fanming, WU Yingyue. Image fusion of infrared image and visible image based onvisual saliency and contrast enhancement[J]., 2017, 39(5): 421-426.

[13] ZHENG Y F, Essock E. A new metric based on extended spatial frequency and its application to DWT based fusion algorithms[J]., 2007, 8(2): 177-192.

[14] QU G, ZHANG D, YAN P. Information measure for performance of image fusion[J]., 2002, 38(7): 313-315.

Image Fusion of Infrared and Visible Images Based on Residual Significance

LI Chenyang1,DING Kun1,2,WENG Shuai1,WANG Li1

(1. Hohai University, Changzhou 213022, China; 2. Photovoltaic Key Laboratory of Jiangsu Province, Changzhou 213022, China)

To make the fusion image show more image details and to obtain a better image visual effect, a fusion method based on residual significance is proposed. First, the infrared image is analyzed using residual significance to obtain its significance coefficients. Then, the source images are decomposed using a dual-tree complex wavelet transform, and the low- and high-frequency components are fused according to different fusion rules. Finally, the fusion image is reconstructed using the inverse transformation of a dual-tree complex wavelet. Experimental results showed that the fusion method proposed in this paper produced higher quality images and better visual effects than those of the traditional fusion method.

spectral residual significance, image fusion, dual-tree complex wavelet transform, fusion rules

TP751.1

A

1001-8891(2020)11-1042-06

2019-12-15;

2020-09-07.

李辰阳(1995-),男,硕士研究生,主要从事图像处理方面的研究。E-mail:576419467@qq.com

国家自然基金项目(51777059);江苏高校“青蓝工程”;六大人才高峰工程(GDZB-006)。