基于计算机视觉的无人机物体识别追踪

2020-07-14李杰刘子龙

李杰 刘子龙

摘 要:提出一种将ROS系统的AR.Drone飞行器作为载体,基于飞行器实现物体识别追踪的具体优化方案。在计算机视觉方面,结合物体识别OpenCV模块中的Haar级联分类器与卡尔曼滤波,实现无人机的目标识别以及对错误目标的过滤功能,使飞行器在搭载摄像头模块后,可结合现有视觉模型完成目标识别要求,算法融合后的系统性能具有良好的鲁棒性;在飞行器控制方面,结合飞行器自身的反馈控制模块与基于相对位置控制的PD位置控制器,优化飞行器自身姿态及目标追踪过程中的动态参数调节优化功能,使飞行器在目标追踪过程中具有良好的自适应性。基于以上两点优化方案建立实验模型,取得了较好的实验效果。具体相对位置估计均方根误差实验结果为:在x方向上为0.124 Sm,在v方向上为0.243 7m,在z方向上为0.176 8m,证明了该优化方案的实用性。

关键词:计算机视觉;无人机;目标识别;目标追踪;ROS系统;OpenCV

DOI: 10. 11907/rjdk.191475

开放科学(资源服务)标识码(OSID):

中图分类号:TP301

文献标识码:A

文章编号:1672-7800(2020)001-0021-04

0 引言

在计算机视觉领域,物体识别算法框架的发展已趋于稳定,目前的计算机视觉已能够应用于大部分场景[1-6]。无人驾驶飞行器[7-8]( Unmanned Aerial Vehicle,UAV)是一种兼具飞行、垂直起降等功能,具有较好机动性的小型机器人,在融合计算机视觉技术后,广泛应用于无人机导航、定位着陆、飞行避障、视觉同步定位与建图( Simultaneous Lo-calization and Mapping,SLAM)等方面。无人机物体识别追踪技术利用无人机作为载体,结合计算机视觉技术,在飞行过程中结合飞行高度与视角,提取目标物体图像特征并对特征信息进行处理,同时结合相对位置控制算法,实现追踪功能。

无人驾驶飞行器在发展过程中,必然会经历具备自主飞行能力的阶段,而在自主飞行技术中,视觉追踪技术是其中最为重要的。无人机由军用与民用飞机演变而来,在定位方面,飞机上通常采用ADS-B广播式自动相关监视系统与扫描雷达系统相融合实现自身定位,而早期大型无人机也沿用这种思路,通过GPS卫星确定飞机自身位置,定期向外广播自身位置与航向。由于GPS卫星及雷达的成本非常高,随后出现一种通过“看见”目标佩戴的GPS跟踪器实现追踪目的的特殊无人机,类似Lily Camera。该技术识别目标的能力较强,但也有着明显缺点,受额外GPS追踪器的限制,使其暂时难以得到广泛应用。另一种方案是使用摄像头与超声波接发装置,使无人机能用光学或声学方式扫描周围空间。如大疆的高端无人机“悟”,即凭借该技术可以在没有GPS的室内进行简单的悬停。但无论是光学摄像头还是超声波,都要依靠信号差进行判断,因而无力应对反差小或者消声、吸光的地面状况。近年来随着深度学习技术在计算机视觉领域的快速发展,使无人机依靠高性能芯片自主提取与识别跟踪目标特征,从而实现物体的自动识别追踪成为可能。

本文融合计算机视觉领域与机器人领域技术,提出飞行器在目标识别追踪[9-13]过程中的一种优化模型。该模型改进了飞行器在目标识别追踪过程中的视觉估计误差匹配精度,达到了更好的人机交互效果。

1 整体系统描述

本实验采用四旋翼飞行器AR.Drone Parrot,飞行器模型见图1。

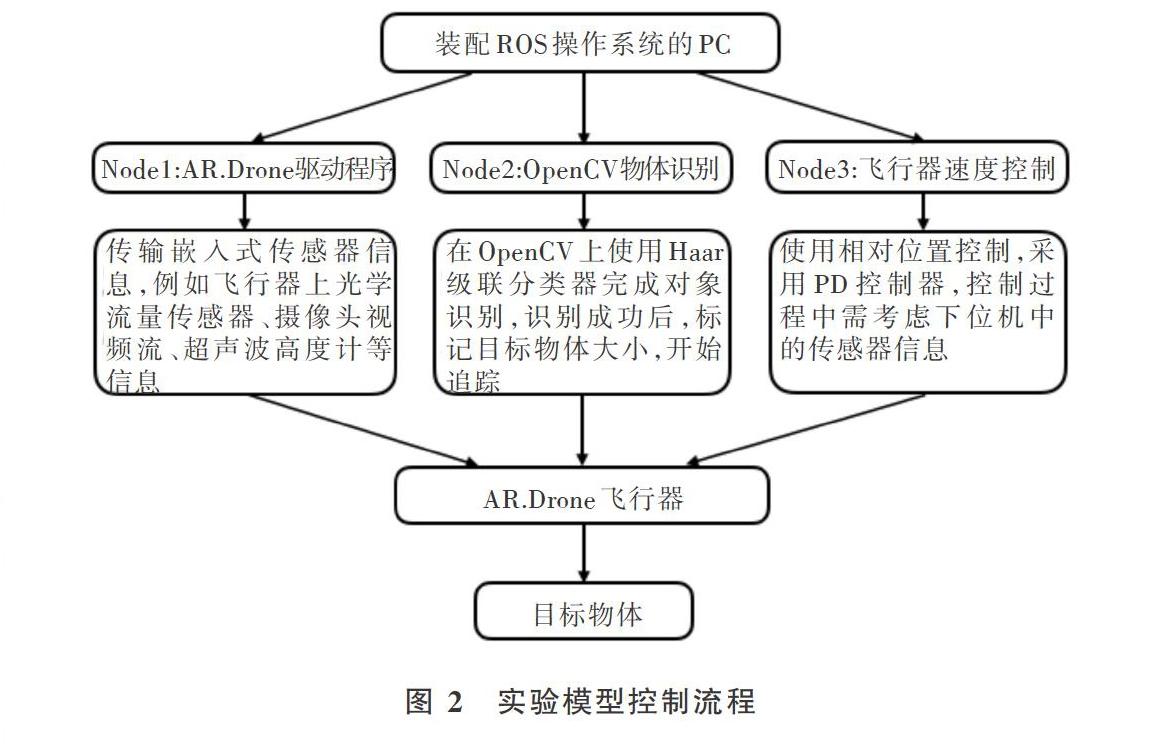

由于该飞行器体积小、质量较轻,并且有泡沫机身保护,因而可以很好地应对个人实验项目。在硬件设施上,该无人机配备有三轴陀螺仪与加速度计、超声波高度计、气压传感器和磁罗盘。此外,其包含两个摄像头:飞行器前部有带90。角镜头的摄像头,分辨率为1280×720像素,采样频率为30 fps,用于对实时视频流与图像进行记录;飞行器底部有一个微型摄像头,分辨率为320×240像素,采样频率为15 fps,可用于估算水平光流速度。飞机本身嵌入Linux系统,因此可通过WiFi使飞行器与手机等电子产品进行交互。但該飞行器的软件和硬件都采用封闭式架构,需要使用一台装配ROS操作系统[14]的PC作为上位机,通过上位机各模块节点实现对下位机驱动程序的控制。实验模型控制流程见图2。

2 视觉对象识别与跟踪

2.1 物体识别算法

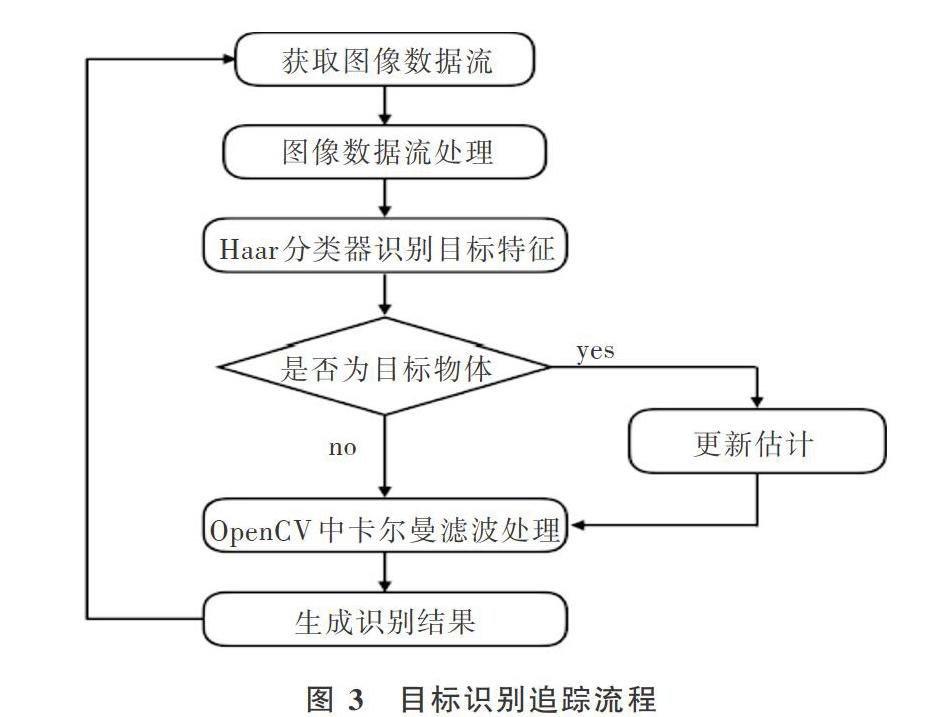

实验过程中飞行器正前方摄像头以BCR格式、30Hz速率传输图像,通过上位机中的OpenCV库进行视频流分析,并使用内核为Sx5的模糊滤波器对图像进行平滑处理,实现降噪功能,从而减少因高频噪声引起的误报检测次数。同时,使用直方图均衡化改善图像对比度。ROS系统调用OpenCV库中的Haar分类器[15-17]对目标进行识别,并通过卡尔曼滤波器选择跟踪识别目标。目标识别追踪流程见图3。

Haar分类器是一种监督分类器,其通过图像的不同级别级联使用H aar-like特征进行检测,以确定是否存在预先训练的指定目标物体图片。此外,Haar分类器还使用积分图(Intergral Image)对Haar-like特征求值进行加速,采用AdaBoost算法训练区分具有特定特征的强分类器,并使用筛选式级联方式将强分类器级联结到一起,以提高准确率。

2.2 目标追踪模型构建

卡尔曼滤波[8-20j( Kalman Filter)是一种高效率的递归滤波器(自回归滤波器),其能够从一系列不完全及包含噪声的测量中,估计动态系统状态。为了增强算法对抗遗漏检测的稳健性,以及在离散时间内的类似场景都能识别出训练过的目标对象,在目标追踪分类器上考虑使用卡尔曼滤波器。随着离散时间的增加,线性算子则会作用在当前状态上,产生一个新的状态,同时会带入一些噪声,并且系统一些已知控制器的控制信息也会被加入。

本文控制算法基于真实实验模拟场景,见图4。对于每个被跟踪的目标,飞行器会在离散时间内对目标建立运动学模型。

在卡尔曼滤波处理中有两个过程:当检测窗口的值小于某个门限值时采用卡尔曼滤波器,否则采用修正后的卡尔曼滤波算法。当飞行器在识别过程中捕获多个目标时,分类器会识别与先前估计值最接近的目标。若正确识别目标,则更新卡尔曼滤波估计值,并用选框标记出来进行追踪,追踪过程中会更新卡尔曼滤波测量矢量参数;若识别多目标时出现错误,则进行算法流程迭代,追踪过程中更新卡尔曼滤波估计,最终正确识别目标并进行检测。

2.3 相对位置控制模型

为了保证飞行器在目标追踪过程中有良好的自适应性和鲁棒性,获得完整的目标状态信息反馈,需要飞行器在飞行过程中对目标物体保持恒定距离。将飞行器相对位置控制转换成具有时变参考的三维位置控制,可以使用PD位置控制器对控制回路进行补偿,则飞行器动态模型如下:

3 算法实验与分析

为了更好地研究飞行器在实际目标识别追踪过程中的性能,采用基于室内和室外两种不同背景条件的检测方法。在室内条件下,由于实验背景的单一性及外部噪声较少,飞行器在目标识别与追踪过程中可以实现快速响应,因此室内试验条件可用于测试计算机视觉算法融合结果。在室外实验条件下,飞行器受光照、风力、背景等噪声干扰较大,对其目标识别与追踪性能造成一定干扰,则可以测试动态视觉相对位置估计误差。

3.1 计算机视觉算法融合结果分析

针对计算机视觉算法融合结果的分析,是指在卡尔曼滤波控制飞行器位姿基础上,融合Haar级联分类器对目标的视觉算法结果进行分析。Haar级联分类器可以预先训练目标识别权重,卡尔曼滤波则有助于过滤识别的错误目标,从而提高系统运算速度,并使其具有较好的鲁棒性。实验数据见图5。

3.2 计算机视觉估计误差结果分析

视觉估计误差结果见图6。从图中可以看出,在离散时间内,飞行器基于自身姿态相对位置估计误差值比较稳定。对实验数据进行处理后可以得出,在x、y、z3个方向上,相对位置估计均方根误差的实验结果分别为0.124 5m、0.243 7m和0.176 8m。

本文提出的飞行器目标识别追踪算法在实验中表现出良好性能,不论是在室内还是室外环境中,飞行器都能较好地应对外界噪声,证实了系统的有效性、自适应性与鲁棒性。

同时,本次实验也存在一些不足。首先本实验基于计算机视觉技术识别目标物体,对特征不明显或未经过训练的目标会出现识别错误等情况;其次是在飞行器追踪功能中,采用相对位置控制以保证飞行器始终能获取目标特征,但对于偏航造成的目标特征丢失过程缺乏鲁棒性;受实验条件限制,本实验飞行器追踪速度恒定,不适用于追踪移动速度较快的目标。

4 结语

本文基于一种能够搭载ROS系统的飞行器实现目标识别与追踪功能。硬件设备使用AR.Drone与一台装配了ROS机器人系统的上位机,通过上位机节点通信功能实现对飞行器的控制以及物体识别与追踪。在计算机视觉算法中,目标识别可通过Haar级联分类器加以实现,同时调用卡尔曼滤波追踪被标记的目标。在飞行器追踪过程中,通过PD控制模型使飞行器在离散时间内完成与目标物体的相对位置调节,最终完成状态反馈。未来希望能够在本实验数据基础上,通过融合机器人及计算机视觉领域相关技术,进一步改善人机交互过程,使智能机器人能够更好地服务于人们的生产和生活。

参考文献:

[1] CHEN C H.Handhook of pattern recognition and computer vision[Ml. USA: World Scientific. 2015.

[2]DONALD G,STUART G,NEIL H, et al.Visual tunng test for com-puter vision systems[Jl. PNAS March, 2015, 112( 12): 3618-3623.

[3]SURAJ S,RAVI K S,KONDA R M, et al.A taxonomy of deep convo-lutional neural nets for computer vision[J].Front.Robot.AI. 2016,2(36):1-13.

[4]STANISLAV E,DMITRY M,ALEKSANDR I,et al.Multilayer cogni-tive architecture for UAV control [J]. Cognitive Systems Research,2016, 39: 58-72.

[5]曹美会,鲜斌,张旭,等.基于视觉的四旋翼无人機自主定位与控制系统[J].信息与控制,2015,44(2):190-196.

[6] 刘锦涛,吴文海,李静,等.四旋翼无人机风场扰动轨迹控制器设计[J].飞行力学,2016, 34(2):47-54.

[7]郁一帆,王磊.无人机技术发展新动态[J].飞航导弹,2019(2):34-42.

[8]LAV G,RAJ J,GABOR V.Survey of important issues in UAV com-munication net,vorks[J].IEEE Communications Survevs& Tutorials,2016, 18(2):1123-1152.

[9]DAWEI D,YUANKAI Q, HONCYANC Y. et al.The unmanned aeri-al vehicle benchmark: object detection and tracking[C].The Europe-an Conference on Computer Vision( ECCV), 2018: 370-386.

[10]CUSTAV H, COUTAM B, MARTIN D.Combining visual trackingand person detection for long term tracking on a UAV [Jl. Interna-tional Symposium on Visual Computing, 2016, 10072: 557-568.

[11]L1 J,YE D H. CHUNG T,et al.Multi-target detection and trackingfrom a single camera in unmanned aerial vehicles( UAVs)[ C]. 2016IEEE/RSJ International Conference on Intelligent Robots and Sys-tems (IROS). IEEE, 2016

[12] 张音哲,刘贵喜,李斯,等.无人机多机动目标自主探测与跟踪[J].控制理论与应用,2015,32( 11):1561-1566.

[13]朱晓钢,杨兵,许华杰.支持无线传感器网络多目标跟踪的最邻近数据关联算法研究[J].计算机科学,2011, 38(5):67-70.

[14]ANIS K.Robot Operating System (ROS)[ M]. Saudi Arabia: Spring-er, Cham.2016.

[15] 閆河,王鹏,杨晓龙,等.一种新的AdaBoost人脸检测方法[Jl.重庆理工大学学报:自然科学,2019, 33(2):106-110, 161.

[16] 张雪芹,方婷,李志前.基于类Haar特征和AdaBoost的车辆识别技术[J].华东理工大学学报,2016,42(2):260-265.

[17]张丹丹,李雷.基于PCANet-RF的人脸检测系统[J].计算机技术与发展,2016, 26(2):31-34.

[18]崔培林,周翟和,吕品,等.自适应误差四元数无迹卡尔曼滤波四旋翼飞行器姿态解算方法[J].西安交通大学学报,2019, 53(3):97-102. IlO.

[19]CARCIA R V, NICHOLAS D F O M. KUGA H K, et al.UnscentedKalman filter for spacecraft atitude estimation using modified Ro-drigues parameters and real data [Jl. Computational and AppliedMathematics. 2016.35(3): 835-846.

[20]乔少杰,韩楠,朱新文,等.基于卡尔曼滤波的动态轨迹预测算法[J].电子学报,2018, 46(2):418-423.

[21]YONGPINC P,HAOYONG Y, TAIREN S. Global asymptotic stabi-lization using adaptive fuzzy PD control[ J].

IEEE, 2015, 45(3):574-582.

[22]TOLGAY K. ALI H M. Adaptive PD-SMC for nonlinear robotic ma-nipulator tracking control [Jl. Studies in Informatics and Control,2017. 26(1):49-58.

(责任编辑:黄健)

基金项目:国家自然科学基金项目( 61573246)

作者简介:李杰(1994-),男,上海理工大学光电信息与计算机工程学院硕士研究生,研究方向为机器人控制、图像处理;刘子龙(1972-),男,上海理工大学光电信息与计算机工程学院副教授、硕士生导师,研究方向为嵌入式系统、控制科学与控制理论、机器人控制。