基于道路试验的跟车场景挖掘系统设计

2020-06-24黄昆刘兴亮武一民朱世豪张晓坤

黄昆 刘兴亮 武一民 朱世豪 张晓坤

(1.河北工业大学,天津 300401;2.中国汽车技术研究中心有限公司,天津 300300)

主题词:跟车 场景挖掘 道路试验 智能网联汽车

1 前言

目前,智能驾驶汽车的研发与验证方法主要分为4类,即实车路试、场地测试、台架测试和仿真模拟。通过技术的不断提升和道路试验的积累,可以实现人、车、环境等要素的数据化,随着要素虚拟程度的提高,智能车辆研发与验证的速度也不断加快。

根据部分知名厂商智能车辆研发与验证的经验,从实车路试到仿真模拟的发展需要经历3个步骤:道路数据信息化、场景提取与挖掘、场景生成与重构。其中,道路数据信息化为要素的数据化提供原始数据,需要进行大量的道路试验。场景提取与挖掘为车辆研发验证过程中的虚拟仿真提供丰富的素材,如欧洲大型实车路试(European Field Operational Test,EuroFOT)项目[1]和中国大型实车路试(China Field Operational Test,China-FOT)项目[2]。场景生成与重构是要素虚拟化成熟的标志,可以极大地提高智能驾驶汽车研发与验证的速度。

本文设计跟车场景动态要素的挖掘系统,依托VECTOR 公司的CANape 软件对跟车场景的本车速度、相对速度、车头间距、横向距离、转向盘转角、车头时距(Time Head Way,THW)、即时碰撞时间(Time to Collision,TTC)等进行挖掘,并留有并联接口,可以通过输入信号及时间处理器增加工程应用中所需要的信号,既可以实现离线跟车场景挖掘,又可以实现在线数据挖掘,以期完成跟车场景数据库的搭建,为自适应巡航控制(Adaptive Cruise Control,ACC)系统跟车部分的数学模型搭建提供数据支持。

2 跟车场景挖掘的控制策略

2.1 场景挖掘的系统架构

如图1所示,跟车场景挖掘的系统架构由数据采集层、数据接收层和数据后处理层组成。其中,Mobileye ME630 用于检测本车的跟随目标和判断目标物的车道位置信息,摄像头用于记录本车前向、左向和右向的视频数据信息,作为人工评判的依据。存储在数据接收层的信号及视频数据通过CANape 的I/O 口实现CANape到Simulink间的信息传递,通过主程序对采集到的信号进行跟车场景挖掘和输出。

图1 跟车场景挖掘系统构架

该跟车场景挖掘系统在离线状态下可通过CANape和Simulink 联合仿真挖掘提取跟车场景的动态要素信息,在道路试验中,将程序嵌入与总线连接的VECTOR工控机,能够实时进行跟车场景挖掘的工作。

数据后处理层由车辆空间位置模块、跟车目标选择模块、跟车约束模块、信号及时间片断处理模块组成。其中,空间位置模块和跟车目标选择模块通过目标与本车的空间位置筛选出跟车目标,并通过跟车约束模块对跟车场景进行实时的跟车中断判定,得到跟车的时间片段,信号及时间片断处理模块通过对输入信号进行时间片段处理,保留跟车场景数据,删除非跟车场景数据。

2.2 车辆空间位置模块

本文设计的跟车场景挖掘程序将目标车辆与本车的空间位置作为主要的车辆跟驰判定参数,包括车头间距和相对横向距离,可通过毫米波雷达采集的数据计算获得。定义空间位置辅助系数r,当目标满足跟车的空间位置条件时,取r=1,否则取r=0。车辆空间位置模块如图2所示。

图2 车辆空间位置模块

车辆空间位置模块的输入参数为本车与目标物的相对距离R和偏航角α,可通过毫米波雷达和角毫米波雷达进行数据采集,模块的输出量为本车与目标的车头间距Ry、相对横向距离Rx以及空间位置辅助系数r,计算如下:

当Rx和Ry同时满足跟车的空间位置约束时,即目标车辆位于本车所在车道前方0~150 m的范围内[3],r的输出值为1,否则为0。

2.3 跟车目标选择模块

跟车目标选择模块对满足跟车空间位置要求的所有目标车辆的车头间距进行比较,选择车头间距最小的目标车辆作为跟车目标,确保所选的跟车目标为同一车道内的相邻前车。

跟车目标的选择判断流程为:输入目标i(i=1,2,3,…,64,毫米波雷达可以探测目标的最大数量为64)的空间位置辅助系数r,若r=1,则输出目标与本车的车头间距,否则进行下一目标的判断,筛选输出所有满足空间位置要求的目标后,通过比较获得具有最小车头间距的目标i,即为最终选择的跟车目标。

2.4 跟车约束模块

跟车场景挖掘系统利用跟车约束模块对车辆的行驶状态进行实时监控,通过位置、速度、车头时距等跟车参数对跟车是否中断进行实时判定。定义跟车约束辅助系数k,作为模块对跟车判定的输出变量,当且仅当场景满足所有跟车约束条件时,k的输出值为1,否则输出0。跟车约束模块如图3 所示,输入量包括本车速度v、目标车速度vobj、目标与本车的车头间距Ry、横向距离Rx、相对速度vr、车头时距th、车道位置l,模块的输出量为跟车约束辅助系数k。

图3 跟车约束模块

跟车约束的判定条件如下:

a.为了避免本车或目标车在拥堵路段或信号灯路口处于静止状态,对本车和目标车的速度进行判定:

b.为了确保满足纵向的空间位置约束条件,对目标车与本车的车头间距进行判定:

式中,y=150 m为跟车的车头间距阈值[3-5]。

c.为了确保本车与目标车处于稳定跟车状态,对目标与本车的车头时距进行判定:

式中,thmax=5 s为跟车场景车头时距的阈值[6-11]。

d.为了确保本车与目标车处于稳定的跟车状态,对目标车与本车的相对速度进行判定:

式中,vrmax=4 m/s为前车与本车的相对速度阈值。

e.在结构化道路,即有车道线的道路上,通过判定目标的横向位置是否在左、右车道线之间[12-16]对目标车是否变道进行判定:

式中,ll、lr分别为左、右侧车道线的位置。

f.在非结构化道路,即无车道线道路上,通过目标与本车的横向距离判断目标车是否变道:

式中,x=1.2 m 为跟车状态下目标车与本车的最大横向距离[17-18]。

2.5 信号及时间片断处理模块

信号及时间片断处理模块用于记录跟车的时间片段和输出场景动态信息。定义跟车场景挖掘系数a,用以判断当前时刻是否属于跟车场景,当且仅当目标i的空间位置辅助系数r和跟车约束辅助系数k的值均为1时,取a=1,否则取a=0。

如图4所示,场景的动态信息(如本车速度、本车加速度、转向盘转角、横摆角速度、纵/横向距离、纵/横向加速度等)以场景挖掘系数a为依据进行筛选,保留属于跟车场景(a=1)的片段信息,去除非跟车场景(a=0)的片段信息并将信息数据置0。

3 场景挖掘结果

3.1 离线跟车场景挖掘

许多道路试验过程中并未进行跟车场景挖掘,为了提取和挖掘这些行程的跟车场景数据,将离线信号输入跟车场景挖掘系统进行处理,离线跟车场景挖掘实现流程如图5所示。

图4 信号及时间片断处理模块

图5 离线场景跟车景挖掘流程

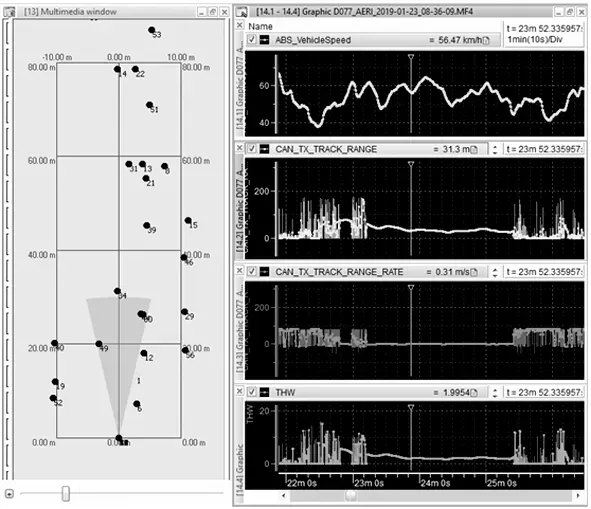

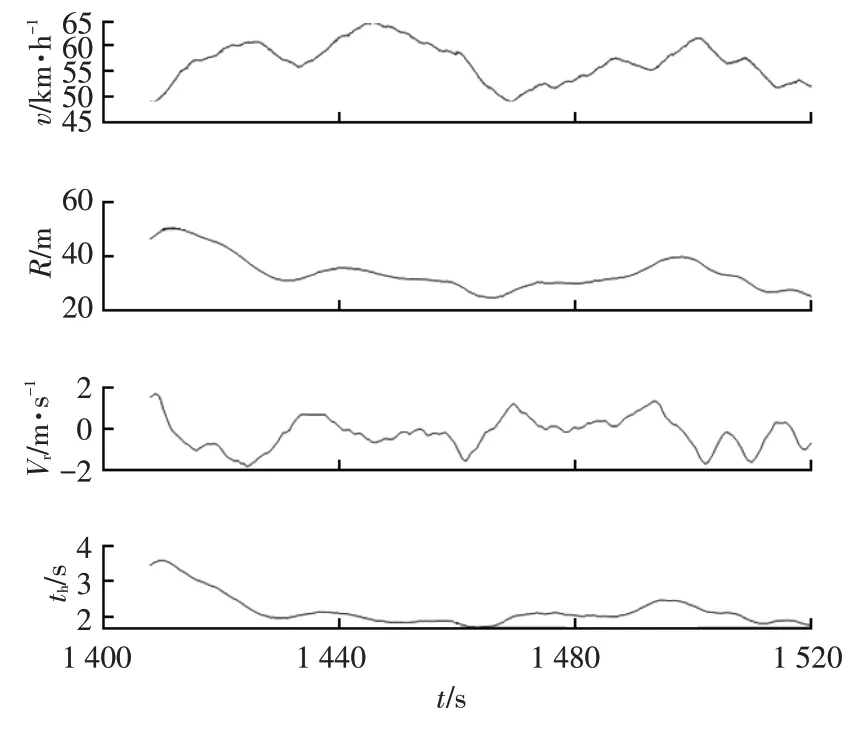

如图6 所示,样本1 为一段行程的部分原始数据(由于一段数据时间较长,此处仅截取一部分片段),在第1 408 s时,目标34和目标14同时满足跟车的空间位置要求,通过跟车目标选择模块确定本车的跟车目标为目标34,在第1 520 s 时,目标34 进行变道,跟车中断,目标34 在该时间段内空间位置辅助系数r和跟车约束辅助系数k的值均为1,因此,场景挖掘系数a的值为1,如图7所示。

图6 样本1的原始数据

图7 样本1的场景挖掘系数

样本1 的跟车场景挖掘结果如图8 所示,场景时间为第1 408~1 520 s,输出的动态要素信息包括本车速度、车头间距、相对速度和车头时距(在工程应用中可以根据实际需求增加或减少参数的数量)。

3.2 在线跟车场景挖掘

道路试验有效时间为6 天,行驶里程为1 633 km,测试地为天津。试验车为一款B 级车,如图9 所示,数据采集设备包括:激光雷达、毫米波雷达,用于监测车辆位置、姿态等信息;Mobileye ME630,用于识别静态场景要素和动态目标车辆信息;摄像头,用于记录行程的视频信息;VECTOR 工控机,用于连接车辆总线、雷达、摄像头等设备。

图8 样本1的跟车场景挖掘结果

图9 道路试验设备及场景

限于篇幅,在跟车场景挖掘系统的在线场景挖掘结果中选取3段自然驾驶行程,行程的静态要素信息如表1所示。

表1 行程静态要素信息

如图10 所示,行程1 的总时长为16 min,输出的参数为目标与本车的纵向相对距离Ry,共挖掘出14 个跟车场景的信息,其中系统漏判定1 次(毫米波雷达未检测到目标),误判定0次。

如图11 所示,行程2 的总时长为35 min,输出的参数为目标与本车的车头时距th,共挖掘出13个跟车场景的信息,其中系统漏判定0次,误判定0次。

如图12 所示,行程3 的总时长为28 min,输出的参数为目标与本车的相对速度vr,共挖掘出10个跟车场景的信息,其中系统漏判定0次,误判定0次。

图10 行程1跟车场景挖掘结果

图11 行程2跟车场景挖掘结果

图12 行程3跟车场景挖掘结果

4 结束语

本文通过研究跟车场景中目标的空间位置特征和跟车的约束条件,并结合国内外的研究成果,设计了能够提取所需动态信息的跟车场景挖掘系统。经离线仿真和道路测试验证,该系统能高效、准确地完成离线和在线跟车场景挖掘工作。其中,在线场景挖掘通过工控机将道路试验与跟车场景的挖掘良好地集成在一起,提高了跟车场景挖掘的效率。