基于滚动引导滤波的红外与可见光图像融合算法

2020-05-25邱晓华

陈 峰,李 敏,马 乐,邱晓华

〈图像处理与仿真〉

基于滚动引导滤波的红外与可见光图像融合算法

陈 峰,李 敏,马 乐,邱晓华

(高新技术研究所,陕西 西安 710025)

针对红外与可见光图像融合时,易产生细节丢失、噪声抑制不佳等问题,本文提出了一种改进的滚动引导滤波融合算法。该算法充分利用了滚动引导滤波边缘和局部亮度保持特性,在通过均值滤波将输入图像分解为基础层与细节层的基础上,结合滚动引导滤波与高斯滤波获取输入图像的显著图,利用不同尺度参数的引导滤波对显著图优化得到权重图,将权重图作为权重分别指导基础层与细节层的融合,最后联合融合后的子图重构得到融合图像。针对3类测试数据进行的融合实验表明,与非下采样轮廓波变换、基于引导滤波、基于显著性检测的两个尺度的图像融合等经典方法相比,本文方法得到的融合图像不但从主观视觉效果上细节信息更丰富、目标对比度加强,并且在非线性相关信息熵、相位一致性等6项客观评价指标上均具有较好的效果。

滚动引导滤波;显著图;图像融合;权重图

0 引言

图像融合本质上是一种图像增强技术,旨在通过提取不同传感器(如红外与可见光)或同种传感器采集的图像(如多聚焦图像)的互补信息进行融合,生成信息更丰富、图像特征更多的融合图像。红外与可见光图像融合技术是当前图像融合领域研究的热点之一。红外传感器通过捕捉目标的热辐射信息,可生成黑暗和雨雾等恶劣气候条件下的图像,图像中红外目标突出,但空间分辨率较低、细节信息较少,而场景对应的可见光图像纹理、边缘等细节信息丰富,分辨率较高。故综合这两类图像的互补信息,可生成一幅红外目标突出、纹理、边缘细节信息丰富的图像,此类图像在检测跟踪、目标识别、监控等军事和民用领域的应用更有优势。

根据采用的理论和工具的差异,目前的图像融合算法一般可分为基于多尺度变换、基于稀疏表示、基于神经网络、基于子空间、基于显著性以及上述方法结合的混合模式,其中基于多尺度变换的方法是当前该领域中研究最多的[1-2]。最早用于图像融合中的理论是基于金字塔变换和小波变换的图像融合算法[3],比如拉普拉斯金字塔[4-5]、对比度金字塔[6-7]、离散小波变换(discrete wavelet transformation,DWT)[8]等。针对离散小波变换不具有平移不变性、方向选择有限的问题,又有学者提出了融合性能更好的双树复小波变换[9]。此外,方向灵敏度更高的轮廓波变换(contourlet transform)、剪切波变换(shearlet transform)以及具有平移不变性的非下采样轮廓波变换(non-subsampled contourlet transform,NSCT)、非下采样剪切波变换(nonsubsampled shearlet transform,NSST)等多尺度变换工具也相继被众多学者用于图像融合领域,2019年Ma等人在文献[1]中对这些方法进行了综述。NSCT等多尺度变换方法首先将图像分解为高频与低频系数,然后采用不同的权重分别对高低频系数进行组合,再经逆变换得到融合图像。此类方法的融合质量较高,但时间消耗较大。

由于保边滤波器具有噪声平滑、边缘保留等特性,近年来,众多学者开始将保边滤波成功运用于图像融合中[10-13]。2013年Li等人提出一种基于引导滤波的图像融合算法[10](Image fusion with guided filtering,GFF),采用均值滤波对图像分解,结合拉普拉斯滤波和高斯滤波来获取显著图,并首次将引导滤波用于权重图的构造,解决了初始权重图目标边缘未对齐的问题。2019年,Zhang等人在文献[13]中设计了一个梯度滤波器来获取显著图,可提取更多的梯度特征。同年,Ma等人在文献[14]中提出用中值滤波图像与均值滤波图像做差值,取绝对值后,再经高斯滤波得到显著图,该方法保留的细节特征较多,但中值滤波在去噪的同时也会去除一些高频信息。2014年Zhang等人提出一种滚动引导滤波(the Rolling Guidance Filter,RGF)框架[15],区别于双边滤波、引导滤波,该滤波器可以有效消除光晕,在平滑小尺度目标的同时恢复大尺度目标边缘,2017年Ma等人结合滚动引导滤波与高斯滤波对源图像进行多尺度分解[12]。

在以上研究的基础上,本文提出结合滚动引导滤波与高斯滤波获取显著图,再利用大、小尺度参数的引导滤波对其优化分别得到基础层与细节层的权重图,利用权重图分别指导基础层与细节层的融合,最后联合融合的子图像,得到融合图像。针对3种测试数据,将本文算法与NSCT、GFF、基于多尺度变换与稀疏表示(LP and sparse representation,LPSR)等经典算法进行了实验对比分析,验证了本文算法的优越性。

1 基于滚动引导滤波的显著图提取

1.1 滚动引导滤波

滚动引导滤波是一种高效的尺度感知滤波器,在平滑小尺度目标及纹理细节时,可以迭代恢复大尺度目标的边缘。该滤波器的原理结构可细分为:小尺度结构平滑和大尺度结构边缘恢复。首先采用高斯滤波器对源图像进行小尺度结构的平滑。设为输入图像,为高斯模糊后的图像,表示为:

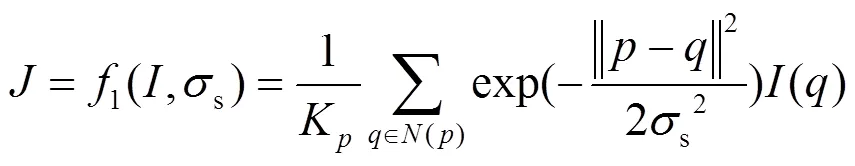

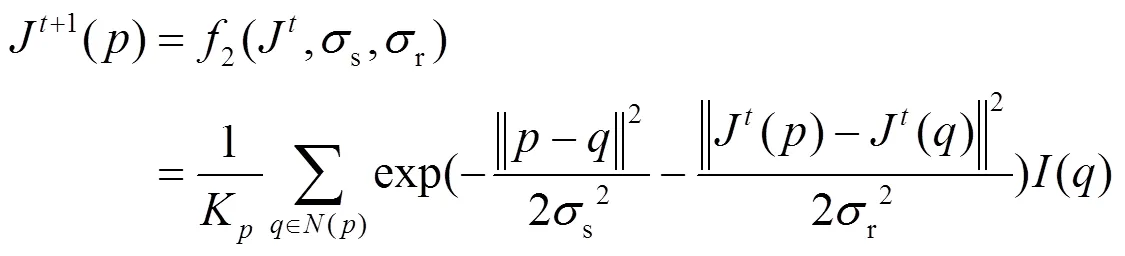

滚动引导滤波的第二步是采用双边滤波(bilateral filter,BF)[16]将第一步中高斯滤波的结果作为引导图像,初始输入图像作为输入图像,迭代恢复被模糊的大尺度结构边缘。下一次迭代的引导图像和输入图像分别为上一次迭代的输出图像、初始的输入图像。随着迭代次数的增加,被模糊掉的大尺度结构边缘会越来越清晰。据文献[15]所述,此处的双边滤波可根据实际应用需求采用引导滤波(guided filter,GF)[17]、域变换(domain-transform filter,DTF)[18]等滤波器替代,本文采用双边滤波的方案,表示为:

设=0时,0为常数,可得到滚动引导滤波的定义式:

=rgf(,s,r,) (3)

式中:为输入图像;为输出图像;为总的迭代次数。

1.2 显著图提取方法

自然图像由不同尺度的目标组成,且包含了不同的尺度结构[15],图像的显著特征通常指图像中不同目标的边缘、角等信息。

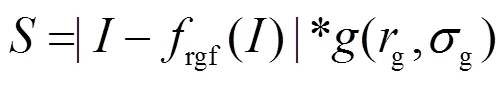

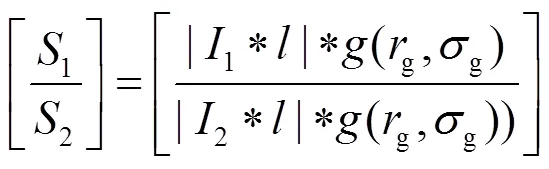

滚动引导滤波在迭代过程中通过s和r两参数控制滤波的空间(距离)权重和范围(强度)权重,可实现对图像不同尺度的有效分割,最终平滑小尺度结构的同时可准确保留目标的边缘。将滚动引导滤波用于平滑图像时,在一定范围内,s值越大,平滑掉的细节越多;r值越大,图像中保留的目标边缘也会趋于模糊。依据这一特性,可利用该滤波器提取图像的高通图像,即利用原图与经该滤波平滑后的图像做差值并取绝对值。此时s和r取值越小,高通图像保留的细节信息丰富。由于该高通图像仍含有噪声,需经高斯滤波去噪,得到噪声较少的显著图。结合滚动引导滤波与高斯滤波提取显著图的表达式可表示为:

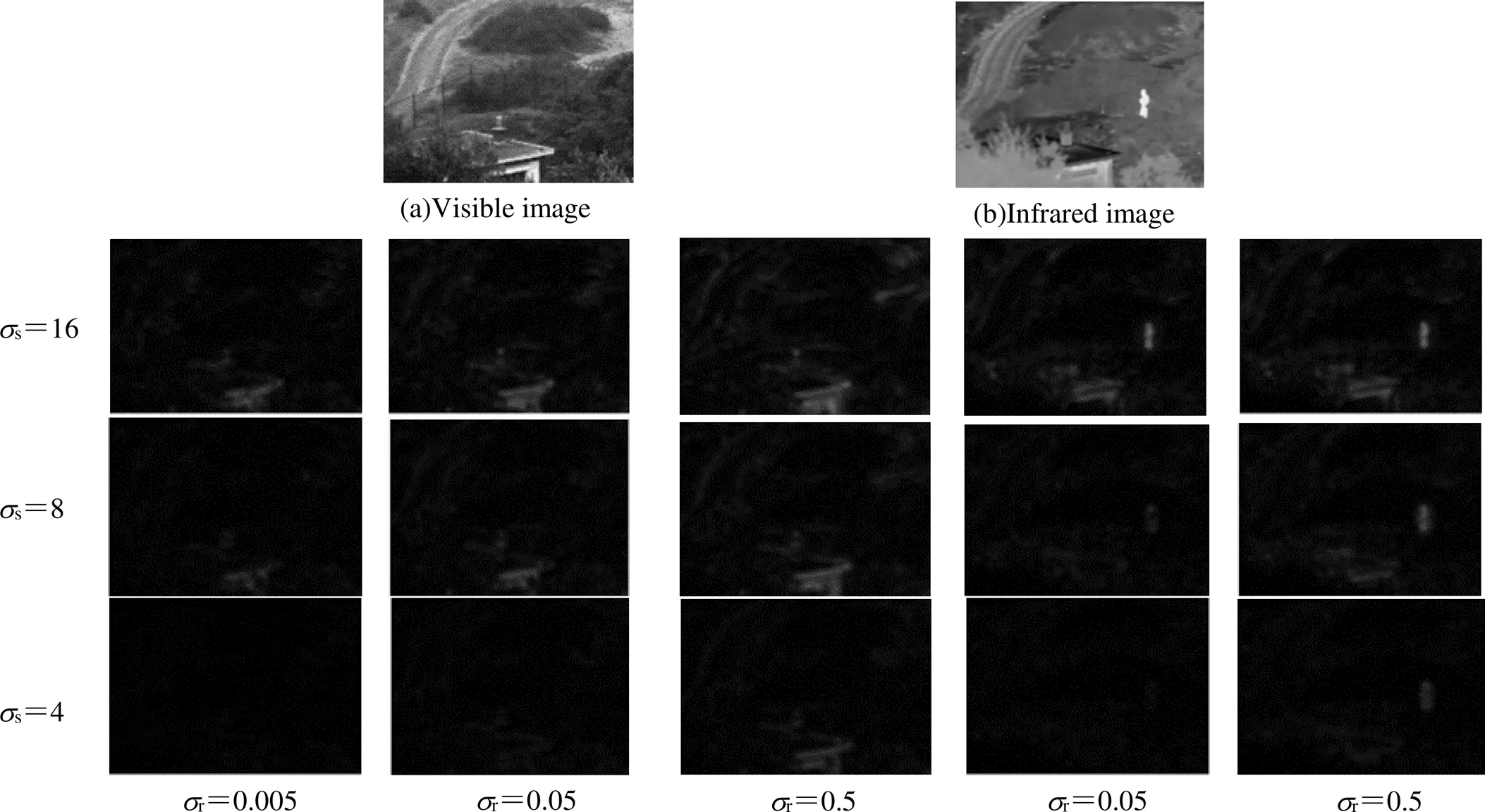

式中:表示提取的显著图;rgf(×)表示滚动引导滤波;表示高斯滤波;g和g为高斯滤波核的窗口大小和标准差,均设置为5。为进一步分析s和r两参数对提取的显著图的影响,下面分别对一组经严格配准后的红外与可见图像进行实验分析,实验图像如图1(a)、图1 (b)所示。

在图1中,左边3列是对可见光图像提取的显著图。由图可知,当取定s(或者r)时,在一定范围内,r(或s)取值越大,提取的显著图包含的细节信息越丰富,当s和r分别取16、0.5时,提取的细节信息最多,即右边三列最右上角的图像。图1中最右边两列为s取不同值、r取0.05和0.5时,当s和r分别取16、0.5时提取的显著图包含的红外目标特征最多,轮廓最清晰,即右边两列最右上角的图像。综上所述,当s与r分别取16与0.5时,所提方法对红外与可见光图像提取的显著图包含的细节信息最丰富。

2 基于滚动引导滤波的图像融合

在文献[10]中提出将引导滤波用于权重图优化的框架,并基于均值滤波提出了一种融合方法,本节首先从融合框架、权重图构造方法进行介绍,然后对本文的权重图构造方法详细论述。由于均值滤波分解图像效率较高,文中仍采用均值滤波将图像分解为基础层与细节层。

图1 不同ss和sr下提取的显著图

Fig 1 The saliency images extracted under differentsandr

2.1 融合框架

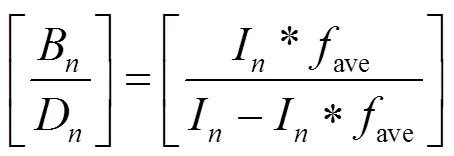

设I(的值为1、2)为输入源图像,通过均值滤波将源图像分解为对应的基础层B和细节层D,分解函数表示为:

式中:ave为均值滤波;“*”为滤波运算,源图像经均值滤波后可得到包含大量低频信息的基础层,表示图像的整体对比度和尺度较大的目标边缘。

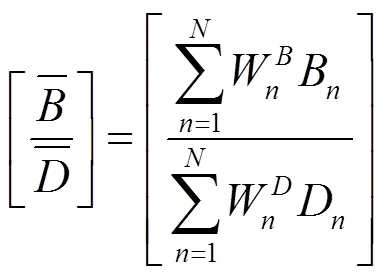

设为融合的结果图像,分别对式(6)融合后的基础层与细节层融合图像赋予值为1的权重,重构得到最终的融合图像,表示为:

2.2 权重图构造方法

权重图的构造过程包括显著图、初级权重图、最终权重图构造3个步骤。文献[10]利用了一个3×3的拉普拉斯滤波和高斯滤波来构造显著图,其中拉普拉斯滤波可以增强图像的特征,但同时也会增强噪声,高斯滤波用于对图像去噪得到显著图,可表示为:

式中:为拉普拉斯滤波器;为高斯滤波器;“*”为滤波运算;1、2为提取的显著图。

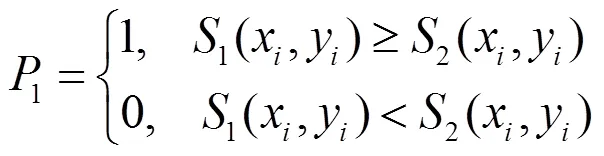

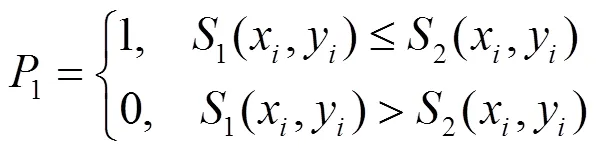

通过比较显著图1、2中相应像素点的显著值,得到初级权重图(二进制图)1与2,表示为:

或者:

2=1-1(10)

式中:1(x,y)、2(x,y)分别为各显著图中像素点(x,y)的灰度值。

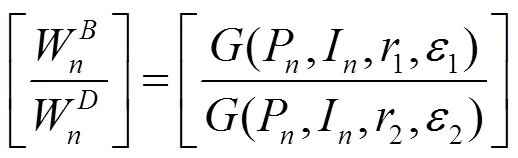

由于初级权重图中仍包含噪声,且有的目标边缘未对齐,直接作为权重图融合,可能会产生伪影,故采用引导滤波对其进行优化。分别以源图像(1、2)为引导图像,初级权重图为输入图像,经引导滤波优化后可获得最终的权重图。表示为:

2.3 改进的权重图构造方法

上述融合方法中采用拉普拉斯滤波器获取源图像的显著特征图,拉普拉斯滤波的原理是利用3×3模板遍历整个输入图像,取模板内所有像素点的平均值代替中间像素点,但加权平均的方式会导致获取的边缘、纹理等高频信息不充分,最终的融合图像细节信息保留不够充分。

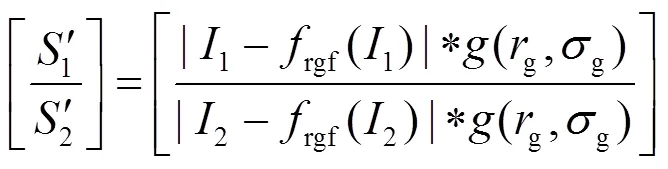

在上文中,论证了将滚动引导滤波用于构造显著图的可行性。结合式(4)与式(8)后可得新的显著图构造算法,如下所示:

式中:1¢、2¢分别为经滚动引导滤波和高斯滤波后获得的显著图。

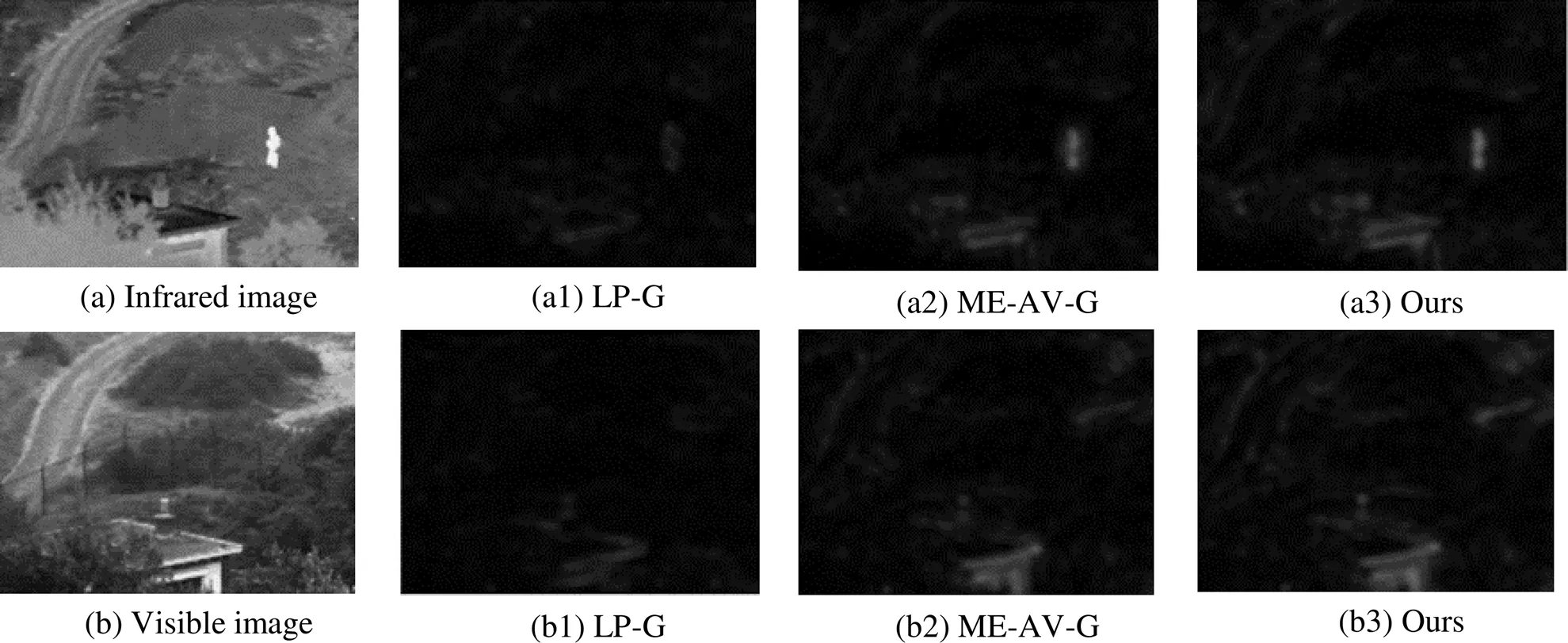

图2是分别采用拉普拉斯滤波与高斯滤波(LP-G)、中值滤波-均值滤波与高斯滤波(ME-AV-G)以及本文方法对红外与可见光图像获得的显著图。比较红外显著图可知,本文方法得到的显著图中目标的轮廓更清晰,其他方法保留的红外目标较模糊;比较可见光显著图可知,本文方法保留的细节信息更丰富。

图2 不同方法获取的显著图

2.4 融合算法

基于滚动引导滤波的图像融合具体步骤如下所示:

Step1:利用均值滤波将红外与可见光图像分别分解为基础层与细节层{B、D};

Step2:利用滚动引导滤波与高斯滤波获得源图像的显著图{1、2};

Step3:比较显著图中的显著值,获得初始权重图{1、2};

Step4:利用不同尺度的引导滤波优化初始权重图得到基础层与细节层的权重图{W、W};

Step5:将得到的权重图作为权重系数分别指导基础层与细节层的融合;

Step6:将融合后的基础层与细节层分别以1为权重系数,重构得到最终的融合图像

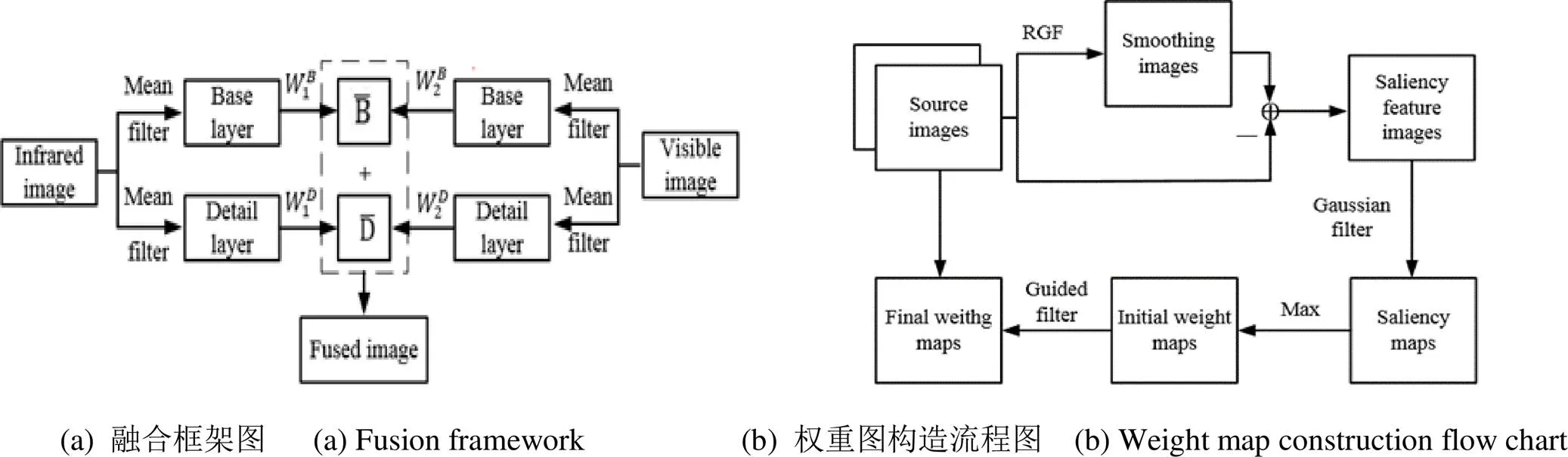

图3中,图(a)为采用均值滤波对图像单尺度分解的融合框架图,图(b)为源图像经滚动引导滤波、高斯滤波、引导滤波等运算的基础层与细节层权重图构造流程图。

3 实验结果与分析

3.1 实验条件

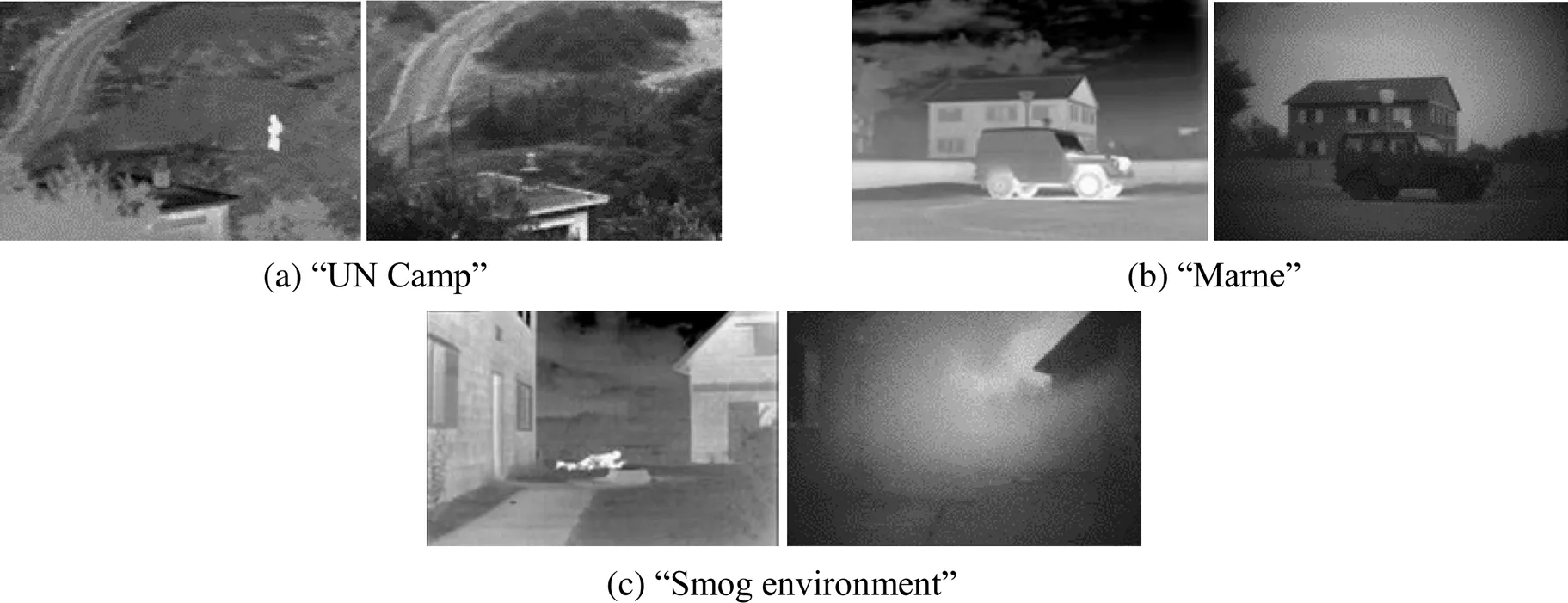

为进一步验证本文方法的有效性,选择了3类典型背景目标进行实验,所选择的实验数据均为公开且经严格配准后的图像。如图4所示。实验的运行环境为:Intel i5,2.3GHz,内存4GB,64位Windows7操作系统,Matlab2017a。此外,将本文方法与DWT[8]和NSCT[19]两种经典的多尺度变换方法,LPSR[20]、基于显著性检测的两个尺度的图像融合方法[21](two-scale image fusion based on visual saliency,TSIFVS)两种最新提出的方法,以及文献[10]所提出的GFF方法(这5种方法进行比较,各方法的参数设置均与原文献中保持一致,本文方法的尺度参数s和r分别设置为16和0.5,迭代次数采用文献[15]中的最佳次数4。

图3 红外与可见光图像融合流程图

图4 3对红外与可见光图像

3.2 实验结果分析

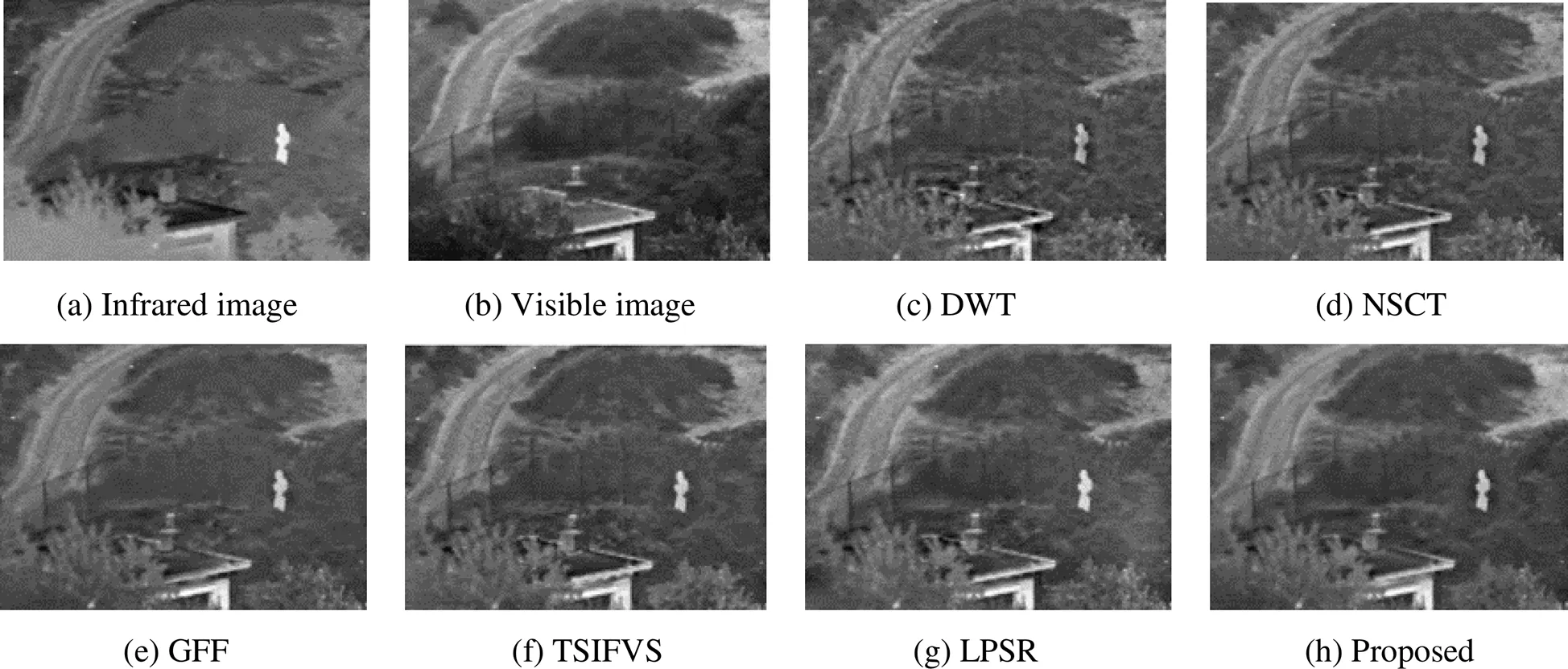

图5为不同方法对测试数据“UN Camp”的融合结果,对比分析融合结果,DWT(图5(c))、NSCT(图5(d))两种传统的多尺度变换方法得到的融合图像,目标不够突出,整体亮度偏暗;GFF方法(图5(e)),目标附近植被和远处山丘纹理不清晰,表示对红外噪声抑制不充分;TSIFVS方法(图5(f)),目标较突出,且目标周围的栅栏也较清晰,但屋顶背景较暗,目标右边的植被较模糊,表明融合了较多的红外信息;LPSR方法(图5(g)),目标较突出,但目标右边的植被不清晰;本文方法(图5(h)),目标突出,且目标周围的栅栏、屋顶及远近位置的植被等背景都较清晰。

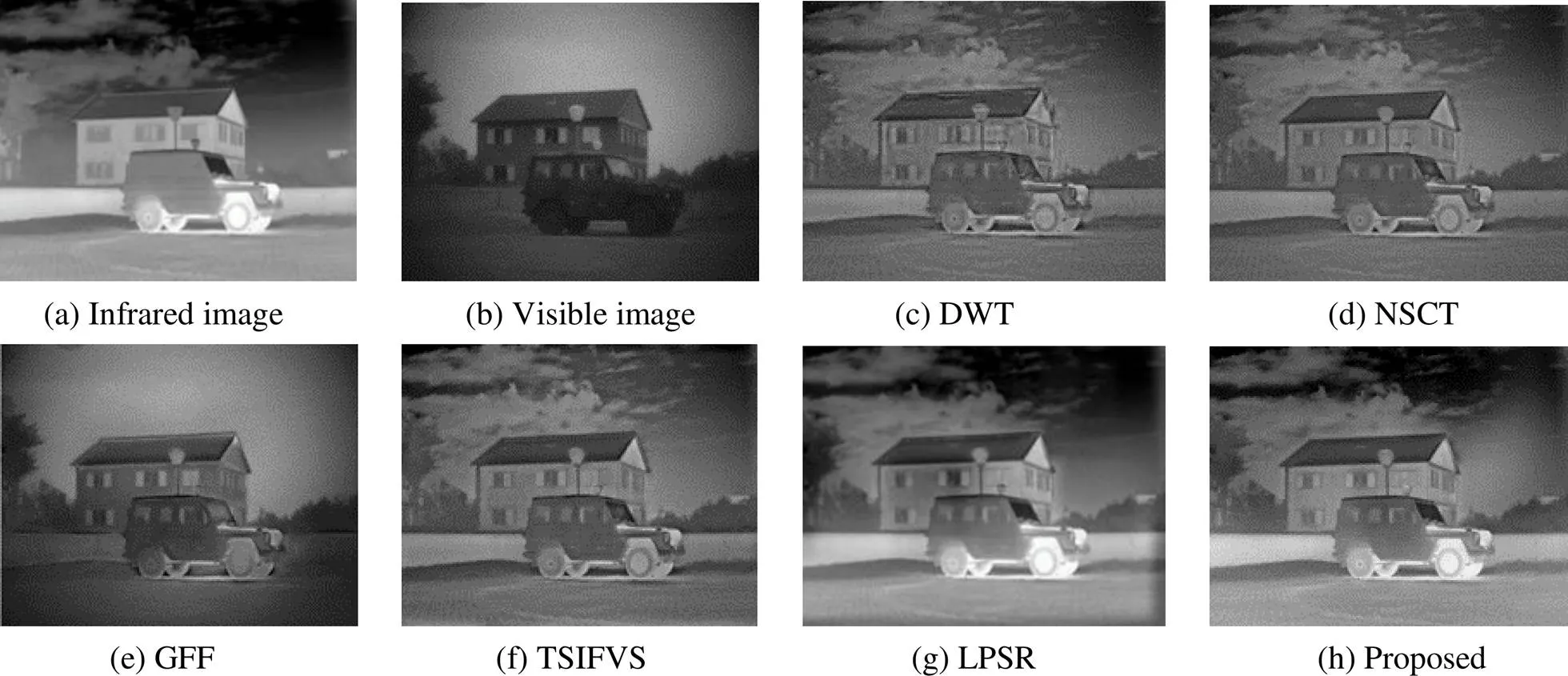

图6为不同方法在测试数据“Marne”上的融合结果,汽车为带内热源的目标,相比于图5中人这一小目标,汽车的红外与可见光特征分布更复杂。观察房子、车辆、天空、地面等目标背景,图6(c)、(d)两种经典的方法融合的图像亮度信息较少,含有的噪声较多,整体视觉效果较差。图6(e)方法融合的可见光细节信息较多,但目标的红外特征较少且融合图像中间较亮,周围较暗,特征融合存在不衔接的缺点。图6(f)方法融合的红外信息较少,图6(g)车辆融合特征较明显,但车窗处的细节信息较少一些,房子整体外观,有的地方较亮,有的偏暗。本文的方法(图6(h))车辆红外特征较明显,房子外观整体较亮,融合效果较好。

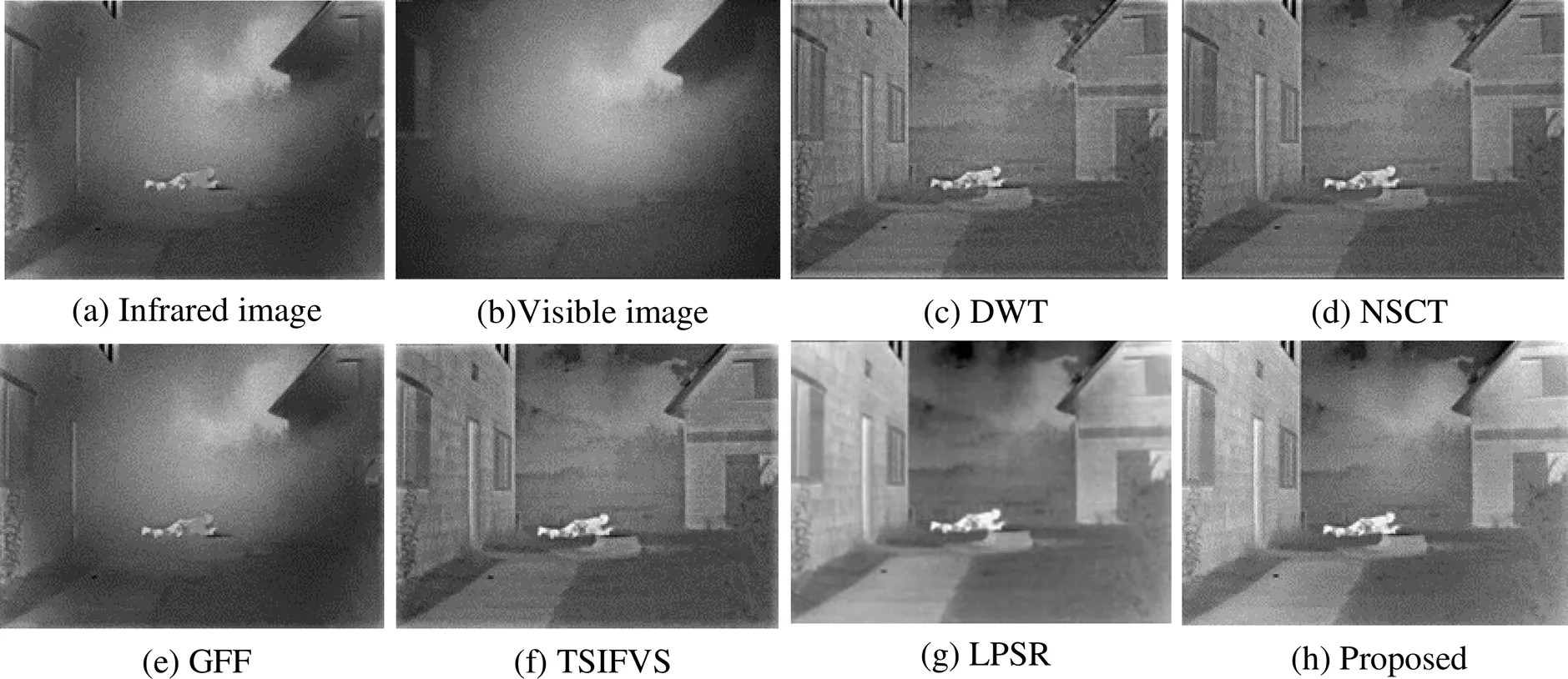

图7是针对测试数据“Smog environment”进行的融合,比较不同方法的融合结果可得出:(c)、(d)两种方法融合的结果包含的噪声较多,整体偏暗,目标不突出;(e)方法融合了较多的烟雾信息,红外特征融合较少;(f)方法,目标突出,细节信息丰富,但整体偏暗;(g)方法融合的结果,目标突出,背景细节信息丰富;(h)方法融合结果,目标突出、轮廓清晰,房子间的天空融合自然,具有与(g)方法相当的视觉效果。

图5 不同方法在测试数据“UN Camp”上的融合结果

图6 不同方法在测试数据“Marne”上的融合结果

图7 不同方法在测试数据“Smog environment”上的融合结果

3.3 客观指标评价

仅通过视觉效果来评价算法的融合效果,评价结果带有一定的主观性,为更加客观地评价本文方法的有效性,还需利用客观评价指标进行评价。在文献[1]与文献[22]中对一些经典及其衍生的客观评价指标进行了实验分析与验证,本文选择其中的6项指标:基于信息论的评价指标,标准化互信息(NMI)和非线性相关信息熵(NCIE);基于图像特征的评价指标,特征互信息(FMI)和相位一致性(P);基于结构相似度的评价指标,局部结构相似度(Y);基于人类视觉感知的评价指标(CB)。

标准化互信息表示从输入图像转换到融合图像中的信息量;非线性相关信息熵表示融合图像与输入图像之间的非线性相关程度;特征互信息从边缘、细节、对比度这3个方面综合评价从输入图像到融合图像转换的特征信息;相位一致性表示融合图像包含的边缘、角度信息;局部结构相似度表示融合图像与输入图像的局部结构相似程度;基于人类视觉感知的评价(CB)表示融合图像获得的对比度信息。

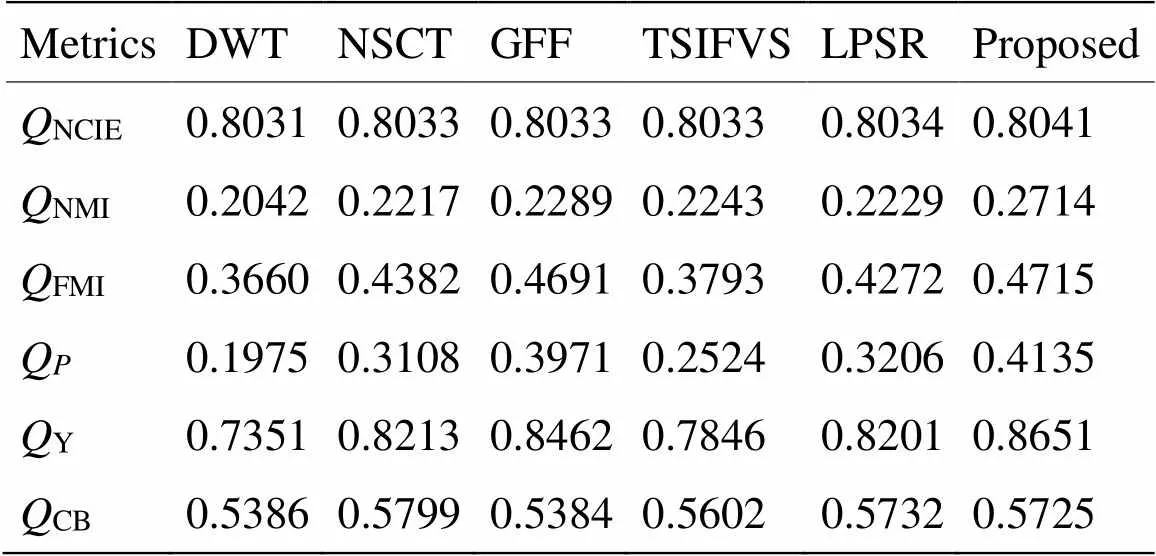

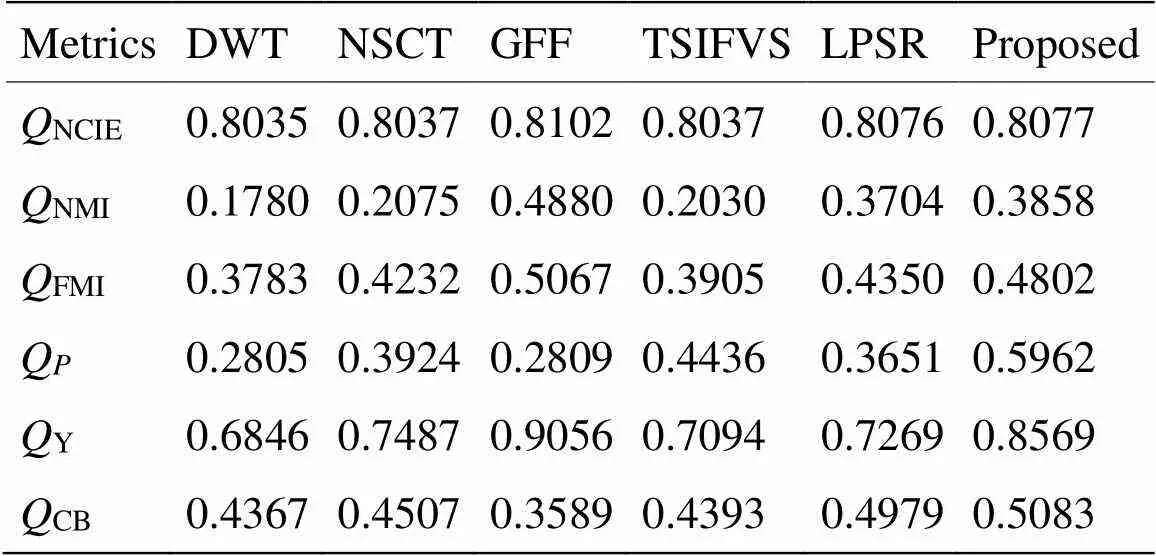

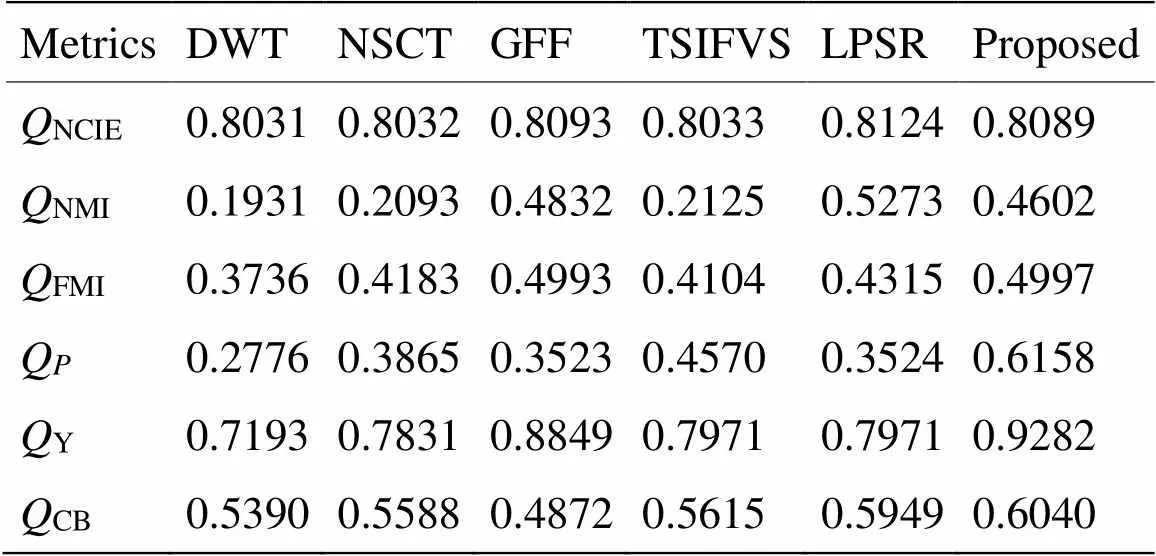

从表1、2可以发现经本文改进的方法在非线性相关信息熵(NCIE)、标准化互信息(NMI)、特征互信息(FMI)、相位一致性(P)、局部结构相似度(Y)、人类视觉感知(CB)这6个评价指标方面都有较大幅度的提升。在表1中,本文方法的CB数值比NSCT算法的低一些,但其他的指标综合评价均高于NSCT算法。在表3中,本文方法的FMI、Q、Y、CB客观评价指标均高于其它方法,NCIE比GFF方法的值略低,但NMI这一基于信息熵的评价指标比GFF方法高;本文的NMI值低于LPSR方法,但NCIE值比其高。

表1 测试数据“UN Camp”融合结果客观指标比较

表2 测试数据“Marne”融合结果客观指标比较

表3 测试数据“Smog environment”融合结果客观指标比较

4 总结

本文利用滚动引导滤波在边缘和局部亮度保持的特性,结合高斯滤波去噪的特性来获取显著图,利用不同尺度的引导滤波对其优化,得到基础层与细节层的权重图,利用权重图指导基础层与细节层的融合,联合融合后的子图像重构得到融合图像。文中分析了滚动引导滤波的尺度参数s和r对提取的显著图的影响。通过与LP-G方法、ME-AV-G方法提取的显著图比较,结合滚动引导滤波与高斯滤波的方法提取的显著图边缘、亮度等细节特征更多。最后针对3种不同的测试数据进行实验,结果表明:本文方法较好地保留了红外与可见光图像中的目标背景等信息,与NSCT、GFF、TSIFVS等方法相比较,融合图像在主观视觉分析和客观评价指标上均更有优势,是一种有效的融合方法。但本文方法仅对图像进行了两个尺度的分解,下一步将对更多尺度级的分解与融合进行研究。

[1] MA J, MA Y, LI C. Infrared and visible image fusion methods and applications: A survey[J]., 2019, 45:153-178.

[2] XIN J, QIAN J, YAO S, et al. A Survey of Infrared and Visual Image Fusion Methods[J]., 2017, 85: 478-501.

[3] 封子军. 像素级图像融合算法研究[D]. 成都: 电子科技大学, 2014.

FENG Z J. Research on pixel-level image fusion method[D]. Chengdu: University of Electronic Science and Technology, 2014.

[4] YU X, REN J, CHEN Q, et al. A false color image fusion method based on multi-resolution color transfer in normalization YCBCR space[J]., 2014, 125(20): 6010-6016.

[5] Vanmali A V, Gadre V M. Visible and nir image fusion using weight- map-guided Laplacian-Gaussian pyramid for improving scene visibility[J]., 2017, 42(7): 1063-1082.

[6] JIN H, XI Q, WANG Y, et al. Fusion of visible and infrared images using multi-objective evolutionary algorithm based on decomposition[J]., 2015, 71: 151-158.

[7] XU H, WANG Y, WU Y, et al. Infrared and multi-type images fusion algorithm based on contrast pyramid transform[J]., 2016, 78: 133-146.

[8] Chipman L J, Orr T M, Graham L N. Wavelets and image fusion[C]//. 1995: 248-251.

[9] ZUO Y, LIU J, BAI G, et al. Airborne infrared and visible image fusion combined with region segmentation[J]., 2017, 17(5): 1127.

[10] LI S, KANG X, HU J. Image Fusion With Guided Filtering[J]., 2013, 22(7): 2864-2875.

[11] ZHU J, JIN W, LI L, et al. Multiscale infrared and visible image fusion using gradient domain guided image filtering[J]., 2017: S1350449517305042.

[12] MA J, ZHOU Z, WANG B, et al. Infrared and visible image fusion based on visual saliency map and weighted least square optimization[J]., 2017, 82: 8-17.

[13] ZHANG Y, WEI W, YUAN Y. Multi-focus image fusion with alternating guided filtering[J]., 2019, 13(4): 727-735.

[14] MA T, JIE M, BIN F, et al. Multi-scale decompotion based fusion of infrared and visible image via total variation and saliency analysis[J]., 2018, 92: 154-162.

[15] ZHANG Q, SHEN X, XU L, et al. Rolling Guidance Filter[C]//, 2014: 815-830.

[16] Tomasi C, Manduchi R. Bilateral Filtering for Gray and Color Images[J]., 1998: 839-846.

[17] HE K, SUN J, TANG X. Guided Image Filtering[J]., 2013, 35(6): 1397-1409.

[18] Gastal E S L, Oliveira M M . Domain transform for edge-aware image and video processing[J]., 2011, 30(4): 1.

[19] Adu J, GAN J, WANG Y, et al. Image fusion based on nonsubsampled contourlet transform for infrared and visible light image[J]., 2013, 61: 94-100.

[20] LIU Y, LIU S, WANG Z. A general framework for image fusion based on multi-scale transform and sparse representation[J]., 2015, 24: 147-164.

[21] Bavirisetti D P, Dhuli R. Two-scale image fusion of visible and infrared images using saliency detection[J]., 2016, 76: 52-64.

[22] LIU Z, Blasch E, XUE Z, et al. Objective Assessment of Multiresolution Image Fusion Algorithms for Context Enhancement in Night Vision: A Comparative Study[J]., 2011, 34(1): 94-109.

Infrared and Visible Image Fusion Algorithm Based on the Rolling Guidance Filter

CHEN Feng,LI Min,MA Le,QIU Xiaohua

(High-tech Institute, Xi’an 710025, China)

For the fusion of infrared and visible images, it is easy to produce problems such as missing detail information and suppressing less noise. In this paper, an improved fusion algorithm is proposed by applying the characteristics of a rolling guidance filter, which preserves edge and local brightness. First, the input images are decomposed into base and detail layers by mean filtering. Second, the saliency maps of the input images are obtained by combining the rolling guidance and Gaussian filters. The weight maps are then optimized by guided filters of different scales. The optimized maps are used to instruct the fusion of the base and detail layers. Finally, the fused image is reconstructed by combining the merged sub-images. The method of this paper is superior on the six indicators, such as nonlinear correlation information entropy and phase consistency, compared to the classical methods such as non-subsampled contourlet transform(NSCT), image fusion with guided filtering(GFF), and two-scale image fusion based on visual saliency(TSIFVS).

the rolling guidance filter(RGF), the saliency features, image fusion, edge preserving filter, weight map

TN219

A

1001-8891(2020)01-0054-08

2019-04-24;

2019-11-29.

陈峰(1994-),男,硕士研究生,研究领域为图像处理,E-mail:1204858129@qq.com。

李敏(1971-),博士研究生导师,主要研究方向:红外图像处理与目标识别,E-mail:clwn@163.com。

国家自然科学基金项目(61102170);国家社科基金项目(15GJ003-243)。