基于类别相关的领域自适应交通图像语义分割方法

2020-04-21贾颖霞郎丛妍冯松鹤

贾颖霞 郎丛妍 冯松鹤

(北京交通大学计算机与信息技术学院 北京 100044)

图像语义分割作为计算机视觉领域的一个重要研究问题,旨在对输入图像的每一个像素根据其所属的类别进行分类,最终整合得到包含语义信息的分割输出结果,其分割结果的准确度对后续的场景理解、目标追踪以及图文转换等课题起着直接且至关重要的作用.近年来,由于深度学习的发展以及全卷积神经网络(fully convolutional network, FCN)[1]的出现,语义分割得以快速发展.

然而,现有的语义分割算法[1-4]存在着许多不足,特别是对精准标注过分依赖.由于对数据进行人工标注将会耗费大量的时间和精力,因此实际应用中收集到的图像大多没有精准的数据标注.对精准标注的过分依赖导致现有的语义分割方法难以直接应用于非精准甚至无标注数据集中.

为解决这一问题,近年来提出领域自适应方法,用于缩小所含类别相似、数据分布相近的有标注源域数据集和无标注目标域数据集之间的语义鸿沟.拥有一定量的有标注数据,通过训练神经网络模型,便可对其进行特征提取与语义分割.利用生成-对抗学习[5]的思想,对这个网络经过调整、优化,即可将其有效应用在其他跨域的无标注数据集中.而与常见的利用生成对抗网络(generative adversarial network, GAN)[5]进行图像分类或图像增强的方法不同,语义分割方法所需的特征需要同时包含图像整体的空间布局信息和局部语义类别的上下文信息,实现难度大.

现有的领域自适应语义分割方法大多存在2个问题:

1) 绝大多数算法直接将领域自适应方法应用在原图上,分别利用来自源域和目标域的原图进行对抗学习,进而实现语义分割,而实验结果表明,这一做法存在2个不足:①若直接对原图进行识别及语义分割、对抗判别等操作,容易出现分割不准或过度分类等问题,如图1左侧展示的场景是阴天1辆轿车停在纽约街头马路,图1右侧展示的场景是晴天1辆跑车停在伦敦乡镇的栅栏外,2张原图间场景存在较大差异,而在语义分割方法中,两者所包含的语义信息及语义类别却较为相近.②现有的领域自适应方法所采用的对抗判别基准多为直接使用GAN[5]网络中的鉴别器,判别输入的2张图片是否来自同一数据域.而图像语义信息通过其包含的全部语义类别体现.仅利用整张原图进行语义判别,容易造成类别错分等分割结果不理想的问题.

Fig. 1 Comparison of original image and segmentation results图1 原图及语义分割结果对比图

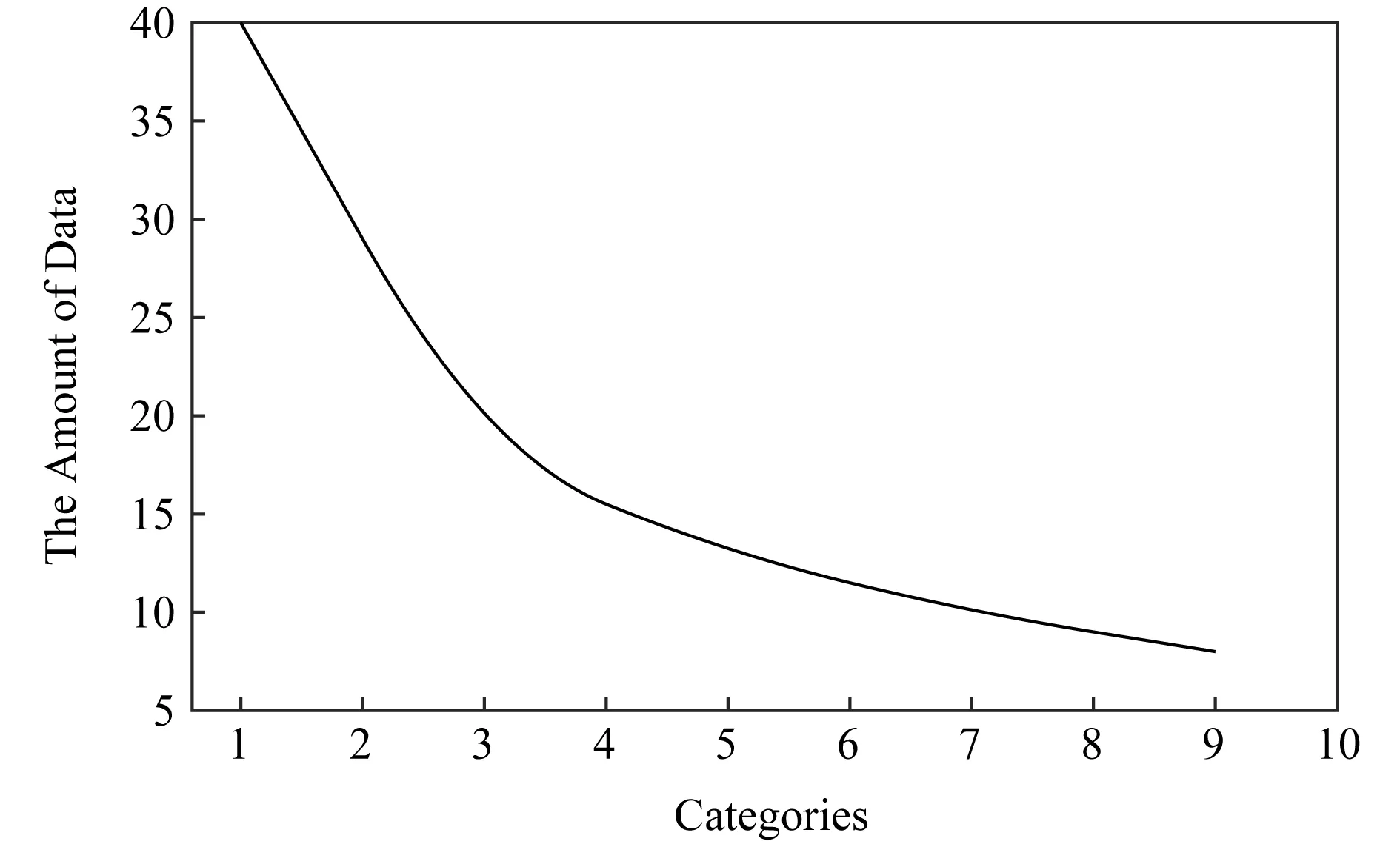

2) 目前许多数据集均存在“长尾分布”效应,即20%的语义类别占据80%的数据量,诸如在交通场景数据集中,车辆、道路等占据了约80%的数据量,而交通信号灯及路标等类别,因其所占数据量较小且易与背景混淆而时常难以被正确分割,为实际应用带来了诸多不便.

根据以上分析,本文针对现有的领域自适应及语义分割方法中存在的问题,提出2个改进方案:

1) 为改善现有数据集中数据分布不均的情况提出基于改进focal loss[6]的损失函数;同时,引入Pixel Shuffle方法[7]改进上采样方法,在对源域数据进行语义分割的过程中,有效提高解码器对原图空间信息及上下文语义信息的恢复程度.

2) 提出一种新的基于类别相关的领域自适应语义分割方法,通过提出新的领域自适应阶段、设计基于语义类别相关的对抗判别标准,并对目标域语义分割网络进行约束调优来有效解决不同数据集跨域分割问题,使得语义分割效果具有更细粒度的提升,进而减少对全标注样本的需求;同时显著提高对于标注情况、图像风格、数据分布均不相似但包含相同语义类别的2个数据集间的自适应水平,提升语义分割精准度和泛化性能.

1 研究现状

1.1 语义分割

目前大多数语义分割方法的核心思想来自FCN[1],FCN将卷积神经网络(convolutional neural network, CNN)[8]中的最后一层替换为卷积层,同时使用跳跃式结构,将高层次特征与低层次特征结合,有效提高分割精准度.而为了更好地融合多尺度语义信息,提高分割结果,近年来,许多方法采用“编码器-解码器”[2]结构,其中编码器负责提取高层抽象语义特征,解码器通过反卷积[9]或反池化等方法拟合不同层次特征,逐步将分割特征图的语义信息和大小恢复至与原图一致.近来,文献[3]中提出名为Deeplab V3+的方法,引入可任意控制编码器用以提取特征的分辨率,同时通过空洞卷积方法平衡其精度和耗时.

针对现有监督方法过于依赖精确标注的问题,文献[10]中提出基于显著图信息的弱监督语义分割方法,通过显著图求得每个像素属于前景物体或者背景的概率,并采用多标签交叉熵损失训练出一个简单的深度卷积神经网络,再根据数据集中图像级别的标注信息剔除部分噪声,使得该网络具备较高语义分割能力.文献[11]中提出基于对抗性擦除的方法,将图片输入至分类网络,通过训练得到对于当前图片而言最具判别力的区域,将这部分的像素值在网络中设置为0,并将擦除后的图片输入分类网络进行再训练.网络会自动寻找其他证据,使得图像可以被正确分类,重复以上操作,最后通过融合经擦除的区域获取相应物体的整个区域.文献[12]中提出基于图模型和图匹配的自监督学习语义分割方法,提出一种基于类内连通图的三元组抽样方案改进分割精度.以上方法均取得较为优异的结果,但针对完全无标注的图像,依然难以有效、快速地处理.

针对以上问题,本文引入1.2节中描述的领域自适应方法,通过对有标注数据集的分割方法进行训练学习与迁移,解决对无标注数据集的跨域分割问题,显著提升无标注数据集的语义分割精准度.

1.2 领域自适应

领域自适应是迁移学习[13]在计算机视觉领域的应用,用以解决源域和目标域之间的域不变及域迁移问题.根据“适应”内容的不同,目前主要有3类领域自适应方法.1)基于对抗-生成[5]思想,使得目标域有效“适应”源域的分割模型及方法;2)基于风格转换[13],利用目标域数据对源域数据进行图像增强,进而实现2个域内数据彼此“适应”的方法;3)采用“师生”模型体系结构的基于知识蒸馏[14]的领域自适应方法.

在基于生成对抗思想的方法中,依据对抗阶段采用的判别标准的不同,可将其分为基于数据分布的域适应、基于特征选择的域适应以及基于子空间学习的域适应方法等.这类方法的主要实现难点在于如何有效减小源域数据集与目标域数据集两者间的分布差异.文献[15]中通过最小化最大平均差异方法,实现对源域和目标域之间特征分布的有效对齐.文献[16]中提出依据相关对齐损失,匹配源域数据集和目标域数据集特征的均值和协方差.

针对现有领域自适应方法中,多采用原图或高层次抽象特征图进行跨域训练,进而造成的语义不一致或类别错分问题,本文提出一种新的基于类别相关的领域自适应语义分割方法:首先,对原图进行粗分割;其次,对其分割结果进行类别相关的优化调整.通过提升跨域数据集间的自适应水平,有效实现对无标注数据集的跨域语义分割,提高算法的泛化性能.

2 一种基于类别相关的语义分割方法

2.1 方法综述

在本节中,如图2所示,本文提出一种包含3个处理阶段的基于类别相关领域的自适应语义分割方法模型.

1) 对基于监督学习的语义分割方法进行改进.为了提高图像中类别边缘的分割精度,改进解码过程中基于特征图的上采样(upsampling)方法,提高对输入图像中的空间信息及上下文语义信息的恢复程度;同时,针对数据集中数据分布不均的情况,对现有方法的损失函数进行相应改进,使本文方法针对难分割、数据量小的类别,能有效提高其分割准确度.

2) 根据前期调研,现有领域自适应方法的适应阶段大多选择在原图或经卷积处理后的特征图上进行,而本文则选择在经过分割网络处理得到的粗分割输出空间上进行学习与训练,这样使得本文方法既能在一定程度上有效避免语义不一致问题,又能有效利用图像中的基础结构化的域不变特征、上下文语义及空间信息.此外,提出将类别相关的数据分布情况作为领域自适应的对齐标准,并对整体的语义分割网络进行约束调优,使本文方法的分割效果较先前方法有更细粒度的提升.

3) 根据前2阶段学习及训练得出的网络,设计损失函数,对算法网络进行全局约束优化,提高本文算法泛化性,使得标注情况、图像风格、数据分布均不相似但包含相同语义类别的2个数据集间能够更好地实现领域自适应.

Fig. 3 The graph of super-resolution reconstruction method图3 超分辨率重建方法示意图

2.2 方法设计

2.2.1 基于监督学习的方法改进

本文首先对现有基于监督学习的语义分割网络进行改进.

本文针对源域数据集采用的基础网络模型为DeepLab[3],其使用“编码器-解码器”结构,在解码过程中使用双线性插值方法,利用周围4个像素点信息对待测样点进行插值计算,继而将特征图逐步复原至输入图像的大小.

而双线性插值方法不仅计算量较大,且仅考虑待测样点周围4个直接相邻点灰度值的影响,未考虑其他各相邻点间灰度值变化率的影响,从而导致缩放后图像的高频分量损失,相应类别的分割边缘模糊;同时,因在相邻点之间反复计算,存在一定程度的重叠(overlap)现象.

因此,在扩大特征图大小且恢复图像语义信息的上采样过程中,本文采用如图3所示的超分辨率重建[7]方法.首先通过卷积计算得到r2个通道的特征图,然后通过周期筛选方法得到更高分辨率的图像.其中,r为上采样因子(upscaling factor),即相应图像的扩大倍率.

将带有精准标注的源域数据输入至经过优化的语义分割网络中,得到语义分割结果,并将此结果与源域数据中的真实分割区域(ground truth)进行比对,求得当前方法的分割准确率.

同时,针对数据集中语义类别分布存在的如图4所示的“长尾效应”,即20%的语义类别占据数据集中80%的数据量,而其他很多对分割精准度具有重要影响的语义类别因所占数据比例较小而难以被正确分割,本文提出如式(1)所示的基于改进focal loss[6]的优化方法,作为基于监督学习语义分割方法的损失函数,旨在将更多的注意力倾注在数据量小但对分割结果影响较大的数据类别上,使得相应类别及图像整体的分割准确率能够得到有效提升.

Fig. 4 The graph of long tail distribution图4 长尾分布示意图

(1)

其中,PS表示源域中某个类别被正确预测的概率,与参数α,γ一起用于优化分割结果.依据此函数及其计算结果,对当前的监督学习方法进行迭代优化.

2.2.2 基于类别对齐的领域自适应方法

根据文献阅读及实验复现,现有的领域自适应语义分割方法选择的自适应阶段通常为目标域数据原图或经卷积计算处理后的特征图.对语义分割方法而言,原图中所含冗余因子较多,如光照情况、色彩情况等.直接对原图进行领域自适应及分割,容易导致语义不一致问题.同时,经卷积提取的特征图中所含的图像上下文及空间信息又较为匮乏,因而容易导致边缘模糊或类别错分问题.

此外,现有方法选择的自适应判别基准通常直接采用GAN[5]的思想,即直接将整张图像输入至领域自适应网络的判别器中,判断2个输入图像是否来自同一数据域.然而,此判别基准可能过度关注全局信息的对齐而忽略原本相近的语义类别,导致原本正确分割的语义类别被调节至错误分割.

根据理论分析及验证性实验结果,本方法首先将源域数据和目标域数据直接输入至2.2.1节的网络中进行分割.对于源域数据,得到基于监督学习的精准分割结果;对于目标域数据,得到其粗分割结果.

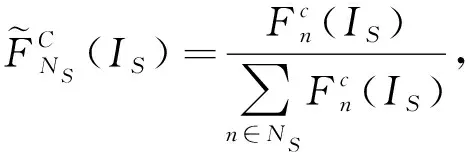

因此,将2.2.1节中设计及优化后的分割网络视为生成器,并固定其网络结构及相应参数设置,将源域数据中的语义类别及其分割情况作为起始基准.结合目标域数据的分割结果,根据式(2)(3),在判别环节分别计算源域和目标域的分割结果中具体语义类别及其数据分布情况,并传入本文设计的判别网络中,根据类别相关对齐原理,进行类别层面的对齐调优,使得源域数据与目标域数据所含的语义类别类内相似性不断提升,类间独立性不断扩大.

(2)

(3)

同时,针对以上基于类别相关的领域自适应方法,首先统计2个域的总体数据分布情况,然后根据生成-对抗学习思想设计损失函数,并利用其计算结果,对本文方法的对齐过程及判别器设计进行相应优化:

(4)

(5)

(6)

2.2.3 约束调优

以2.2.1节和2.2.2节中优化设计的模型为基础,对本文提出的算法网络进行整体约束优化,同时,经由此阶段处理,可对2.2.2节中部分类别不一致及类别在2个域间分布不均的情况进行优化调整.

将分割结果输入到领域自适应阶段的判别器中进行判别,根据判别结果,对分割网络进行迭代优化,直至判别器无法鉴别其接收的分割结果图来自源域还是目标域,即类别对齐已完全实现时,则认为当前基于类别相关的算法网络结构已经达到较为理想的结果,实现了对领域自适应语义分割方法的有效提高.

在此过程中,提出式(7)所示的损失函数,将本文方法模型视为一个基于GAN[5]的结构,依据此函数计算本算法的整体损失值,对算法网络进行优化与改进.

(7)

其中,IS,IT分别表示源域数据和目标域数据正确分割的情况.

3 实验结果与分析

3.1 数据集

本文提出一种基于类别相关的领域自适应语义分割方法,并在道路交通数据集GTA5[17],SYNTHIA[18],Cityscapes[19]上进行实验.

同时,为了证明本文方法的鲁棒性,在MSCOCO[20]和VOC 2012[21]数据集上进行验证性实验,并统计交通场景相应数据类别的实验结果.

GTA5[17]是基于游戏Grand Theft Auto V提取的包含有25 966张分辨率为1 914×1 052的超高清且自动带有标注数据的赛车游戏场景图像数据集,其场景均为对美国洛杉矶和南加州真实交通环境场景的复现,所包含的类别与Cityscapes数据集完全兼容.

SYNTHIA[18]是由计算机合成的、城市道路驾驶环境的像素级标注的数据集,包含21 494张分辨率为1 914×1 052的超高清且自动带有标注数据的交通场景图像,其所含类别与Cityscapes完全兼容.

Cityscapes[19]是由梅赛德斯-奔驰提供的无人驾驶环境下的图像分割数据集,用于评估视觉算法在城区场景语义理解方面的性能.Cityscapes包含德国50个城市不同场景、不同背景、不同季节的街景,其中包含5 000张精细标注的道路交通场景图像、20 000张粗略标注的图像、30类标注物体以及1 525张只包含原图、没有标签的测试集图像.

MSCOCO[20]是微软发布的,包括91个类别、328 000张图片和2 500 000条标注信息的数据集,而其对于图像的标注信息不仅有类别、位置信息,还有对图像的语义文本描述.

VOC 2012[21]是包含11 530张图片的开源数据集,其中每张图片都有标注,标注的物体包括人、动物(如猫、狗、鸟)、交通工具(如车、船和飞机等)、家具(如椅子、桌子、沙发等)在内的20个类别.

3.2 实验环境、网络设计及评价指标

本文模型所使用的深度学习框架为Pytorch 1.0.0版本,相关实验在基于Ubuntu 16.04操作系统的2块NVIDIA TITAN XP独立显卡上运行.

本文实验采用的网络结构如图2所示,对于本文提出的方法,在计算式(1)所示的损失值时,设定α=0.2,γ=2效果最为理想.在训练过程中,我们将初始语义分割阶段视为生成部分,在对输入图像进行语义分割时,分别使用VGG-16[22]和ResNet-101[23]这2种网络模型作为基础架构,源域与目标域共享参数,使用Leaky-ReLU[24]作为激活函数,并使用超分辨率重建[7]作为上采样方法,使用随机梯度下降法(stochastic gradient descent, SGD)[25]作为生成部分的优化方法,令初始学习率rg=2.5×10-4,动量参数βg=0.9;对于判别部分中的判别网络,使用4层通道数分别为 {64,128,256,1}的卷积层,使用Leaky-ReLU[24]为激活函数,令初始学习率rd=1.0× 10-6, 令1阶矩估计、2阶矩估计的指数衰减率分别为β1=0.9,β2=0.99;在计算本文方法的整体损失值时,分别将基于监督学习的损失值、基于类别相关的判别损失值及基于GAN[5]模型结构的损失值对应权重设置为λ1,λ2,λ3,对应权重值分别为0.2,1.0,0.5.

本文采用的主要评价指标为如式(8)(9)所示的针对每个类别的像素分割精准度(pixel accurancy, PA)和针对图像整体的平均交并比(mean inter-section over union,mIoU).

像素分割精度表示的是该类别标记正确的像素数目占总像素数目的比例:

(8)

其中,pii表示被正确分类的像素数目,pij表示实际类别为i而被预测为类别j的像素点的数目.

平均交并比表示的是预测分割区域(predicted segmentation)和真实分割区域间交集与并集的比值:

(9)

其中,k+1表示数据集中全部类别数目.

3.3 实验结果

根据图2所示的网络结构,在3.1节中的数据集上进行实验,得到统计结果.

3.3.1 以GTA5数据集为源域的对比实验

设定GTA5[17]为源域数据集,设定Cityscapes[19]为无标注目标域数据集.选择VGG-16网络作为本算法的基础神经网络结构,将本方法与现有的其他领域自适应语义分割方法[26-33]进行表1、表2所示的对比分析.

表1所示,本文方法与近期一些实现方法相比,分割精准度及平均交并比均有所提升.特别是交通标志或交通灯等占有数据量较小,易与背景类混淆,因而难以被正确地分割语义类别,利用本文提出的类别相关方法,其分割精准度得到有效提升.先前方法中,路灯类的平均分割精准度为19.4%,最高精准度[31]为30.3%,本文方法可以将其提高至33.4%;路标类在先前方法中的平均分割精准度为9.6%,最高精准度[28]为18.3%,而本文提出的方法将其提高至19.7%;同时,本文方法将车行道类别的分割精准度提高至87.3%,将植物草木类的分割精准度提高至83.2%.近年来,使用ResNet[23]的算法均取得较为理想的效果,本文采用其作为基础的神经网络模型,继续在GTA5[17]与Cityscapes[19]数据集上训练本文提出的领域自适应语义分割方法,并与直接在目标域上使用ResNet结构的语义分割方法和使用VGG-16[22]作为基础模型的本文方法进行对比实验.

表2展示出3个方法在2个数据集上的实验结果,其中,RES表示单独使用ResNet对数据集进行特征提取与分割的结果,Ours-V表示使用VGG-16作为本文骨架网络得到的实验结果,Ours-R表示使用ResNet作为本文骨架网络得到的实验结果.相比其他2个方法,使用基于ResNet-101[23]结构的本文方法,在具体语义类别及整体图像的分割精准度上均有提升.例如,将交通标志类的平均分割精准度从20%提升至23.4%,将路灯类的平均分割精准度从32%提升至35.4%,继而将图像整体的分割平均交并比提升至43.7%.

Table 1 Comparison of Results with GTA5 as Source and Cityscapes as Target Domain表1 GTA5为源域、Cityscapes为目标域的实验结果对比

Notes: The best results are in bold; Swal stands for Sidewalk, Buil stands for Building, Veg stands for Vegetation, Per stands for Person, and Moto stands for Motorbike.

Table 2 Comparison of Experimental Results with Baseline on ResNet and VGG-16表2 分别以ResNet和VGG-16为Baseline的实验对比结果

Notes: Swal stands for Sidewalk, Buil stands for Building, Veg stands for Vegetation, Per stands for Person, and Moto stands for Motorbike.

图5展示了本文提出的方法在以GTA5[17]为源域、Cityscapes[19]为目标域的分割结果.其中图5(b)所示为直接对无标注数据集进行分割的结果,其中如车行道、汽车等语义类别已被识别,但与之相比,图5(c)中展示的结果对于图像中每个类别的分割边缘,其中路标、信号灯以及人行道等语义类别的分割精准度均有显著提升,且分割结果与图5(d)所示的数据集给出的真实分割区域较为接近.

Fig. 5 An example of semantic segmentation results with GTA5 as source domain and Cityscapes as target domain图5 以GTA5为源域、Cityscapes为目标域分割示例

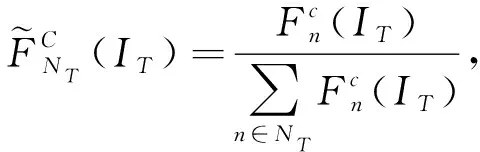

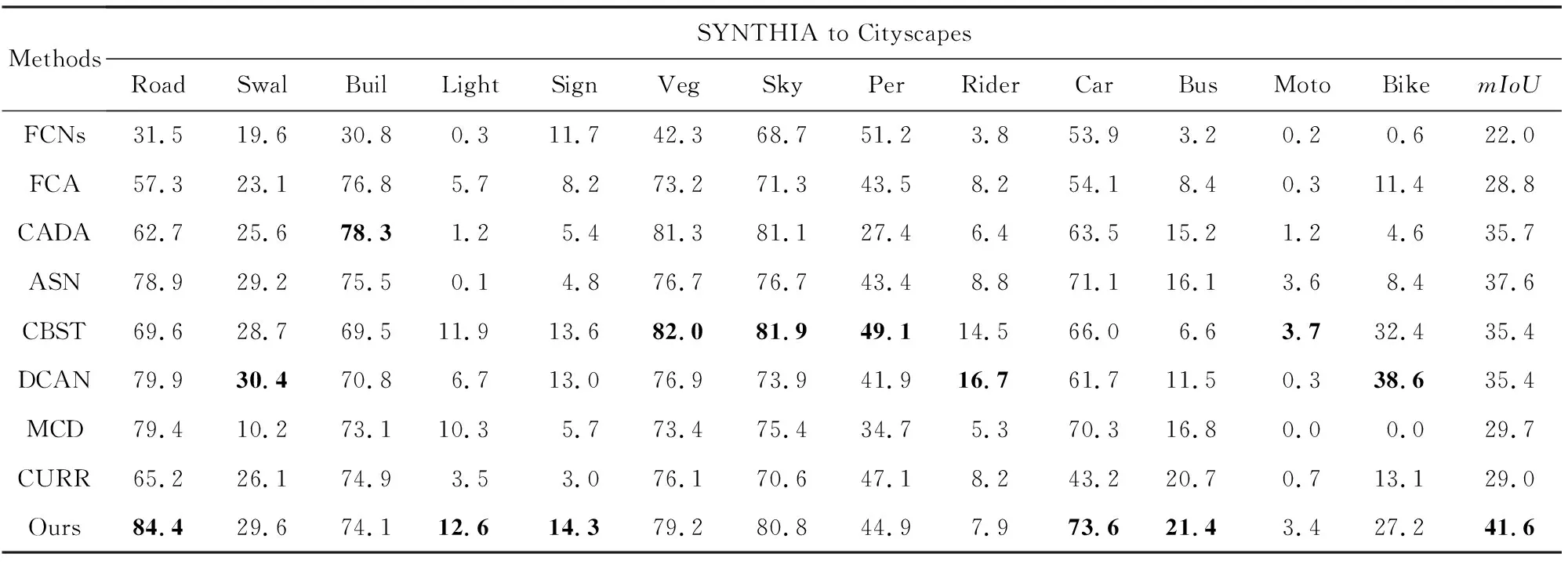

3.3.2 以SYNTHIA数据集为源域的对比实验

基于先前的模型及参数设置,以虚拟合成数据集SYNTHIA[18]为源域、以Cityscapes[19]数据集为目标域进行实验.

表3所示,图像整体的分割平均交并比被提升至43.6%,图中汽车、车行道、人行道等语义类别的分割精准度也得到显著提升.其中,车行道类的平均分割精准度在先前方法中的均值为66%,最高值[31]为79.9%,而本文方法可将其提升至84.4%;汽车类的分割精准度在先前方法中的均值为60.4%,最高值[29]为71.1%,本文方法可将其提升至73.6%.对于信号灯、路标以及公共汽车这3个语义类别,现有方法的分割精准度均值为4.9%,8.2%,12.4%,而本文方法可将其提升至12.6%,14.3%,21.4%.

Table 3 Comparison of Experimental Results with SYNTHIA as Source Domain and Cityscapes as Target Domain表3 以SYNTHIA数据集为源域、Cityscapes数据集为目标域的方法实验结果对比

Notes: The best results are in bold; Swal stands for Sidewalk, Buil stands for Building, Veg stands for Vegetation, Per stands for Person, and Moto stands for Motorbike.

此外,基于不同源域数据集上的实验结果也表明了本文所提方法的正确性、有效性和泛化性.

图6展示了本文提出方法在以SYNTHIA[18]为源域、Cityscape[19]为目标域的分割结果.图6(b)所示为未经自适应优化的结果,观察可见,图像中汽车、道路等常见语义类别已经可以被提取,但由于源域SYNTHIA是计算机合成的数据集,与目标域Cityscapes的真实交通图像场景略有不同,因而目标域的分割结果中存在分割边缘模糊和类别错分等现象.图6(c)所示为本文方法的实验结果,经过本文的方法处理,车辆、道路、交通信号灯以及行人等类别的分割结果与图6(d)中所示的真实分割标注已经非常接近,而路障、建筑以及人行道等类别也被有效识别及分割.

Fig. 6 An example of semantic segmentation results with SYNTHIA as source domain and Cityscapes as target domain图6 以SYNTHIA为源域、Cityscapes为目标域分割示例

3.3.3 以MSCOCO数据集为源域的对比实验

为了验证本文方法的有效性和泛化性,设定MSCOCO[20]数据集中带有精准语义标注的图像数据为源域数据集,VOC 2012[21]数据集中针对分割任务的图片为目标域数据集,与文献[26-29]中的方法进行对比与验证实验.

表4所示,对于图像整体,以及图像中汽车、摩托车和行人等常见的交通语义类别,本文方法依然拥有较高的分割精准度.其中,汽车类在先前方法中的分割精准度均值约为53.8%,本文方法可将其提升至62.6%;摩托车类在先前方法中的分割精准度均值为42%,本文方法将其提升为43.4%;而先前方法中图像分割的平均交并比值最高[29]为45.9%,本文提出的方法可达48.6%.

3.4 消融实验

在3.3节中,经过3组与先前方法的对比实验,已验证本文方法的有效性和泛化性;为了进一步验证本文方法中每个步骤的可行性,本节对本文方法中具体的优化阶段进行消融实验,验证每个处理阶段的正确性和必要性.

Table 4 Comparison of Results with MSCOCO as Source Domain and VOC 2012 as Target Domain

Notes: The best results are in bold; Moto stands for Motorbike, Per stands for Person, and TVmo stands for TV-monitor.

3.4.1 针对源域数据的消融实验结果

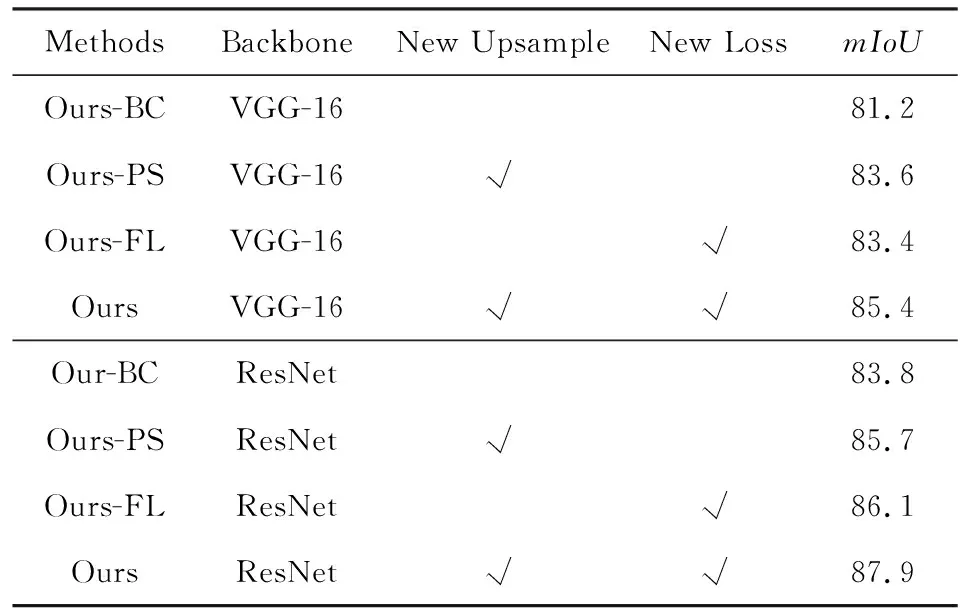

如表5所示,Ours-BC表示直接使用骨架网络的本文基础方法在源域数据集上得到的实验结果;Ours-PS表示单独改进本文上采样方法得到的实验结果;Ours-FL表示单独改进本文监督学习方法的损失函数得到的实验结果;Ours表示融合2个优化方法在源域数据集上得到的实验结果.针对2.2.1节中提出的基于监督学习的源域数据分割优化方法,经本文消融实验对比,在使用不同的基础网络的前提下,超分辨率重建和改进focal loss损失均可提升原分割结果约2%,本文方法中将其结合使用,可在源域数据集GTA5中提高整体分割精准度约4%.同时,在基础网络中,使用ResNet的分割结果优于使用VGG-16得到的分割结果约2%.

Table 5 Ablation Study Results of Optimization Method with GTA5 as Source Domain

Notes: “√” indicates that the method described in the corresponding column is used for the experiment described in the current row.

3.4.2 针对目标域数据的消融实验结果

针对本文2.2节中提出的优化源域分割方法和使用类别相关信息进行数据对齐,在采用2种基础网络的前提下,消融实验对比结果如表6所示.在表6中,Ours-BC表示直接使用骨架网络的本文基础方法在目标域数据集上得到的实验结果;Ours-S表示单独对源域训练部分进行优化在目标域上得到的实验结果;Ours-C表示单独利用类别相关信息,在改进目标域跨域方法时在目标域上得到的实验结果;Ours表示使用本文完整方法得到的实验结果.在进行领域自适应的过程中经过优化源域分割方法,可提升目标域数据集Cityscapes的分割精准度约3%,使用类别信息可提升分割精准度约3%,本文在2.2.1节和2.2.2节中综合考虑并实现2阶段的优化方法,将目标域的整体分割精准度提升约6%.

综上,将本文提出的方法,在3个不同类型的源域数据集、2个不同类型的目标域数据集上进行验证实验.结果表明:分割的精准度在不同的语义类别上均有着较高的提升,证明了本文方法的有效性,同时,也证明了基于类别相关的领域自适应语义分割方法拥有较强的泛化性,可以有效应用于不同类型的数据集和图像场景中.

Table 6 Results of Ablation Study with GTA5 as Source Domain and Cityscapes as Target Domain

Notes: “√” indicates that the method described in the corresponding column is used for the experiment described in the current row.

此外,经过对源域数据集和目标域数据集的消融实验验证,本文方法中针对分割过程中每个阶段提出的优化方法均可有效提升实验结果,并且,经过本文方法的整体约束优化,分割结果达到更高的精准度.

4 总结与展望

本文提出了一种基于类别相关的领域自适应语义分割方法,用以解决数据集中类别分布不均及无标注数据集的语义分割问题.实验结果表明:本文方法通过优化上采样方法、关注小样本数据类别、调整领域自适应阶段、寻找结构化信息以及在判别阶段中采用基于类别相关的方法,可以有效提升源域数据集和目标域数据集中图像的语义分割精准度,并且可以将领域自适应的方法有效应用到更大的范围中.然而,本文提出的方法在针对行人等具有运动性且容易出现遮挡等问题的类别、分割精准度及边缘清晰度等结果仍有一定提升空间,未来考虑引入行人重识别中的一些特征、属性提取方法,以及根据已有数据集得到先验约束对分割结果再次约束优化等方法,对本文提出的方法进行更深层次的优化.