基于特征融合时序分割网络的行为识别研究

2020-01-09李洪均丁宇鹏李超波张士兵

李洪均 丁宇鹏 李超波 张士兵,3

1(南通大学信息科学技术学院 江苏南通 226019)2(计算机软件新技术国家重点实验室(南京大学) 南京 210023)3(南通智能信息技术联合研究中心 江苏南通 226019)4(通科微电子学院 江苏南通 226019)

人体行为识别是一项具有挑战性的任务,受光照不同、背景复杂、多视角、类内差异大等诸多因素的影响[1-3].人体行为识别算法主要分为2种:1)基于传统机器学习的方法[4-13];2)基于深度学习的方法[14-18].这2种方法各有优劣,基于传统机器学习的行为识别算法关键在于特征的提取,研究过程中往往会花费心力设计满足需求的特征,实现简单,但其表征行为动作的能力也受限于提取的特征;基于深度学习的行为识别算法能够自动学习特征,但需要大量数据支撑,自动提取的特征是否有效与网络结构设计、网络参数选取等息息相关.

行为识别中应用深度学习最直接的方法即使用卷积神经网络(convolutional neural network, CNN)对视频的每一帧进行识别,但这种方法并没有考虑到连续视频帧之间的运动信息.Ji等人[19]首次提出了3D卷积的概念,利用3D卷积核提取空间和时间特征用于行为识别.Simonyan等人[20]提出了双流卷积神经网络用于行为识别,该网络分为空间流卷积网络和时间流卷积网络2个部分.空间流卷积网络以单帧RGB图像为输入,表示视频中某一刻的静态表观信息;时间流卷积网络以连续几帧光流图像堆叠在一起为输入,表示物体的运动信息,最后将2个网络的分类结果融合得到最终准确率,该模型的提出打破了改进版的稠密轨迹提取算法(improved dense trajectories, IDT)[21]在行为识别领域的领先地位.Tran等人[15]提出了一种新的3D卷积神经网络(convolutional 3 dimention, C3D),C3D网络将连续视频帧堆叠起来作为网络输入,利用3D卷积核在堆叠后形成的立方体中进行卷积,较2D卷积核多了时间维度,这样可以从连续帧上获取运动信息,该算法最大的优势是识别速度较双流算法提升了很多.至此,行为识别算法形成了两大主流流派:一种是基于双流卷积神经网络的行为识别算法;另一种是基于3D卷积神经网络的行为识别算法.

目前,主流的行为识别网络输入数据为RGB图像和光流图像.对于空间流卷积网络,输入数据为RGB图像,最开始的空间流网络采用逐帧输入的方式,而目前公开的数据集往往单帧图像就能完成识别任务,这种情况下空间流卷积网络的输入就存在大量冗余信息.为了减少逐帧输入时连续帧之间的冗余,Zhu等人[22]提出了一种关键帧获取的方法,挖掘视频中对于行为识别有决定性的帧和关键区域,以此来提升准确率与效率.虽然这个提取关键帧的方法可以集成到1个网络中训练,但是其与目标检测网络RCNN类似,先提取候选框,再选关键帧,网络结构复杂;Kar等人[23]提出了一种AdaScan特征聚集方法,判断不同帧的重要程度,并据此聚集特征以实现提升准确率与效率的目的,该方法整体模型较前一种方法简单.对于时间流卷积网络,输入数据为光流图像,光流提取耗时耗力,并且光流所包含的运动特征未必是最优特征.不少研究者对光流进行了改进,并且对其在行为识别中起到的作用进行了研究.Zhu等人[24]提出了一种双流卷积网络,在时间流网络之前加入了MotionNet生成光流图像,作为时间流卷积网络的输入,该方法提升了光流质量;Sevilla-Lara等人[25]通过实验证明了光流对于行为识别有效是因为它的表观特征不变性,其本身质量评判指标终点误差(end-point-error, EPE)与行为识别准确率并无强相关性,从测试的光流算法来看,光流在边界处以及小位移处的精度对于行为识别算法性能的提升有强相关性,并且通过行为识别的损失函数值对光流进行改进,使得识别准确率得以提升.同样,由于光流图像的弊端,也有不少研究者在寻找能够替代光流的特征方面做了一些工作.Zhang等人[26]利用运动向量来替代光流,运动向量原本用于视频压缩,不需要额外的计算就可以直接提取,极大地加快了双流卷积网络的识别速度,但精度有所降低;Choutas等人[27]提出了一种新型姿态特征,通过提取人体关键关节点的轨迹,并对其进行颜色编码,形成姿态特征图像用于行为识别,其对于RGB图像和光流图像所提供的特征具有补充作用,单一使用表现不佳.仅通过改变双流网络的交互方式和提取新的运动特征作为网络输入,并不能同时解决精度与速度的问题,网络结构的改变对于算法性能的提升也有决定性的作用.

近年来,主要的行为识别网络结构大都基于双流网络和3D卷积网络发展而来.Wang等人[28]提出了时序分割网络(temporal segment network, TSN),利用多个双流网络提取不同时序位置上的短时运动信息并进行融合,以解决传统双流只关注表观特征和短时运动信息的问题.Lan等人[29]继承了TSN的优良特性,对于不同时序位置上的短时运动信息进行了加权融合;Zhou等人[30]提出了时序推理网络,该网络建立在TSN基础之上,增加了3层全连接网络学习不同长度视频帧的权重,并对不同长度的视频帧进行时序推理,最后进行融合得到结果.Xu等人[31]结合了C3D和Faster-RCNN(faster-region convolutional neural network)[32]的思想提出了R-C3D(region-convolutional 3D network),R-C3D使用3D卷积提取视频特征,采用了Faster-RCNN形式的思路,即先生成提议,再进行候选区域池化,最后进行分类和边界回归,该网络可以对任意长度的视频进行端到端行为识别,并且速度快、通用性好;Qiu等人[33]针对行为识别中采用的3D卷积进行改造,提出了P3D网络(pseudo-3D residual net, P3D ResNet),利用1×1×3卷积和3×1×1卷积代替3×3×3卷积,前者与2D卷积类似,提取空间流特征,后者用来获取时间流特征,这种方法大大减少了计算量.不仅双流卷积网络和3D卷积神经网络可以提取时间流信息,利用长短时记忆网络(long short-term memory, LSTM)[34]也可以进行时间维度建模,这也是目前行为识别领域比较流行的一个方向.Long等人[35]提出了一种结合注意力机制的多模态LSTM结构,稳定性高;Du等人[36]引入姿态注意力机制,结合了LSTM和CNN结构,能够有效提取时空特征.另外,还有研究者在构成深度网络的通用部件方面做了研究,Wang等人[37]提出了一种新型的非局部网络结构,将非局部操作作为一个高效、简单、通用的组件,能够用来捕捉神经网络中的长距离依赖关系.深度学习算法以双流结构和3D卷积为主,其中基于双流结构的算法精度高,速度较慢;而基于3D卷积的算法速度快,精度略低,整体高于传统的机器学习算法,在应对复杂背景、类内变化大等问题方面较传统算法有很大优势.

本文针对主流的双流卷积网络输入数据为RGB图像和光流图像的局限,利用低秩空间中稀疏特征能够有效捕捉视频中运动物体的信息特点,对网络输入数据进行补充.同时,针对网络中缺乏信息交互的特点,将深度网络中高层语义信息和低层细节信息结合起来共同识别行为动作,使网络性能更具优势.本文的主要贡献有2方面:

1) 研究了基于时序分割网络的双流卷积神经网络,从网络输入数据的角度展开研究,提出了融合稀疏特征的时序分割网络,更好地聚焦运动目标.

2) 针对特征利用率低的问题,从网络结构的角度展开研究,提出了多层特征融合的行为识别时序分割网络,更好地融合特征.

1 相关工作

1.1 双流卷积神经网络

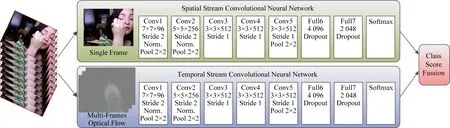

双流卷积神经网络分为空间流卷积神经网络和时间流卷积神经网络,这2个卷积神经网络分别处理视频的空间维度和时间维度,分别提取空间信息和时间信息,双流卷积神经网络基本结构如图1所示.其中,空间信息是指视频中的场景、物体等信息;时间信息是指视频中物体的运动信息.

空间流卷积神经网络的输入是单帧的RGB图像,能有效地识别静止图像中的人体行为动作,网络结构类似于常用的图像分类网络,通常使用Alexnet,VGG16,GoogleNet等深度模型作为空间流卷积神经网络,一般先在ImageNet上预训练,然后再将预训练的参数迁移到空间流网络中来,以提升网络训练速度和性能.时间流卷积神经网络的输入是堆叠的连续帧光流图像,光流能够表示视频中物体的运动信息,是利用像素点在时域上的变化以及其在连续帧上的相关性来表示物体运动的一种方式.利用光流的这一特性,能有效识别连续帧之间的人体行为动作,为了时空网络融合时特征维度相匹配,时间流网络结构通常和空间流卷积网络相同.

Fig. 1 Two-stream convolutional neural network图1 双流卷积神经网络结构

双流网络的融合是指空间流网络与时间流网络之间的融合,一般分为2种形式:1)空间流和时间流2个独立卷积网络在它们的Softmax层后进行融合,只是结果的融合,通常使用平均法和加权法融合不同类别的得分,得到最后的结果;2)时空网络在中间特征层融合.一般在某一网络层进行时空特征融合后形成混合的时空卷积网络;另一种融合方式是形成混合的时空卷积网络之后,保留单纯的空间流卷积网络或者时间流卷积网络,Softmax层之后再一次融合不同类别的得分,得到最终的结果.

1.2 3D卷积神经网络

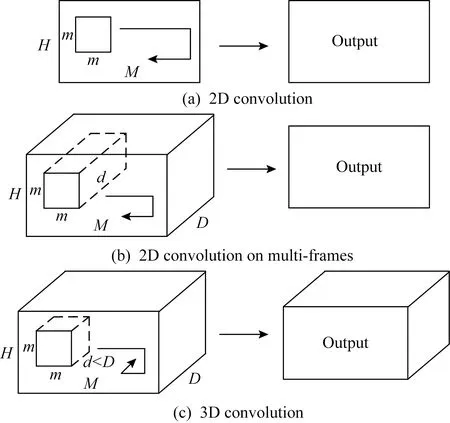

在视频序列中使用卷积神经网络,最直接的方法是对视频序列的每一帧图像使用卷积神经网络来识别,但是这样对单帧图像的处理没有考虑连续帧之间的信息,在行为识别中行为的发生一般会持续一个过程,在连续帧之间存在运动信息.那么,为了有效利用连续帧之间的运动信息,文献[15]提出一种3D卷积神经网络的方法,即在卷积神经网络结构中采用3D卷积核进行卷积,3D卷积核与2D卷积核相比,增加了时间维度,可以同时获取时间和空间维度的特征,在行为识别特征表示方面优于2D卷积.2D卷积是在单帧图像的基础上进行卷积,通常选取3×3大小的卷积核,将2D卷积应用于图像将输出图像,将2D卷积应用于多个图像,将它们视为不同的通道,也会得到图像.因此,2D卷积网络在每次卷积操作之后都会丢失输入信号的时间信息.3D卷积是在相邻的几帧图像上进行卷积,卷积核大小一般为3×3×3,只有3D卷积才能保留输入信号的时间信息,如图2所示:

Fig. 2 2D convolution and 3D convolution图2 2D卷积与3D卷积

3D卷积神经网络体现时间维度是将多个连续的图像帧堆叠在一起,形成1个立方体,然后在立方体中使用3D卷积核进行卷积,卷积核的深度要小于堆叠的图像帧的数量.因此,3D卷积中的每一个特征都会有相邻帧的特征相连,在连续帧上的表示便能获取到视频中物体的运动信息.

1.3 时序分割网络

给定1个视频V,把它分成K段{S1,S2,…,SK},每段的时长相等.那么时序分割网络可以表示为

QTSN(T1,T2,…,TK)=H(g(F(T1;W),F(T2;W),…,F(TK;W))),

(1)

其中,(T1,T2,…,TK)是视频V中的单一帧组成的序列,而Tk是由其对应的视频子片段Sk中的帧随机采样产生,k∈{1,2,…,K};F(Tk;W)是输入属于不同类别的分数预测函数,即视频帧Tk经参数为W的卷积神经网络后得到1个C维的向量,其表示Tk分别属于C类行为动作的预测得数;g(·)是段共识函数,将多个子视频经卷积神经网络得到的预测结果进行融合,获得关于视频所属类别的一致性预测结果G=(G1,G2,…,GC)T,C表示类别数;基于以上的一致性预测结果,使用函数H(·)预测整个视频属于每个行为类别的概率,这里H(·)使用Softmax函数,概率最高的类别就是视频V所属类别.结合分类常用的交叉熵损失,最终视频V的类别预测损失函数可以表示为

(2)

其中,yi表示类别i的真值.这种时序分割网络是可微的,或者至少有次梯度的,由函数g(·)的选择决定,可以用反向传播算法和多个子视频帧来联合优化模型参数W.在反向传播过程中,模型参数W关于损失值L的梯度为

(3)

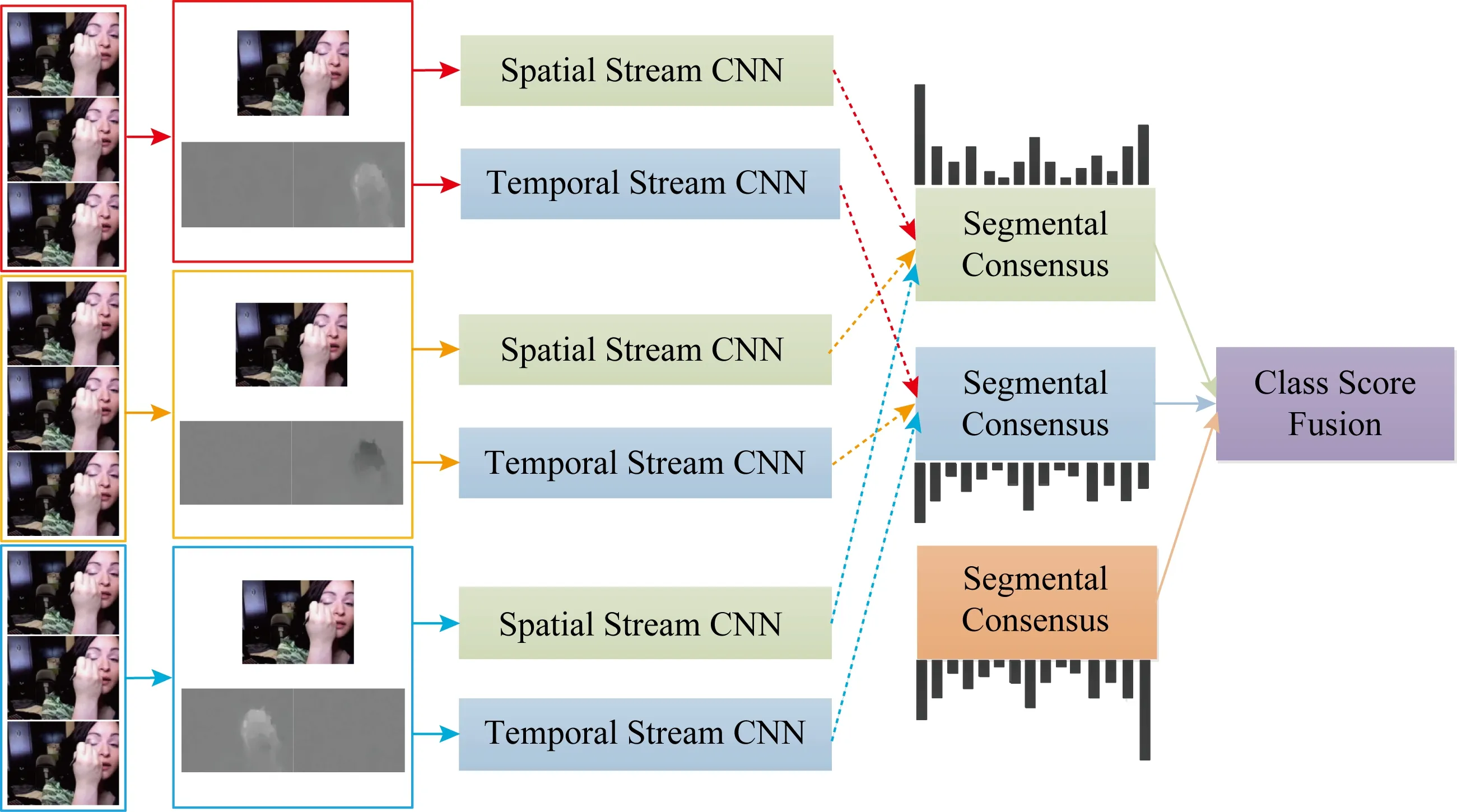

其中,K是TSN使用的子视频段数.TSN从整个视频中学习模型参数而不是1个短的片段.与此同时,通过对所有视频固定K,采用了一种稀疏时间采样策略,其中采样片段只包含一小部分帧.与先前使用密集采样帧的方法相比,这种方法大大降低计算开销.时序分割网络结构如图3所示:

Fig. 3 Temporal segment network图3 时序分割网络结构

2 特征融合时序分割网络的行为识别

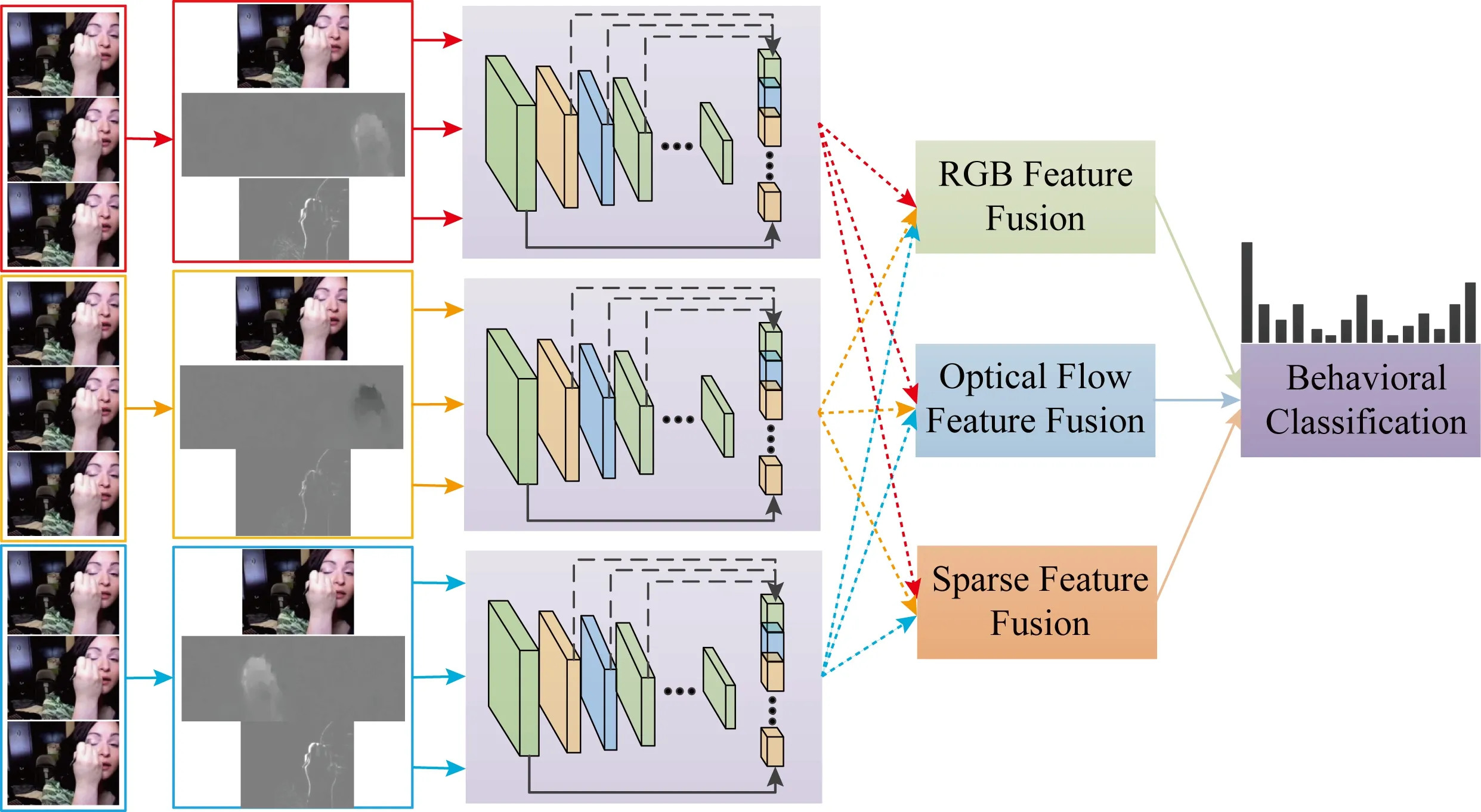

本节将详细从网络输入数据和网络结构2个方面展开研究:1)研究了融合稀疏特征的网络输入数据,目的是稀疏特征聚焦于视频中的前景目标,能够有效地提取图像中的运动物体,减少冗余信息,与RGB图像和光流图像包含的信息形成互补;2)利用卷积神经网络可视化验证了浅层卷积能提取细节特征,深层卷积能提取语义特征,将深度网络中高层特征的语义信息和低层特征的细节信息相结合,利用不同卷积层之间的特征优势互补,有利于网络捕捉人体行为的整体特征和不同类别之间的细节特征,从而提升行为识别的准确率.图4为算法的流程图.具体步骤为:1)将输入的视频平均分为3个子视频,对3个子视频随机采样,获取样本的RGB、光流以及稀疏图像,分别输入到卷积网络中;2)提取各数据类型不同卷积层的特征,将卷积网络提取的特征按照不同的样本类型进行融合;3)利用Softmax函数进行行为分类.

Fig. 4 Diagram of action recognition of temporal segment network based on feature fusion图4 特征融合时序分割网络的行为识别框图

2.1 稀疏特征

许多实际应用中已知的数据矩阵D往往是低秩或近似低秩的,但存在随机幅值任意大且分布稀疏的误差破坏了原有数据的低秩性,为了恢复矩阵D的低秩结构,可将矩阵D分解为2个矩阵之和,即D=A+E,其中矩阵A和E未知,但A是低秩的,E是稀疏的.

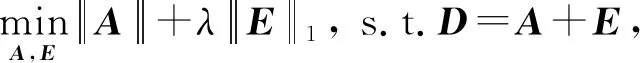

当矩阵E的元素服从独立同分布的高斯分布时,可用经典的主成分分析方法来获得最优的矩阵A,即转换为最优化问题:

(4)

当E为稀疏的大噪声矩阵时,PCA无法给出理想的结果,可用鲁棒性主成分分析(robust principal component analysis, RPCA)来获取最优矩阵A,则式(4)问题可以转化为优化问题:

(5)

其中秩函数rank(·)、矩阵的0范数均非凸,变成了NP-hard问题,需要对其松弛.因为,核范数是秩函数的凸包,且1范数是0范数的凸包,故式(5)的NP-hard问题松弛后可转化为凸优化问题:

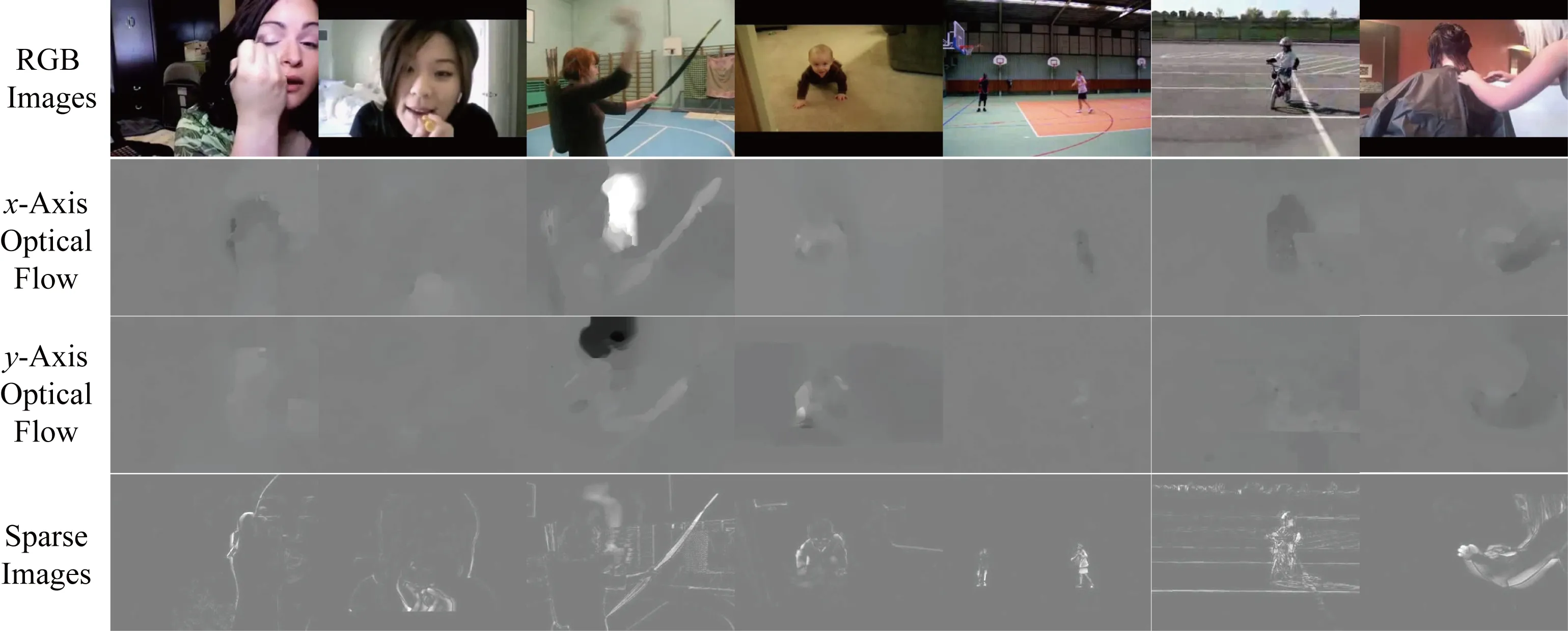

Fig. 5 Comparison of RGB, optical flow and low rank data图5 RGB、光流和低秩数据对比

(6)

对于式(6)所描述的RPCA问题,可以使用增广拉格朗日乘子法来优化,拉格朗日函数为

(7)

其中,Y为拉格朗日乘子,μ是1个较小的正数.

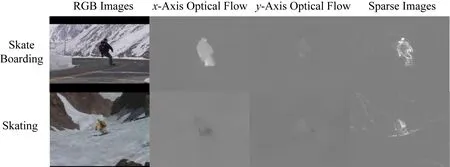

RPCA在图像和视频处理方向应用广泛,常用于图像矫正、去噪、视频背景建模与前景目标提取等方面,类似地,还有图像分割、显著性检测等[38-42].对于视频中的前景目标分割,由于帧与帧之间的相关性,背景被近似为低秩分量;而前景目标只占据图像中一小部分像素,例如人体运动,运动的人体部分可以看作是稀疏分量.通过以上的增广拉格朗日乘子法求解RPCA问题,对于行为动作视频可以得到如图5所示的稀疏特征.图5中第1行表示RGB图像,第2行表示x轴方向的行为运动光流图像,第3行表示y轴方向的行为运动光流图像,第4行表示稀疏图像.由图5可知,RGB图像表示图像的表观特征,既包括背景,也包括前景目标;光流图像表示图像中运动物体的运动方向与速度,对于x轴方向,白色表示往右边运动,灰度值越高说明运动速度越快,黑色表示往左边运动,灰度值越低说明运动速度越快,其余灰色区域表示没有运动物体,y轴方向同理,白色表示往上边运动,黑色表示往下运动;而稀疏特征图像不同于彩色和光流图像,其聚焦前景目标的行为动作,能有效地提取出运动物体,同时去除背景能有效降低数据的冗余度,显著提升网络训练速度.

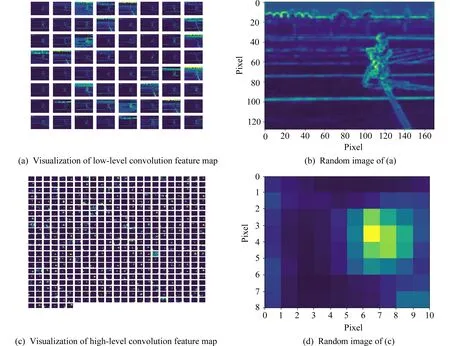

2.2 网络特征融合

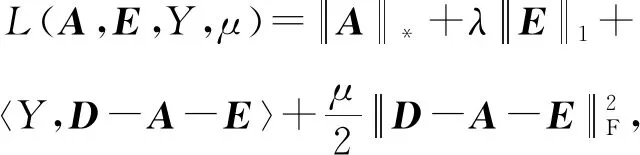

针对其网络中缺乏信息交互的缺点,将深度网络中高层语义信息和低层细节信息结合起来共同识别行为动作,使网络性能更具优势.多层特征融合是建立在卷积神经网络低层细节特征和高层语义特征基础之上的,利用不同深度卷积层特征具备的特点来实现.以inceptionv2网络为例来说明改进后的卷积神经网络工作原理,如图6所示.该网络是由多流卷积神经网络组合而成.对于空间流卷积神经网络而言,假设输入的彩色图像尺寸大小为224×224×3,首先选取尺寸大小为7×7、步长为2的卷积核,利用卷积层提取输入图像的特征,得到64个大小为112×112的特征图,然后进行最大池化得到56×56的特征图;选取尺寸大小为3×3、步长为2的卷积核,再次卷积提取池化后的特征并二次池化,得到池化后的特征大小为28×28×192.接着,将得到的特征依次经过10个inception结构单元,分别是从结构单元inception3a到inception5b,得到的特征大小为7×7×1 024,再次经过1个平均池化输出1×1×1 024的特征,展开为1D向量作为全连接层的输入之一;与此同时,将浅层卷积后的输出特征也展开为1D向量送入全连接层.最后,以浅层卷积特征和深层卷积特征一同输入全连接层,形成1×101的向量.

如图6所示,以融合inception3a层的输出特征和inception5b的输出特征为例来说明多层卷积特征融合过程.为了清楚说明高低维度特征的融合原理,表1列出了卷积神经网络各层输出的特征尺寸大小.

Table 1 Map Size of Network Layers表1 网络各层输出特征图尺寸

Fig. 7 Feature visualization of convolutional neural networks图7 卷积神经网络特征可视化

首先,输入图像经过前2层卷积层和池化层之后得到28×28×192的特征图,前2维数据表示特征图的长和宽,第3维数据表示通道数.然后,将特征送入inception3a层,经过inception结构单元中的4个支路分别得到4组特征,将这4组特征串联起来作为下一层的输入.与此同时,对该特征进行池化操作,这里选择平均池化,相较与最大池化,平均池化在减少维度的同时,能够保留更多的图片背景信息,有利于信息传递到下一个模块进行特征提取,并且使得其尺寸与深层卷积特征尺寸相同,便于特征融合.另外,由于特征融合会增加特征维度,增大计算复杂度,通过卷积核为1×1的卷积做降维,得到浅层卷积特征.将浅层卷积特征与inception5b层的输出特征串联起来,展开为1维向量作为全连接层的输入.

(8)

其中,1≤i≤H,1≤j≤M,1≤d≤D,并且xa,xb∈RH×M×D,y∈RH×M×D.

3 实验与仿真

本节在2个大型动作数据集上进行实验,来验证融合特征的时序分割网络的有效性.这2个数据集分别是UCF101和HMDB51.其中,UCF101数据集包含101个动作类别和13 320个视频剪辑;HMDB51数据集是包括各种来源(如电影和网络视频)的大量逼真视频,数据集由来自51个动作类别的6 849个视频剪辑组成.实验遵循数据集原始评估方案,使用3个训练测试分组,分别为数据集分组1、数据集分组2、数据集分组3,并以这些分组的平均准确率作为最终的行为识别准确率.

本节实验使用小批量随机梯度下降算法来学习网络参数,批量大小设置为32,动量设置为0.9.另外,使用数据集预先训练的模型初始化网络权重,并在实验中设置了较小的学习率.对于空间网络,学习速率初始化为0.001,并且每2 000次迭代减少110,整个训练过程在10 000次迭代时停止;对于时间网络和稀疏网络,将学习速率初始化为0.005,在12 000和18 000次迭代后减少到110,最大迭代次数设置为20 000.为了快速提取光流,选择在OpenCV中用CUDA实现的TVL1光流算法;为了加速训练,采用了多个GPU的数据并行策略,使用Caffe和OpenMPI2实现.

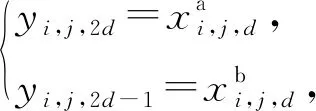

3.1 实验数据集

UCF101有13 320个视频,包括101个动作类别,动作多样性大,在摄像机运动、物体外观和姿态、物体比例、视点、杂乱背景、光照条件等方面存在较大变化,并且动作视频均由剪辑而成,而非演员表演,具有一定的真实性,是目前最具挑战性的数据集,数据集中部分动作类别如图8所示:

Fig. 8 Partial action categories in UCF101 dataset图8 UCF101数据集部分动作类别

HMDB51数据集包含6 766个视频剪辑,分为51个动作类别,每个动作类别至少包含101个视频剪辑,部分动作类别如图9所示.HMDB51数据集大部分来自电影,一小部分来自公共视频网站,如Prelinger archive,YouTube和谷歌视频等.

Fig. 9 Partial action categories in HMDB51 dataset图9 HMDB51数据集部分动作类别

3.2 实验环境

深度学习硬件环境:CPU E5-2696v4,GPU 2块GTX1080Ti,256 GB固态硬盘,32 GB内存;网络的学习与测试环境:Ubuntu16.04,NVIDIA CUDA 8.0,cudnnv5,Caffe,opencv3.0,Python.

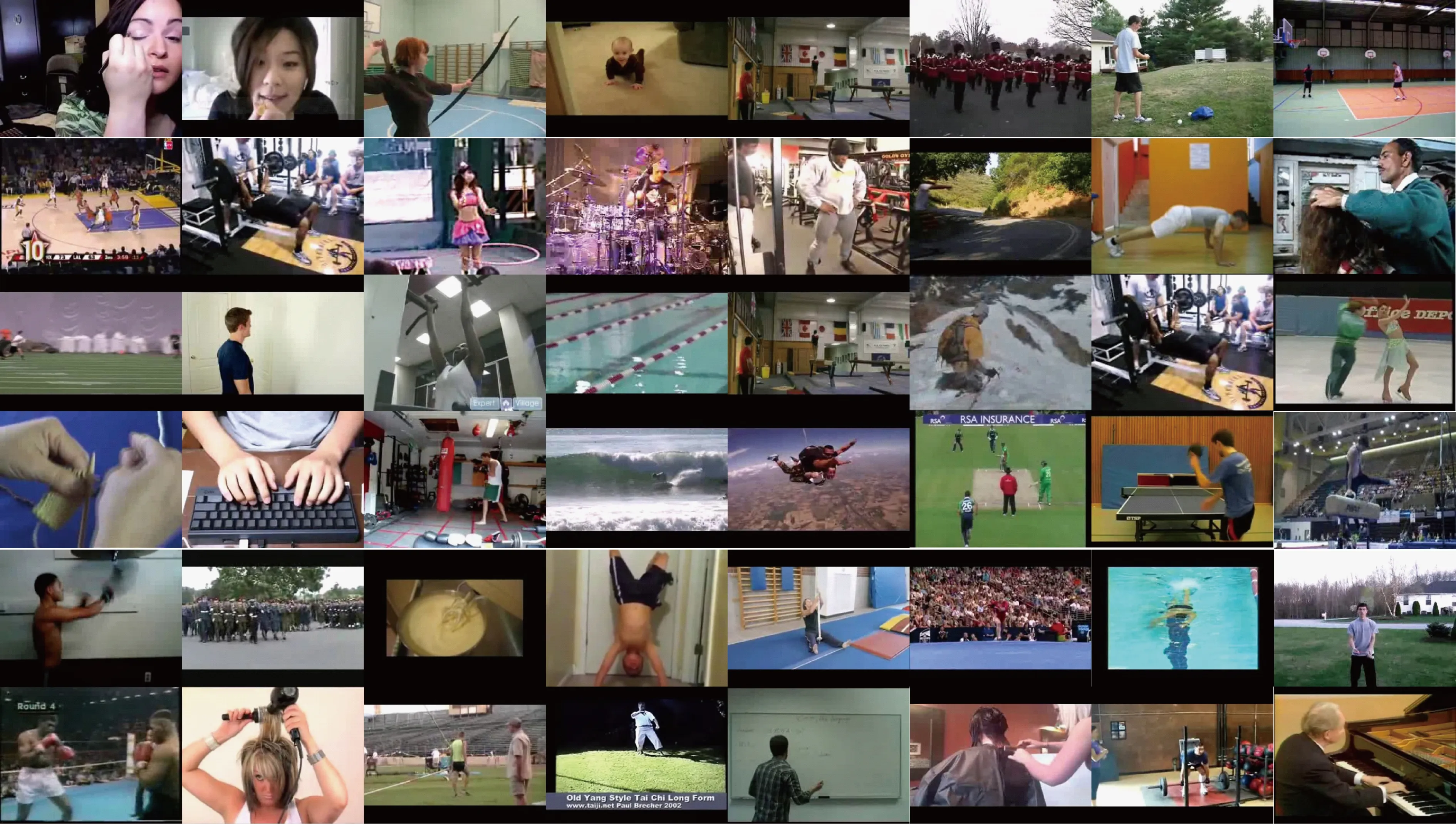

3.3 稀疏特征引入效果

实验在UCF101和HMDB51这2个公共行为识别数据集上对其进行了验证,并与近年来一些经典算法以及常用算法进行了比较,对比结果如表2所示:

Table 2Accuracy Comparison of Different Algorithms onUCF101 and HMDB51 Datasets

表2 UCF101和HMDB51数据集上不同算法准确率比较%

Note: Bold fonts represent the best values in different algorithms.

从表2可以看出,算法分为3类:

第1类是不使用深度学习算法的传统经典机器学习算法,该类算法手动提取行为特征,稳定性高,在UCF101数据集上识别率可达到88%左右,在HMDB51数据集上识别率超过了61%.例如,文献[46]中提出的一种名为MoFAP的组合运动特征,该特征由3部分组成:局部运动特征、运动原子、运动语句.其中,运动原子指运动过程中的某一子阶段,而运动语句就是这些子阶段的组合,例如跳高分为3个子阶段,助跑、起跳和着陆,即运动原子;三者之间的不同组合就成为运动语句,通过这种方式使得特征对行为的表征能力更强,以提高识别精度.

第2类是使用3D卷积的深度学习算法,该类算法速度快,可以达到实时,且识别率较传统算法高出4%以上.例如,文献[48]认为不同的动作具有不同的时间和空间模式,有些行为可能需要长时间的行为动态才能辨认,提出了LTC网络结构,通过增加输入视频的时长以提高识别准确率.

第3类是使用双流卷积神经网络的算法,该类算法精度最高,可以达到94%以上.由表2可知,融合稀疏特征的时序分割网络较时序分割网络有一定提升,在UCF101上识别率可达到96%以上,在HMDB51上识别率超过了76%.

3.4 多层特征融合实验

为了验证多层卷积特征融合卷积网络的有效性,以UCF101数据集分组1的实验为例,从结构单元inception3a层到inception5a层的输出与inception5b层的特征进行融合,各层融合之后的网络识别率.表3列出了RGB、光流图像和稀疏图像训练的时序分割网络在加入多层特征融合方法之后的识别率.与RGB图像类似,利用光流图像和稀疏图像训练的时序分割网络也是在incepteion5a层输出的特征和incepteion5b层输出的卷积特征融合后,得到的识别率最高,分别达到了93.56%和86.10%,光流基本维持不变,稀疏网络较不融合浅层卷积特征的网络识别率高了0.6%以上,说明了浅层特征的加入对于网络性能的改善.

Table 3Comparison Recognition Rate of Different ConvolutionLayers Fusion under UCF101 Dataset

表3 UCF101数据集分组1下不同卷积层融合的识别率对比%

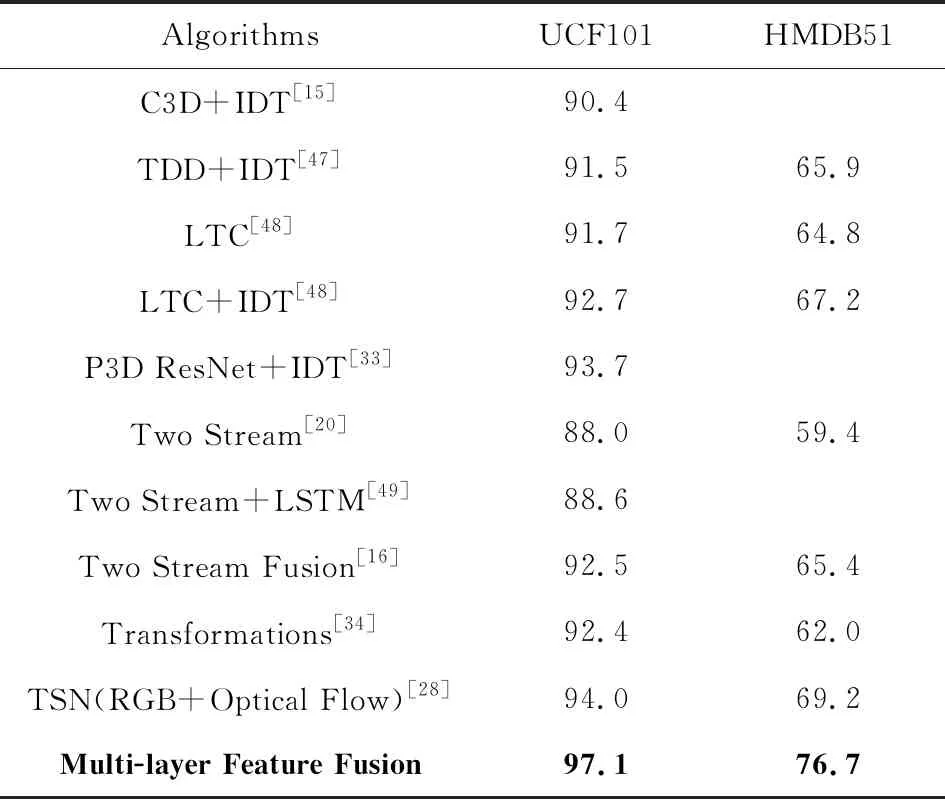

为了进一步验证多层特征融合的行为识别时序分割网络的有效性,实验在UCF101和HMDB51这2个公共行为识别数据集上对其进行了验证,并与近年来一些经典算法以及常用算法进行了比较,对比结果如表4所示.

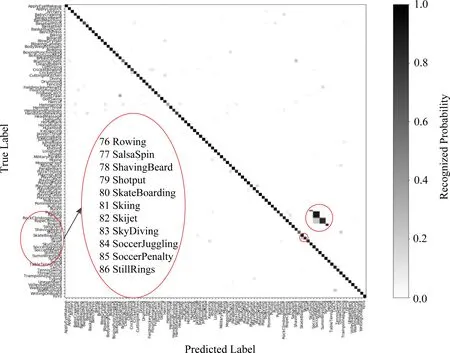

Fig. 10 Accuracy confusion matrix on UCF101 dataset图10 UCF101数据集准确率混淆矩阵

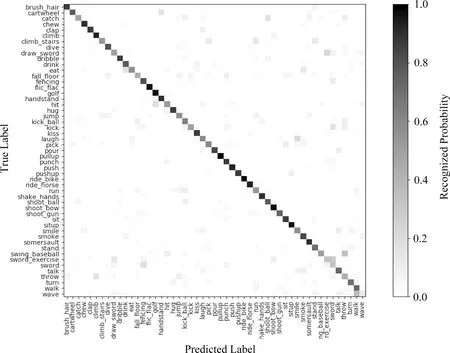

从表4可以看出,多层特征融合的行为识别时序分割网络较原有的融合稀疏特征的时序分割网络有一定的提升,UCF101识别率为97.1%,在HMDB51数据集上可以达到76.7%,说明浅层卷积层与深层卷积融合对于网络性能的提升具有一定的作用.其准确率混淆矩阵图10和图11所示,x轴表示预测的视频动作类别,y轴表示真实的视频动作类别,右侧图例颜色越深表示准确率或者误识率越高,颜色越浅表示准确率或者误识率越低;混淆矩阵对角线上的小方块表示识别准确率,其余位置的小方块表示误识率,即视频实际属于小方块所在行对应的类别,被误识为小方块所在列对应的类别;且每一行小方块对应的概率之和为1,若该行对角线上的小方块对应的概率为1,该类别识别准确率为100%,若该行对角线上的小方块对应的概率小于1,则该类别存在误识.例如UCF101数据集中,第80和第81个类别分别为滑板和滑雪,如图12所示,分别例举了其RGB图像、光流图像和稀疏图像,可以看出这2个动作类别较为相似,观察混淆矩阵中局部放大部分可以发现,这2个类别的误识率相对于其他类别偏高.

Table 4 Accuracy Comparison of Different Algorithms on UCF101 and HMDB51 Datasets表4 UCF101和HMDB51数据集上不同算法准确率比较 %

Note: Bold fonts represent the experimental results of our method.

Fig. 11 Accuracy confusion matrix on HMDB51 dataset图11 HMDB51数据集准确率混淆矩阵

Fig. 12 Legend of the 80th and 81st categories图12 第80个和第81个类别图例

4 总 结

本文研究了基于时序分割网络的双流卷积神经网络,并在它的基础上提出了融合稀疏特征的时序分割网络.同时针对特征利用率低的问题,提出了多层特征融合的行为识别时序分割网络.本文基于稀疏特征和多层特征融合的行为识别网络,算法在公共库UCF101和HMDB51上的识别效果要好于主流算法.

人体动作识别是一项具有挑战的任务,本文提出特征融合时序分割网络的行为识别,从网络输入数据的角度展开研究,虽然在一定程度上和RGB图像以及光流图像表示的特征存在互补,但单独使用时,效果均不如RGB图像和光流图像,如何优化稀疏特征,减少矩阵分解过程中的信息缺失,提高它的表征能力,是需要进一步研究.针对特征利用率低的问题,从网络结构的角度展开研究,提出了多层特征融合的行为识别时序分割网络,主要研究了浅层特征与深层特征的融合,虽然一定程度上提高了特征利用率,但是这还远远不够,不同网络之间的特征交互是需要进一步研究.目前,大多数行为识别方法都使用光流来表示运动特征,但光流提取耗时耗力,并且光流所包含的运动特征未必是最优特征,寻找优质的运动特征替代光流,提升行为识别效率,这些需要进一步研究和探索.