基于动作模板匹配的弱监督动作定位

2019-10-23石祥滨周金成刘翠微

石祥滨 周金成 刘翠微

摘 要:为解决视频中的动作定位问题,提出一种基于模板匹配的弱监督动作定位方法。首先在视频的每一帧上给出若干个动作主体位置的候选框,按时间顺序连接这些候选框形成动作提名;然后利用训练集视频的部分帧得到动作模板;最后利用动作提名与动作模板训练模型,找到最优的模型参数。在UCF-sports数据集上进行实验,结果显示,与TLSVM方法相比,所提方法的动作分类准确率提升了0.3个百分点;当重叠度阈值取0.2时,与CRANE方法相比,所提方法的动作定位准确率提升了28.21个百分点。实验结果表明,所提方法不但能够减少数据集标注的工作量,而且动作分类和动作定位的准确率均得到提升。

关键词:动作定位;动作模板;弱监督;动作提名;视频

中图分类号: TP391.4

文献标志码:A

Weakly supervised action localization based on action template matching

SHI Xiangbin1,2, ZHOU Jincheng1*, LIU Cuiwei2

1.College of Information, Liaoning University, Shenyang Liaoning 110136, China ;

2.College of Computer Science, Shenyang Aerospace University, Shenyang Liaoning 110136, China

Abstract: In order to solve the problem of action localization in video, a weakly supervised method based on template matching was proposed. Firstly, several candidate bounding boxes of the action subject position were given on each frame of the video, and then these candidate bounding boxes were connected in chronological order to form action proposals. Secondly, action templates were obtained from some frames of the training set video. Finally, the optimal model parameters were obtained after model training by using action proposals and action templates. In the experiments on UCF-sports dataset, the method has the accuracy of the action classification increased by 0.3 percentage points compared with TLSVM (Transfer Latent Support Vector Machine) method; when the overlapping threshold is 0.2, the method has the accuracy of action localization increased by 28.21 percentage points compared with CRANE method. Experimental results show that the proposed method can not only reduce the workload of dataset annotation, but also improve the accuracy of action classification and action localization.

Key words: action localization; action template; weakly supervised; action proposal; video

0 引言

計算机视觉中的动作定位任务[1-19] 不仅需要在空间上和时序上定位动作,而且需要确定动作类别。即不仅需要确定动作在视频每一帧上的位置,而且需要确定动作从什么时间开始到什么时间结束,以及视频中动作是什么类别的动作。动作定位有着广泛的应用前景,比如警方需要确定犯罪分子的逃跑路线或是街头斗殴的经过以及球迷希望集中观看足球场上精彩射门瞬间等。

近些年对视频动作定位的研究方兴未艾。文献[1-6]虽然能够做到在时序上对动作进行定位,但是无法在空间上对动作进行定位。现有的能够实现动作时空定位的方法可以概括为两类,一种是强监督方法,另一种是弱监督方法。文献[8-16]利用强监督方法定位动作,这些方法的缺点在于必须对数据集中视频的每帧图像逐一标注,使得研究人员将大部分时间花在标注数据集这样简单重复的工作上,牺牲了真正研究算法的时间。文献[17-18]采用弱监督方法,利用从网络上下载的图像来帮助定位人的动作,减少了标注数据集所花费的精力,但是获取合适的网络图像、处理网络图像同样不容易。为解决动作定位任务中数据集标注工作量大且容易标错的问题,本文提出一种基于模板匹配的动作定位模型,只需要对视频作类别标注和极少的帧级别标注,是一种弱监督方法,减少了处理数据集的时间,同时也不用借助网络图像。

1 动作定位问题的起源与难点

随着互联网、社交媒体的发展,生活中需要处理的视频激增,借助计算机视觉技术,可以在一定程度上解决有限的人员精力和海量视频数据之间的矛盾。计算机视觉中动作识别任务能够确定视频中动作的类别,但是有时不但需要知道动作类别还需要知道动作发生的时空位置,由此产生了动作定位。

动作识别本身就是一项困难的工作,对于未经处理的视频,相机的抖动和复杂的背景加大了识别的难度,但是近些年来计算机视觉领域的发展使得这项任务取得了很大进展,处理动作识别数据集时只需要确定每个视频的类别标签,这相对来说不是一件繁重的事情。在动作定位中,不但要标注动作的类别,还要标注动作在每一帧上发生的具体位置,对于大型的数据集,靠人工来完成是一项艰巨的工作,不仅量大、耗时长,而且容易出错。如果在只知道数据集中视频类别的情况下就可以实现动作定位,就可以大大减少研究人员在数据集处理上所花费的时间。

2 模型主要思想

为定位视频中动作的位置并确定视频中动作的类别,需要先在视频的每一帧上给出若干个动作主体(人)的矩形候选框;然后按照时间顺序连接候选框形成多个候选的动作轨迹,即动作提名;最后从这些动作提名中选择一个最合适的提名作为动作的位置,同时判定动作的类别。由于本文方法是弱监督的,训练视频只做了动作类别标注和极少部分帧级别标注,动作的实际位置并未标注出来,所以模型训练时需要利用动作模板从动作提名中选择一个最合适的提名作为视频中动作的真实位置。每类动作的动作模板从训练视频中极少部分帧级别标注的矩形框得到。训练视频中动作的真实位置未被告知,看作模型的隐变量,模型训练时从动作提名中取值。

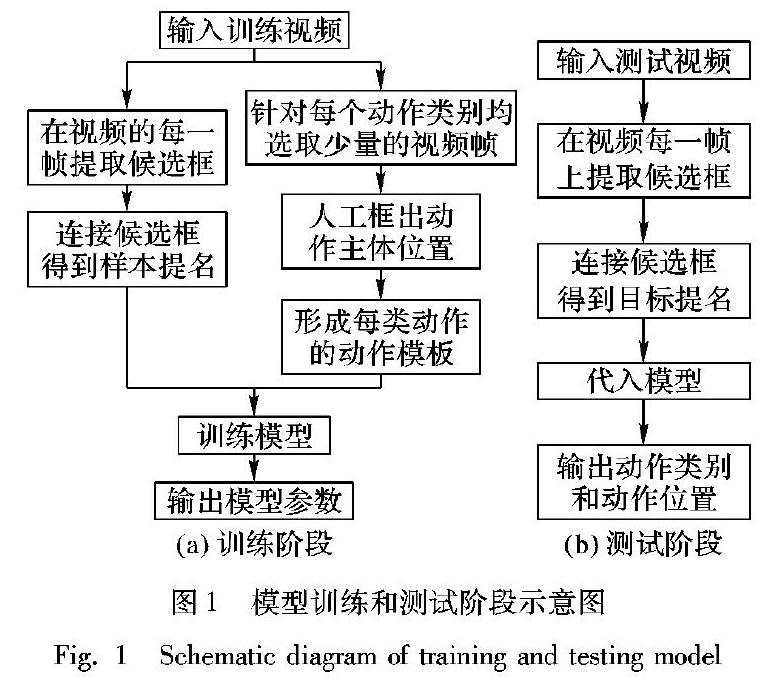

模型训练阶段,首先在训练视频每一帧上给出动作主体(人)的若干个候选框,然后按照时间顺序连接候选框形成多个候选动作轨迹,即动作提名。从训练视频中提取的动作提名称作样本提名,分别提取整个视频的C3D(Convolutional 3-Dimension)特征[19]和样本提名的C3D特征。同时从训练集中选择少量视频帧,人工标注出动作主体的位置,形成每类动作的动作模板。模型训练时,训练视频中动作的实际位置未人工标注,通过动作模板与样本提名匹配,促使模型選择最合适的样本提名作为视频中动作的位置。利用整个视频的C3D特征、样本提名的C3D特征和动作模板训练模型。图1(a)是训练阶段示意图。

测试阶段,同样在每个测试视频帧中给出动作主体(人)的候选框,连接候选框形成动作提名,从测试视频中提取的动作提名称作目标提名,然后将整个视频的C3D特征[19]和目标提名的C3D特征代入训练好的模型,确定动作类别和动作位置。图1(b)是测试阶段的示意图。

模型训练需要解决以下几个问题:1)获得每个测试视频的样本提名;2)得到动作模板,以及样本提名与动作模板匹配;3)求解模型参数。

3 获取动作提名

训练阶段和最后的识别都需要先获取动作提名。首先在每一个视频帧上获得候选框,由于动作的主体是人,所以主要提取人的候选框;然后, 按照时间顺序连接这些候选框形成动作提名,并利用稳定光流去除动作提名中不包括动作的部分。

3.1 生成候选框

获取动作提名的前提是在视频帧上生成精度高的候选框,由于目前还没有一种在精度、速度、召回率这三方面均表现良好的解决方案,所以为了得到高质量的候选框,采用多种方法,取长补短。这里采用三种方法来获得帧上的候选框,分别是YOLOv3(You Only Look Once in version 3)[20]、EdgeBoxes[21]和Objectness[22]。Objectness根据目标框之间的NG(Normed Gradients)[22]特征具有显著的共性,以及目标框和背景框的NG特征明显不同,确定哪些候选框框住的是目标。虽然这种方法计算速度快、召回率高,但是结果不够精确。EdgeBoxes利用边缘信息确定框内的轮廓个数和与框边缘重叠的轮廓个数,然后给出候选框,这种方法的缺陷在于评分较高的框近乎是整幅图像的大小,虽然召回率高但是不够精确。相比前两种方法,YOLOv3的优点是给出的候选框精确度高,同时可以判定类别,缺点是召回率较低。

提取候选框时,YOLOv3能够提取高质量的人的候选框,但是由于人的姿态丰富多变,会出现在某些帧上丢失检测的情况。EdgeBoxes和Objectness得到的候选框比较丰富,召回率较高,但是大多数都不精确且不知道框住的物体是什么。三种方法各有利弊,为提升候选框的数量和质量,对YOLOv3设定一个较高阈值获得高质量的人的候选框,并利用EdgeBoxes和Objectness继续在每一帧上提取物体候选框,最后每一个视频帧上得到的候选框包括所有的YOLOv3候选框,以及得分排名靠前的EdgeBoxes和Objectness候选框各500个。连接过程中优先连接YOLOv3候选框,在出现丢失检测的帧上用另外两种候选框替代。

3.2 连接候选框

获取帧级别的候选框后,需要在帧与帧之间无间断地连接候选框,所形成的候选框序列就是动作提名。动作提名最大的特性就是平滑性和相似性,帧与帧之间的连接要平滑,前一个框和后一个框要具有很强的相似性。

框与框的连接是一个沿着时间顺序按照连接得分大小决定是否进行连接的过程。后一个框与前一个框的连接得分由下式计算得到:

score=α1·IOU+α2·A+α3·S

(1)

IOU= box1∩box2 box1∪box2

(2)

A=1- | area1-area2 | area1+area2

(3)

α1+α2+α3=1

(4)

其中:IOU表示两个框的重叠度,A表示两个框面积的相似性,area1和area2是框的面积,S表示颜色直方图的相似性。IOU和A约束动作提名的平滑性,S约束动作提名上框与框之间的相似性。连接时先连接得分较高的YOLOv3框,在没有满足条件的YOLOv3框的情况下尝试连接满足条件的EdgeBoxes或Objectness候选框。动作主体是人,而YOLOv3提取人的候选框,所以每个动作提名的第一个矩形框总是YOLOv3框,由于YOLOv3框数量较少,减少了无效连接的数量。经过实验发现,候选框重叠度和候选框大小相似性两个因素对获得动作提名一样重要,候选框颜色直方图相似性要比其他两个因素影响更大,所以实验中候选框连接得分公式中的参数α1、α2和α3分别设置成0.3、0.3和0.4。每个动作提名连接时,如果与下一帧上候选框连接的最高得分score<0.2,则结束该提名的后续连接。

3.3 确定时间位置

为便于标记时间位置,使从视频中提取的每个动作提名的长度与该视频的长度相等,把动作提名没有覆盖到的视频帧上的位置标记成(0,0,0,0),四个数分别是矩形框左上角坐标和右下角坐标。每个动作提名的有效长度不包括标记成(0,0,0,0)的部分,本文其他地方提到的动作提名都是指有效长度部分。对动作提名使用稳定光流[23]来确定动作的开始位置和结束位置。计算每一帧的平均光流幅值和相应的动作提名上矩形框的平均光流幅值来舍弃动作提名的头部和尾部中不是动作的部分。

γ>f/F

(5)

其中:f是矩形框内的平均光流幅值,F是整个视频帧的平均光流幅值。当f/F小于阈值γ时,将动作提名当前的矩形框标记成(0,0,0,0);当f/F大于于阈值γ时停止。γ取值1.5。

4 动作模板

每类动作的动作模板是该类动作各种动作姿态的集合,从训练集得到。数据集中有c类动作,就会形成c种动作模板。由于训练视频中动作位置未被人工标注,动作模板的作用在于使模型训练时选择最合适的样本提名作为训练视频中动作的位置。

分别从每个动作类别的训练视频中随机选择200帧图像,在这些视频帧上人工标注出动作的位置,然后提取标注框的VGG(Visual Geometry Group)特征[24],特征的维度用dim表示。将标注框的特征按列合并成矩阵 M ,将 M 看作动作模板,若每个动作模板包含n个标注框,则 M 是一个dim×n维矩阵。为使得到的动作模板更具代表性和可靠性,能够很好地表征一类动作,并且 M 的维数不至于过大,将标注框集合随机且有重合地形成3组,也就是每类动作形成3个动作模板。为解决动作模板中同一姿态出现次数过多、动作姿态不够多样的问题,对矩阵 M 的列向量组求极大线性无关组,组中不符合条件的动作姿态从标注框集合中随机选择一个替换,直至最终确定合适的动作模板。

同时,对每个样本提名关键帧上的候选框提取VGG特征,关键帧选取的步长是ρ,按列合并这些特征形成矩阵 P , P 的行数是特征的维数,列数是框的个数。

样本提名与动作模板的匹配等价于矩阵 P 中所有列向量能否被矩阵 M 近似地表示。将模板匹配转化成优化问题,如式(6)所示:

min u (‖ P - M · u ‖2F+λ1‖ u - u ‖2F+λ2‖ u ‖1)

(6)

用文献[7]中方法求解出此优化问题的参数矩阵 u ,其中 u 是 u 行向量均值在列上的级联。式(6)中‖ P - M · u ‖2F是匹配误差,与动作实际位置重叠度越高的样本提名和动作模板之间匹配误差越小。由于一个连续动作轨迹上的矩形框具有时序性,框与框的特征之间具有相似性,因此参数矩阵 u 中列向量之间应具有相似性。式(6)中‖ u - u ‖2F约束参数矩阵 u 中列向量的相似性。

比如,对于跳水动作,利用训练集中跳水视频的部分帧可以得到跳水动作的动作模板。将跳水动作模板与某个跳水视频的众多动作提名逐一匹配,匹配误差最小的动作提名就是最优提名,在模型训练阶段将找到的最优提名看作视频中动作的位置。

5 基于模板匹配的动作定位模型

获得训练视频的样本提名和每类动作的动作模板后,下一步建立基于模板匹配的动作定位模型,通过模型确定視频中动作的类别和时空位置。下面介绍模型训练过程,以及模型训练好后如何判定视频中动作的类别和位置。

5.1 模型训练

令V={(xi,yi)i=1:N}表示训练集,其中:xi表示第i个视频;Y是动作类别集合;yi是视频xi的动作类别标签,yi∈Y;N是视频的数量。Hi是从视频xi提取的样本提名集合。视频xi中动作的实际位置在训练之前未被人工标注,模型训练时选择一个最合适的样本提名h*i作为视频xi中动作的位置,h*i∈Hi,h*i视作模型的隐变量。

定义判别函数F(x,h):

F(x,h)=max y,h f w y(x,h)

(7)

f w y(x,h)= w y Φ (x,h)

(8)

分区

图2 联合特征的提取过程 和联合特征的结构

Fig. 2 Extraction of joint features and structure of joint features

其中:y表示动作类别,y∈Y;令H表示从视频x中提取的样本提名集合,h∈H; Φ (x,h)是由整个视频x的C3D特征和视频x中样本提名h的C3D特征组成的联合特征,如图2所示; w y表示与动作类别y相关的模型参数向量,f w y(x,h)是视频x和其样本提名h的联合特征与 w y的乘积。整个模型的参数 w 由全部的 w y组成。

为学习判别函数F(x,h)的参数,引入隐变量支持向量机,与普通支持向量机相比,唯一不同点在于模型训练时视频xi中动作位置h*i没有显式地告知,需要在参数学习过程中确定,将h*i看作隐变量。隐变量支持向量机参数优化问题定义为:

min w ,ξi,ξsi 1 2 ‖ w ‖2+c1∑ N i=1 ξi+c2∑ N i=1 ξsi

(9)

s.t.

fwyi(xi,h*i)-f w y′(xi,h′i)≥Δ(yi,y′)-ξi; y′,h′i,i

(10)

min j:yi=yj 1 zxi Θ(h*i,tj)≤ξsi; i

(11)

其中:c1、c2是惩罚系数;ξi、ξsi是松弛变量;N是视频的数量;y′从所有的动作类别中取值,y′∈Y;yi表示视频xi的真实动作类别;Hi是视频xi所对应的样本提名集合;h*i表示视频xi的动作位置,h*i∈Hi;对Δ(yi,y′),当yi≠y′时,Δ=1,否则Δ=0。

约束(10)是含有隐变量的支持向量机中最大间隔约束,确保模型能够对视频进行正确的类别判定。

tj是动作类别yj的动作模板;Θ(h*i,tj)表示h*i与tj的匹配误差,由式(6)计算,用来评估样本提名与动作模板的相似性,误差值越小说明相似性越大;

zxi=max h′i min j:yi=yj Θ(h′i,tj),h′i是视频xi中的样本提名,h′i∈Hi,zxi的值是确定的,用来归一化Θ(h′i,tj),使得ξsi的值始终在[0,1]范围内。由于视频xi中动作位置h*i未被人工标注,在训练阶段未知,看作是隐变量,约束(11)利用动作模板促使模型倾向于选择与动作实际位置一致的样本提名,提高动作定位的准确性。

利用文献[18,25]中的方法求解优化问题(9),得到模型的参数 w 。

5.2 识别和定位

利用学习到的参数 w ,将视频x的C3D特征和目标提名h的C3D特征代入式(12),可以知道任意视频x的动作类别y*和动作位置h*。h∈H,H是从视频x中提取的目标提名集合;y∈Y,Y是所有动作类别集合。算法1是判定动作类别和定位动作的伪代码。

(y*,h*)=max y,h f w y(x,h)

(12)

算法1 判定动作类别和定位动作。

输入 待处理视频x;

输出 动作类别y*和动作位置h*。

程序前

从视频x中提取动作主体(人)的候选框

按照算法2得到目标提名集合H

将视频x的C3D特征和目标提名的C3D特征代入训练好的F(x,h),h∈H

程序后

算法2 按照时间顺序连接候选框得到目标提名。

输入 用YOLOv2,EdgeBoxes,Objectness方法在视频x每帧上获取的候选框;

输出 动作提名集合H。

程序前

fo r t=0 to frames

//从第t帧开始搜索直到最后一帧

if numPath>500

//如果找到的提名数大于500

break

end if

wh ile pbs[t].size() != 0

//当第t帧上的候选框数不为0

if numPath>500

break

end if

+ +numPath

将动作提名的第一个框从第t帧上候选框集合移除

fo r j=t+1 to frames

if 在第j帧上找到满足连接条件的候选框

将j帧上连接的候选框从候选框集合中移除

el se

转至第一个for循环判定条件处

end if

end for

end while

end for

程序后

6 實验结果与分析

实验所使用的数据集是UCF-sports,该数据集包含多个运动视频,一共10类动作150个视频。其中:跳水动作(Diving-Side, DS)有14个视频,打高尔夫(Golf-Swing, GS)有18个视频,踢(Kicking, K)有20个视频,举重(Lifting, L)有6个视频,骑马(Riding-Horse, RH)有12个视频,跑步(Run-Side)有13个视频,玩滑板(Skateboarding, S)有12个视频,鞍马(Swing-Bench, SB)有20个视频,单杠(Swing-Sideangle, SS)有13个视频,走(Walk-Front, WF)有22个视频。UCF-sports数据集中视频的时间长度不一,视频帧的分辨率不一,背景复杂,对于动作定位来说十分具有挑战性。

遵循UCF-sports数据集官网对动作定位任务中数据集分类的建议,数据集中的103个视频作为训练数据,47个视频作为测试数据,训练集和测试集的比例大概是2∶ 1。实验中判定动作起止时间位置参数γ设置成1.5,动作提名中关键帧步长ρ是6,每个动作模板中包含20个人工标注的候选框。候选框连接阶段会舍弃长度过短的提名,提名中候选框少于10个认为不可靠。实验中用C3D网络[19]提取4096维的视频特征和动作提名特征,用VGG网络[20]提取4096维矩形框内的图像特征。

在UCF-sports數据集上,分类效果如表1和2所示。表1中的大写字符是每类动作的英文首字母缩写,表中数字是模型对测试集视频的分类结果,可以计算出总体的识别准确率是87.2%。从表3中可以看出本文方法在动作定位任务中识别精度优于其他方法,比TLSVM(Transfer Latent Support Vector Machine)[18]方法识别准确率提高了0.3个百分点。

实验定位效果如图3所示,图中虚线框是测试集中人工标注的位置,实线框由本文方法定位产生,定位效果的衡量标准按照式(13):

τ= 1 n ∑ n i=1 IOUi(b1,b2)

(13)

其中:τ是定位结果和动作真实位置之间的重叠度,表示定位的效果;n是动作持续的帧数;IOUi(b1,b2)是第i帧上定位框b1与实际框b2之间的交并比。在阈值τ取0.2的情况下,即定位结果如果与动作真实位置重叠度大于0.2时认为定位结果正确,将定位的精度与CRANE(Concept Ranking According to Negative Exemplars)[28]、Siva等[29]提出的方法和Sultani等[17]进行对比,结果如表4所示。

CRANE[28]、Siva等[29]提出的方法和Sultani等[17]都是弱监督方法,其中效果最好的Sultani等[17]先给出动作提名,然后利用网络图像来对动作提名排序,选出得分最高的动作提名作为定位结果。而本文方法动作的定位和识别同时进行,两者之间相互促进,知道动作类别可以帮助定位,知道动作位置也可以帮助判定类别,提高了各自的精度。另外,本文方法利用视频帧帮助定位动作比Sultani等[17]利用网络图像更加合适,因为视频帧中动作姿态来自一个完整连续的动作视频,比静止孤立的网络图像能够更好地表现动作的特点。从表4定位效果来看,本文方法要明显好于其他几种方法。

在UCF-sports数据集上的实验,如果使用强监督方法需要人工标注6605张训练集视频帧,而使用本文方法只需要分别从每个动作类别的训练视频中随机选择200帧图像人工标注即可,其余视频帧不用标注。由于UCF-sports数据集包含10个动作类别,所以人工标注2000张训练集视频帧,数据集标注的工作量将减少69.7%。

7 结语

本文提出一种只需对数据集中视频做动作类别和极少帧级别标注就可以定位动作的弱监督方法,训练时将动作真实位置看成是隐变量[30],利用动作模板在短时间内完成模型参数的学习。本文方法受相机抖动影响较小,并且可以处理任意长度视频,方法应用范围广。在数据集UCF-sports上的实验结果显示,相比CRANE[28]、Siva等[29]提出的方法和Sultani等[17]提出的方法,本文方法的定位效果分别提升了28.21个百分点、30.61个百分点和0.9个百分点。本文方法能处理包含单个主要动作的视频,但是当视频中出现两个及以上不同类型动作同时发生的情况,则不能很好地将这些动作都定位出来,这是未来需要继续研究的方向。

参考文献

[1] YUAN Z, STROUD J C, LU T, et al. Temporal action localization by structured maximal sums [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2017: 3215-3223.

[2] LIN T, ZHAO X, SHOU Z. Single shot temporal action detection [C]// Proceedings of the 25th ACM International Conference on Multimedia. New York: ACM, 2017: 988-996.

[3] SHOU Z, WANG D, CHANG S. Action temporal localization in untrimmed videos via multi-stage CNNs [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 1049-1058.

[4] SHOU Z, CHAN J, ZAREIAN A. CDC:convolutional-de-convolutional networks for precise temporal action localization in untrimmed videos [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2017: 1417-1426.

[5] XU H, DAS A, SAENKO K. R-C3D: region convolutional 3D network for temporal activity detection [C]// Proceedings of the 2016 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2017: 5794-5803.

[6] ZHAO Y, XIONG Y, WANG L, et al. Temporal action detection with structured segment networks [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2017: 2933-2942.

[7] SCHMIDT M. Graphical model structure learning with l1-regularization [D]. Berkeley: University of British Columbia, 2010: 27-32.

[8] SAHA S, SINGH G, SAPIENZA M, et al. Deep learning for detecting multiple space-time action tubes in videos [C]// Proceedings of the 2016 British Machine Vision Conference. Guildford, UK: BMVA Press, 2016: No.58.

http://www.bmva.org/bmvc/2016/papers/paper058/abstract058.pdf

https://arxiv.org/abs/1608.01529?context=cs

[9] ZOLFAGHARI M, OLIVEIRA G L, SEDAGHAT N, et al. Chained multi-stream networks exploiting pose, motion, and appearance for action classification and detection [C]// Proceedings of the 2017 IEEE Conference on International Conference on Computer Vision. Piscataway, NJ: IEEE, 2017: 2923-2932.

[10] SINGH K K, LEE Y J. Hide-and-Seek: forcing a network to be meticulous for weakly-supervised object and action localization [C]// Proceedings of the 2017 IEEE Conference on International Conference on Computer Vision. Piscataway, NJ: IEEE, 2017: 3544-3553.

[11] BAGAUTDINOV T, ALAHI A, FLEURET F, et al. Social scene understanding: end-to-end multi-person action localization and collective activity recognition [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2017: 3425-3434.

[12] CHEN L, ZHAI M, MORI G. Attending to distinctive moments: weakly-supervised attention models for action localization in video [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision Workshops. Piscataway, NJ: IEEE, 2017: 328-336.

[13] HOU R, CHEN C, SHAH M. Tube Convolutional Neural Network (T-CNN) for action detection in videos [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2017: 5823-5832.

[14] WANG L M, XIONG Y J, LIN D H, et al. UntrimmedNets for weakly supervised action recognition and detection [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2017: 6402-6411.

[15] KLSER A, MARSZAEK M, SCHMID C, et al. Human focused action localization in video [C]// Proceedings of the 2010 European Conference on Computer Vision, LNCS 6553. Berlin: Springer, 2010: 219-233.

[16] WEINZAEPFEL P, HARCHAOUI Z, SCHMID C. Learning to track for spatio-temporal action localization [C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2015: 3164-3172.

[17] SULTANI W, SHAH M. What if we do not have multiple videos of the same action? — video action localization using Web images [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 1077-1085.

[18] LIU C W, WU X, JIA Y. Weakly supervised action recognition and localization using Web images [C]// Proceedings of the 2014 Asian Conference on Computer Vision, LNCS 9007. Berlin: Springer, 2014: 642-657.

[19] TRAN D, BOURDEV L, FERGUS R, et al. Learning spatiotemporal features with 3D convolutional networks [C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2015: 4489-4497.

[20] REDMON J, FARHADI A. YOLOv3: An incremental improvement [J]. arXiv E-print, 2018: arXiv:1804.02767. [EB/OL]. [2018-09-23]. https://arxiv.org/pdf/1804.02767.pdf.

[21] ZITNICK L, DOLLR P. Edge boxes: locating object proposals from edges [C]// Proceedings of the 2014 European Conference on Computer Vision, LNCS 8693. Berlin: Springer, 2014: 391-405.

[22] CHENG M, ZHANG Z, LIN W, et al. BING: binarized normed gradients for objectness estimation at 300fps [C]// Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2014: 3286-3293.

[23] WANG H, SCHMID C. Action recognition with improved trajectories [C]// Proceedings of the 2013 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2013: 3551-3558.

[24] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [J]. arXiv E-print, 2015: arXiv:1409.1556. [EB/OL]. [2018-09-23]. https://arxiv.org/pdf/1409.1556.pdf.

[25] DO T, ARTIRES T. Regularized bundle methods for convex and non-convex risks [J]. The Journal of Machine Learning Research, 2012, 13(1): 3539-3583.

[26] LAN T, WANG Y, MORI G. Discriminative figure-centric models for joint action localization and recognition [C]// Proceedings of the 2011 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2011: 2003-2010.

[27] MOSABBEB E A, CABRAL R, TORRE F de la, et al. Multi-label discriminative weakly-supervised human activity recognition and localization [C]// Proceedings of the 2014 Asian Conference on Computer Vision, LNCS 9007. Berlin: Springer, 2014: 241-258.

[28] TANG K, SUKTHANKAR R, YAGNIK J, et al. Discriminative segment annotation in weakly labeled video [C]// Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2013: 2483-2490.

[29] SIVA P, RUSSELL C, XIANG T. In defence of negative mining for annotating weakly labelled data [C]// Proceedings of the 2012 European Conference on Computer Vision, LNCS 7574. Berlin: Springer, 2012: 594-608.

[30] 劉翠微.视频中人的动作分析与理解[D].北京:北京理工大学,2015:77-78. (LIU C W. Analysis and understanding of human action in video [D]. Beijing: Beijing Institute of Technology, 2015: 77-78.)