基于CNN特征提取和加权深度迁移的单目图像深度估计

2019-05-14安国艳梁宇栋

温 静,安国艳,梁宇栋

基于CNN特征提取和加权深度迁移的单目图像深度估计

温 静,安国艳,梁宇栋

(山西大学计算机与信息技术学院,山西 太原 030006)

单目图像的深度估计可以从相似图像及其对应的深度信息中获得。然而,图像匹配歧义和估计深度的不均匀性问题制约了这类算法的性能。为此,提出了一种基于卷积神经网络(CNN)特征提取和加权深度迁移的单目图像深度估计算法。首先提取CNN特征计算输入图像在数据集中的近邻图像;然后获得各候选近邻图像和输入图像间的像素级稠密空间形变函数;再将形变函数迁移至候选深度图像集,同时引入基于SIFT的迁移权重SSW,并通过对加权迁移后的候选深度图进行优化获得最终的深度信息。实验结果表明,该方法显著降低了估计深度图的平均误差,改善了深度估计的质量。

单目深度估计;卷积神经网络特征;加权深度迁移;深度优化

单目图像深度估计是计算机视觉领域的热点问题。然而,受到单个摄像头的制约,想要通过空间立体几何计算图像中精确的深度信息是极其困难的。

现有的单目图像深度估计算法大都是对1幅图像上的所有像素点赋予一个相对深度关系,有基于线索、基于图模型和基于采样的深度估计方法。基于线索的估计方法是利用各种单目深度线索进行深度估计,常用的深度线索包括:运动信息[1]、聚焦[2]、线性透视[3]、纹理、遮挡[4]、阴影[5]等。因为不同的线索只出现在特定的场景,且各线索与深度间的关系不是绝对的,所以存在场景适用性和深度估计失败的问题。基于图模型的估计方法[6]考虑到场景在不同深度处成像的阴影、纹理存在差异,以及彼此间的遮挡关系,采用图模型来描述图像特征和彼此间的相对位置关系,并通过监督学习进行训练。该类算法的缺点是需要设计参数化的模型以及引入太多的场景假设。针对此问题,KONRAD等[7]提出基于采样的估计方法,首先从RGBD (red green blue depth)数据库中检索出匹配的图像,然后通过融合匹配图像的深度得到测试图像的深度。文献[8]提出基于尺度不变特征变换(scale invariant feature transform, SIFT)流的深度迁移方法,在相似场景间通过SIFT流建立像素级稠密空间对应关系,并将相似图像对应位置上的深度直接迁移到输入图像上。文献[9-11]构建能量方程对迁移后的深度进行插值和平滑,进一步改善了深度估计的质量。但该方法没有考虑同一对象深度的均匀性,使得同一目标的深度关系不一致。此外,该类算法的核心步骤是从深度数据库中进行相似图像的采样,将直接影响最终深度融合的效果,目前其算法的采样都是基于传统的图像全局特征之间的欧式距离,没有考虑到输入图像中不同目标的差异性和同一目标的一致性。

本文在基于采样的深度估计方法基础上通过引入了卷积神经网络(convolution neural network, CNN)特征获得更精确有效的相似图像集,并利用基于SIFT的迁移权重(SIFT similar weight,SSW)改善深度迁移时的图像深度均匀性问题。为此,本文提出了基于CNN特征提取和加权深度迁移的单目图像深度估计算法。

1 算法框架

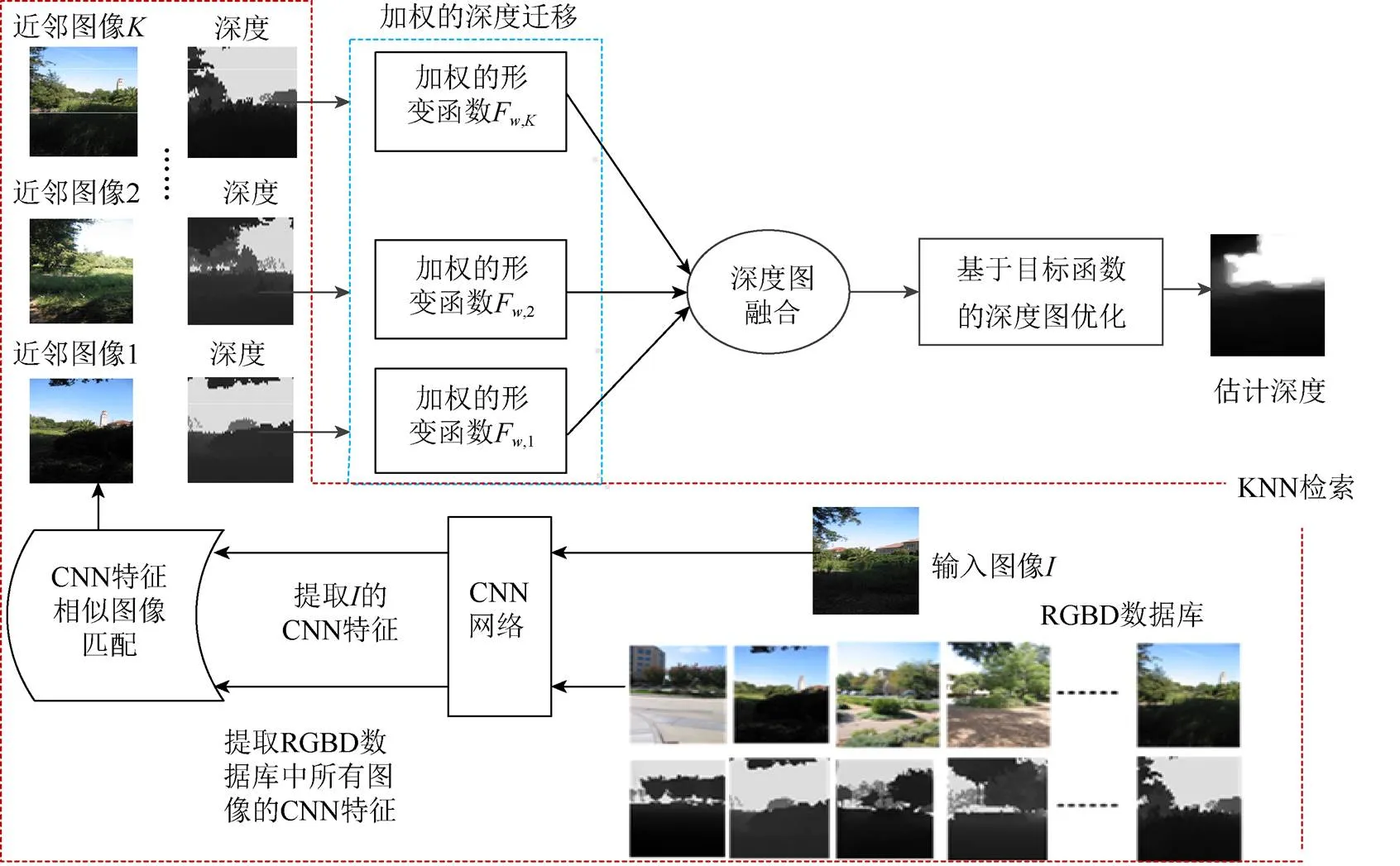

基于CNN特征提取和加权深度迁移的单目图像深度估计算法框架如图1所示,主要分为KNN检索、加权的SIFT流[8]深度迁移、深度图融合和基于目标函数的深度图优化4个模块。对于一幅输入图像,①通过KNN检索出对近邻图像和深度图;②通过SIFT流计算输入图像和各近邻图像的形变函数,将形变函数分别迁移到对应的候选近邻深度图并加权;③融合加权迁移后的候选深度图作为输入图像的初始深度估计;④建立目标函数对加权迁移后的候选深度图进行优化,便可得到最终的深度估计。

图1 基于CNN特征提取和加权深度迁移的单目图像深度估计算法框架

1.1 基于CNN特征的KNN检索

1.1.1 CNN特征提取

近年来,基于深度模型的CNN[12]在计算机视觉领域取得了重要进展,如物体识别和图像分类等。从深度网络模型提取的CNN特征在一定程度上可以弥补电子设备所捕获的特征和视觉特征所感知到的语义信息之间的差异,如Gist[13]、HOG[14]、LBP[15]和SIFT[16]等特征,其用以表征丰富的语义信息。

本文提取CNN特征所采用的CNN模型如图2所示,该网络模型是一个在大量ImageNet数据集上训练得到的预训练模型,其包含13个卷积层和3个全连接层。卷积层和前2个全连接层使用RELU(rectified linear units)作为激励函数。本文使用第2个全连接层的特征图作为图像的一种表示,因为该特征具有较好的性能。因此,对于给定图像,首先将其放缩到224×224大小作为网络的输入;其次通过网络逐层向前传播;最后,从第2个全连接层提取得到的特征图()大小为1×1×4096,将其编码为1×4096大小的一维向量作为CNN的特征表示。

图2 卷积神经网络模型

1.1.2 KNN检索

对于1幅输入图像,首先采用1.1.1节中的方法提取其CNN特征,并计算其基于CNN特征余弦匹配在RGBD数据库中的相似图像集。假设为输入图像,为候选近邻图像,(·)为CNN特征,由式(1)计算输入图像和RGBD数据库中每幅图像的CNN特征的余弦距离;然后,对距离从大到小进行排序;最后,将前个最大CNN余弦距离对应的图像作为的KNN (K-Nearest Neighbor),其对应的深度作为的候选近邻深度,即

1.2 加权的SIFT流深度迁移

利用SIFT流[8]建立图像之间的稠密像素级形变函数,将该形变函数迁移至候选近邻深度图像集,可作为输入图像估计的深度图。然而,该方法是对某幅候选近邻深度图像的全局迁移,没有考虑输入图像与候选近邻图像的空间关系局部差异性,使在同一目标估计出的深度信息缺乏一致性。为此,本文提出基于SSW权重的深度迁移,用于抑制因匹配误差造成的深度迁移误差。

1.2.1 基于SIFT流的形变函数

通过计算候选近邻图像与输入图像之间的SIFT流[8],进而构建候选近邻图像到输入图像的形变函数F。

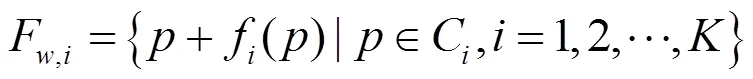

设为图像中(,)处的像素,候选近邻图像到输入图像间的SIFT流为(),则形变函数F为候选图像各像素叠加SIFT流的集合,即

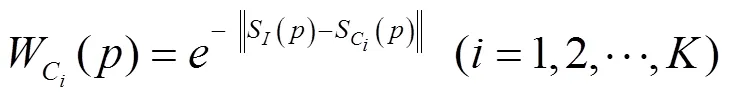

1.2.2 迁移权重SSW

本文提取SIFT描述符计算输入图像和候选近邻图像的相似程度作为迁移权重,以区分各候选近邻图像对输入图像深度迁移的贡献度。可定义该权重为基于SIFT的迁移权重SSW,并依据式(3)计算第幅候选近邻图像C到输入图像的迁移权重SSW,即

不同于将候选近邻图像对应位置上的深度直接迁移到输入图像上,而是将深度乘以权重再进行迁移。这样,各候选近邻图像对深度迁移的贡献不同,对其进行加权后再进行融合,可抑制因匹配误差造成的深度迁移误差。

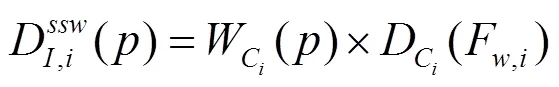

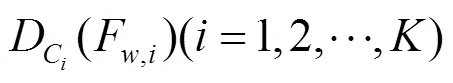

1.2.3 基于SSW的深度迁移

1.3 基于中值滤波的深度图融合

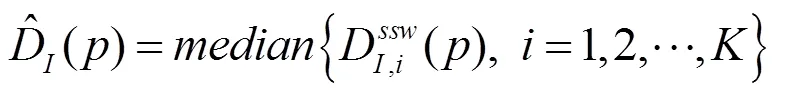

本文将输入图像的候选近邻深度图进行加权迁移后的各深度图进行融合,作为输入图像的初始深度估计。基于假设幅图像与输入图像中的相似物体应当出现在同一位置上,例如道路一般出现在图像的底部,本文采用相同位置上的深度值取中值的方式即中值滤波融合方法,即

1.4 基于目标函数的深度图优化

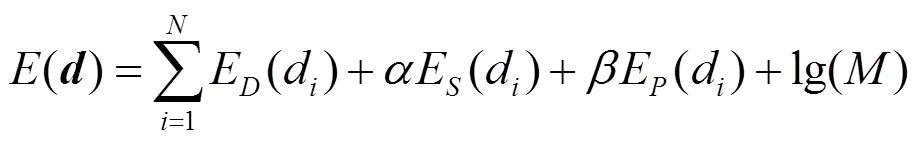

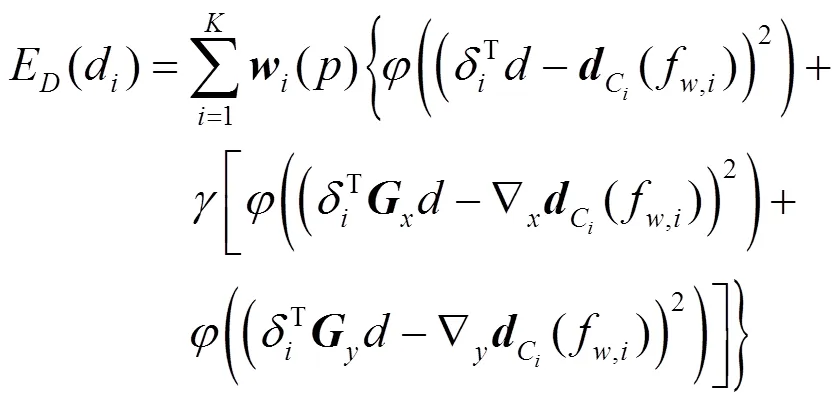

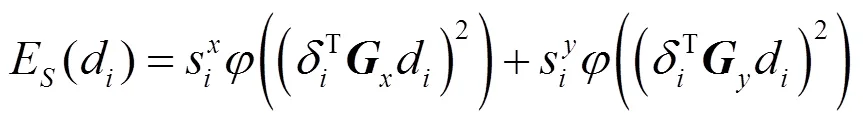

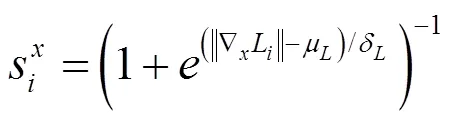

本文将优化后的最终深度图表示为维的列矢量,其中为输入图像中的像素总数。本文构建深度图优化目标函数包括数据项E、空间平滑项E和先验项E3部分,即

数据项E为优化后的深度图与迁移后候选近邻深度图的关联程度,其定义为

平滑项E为深度梯度延,方向上的平滑变化函数,即

先验项E是为了防止深度像素匹配的过程中出现输入图像的某些像素点,由于在近邻图像中匹配的像素点过少,从而无法进行深度赋值的问题,采用式(11)增加一个基本的深度赋值,即

其中,p为所有候选近邻深度图的平均值。

式(6)需要一个无约束的、非线性的优化,本文选用迭代重加权最小二乘法(iteratively reweighted least squares,IRLS)[17]对其最小化。IRLS是一种递归优化算法,其用一个参数化的线性函数近似代替原始的目标函数,并通过加权最小二乘法求解。由于每次迭代的权值是不确定的,IRLS算法实际上是一种通过迭代获取权值的方法。通过不断迭代求解直到收敛,可以得到较精确的估计深度图。

本文将式(5)的计算结果作为IRLS的迭代初值,对于每次迭代中最小二乘问题,使用预处理共轭梯度法(preconditioned conjugate gradient,PCG)[17]来进行求解。对于1幅输入图像,通过KNN候选近邻图像的匹配、加权的SIFT流深度迁移、深度图融合和基于目标函数的深度图优化4个步骤的逐步求精,可以得到最终的深度估计。

2 实验结果与分析

为了验证本文算法的有效性,实验采用Make3D数据库[18]和NYU Depth V2数据库[19]。Make3D数据库主要采集于室外场景,其包含400对“图像+深度”训练数据和134对“图像+深度”测试数据,图像和深度的分辨率均为1704×2272,其中深度通过激光测距仪获得。NYU Depth V2数据库主要通过Kinect采集于室内场景,将其原始的1 449张图像分为795对“图像+深度”训练数据和654对“图像+深度”测试数据,图像和深度的分辨率均为640×480。实验中IRLS迭代次数设置为10,候选近邻总数设置为7。

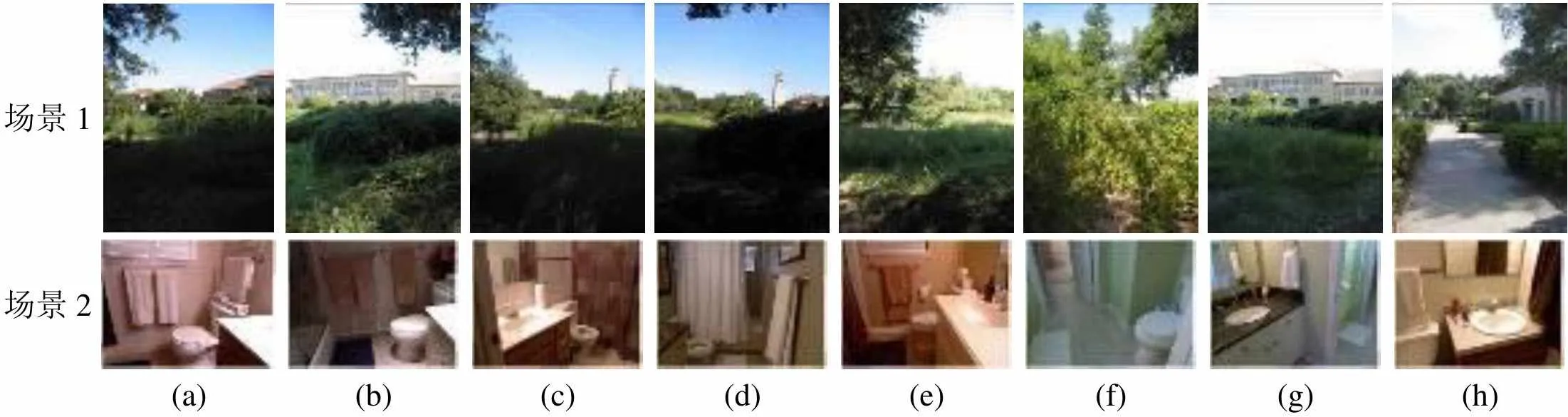

实验1. 为验证CNN特征余弦距离匹配进行KNN检索的有效性,与文献[10]算法中采用的Gist特征欧式距离匹配选取候选近邻图像的方法进行对比。图3和图4为场景1和场景2分别基于Gist特征欧式匹配和CNN特征余弦匹配的KNN检索结果,(a)为原图,(b)~(h)为对应场景基于KNN的检索结果。从(b)到(h),与待检索场景的相似度依次递减。由图可看出,通过提取CNN特征进行相似图像集匹配实验结果更符合人的语义信息,内容相似的场景被成功检索出来。

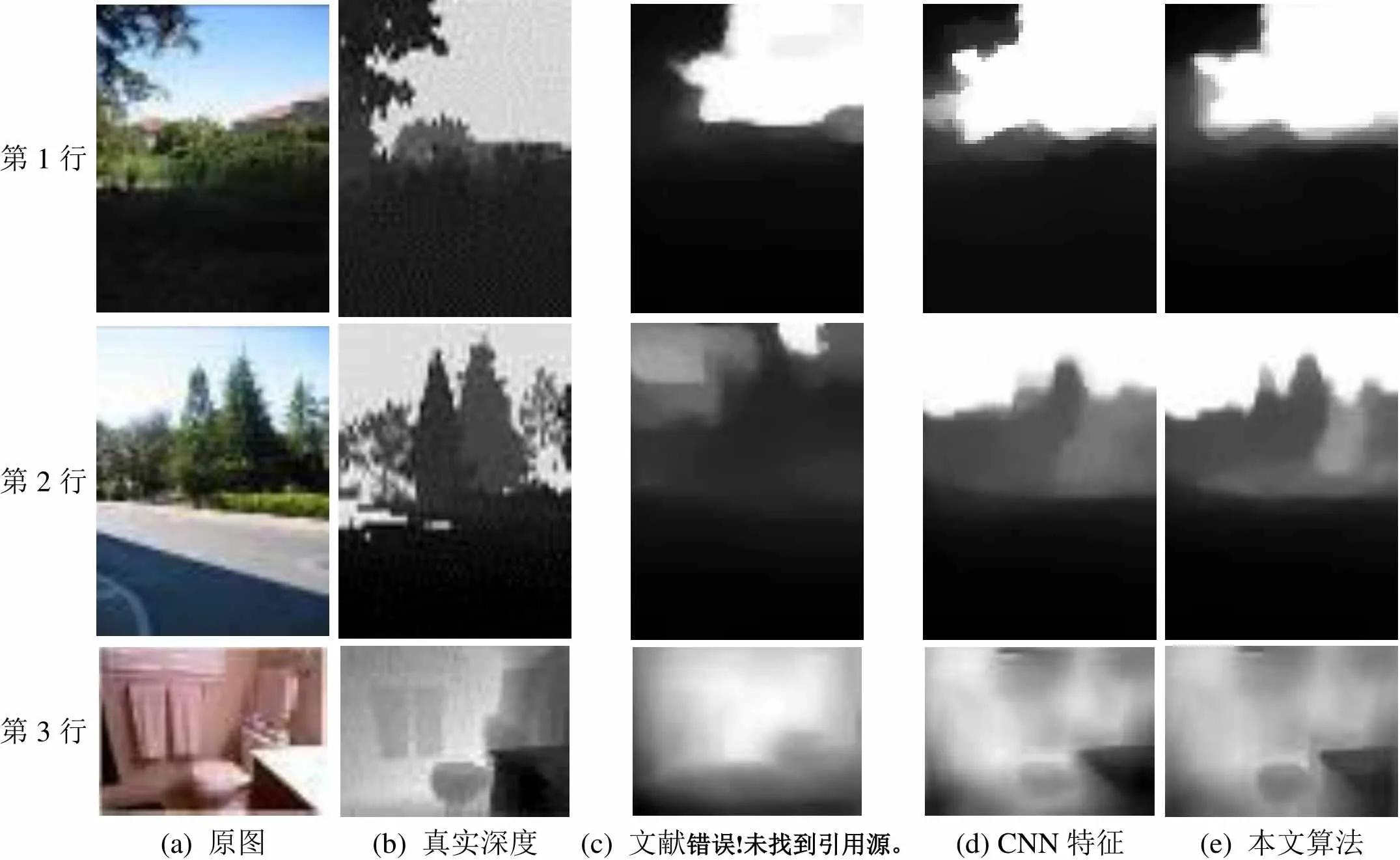

实验2.为验证CNN特征提取和加权深度迁移对深度估计的影响,将基于CNN特征提取的深度估计、本文算法与文献[10]算法进行比较,实验结果如图5所示。

从图5可以看出,CNN图像匹配可较好地重构出目标场景中的对象,如图5的第1行中,图5(d)深度估计比图5(c)更接近于真实深度;再如第2行中,图5(c)深度估计错误,而图5(d)准确地重构出目标对象。加权深度迁移更好地刻画目标图像中同一对象的均匀性,如图5的第3行中,图5(d)背景中马桶和洗漱台的边界不太明显,而图5(e)可较明显区分出边界信息,体现出了深度均匀性对深度估计的影响。

实验3. 为验证本文方法在不同单目图像上的有效性,与文献[10]算法进行对比,图6和图7分别为Make3D数据库和NYU Depth V2数据库的部分实验结果。从图中可以看出,通过本文方法估计的深度图的整体轮廓与真实深度更接近,局部细节信息更准确,更有利于进行图像的深度估计。

由图6可知,在室外场景中,相对于文献[10]算法,本文方法具有更加可信的深度估计结果,可以较好地保持原图中目标图像的边界,例如图第1和第2行中的树枝。同时,本文方法可以较好地估计出场景的轮廓结构,例如图第4行中的场景。此外,本文方法可以重构出场景细微之处的深度信息,例如图第3行中的右下角部分。

场景1 场景2 (a)(b)(c)(d)(e)(f)(g)(h)

场景1 场景2 (a)(b)(c)(d)(e)(f)(g)(h)

第1行 第2行 第3行 (a) 原图(b) 真实深度(c) 文献[10](d) CNN特征(e) 本文算法

第1行 第2行 第3行 第4行 (a) 原图(b) 真实深度(c) 文献[10](d) 本文算法

第1行 第2行 第3行 第4行 (a) 原图(b) 真实深度(c) 文献[10](d) 本文算法

由图7可知,在室内场景中,相对于文献[10]算法,本文方法可以精细地重构场景中的部分结构,例如图7第1行中的电视和柜子、第2和4行中的餐桌以及第3行中的马桶和洗漱台。

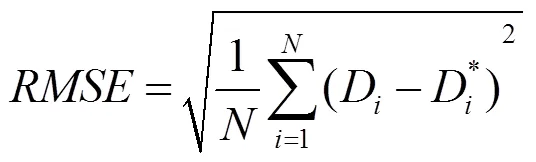

实验4.表1和表2分别给出了本文算法和文献[10]算法在Make3D数据库和NYU Depth V2数据库测试数据上的平均相对误差RE、平均均方根误差RMSE和平均对数误差LE,其分别如式(12)~(14)所定义方法进行计算,即

从表1和表2可看出,相比于文献[10]算法,本文算法利用CNN特征提取明显降低了估计深度图的RE、RMSE和LE视觉效果方面也取得了较好的效果,如图5(d)比(c)深度估计图更加接近于真实深度,优于文献[10]算法基于Gist特征进行KNN检索最终估计的深度效果;其次,本文算法基于CNN特征提取和加权深度迁移在平均误差方面相比于仅引入CNN特征匹配略有降低,但视觉效果上有明显提升,如图5(e)与(d)相比,加权深度迁移能刻画出场景中同一对象的深度均匀性,较明显区分出不同对象之间的边界信息,使估计深度图更接近于真实深度,又如图6和图7,本文算法明显提升了深度估计效果。

表1 在Make3D数据库上的比较结果

表2 在NYU Depth V2数据库上的比较结果

3 结束语

本文通过引入CNN特征计算输入图像的相似图像集,将相似图像对输入图像的形变函数迁移至相似候选深度图像并加权,以获取最终的深度估计。在实验结果分析中,无论是在定性的视觉对比,还是定量的性能对比,本文算法都获得了较优的结果,显著降低了估计深度的平均误差,改善了深度估计的质量。

[1] ROBERTS R, SINHA S N, SZELISKI R, et al. Structure from motion for scenes with large duplicate structures [C]//The 24th IEEE Conference on Computer Vision and Pattern Recognition, CVPR 2011. New York: IEEE Press, 2011: 3137-3144.

[2] SUWAJANAKORN S, HERNANDEZ C, SEITZ S M. Depth from focus with your mobile phone [C]//2015 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2015: 3497-3506.

[3] CHENG C C, LI C T, HUANG P S, et al. A block-based 2D-to-3D conversion system with bilateral filter [C]// 2009 Digest of Technical Papers International Conference on Consumer Electronics. New York: IEEE Press, 2009: 1-2.

[4] CHANG Y L, FANG C Y, DING L F, et al. Depth map generation for 2D-to-3D conversion by short-term motion assisted color segmentation [C]//2007 IEEE International Conference on Multimedia and Expo. New York: IEEE Press, 2007: 1958-1961.

[5] ZHANG R, TSAI P S, CRYER J E, et al. Shape-from-shading: A survey [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1999, 21(8): 690-706.

[6] SAXENA A, SUNG H. CHUNG A Y N. 3-D depth reconstruction from a single still image [J]. International Journal of Computer Vision, 2008, 76(1): 53-69.

[7] KONRAD J, WANG M, ISHWAR P. 2D-to-3D image conversion by learning depth from examples [C]//2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. New York: IEEE Press, 2012: 16-22.

[8] LIU C, YUEN J, TORRALBA A. SIFT flow: Dense correspondence across scenes and its applications [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5): 978-994.

[9] KARSCH K, LIU C, KANG S B. Depth extraction from video using non-parametric sampling [C]//The 12th European Conference on Computer Vision. Heidelberg: Springer, 2012: 775-788.

[10] KARSCH K, LIU C, KANG S B. Depth transfer: Depth extraction from video using non-parametric sampling [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(11): 2144-2158.

[11] 朱尧, 喻秋. 基于非参数采样的单幅图像深度估计[J]. 计算机应用研究, 2017, 34(6): 1876-1880.

[12] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks [C]//NIPS’12 Proceedings of the 25th International Conference on Neural Information Processing Systems. New York: IEEE Press, 2012: 1097-1105.

[13] OLIVA A, TORRALBA A. Modeling the shape of the scene: A holistic representation of the spatial envelope [J]. International Journal of Computer Vision, 2001, 42(3): 145-175.

[14] DALAL N, TRIGGS B. Histograms of oriented gradients for human detection [C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPE’05). New York: IEEE Press, 2005: 886-893.

[15] OJALA T, PIETIKÄINEN M, MÄENPÄÄ T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971-987.

[16] LOWE D G. Distinctive image features from scale-invariant keypoints [J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[17] LIU C. Beyond pixels: Exploring new representations and applications for motion analysis [M]. Cambridge: Massachusetts Institute of Technology, 2009: 153-164.

[18] SAXENA A, SUN M, NG A Y. Make3D: Learning 3D scene structure from a single still image [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(5): 824-840.

[19] SILBERMAN N, HOIEM D, KOHLI P, et al. Indoor segmentation and support inference from rgbd images [C]//The 12th European Conference on Computer Vision. Heidelberg: Springer, 2012: 746-760.

Monocular Image Depth Estimation Based on CNN Features Extraction and Weighted Transfer Learning

WEN Jing, AN Guo-yan, LIANG Yu-dong

(School of Computer and Information Technology, Shanxi University, Taiyuan Shanxi 030006, China)

The depth estimation of monocular image can be obtained from the similar image and its depth information. However, the performance of such an algorithm is limited by image matching ambiguity and uneven depth mapping. This paper proposes a monocular depth estimation algorithm based on convolution neural network (CNN) features extraction and weighted transfer learning. Firstly, CNN features are extracted to collect the neighboring image gallery of the input image. Secondly, pixel-wise dense spatial wrapping functions calculated between the input image and all candidate images are transferred to the candidate depth maps. In addition, the authors have introduced the transferred weight SSW based on SIFT. The final depth image could be obtained by optimizing the integrated weighted transferred candidate depth maps. The experimental results demonstrate that the proposed method can significantly reduce the average error and improve the quality of the depth estimation.

monocular depth estimation;convolution neural network features; weighted depth transfer; depth optimization

TP 391

10.11996/JG.j.2095-302X.2019020248

A

2095-302X(2019)02-0248-08

2018-09-07;

2018-09-12

国家自然科学基金项目(61703252);山西省高等学校科技创新项目(2015108)

温 静(1982-),女,山西晋中人,副教授,博士,硕士生导师。主要研究方向为图像处理、计算机视觉等。E-mail:wjing@sxu.edu.cn