基于深度学习的障碍物检测研究

2019-03-04张舜郝泳涛

张舜 郝泳涛

摘要:避障导航是自动导引小车领域的重要课题,障碍物检测则是其中的重要环节。随着计算机视觉的发展,基于深度学习的图像目标检测算法已日趋成熟,针对自动导引小车避障检测对精准性和实时性要求都较高的情况,本文搭建深度学习模型,使用端到端的物体目标检测网络,对室内环境下自动导引小车可能的工作场景进行训练,在速度较快的情况下得到了很高的精准度。

关键词:避障检测;深度学习;自动导引小车;图像檢测

中图分类号:TP311 文献标识码:A

文章编号:1009-3044(2019)34-0185-03

无人智能车一直是科研领域的热门话题,不论在无人驾驶领域,还是在AGV小车领域,避障一直是一个关键的课题。在无人驾驶的领域研究中,主要有雷达和摄像头两种传感器,雷达主要有超声波雷达和激光雷达。雷达传感器只能判断障碍的存在,而不能判别障碍的种类,而且随着一系列深度学习检测算法的提出,基于计算机视觉的识别和检测的算法的视觉传感器已经逐渐能够代替雷达传感器,基本满足AGV小车避障检测的需求。

传统的机器学习检测方法由以下步骤组成:1)输入待检测图像,并进行相关的预处理;2)使用滑动窗口方法获取候选框;3)对每个候选框取特征信息;4)使用分类器进行判定。这些滑动窗口和特征提取相结合的传统机器学习算法,在早期取得了比较好的效果,但是其过高的计算复杂度、较差的实时性都成为限制其发展的阻碍,并且传统机器学习算法在应对复杂情形下的表现差强人意。但自从2012年开始,AlexNet[1]的出现打破了这一现状,标志基于深度学习的图像检测算法开始发展。基于深度学习的图像物体检测算法目前有两条分支。第一条分支的基本原理是先生成候选区,再对候选区提取特征。自R_CNN[2]模型开始,这条分支在精准度上取得了十足的进展;2015年提出的fast R_CNN[3]贝1J结合了R-CNN和SPP-NETf空间金字塔池化层)[4]的优点;2015年提出的faster R-CNNc5]结合了RPN候选框提取,相比于fast R-CNN进一步提高了效率;2017年提出的FPN(Feature Pyramid Network)[6]则解决了高层中无法检测细小物体的问题;2017年提出的Mask R_CNN[7]则基于faster R-CNN新增了基于掩码层的分割分支。另一条分支则通过直接检测出物体的种类和位置来实现端到端的检测,相应,这种检测手段也极大地提高了检测的速度。2016年,Red-mon等人发表了一篇名为:vou look onlv once[8]的文章,标志着端到端的目标检测分支的诞生,相比于faster R-CNN.YOLO具备更快的检测速度;随后在2017年,又提出了一种速度更快、精度更高,并且可以识别9000种物体的模型YOL09000[9];在2018年,再次提出了基于Darknet-53和多尺度特征的YOLOv3[10],在精准度相当的情况下,YOLOv3的速度是其他模型的至少3-4倍。

综合上文的分析,我们可以看出,在基于AGV小车对障碍物检测实时性要求较高的前提下,YOLOv3在相同精准度下,具备最快的检测速度,故本文拟采用YOLOv3框架来实现对AGV小车在室内场景下的障碍物检测方法的研究。

1 YOLO v3

YOLO是一种端到端的图像检测框架,其核心过程就是将整张图片作为网络的输入,可以在输出层直接得到物体的检测边界框,并标注其检测到得所属类别。YOLO使用了网格而非传统的滑动窗口,首先将一幅图片分成S * S个网格,每个网格需要预测一个中心点落在这个网格当中的物体;每个网格需要预测B个边界框(boundingbox),每个边界框都要回归一个位置信息,包括x,y,w,h,分别代表坐标信息和尺寸信息,同时还要再输出一个置信度值(confidencescore),其计算的方式如(1)式所示.

如果有物体在一个单元格(gridcell)中,则Pre(Object)取1,否则取0;第二项则是预测的边界框和实际的标记之间的IOU值。

除了返回位置和置信度信息,每个网格还需要返回对每一个类别的预测信息,分别代表对每个类别预测的概率。如果有C个类别,则需要输出C个相应的概率值。也就是说,在一个划分为S*S个网格的网络中,每个网格需要预测B个边界框,每个边界框输出(x,v,w,h,confidence)五个维度的信息,并且每个网格要输出 C个类别的预测信息,故整个网络最后的输出为S*S*(5*B+C)的一个张量。

在测试的时候,类别信息与置信度相乘,就可以得到每个边界框的类别预测的置信度得分如(2)式所示。

得到每一个边框的预测置信度得分后,过滤掉低于阈值的边框,对保留的边框进行非极大值抑制(NMS)处理,就得到了最终的检测结果。

YOLO采用了均方差损失函数,但是不同的部分要赋予不同的权重,8维(B=2的情况下)位置信息要赋予比20维(C= 20的情况下)的类别信息更大的权重。每个网格都只预测一个物体,选择IOC最大的边界框,其他边界框则认为不存在物体。损失函数如(3)式所示。

在YOLO的基础上,YOLO v2使用了一个新的类似于VGG的分类模型,并使用3* 3的过滤器,每次池化后都增加一倍的通道数量,通过使用全局平均池化、批量标准化来让训练更加稳定,加速收敛,使模型规范化。而YOL0 9000则利用同时优化检测和分类功能来支持实时地检测9000种物体分类。

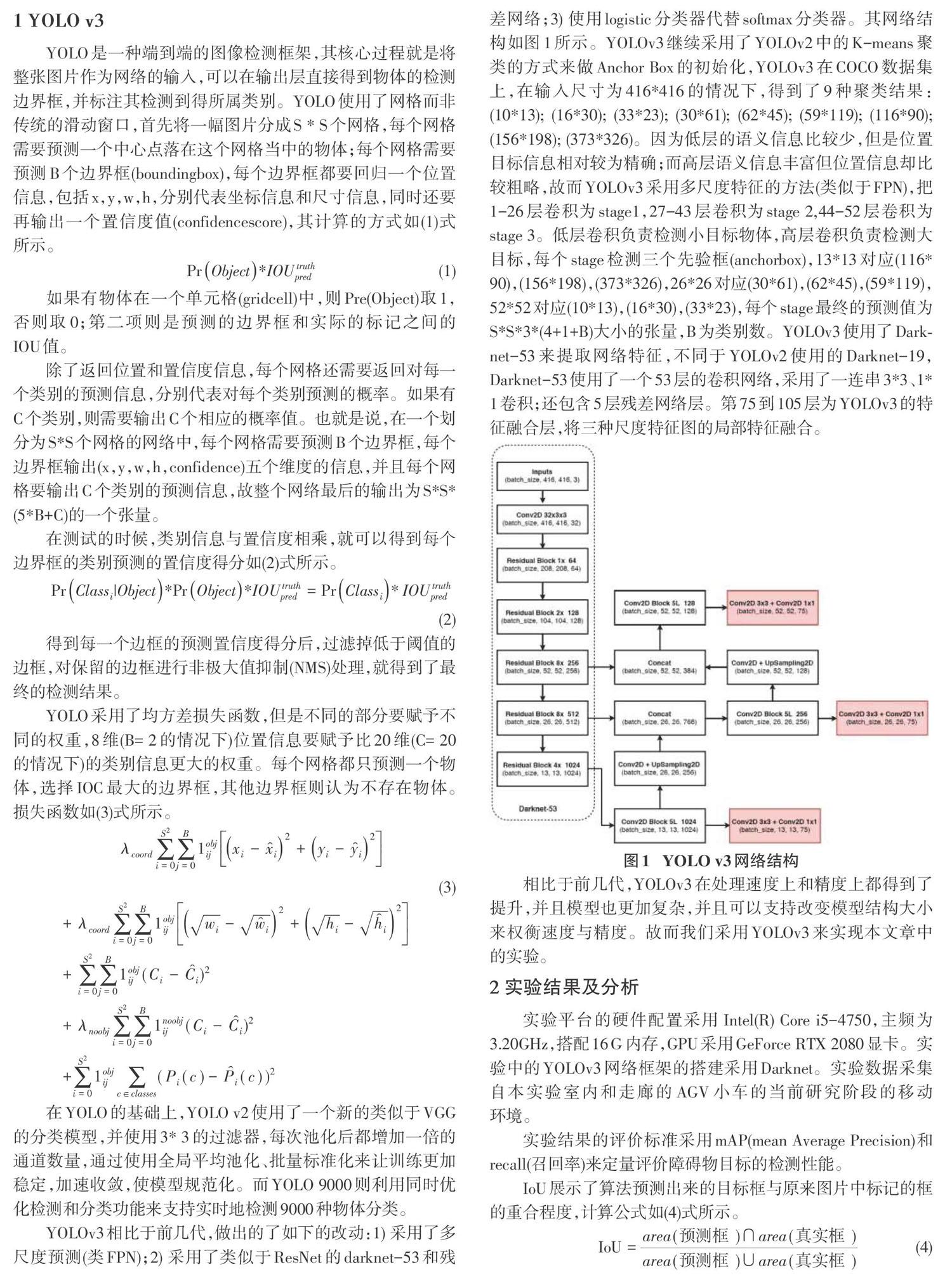

YOLOv3相比于前几代,做出的了如下的改动:1)采用了多尺度预测(类FPN);2)采用了类似于ResNet的darknet-53和残差网络;3)使用logistic分类器代替softmax分类器。其网络结构如图1所示。YOLOv3继续采用了YOLOv2中的K-means聚类的方式来做Anchor Box的初始化,YOLOv3在COCO数据集上,在输入尺寸为416*416的情况下,得到了9种聚类结果:(10*13); (16*30); (33*23); (30*61); (62*45); (59*119); (116*90);(156*198); (373*326)。因为低层的语义信息比较少,但是位置目标信息相对较为精确;而高层语义信息丰富但位置信息却比较粗略,故而YOLOv3采用多尺度特征的方法(类似于FPN),把1-26层卷积为stagel,27-43层卷积为stage 2,44-52层卷积为stage 3。低层卷积负责检测小目标物体,高层卷积负责检测大目标,每个stage检测三个先验框(anchorbox),13*13对应(116*90), (156*198), (373*326),26*26对应(30*61), (62*45),(59*119),52*52对应(10*13),(16*30),(33*23),每个stage最终的预测值为S*S83*(4+1+B)大小的张量,B为类别数。YOLOv3使用了Dark-net-53来提取网络特征,不同于YOLOv2使用的Darknet-19.Darknet-53使用了一个53层的卷积网络,采用了一连串3*3、l{1卷积;还包含5层残差网络层。第75到105层为YOLOv3的特征融合层,将三种尺度特征图的局部特征融合。

相比于前几代,YOLOv3在处理速度上和精度上都得到了提升,并且模型也更加复杂,并且可以支持改变模型结构大小来权衡速度与精度。故而我们采用YOLOv3来实现本文章中的实验。

2 实验结果及分析

实验平台的硬件配置采用InteI(R) Core i5-4750,主频为3.20GHz,搭配16G内存,GPU采用GeForce RTX 2080显卡。实验中的YOLOv3网络框架的搭建采用Darknet。实验数据采集白本实验室内和走廊的AGV小车的当前研究阶段的移动环境。

实验结果的评价标准采用mAP(mean Average Precision)和recall(召回率)来定量评价障碍物目标的检测性能。

IoU展示了算法预测出来的目标框与原来图片中标记的框的重合程度,计算公式如(4)式所示。

使用IoU判断目标检测是否被正确检测,需要设置一个阈值。通常将这个阈值设为0.5或0.75,如果IoU大于阈值,可以认为检测是正确的,反之则是错误的。根据IoU与阈值比较,可计算出每个类的正确检测次数,计算公式如(5)式所示。

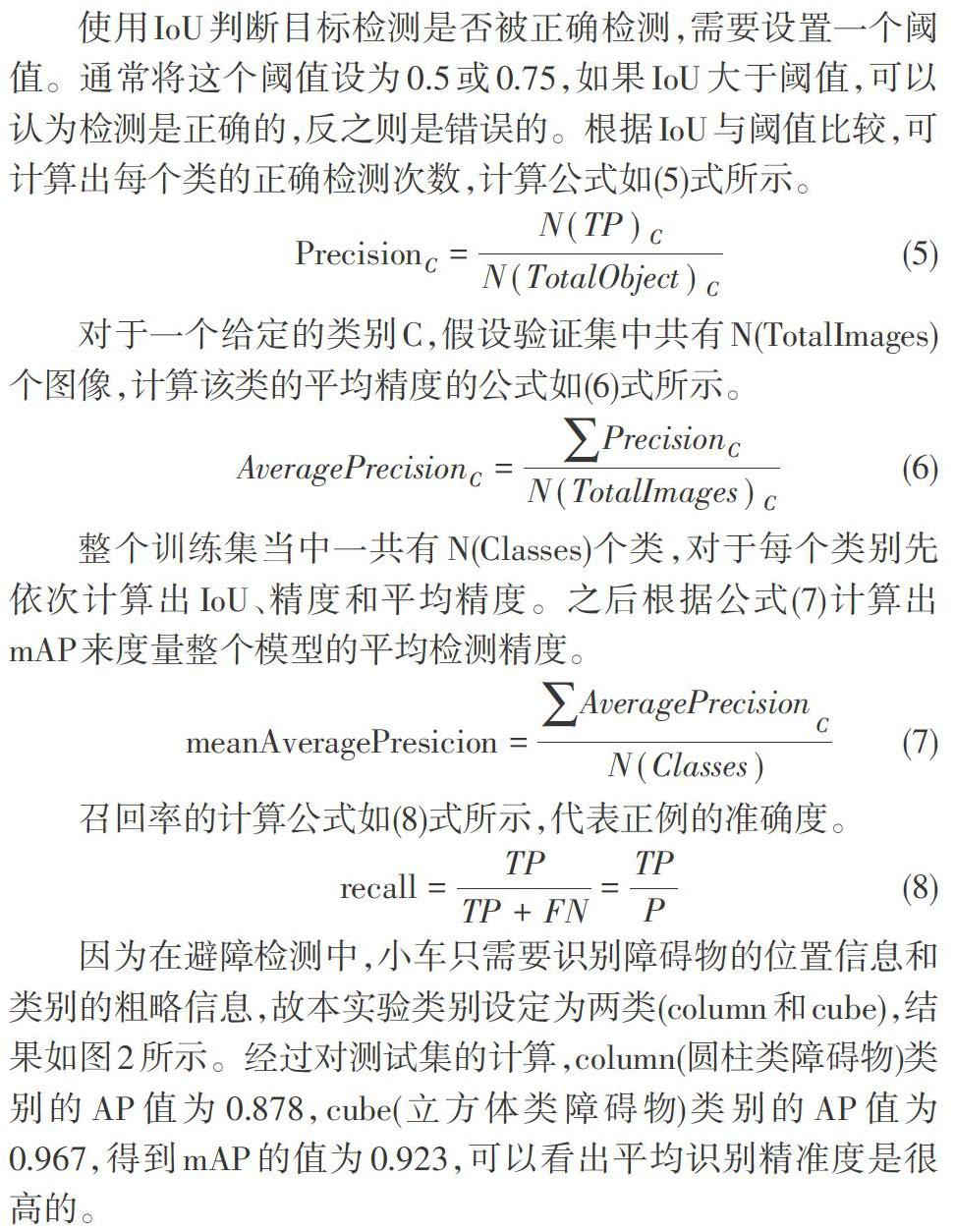

因为在避障检测中,小车只需要识别障碍物的位置信息和类别的粗略信息,故本实验类别设定为两类(column和cube),结果如图2所示。经过对测试集的计算,column(圆柱类障碍物)类别的AP值为0.878,cube(立方体类障碍物)类别的AP值为0.967,得到mAP的值为0.923,可以看出平均识别精准度是很高的。

图3表示Region分别为94(中型物体)和106(大型物体)的Loss、IoU、Recall(IoU阈值为0.75)曲线,可以看出模型的平均损失在随着训练集数据的增加逐渐减小,并且在IoU=0.75、Region=94/106的情况下,Recall值均能达到1,说明YOLO v3对于在室内AGV小车的障碍物检测上能够达到很好的检测效果。

3 结束语

本文我们使用了YOLO v3来实现室内AGV小车的障碍物检测。实验表明YOLO v3模型对于室内ACV小车的障碍物检测是有效的,这会有助于我们在AGV小车避障导航领域的进一步研究。未来我们将尝试更复杂的室内环境和更多类型物体的检测,进一步提高检测精度和检测速度,实现能够充分满足AGV小车工作环境的避障系统。

参考文献:

[1] Krizhevsky A,Sutskever I.Hinton G.ImageNet Classifica-tion with Deep Convolutional Neural Networks[C]/ NIPS. Cur-ran Associates Inc. 2012.

[2] Girshick R,Donahue J,Darrelland T,et al.Rich feature hi-erarchies for object detection and semantic segmentation[C]/2014 lEEE Conference on Computer Vision and Pattern Rec-ognition. IEEE, 2014.

[3] Girshick R.Fast R-CNN[C]/ 2015 lEEE International Confer-ence on Computer Vision (lCCV). lEEE, 2016.

[4] He K,Zhang X,Ren S,et al.Spatial Pyramid Pooling inDeep Convolutional Networks for Visual Recognition[J]. IEEETransactions on Pattern Analysis and Machine Intelligence,2015, 37(9):1.

[5] Ren S,He K,Girshick R.et al.Faster R-CNN: TowardsReal-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis&Machine Intelli-gence, 2015, 39(6):1137-1149.

[6] Li H,Xiong P,An J,et al.Pyramid Attention Network forSemantic Segmentation[J]. 2018.

[7] He K,Gkioxari G,Dollar P,et al.Mask R-CNN[C]// 2017lEEE International Conference on Computer Vision (ICCV).IEEE Computer Society, 2017.

[8] Redmon J , Diwala s . Cirshick R , et al. You Only LookOnce: Unified, Real-Time Object Detection[C]/ 2016 IEEEConference on Computer Vision and Pattem Recognition(CVPR). lEEE Computer Society, 2016.

[9] Redmon J , Farhadi A. [IEEE 2017 IEEE Conference on Com-puter Vision and Pattem Recognition (CVPR) - Honolulu, Hl(2017.7.21-2017.7.26)] 2017 lEEE Conference on ComputerVision and Pattern Recognition (CVPR) - YOL09000: Better,Faster, Stronger[J]. 2017:6517-6525.

[10] Redmon J , Farhadi A. YOLOv3: An Incremental Improve-ment[J]. 2018.

收稿日期:2019-08-20

作者簡介:张舜(1992-),男,辽宁盘锦人,硕士,主要研究方向为计算机图形学,图像处理等;郝泳涛(1973-),男,山东威海人,教授,博士生导师,研究方向为企业信息集成系统,知识处理与挖掘,智能设计,分布式智能系统和虚拟现实技术等。