基于深度学习的癌症计算机辅助分类诊断研究进展

2019-02-14肖焕辉袁程朗冯仕庭罗宴吉黄炳升

肖焕辉 袁程朗 冯仕庭 罗宴吉 黄炳升*

癌症是全球范围内的主要死亡原因和增加预期寿命的主要障碍。据统计,2018年全球预估癌症新发病例数达1 810万,死亡病例数达960万[1]。影像诊断对于癌症的诊断和治疗非常重要。计算机辅助诊断(computer aided diagnosis,CAD)旨在通过计算机对病人的影像进行分析并辅助医生完成诊断,基于医学影像的分类诊断是CAD的重要研究方向。大部分CAD研究基于传统机器学习方法,如支特向量机(su pport vector machine,SVM)、随机森林(randomforest,RF)、逻辑回归(logistic regression,LR)等。传统机器学习有赖于人为的兴趣区标注、特征提取与选择等步骤,难以实现全自动化,分类性能也受限于人为选取特征的表征能力。近年来兴起的深度学习技术,使得计算机能够自动从目标数据中学习获得更深层次、更抽象的特征,并且能够有效排除人为因素的影响,更易于实现全自动化,更具发展潜力,因此日益受到关注。

1 应用于图像分类任务的深度学习模型

深度学习实质上是一种由多层神经网络构成的计算模型。深度学习方法是通过多层非线性神经网络层将数据的低级别特征组合并转换成更高级别、更复杂的抽象特征,以完成复杂任务的学习[2]。用于图像分类任务的深度学习算法主要包括卷积神经网络(convolutional neural network,CNN)、基于自编码器(autoencoder,AE)的深度网络、基于受限玻尔兹曼机(restricted Boltzmann machine,RBM)的深度网络。

CNN在1988年由Fukushima[3]提出,用于图像分类的CNN通常由卷积层、池化层及全连接层组成。通过局部感受野、权值共享以及空间上的下采样,使CNN能够在较低的模型复杂度下充分利用图像的局部与全局信息,并对图像的平移、旋转、缩放等具有一定的鲁棒性。AE在1986年由Rumelhart等[4]提出,在此基础上,相继产生了稀疏自编码(sparse autoencoder,SAE)、去噪自编码 (denoising autoencoder,DAE)和堆栈去噪自编码(stacked denoising autoencoder,SDAE)等深度模型。该类模型通过编码与解码过程,能够得到数据在较低维空间下的非线性特征表示,并据此进行分类。RBM在1986年由Smolensky[5]提出,并由此衍生出深度置信网络(deep belief network,DBN)、深度玻尔兹曼机(deep Boltzmann machine,DBM)等模型。这类模型是一种可以学习输入集合概率分布的生成式随机神经网络,能够通过输入数据的概率分布来学习提取数据的抽象特征,并用以区分数据。

基于AE、RBM的分类模型的建立包括无监督预训练与有监督微调学习两个阶段,可更好地学习复杂数据的结构和分布以实现有效分类,但其训练难度与网络的深度、复杂度成正比,使得更为复杂、更具深度的网络难以实现。其中,微调学习是迁移学习的实现方式之一。在深度学习中,迁移学习通过模型对已有知识(源域数据及其任务)的学习来辅助模型对新知识(目标域数据及其任务)的学习,是解决深度学习模型训练数据不足的问题的重要方法,能够提高深度学习模型的泛化性能。基于CNN的分类模型,仅需进行有监督学习,且由于CNN具有权值共享的特点,以及跳跃连接、瓶颈层等网络结构的存在,能够有效减少网络参数量与网络拟合时间,使CNN模型在模型结构相似的情况下,有着比AE、RBM模型更低的训练难度。此外,相比于AE与RBM模型注重于数据全局信息的利用,CNN依靠感受野的变化,能够有效利用数据的全局与局部信息,更有助于图像的分类。因此,基于CNN的图像分类模型研究,是目前基于深度学习的图像分类研究中的最热点。近年来,亦提出多个混合深度模型(如卷积置信网络、卷积自编码网络等),但在癌症CAD研究中未见报道。

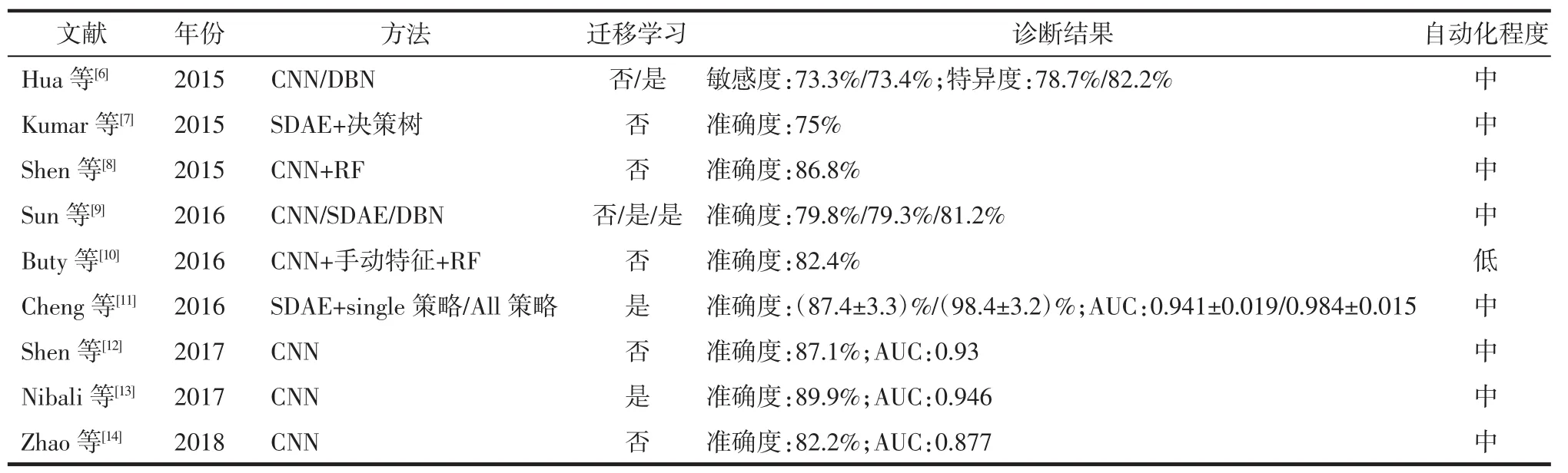

表1 基于深度学习的肺结节良恶性分类方法研究(LIDC公共数据库)

2 基于深度学习的癌症计算机辅助分类诊断方法

基于深度学习的CAD性能会受到所用数据的影响。为方便比较、总结,本文仅针对在公共数据库上进行的研究展开综述。其中,对肺癌、乳腺癌的研究报道较为全面。故对这2种疾病的相关计算机辅助分类诊断研究展开综述。

2.1 基于肺癌CT影像的CAD 对肺癌CT影像的计算机辅助分类诊断研究主要集中在肺结节的良恶性鉴别诊断上。近年来基于深度学习的肺结节良恶性分类研究报道较多,在肺影像数据库联盟(lung image database consortium,LIDC)公共数据库中关于不同方法的准确度、敏感度、特异度、受试者操作特征曲线下面积(AUC)及自动化程度分析的研究见表1。LIDC数据库共包括了1 018例肺结节病人CT影像,每例影像都由4位经验丰富的胸部放射科医生分别进行肺结节标注并给出1~5的恶性程度评分。通常将平均评分<3的定义为良性结节,反之则为恶性结节。其中,至少有1位放射科医生认定的肺结节共7 371个,而至少有1位放射科医生认定且直径≥3 mm的结节共有2 669个,4位放射科医生共同认定且直径≥3 mm的结节共928个。

Hua等[6]分别使用由2个卷积层、2个池化层及2个全连接层组成的简单CNN,以及由2层RBM组成的DBN实现肺结节良恶性分类。与此类似,Sun等[9]分别使用了简单 CNN、由 3个 DAE组成的SDAE和由4层RBM组成的DBN实现肺结节良恶性分类。上述方法与机器学习方法比较,分类准确度略有提高,最高达到81.2%。但所用方法的网络结构简单,缺乏根据目标数据特点的针对性调整,仍有较大改进空间。

随着深度学习与传统机器学习结合应用,使得深度神经网络的深层特征提取能力与传统机器学习分类器的强分类能力能够充分发挥,从而提升了CAD的性能。AlexNet由5个卷积层与3个全连接层构成,在2012年的ImageNet自然图像分类竞赛中获得冠军[15]。网络所用的Relu激活函数、Dropout层、局部归一化响应层以及对图像处理器的应用等,对后续的CNN方法研究有着重要的指导价值。Buty等[10]使用CNN架构AlexNet作为特征提取器,结合手动提取的特征,应用于RF分类器后,准确度达到82.4%。Shen等[8]使用由2个卷积层、2个池化层及一个全连接层构成的三维CNN提取肺结节在多尺度视图下的三维特征,在结合了不同机器学习分类器后,肺结节良恶性分类准确度最高达到86.8%。以上研究表明深度学习与机器学习相结合能够提升CAD性能,但这样的结合不可避免地引入了机器学习方法的特征选择、参数优化等过程。在深度学习的大数据量下,这样的引入将导致整体训练时间的大幅增加。再者,当深度神经网络所提取的特征有着足够的表征能力时,强分类器带来的提升并不显著。所以,目前人们仍主要专注于深度学习方法本身的改进。

深度学习方法的改进包括在网络结构、网络训练策略、网络的输入与输入形式等方面。Zhao等[14]参考1998年首个被提出并应用于手写数字识别的CNN模型LeNet,以及经典CNN模型AlexNet后,提出名为Aglie的CNN网络。Aglie网络在肺结节良恶性分类任务中性能优于LeNet及AlexNet,将准确度从不足80%提升到82.2%,AUC达到0.877。Shen等[12]参考可在多个尺度下进行特征提取并得到大小恒定的特征向量的空间金字塔池化网络,提出了一种具有多级裁剪结构的CNN模型,该模型通过裁剪结合池化的方式来获取图像在不同尺度下的特征,将准确度提高到87.1%,AUC达到0.93。Nibali等[13]将2015年ImageNet自然图像分类竞赛的冠军深度残差网络应用于肺结节良恶性分类中。深度残差网络使用了主要由跳跃连接构成的残差块结构,使网络深度加大的同时,减少了对梯度消失的困扰。通过以ImageNet自然图像集为源域进行迁移学习,该网络准确度达到89.9%,AUC为0.946。Cheng等[11]将反映肺结节兴趣区大小的多个参数与肺结节兴趣区一同作为SDAE分类网络的输入,并比较了仅使用肺结节的中间层切片图像的Single策略与使用肺结节所有切片图像的All策略进行分类的性能差异,结果显示使用Single策略的准确度为(87.4±3.3)%,AUC 为 0.941±0.019,而 All策略的准确度达到(98.4±3.2)%,AUC 达到 0.984±0.015。

可见,通过对深度学习方法的改进,以及与传统机器学习相结合等尝试,肺结节良恶性分类诊断能够达到较高的准确度。但是,这方面仍有很多问题亟待解决,如仍局限于对单个病灶的诊断,无法做到以病人为单位进行诊断;局限于医生对病灶的手动标注,未能实现真正的全自动诊断。总体而言,距离真正的临床应用还比较遥远。

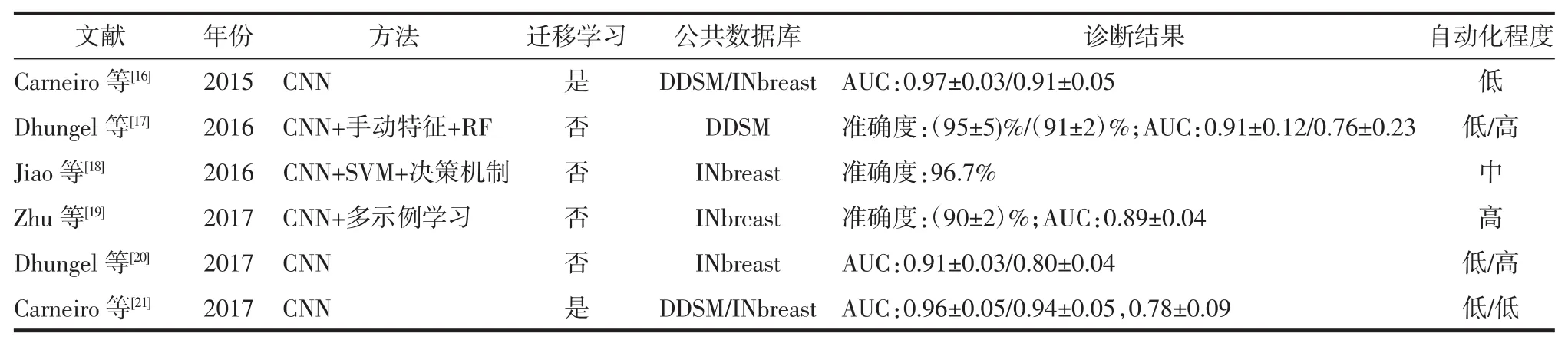

2.2 基于乳腺X线摄影图像的乳腺癌CAD 基于乳腺X线摄影图像的乳腺癌计算机辅助分类诊断研究主要集中于乳腺病灶的良恶性鉴别诊断中。在乳腺钼靶数据集(INbreast)和数字乳腺X线图像数据库 (digital database for screening mammography,DDSM)中可见针对不同深度学习方法的准确度、AUC及自动化程度进行的分析研究(表2)。INbreast公共数据库共有115个病例,90例有双侧乳腺的双视图图像(乳腺横断面和乳腺侧斜位视图图像),其余25例仅有单侧乳腺的双视图图像,共410幅图像。DDSM公共数据库共有2 620个病例,每例都有双侧乳腺的双视图图像,共10 480幅图像。2个数据库的数据都包括乳腺影像报告和数据系统(BI-RADS)分级,等级范围从0~6。 在乳腺癌 CAD研究中,将BI-RADS等级≤3者视为良性病灶,反之则为恶性病灶。

与肺癌CAD研究类似,有研究者将深度学习与传统机器学习相结合以提升CAD的性能。Dhungel等[20]通过人为规范神经网络的特征学习过程,使用简单CNN定向地提取图像特征,该定向特征在RF分类器上的表现优于人为提取的同类特征,亦优于直接使用该CNN进行分类。该研究在DDSM数据库上进行了测试,依赖于医生手动分割病灶的准确度达到(95±5)%,AUC 为 0.91±0.12,而在全自动实现的情况下,准确度为(91±2)%,AUC 为 0.76±0.23。相比之下,Jiao等[18]使用了更具深度的CNN结构,通过CNN的中间层与深层神经元分别提取的中层与深层特征,对应地建立了2个SVM分类器,并设计了特定的决策策略,在INbreast数据库上准确度达到96.7%。上述研究再次表明深度学习与机器学习相结合提升了CAD的性能。但同样地,两者相结合带来的问题仍未能避免,因此人们更重视深度学习方法本身的改进。

Carneiro等[16]提出对乳腺病灶的多个视图进行分析,将乳腺横断面以及侧斜面视图下的完整乳腺、病灶检测图和分割掩膜图共6种图像作为网络的输入,并以ImageNet自然图像集作为源域进行了迁移学习。在DDSM、INbreast数据库上,AUC分别达到 0.97±0.03 与 0.91±0.05。 在已有研究[17]的基础上,Carneiro等[21]进一步将6个二维输入合并为2个三维输入,以提高不同视图间的对比信息在网络中的重要性,并在迁移学习和多网络融合策略上进行了改进。该研究的半自动方法在DDSM与INbreast数据库上AUC分别达到0.96±0.05与0.94±0.05,全自动方法在INbreast数据库上AUC为0.78±0.09。不同于在网络输入上的改进,Dhungel等[20]在Carneiro等[16]研究的基础上,用深度残差网络取代简单CNN结构以获取更深层特征。在没有进行迁移学习的情况下,在INbreast数据库上,半自动方法和全自动方法的AUC分别为0.91±0.03和0.80±0.04。与前面局限于单个病灶的研究不同,Zhu等[19]将AlexNet与多示例学习方法结合,通过AlexNet网络和病人乳腺原始图像得到整个乳腺的病灶良恶性概率分布图,再通过基于稀疏表达的多示例学习从概率图中得到病人的良恶性分类。该法在INbreast数据库上的准确度为(90±2)%,AUC 为 0.89±0.04。

从上述研究可发现,乳腺病灶良恶性CAD研究,已能在半自动条件下实现对单个病灶的准确诊断,并且更进一步实现了对单个病灶乃至单个病人的全自动诊断。但全自动方法未能达到半自动方法的高准确率,距离临床应用仍有差距。

表2 基于深度学习的乳腺病灶良恶性分类方法研究(INbreast、DDSM公共数据库)

3 小结

综上所述,基于深度学习的图像分类技术已经在癌症的CAD研究中具有良好表现并呈现出巨大潜力。在医疗数据日益复杂化的当下,能够自主学习数据特征的深度学习优于非深度学习方法且具有更好的发展前景。此外,由于深度学习的方法改进有着较强的泛化性,方法上的进步能够在多个领域上取得进步,有着较高的研究价值。但目前深度学习方法仍处于起步阶段,对于复杂功能的实现仍然有着较大的难度,并且存在着很大的不可解释性,难以为临床医生信服并接受。对于临床实际应用而言,临床诊断对逻辑分析能力和抽象概念的理解能力要求较高,现阶段深度学习未能满足临床实际应用的需求。此外,医学影像数据相对于自然图像数据的稀缺性,使深度学习方法难以获得很强的泛化能力,亦是其难以应用于临床的重要原因之一。

基于深度学习与医学影像的癌症计算机辅助分类诊断技术将随着研究的深入不断得到提升,有望在将来真正应用于临床实践,提高癌症的临床诊断、治疗水平。