面向延迟敏感型物联网应用的计算迁移策略

2019-01-06郭棉李绮琦

郭棉 李绮琦

摘 要:針对云计算网络延迟较长、能耗过高和边缘服务器计算资源有限的问题,提出了一种提高延迟敏感型物联网(IoT)应用服务质量(QoS)的边缘云合作的漂移加惩罚计算迁移策略(DPCO)。首先,建立物联网边缘云系统模型,对业务模式、计算任务所经历的传输延迟和计算延迟、系统产生的计算能耗和传输能耗等进行数学建模;然后,以系统能耗和任务平均延迟为优化目标,以边缘服务器的队列稳定性为限制条件构建边缘云合作的计算迁移优化模型;接着,以优化目标为惩罚函数,基于李雅普诺夫稳定性理论推导出计算迁移优化模型的漂移加惩罚函数特性。最后,基于推导结果提出了DPCO计算迁移算法,通过每时隙选择使当前漂移加惩罚函数最小化的计算迁移策略来降低长期的单位时间能耗和缩短系统平均延迟。与轻流雾处理(LFP)、基准边缘计算(EC)、基准云计算(CC)策略相比,DPCO的系统能耗最低,约是CC策略的2/3;任务平均延迟也最小,可减少为CC的1/5。实验结果表明,DPCO能够有效降低边缘云计算系统的能量消耗,减少计算任务的端到端延迟,满足延迟敏感型IoT应用的QoS要求。

关键词:云计算;边缘计算;计算迁移;能量消耗;服务质量

中图分类号: TP393.027文献标志码:A

Computation offloading policy for delay-sensitive Internet of things applications

GUO Mian*, LI Qiqi

(School of Electronic and Information Engineering, Guangdong University of Petrochemical Technology, Maoming Guangdong 525000, China)

Abstract: The large network transmission delay and high energy consumption in cloud computing as well as the limited computing resource in edge servers are the bottlenecks for the development of delay-sensitive Internet of Things (IoT) applications. In order to improve the Quality of Service (QoS) of IoT applications while achieving green computing for computing systems, an edge-cloud cooperation Drift-plus-Penalty-based Computation Offloading (DPCO) policy was proposed. Firstly, mathematical modeling was performed on the business model, the transmission delay as well as the computation delay of the computation job, the computation energy as well as the transmission energy generated by the system were modeled by constructing the IoT-Edge-Cloud model. Then, the system consumption and the job average delay were optimized, with the queueing stability of the edge servers as constraint condition, the edge-cloud cooperation computation offloading optimization model was built. After that, with the optimization targets as the penalty function, the drift-plus-penalty function properties of computation offloading optimization model were analyzed based on Liapunov stability theory. Finally, DPCO was proposed based on the above results, the long-term energy consumption per unit time and the average system delay were reduced by selecting the computation offloading policy of minimizing the present drift-plus-penalty function in every time slot. In comparison with Light Fog Processing (LFP), the benchmarked Edge Computing (EC) and Cloud Computing (CC) policies, DPCO consumes the lowest system energy, which is 2/3 of that of the CC policy; DPCO also provides the shortest average job delay, which is 1/5 of that of the CC policy. The experimental results show that DPCO can efficiently reduce the energy consumption of edge-cloud computing system, shorten the end-to-end delay of the computation job, and satisfy the QoS requirements of delay-sensitive IoT applications.

Key words: cloud computing; edge computing; computation offloading; energy consumption; Quality of Service (QoS)

0 引言

随着物联网(Internet of Things,IoT)应用的发展,分布式终端用户(例如,物联网设备)产生了巨量的数据,这些数据要求被快速计算处理以获得最大的效益[1]。许多物联网应用,如虚拟现实[2]、无人驾驶等,都是延迟敏感和计算密集型[3]。尽管集中式云计算数据中心在为计算密集型应用提供高性能计算方面体现了明显的优势,然而它对延迟敏感型应用服务质量(Quality of Service, QoS)保证的低效性[4]以及巨量的能耗已经成为发展延迟敏感型物联网应用的瓶颈[5]。首先,云计算资源主要部署在远程的数据中心,将巨量的分布式数据传输到远程数据中心将使得数据应用经历较长的网络延迟。特别地,随着移动应用的不断增长,不断增长的网络负载将导致不可容忍的网络延迟。其次,从终端用户将巨量的数据传输到远程云计算中心的方式也消耗了巨量的网络带宽资源和传输能量。

近年来,边缘计算已成为推动延迟敏感型物联网应用发展的分布式数据中心范式研究热点[4-5]。在边缘计算范式中,网络边缘设备,例如基站[6]、无线接入点[6]和边缘路由器[7]等,有着类似于云数据中心的计算和存储能力[8],因而用户网络的计算请求可以迁移到附近的边缘服务器来处理,以此达到降低网络传输延迟和减少传输能耗的目的。研究学者对面向边缘计算环境的计算迁移策略进行了积极的研究。文献[9]研究了物联网边缘云的计算迁移问题,提出了一种以延迟最小化为优化目标的的轻流雾处理(Light Fog Processing, LFP)计算迁移方法。文献[10]基于马尔可夫过程构建了面向边缘计算系统的功率限制延迟最小化计算迁移问题,并提出了一种单维搜索算法来决定是否将计算迁移到边缘服务器。文献[11]提出了一种多维搜索和调整计算迁移方法来降低延迟敏感型应用的平均延迟。文献[12]提出了一种资源优化方法来最小化多天线接入点的能耗。文献[13]设计了一种选择性计算迁移方法来最小化物联网设备的能耗和降低信令开销。文献[14]提出了一种基于拉格朗日的计算迁移能耗优化策略来缩短移动终端的总计算时间和降低能耗,為移动边缘计算中计算密集型应用提供保障。文献[15]提出了一种能够联合优化移动终端处理时延与能耗的移动计算迁移方法。文献[16]也提出了一种能耗感知的工作流计算迁移(Energy-aware computation Offloading for Workflows, EOW)方法来降低移动设备的能源消耗。

上述面向边缘计算环境的计算迁移策略的研究主要是研究终端用户是否决定将计算任务迁移、以及迁移多少到边缘服务器进行计算,目的是最小化延迟或降低能耗等。然而,与云计算数据中心相比,边缘计算服务器的计算能力是非常有限的[17],它不能对所有突发的计算请求作出快速响应。因此,一些计算任务将在边缘服务器经历超长的排队延迟,甚至,该排队延迟将超过从用户网络到远程云计算中心的网络延迟,给延迟敏感型应用带来极差的用户体验。

为了对用户提供服务质量保障和绿色化计算系统,本文综合考虑云计算数据中心资源的充裕性和边缘计算服务器的地域性优势,提出一种面向延迟敏感型物联网应用的边缘云合作计算迁移策略,即基于漂移加惩罚计算迁移(Drift-plus-Penalty-based Computation Offloading, DPCO)策略。该策略首先对物联网边缘云(IoT-Edge-Cloud)计算系统进行数学建模,包括业务模式、传输延迟和计算延迟、计算能耗和传输能耗等。然后以系统能耗和任务平均延迟为优化目标、以边缘服务器的队列稳定性为限制条件构建计算迁移优化模型。接着以优化目标为惩罚函数,分析了计算迁移模型的李雅普诺夫漂移加惩罚函数特性。基于分析结果,提出了DPCO计算迁移算法,通过每时隙选择使当前漂移加惩罚函数最小化的计算迁移策略来降低长期的单位时间系统能耗和减少任务平均延迟。通过与基准边缘计算(benchmarked Edge Computing, EC)、基准云计算(benchmarked Cloud Computing, CC)策略的对比实验证实了DPCO策略能够有效降低系统能耗,减少任务平均延迟,满足延迟敏感型应用的服务质量要求和绿色化物联网边缘云计算系统。

1 系统模型

1.1 系统架构

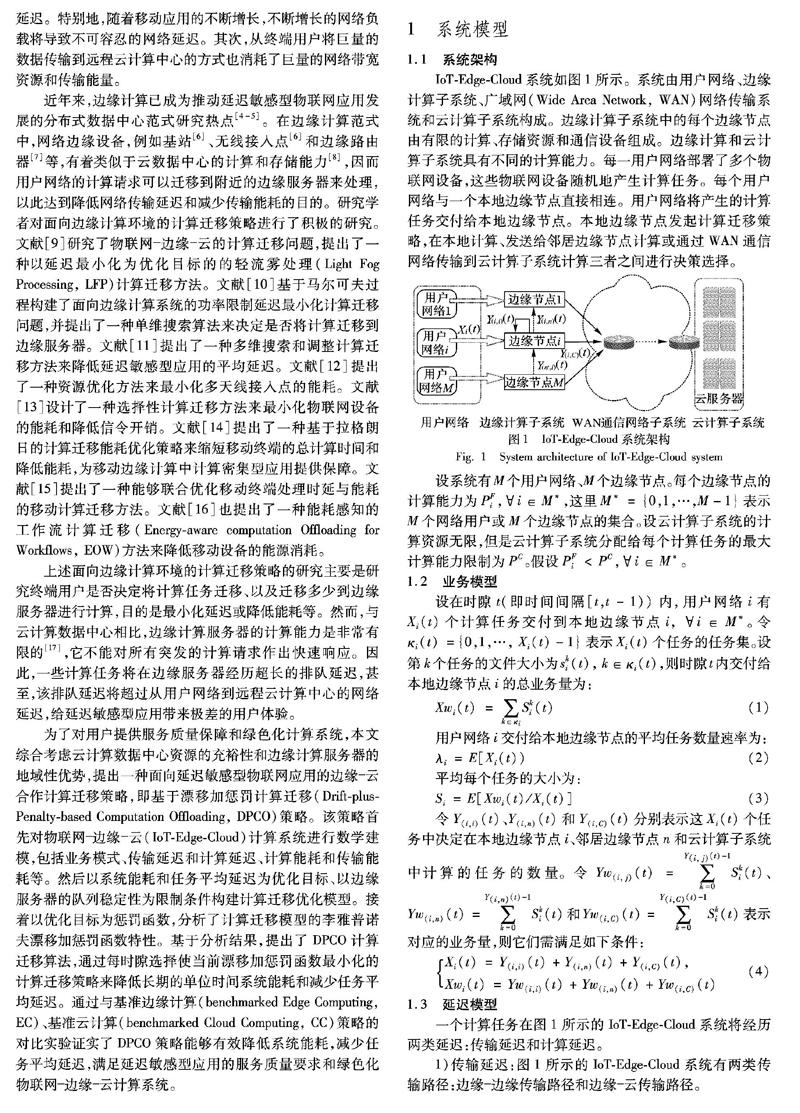

IoT-Edge-Cloud系统如图1所示。系统由用户网络、边缘计算子系统、广域网(Wide Area Network, WAN)网络传输系统和云计算子系统构成。边缘计算子系统中的每个边缘节点由有限的计算、存储资源和通信设备组成。边缘计算和云计算子系统具有不同的计算能力。每一用户网络部署了多个物联网设备,这些物联网设备随机地产生计算任务。每个用户网络与一个本地边缘节点直接相连。用户网络将产生的计算任务交付给本地边缘节点。本地边缘节点发起计算迁移策略,在本地计算、发送给邻居边缘节点计算或通过WAN通信网络传输到云计算子系统计算三者之间进行决策选择。

设系统有M个用户网络、M个边缘节点。每个边缘节点的计算能力为PFi,i∈M*,这里M*={0,1,…,M-1}表示M个网络用户或M个边缘节点的集合。设云计算子系统的计算资源无限,但是云计算子系统分配给每个计算任务的最大计算能力限制为PC。假设PFi 1.2 业务模型 设在时隙t(即时间间隔[t,t-1))内,用户网络i有Xi(t)个计算任务交付到本地边缘节点i, i∈M*。令κi(t)={0,1,…, Xi(t)-1}表示Xi(t)个任务的任务集。设第k个任务的文件大小为ski(t), k∈κi(t),则时隙t内交付给本地边缘节点i的总业务量为: Xwi (t) = ∑k∈κi Ski(t)(1) 用户网络i交付给本地边缘节点的平均任务数量速率为: λi=E[Xi(t))(2) 平均每个任务的大小為: Si=E[Xwi(t)/Xi(t)](3) 令Y(i,i)(t)、Y(i,n)(t)和Y(i,C)(t)分别表示这Xi(t)个任务中决定在本地边缘节点i、邻居边缘节点n和云计算子系统中计算的任务的数量。令Yw(i, j)(t)=∑Y(i, j)(t)-1k=0Ski(t)、Yw(i,n)(t)=∑Y(i,n)(t)-1k=0Ski(t)和Yw(i,C)(t)=∑Y(i,C)(t)-1k=0Ski(t)表示对应的业务量,则它们需满足如下条件: Xi(t)=Y(i,i)(t)+Y(i,n)(t)+Y(i,C)(t), Xwi(t)=Yw(i,i)(t)+Yw(i,n)(t)+Yw(i,C)(t) (4) 1.3 延迟模型 一个计算任务在图1所示的IoT-Edge-Cloud系统将经历两类延迟:传输延迟和计算延迟。 1)传输延迟:图1所示的IoT-Edge-Cloud系统有两类传输路径:边缘边缘传输路径和边缘云传输路径。 a)边缘边缘传输延迟:边缘边缘传输路径长度一般为一跳,令B(i, j)表示边缘i至邻居边缘j传输链路带宽, α(i, j)表示该链路的传输延迟因子,即,网络不稳定或拥塞引起的网络延迟;令Sk表示第k个从边缘i传输到边缘j的任务的大小,则该任务在传输路径i-j的传输延迟可表述为: Dkcomm(i, j)=α(i, j)+Sk/B(i, j)(5) b)边缘云传输延迟:边缘至云之间通过WAN通信网络子系统进行信息传输。WAN通信网络子系统汇聚了所有边缘节点到云计算子系统的业务,因此采用滑动平均网络延迟来估算每个任务从边缘节点传输到云计算子系统所需的时间,即,在t+1时隙内从边缘节点i传输至云端C的任务的网络传输延迟为: Dcomm(i,C)(t+1)=aDcomm(i,C)(t)+(1-a)D^(t)(6) 式中D^(t)表示t时隙内平均每个任务的传输延迟: D^(t)=α(i,C)+Yw(i,C)(t)B(i,C)Yi,C(t)(7) 其中α(i,C) 表示WAN通信网络子系统传输延迟因子。 2)计算延迟:由于边缘节点的计算资源有限性,边缘服务器采用排队系统模型;与边缘服务器相比,云计算子系统的计算资源是无穷的,因此云计算子系统不考虑排队模型,即:每个到达云计算子系统的任务都立即能得到服务。 a)边缘服务器的计算延迟。令Qi(t)表示边缘服务器i在时刻t等待服务的任务的数量,则t+1时刻该服务器等待服务的任务数为: Qi(t+1)=max[Qi(t)+Yi(t)-ri(t),0](8) 式中: Yi(t)和ri(t)分别表示在t时隙内到达服务器的任务数和被服务的任务数。且有: Yi(t)=∑j∈M*Y(j,i)(t)(9) 令Qwi(t)表示边缘服务器i在时刻t积压的业务量,则t+1时刻该服务器积压的业务量为: Qwi(t+1)=max[Qwi(t)+Ywi(t)-PFi/χ,0](10) 式中: PFi/χ表示服务器每时隙能处理的比特量; Ywi(t)是在t时隙内到达服务器的汇聚业务量,其计算公式为: Ywi(t)=∑Yi(t)-1k=0Ski(11) 式中, Ski是第k个到达任务的大小。 采用先进先服务(First-In-First-Service, FIFS)规则调度队列内的任务,则在t时隙内第k (k∈{0,1,…,Yi(t)-1})个到达边缘服务器排队系统的任务的计算延迟为: D(i,k)comp(t)=χPFi(Qwi(t)+∑kj=0Ski)(12) 该计算延迟由排队延迟和服务延迟组成。 b)云计算子系统的计算延迟。令Sk表示时隙t内第k个到达云计算子系统的任务的大小,则该任务在云计算子系统的计算延迟为: D(C,k)comp(t)=χSk/PC(13) 3)端到端延迟:因此,对于在时隙t内第k个到达计算节点i(如边缘计算节点或云计算子系统)的任务,设其大小为Ski,其端到端延迟可表示为: D(i,k)(t)=IkF(t)D(i,k)comp(t)+IkNF(t)[Dkcomm(j,i)+ D(i,k)comp(t)]+IkC(t)[Dkcomm(j,C)+D(C,k)comp(t)](14) 式中:D(i,k)comp(t)和D(C,k)comp(t)分别是边缘节点i和云计算子系统C的计算延迟; Dkcomm(j,i)和Dkcomm(j,C)分别是传输路径边缘j-边缘i、边缘j-云C的传输延迟;IkF(t)、IkNF(t)和IkC(t)是二值决策指示变量,当IkF(t)=1时,表示该任务在本地边缘节点计算;当IkNF(t)=1时,表示该任务在邻居边缘节点计算;当IkC(t)=1时,表示在云计算子系统计算。这3个计算决策变量之间的取值应满足如下关系: IkF(t)+IkNF(t)+IkC(t)=1(15) 4)系统平均延迟:则在时隙t内计算的所有任务的平均延迟为: Dsys(t)=∑i∈M*∪CD(i,k)(t)/∑i∈M*∪CYi(t)(16) 数学期望为: Dsys=E[Dsys(t)]=limt→∞1t∑t-1τ=0Dsys(τ)(17) 1.4 能耗模型 由于边缘计算节点与云计算子系统架构上的区别性,对边缘计算节点和云计算子系统采用不同的能耗模型。 1)边缘节点的计算能耗。根据文献[18],边缘节點的计算能耗是计算业务量的凸函数,因此采用如下的能耗模型: PwFi(t)=af(Ywi(t))2+bf(Ywi(t))+cf(18) 式中: PwFi(t)是边缘节点i在时隙t的计算能耗; af>0,bf,cf≥0是能耗因子; Ywi(t)是该节点在时隙t的计算业务量。 2)云计算子系统的计算能耗。根据文献[18-19],在时隙t到达云计算子系统的第k个来自用户网络i、任务大小为Ski的任务的计算能耗为: PwC(i,k)(t)=χSkiPC(Ac fθC(t)+Bc)(19) 式中: χSki/PC是任务执行时间; Ai>0、θ∈[2.5,3]和Bc≥0是能耗因子; fc(t)是分配给该任务的中央处理器(Central Processing Unit, CPU频率。 则处理时隙t内到达云计算子系统的所有任务所需的能耗为: PwC(t)=∑i∈M*∑Y(i,C)(t)-1k=0PwC(i,k)(t)(20) 3)传输能耗:设传输路径(i-j)在时隙t传输的业务量为λw(i, j)(t),则该传输路径在该时隙的传输能耗为: Pwcomm(i, j)(t)=a(i, j)λw(i, j)(t)(21) 式中, a(i, j)>0是传输路径能耗因子。 4)系统能耗:因此,IoT-Edge-Cloud系统在时隙t的能耗为: Pw(t)=∑i∈M*PwFi(t) + PwC(t) + ∑i∈M*∑j∈M*∪C,j≠iPwcomm(i, j) (t)(22) 数学期望为: Pw=E[Pw(t))]=limt→∞1t∑t-1τ=0Pw(τ)(23) 1.5 能耗延迟均衡函数 令G(t)表示系统在时隙t的能耗延迟均衡函数,定义为: G(t)=ω1Pw(t)+ω2Dsys(t)(24) 式中:ω1≥0和ω2≥0分别是能耗和系统平均延迟的均衡控制参数。当ω1=0时,表示不考虑系统能耗;当ω2=0时,表示不考虑任务平均延迟。 则能耗延迟均衡的数学期望为: G=E[G(t)]=ω1E[Pw(t)]+ω2E[Dsys(t)]= ω1Pw+ω2Dsys(25) 1.6 问题建模 令κXi(t)={0,1,…,Xi(t)-1}表示时隙t内到达边缘节点i、且来自用户网络i的任务集合;令γki(t)=(I(i,k)F(t),I(i,k)NF(t),I(i,k)C(t))表示其中第k个任务的计算迁移决策向量;则γi(t)=(γ0i(t), γ1i(t), …, γki(t), …, γXi(t)-1i(t))表示时隙t内边缘节点i对来自用户网络i的所有任务的计算迁移决策向量, γ(t)=(γ0(t), γ1(t),…, γi(t), …, γM-1(t))表示时隙t内IoT-Edge-Cloud系统所有边缘节点的计算迁移决策向量。 则,对于来自用户网络i的任务,有式(26)~(27): Y(i,i)(t)=∑k∈ΚXiI(i,k)F(t) Y(i,n)(t)=∑k∈ΚXiI(i,k)NF(t) Y(i,C)(t)=∑k∈ΚXiI(i,k)C(t) (26) Yw(i,i)(t)=∑k∈ΚXiI(i,k)F(t)Ski Yw(i,n)(t)=∑k∈ΚXiI(i,k)NF(t)Ski Yw(i,C)(t)=∑k∈ΚXiI(i,k)C(t)Ski (27) 因此,能耗延迟优化的IoT-Edge-Cloud系统计算迁移问题可以建模为能耗延迟均衡函数最小化问题,即: 最小化: G=E[G(γ(t))](28) 限制条件有式(4)、式(26)~(27)和下面的式(29)~(30): Qi<∞; i∈M*(29) Qwi<∞; i∈M*(30) 式(28)由式(25)而来;式(4)是业务限制条件;式(26)~(27)的依据是的定义;不等式(29)~(30)是边缘节点排队系统稳定性条件。Qi、Qwi分别定义为: Qi=E[Qi(t)]=limt→∞1t∑t-1τ=0Qi(t)(31) Qwi=E[Qwi(t)]=limt→∞1t∑t-1τ=0Qwi(τ)(32) 在优化问题(28)~(30)中,决策变量为γ(t)。根据式(26)~(27),当γ(t)确定时, Y(i, i)(t)、Y(i, n)(t)、Y(i,C)(t)以及Yw(i, i)(t)、Yw(i, n)(t)、Yw(i,C)(t)也确定,从而获得G。因此,能耗延迟优化的IoT-Edge-Cloud系统计算迁移问题等效于找出一系列优化的γ*(t)( t=0, 1, …, ∞)来获得最小化的G。 2 DPCO策略 本文基于李雅普诺夫稳定性理论[20-21],提出一种基于漂移加惩罚的计算迁移(DPCO)策略。该策略通过李雅普诺夫漂移加惩罚函数得出的结论对任务进行计算迁移决策,得到一系列的γ(t),进而得到优化问题(28)~(30)的解。 2.1 李雅普诺夫漂移加惩罚函数 令Qw(t)=(Qw0(t), Qw1(t), …, Qwi(t),…, QwM-1(t))表示M个边缘服务器排队系统在时刻t的积压业务量向量。令L(t)表示积压业务量的李雅普诺夫函数,定义为: L(t)=12∑i∈M*Qwi(t)2(33) 則,Qw的一步李雅普诺夫漂移定义为: ΔL(t)=E[L(t+1)-L(t)|Qw(t)](34) 引理1 每一时隙,对任意的Qw(t),在任意计算迁移策略下,边缘服务器排队系统积压业务量的李雅普诺夫漂移满足: ΔL(t)≤B-∑i∈M*Qwi(t)PFi/χ+ ∑i∈M*Qwi(t)E[Ywi(t)|Qw(t)](35) 式中B是一个常数。 证明 根据式(10),有: Qwi(t+1)2≤(Qwi(t)+Ywi(t)-PFi/χ)2= Qwi(t)2+(Ywi(t)-PFi/χ)2+ 2Qwi(t)(Ywi(t)-PFi/χ)(36) 将(36)、(33)代入(34)并化简,得: ΔL(t)≤12∑i∈M*EYwi(t)-PFiχ2|Qw(t)+ ∑i∈M*Qwi(t)EYwi(t)-PFiχ|Qw(t)(37) 由于: 0≤Ywi(t)≤∑i∈M*Xwi(t) 以及: E[∑i∈M*Xwi(t)]=∑i∈M*λiSi=λS 因此,有: Ywi(t)-PFiχ2≤maxPFiχ2,λS-PFiχ2 令: B=∑i∈M*max12PFiχ2,12λS-PFiχ2 并代入(37),得: ΔL(t)≤B+∑i∈M*Qwi(t)EYwi(t)-PFiχ|Qw(t) 此外, PFi/χ独立于Qw(t),因此: EPFiχ|Qw(t)=PFiχ 由此可得: ΔL(t)≤B-∑i∈M*Qwi(t)PFiχ+ ∑i∈M*Qwi(t)E[Ywi(t)|Qw(t)] 证毕 由于本文的目的是找出一系列优化的计算迁移策略γ*(t)(t=0,1,…,∞)来最小化G,因此把G(γ(t))作为惩罚函数加入积压业务量的李雅普诺夫漂移函数,即,定义李雅普诺夫漂移加惩罚函数为ΔL(t)+VE[G(γ(t))|Qw(t)]。由此得到引理2。 引理2 每一时隙,对任意的Qw(t),在任意计算迁移策略下,边缘服务器排队系统积压业务量的李雅普诺夫漂移加惩罚函数满足: ΔL(t)+VE[G(γ(t))|Qw(t)]≤ B+VE[G(γ(t))|Qw(t)]-∑i∈M*Qwi(t)PFi/χ+ ∑i∈M*Qwi(t)E[Ywi(t)|Qw(t)]= B+Vω1E[Pw(γ(t))|Qw(t)]+ Vω2E[Dsys(γ(t))|Qw(t)]-∑i∈M*Qwi(t)PFi/χ+ ∑i∈M*Qwi(t)E[Ywi(t)|Qw(t)](38) 式中:B是与引理1相同的常数,且该常数独立于V;V是一个非负控制参数。通过控制V、ω1和ω2的取值,可获得能耗和平均延迟的均衡优化值。 引理2可由引理1两边同时加上惩罚函数直接获得。 2.2 DPCO算法 根据引理1和引理2的结论,本文提出分布式DPCO策略来找出优化的γ*(t)(t=0,1,…,∞),来最小化不等式(38)的右边,从而最小化ΔL(t)+VE[G(γ(t))|Qw(t)],以达到最小化G的目的。具体的DPCO算法如算法1所示。 算法1 DPCO算法。 输入 Xi(t)、Qw(t)。 输出 γ*i(t)。程序前 Begin: 1) 初始化: Yw(i, i)(t)=0、Yw(i, n)(t)=0,n∈{i的邻居列 表}; 2) 决策过程:选取γ*i(t),使其满足 γ*i(t)=arg minri(t)(VG(γi(t))+ ∑j={i, n}Qwj(t)Ywj(γi(t)))(39) 3) 处理决策:观察γ*i(t),对k∈κXi,执行 a) 当I(i, k)F(t)=1:将该任务放入本地边缘服务器排队系 统; b) 当I(i, k)NF(t)=1:将该任务迁移到邻居边缘节点计算; c) 否则:将该任务迁移到云计算子系统计算。 End程序后 基于DPCO的IoT-Edge-Cloud系统任务分配和调度过程如算法2所示。 算法2 基于DPCO的任务分配和调度过程。程序前 初始化: Q(0)=0 、Qw(0)=0; Begin: 对每一时隙t≥0,do 1) 任务分配过程: a) 边缘节点i收到来自用户网络i的Xi(t)个计算任务, 执行下述步骤: i) 观察Qw(t),执行DPCO算法,即算法1; ii) 将步骤i)的结果代入式(26)、(27),计算出Y(i, i)(t) 和Yw(i, i)(t),采用式(40)更新Qi(t)和Qwi(t)。 Qi(t+1)=Qi(t)+Y(i, i)(t) [20]NEELY M J, WALRAND J. Stochastic Network Optimization with Application to Communication and Queueing Systems [M]. Williston: Morgan and Claypool, 2010: 45-48. [21]MEYN S P, TWEEDIE R L. Stability of Markovian processes III: Foster-Lyapunov criteria for continuous-time processes [J]. Advances in Applied Probability, 1993, 25(3): 518-548. This work is partially supported by the Natural Science Foundation of Guangdong Province (2015A030310287), the College Students Innovation and Entrepreneurship Training Program of Guangdong University of Petrochemical Technology (733149). GUO Mian, born in 1979, Ph. D., lecturer. Her research interests include edge computing, cloud computing, network quality of service, deep reinforcement learning. LI Qiqi, born in 1998. Her research interests include edge computing, deep learning. 收稿日期:2019-05-27;修回日期:2019-06-27;錄用日期:2019-07-02。 基金项目:广东省自然科学基金资助项目(2015A030310287);广东石油化工学院大学生创新创业培育计划项目(733149)。 作者简介:郭棉(1979—),女,广东茂名人,讲师,博士,CCF会员,主要研究方向:边缘计算、云计算、网络服务质量、深度强化学习;李绮琦(1998—),女,广东广州人,主要研究方向:边缘计算、深度学习。 文章编号:1001-9081(2019)12-3590-07 DOI:10.11772/j.issn.1001-9081.2019050891