基于小波包分解的无参考立体图像质量评价

2018-12-26沈丽丽彭科

沈丽丽 彭科

摘 要:立体图像质量评价在立体图像处理领域中应用广泛.基于小波包分解的精细分辨率,提出了一种全新的无参考立体图像质量评价算法.选取合值图和差值图作为融合图来评估立体图像,首先,对立体图像对进行小波包分解,基于双眼竞争和双眼抑制原理,将分解后的左右视图进行融合得到合值图和差值图.然后,分别在融合图上提取自然场景统计(NSS)特征和信息熵;另外,考虑到左右视图之间的内在相关联系,提取结构相似度特征.最后,运用支持向量回归(SVR)来建立感知特征和主观分数模型并预测得到客观评价分数.采用该算法在LIVE 3D立体图像数据库上进行测试,实验结果表明,该算法与人眼主观评价结果一致性较高,优于当前主流的立体图像质量评价算法,符合人眼视觉感知特性.

关键词:立体图像质量评价;小波包;无参考;结构相似度

中图分类号:TP391 文献标志码:A

Abstract:Stereoscopic image quality evaluation is widely employed in the field of stereo image processing. Based on accurate resolution of waveletpacket, a novel algorithm for noreference stereoscopic image quality assessment is proposed. It evaluates stereo image quality via fusion map, which consists of cyclopean map and difference map. First, the stereo image pair is decomposed by waveletpacket, and afterwards the decomposed left and right views are fused to obtain cyclopean map and difference map based on the principle of binocular rivalry and binocular suppression. Then, Natural Scene Statistics (NSS) features and information entropy are extracted on the fusion map; besides, the structural similarity feature is extracted by taking into account the internal relations between the left and right views. Finally, the Support Vector Regression (SVR) is used to establish model between the perception features and subjective scores, which can predict the objective evaluation score. The experimental results on LIVE 3D image databases show that the proposed algorithm has high consistency with the subjective evaluation results, and it outperforms stateoftheart stereoscopic image quality assessment algorithms and is in accordance with the human visual perception characteristics.

Key words: stereoscopic image quality assessment(SIQA); waveletpacket; noreference(NR); structural similarity

近年來,立体电视、立体游戏等立体技术已逐渐深入到人们的日常生活当中,为人们带来了极佳的视觉体验和心理震撼.相比于二维平面图像,立体图像可以使人们身临其境地感受到立体感及临场感,逐渐地成为信息技术研究的主流方向[1].然而,在3D立体图像成像过程中,图像信息采集、压缩、传输、解码、渲染等会存在各种各样的失真,失真程度非常严重的立体图像会使人观看不舒服,甚至出现疲劳、头晕等现象.因此,对立体图像进行质量评估非常重要.

目前,平面2D图像客观质量评价方法已经相对成熟[2-4],相对于平面图像而言,立体图像质量评价不但要考虑左右视点质量,还要考虑到舒适度、视差信息等,所以对于立体图像客观质量评价方法的研究仍然是一个较复杂的难题.早期的立体图像质量评价方法都是借助2D图像质量评价方法进行,分别计算左右视图获得的质量,然后平均得到一个综合质量,如将2D质量评价中取得比较成功的算法MSSSIM[2]、BRISQUE[3]运用到立体图像中能取得一定的效果,但评价过程中没有考虑到任何立体感知因素.因此,在评价立体图像时需要添加立体深度信息, Chen等根据双眼竞争原理提出Cyclopean模型[5],并在文献[6]中基于Cyclopean和视差图、不确定图分别提取2D特征和3D特征,王珊珊[7]等基于双目能量响应提取出不同频率、不同方向和不同视差下的局部特征,Lin[8]等运用差分高斯模型并用增益控制模型来结合左右视点,Shao[9]等充分考虑到双眼视觉特性,提出全参考的感知模型,Gu[10]等根据非线性叠加和视差补偿模型提出无参考评价模型,Zhou[11]等模拟视觉感知并提出双眼特征自相似度模型,以上算法都具有很好的评价性能,但与人眼主观感知仍有一定差距,尤其在评价非对称失真图像时存在着许多不足.

因此,本文利用小波包分解[12]提取对人眼敏感的图像信息,提出一种无参考立体图像质量评价方法,采用合值图和差值图来描述立体图像在视觉感知中融合过程.通过主观数据库测试显示,所提出的算法具有高效性且与人眼主观感知一致性较高.

1 小波包分解

大量主观实验研究结果表明,单眼细胞在感知图像信息的过程中,能够使用分析模型来表示[13],例如离散小波分解、Gabor变换、DCT变换、Contourlet变换或其他滤波器变换.相比以上模型,小波包分解是一种更为精细的分解方法,它在全频带进行多层次的频带划分,对多分辨率分析没有细分的高频部分进一步分解[14],在精细尺度上更能反映出图像质量受失真影响的程度.

人类视觉系统(Human Visual System,HVS)对不同频率的敏感程度是有差异的,经过小波包分解之后的立体图像能提供频域中的局部化信息,所携带的图像质量信息较多,可以精确地量化自然图像的统计特征,本文首次将小波包分解应用到立体图像质量评价上,可以较好地模拟人类视觉系统的多分辨率特性.

采用Daubechies小波系对立体图像进行两级分解.以左视图为例,用VL表示,经过小波包两层分解之后为WL,其中第一级分解后有4个子带,第二级分解是在第一级分解的4个频域子带上再次进行分解得到16个频域子带,同样,右视图VR在小波包分解后得到的小波包子带为WR.因此,立体图像对经过2级小波包分解之后得到左右视点各20个子带图像.

2 立体图像质量评价模型

在评估立体图像质量时,需要考虑左右视图对立体感即深度信息的影响.本文采用小波包分解分别对立体图像左右视图进行分解,分解之后的图像能够表示空间频域信息,具有与人眼一致的高分辨率特性.然后基于双眼竞争和双眼抑制原理,对分解后的左右视图进行融合,得到合值图和差值图,然后在融合图上提取NSS特征和信息熵.另外,为了更有效的表示左右视点内在联系,本文分别计算左右子带视图结构信息,然后得到结构信息相似度.最后,运用SVR在公开LIVE Phase I和LIVE Phase II两大立体数据库上进行训练和测试,最终得到客观评价分值.图1为本文所提出的基于小波包分解的无参考立体图像质量评价模型算法示意图.

2.1 融合图

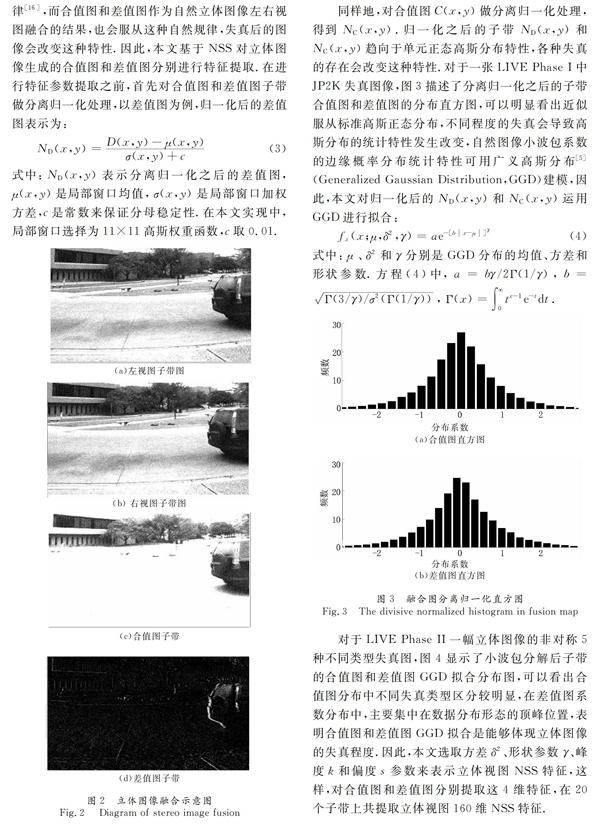

立体视觉感知是一个复杂的视觉系统,双眼竞争和双眼抑制在双眼感知立体图像时占据非常重要的作用.因此,本文也基于双眼感知属性,将小波包分解后的频域子带图像进行融合,融合过程分为合值图和差值图.

2.1.1 合值图

对于LIVE Phase II一幅立体图像的非对称5种不同类型失真图,图4显示了小波包分解后子带的合值图和差值图GGD拟合分布图,可以看出合值图分布中不同失真类型区分较明显,在差值图系数分布中,主要集中在数据分布形态的顶峰位置,表明合值图和差值图GGD拟合是能够体现立体图像的失真程度.因此,本文选取方差δ2、形状参数γ、峰度k和偏度s参数来表示立体视图NSS特征,这样,对合值图和差值图分别提取这4维特征,在20个子带上共提取立体视图160维NSS特征.

2.2.3 左右视图结构相似度特征提取

现有的大多数算法主要考虑单独在左右视点或融合图基础上进行特征提取,而忽略了立体图像左右视图之间的内在联系.对于立体图像左右视图,双眼视觉所观看到的是两幅具有细微不同的场景图,由对称性失真引起的立体图像场景图不同主要体现在左右视点的视差,不同的视差会影响到人观看立体图像的感知,而对于非对称性失真,既表现在视差的不同,也因左右视图失真位置、失真程度大小等的不同而显现差别,这都会影响人眼的立体感知质量.因此,本文用结构相似度来衡量左右视图的变化程度,即分别表示小波包分解之后的左右子带视图的结构信息,然后提取两者局部相似度因子作为特征.

本文选择用相位一致性(Phase Congruency,PC)和高斯拉普拉斯(Laplace of Gaussian,LoG)来表示20对左右子带视图局部结构特征.LoG主要是一种利用频域空间进行图像边缘检测的方法,能够比较准确获取图像各个方向因亮度改变而带来的变化.

2.3 立体图像质量预测

针对立体图像提取的特征矢量,通过回归函数与相应的主观差值分数(Difference Mean Opinion Scores,DMOS)建立映射关系,相比其它回归函数,SVR [19]更注重于全局優化,在处理低样本、高维特征数据方面是一种特别有效的机器学习方法,因此广泛运用于分类回归模型.SVR预测立体图像质量分数主要分为训练部分和测试部分,训练部分是用训练立体图像提取的特征和对应的DMOS值作为SVR的输入,然后输出得到最优化回归模型,测试部分在测试集上运用回归模型,获得测试集图像的客观预测分数.

3 实验结果与分析

3.1 数据库和评价指标

为了有效地验证本文所提出的立体质量评价表现性能,在LIVE 3D立体图像数据库上进行训练和性能测试.LIVE 3D数据库包括LIVE Phase I数据库[20]和LIVE Phase II数据库[6].其中LIVE Phase I是对称失真立体图像数据库,包括20张原始图像以及由这20张参考图像经过不同失真类型及程度获得失真图像共365幅,包括45幅高斯模糊(Gblur)以及JPEG、JP2K、高斯白噪声(WN)、快速衰落(FF)失真类型图片各80张.LIVE Phase II数据库包含8幅不同的原始图像,同样的由5类失真类型组成,每类有9种程度失真共72幅失真图像,由此生成360幅失真图像,按照立体图像失真的对称性,可以分为120幅对称立体图像对和240幅非对称立体图像对.每一幅失真图像都有唯一的DMOS值与之对应,LIVE Phase I和LIVE Phase II是互不相同的,主要针对立体图像左右视图对称性失真和非对称性失真.

在实验结果测试中,三个比较常用的性能指标:斯皮尔曼等级相关系数(Spearmans rank ordered correlation coefficient,SROCC)、线性相关系数(Linear correlation coefficient,LCC)和均方根误差(Root mean squared error,RMSE)被用来度量实验结果的表现性能,评价与主观感受的一致性程度.其中,RMSE值越小表示评价指标性能越好,而SROCC和LCC的值越大表明与人主观判断一致性越好.

在具体的实验过程中,首先将数据库随机划分为无交叉重叠的训练集和测试集两部分子集,其中训练集图像占数据库总数80%,测试集图像比例占20%,然后运用SVR进行训练和测试,最终得到客观评价值的SROCC、LCC和RMSE值.上述训练和测试程序无重叠随机进行1 000次迭代,取中值结果为最终质量分数.

3.2 算法性能分析

在探究本文所提出的立体图像评价方法的有效性时,比较了一些常见的全参考和无参考算法评价方法,表1给出了在LIVE 3D数据库上不同评价算法的性能比较,性能比较好的数值用加粗表示.从整体上看,由于LIVE Phase II图像库有对称失真和非对称失真,较为复杂,所以整体效果上没有LIVE Phase I性能好,但本文充分考虑到立体深度信息,不仅计算左右视点合值图和差值图,也分析了左右视点相应局部结构相似度信息,这对于模拟非对称失真立体图像非常有效.因此,算法在LIVE Phase II上性能表现优越.

在两大数据库上可以明显看出本文所提出的算法性能明显优于其他评价算法,其中MSSSIM[2]和BRISQUE[3]属于平面图像质量评价方法,可以看出这两个平面算法在LIVE Phase I和LIVE Phase II上有明显的差别,这主要是因为LIVE Phase II中左右图像失真不对称导致平均加权得到的值大大降低,其余3D算法均考虑到了立体图像属性,可以看出Shao等[21]利用联合稀疏表示在LIVE Phase I效果较好,与以上优秀的算法相比,本文算法在LIVE Phase I和LIVE Phase II上LCC值分别达到0.956和0.955,显得更有竞争力.

为了验证本文算法在不同失真类型下的表现性能,在单一失真类型下分别进行实验,为了节省空间,表2仅给出不同算法在LIVE Phase I和LIVE Phase II上不同失真类型的SROCC值比较结果.通过与其他算法进行比较,本文提出的算法在LIVE Phase I和LIVE Phase II上测试的结果取得了比较好的效果,除了对部分失真略有不足,整体上明显优于其他算法.

同时,为了更直观地描述本文算法与人主观评价的一致性比较,图6画出了在LIVE Phase I和LIVE Phase II上的散点图.图中所有的离散点横坐标表示算法客观评价分数,纵坐标表示DMOS,图中曲线是进行非线性拟合而绘制的曲线.可以观察到本算法客观质量评价与人眼感知高度吻合.

3.3 融合图性能分析

对于感知立体图像质量,模拟双眼融合行为是非常重要的因素,通过以上分析,本文选取在小波包分解域上得到的合值图和差值图作为融合图,取得了较好的效果.传统经典的融合模型,都是在原图像上通过以频谱能量或PCA特征为权值来进行左右视点融合,在实验中发现其复杂度远高于合值图但并未提升实验效果.另外,考虑到左右视图存在一定视差,特别是对于非对称失真的立体图像,许多视差匹配算法描述的效果并不好,本文以差值图来表现深度信息,实现复杂度既简单,又能与人眼视觉较一致.

考虑到仅用生成的融合图来描述立体图像特征并不全面,忽略了左右视点之间的关系,因此,本文还提出左右视图结构相似度特征.表3列出了是否有左右视图结构相似度特征两者性能的实验结果.从表3中可以观察得出,构建融合图模型来模拟人眼感知是非常有效的,在引入左右视点结构相似度之后,能使算法的有效性再次提升.

3.4 鲁棒性分析

鲁棒性分析是进一步衡量算法性能的一个标准,分别在LIVE Phase I和LIVE Phase II数据库上将训练集图像所占比例由80%降为60%、40%、20%,然后重新进行训练回归模型来实验,最终得到的SROCC、LCC和RMSE值如表4所示.从表中可以看出随着训练图像比例的增大,LCC和SROCC值也显著增大,RMSE值也随之减小,评价性能越来越好.即使训练集图像比例为40%,LIVE Phase I图像库LCC值也能达到0.938,LIVE Phase II圖像库LCC值也能达到0.934.因此,本文算法对训练集大小并不敏感,具有较好的鲁棒性.

3.5 复杂度分析

为了评估所提出算法的计算复杂度,本文与已公开代码的算法进行了比较,表5记录了每个算法在LIVE Phase I上处理每张图片的平均耗时.算法实现的平台为Windows 7 64位,CPU为Inter Core i5-6500,3.20GHz,内存为8G RAM,软件为Matlab 2014a.

由于视差图的计算较为复杂,所以Chen[5]算法应用合成图需要很高的复杂度;另一方面,因为MSSSIM[2]和BRISQUE[3]都没有考虑任何立体深度信息,虽然计算复杂度比较快,但是性能较差.而本文所提出的算法复杂度由于需要图像分解和多维特征提取,所以略低于平面算法,但远快于Chen[5]算法.

4 结 论

立体技术的迅速普及,使得立体图像质量评价成为亟待研究的问题.本文模拟人眼视觉性能,提出了基于小波包分解的无参考立体图像质量客观评价算法,分别在合值图和差值图上提取图像大量特征,还提取左右视点结构相似度特征.实验结果表明,该方法是一种与人眼感知高度一致的评价模型.相比全参考和部分参考立体图像评价算法,该算法高效可靠,可以实时动态地评估立体图像、视频传输过程中的质量,即对接收端接受的立体图像帧及时评价质量好坏,并以此作为反馈来对受损图像进行处理.为进一步提升立体图像观看舒适度提供重大参考.

參考文献

[1] 周武杰, 郁梅, 蒋刚毅,等. 基于视觉感知和零水印的部分参考立体图像质量评价模型[J]. 电子与信息学报, 2012, 34(8):1786-1792.

ZHOU W J, YU M, JIANG G Y, et al. Reducedreference quality assessment model of stereoscopic image based on visual perception zerowatermark[J]. Journal of Electronics & Information Technology, 2012, 34(8):1786-1792. (In Chinese)

[2] WANG Z, SIMONCELLI E P, BOVIK A C. Multiscale structural similarity for image quality assessment[C]// Signals, Systems and Computers, USA: Conference Record of the ThirtySeventh Asilomar Conference on IEEE,2004:1398-1402.

[3] MITTAL A, MOORTHY A K, BOVIK A C. Noreference image quality assessment in the spatial domain[J]. IEEE Transactions on Image Processing, 2012, 21(12):4695-4708.

[4] 侯春萍, 刘月, 岳广辉,等. 沃尔什哈达玛变换域的无参考图像质量评价[J]. 湖南大学学报(自然科学版), 2017, 44(8):137-144.

HOU C P, LIU Y, YUE G H, et al. Noreference image quality assessment on Walsh Hadamard transform domain[J]. Journal of Hunan University (Nature Sciences), 2017, 44(8):137-144.(In Chinese)

[5] CHEN M J, SU C C, KWON D K, et al. Fullreference quality assessment of stereopairs accounting for rivalry[J]. Signal Processing Image Communication, 2013, 28(9):1143-1155.

[6] CHEN M J, CORMACK L K, BOVIK A C. Noreference quality assessment of natural stereopairs[J]. IEEE Transactions on Image Processing, 2013, 22(9):3379-3391.

[7] 王珊珊, 邵枫, 蒋刚毅,等. 基于双目能量响应的无参考立体图像质量评价[J]. 光电子·激光, 2014(4):741-747.

WANG S S, SHAO F, JIANG G Y, et al. Noreference image quality assessment based on binocular energy response[J], Journal of Optoelectronics·Laser, 2014(4):741-747. (In Chinese)

[8] LIN Y H, WU J L. Quality assessment of stereoscopic 3D image compression by binocular integration behaviors[J]. IEEE Transactions on Image Processing, 2014, 23(4):1527-1542.

[9] SHAO F, LIN W, GU S, et al. Perceptual fullreference quality assessment of stereoscopic images by considering binocular visual characteristics[J]. IEEE Transactions on Image Processing, 2013, 22(5):1940-1953.

[10]GU K, ZHAI G, YANG X, et al. Noreference stereoscopic IQA approach: from nonlinear effect to parallax compensation[J]. Journal of Electrical and Computer Engineering, 2012(5):1-12.

[11]ZHOU W, ZHANG S, PAN T, et al. Blind 3D image quality assessment based on selfsimilarity of binocular features[J]. Neurocomputing, 2016, 224:128-134.

[12]HADIZADEH H, BAJIC I V. Noreference image quality assessment using statistical waveletpacket features[J]. Pattern Recognition Letters, 2016, 80:144-149.

[13]FLEET D J, WAGNER H, HEEGER D J. Neural encoding of binocular disparity: energy models, position shifts and phase shifts[J]. Vision Research, 1996, 36(12):1839-1857.

[14]王旭紅, 何怡刚. 基于小波包和Elman神经网络的异步电机转子断条故障诊断方法[J]. 湖南大学学报(自然科学版), 2010, 37(5):45-48.

WANG X H, HE Y G. Method of fault diagnosis for induction machine rotor broken bar based on wavelet package and elman neural network[J]. Journal of Hunan University (Nature Sciences), 2010,37(5):45-48.(In Chinese)

[15]MA L, WANG X, LIU Q, et al. Reorganized DCTbased image representation for reduced reference stereoscopic image quality assessment[J]. Neurocomputing, 2016, 215(C):21-31.

[16]RUDERMAN D L. The statistics of natural images[J]. Network Computation in Neural Systems, 2009, 5(4):517-548.

[17]LIU L, LIU B, HUANG H, et al. Noreference image quality assessment based on spatial and spectral entropies[J]. Signal Processing Image Communication, 2014, 29(8):856-863.

[18]KOVESI P. Phase congruency detects corners and edges[C]// Pattern Recognition Society Conference. Australia: DICTA ,2003:309-318.

[19]ANDREW A M. An introduction to support vector machines and other kernelbased learning methods[J]. Kybernetes, 2001, 32(1):1-28.

[20]MOORTHY A K, SU C C, MITTAL A, et al. Subjective evaluation of stereoscopic image quality[J]. Signal Processing Image Communication, 2013, 28(8):870-883.

[21]SHAO F, LI K, LIN W, et al. Learning blind quality evaluator for stereoscopic images using joint sparse representation[J]. IEEE Transactions on Multimedia, 2016, 18(10):210-220.