采用深度学习的多方位角SAR图像目标识别研究

2018-08-20邹浩林赟洪文

邹 浩 林 赟 洪 文

(1. 中国科学院空间信息处理与应用系统技术重点实验室,北京 100190;2. 中国科学院电子学研究所,北京 100190;3. 中国科学院大学,北京 100049)

1 引言

合成孔径雷达是一种主动式微波遥感设备,它通过发射电磁波并接收回波对目标进行成像,其特殊的成像机理使其不受光照和气候的影响,能够全天时、全天候地对地面观测目标进行高分辨地成像,因此适用于军事侦查、遥感测绘、地球科学、水文地矿等领域,具有很高的军用价值和民用价值[1-3]。与光学图像不同,SAR图像中含有大量的相干斑噪声[4],严重影响了图像质量,对目标的检测和识别有较大的影响。此外,由于透视伸缩、阴影、叠掩等SAR影像固有的变形现象,SAR图像对目标观测方位角的变化十分敏感[5],即便观测方位角间隔不大,目标在SAR图像中的形态也不尽相同。这给SAR图像解译和地物目标识别带来了特殊的难题。

近年来,深度学习(Deep Learning,DL)在自然语言处理、语音识别、目标检测、图像分类、人机博弈、自动驾驶等模式识别领域取得了长足的发展和辉煌的成绩,各行各业对深度学习方面的人才需求大增[6]。常用的深度学习算法有卷积神经网络[7]、深度置信网络(Deep Belief Network,BDN)[8]、循环神经网络(Recurrent Neural Network,RNN)[9],等等,其中,在目标检测、目标识别等计算机视觉领域使用最为广泛的算法则是卷积神经网络。计算机计算性能的指数级别提升和互联网海量数据的便捷获取将深度学习推向新的高潮。2012年,在ImageNet举办的大规模图像分类竞赛(ImageNet Large Scale Visual Recognition Challenge,ILSVRC)中,Krizhevsky等人[10]设计了一个具有8层网络结构的AlexNet深度学习网络,以15.3%的Top5错误率夺得冠军,该错误率远低于之前26%的最低错误率。Szegedy等人[11]于2014年设计了一个拥有22层网络结构的Google Inception网络,在降低参数量和计算量的同时,以6.67%的Top5错误率获得冠军。在2015年,He等人[12]将网络层次继续加深,提出的152层的残差网络(Residual Network,ResNet)将错误率继续降低至3.57%,超越了人工标注的5%的错误率。

目前,基于深度学习的光学图像目标识别算法已被广泛应用到SAR图像目标识别中,并取得了不错的正确识别率(Probability of Correct Cognition,PCC)。2014年,Chen等人[13]设计了一个单隐层卷积神经网络对SAR图像目标进行识别,在经典的10大类军事目标数据集上获得了84.7%的正确识别率。2016年,田壮壮等人[14]将类别可分性度量正则化项添加到了损失函数中,并利用支持向量机(Support Vector Machine,SVM)对卷积神经网络提取出的特征图(Feature map)进行分类,提高了网络的类别区分能力。同样在2016年,Chen等人[15]针对目前SAR图像数据规模比较小、对观测条件敏感等客观条件,设计了一个拥有5个卷积层(Convolutional layer)和3个池化层(Pooling layer)的卷积神经网络,他们用卷积层替换了全连接层,并取得了99.13%的识别率。不过他们通过在数据集上对图像进行随机裁剪和翻转的方法增强训练数据集,将图像训练样本数量扩大到了原来的10倍,这将导致训练时间的增加。2017年,Furukawa等人[16]借鉴了残差网络的设计思想,针对SAR图像目标识别设计出一个拥有18个卷积层的网络结构,并通过随机裁剪等数据增强方法取得了极高的识别率。不过该网络拥有高达百万数量级别的庞大参数,训练网络时将占用巨大的计算资源以及耗费大量的时间,参数数量存在冗余,尚有待优化。

上述这些SAR目标识别方法都只是利用了目标的单一方位角观测图像,并没有考虑到SAR图像数据的获取特点,即雷达可以从多个方位角对目标进行成像,这些图像中目标的信息存在一定的冗余。而且,这些方法(除文献[15]外)只对形态差异较大的目标数据集的识别率情况进行了讨论,而没有考虑形态差异很小的目标数据集的识别率情况。本文设计了一个利用同一目标的多方位角SAR图像进行目标识别的卷积神经网络,选取的3幅同目标SAR图像在方位角上是连续获取的,它们被分别当作彩色图像的R、G、B三个通道的图像输入到网络中。此外,在本文设计的卷积神经网络中,每次卷积运算后紧接着一次批归一化(Batch Normalization,BN)处理[17],以提升网络的容纳能力,最后一个池化层通过尺度压缩将特征图展平(Flatten)。该网络一共有4个卷积层和4个池化层,以及一个全连接层(Fully connected layer),具有参数规模小和正确识别率高的特点。

2 网络结构

卷积神经网络的前几层一般由卷积层和池化层交替构成,后面则是若干全连接层,最后接入Softmax回归进行分类识别。其中卷积层用来学习图像中不同的特征,池化层是为了在尺度空间上保证特征的层次性,全连接层则可以被看作是高维空间的一个分类器,Softmax回归将识别结果以归于各个类别的概率输出。本文设计的网络共有4个卷积层和4个池化层,以及1个全连接层,其整体结构如图1所示,其中卷积层用“Conv”表示,“15@5×5”表示该卷积层共有15个尺寸为5×5的卷积核,激活函数(Activation function)选用修正线性单元(Rectified Linear Unit,ReLU),池化层选用最大池化(Max pooling),“2×2”表示该池化层的下采样窗口的尺寸为2×2。所有卷积核的步长(Stride)均设置为1,特征图四周无补0操作,所有下采样窗口的滑动步长均设置为2。

图1 网络整体架构Fig.1 Network architecture

单幅SAR图像的尺寸被裁剪成80×80,一共输入3幅,即输入的伪彩色图像的尺寸为80×80×3。第1个卷积层共有15个尺寸为5×5的卷积核,输出是15个尺寸为76×76的特征图,经过第1个池化层后特征图的尺寸变为38×38。第2个卷积层共有30个尺寸为5×5的卷积核,输出是30个尺寸为34×34的特征图,经过第2个池化层后特征图的尺寸变为17×17。第3个卷积层共有60个尺寸为6×6的卷积核,输出是60个尺寸为12×12的特征图,经过第3个池化层后特征图的尺寸变为6×6。第4个卷积层共有120个尺寸为5×5的卷积核,输出是120个尺寸为2×2的特征图,经过第4个池化层后特征图的尺寸变为1×1,该池化层通过尺度压缩实现了特征图的展平操作。120个1×1的特征图即一个120维的向量,经过1个全连接层后输出到N个节点,每个节点经过Softmax处理后输出该目标归于各个类别的概率,这里N表示目标的类别数量。

2.1 网络的输入

卷积网络的输入为一幅伪彩色图像,它的R、G、B三个通道的图像分别是在连续方位角上获取的同一目标的三幅SAR图像。不妨设这三幅图像分别为Aθ1、Aθ2和Aθ3,其中θi(i=1,2,3)为飞行平台获取图像Aθi时的方位角角度,那么伪彩色图像的三个通道可以表示为

(1)

这里,rotate(X,φ)表示将图像X逆时针旋转了φ度。因此,伪彩色图像可以表示为

A=cat(R,G,B)

(2)

其中cat(·)表示图像叠加操作。

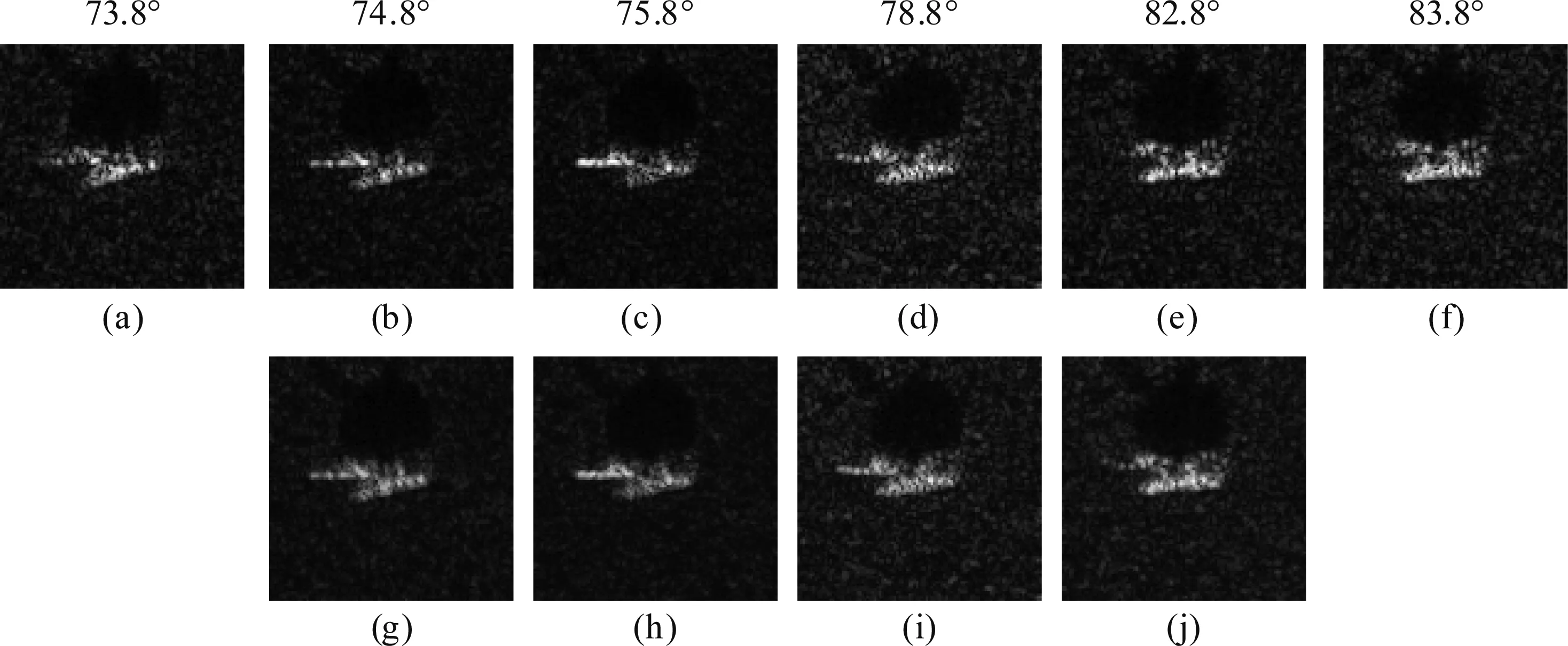

图2是在不同方位角获取的同一目标的SAR图像及其伪彩色图像,其中图2(a)~(f)分别是在方位角为73.8°、74.8°、75.8°、78.8°、82.8°和83.8°处获取的,它们在方位角上是连续的。观测方位角的差异使得SAR图像中目标具有不同的形态,即便方位角角度差很小,但是由此而引起的图像变化却不容忽视。图2(g)~(j)是图2(a)~(f)中连续的三幅图像合成的伪彩色图像,图2(g)对应着图2(a)~(c),图2(h)对应着图2(b)~(d),以此类推。彩色信息赋予了目标更丰富的内容,彩色信息的差异则是观测方位角差异在目标成像上的体现。

在真实场景中,我们可能无法提前获取目标的具体朝向,也就无法直接获取目标的地面真实信息,

图2 同一目标的SAR图像(a)~(f)和伪彩色图像(g)~(j)Fig.2 SAR images (a)~(f) and pseudo-color images (g)~(j) of the same target

也即无法预知θ1、θ2和θ3的值,但是飞行平台在获取图像数据的过程中可以获取到相邻两个观测方位角的角度差,即θ2-θ3和θ2-θ1是可以计算出来的。因此,飞行平台只需在连续的3个方位角获取目标的SAR图像即可满足本文设计的卷积网络的要求。

2.2 引入批归一化

批归一化本质上是为了解决网络在反向传播(Back Propagation,BP)过程中的梯度不稳定问题,以加快网络的收敛速度。若令

(3)

表示网络从第l-1层传播到第l层,即网络的前向传播,其中ωl为第l层的权重参数矩阵,hl为第l层的节点。那么从第l层传播到第l-1层,即网络的反向传播可以表示为

(4)

其中Δl为反向传播过程中第l层的差值。

当网络从第l层反向传播到第k(k (5) (6) (7) 接着对其作白化处理,即 (8) 批归一化会改变原始数据的分布,会使得大部分数据被拉至激活函数中间的线性部分,而在深层网络中非线性变换是至关重要的。因此,为了在非线性和梯度之间做个权衡,引入两个参数γ和β进行对数据自动调整: (9) 参数γ和β分别对数据做尺度变换和平移变换,是需要网络自己去权衡和学习的。 本文采用小批量随机梯度下降法(Mini-batch Stochastic Gradient Decent,MSGD)[18]对整个网络进行训练,并使用参数为0.9的动量(Momentum)来保持梯度下降的惯性方向,以增强网络训练的稳定性。在初始训练时给定一个稍大的初始学习率υ0,每当训练完d轮训练数据集后,使学习率下降到之前的α倍,即 (10) 其中i(i≥1)为训练轮数。本文中,υ0取0.001,d取5,α取0.5。 本文使用了由Sandia National Laboratory提供的SAR图像数据集——静止目标获取与识别(Moving and Stationary Target Acquisition and Recognition,MSTAR)数据集。在该数据集中,所有图像的分辨率为0.3 m×0.3 m,方位向从0°到360°覆盖了每个目标,涵盖了不同类别、不同型号、不同方位角、不同俯视角的军事目标,其中公开可用的只有小部分。本文分别在经典的10大类目标数据集和8种T72坦克目标数据集上各自做了实验,以验证本文提出的利用目标多方位角SAR图像进行目标识别的方法的可行性和有效性,并与其他卷积神经网络方法在识别精度和网络参数数量上作了对比分析。在训练网络和测试网络的时候,输入的均是在连续方位角上获取的同一目标的3幅SAR图像。 实验一用到的SAR图像数据为经典的10大类目标(分别为T62,T72,BMP2,BRDM2,BTR60,BTR70,D7,ZIL131,ZSU23/4,2S1)图像,它们各自的光学图像和同一方位向下的SAR图像如图3所示,从图中可以看出,不同目标的光学图像具有很大的差异,对应的SAR图像也存在人眼可辨的差别。表1是实验一用到的训练样本和测试样本的型号及其数量,其中在17°俯视角下获取的SAR图像用于训练,在15°俯视角下获取的SAR图像用于测试。 表2是实验一的正确识别率混淆矩阵,混淆矩阵中每一行表示目标所属的真实类别,每一列表示卷积网络的预测结果。从表中可以发现,除了目标BTR60未达到百分之百的识别外,其他9类目标均得到了完全的识别,整体识别率达到99.92%,这说明本文搭建的卷积网络能够有效地对SAR目标进行识别。利用多幅同目标SAR图像作为输入的策略增加了目标的信息,网络通过反向传播能够捕获到这些重要的信息,从而提高目标识别正确率。 表3是本文方法与其他方法的对比,分别从网络参数数量和正确识别率两个方面进行了对比分析。从文献[15-16][19-20]可以看出,目标的正确识别率与网络参数数量有关,随着参数数量的增加正确识别率也随之升高,说明针对含有大量相干斑噪声的SAR图像而言,过少的参数不足以挖掘出不同类别目标之间的特征,会导致较低的识别率。为了达到99.56%的识别率,文献[16]使用了上百万数量级别的参数,这在训练网络和测试网络时会占 图3 实验一中目标的光学图像和SAR图像Fig.3 Optical images and SAR images of targets in experiment ONE 目标型号2S1BMP2BRDM2BTR60BTR70D7T62T72ZIL131ZSU234训练集(17°)299233298256233299299232299299测试集(15°)274195274195196274273196274274 表2 实验一的混淆矩阵 用大量的计算资源,效率也会很低。在具有99%以上识别率的方法中,本文方法用最少的参数,却获得了最高的识别率,这一方面得益于本文使用多幅同目标图像作为网络训练和测试的输入,另一方面和网络的设计也分不开。在该数据集上,本文方法具有高达99.92%的识别精度,说明本文利用多方位角SAR图像在卷积神经网络中进行目标识别的方法是一种有效的SAR图像目标识别方法。 表3 与其他方法的比较 实验二同样用到了MSTAR数据,不过此次的目标均为T72坦克,只是它们的具体型号不同,分别为A04、A05、A07、A10、A32、A62、A63和A64,共计8种目标。图4是实验二用到的8种不同型号的T72坦克的光学图像和在同一方位向下SAR图像,从它们的光学图像中可以看出,这8种T72坦克具有相似的外形,难以区分,而人眼几乎无法从它们的SAR图像中判别出它们的所属型号,这给SAR图像目标识别带来了挑战性的难题。表4是实验二用到的训练样本和测试样本的型号及其数量,其中在17°俯视角下获取的SAR图像用于训练,在15°俯视角下获取的SAR图像用于测试。 表5和表6是实验二的正确识别率混淆矩阵,其中表5是输入为单幅目标图像得到的识别结果,表6是输入为3幅同目标图像(作为1幅伪彩色图像)得到的识别结果,我们并未改变网络的结构和超参数,只是对输入做了修改。从表中可以发现,利用3幅图像作为输入时的整体正确识别率较单幅图像相比提高了7.58%,各个目标的识别率也都有所提升,其中目标A63从84.56%的识别率提升到98.18%,足足提升了13.62%,这说明多幅图像能够携带目标更多的信息,卷积网络正是捕获了这些信息,提高目标正确识别率。在同类别不同型号目标的识别问题上,本文方法能够获得98.49%的识别率,说明本文方法在同类别不同型号的目标识别问题上具有较强的鲁棒性。 图4 实验二中8种不同型号的T72坦克的光学图像和SAR图像Fig.4 Optical images and SAR images of 8 different types of T72 tank in experiment TWO 表4 实验二的数据集 当卷积网络的输入为单幅SAR图像和3幅SAR图像时,第1、第2个卷积层分别得到的特征图如图5所示,其中第1个卷积层共得到15张特征图,尺寸为76×76,第2个卷积层共得到30张特征图,尺寸为34×34。图5(a)和图5(c)是输入分别为单幅图像和3幅图像时第1个卷积层获取的特征图,从图中可以看出,图5(a)中的特征图受原始SAR图像中相干斑噪声的影响十分严重,目标及其阴影在特征图中表现得并不明显,甚至在有些特征图中几乎难以辨别出目标,目标周围的环境噪声被放大。而图5(c)中的特征图几乎不受到相干斑的影响,目标所在位置清晰可见,目标及其阴影的轮廓也十分明显,目标周围的环境噪声得到抑制,这说明将3幅图像作为1幅伪彩色图像输入到卷积网络中增加了目标的信息,卷积网络通过反向传播优化参数,能够捕获到这些有用的信息。图5(b)和图5(d)是输入分别为单幅图像和3幅图像时第2个卷积层获取的特征图,从图中可以发现,图5(b)中的特征图开始变得紊乱,而图5(d)中的特征图依旧十分清晰,即图5(d)提取出的特征要比图5(b)好很多,而更好的特征则意味着更高的正确识别率。 表5 实验二的混淆矩阵(单幅图像) 表6 实验二的混淆矩阵(3幅图像) 图5 输入分别为单幅图像和3幅图像时,不同卷积层中的特征图Fig.5 Feature maps of different conv. layers, when input is a single image or three images 一方面卷积核提取出的特征图的质量好坏影响着整体识别性能,另一方面,卷积核的个数同样对识别性能有所影响。在用深度学习做图像识别领域中,一般地,后一层卷积层中卷积核的数量是前一层的两倍,也就是说,如果第1个卷积层有s个卷积核,那么第k(k≥2)层卷积层则有2k-1·s个卷积核,本文的网络亦采用了这样的设计策略。图6展示了目标整体识别率随卷积核的数量变化的示意图,可以看出,识别率受卷积核的数量的影响颇大。当卷积核较少时,随着其数量的增加,正确识别率急速上升;但当卷积核较多时,随着其数量的增加,正确识别率上升缓慢,甚至几乎不再上升。卷积核的多少决定着特征图的数量,太少的卷积核不利于获得可观的目标识别率,而过多的卷积核不但对提高目标识别率帮助不大,还会在训练阶段占用大量的计算资源和训练时间。 图6 正确识别率与卷积核的数量的关系Fig.6 Relationship of PCC and the number ofconvolution kernels 本文提出了一种利用多方位角SAR图像在卷积神经网络中进行目标识别的方法,并设计了一个用于SAR图像目标识别的卷积神经网络架构,通过将3幅同目标图像作为一幅伪彩色图像输入到网络中,降低了目标方位敏感性,提高了目标识别率。在经典的10大类目标识别数据集上,本文方法用少量的网络参数取得了最高的识别率,在同类别不同型号的目标识别问题上,本文方法也达到了98.49%的识别率,这得益于良好的网络结构设计和在网络输入方式上的改进。实验结果表明,即便在小规模的数据集上,利用多方位角SAR图像能够显著提高目标识别率,在同类别不同型号的目标识别问题上有着可观的识别率,本文方法是一种有效的合成孔径雷达目标识别方法。 [1] 盖旭刚, 陈晋汶, 韩俊,等. 合成孔径雷达的现状与发展趋势[J]. 飞航导弹, 2011(3):82- 86. Gai Xugang, Chen Jinwen, Han Jun, et al. Present Situation and Development Trend of Synthetic Aperture Radar[J]. Aerodynamic Missile Journal, 2011(3):82- 86.(in Chinese) [2] 张红, 王超, 张波,等. 高分辨率SAR图像目标识别[M]. 北京:科学出版社, 2009:4-7. Zhang Hong, Wang Chao, Zhang Bo, et al. High Resolution SAR Image Target Recognition[M]. Beijing: Science Press, 2009:4-7.(in Chinese) [3] Moreira A, Prats-Iraola P, Younis M, et al. A Tutorial on Synthetic Aperture Radar[J]. IEEE Geoscience and Remote Sensing Magazine, 2013, 1(1):6- 43. [4] 王瑞霞,林伟,毛军.基于小波变换和PCA的SAR图像相干斑抑制[J].计算机工程,2008,34(20):235-237. Wang Ruixia, Lin Wei, Mao Jun. Speckle Suppression for SAR Image Based on Wavelet Transform and PCA[J]. Computer Engineering,2008,34(20):235-237.(in Chinese) [5] O’Sullivan J A, Devore M D,Kedia V, et al. SAR ATR Performance Using a Conditionally Gaussian Model[J]. IEEE Transactions on Aerospace and Electronic Systems, 2001, 37(1):91-108. [6] 徐丰,王海鹏,金亚秋.深度学习在SAR目标识别与地物分类中的应用[J].雷达学报,2017,6(2):136-148. Xu Feng, Wang Haipeng, Jin Yaqiu. Deep Learning as Applied in SAR Target Recognition and Terrain Classification[J]. Journal of Radars, 2017, 6(2):136-148.(in Chinese) [7] LEcun Y, Bottou L, Bengio Y, et al. Gradient-Based Learning Applied to Document Recognition[J]. Proceedings of the IEEE, 1998, 86(11):2278-2324. [8] Hinton G E,Osindero S, Teh Y W. A Fast Learning Algorithm for Deep Belief Nets[J]. Neural Computation, 2014, 18(7):1527-1554. [9] Williams R J,Zipser D. A Learning Algorithm for Continually Running Fully Recurrent Neural Networks[J]. Neural Computation. 1989, 1(2): 270-280. [10] Krizhevsky A, Sutskever I, Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks[C]∥International Conference on Neural Information Processing Systems. Nevada, USA: Curran Associates Inc, 2012: 1097-1105. [11] Szegedy C, Liu W, Jia Y, et al. Going Deeper with Convolutions[C]∥Computer Vision and Pattern Recognition. Boston, USA: IEEE, 2015: 1-9. [12] He K, Zhang X, Ren S, et al. Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification[C]∥IEEE International Conference on Computer Vision, Washington DC, USA: IEEE, 2015:1026-1034. [13] Chen S, Wang H. SAR Target Recognition Based on Deep Learning[C]∥International Conference on Data Science and Advanced Analytics. Shanghai, China: IEEE, 2015:541-547. [14] 田壮壮, 占荣辉, 胡杰民,等. 基于卷积神经网络的SAR图像目标识别研究[J]. 雷达学报, 2016, 5(3):320-325. Tian Zhuangzhuang, Zhan Ronghui, Hu Jiemin, et al. SAR ATR Based on Convolutional Neural Network[J]. Journal of Radars, 2016, 5(3): 320-325.(in Chinese) [15] Chen S, Wang H, Xu F, et al. Target Classification Using the Deep Convolutional Networks for SAR Images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(8): 4806- 4817. [16] Furukawa H. Deep Learning for Target Classification from SAR Imagery: Data Augmentation and Translation Invariance[J].IEICE Technical Report, 2017, 117(182):11-17. [17] Loffe S, Szegedy C. Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift[C]∥International Conference on Machine Learning. Lille, France: JMLR.org, 2015:448- 456. [18] Qian Q, Jin R, Yi J, et al. Efficient Distance Metric Learning by Adaptive Sampling and Mini-Batch Stochastic Gradient Descent[J]. Machine Learning, 2015, 99(3):353-372. [19] Morgan D A E. Deep Convolutional Neural Networks for ATR from SAR Imagery[C]∥Algorithms for Synthetic Aperture Radar Imagery XII. Maryland, USA: SPIE Defense and Security, 2015:94750F. [20] 刘寒颖, 张耀天, 张玉玺,等. 基于深度学习的SAR目标识别及FPGA实现[C]∥第十一届全国信号和智能信息处理与应用学术年会会议. 贵阳, 中国: 计算机工程应用, 2017:371-375. Liu Hanying, Zhang Yaotian, Zhang Yuxi, et al. SAR Target Recognition and FPGA Implementation Based on Deep Learning[C]∥Eleventh Annual National Conference on Signal and Intelligent Information Processing and Application. Guiyang, China: Computer Engineering and Applications, 2017:371-375.(in Chinese)

2.3 学习率的设计

3 实验结果与分析

3.1 实验一

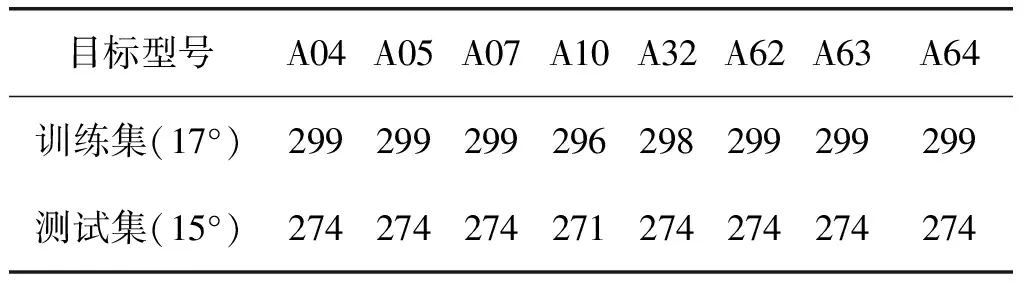

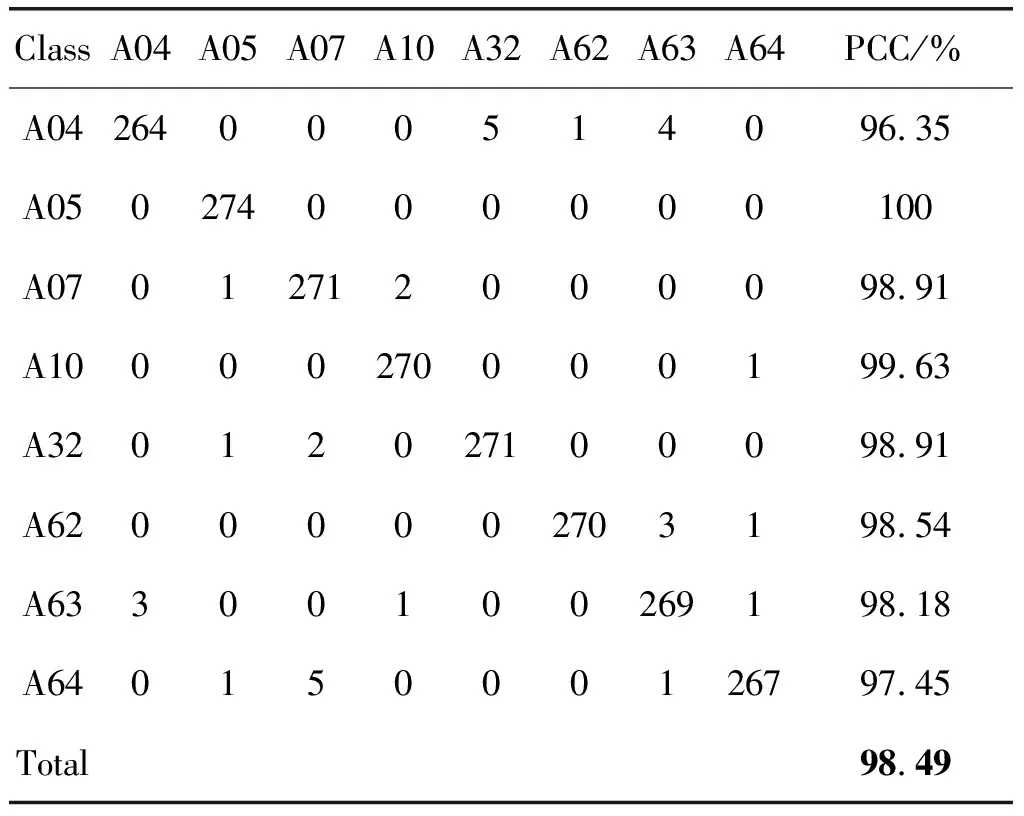

3.2 实验二

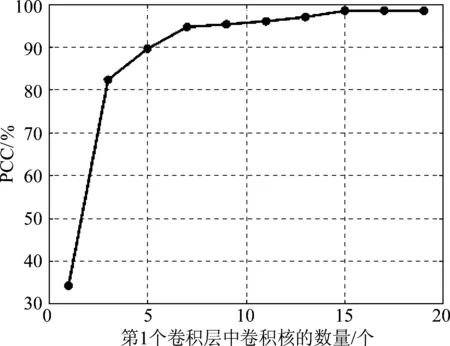

4 结论