单幅近红外手掌图像掌静脉和掌纹多特征识别

2018-05-08李俊林王华彬

李俊林,王华彬,陶 亮

LI Junlin,WANG Huabin,TAO Liang

安徽大学 计算机科学与技术学院,合肥 230601

School of Computer Science and Technology,Anhui University,Hefei 230601,China

1 引言

当前,生物特征识别技术[1]由于其便捷性,是人们用来替代传统人工密码认证方式的主要途径。现有的研究人员对基于手部特征的识别技术已经做了大量的研究,主要包括指静脉识别[2]、掌静脉识别[3]、指纹识别[4]、掌纹识别[5]和手型识别[6]等。而针对指纹识别和掌纹识别这些皮肤表层的生物特征,容易遭到伪造,破坏其安全性[7],且单一特征的识别技术在提高识别率上往往处于研究的瓶颈[8]。为了解决以上问题,现有的学者提出了多特征融合识别技术[9],其中,掌静脉和掌纹的融合识别技术是当前的研究热点之一。在掌静脉图像和掌纹图像多特征融合识别系统中,利用近红外手掌图像中提取增强的掌静脉图像是其步骤之一,这个过程中却丢弃了近红外手掌图像中原本包含掌纹图像等结构特征信息,后续步骤中需要用其他方式重新获得掌纹结构信息的图像,这些过程无疑造成诸多的不便和繁琐。在现今应用成熟的掌静脉图像和掌纹图像多特征融合识别的系统中,获取样本的掌静脉图像和掌纹图像,主要有以下两种方式:

(1)采用多摄像头,普通镜头和带有近红外(Near Infrared,NIR)滤波片的镜头组合使用,如文献[10],采用3个摄像头分别捕捉掌纹、掌静脉和掌背的图像,得到的3个图像分别提取各自的特征,最后进行决策层的融合方法,实现多模态的特征融合识别。上述研究都由于多幅图像空间位置不是一一对应的,这样得到的多幅图像需要进行图像配准。如Yang等人在文献[11]中和Wang等人在文献[12]都用到图像配准的方法,找到单应矩阵,从而实现一对一的映射关系。为找到的3×3的单应矩阵需要选取图像中的4个结构点,应用到实际都有一定的缺陷。

(2)采用单摄像头,利用不同波长频谱捕捉掌纹和掌静脉图像,如文献[13]。因为血液中的血红蛋白吸收红外光谱的范围在760~850 nm之间,红外光谱被静脉血液中的血红蛋白吸收,使得掌静脉在近红外光源下显得更暗,从而区别显示掌纹和掌静脉。其具体操作相对来说比较复杂,实际应用范围有限。

通过上述分析可知,现有的掌静脉和掌纹融合识别方法中,掌静脉和掌纹图像是完全独立的,不管采用多摄像头还是单摄像头模式,其采集过程多有不便,较为繁琐。经过实验分析,单幅近红外手掌图像中同时包含掌静脉和掌纹结构信息,如果能够从单幅图像中分别增强掌静脉以及掌纹结构,设计出合理的融合识别方法,不仅提高单幅近红外手掌图像的识别率,而且可以简化融合识别系统的复杂度。

本文提出了一种从单幅近红外手掌图像中,分别单独增强掌静脉和掌纹结构,实现掌静脉和掌纹的多特征融合识别方法。具体过程如下:(1)增强掌静脉结构,首先利用改进的引导滤波算法,去除掌纹结构;然后用反模糊细节增强模型对掌静脉结构进行增强。(2)为了增强掌纹结构,利用分块增强算法突出掌纹主线条结构,同时去除掌静脉结构;针对分块增强算法无法处理颗粒噪声的问题,及提高掌纹主线条结构的对比度,使用基于Sobel梯度算子反锐化掩模增强算法增强掌纹结构。(3)利用二维小波分解提取掌静脉图像和掌纹图像的全局特征,提出特征加权融合识别方法。训练时,计算掌静脉和掌纹图像的识别阈值,计算两者加权后的识别阈值,得到最终的识别阈值。测试时,计算待测样本和已注册图像掌静脉和掌纹的相似系数,找出加权后相似系数最大的一组,判断相似系数和识别阈值的关系,若相似系数大于等于其识别阈值,判断为同类,否则拒绝识别,识别结束。最后统计其中正确识别和错误识别的样本数,得到识别率、误识率和拒识率。

本文设计的算法可以从单幅近红外手掌图像中,分别增强掌静脉图像和掌纹图像。然后利用掌静脉和掌纹图像,提出特征加权融合识别算法,其识别效果优于其他算法。

2 近红外手掌图像分析

由于活体人体手掌组织各个部位的差异性,使得近红外手掌图像中同时包含掌静脉结构和掌纹结构图像,如图1中所示的样本图像,可以观察到掌静脉和掌纹结构(掌静脉结构表现暗淡,掌纹结构表现偏白)。通过对感兴趣区域的(Region of Interest,ROI)近红外手掌图像进行分析,发现掌静脉和掌纹结构存在以下区别:

(1)掌纹线条结构延伸平缓,局部区域掌静脉相对于掌纹的线条结构更宽,且掌静脉在结构边缘处方差较大。

(2)掌纹与掌静脉的像素值分布范围不同,掌静脉像素值偏小,视觉上显得暗淡。

基于以上两点事实,认为可以从单幅近红外手掌图像中分别单独增强掌静脉结构和掌纹结构图像,实现掌静脉和掌纹的多特征融合识别。

图1 数据库样图

3 掌静脉结构增强

3.1 图像自引导滤波理论

提取掌静脉图像使用引导滤波算法[14],针对二维引导滤波模型,可用下面式(1)表达:

在式(1)中,I为引导滤波的引导图像,q为输出图像式,p为输入图像式,Wij为是引导图像I的核函数,i和 j为像素点的空间位置。I作为引导图像,如果I=p,即自引导滤波。设滤波窗口wk,中心点为k,q为I的线性变换,则引导图像如式(2)所示:

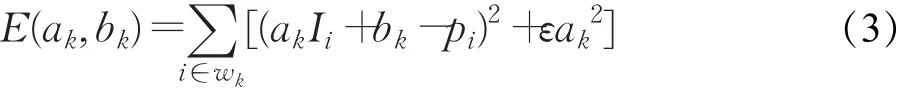

引导滤波中,为了减少边缘细节损失,通过最小化p和q的差来确定系数ak和bk,使得式(3)最小:

式(3)中ε是正则化参数,防止ak过大。通过最小二乘法解式(3),求解 ak、bk得到:

式(4)、(5)中 uk和分别是 I在 wk中的均值和方差,|w|是wk中像素的个数,pˉk是输入图像 p在wk中的均值,求出该局部线性模型后,代入整幅图像,由于每一个像素点会有多个包含在该像素点的窗口wk,所以当在不同的窗口wk计算时qi的值会有不同,故进行平均处理,如下式:

式(7)中:

综上,核函数W可以定义如下:

3.2 基于自引导滤波的掌静脉结构增强

图像增强是图像处理过程中非常重要的一个步骤,关系到高层次图像处理的特征提取和识别。图像增强的主要目的是抑制噪声和提高图像边缘的对比度。自引导滤波由于引导图像是自身图像,和其他滤波算法相比具有良好的边缘梯度保持能力,同时具备一定的平滑去噪能力。引导滤波在图像的增强方面得到广泛的应用,通过原图像和自引导滤波后的图像相减得到滤除的部分,将这些滤除的部分以一定的比例融入滤波后的图像,即可以获得到高对比度的图像。这个过程如何选取合适的滤波半径和正则化参数是关键。

自引导滤波中,如果ε>0,像素值方差大的局部区域,自引导滤波效果不明显,保持了原图的边缘信息。而像素值方差小的局部区域,自引导滤波近似为加权均值滤波;同时,滤波半径越大,其平滑噪声效果越明显,但随着滤波半径的增大也会降低边缘的对比度图2(b)。观察近红外手掌图像,容易发现掌纹像素值较大,线条窄细,其结构边缘局部像素值方差较小,因此,自引导滤波选取较大的滤波半径对其使用近似的加权均值滤波处理,去除掌纹结构。而掌静脉结构,灰度值较低,且边缘明显,其局部像素值方差较大,自引导滤波可以选取较小的滤波半径,从而保持掌静脉结构边缘信息。然而由于自引导滤波半径固定,不能获得增强掌静脉结构的同时去除掌纹的图像,如图2(c)所示。

为了解决以上的问题,本文提出了改进的自引导滤波算法增强掌静脉图像,不仅可以增强掌静脉图像,同时可以去除掌纹信息。观察自引导滤波后的图2(b),较大的自引导滤波半径可以得到平滑掌纹的图像,而当自引导滤波半径较小时可以得到保持边缘的掌静脉图像。因此可以分两次自引导滤波处理,第一次选取较小的滤波半径r1得到保持掌静脉边缘的q1,第二次将对q1使用较大的滤波半径r2得到平滑掌纹的q2,最后对q1和q2使用细节融合增强算法,具体步骤如下:

(1)对近红外手掌图像 pinfrared使用自引导滤波,选取较小的滤波窗口r1=2和正则化参数ε=0.12,得到保持掌静脉边缘的q1。

(2)对q1使用窗口较大的r2=16和正则化参数ε=0.12,进行自引导滤波,平滑掉掌纹后的图像q2。

(3)对保持细节边缘的q1和平滑掉掌纹后的图像q2使用细节增强模型,I为增强后掌静脉图像,这里的t为细节增强参数,t取5。

(4)为了增强较好的掌静脉图像,重复步骤(1)~(3),提取增强后的掌静脉图像Ivein。

经过上述步骤处理近红外手掌图像,得到增强的掌静脉图像,如图2(d)所示,掌静脉结构对比度明显,去除了掌纹结构信息,且增强后的掌静脉结构保持连续。

图2 增强掌静脉

4 掌纹结构增强

4.1 分块增强模型

近红外手掌图像中包含掌纹结构,由于掌纹结构窄细,线条平缓。相对于掌静脉,掌纹的像素值较大,且掌纹的像素值偏离该局部区域的均值。因此可以用改进的分块增强模型[15]突出掌纹的主线条结构。分块增强算法需要评估背景强度,其具体算法步骤如下:

(1)将图像分成大小相等半径为R小块,每个小块间3个像素的重叠,计算各个小块的像素均值,得到背景矩阵。

(2)将得到的背景矩阵使用双三次插值,得到和原图像矩阵一样的维数。

(3)用原图像和背景矩阵相减,最后使用直方图均衡化。

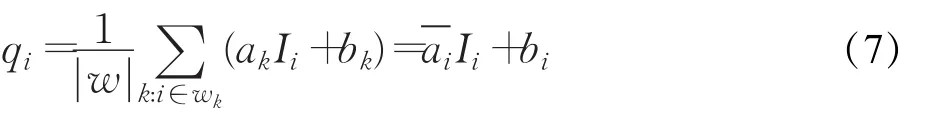

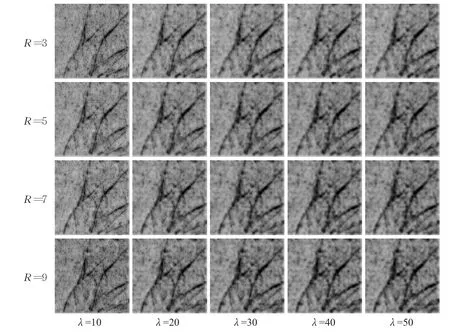

图3列出了不同分块半径下的掌纹增强效果。

图3 不同分块半径下掌纹结构增强

实验得知,图像分块增强算法可以提高掌纹结构的纹理和对比度,同时,由于分块增强模型算法对背景矩阵使用了双三次插值,图像的分块增强引入大量颗粒噪声,掌纹纹理结构得到突出,但是无法消除背景的噪声,如图3(b)所示。由于这个问题,本文在掩模增强算法[16]的基础上,对掌纹结构提出了基于Sobel算子改进的图像反锐化掩模增强算法。

4.2 基于Sobel算子的反锐化掩模掌纹结构增强

为了获取掌纹的主线条结构纹理,Sobel算子在检测边缘的同时可以抑制噪声。Sobel算子的梯度操作可以明显地看到掌纹的主线结构提取出来,如图4(c)所示,但是也不可避免地引入虚假掌纹结构和其他噪声。虚假掌纹结构表现为不连续的断点噪声,这些噪声是Sobel算子的误检测导致,将那些梯度大于阈值的认为是掌纹结构边缘。为了消除这些虚假掌纹结构信息的噪声,本文使用的方法是迭代均值滤波处理,滤波窗口大小为9。均值滤波的功能是对像素邻域内所有的像素值取均值,将得到的平均值作为当前像素新的像素值。由于掌纹主线条结构处像素值较大,掌纹边缘周围的像素值较小,经过均值滤波处理后的掌纹结构更加突出,同时对于那些由于Sobel算子误检测的噪声小块和细纹可以得到平滑和去噪处理。图4(d)~(f)分别为均值滤波迭代一次、两次和三次的结果,从中可以看出,经过三次迭代后的效果最好,过多的迭代也会造成图像模糊化问题。

图4 掌纹结构图像增强

为了进一步增强掌纹结构,提高掌纹主线结构和周围的对比度,这里使用隶属度函数[17]。该方法提供模糊反锐化的图像增强算法,即:

其中,I′是增强后的图像,I为待增强图像,Ifuzzy为I经过隶属度函数处理后的模糊化后的图像,λ是细节增强系数。当λ=10时,掌纹增强的效果如图4(g)所示。

综上,掌纹结构的增强步骤为:

(1)将图像分成小块,每个小块大小为R×R,用分块增强模型算法处理近红外手掌图像Pinfrared,得到Iblock。

(2)采用Sobel算子水平和垂直方向检测分块增强图像Iblock中掌纹主线条结构,经过3次迭代均值滤波处理得到ISobel。

(3)隶属度函数处理ISobel,得到模糊化后的图像Ifuzzy。

(4)使用模糊反锐化图像增强模型 I′=ISobel-λ×Ifuzzy,得到增强后的掌纹结构图像I′。

5 特征提取及融合识别

5.1 特征提取和识别率计算

小波分解在图像特征提取中比较常见的应用方法。经小波分解后的图像有低频和高频部分,低频对应图像的全局特征,高频对应与图像的细节特征。由于在近红外手掌图像中提取掌静脉和掌纹主要结构信息的过程中,细节信息丢失严重,但掌静脉和掌纹的主要结构特征得到保留,因此特征提取选取小波分解后的低频子带图像。

图像每经过一次小波分解,图像像素点个数都会减少到原图像的1/4,且会得到LL、HL、LH和HH四个子带图像,分别代表原图像水平方向和垂直方向的低频分量、水平方向高频分量和垂直方向低频分量、水平方向低频分量和垂直方向高频分量、水平方向和垂直方向的高频分量。近红外手掌图像中提取到的掌静脉图像和掌纹图像,大小依然是128×128的灰度图像。为了降低图像的维数,保持图像主要的全局特征,这里使用二级二维小波分解的方法,两次提取LL子带低频分量的图像。

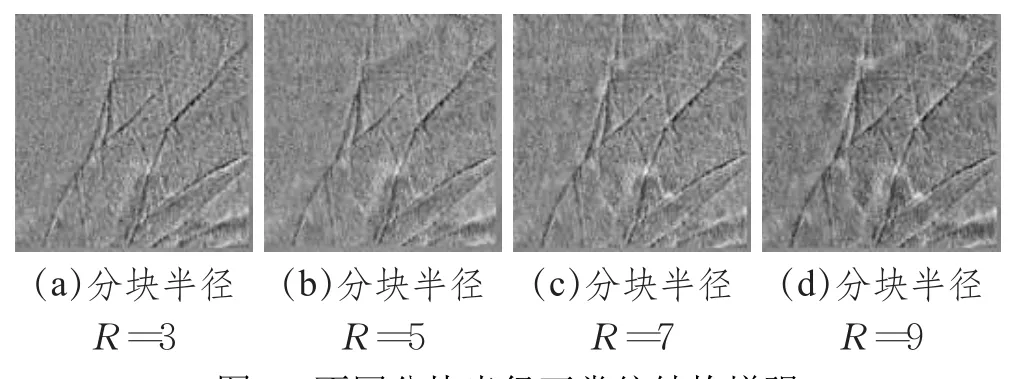

经过二级二维小波分解后LL子带低频分量的图像,保持了图像的主要全局特征,且图像矩阵的大小降低为32×32。设A、B为大小为M×N的两个矩阵。则它们的相似系数Rs定义如下:

识别阈值的设置:训练时,计算每个样本的若干张图像中任意两张图像矩阵的相似系数,取其中最小的值记为,则识别阈值其中m=1,2,…,500)。

测试时用数据库每个样本中随机选取的6张图像,共进行3 000次测试。具体步骤为:

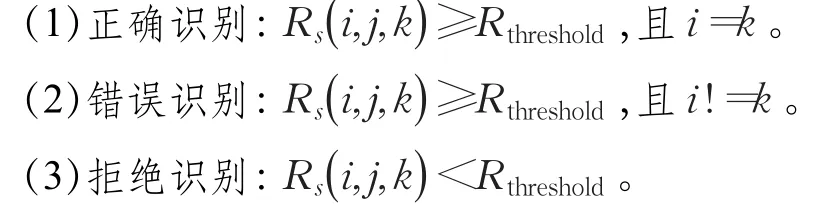

将第i个待测样本的第 j张图像与数据库k个样本的第1张图像一一计算相似系数(其中i=1,2,…,500,j=7,8,…,12,k=1,2,…,500),取其中相似系数最大的一组,判断和Rthreshold的关系,将识别结果定义如下:

识别率(Correct Recognition Rate,CRR)、误识率(False Accept Rate,FAR)和拒识率(False Rejection Rate,FRR)定义如下:

5.2 融合识别

图像的融合系统中,融合方式有多种,分为像素层融合、特征层融合和决策层融合。一般将这些融合方式称为低级融合、中级融合和高级融合[18]。不同的融合识别系统采用的融合方式不一样。其中,低级融合的融合方式利用图像的信息量最大,高级融合的融合方式利用图像的信息量最小。虽然在信息量利用方面低级融合要优于高级融合,但是从实现的难度来看,图像的高级融合方式更加简单便捷[19],通过计算单一模态得分后即可通过加权得分实现决策层的特征融合,且本文在增强掌静脉和掌纹结构图像的过程中,原近红外手掌图像的像素信息已经发生改变,不适合使用低级融合的掌静脉和掌纹多特征融合,综合以上原因,本文采用了决策层的加权融合方法,即对掌静脉和掌纹的识别阈值进行加权处理,其阈值的数学表达式如下:式(12)中,α是加权系数,0≤α≤1,Tvein是掌静脉的识别阈值,Tprint是掌纹的识别阈值,通过加权处理,最后得到融合后的识别阈值Tfusion。

6 实验结果和实验分析

6.1 数据库选择

目前公开的近红外手掌图像的数据库中,香港理工大学人体生物特征识别研究中心提供的多频谱掌纹图像数据库[20]是众多学者经常使用的数据库之一,该数据库提供蓝、绿、红和近红外光源下的手掌感兴趣区域图像。本文选取的是近红外手掌图像,图像为128×128的灰度图像,来自250个人的左手和右手,共计500个样本,每个样本分前后两个时期采集,每期采集6张近红外手掌图像,共计6 000张。其中,对于近红外手掌图像感兴趣区域提取算法在文献[21]中有说明。

6.2 自引导滤波窗口r和正则化参数ε参数选择

自引导滤波中,选取合适的滤波窗口r和正则化参数ε是有效增强掌静脉的关键,图5是调节自引导滤波参数的一组实验效果图。

由图5知,在滤波窗口半径r固定的时候,正则化参数ε变化对滤波的效果变化不明显。相反,在正则化参数ε固定的时候,滤波窗口的变化对滤波效果较为明显,随着窗口的增加,图像的平滑效果也越明显。因此,本文采用固定正则化参数ε=0.12,控制滤波窗口r来比较掌静脉增强效果。

图5 滤波窗口r和正则化参数滤波效果

6.3 掌静脉结构增强和识别实验

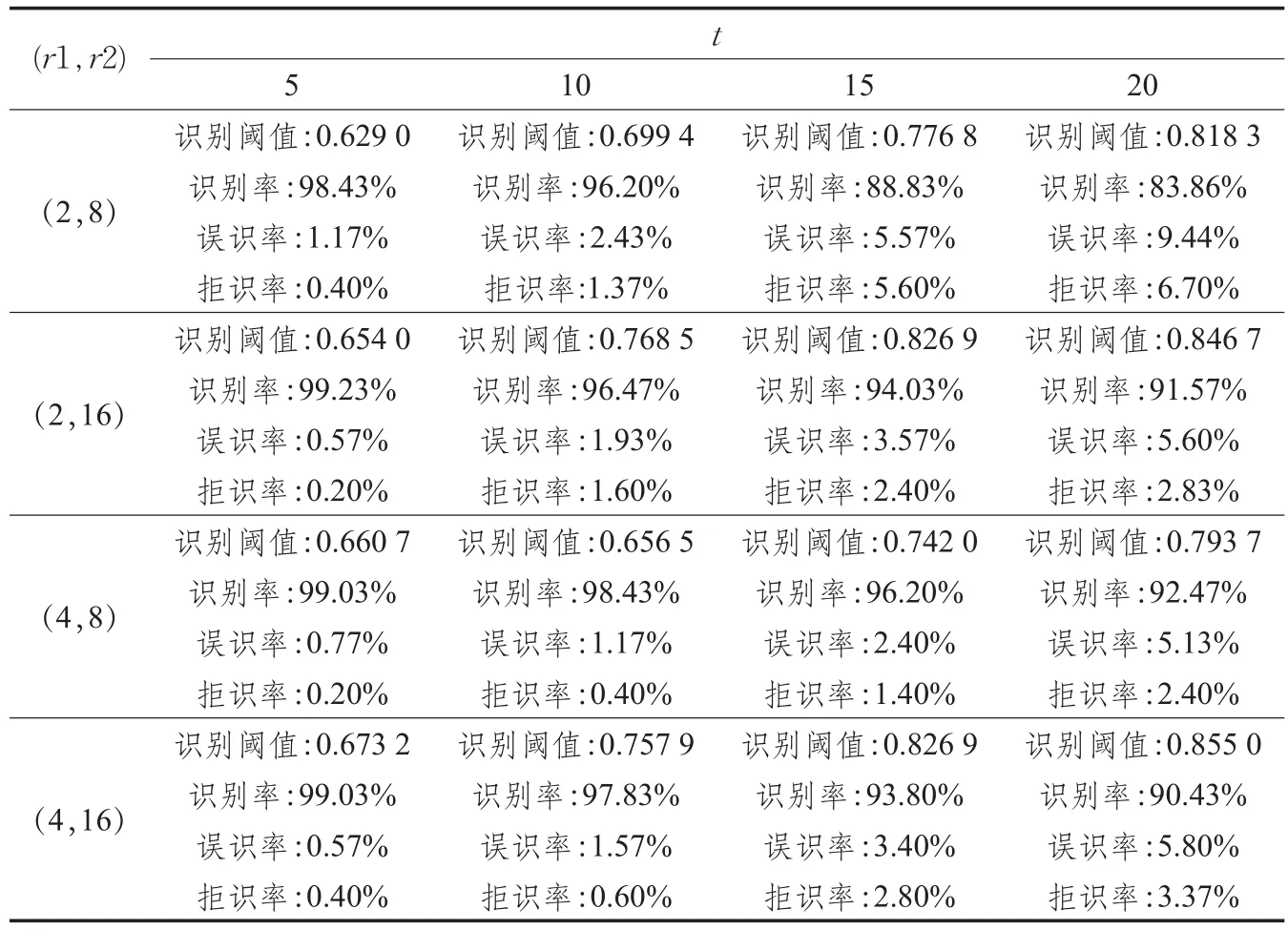

掌静脉的自引导滤波中,正则化参数ε变化对掌静脉的滤波效果影响不明显,这里取值0.12,而滤波窗口t的变化对掌静脉的滤波效果明显。因此,图6列出(r1,r2)和细节增强参数t,比较掌静脉的增强效果。

图6 不同滤波窗口和增强系数掌静脉增强效果

表1 不同滤波窗口和增强系数的掌静脉识别效果

其中图6中(r1,r2)分别表示自引导滤波保持掌静脉边缘的q1选择较小的滤波窗口r1,以及自引导滤波为了平滑掌纹得到的q2而选择较大的滤波窗口r2,t为细节增强模型参数。得到的掌静脉结构增强效果图6所示,表1给出了对应的掌静脉识别结果。

结合图6和表1,可以看出,随着窗口(r1,r2)的取值变化,滤波效果也发生了变化。增强系数取值增大,也会导致掌静脉图像的滤波效果变得更加明显。同时,增强系数过大,引入的噪声数据也会增多,不利于识别。在选取每个样本的随机6张图像作为训练样本时,由表1中数据可得,当 (r1,r2)=(2,16)时,t=5时,此时的掌静脉识别效果最好,掌静脉的识别阈值为0.654 0,识别率99.23%,误识率0.57%,据识率为0.20%。

一般来说,当选取的训练样本数越多,模式识别的识别效果也会越好。本文在训练样本个数不同的情况下做了识别实验,其结果如图7所示。

图7表明,当样本的训练个数在6以下时,掌静脉的识别率是随着训练样本数的增加而提高;当训练的样本数大于6时,识别率变化不明显,只有在样本数为9和10时,识别率稍有提高,由于实验中样本训练个数越多,对应的处理时间也会增多。因此,本文的所有识别实验中,选取训练样本为6,既充分考虑识别率也兼顾了处理时间。

图7 训练样本数和识别率关系

6.4 掌纹结构增强和识别实验

由4.1节可知,掌纹的分块增强算法中,实验得知,分块大小也会影响掌纹结构质量和图像的噪声,分块较小的时候留下来的掌静脉信息较少,然而掌纹的对比度不高,不利于增强掌纹结构;分块较大的时候,掌纹结构更加突出,然而掌静脉等不必要的噪声信息较多。

细节增强系数也会影响识别率,为了选取细节增强参数λ,图8列出了不同参数下增强后的掌纹结构图像,及表2对应地列出了掌纹识别结果。

结合图8和表2可知,在R=9,λ=50时,此时的掌纹识别效果最好,得到的掌纹识别阈值是0.525 4,识别率为94.00%,误识别率为3.57%,据识别率为2.43%。上述的结果表明,同时增强掌静脉和掌纹,掌静脉的识别效果要优于掌纹识别。

图8 不同分块半径和增强系数掌纹增强效果

表2 不同分块半径和增强系数掌纹识别效果

表3 掌静脉和掌纹融合识别效果

6.5 融合识别实验

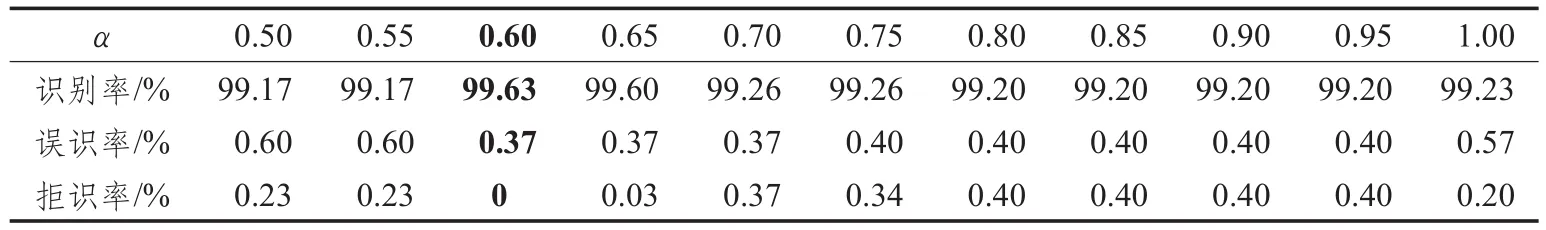

为了达到最好的识别效果,结合掌静脉识别和掌纹识别的实验结果,将掌静脉的增强参数设置为(r1,r2)=(2,16),t=5;掌纹的增强参数设置为 R=9,λ=50。由实验得知,同时增强掌静脉结构和掌纹结构图像,掌静脉的识别效果优于掌纹识别效果,因此,融合识别时掌静脉的权值应该大于掌纹的权值,即α的取值区间为[0.5,1.0]。为了找到近优解α,择优间隔为0.05。最后得到的融合识别效果如表3所示。

由表3可得,在α取值0.6时,此时的融合识别率最高99.63%,误识率为0.37%,拒识率为0。在α取值0.7时,此时的等误率(Equal Error Rate,EER)为0.37%。

6.6 识别速度

本文中的所有实验均在Intel i5/3.20 GHz CPU/4 GB RAM/MATLAB 2013环境下进行,对整个识别阶段的处理时间Ttotal定义如下:

式(13)中,Tv_e为在近红外手掌图像中增强掌静脉结构图像所需时间;Tp_e为在近红外手掌图像中增强掌纹结构图像所需时间;Tv_w为掌静脉结构图像的小波分解特征提取所需时间;Tp_w为掌纹结构图像小波分解的特征提取所需时间;Tf_r为掌静脉和掌纹加权融合识别处理时间。设图像的像素点个数为N,则表4列出每个步骤对应的时间复杂度和其平均运行时间。结果表明,识别阶段总的时间Ttotal为0.708 181 s。

表4 时间复杂度和对应的运行时间

6.7 实验对比

在单幅近红外手掌图像实现掌静脉和掌纹多特征融合识别的研究中,目前没有可以比较的文献。为了验证本文提出的算法具有有效性,故在表5中列举了针对近红外手掌图像针对掌静脉特征几种常见的识别算法。其中,文献[22]对近红外手掌图像中的掌静脉采用了基于方向梯度直方图的特征提取方法,和改进的支持向量机的方法实现识别匹配。通过计算图像局部像素点的梯度幅值和前景边缘方向来描述图像特征,最后采用可调节阈值支持向量机完成分类识别。文献[23]把近红外手掌图像中掌静脉作为特征,通过二维可调Gabor滤波器在提取掌静脉图像的4方向(0°,45°,90°和135°)特征,找到Gabor函数实部和虚部响应的4个方向中最大的梯度值,对实部最大梯度值和虚部最大的梯度值使用位串编码(VeinCode),采用这样的方向编码方法,将掌静脉的方向信息存储为特征向量,最后采用归一化后的汉明距离方法进行匹配识别。文献[24]采用尺度不变特征变换(Scale Invariant Feature Transform SIFT),首先通过高斯差分函数的极值点找到掌静脉图像中的关键点,对每一个样本图像分配梯度幅值和梯度方向,在关键点区域16×16的数组内形成方向直方图,计算关键点梯度方向,每个关键点包含8个方向信息,一共有4×4个关键点,这样就形成了128维的特征向量,最后采用欧几里德距离进行样本匹配识别。本文在香港理工大学提供的近红外手掌图像数据库中实现了其中的算法。由于以上文献算法对本文数据库中的近红外手掌图像只作为静脉识别,其方法为单一特征的掌静脉识别,没有考虑原近红外手掌图像中的掌纹信息,本文在考虑掌纹信息情况下等误率优于以上算法,具体对比如表5所示。

表5 近红外手掌图像识别性能对比

6.8 实验分析

本文对单幅近红外手掌近图像分别增强掌静脉结构和掌纹结构图像。采用自引导滤波算法增强掌静脉结构,通过实验表明,自引导滤波中正则化参数ε对掌静脉的滤波效果不明显,而近红外手掌图像中掌静脉和掌纹的结构纹理不同,通过自引导滤波无法获得增强掌静脉结构同时去除掌纹结构的图像。为了解决这个问题,本文使用了两次自引导滤波,第一次使用较小的滤波半径,得到保持掌静脉边缘的图像,对第一次滤波图像使用较大的自引导滤波半径处理,得到了平滑掌纹结构的图像,两次相减刚好是滤除的掌纹纹理的部分,通过一定的系数融合到保持掌静脉边缘的图像中,掌静脉的边缘结构相比原图,得到明显增强,且同时平滑了掌纹信息。近红外手掌图像中同时也包含掌纹结构,由于掌纹结构窄细,线条平缓。相对于掌静脉,掌纹的像素值较大,且掌纹的像素值偏离该局部区域的均值。因此用分块增强模型突出掌纹的主线条结构。经过分块增强后,掌纹主线条结构得到突出,但引入了颗粒噪声。为了提高掌纹边缘的对比度和平滑噪声,使用Sobel算子在水平和垂直方向做边缘检测,对误检测的边缘使用迭代均值的滤波方法平滑,平滑后的图像使用反锐化掩模增强算法增强掌纹图像,和原图相比,掌纹主线条结构对比度提高,且平滑了掌静脉结构。对增强后的掌静脉结构和掌纹结构图像使用加权特征融合识别,结果表明,在相同的数据库下,本文算法等误率EER为0.37%,比其他算法平均降低0.66%。

7 结论

本文单幅近红外手掌图像实现掌静脉和掌纹多特征融合识别的方法:即利用单幅近红外手掌图像分别单独增强掌静脉和掌纹结构图像,解决了传统多特征识别需要获取多幅图像的问题。由于掌静脉和掌纹结构在近红外手掌图像中局部纹理信息的差异和像素值分布范围的不同,通过改进的自引导滤波方法增强掌静脉结构,和基于Sobel算子反锐化掩模增强算法增强掌纹结构,得到了增强后的掌静脉和掌纹结构图像。对掌静脉和掌纹结构图像使用多特征融合识别方法,结果表明,本文掌静脉和掌纹融合识别算法识别率达到99.63%,对比单一特征掌静脉识别率提高0.40%,单一特征掌纹识别率提高5.63%。单幅近红外手掌图像的多特征融合识别率比其他算法等误率EER平均降低0.66%,单个随机样本平均识别时间小于1 s,算法适用于门禁、考勤等识别系统。因此,本文算法具有实用性。

参考文献:

[1]Shekhar S,Patel V M,Nasrabadi N M,et al.Joint sparse representation for robust multimodal biometrics recognition[J].IEEE Transactions on Pattern Analysis&Machine Intelligence,2014,36(1):113-126.

[2]Liu Z,Song S.An embedded real-time finger-vein recognition system for mobile devices[J].IEEE Transactions on Consumer Electronics,2012,58(2):522-527.

[3]Kang W,Wu Q.Contactless palm vein recognition using a mutual foreground-based local binary pattern[J].IEEE Transactions on Information Forensics&Security,2014,9(11):1974-1985.

[4]Cao K,Jain A K.Learning fingerprint reconstruction:From minutiae to image[J].IEEE Transactions on Information Forensics&Security,2015,10(1):104-117.

[5]Zhang D,Lu G.3D palmprint classification by global features[J].IEEE Transactions on Systems Man&Cybernetics Systems,2013,43(2):370-378.

[6]Kang W,Wu Q.Pose-invariant hand shape recognition based on finger geometry[J].IEEE Transactions on Systems Man&Cybernetics Systems,2014,44(11):1510-1521.

[7]Gupta P,Gupta P.Multi-modal fusion of palm-dorsa vein pattern for accurate personal authentication[J].Knowledge-Based Systems,2015,81:117-130.

[8]Haghighat M,Abdel-mottaleb M,Alhalabi W.Discriminant correlation analysis:Real-time feature level fusion for multimodal biometric recognition[J].IEEE Transactions on Information Forensics&Security,2016,11(9):1984-1996.

[9]Ding Changxing,Tao Dacheng.Robust face recognition via multimodal deep face representation[J].IEEE Transactions on Multimedia,2015,17:2049-2058.

[10]Bu W,Zhao Q,Wu X,et al.A novel contactless multimodal biometric system based on multiple hand features[C]//2011 International Conference on Hand-Based Biometrics(ICHB),2011:1-6.

[11]Yang W,Huang X,Zhou F,et al.Comparative competitive coding for personal identification by using finger vein and finger dorsal texture fusion[J].Information Sciences,2014,268(6):20-32.

[12]Wang J G,Yau W Y,Suwandy A.Feature-level fusion of palmprint and palm vein for person identification based on a“junction point”representation[C]//The 15th IEEE International Conference on Image Processing,San Diego,CA,2008:253-256.

[13]Fuksis R,Kadikis A,Greitans M.Biohashing and fusion of palmprint and palm vein biometric data[C]//International Conference on Hand-based Biometrics,2011:1-6.

[14]He K,Sun J,Tang X.Guided image filtering[J].IEEE Transactions on Pattern Analysis&Machine Intelligence,2013,35(6):1397-1409.

[15]Zhou Y,Kumar A.Human identification using palm-vein images[J].IEEE Transactions on Information Forensics&Security,2011,6(4):1259-1274.

[16]Guang D.A generalized unsharp masking algorithm[J].IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society,2011,20(5):1249-1261.

[17]王艳霞,阮秋琦.一种新的掌纹图像预处理方法[J].中国图象图形学报,2008,13(6):1115-1122.

[18]Zhang D,Guo Z,Lu G,et al.An online system of multispectral palmprint verification[J].IEEE Transactions on Instrumentation&Measurement,2010,59(2):480-490.

[19]王科俊,宋新景,王晨晖.手形和掌纹决策层融合方法研究[J].黑龙江大学工程学报,2010,1(4):122-127.

[20]Polyu.Multispectral palmprint database[EB/OL].(2015-06-24).http://www.comp.polyu.edu.hk/~biometrics/MultispectralPalmprint/MSP.htm.

[21]Goshtasby A A,Nikolov S.Image fusion:Advances in the state of the art[J].Information Fusion,2007,8(2):114-118.

[22]徐笑宇,姚鹏.基于HOG与改进的SVM的手掌静脉识别算法[J].计算机工程与应用,2016,52(11):175-180.

[23]Lee J C.A novel biometric system based on palm vein image[J].Pattern Recognition Letters,2012,33(33):1520-1528.

[24]Pan M,Kang W.Palm vein recognition based on three local invariant feature extraction algorithms[M]//Biometric Recognition.Berlin Heidelberg:Springer,2011:116-124.