浅谈大型数据中心制冷节能与控制

2018-05-05邱京昊

邱京昊

QIU Jing-hao

(中经云数据存储科技(北京)有限公司)

(Zhong Jing Cloud Data Storage Technology (Beijing) Co., Ltd.)

1 引言

随着经济形势的迅猛发展,大数据、云计算的兴起,以及“互联网+”、智慧城市、5G以及人工智能时代的到来,将进一步促发海量数据的生产、存储和运营。由于需求庞大且与日俱增,数据中心正在发展成为一个具有战略重要性的产业,成为新一代信息产业的重要组成部分。数据中心建设呈现集中化、大型化的趋势,越来越多的数据中心开始向能源集中的地方汇聚,越来越多的超大型数据中心园区不断建成,对于能源的利用是一项极大的挑战。

2 数据中心的能源消耗

关于数据中心能效,现阶段比较有影响的是绿色网格组织(Green Grid)提出的能效指标:电能利用效率PUE(Power Usage Effectiveness)。目前PUE已经成为衡量数据中心能耗的最重要的指标:PUE=所有设备的电耗/IT设备的功率。在保证数据中心稳定、安全运行的同时,如何提高能源利用率,降低PUE,已成为众多大型数据中心的目标之一。

一个典型的数据中心的能耗分布大概如下:IT设备占总能耗的52%;空调系统占38%;UPS及配电系统的损耗大概占9%;其余的电力照明系统约为1%。

对于大型数据中心而言,采用集中式水冷冷水系统进行制冷更节能、更经济、也更利于集中管理,是大型数据中心中主流的制冷方式。水冷冷水空调系统的能耗比例大约为:压缩机的能耗占到了54%,水泵占18%,冷却塔占9%,精密空调占19%。

3 数据中心制冷节能技术

3.1 水侧自然冷却技术

在我国北方地区,由于冬季和过渡季室外温度较低,可以利用室外冷源对机房进行降温。水侧自然冷却技术是通过冷却塔在冬季对冷却水进行降温后,再通过板式换热器与冷冻水进行冷量交换后,接入机房专用精密空调,进行制冷。水侧自然冷却是目前大型数据中心中最常使用的节能技术。

3.1.1 提高冷冻水供水温度

在许多大型数据中心的设计中,基本都会采用冷热通道封闭的节能措施,冷通道设计温度通常为18℃±2℃,以保证服务器的工作环境。但是在新国标:《电子信息机房设计规范》GB50174-2017中规定,冷通道或机柜进风区域的温度为18℃~27℃;在美国国家标准学会颁布的《数据中心电信基础设施标准》TIA942-2010中规定计算机房环境温度要求为18℃~27℃。服务器完全可以工作在比18℃更高的环境温度中,所以提高冷冻道的设计温度是最直接的节能手段。

为保证冷通道18℃±2℃的设计,冷冻水的供水温度需保证不高于12℃,建议将冷冻道的温度提高至23℃,这样冷冻水的供水温度可提升至16℃。提升冷冻水的供水温度,可以大幅提高冷冻机的运行效率。某品牌厂家1000RT(制冷量为3516kW)的冷冻机在冷却水温度为32℃/37℃,冷冻水出水温度为12℃的工况数据,在此状态下冷冻机的满载COP 为 6.574。 同 样 1000RT(3516kW)的冷冻机在冷却水温度为32℃/37℃,冷冻水出水温度为16℃时的工况数据,满载COP为7.754。由于冷冻水温度的提高,在同样的冷却水温度下,冷冻机的效率在满负载的状态下,运行效率可以提高17%。

以一个10000组机架,3kW/Rack功率密度的大型数据中心而言,满载情况下大约需要1000RT的冷冻机9-10台进行整个数据中心的制冷。根据某冷机厂家提供的数据,在冷冻水供水温度为12℃时,冷冻机输入功率为535kW,在冷冻水供水温度为16℃时,冷冻机的输入功率为453kW,1h即可节约电量10*(535-453)=820kW ·h。

在上文中提到,数据中心最常用的节能技术为自然冷却技术,提高冷冻水温度后,可以大幅提高自然冷却时间。有研究表明[1],在北京地区冷冻水供水温度由12℃上升到15℃,可用完全自然冷却时间增加了706h,仍然以上述数据中心为例,全年可节省电量约三百多万千瓦时的电能。

3.1.2 细化控制参数,充分利用预冷状态

以北京地区为例,除了完全自然冷却,在过渡季,部分自然冷却时间为1287小时[1],部分自然冷却需要冷机和自然冷却同时运行。首先同样的冷冻水供水温度下,冷却水温度越低,冷冻机的效率也会越高。根据上面厂家提供的数据,同样冷冻水供水温度为7℃时,冷却水进水温度由19℃降低到12.8℃时,会使冷机效率大幅提高,COP由8.12涨至9.96。但是过低的冷却水温度可能会导致冷冻机无法启动,大部分的冷冻机冷却水进水温度不能小于18℃;另外,大型离心式冷水机组,在负载过低的情况下会生喘震,无法正常运行。所以如何能在最大限度下利用自然冷源,又可以使冷冻机正常运行,就需要细化控制参数,来解决这两个突出的问题。

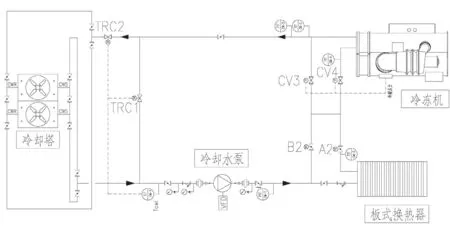

图1 冷却水系统简图

一个典型的数据中心冷冻机冷却水系统简图如图1所示,以冷冻水运行工况16℃/21℃为例。当系统进入部分自然冷却制冷模式时,冷却水侧的电动阀门CV4、A2开启,CV3、B2关闭。冷冻水侧的阀门切换后,使冷冻水全流量通过板式换热器后进入冷冻机。将板换冷冻水侧的出水温度设定为17.8℃,此参数优先通过冷却塔风机的变频控制,这样既可以保证冷冻机的负载维持在35%以上,解决了因负载过低导致停机的问题,同时也保证了一个比较低的冷却水温度,提高冷机的运行效率。

根据冷机最小冷凝器压力(由冷机自带的控制器提供该信号点),控制电动调节阀CV3、CV4的开度,调节进入冷凝器的冷却水量,保证压缩机正常工作所需的最小压差,以便使冷水机组正常运行。

3.2 就近制冷、提高送风效率

常规数据中心的机房气流组织采用架空地板下送风的设计,精密空调布置在机房的一侧或两侧(送风距离超过15m),大部分具有单独的空调间,对机房进行降温。这样的设计送风距离较远,双侧送风会超过7.5m,单侧最远会达到13m~14m。

3.2.1 列间空调

采用列间空调制冷,制冷模式由集中制冷到分布式制冷,实现针对高密度机柜的就近制冷和精确制冷。列间空调制冷改变了常规的数据中心下送、上回的形式,而是采用了水平送、回风,减小了传输距离,冷风就近送到需要的IT设备位置,从而减小风阻,降低风机功耗。

列间空调内部同样配置了变频风机和水量调节阀,可动态地跟踪服务器的功耗变化,调节制冷的输出量,提高末端空调的制冷效率,减少列间空调无效冷量及电力输入,最大限度做到精确化供冷。

3.2.2 背板冷却技术

背板冷却技术可以有效解决机房高密度以及机柜局部过热的问题[2-3],背板空调主要指的是安装在机架背面的冷却盘管,根据其使用的载冷剂不同,可以分为水冷背板与热管背板等不同类型的背板等。

采用背板冷却技术,在节能方面存在一定的优势:①背板为无风扇运行,靠服务器机柜风扇进行气流换热,无耗能部件;②更贴近IT服务器机柜,制冷效率更高;③节约空间,在同等面积的情况下,采用背板冷却,可布置更多的机柜。

3.3 风侧自然冷却

为了降低PUE,各种新技术也在不断地被应用在数据中心中。如何更多的应用自然冷源成为的主要的技术方向。风侧自然冷却技术相对于前文提到的水侧自然冷却技术,减少了能量转换和传递的环节,节能效果更佳直接和显著。雅虎公司在美国的“鸡舍”数据中心,采用了风侧自然冷却技术,开放的风墙可以使空气进入机房中,对服务器进行冷却,一年中百分之九十的时间利用室外空气冷却,全年综合PUE可以低至1.08。

3.3.1 直接风侧

水侧自然冷却系统通常需要室外湿球温度低于6℃,才能保证冷却塔的出水温度满足自然冷却的水温要求。而直接风侧自然冷却,只要室外天气参数满足机房需求的18℃~27℃,相对湿度满足30%~80%即可直接采用室外自然风对机房进行降温冷却。直接风侧自然冷却的气流组织图大致如图2所示:

图2为100%新风自然冷却运行工况的原理图,当室外温度过低时,还可以通过风阀的调节,进入混风模式,机房的热回风与新风混合后,满足机房的需求后送入机房区内;当室外温度过高或者空气质量无法满足条件时,可关闭新风阀门,开启冷冻机制冷模式,来满足机房需求。

虽然风侧自然冷却的方式会大大降低PUE,但是室外空气的质量也大大影响使用的效果与应用的可行性。在我国,虽然北方地区的气温比较适合这种方式,但空气质量无法满足数据中心的使用需求。

国际自动化学会 (ISA) 标准71.04将环境危害等级分为:G1,G2,G3及GX级,为评估环境中潜在的气体腐蚀程度提供了依据。G1级是良好而GX 级是最严重。空气中的水,还有硫离子、氯离子、氮氧离子以及氧气,都会对服务器上的金属元件产生不同程度的腐蚀,以及加速老化的作用。另外、数据中心建设在沿海地区,附近包括燃煤工厂、化工厂均会恶化数据中心附近的环境。图3是北京的空气质量对应的等级,根据多个腐蚀性测试结果表明[7],大量的新风进入机房内,会威胁IT设备的稳定运行。

在应对IT设备的腐蚀上,大致有三个措施:①使用空气过虑技术;②优化PCB板的设计;③使用防腐涂层。绝大多数的用户不会选择定制的服务器,所以使用空气过虑技术成为了大多数采用全新风自然冷却数据中心的首选技术[8],但是采用化学过滤器会大大增加数据中心的运维成本,所以解决有害气体腐蚀威胁的另一种思路,是应用间接风侧自然冷却空调系统。

3.3.2 间接风侧

间接风侧自然冷却技术是近几年宣传推广比较多的节能技术之一,间接蒸发冷却技术,是利用一侧空气和水直接接触蒸发冷却产生的冷量对另一侧空气进行等湿降温。经过间接蒸发冷却后,空气的温度降低, 但湿度保持不变,送风温度可以更低[9],并且避免了大量新风进入机房,减少了服务器的腐蚀问题。

间接蒸发冷却技术与传统的数据中心相比较,在PUE和水耗量(WUE)上都有比较大的优势,只不过设备体积庞大,受到场地限制,目前没有大规模的应用。

图2 直接风侧冷却原理图

图3 北京的空气质量等级

4 结束语

随着电子产业的发展,IT设备对运行环境的适应性越来越强,高温服务器的应用将推动数据中心冷却系统更加节能。目前经过定制的高温服务器已经能在35℃进风条件下持续稳定运行,这意味着广大的北方地区大部分时间无需机械制冷。随着高温服务器的进一步发展,进风温度40℃条件下稳定运行的服务器也许不久将成为现实,届时,数据中心制冷系统将实现全年100%自然冷却。

[1]张素丽. 数据中心冷水系统自然冷却节能分析[J].暖通空调,2016,46(5):80-83.

[2]刘书浩 张海涛 黄良赵等. 数据中心热管背板空调应用实测研究——机房空气流场分析[J].制冷与空调,2015,15(2):51-56

[3]刘书浩 张海涛 郭佳哲等. 数据中心热管背板空调应用实测研究——系统不平衡运行分析[J].制冷与空调,2015,15(3):22-25