融合颜色特征和灰度特征的时空上下文跟踪

2018-04-18陈金广贺莉娜王明明马丽丽

陈金广,贺莉娜,王明明,马丽丽

(西安工程大学 计算机科学学院,陕西 西安 710048)

0 引 言

针对视觉跟踪[1]已有许多很好的研究成果,如Struck[2]、CT[3]、CSK[4]、ALSA[5]等,但视频目标本身固有的问题,如目标的外观变化、背景变化、光照变化、姿态变化、平面内外旋转、运动模糊等,导致视频目标跟踪依然面临很大的挑战。

人们结合相关滤波技术[6,7]以及上下文信息[8,9],在视频目标识别、检测、跟踪等方面取得了显著效果。尤其,Zhang等提出了基于贝叶斯滤波的时空上下文(spatio-temporal context,STC)算法[10],使用时空上下文信息并利用快速傅里叶变换(FFT),大大提高了算法的运行速度。然而由于仅选取单一灰度特征,抛弃了更具辨识度的颜色纹理等特征,算法的跟踪精度不高,且无法处理面内外旋转跟踪难题。为了提高算法精度,Xu等[11]对疑似目标及其周围区域进行分块划分,利用LK光流法计算区域的重要性,将其作为权值进行加权,Wang等[12]引入HOG特征替代灰度特征,Zhao等[13]引入卡尔曼滤波,以处理遮挡情况下的跟踪问题。以上算法在一定程度上提高了跟踪精度,但时间复杂度相应增加。

在目标识别、检测等研究中,使用颜色特征可以取得良好效果[14,15],而且颜色特征对姿态变化、尺度变化具有不敏感特性,能够处理由面内外旋转带来的目标外观变化问题。相比于RGB、HSV[16]、LAB[17]等3维颜色空间表示,Color Name特征将RGB映射到11维颜色空间中,能够更为详尽地描述目标外观,并且已通过对比实验验证其有效性。由于该方法增大了特征维数,因此时间复杂度较大。对此,文献[18]提出一种自适应降维的方法,将11维特征降至2维,在最大程度保留有效信息的基础上降低特征维数,从而提高算法的实时性。考虑到该特征的有效性,本文结合时空上下文跟踪算法,将自适应降维后的2维颜色特征和灰度特征进行融合,用融合后的特征替换原灰度特征来处理面内外旋转跟踪难题。实验结果表明,在保留原STC算法对部分遮挡、光照变化、较小的姿态变化等情况下跟踪可靠性的基础上,本文提出的算法能够提升跟踪精度,并有效处理面内外旋转情况下的跟踪问题。

1 时空上下文算法

时空上下文算法基于贝叶斯框架,建立感兴趣的目标与周围背景的时空关系,在低阶特征上对目标及其局部上下文进行统计关系建模,通过计算置信图,找到似然概率最大的位置,即为估计得到的新一帧的目标位置。时空上下文算法描述如下:

跟踪问题可以描述为一个计算并寻找目标位置x最大似然的过程

c(x)=P(x|o)=∑c(z)∈XCP(x,c(z)|o)=

∑c(z)∈XCP(x|c(z),o)P(c(z)|o)

(1)

式中:XC={c(z)=((I(z),z)|z∈Ωc(x))}是上下文特征集,I(z)是图像中z处的灰度值,Ωc(x)是目标位置x处的上下文邻域,o是指跟踪目标存在于场景内。由式(1)知,似然函数P(x|o)可以分解为一个条件概率P(x|c(z),o)和一个上下文先验概率P(c(z)|o)。

置信图(confidence map)函数具体是指在给定目标位置x*的基础上计算上下文区域任何一点x的似然,定义为

P(x|o)=bexp(-|(x-x*)α-1|β)

(2)

式中:b是归一化常数,α是尺度参数,β是形状参数。实验中,常取经验值:α=2.25,β=0.5。

条件概率是建模目标与周围上下文区域空间关系的函数,为

P(x|c(z),o)=hsc(x-z)

(3)

式中:hsc(x-z)是关于相对距离与方向的函数,具有径向非对称性,即hsc(x-z)≠hsc(|x-z|),能够有效减少二义性的产生,从而避免误跟踪。

上下文先验概率是建模局部上下文各个点x的上下文先验概率的函数,为

P(c(z)|o)=I(z)ωσ(z-x)

(4)

式中:I(z)是位置z处的灰度值,代表目标周围局部上下文的外观。ωσ(z-x)=aexp(-(|z-x|)2/σ2)是加权函数,利用的是生物视觉系统中注意力集中理论,a为归一化常数,σ为尺度参数。

将式(2)~式(4)代入式(1)可得

∑z∈Ωc(x*)hsc(x-z)I(z)ωσ(z-x*)=

hsc(x)⊗(I(x)ωσ(x-x*))

(5)

考虑到时域中卷积计算复杂度高,利用快速傅里叶变换将计算过程转换至频域

(6)

进行傅里叶逆变换后可求得空间上下文模型为

(7)

(8)

更新上下文先验概率模型中权重函数ωσ(·)的尺度参数σ

(9)

(10)

其中,置信图中c(x)值最大的位置,就是估计到的目标位置

(11)

2 融合颜色特征和灰度特征的时空上下文跟踪

2.1 Color Name 特征

与其它的视觉特征相比,颜色特征对图像本身的尺寸、方向、视角的依赖性较小,具有对姿态变化、尺度变化、方向变化不敏感的特性,从而具有较高的鲁棒性,因此能够处理由面内外旋转带来的目标外观变化问题。与RGB、HSV、LAB、HUE等颜色空间表示一样,Color Name特征也是颜色属性特征的一种表示方法。该方法将颜色做了11种基本的颜色分类,其实是把RGB红绿蓝3种颜色细化成了11种基本色,分别是黑、蓝、棕、灰、绿、橙、粉、紫、红、白和黄。相较于上述传统简单的仅对颜色特征进行3维空间转换表示或转换成直方图进行跟踪,11种基本色表示能够更为准确地描述目标的颜色外观。

Color Name特征的提取过程如下:首先使用颜色映射将彩色图像的RGB值映射到11维的颜色概率表示,然后进行归一化操作,将其投影到10维子空间的标准正交基上,降到10维的颜色表示即可得到初步的10维颜色特征。考虑到10个维度会造成时间复杂度的增加,Danelljan等提出了一种自适应降维方法,将10维的颜色表示降到2维,能够在减少颜色表示维度的基础上保留特征的有效信息,从而在保证算法跟踪精度的基础上提高了算法的运行效率。

(12)

2.2 融合颜色特征和灰度特征的时空上下文跟踪

由于原STC算法的上下文先验模型中仅使用单一灰度特征对目标外观的描述能力有限,导致跟踪精度低,故本文在原STC算法的上下文先验模型P(c(z)|o)的基础上,依据上述方法提取颜色特征并经过自适应降维降至2维,将目标局部上下文区域中经自适应降维后的颜色特征X(z)与灰度特征I(z)进行融合,得到改进后的上下文先验概率,即

P(c(z)|o) =X(z)I(z)ωσ(z-x)

(13)

则置信图函数可表示为

hsc(x-z)X(z)I(z)ωσ(z-x*)=hsc(x)⊗

(X(x)I(x)ωσ(x-x*))

(14)

同样,利用傅里叶变换将其转换至频域,以加快算法运行速度

F(hsc(x))⊙F(X(x)I(x)ωσ(x-x*))

(15)

此时,空间上下文模型可表示为

(16)

然后由式(8)更新时空上下文模型,在新的一帧计算目标的置信图

ct+1(x)=F-1(F(hsc(x))⊙

F(X(x)I(x)ωσ(x-x*)))

(17)

置信图中值最大的位置就是跟踪到的目标位置。

2.3 算法跟踪流程

首帧目标位置x*由手动初始化或通过一些目标检测算法进行初始化。

Repeat

由第t帧图像和得到的目标位置x*,提取Color Name特征X(z)与灰度特征I(z);

由式(13)计算上下文先验概率P(c(z)|o);

由式(16)学习空间上下文模型hsc(x);

由式(9)更新尺度参数σt+1;

由式(17)计算置信图ct+1(x),寻找ct+1(x)最大值,这个最大值的位置就是第t+1帧目标的估计位置;

输出当前帧的目标位置xt+1。

Until 处理完视频序列中所有帧。

3 实验结果与分析

选取Bolt、Bolt2、MotorRolling、David、David3这5组视频作为测试序列,涵盖了遮挡、形变、快速运动、面内外旋转、运动模糊、光照变化、背景复杂等属性。分别使用中心位置误差(center location error)、中心距离精度(distance precision)、重叠精度(overlap precision)3个评价标准对算法性能进行定量评价,其中:中心位置误差指的是算法估计的目标中心位置与目标的实际中心位置的平均欧氏距离;中心距离精度指的是视频序列中中心位置误差小于一定阈值的帧数占总帧数的比重;重叠精度指的是算法估计的目标边框与目标的实际边框的平均重叠度。本文算法中,将学习率设为0.1,压缩率设置为0.1,其余参数与文献[10]和文献[18]一致。

3.1 实验1

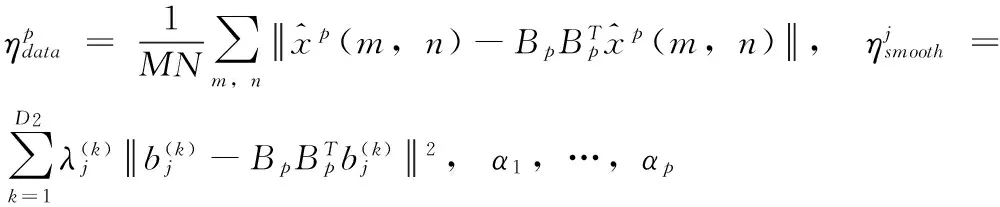

采用CVPR2013 benchmark的视频库[19]中的Bolt视频序列,选取Bolt的中220帧作为测试视频,视频分辨率为640×360。实验结果如图1所示。视频中多名运动员参加100 m短跑比赛,从起点一起向终点奔跑,跟踪的目标是运动员博尔特,比赛期间参赛小组队员相互有短暂的遮挡,背景较为杂乱,并且由于快速移动及姿势变化,使得视频中存在外观变形较大、面内旋转、运动模糊等情况。目标初始化时,选取CVPR2013 benchmark提供的ground truth值作为目标起始跟踪位置。

猪为六畜之首,粮猪安天下。我国是一个养猪大国,养猪业历史悠久,改革开放以来生猪产业发展对增加农民收入,满足城乡居民畜产品需求方面做出了巨大贡献,是农村经济的重要支柱产业和农民增收的重要途径,在畜牧业乃至整个农业生产中占据重要位置。

图1 实验1跟踪结果

在Bolt视频序列中,如图1(a)所示STC算法刚开始能很好地跟踪目标,但在#21帧时已经偏离目标的真实位置,并渐渐丢失目标,原因是仅使用灰度特征对目标外观的描述能力有限,对外观变形剧烈和面内外旋转等情况下的跟踪处理效果不佳,从而导致目标跟踪失败。本文算法和CN算法均能很好地跟踪目标,并且跟踪精度很高,其中距离精度分别达到97.7%和100%,这是因为两种算法均使用了Color Name特征,该特征具有旋转不变性。此外,本文算法采用Color Name特征联合灰度特征应用于STC算法框架,相较于CN算法,提升了约3 fps的跟踪速度。

3.2 实验2

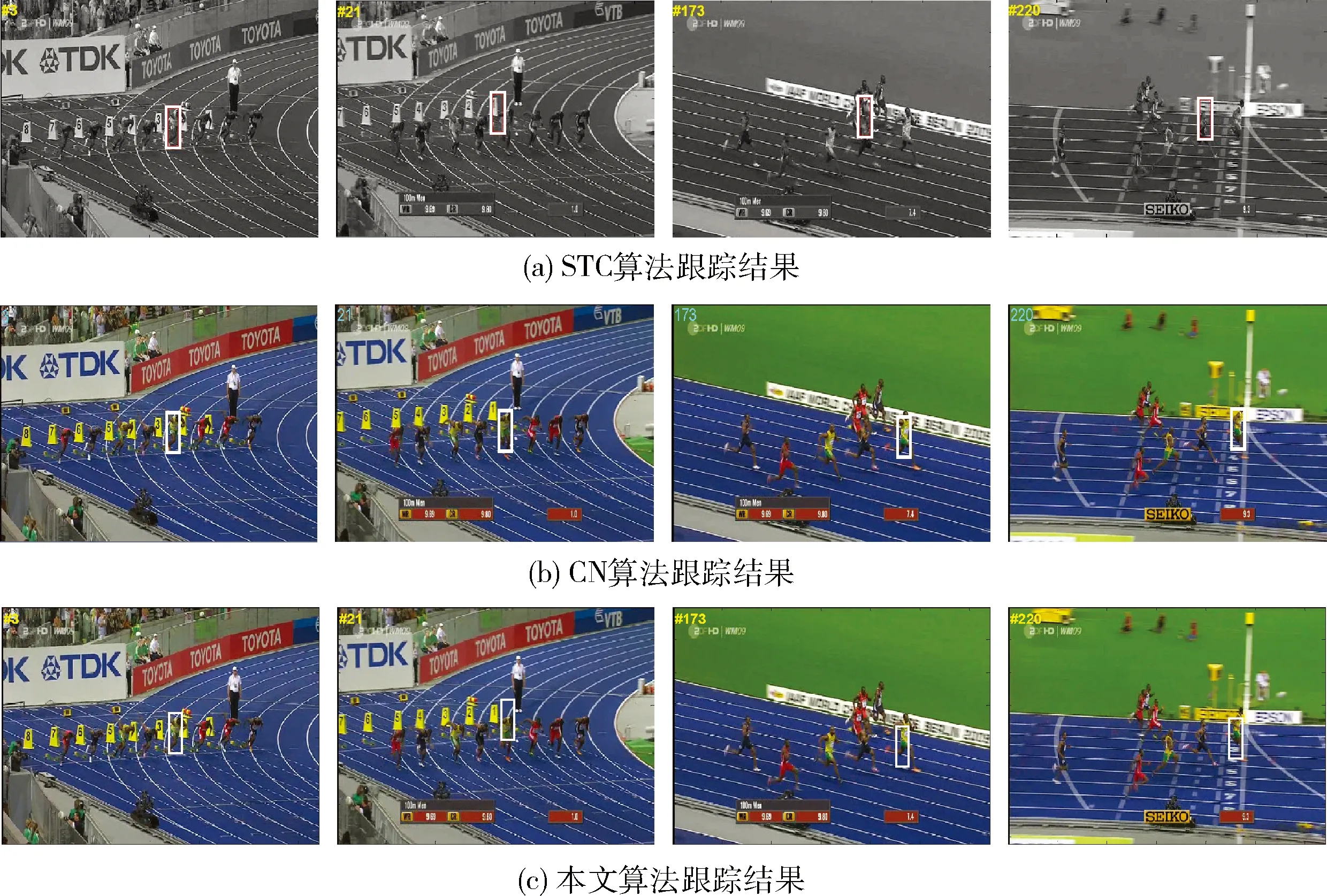

采用CVPR2013 benchmark的视频库中的Bolt2视频序列,选取Bolt2中的293帧作为测试视频,视频分辨率为480×270。实验结果如图2所示。视频中多名运动员参加100 m短跑比赛,一起向前奔跑,跟踪的目标均是运动员博尔特,视频序列Bolt2除了存在Bolt序列含有的跟踪挑战之外还存在图像分辨率较低、尺度变化等跟踪困难。目标初始化时,选取CVPR2013 benchmark提供的ground truth值作为目标起始跟踪位置。

图2 实验2跟踪结果

从图2(b)可以看到CN算法在#10帧时已经完全丢失目标,跟踪失败。图2中(a)和(c)跟踪结果显示,STC算法和本文算法均能持续跟踪目标,但STC算法在#191帧之后一直存在一定程度的偏移,而本文算法不存在,距离精度和重叠精度分别提升到了99.6%和85.9%,故本文算法在跟踪精度方面是优于STC算法的,CN算法的核函数在图像分辨率较低情况下跟踪效果不理想。因此Color Name 特征与灰度特征融合后联合时空上下文关系在图片分辨率较低情况下可以提升跟踪准确度。

3.3 实验3

采用CVPR2013 benchmark的视频库中的MotorRolling视频序列,选取MotorRolling中的69帧作为测试视频,视频分辨率为640×360。实验结果如图3所示。视频中一名骑手控制摩托车在U型场地上做翻转动作,跟踪的目标是摩托车,摩托车在跟踪过程中存在光照变化、面内外旋转、运动模糊且方向和速度变化突兀等挑战。目标初始化时,选取CVPR2013 benchmark提供的ground truth值作为目标起始跟踪位置。

图3 实验3跟踪结果

起初在目标运动变化不大时,3种算法均能有效跟踪目标位置。当目标摩托车开始旋转时,目标不仅在外观上发生旋转,而且同时伴有强光照射,光照也发生了剧烈变化,此时CN跟踪算法最先偏离目标的真实位置,在#11帧时已经出现了偏移,到#32帧时已经彻底丢失目标,随后跟踪窗口也丢失,而STC算法在#11帧时仍能跟踪目标,但所跟踪到的位置与真实的中心距离稍有偏差,#32帧后偏差增大,不久渐渐偏离目标并最终丢失跟踪目标,只有本文算法能够持续跟踪目标,并将平均中心距离误差缩减到了19.3 pixel,跟踪距离精度和重叠精度从原先的26%和27.5%分别提升到了50%和49.5%。原因是STC算法使用灰度特征对目标外观描述能力有限,从而在面对光照变化、外观变形剧烈和面内外旋转、运动模糊且方向和速度突兀等情况时跟踪处理效果不佳,从而导致目标跟踪失败,CN算法提取了Color Name 特征,对外观进行了描述,其特征本身具有旋转不变性特点,但忽略了时空上下文之间的紧密联系,因此不能够进行持续跟踪。本文算法采用了Color Name特征描述目标外观信息,联合时空上下文关系表示情景信息,融合两种特征信息加强了特征对外观的描述力度,在发生光照变化、外观变形剧烈和面内外旋转、运动模糊且方向和速度变化突兀等情况时仍能较好地描述目标特征。

3.4 实验4

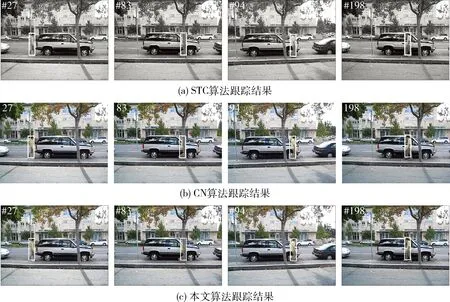

采用CVPR2013 benchmark的视频库中的David3视频序列,选取David3中的252帧作为测试视频,视频分辨率为480×640。实验结果如图4所示。视频中David沿街道直行一段距离之后原路返回,跟踪的目标是行人David,目标在跟踪过程中存在部分及全部遮挡、面内旋转、面外旋转、背景杂乱等挑战。目标初始化时,选取CVPR2013 benchmark提供的ground truth值作为目标起始跟踪位置。

在#27帧和#83帧时,目标存在部分遮挡和全部遮挡情况,在遮挡发生后时3种算法均能对目标进行准确地跟踪,差异性不大。目标返程时,外观发生了较大变化,STC算法和CN算法也都能够准确跟踪到目标,中心距离误差为10 pixel左右,距离精度和重叠精度都很理想,其中本文算法的中心距离误差最小,为7个像素,距离精度和重叠精度分别提升到了92.5%和88.5%。因此,本文算法应用特征融合能够改善跟踪效果,更为有效地处理目标外观变化和遮挡问题。

图4 实验4跟踪结果

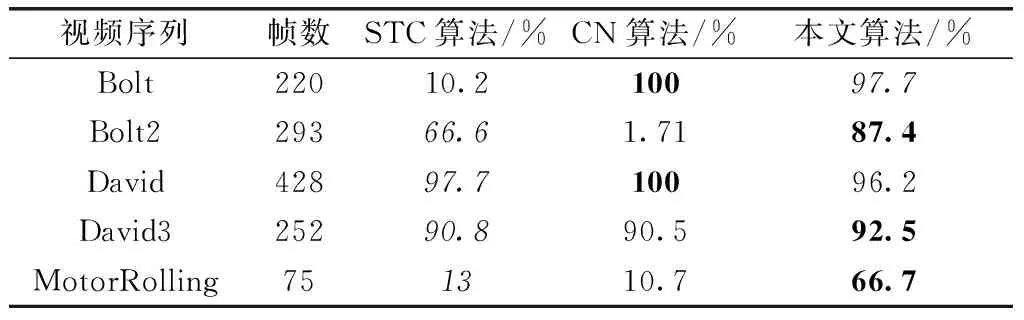

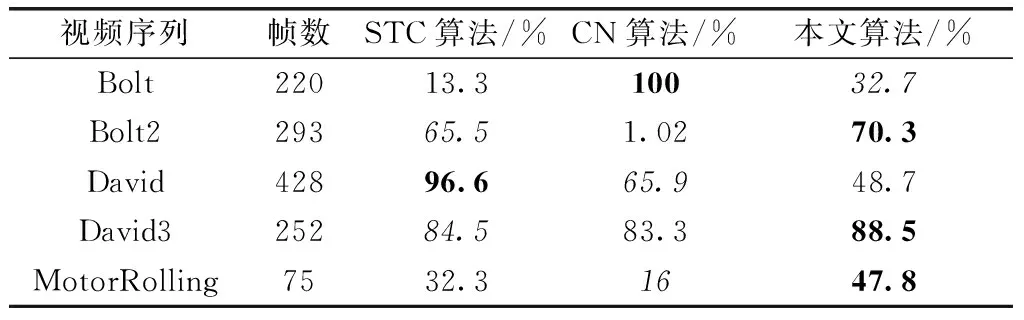

3.5 结果评估

表1~表3分别提供了本次实验所用的5组视频序列在3种算法下的中心距离误差、中心距离精度和重叠精度的数据对比,其中黑体表示最优,斜体表示次优。易知,本文算法能够有效处理光照变化、外观剧烈变化、面内外旋转、部分遮挡及全部遮挡和背景杂乱等情况下的跟踪问题,从而提升了跟踪准确率和成功率。但是本文算法相较于STC算法增加了特征处理过程,故在总体运行速度上较STC算法略慢,但仍满足实时性要求。

表1 各算法中心位置误差对比

表2 各算法中心距离精度对比

表3 各算法重叠精度对比

4 结束语

参考文献:

[1]YIN Hongpeng,CHEN Bo,CHAI Yi,et al.Vision-based object detection and tracking:A review[J].Acta Automatic Sinica,2016,10(42):1466-1481(in Chinese).[尹宏鹏,陈波,柴毅,等.基于视觉的目标检测与跟踪综述[J].自动化学报,2016,10(42):1466-1481.]

[2]Sam Hare,Stuart Golodetz,Amir Saffari,et al.Struck:Structured output tracking with kernels[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2016,38(10):2096-2109.

[3]Zhang K,Zhang L,Yang MH.Real-time compressive trac-king[C]//Proc of European Conference on Computer Vision(ECCV).Italy:Springer,2012:864-877.

[4]Rui C,Martins P,Batista J.Exploiting the circulant structure of tracking-by-detection with kernels[C]//European Confe-rence on Computer Vision.Berlin,Heidelberg:Springer,2012:702-715.

[5]Lu H,Jia X,Yang MH.Visual tracking via adaptive structural local sparse appearance model[C]//IEEE Conference on Computer Vision & Pattern Recognition,2012:1822-1829.

[6]Henriques JF,Caseiro R,Martins P,et al.High-speed tracking with kernelized correlation filters[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3):583-596.

[7]Liu Chang,Fen Dapeng,Wu Hefeng,et al.Multi-Cue Adaptive correlation filters for visual tracking[C]//International Conference on Digital Home,2016:89-94.

[8]Zhang Tianzhu,Bernard Ghanem,Liu Si,et al.Robust visual tracking via exclusive context modeling[J].IEEE Transactions on Cybernetics,2016,46(1):51-63.

[9]Zhou Ce,Guo Qing,Wan Liang,et al.Selective object and context tracking[C]//IEEE International Conference on Acoustics,Speech and Signal Processing(ICASSP),2017:1947-1951.

[10]Zhang K,Zhang L,Liu Q,et al.Fast visual tracking via dense spatio-temporal context learning[C]//Proc of European Conference on Computer Vision(ECCV).Czech Republic:Springer,2014:127-141.

[11]Xu Jianqiang,Yao Lu,Liu Jinwu.Robust tracking via weighted spatio-temporal context learning[C]//Proc of International Conference on Image Processing(ICIP).Paris,France:IEEE,2014:413-416.

[12]Wang Zhenhai,Xu Bo.An effective object tracking based on spatio-temporal context learning and Hog[C]//Proc of International Conference on Natural Computation(ICNC).CA,USA:IEEE,2015:661-664.

[13]ZHAO Zhou,HUANG Panfeng,CHEN Lu.A tracking algorithm of improved spatio-temporal context with Kalman filter[J].Acta Aeronautica ET Astronautica Sinica,2017,38(2):320306-320316(in Chinese).[赵洲,黄攀峰,陈路.一种融合卡尔曼滤波的改进时空上下文跟踪算法[J].航空学报,2017,38(2):320306-320316.]

[14]Keiji Kamei,Kazu Narumi,Daisuke Shuto.Adaptive color tracking for particle filter to control a drone in a forest[C]//Proc of Joint 8th International Conference on Soft Computing and Intelligent Systems(ICSC).Sapporo,Japan:IEEE,2016:512-517.

[15]Suryo Adhi Wibowo,Hansoo Lee,Eun Kyeong Kim.Multi-scale color features based on correlation filter for visual tracking[C]//Proc of International Conference on Signals and Systems(ICSigSys).Sanur,Indonesia:IEEE,2017:272-277.

[16]Xiao Chi,Chen Wenjie,Gao Huilin.Object tracking algorithm based on HSV color histogram and block-sparse representation[C]//Proc of Chinese Control Conference(CCC).Hangzhou,China:IEEE,2015:3826-3831.

[17]Prachi R Narkhede,Aniket V Gokhale.Color particle filter based object tracking using frame segmentation in CIELab* and HSV color spaces[C]//Proc of International Conference on Communications and Signal Processing(ICCSP).India:IEEE,2015:804-808.

[18]Danelljan M,Khan FS,Felsberg M,et al.Adaptive color attributes for real-time visual tracking[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition(CVPR).USA:IEEE,2014:1090-1097.

[19]Wu Y,Lim J,Yang M.Online object tracking:A benchmark[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition(CVPR).USA:IEEE,2014:2411-2418.