一种基于速度预测的双目视觉跟踪混合算法

2018-04-17曾梓浩朱凌寒

李 鑫,曾梓浩,朱凌寒

(合肥工业大学电气与自动化工程学院,安徽 合肥 230009)

0 引言

视觉跟踪技术是指对图像序列或视频流中的目标进行检测、提取、识别和跟踪的方法。其作为计算机视觉技术的一个重要发展方向,广泛应用于视频监控、人机交互、行星探测、工业生产等领域[1]。

根据目标表征方法的不同,视觉跟踪技术可分为生成式方法和判别式方法两类。生成式方法是将跟踪视为一个目标匹配的过程,在跟踪初始阶段生成一个目标的模板,并在后续图像中寻找匹配程度最高或重构误差最小(即后验概率最大)的预测目标位置。应用较广的算法有高斯混合模型、卡尔曼滤波、粒子滤波和Mean-Shift等。判别式方法通过提取目标具有判别性的特征,采用机器学习中分类的方法找出与目标最为相似的区域。常见的方法有Struck、TLD和TCNN等[2]。由于判别式方法能够显著区分背景和前景的信息,随着近几年深度学习的快速发展,目前其研究在目标跟踪领域占据主流地位。由于生成式方法在低计算资源的情况下有更好的实时性,其在工业应用领域应用更为广泛[3]。

本文综合考量多种生成式跟踪方法和判别式跟踪方法,结合双目视觉系统能够实现目标空间定位的特点,提出了一种基于速度预测的新型混合式跟踪算法。该方法首先采用帧间差分法判断视野中是否出现运动目标。发现运动目标后,采用双目视觉系统预估运动目标在下一帧图像中出现的位置,并对预估位置进行ORB特征点匹配。若匹配度低,采用对极约束或Mean-Shift算法对预估位置作出修正,并根据修正后的位置更新跟踪目标的运动速度,用于下一帧的图像预测。相较于传统的Mean-Shift跟踪算法,该方法具有较好的跟踪效果,实时性较高,可以用于实际的工业生产。

1 双目视觉定位原理及极线约束

双目视觉系统一般由两个硬件参数相同的相机构成,其成像原理如图1所示。相机模仿人眼结构左右放置。假设左右相机中心分别为O1、O2,空间点P在左平面I1的投影点为P1,在右平面I2的投影点为P2。根据几何关系可知,线段O1P1和线段O2P2在P方向延长线必然交于P点。此时,O1、O2、P三点构成一个平面,称为极平面;线段O1O2与像平面交点e1、e2称为极点,O1O2称为基线;极平面与两个像平面I1、I2的交线l1、l2称为极线[4]。

图1 双目成像原理图Fig.1 Binocular imaging principle

假设P点坐标为(X,Y,Z)、P1点坐标为(u1,v1)、P2点坐标为(u2,v2),这三点满足如下关系[5]:

(1)

(2)

式中:M1、M2为投影矩阵,其参数可由相机标定得到。根据物体在左右平面的的投影坐标,可以算出其在空间的位置。

根据图1可知,物体在左右平面的投影遵循极线约束,即同一空间点P在左右平面的投影点必定在l1、l2两条极线上。根据极线约束,可以依据左图像I1(或右图像I2)的投影点,迅速找到右图像I2(或左图像I1)的投影点[6]。

2 混合跟踪算法

混合跟踪算法首先使用帧间差分法判断视野中是否存在运动物体:若发现视野中存在运动物体,则将该物体作为跟踪目标,使用特征提取算法将物体从背景中提取出来,生成ORB特征描述模板和Mean-Shift跟踪模板。然后,依据双目图像信息获取目标运动速度,预测其在下一帧图像中可能出现的位置,并对预测位置处图像与模板进行ORB特征点匹配。若匹配度满足要求,即不更新预测速度;否则,对预测位置进行修正,并更新预测速度。修正方法根据左右图像匹配度差异程度,采用极线约束或Mean-Shift搜索。混合算法循环往复,直至目标运动出摄像机视野,停止跟踪,删除跟踪目标信息。

为应对跟踪过程中可能出现的遮挡情况,即在混合算法进行位置修正后,若匹配度仍然不满足要求,则混合算法会保留跟踪目标的信息,回到帧间差分等待,直至运动目标再次出现。

具体算法流程如下。

①读入视频流,提取第一帧图像作为背景图像予以存储。

②使用帧间差分法判断视野内是否存在运动物体。如存在则转到步骤③,如不存在则停留在步骤②继续侦测。

③将侦测到的运动物体图像与背景图像作比较,提取出运动物体。

④生成运动物体的ORB特征描述模板和Mean-Shift跟踪模板。

⑤通过双目视觉定位原理获取运动目标的初始速度。

⑥预测运动目标在下一帧图像出现的位置。若预测位置在左右图像视野范围内,则对该位置进行ORB特征提取,并与模板进行匹配;若预测位置超出左右图像视野范围,则删除模板,停止此次跟踪。

⑦若左右图像匹配度均高于80%,则表示预测正确,直接跳转到步骤⑥,继续对下一帧图像进行相同处理。若左右图像的其中之一匹配度高于80%,另一边低于80%,则采用双目视觉极线约束,对匹配度低的预测位进行速度修正。若修正后匹配度仍低于80%,则表明该侧视野中物体受到遮挡,不显示该侧跟踪结果。若两边图像匹配度均低于80%,则采用Mean-Shift在附近区域进行搜索。在预设迭代搜索次数内若找到目标,则根据搜索结果修正预测位置,同时进行速度修正;若没有找到,则表明物体被遮挡,跳转到帧间差分法进行等待。

⑧速度修正按照新预测速度占61.8%、旧预测速度占38.2%进行加权求和得到。完成修正后,算法跳回步骤⑥继续进行跟踪。

2.1 帧间差分法

帧间差分法是将相邻连续两帧或者三帧图像进行差分来获得运动目标轮廓,以判别是否存在运动物体的算法。差分公式如下[7]:

Pk(x,y)=fk(x,y)-fk-1(x,y)

(3)

(4)

式中:Pk(x,y)为帧间差分图像;Rk(x,y)为二值图像;Dk(x,y)为帧间差分图像Pk(x,y)的灰度值;T为分割阈值。

根据式(4)可知,若帧间差分图像中,某点的像素值小于阈值T,则认为该点是静止的。该点被判为背景点。若大于阈值T,则认为该点是运动的。该点被判为目标点[8]。

另外,为保证运动目标ORB特征提取的完整性,将帧间差分的视野从摄像机视野的1 280×720像素缩小为1 240×580像素。帧间差分视野如图2所示。

图2 帧间差分视野示意图Fig.2 Schematic diagram of inter-frame differential view

2.2 ORB特征

ORB特征由特征点和描述子两部分组成[9-11]。其具体生成步骤分为FAST角点提取和BRIEF描述子生成。

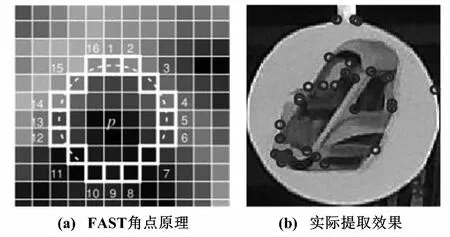

①FAST角点提取。

FAST特征定义为:若某像素点与其周围邻域内足够多的像素点处于不同的区域,则该像素点可能是角点。

常用的提取方法是:任取一像素点P(灰度值为IP),以其为中心形成一个半径为3的圆形区域,取圆周上16个像素点。如果存在n个像素点的灰度值都大于(Ip+T)或者小于(Ip-T),则认定该点为特征点(n取值可为9、11、12)。FAST角点检测原理及实际提取效果如图3所示。

图3 FAST角点检测原理及实际提取效果示意图Fig.3 Schematic diagram of FAST corner detection principle and actual extraction effect

由于传统FAST角点不具备方向性和尺度,所以在提取ORB特征时,需先构建图像金字塔,并在图像金字塔进行FAST角点检测。对提取角点使用灰度质心法,可保证特征的方向性。

②BRIEF描述子。

BRIEF描述子是一种二进制码形式的描述子。提取描述子的过程为:在图像某点的邻域内随机选取n个点对,并对每个点对作二值τ测试[11]。

(5)

式中:P(x)为x点的灰度值。

将BRIEF描述子定义为由N个τ测试组成的向量,如式(6)所示。其中,n一般取256,构成256 bit的二值特征描述子。

(6)

由于BRIEF描述子是二进制描述子,其特征匹配常用汉明距离作为度量,即两个二进制串不同位数的个数。

2.3 Mean-Shift算法

Mean-Shift是基于核密度估计的非参数特征空间分析方法,它通过自适应步长的迭代寻找概率密度分布的局部极值点[12-14]。若在维特征空间中有n个样本,则可以得到空间中任意位置的核概率密度估计[12]。

(7)

若采用H=h2I的形式,以及径向对称核K(x)=ck,dk(‖x‖2),则对应的Mean-Shift向量为:

(8)

式中:g(x)=-k′(x);m(x)总是指向概率密度增大最快的方向,通过若干次迭代可以收敛至概率密度的局部极值点,以实现目标跟踪搜索。

3 试验验证

由于现有的公开视频跟踪资源均为单目摄像机所拍摄,所以此次试验采用自摄影像作为跟踪测试样例,从定性和定量两方面[15]对算法性能进行考核。视频拍摄双目摄像机部分参数如下:像元尺寸为30 μm×30 μm;分辨率为1 280×720;帧率为30 fps;镜头中心距为62 mm。

①定性分析。

首先进行无遮挡跟踪试验。采用自摄视频1进行跟踪,视频背景为较复杂的寝室环境,四周光照不均匀,跟踪目标在第150帧进入跟踪视野。分别采用传统的Mean-Shift算法和混合跟踪算法进行跟踪比对。图4展示了Mean-Shift算法在第155帧、第202帧、第247帧和第257帧的跟踪情况(由于Mean-Shift算法运算不需要双目视觉信息,所以仅针对左侧图像进行跟踪)。

图4 Mean-Shift算法跟踪示意图Fig.4 Schematic diagram of Mean-Shift algorithm tracking

图5为对应帧下混合跟踪算法的跟踪情况。从图5所示结果可知,在无遮挡情况下,混合跟踪算法同Mean-Shift算法一样,能够很好地跟踪运动物体,保证跟踪框始终围绕跟踪目标。

图5 混合算法跟踪示意图Fig.5 Schematic diagram of hybrid algorithm tracking

下一步验证算法在有遮挡情况下的跟踪性能。采用自摄视频2进行试验。该视频跟踪目标在第51帧时进入视野,在第98帧时开始被遮挡,直至第147帧重新回到视野。跟踪结果显示:在物体被遮挡的情况下,由于物体预测位置没有超出视野范围,所以算法暂时保留ORB特征描述模板和Mean-Shift跟踪模板,并进入帧间差分法等待,此时在画面中不会框出目标位置;直至匹配暂存ORB模板的运动物体重新出现,算法恢复跟踪。

②定量分析。

为了进一步从数据上衡量混合跟踪算法的跟踪性能,在定性分析试验的基础上,对比统计混合跟踪算法和Mean-Shift算法成功跟踪的视频帧数,结果如表1所示。

表1 跟踪算法成功跟踪视频帧数Tab.1 The number of video frames that tracking algorithm successfully tracks 帧

在没有遮挡的情况下,Mean-Shift算法和混合算法都能够成功跟踪视频中的运动物体;在有遮挡的情况下,Mean-Shift算法只能跟踪至物体被完全遮挡前的第104帧,而混合算法则能成功跟踪视频294帧图像,具有较好的鲁棒性。

此外,本文还标出了自摄视频2跟踪目标的真实位置(被遮挡前第1帧到第104帧,重新回到视野第147帧到第300帧),并与两种跟踪算法进行对比。相对误差对比如图6所示。跟踪误差的评价准则基于跟踪结果中心和真实位置中心之间的相对位置误差(单位:像素)。理想情况下,位置误差应该为0。

图6 相对误差对比图Fig.6 Comparison of relative errors

如图6(a)所示,在遮挡前混合算法误差基本优于Mean-Shfit,但由于其跟踪依据为速度预测位置的ORB特征匹配,所以在跟踪物体大部分被遮挡的情况下就停止跟踪,不能同Mean-Shift一样跟踪到基本完全遮挡的第104帧。而如图6(b)所示,混合算法在被遮挡后重新跟踪的误差远小于Mean-Shift算法。

4 结束语

本文结合双目视觉空间定位特点,提出一种新的混合型跟踪算法。该算法融合了帧间差分法、双目视觉极线约束、ORB特征匹配和Mean-Shift算法。通过定性和定量两组试验,验证了混合算法拥有良好的跟踪效果,即使物体被遮挡后重新出现,仍能进行准确的跟踪,具有较好的鲁棒性。其跟踪相对误差小于传统Mean-Shift跟踪算法,具有较好的精确性。同时,混合跟踪算法是基于生成式算法的改进算法,所以具有较好的实时性,可以应用于实际的工业生产。

当然,混合跟踪算法由于综合了多种算法,在仅使用CPU运算情况下处理时间较长,对于速度大于5 m/s的运动物体难以实现实时跟踪。因此,如何实现较低硬件条件下高速物体的实时运动跟踪将是今后的研究重点。

参考文献:

[1] 尹宏鹏,陈波,柴毅,等.基于视觉的目标检测与跟踪综述[J].自动化学报,2016,42(10):1466-1489.

[2] 贾静平,覃亦华.基于深度学习的视觉跟踪算法研究综述[J].计算机科学,2017,44(s1):19-23.

[3] 杨戈,刘宏.视觉跟踪算法综述[J].智能系统学报,2010,5(2):95-105.

[4] 胡影峰.基于SIFT特征匹配算子的三维重建方法研究[J].自动化仪表,2011,32(1):30-32.

[5] 黄椰,黄靖,肖长诗,等.基于双目立体视觉的船舶轨迹跟踪算法研究[J].计算机科学,2017,44(1):308-313.

[6] 任继昌,杨晓东.极线约束条件下的双目视觉点匹配策略研究[J].舰船科学技术,2016,38(3):121-124.

[7] 孙挺,齐迎春,耿国华.基于帧间差分和背景差分的运动目标检测算法[J].吉林大学学报(工),2016,46(4):1325-1329.

[8] 徐敏,张红英,吴亚东.基于场景深度的雾天图像能见度检测算法[J].自动化仪表,2017,38(9):89-94.

[9] MUR-ARTAL R,MNOTIEL J M M,TARDS J D.ORB-SLAM:A versatile and accurate monocular SLAM system[J].IEEE Transactions on Robotics,2017,31(5):1147-1163.

[10]KARAMI E,PRASAD S,SHEHATA M.Image matching using SIFT,SURF,BRIEF and ORB:performance comparison for distorted images[C]//Newfoundland Electrical and Computer Engineering Conference,2015.

[11]陈天华.基于特征提取和描述的图像匹配算法研究[D].广州:广东工业大学,2016.

[12]顾幸方,茅耀斌,李秋洁.基于Mean Shift的视觉目标跟踪算法综述[J].计算机科学,2012,39(12):16-24.

[13]周帅,秦明伟,侯宝临.结合局部差分的CamShift动目标跟踪算法[J].自动化仪表,2017,38(2):1-4.

[14]KILIC V,BARNARD M,WANG W,et al.Mean-Shift and sparse sampling-based SMC-PHD filtering for audio informed visual speaker tracking[J].IEEE Transactions on Multimedia,2016,18(12):2417-2431.

[15]DEWAN M A ,GRANGER E,MARCIALIS G L,et al.Adaptive appearance model tracking for still-to-video face recognition[J].Pattern Recognition,2016,49(C):129-151.