基于超级基站的迁移机制应用研究

2018-03-21王园园

杨 俊,王园园

(1.重庆邮电大学 通信与信息工程学院,重庆 400065;2.移动计算与新型终端北京市重点实验室,北京 100190)

0 引言

随着通信技术的迅猛发展,移动网络支撑的无线业务越来越丰富多样。无线业务负载在时间和空间呈现出强烈的不均匀性,随着用户的移动,系统流量负载呈现随时间变化的“潮汐效应”。在工作时段(9:00-17:00),大量用户从住宅区移动到办公区的移动流量急剧增加;而在其余时段(20:00-23:00),用户从办公区移动到住宅区的移动流量急剧增加,而商业区移动流量明显下降。传统基站固有潮汐效应现象造成基站处理资源分配不均,零星负载基站与高负载的基站消耗相同功率,移动网络的平均负载情况远低于忙时负载。

针对传统离散分布的基站架构,其资源按用户峰值匹配,难以从全局进行资源分配,通过研究分析,新一代集中式接入网络架构是一种有效的解决途径。针对集中式接入网的概念,很多研究机构提出相应的架构设计,包括IBM的无线网络云架构[1],中国移动的C-RAN(Centralized,Cooperative,Cloud RAN)[2-3],以及文献[4-6]提出的超级基站。与传统基站架构相比,集中式接入网对基站资源进行集中并池化,通过构造射频软件池、基带软件池和协议栈软件池,承载一个小区的数据处理任务。在集中式接入网中,传统无线基站的功能抽象为运行在特定基站硬件资源上的虚拟基站软件,虚拟基站由动态分配的实际物理计算资源与软件处理逻辑组合而成,对虚拟基站而言,其屏蔽了底层硬件资源细节,所以具有硬件资源可动态配置、映射资源可迁移的特点。

虚拟基站的迁移是实现集中式网络架构下资源高效分配的关键技术。迁移虚拟基站的技术核心是采用迁移机制将负载较高的虚拟基站迁移到负载较低的基站板卡上,从而实现基站负载的动态调整、负载均衡。针对通用处理器组成协议计算资源池,对于基站协议栈而言,为保证迁移过程中用户可靠稳定接入,需要满足以下两方面的要求:

① 最小的用户中断时间(建议值100 ms)[7-8]。因为在迁移的过程中,不可避免地会有一定的中断时间,对于用户而言,必须要足够小且不能让用户感知,否则影响用户体验。通过LTE相关定时器分析,影响用户感知的定时器为T310,T310设置得越大,此时间内相关资源无法及时释放,也无法发起恢复操作或响应新的资源建立请求,从而影响用户体验。

② 基站迁移过程中,总迁移时间不能过长[9-10]。因为在迁移的过程中,会耗费大量的带宽资源,如果迁移时间过长,会影响其他用户的正常使用。

云计算平台和集中式基站有一定的相似性,目前云计算平台广泛地应用迁移技术解决资源负载问题,但对于其应用到基站方面还没有确定结论。因此针对超级基站架构中协议层计算任务的迁移需求,进行3种迁移方案的基站协议栈迁移仿真实验,得出了预拷贝迁移基本符合基站协议栈迁移需求。

1 超级基站

首先对超级基站架构进行阐述。文献[11-13]提到超级基站物理架构包括大规模计算资源池(BBU)和分布式异构射频池(RRU)。BBU是由大规模可扩缩的CPU构建而成,为计算资源的虚拟化、并行处理提供强力的硬件支撑。对于分布式异构RRU池,主要的特点是采用虚拟化智能资源管理,实现按需动态部署、智能覆盖。超级基站为实现基站资源的统计复用,将传统基站资源进行集中式部署,采用虚拟化技术对集中计算资源进行水平池化,在基础硬件层面构建射频资源池、基带处理资源池和通用计算资源池。在资源池内提供大量虚拟基站,每个虚拟基站由协议、基带和射频共同构造,并从资源池内获取相应处理资源,完成完整的基站处理任务。超级基站水平架构图如图1所示。

图1 超级基站水平架构

在超级基站内部,有2个重要模块:计算资源管控模块和资源监测模块。计算资源管控模块功能为虚拟基站动态地分配资源,并根据基站负载情况为资源不足的虚拟基站制定资源调整策略,实现基站处理资源的按需分配、动态管理。而资源监测模块负责监测基站板卡运行所占用的CPU、内存和I/O等资源,该信息返回给计算资源管控模块。例如,资源监测模块发现某块基站单板负载相对较高,而另一块基站单板负载较低,这时将反馈给计算资源管控模块,计算资源管控模块将发起迁移要求,将负载较高的基站单板上运行的虚拟基站迁移到负载较低的单板。在超级基站单板负载都较低的情况,可以将其上运行的虚拟基站都迁移到1个或几个基站单板上。通过上述分析,有效的迁移机制可显著改善基站资源负载均衡问题。

2 基站协议栈迁移算法

在没有利用虚拟机时,板卡之间的协议栈迁移依靠的是系统备份和恢复技术。在源板卡上实时备份操作系统和协议栈程序的状态,然后把存储介质传输到目标板卡上,最后在目标板卡上恢复协议栈的运行。在这种情况下,迁移协议栈会造成较大的停机时间,并且在停机时间内基站协议栈无法处理任何业务,严重影响用户体验。

虚拟机迁移技术实现基站板卡上的虚拟机与协议栈在几乎间断运行的情况下实时移动,为确保迁移前后的基站协议栈状态保持一致,必须传递虚拟机网络状态信息、存储状态信息以及最为关键的运行状态信息。在这些状态信息和数据之中,迁移内存的状态信息和数据最复杂,内存不仅存储的信息量巨大、地址映射相对复杂,而且页面变化较大。与内存迁移相比,CPU运行状态和I/O设备迁移数据量较少、结构单一。因此本文的研究重点是针对内存的迁移机制,下面分别介绍3类迁移对象。

① 存储设备的迁移:存储设备因为其数据量最大,会浪费大量的时间和网络带宽。为了减少迁移的时间和空间损失,采用NFS共享的方式共享数据和文件系统[14],实现虚拟硬盘资源零迁移。

② 网络的迁移:在迁移时虚拟机的所有网络设备,包括协议状态以及 IP 地址都要封装在一起迁移。在局域网内,通过发送 ARP重定向包,就可以把虚拟机的 IP 地址与目的主机的 MAC 地址相绑定,迁移之后所有的数据包就可以成功抵达目的主机。

③ 内存的迁移:虚拟机动态迁移的内存迁移是迁移的难点,目前,迁移算法主要有3种:静态迁移、预拷贝迁移算法和后拷贝迁移算法。

静态迁移:静态复制迁移首先暂停源主机上的虚拟机运行,然后将虚拟机所有的内存页面通过网络传输到目的主机,在完成所有的页面迁移后,在目的主机恢复虚拟机在暂停前的运行状态[15]。

后拷贝迁移:文献[16-18]提到了后拷贝迁移算法,其主要流程:首先在两端主机之间同步支持虚拟机基本运行的最小工作集,将内存的同步过程推迟到虚拟机在目的主机上恢复运行之后,然后目的主机接收到这个最小工作集,并立即恢复虚拟机运行,这时由于虚拟机内存数据在之前没有传输到目的主机,需要通过按需取页的方式从源主机上同步虚拟机内存页面。

预拷贝迁移:文献[19-20]提出预拷贝迁移算法的核心思想是迭代传输内存页面。其内存传输主要分为3个阶段:首先将源主机上虚拟机所有的内存页面全部标记为脏页面并传输到目的主机,在这个迁移过程中,虚拟机仍保持不间断正常的运行,接下来对上一轮复制传输过程中被修改且本轮到目前为止没有被修改的内存页面进行迭代复制传输,每一次迭代传输后都要判断是否满足停机拷贝条件,如果不满足则继续进行迭代复制传输,如果满足停机拷贝条件,源端上虚拟机被停止运行,并将剩余的内存脏页面复制传输到目的主机。预拷贝迁移停机条件是经多轮复制传输后内存脏页面总量收敛到预先规定的最少剩余脏页面。

3 基站协议栈迁移实验

在超级基站实验平台搭建了基于KVM虚拟化的虚拟基站迁移平台,分别进行基于静态迁移、后拷贝迁移、预拷贝迁移情况下基站协议栈迁移实验。

3.1 实验环境

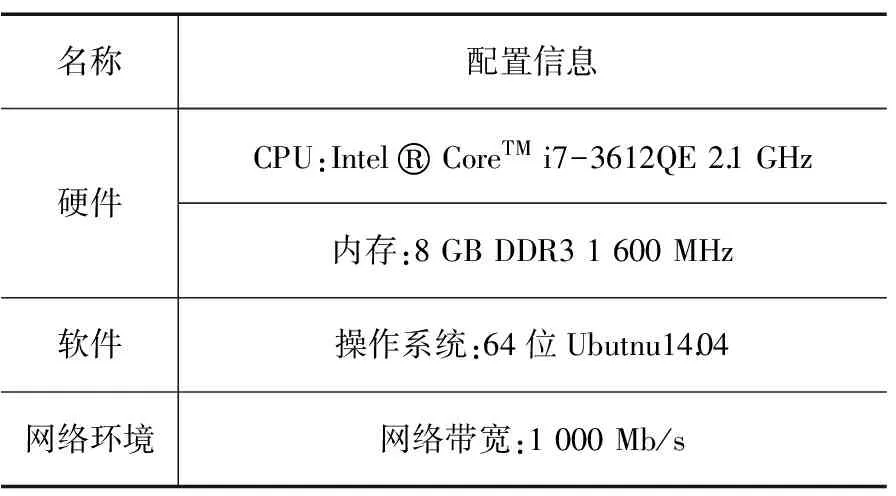

实验在安装了Qemu的Ubantu14.04系统上进行,共有3台超级基站硬件平台,具体软硬件配置如表1所示。

表1 超级基站硬件平台软硬件配置

名称配置信息硬件CPU:Intel®CoreTMi7-3612QE2.1GHz内存:8GBDDR31600MHz软件操作系统:64位Ubutnu14.04网络环境网络带宽:1000Mb/s

其中PHY1、PHY2分别作为虚拟机迁移的源主机和目的主机,同时PHY3提供NFS服务,作为虚拟机镜像文件的共享存储,在源端PHY1创建了虚拟机VM,在其上运行由中科院计算所无线中心开发的面向超级基站的LTE协议栈软件,虚拟机相应配置如表2所示。

表2 虚拟机VM软硬件配置

名称配置信息硬件CPU:4VCPU内存:512M操作系统64位Ubutnu14.04服务器

为分析超级基站协议栈业务迁移的特点,进行4种场景实验:

① 虚拟机运行协议栈软件,协议栈不处理任何业务,模拟空载;

② 虚拟机运行协议栈软件,通过iperf向协议栈发送音频流的数据,模拟终端的音频业务;

③ 虚拟机运行协议栈软件,通过iperf向协议栈发送视频流的数据,模拟终端的视频业务;

④ 虚拟机运行协议栈软件,通过iperf向协议栈发送UDP数据报,模拟终端的下载数据任务。

在实验中,通过计算资源管控模块发动迁移,将虚拟基站从源主机节点迁移到目的主机所用的时间定义为总迁移时间,在迁移过程中,造成基站协议栈中断业务处理的时间定义为停机时间,由基站协议栈软件日志测定。

3.2 基于静态迁移算法

基于静态迁移的协议栈迁移实验数据如表3所示。

表3 基于静态迁移的基站协议栈迁移实验数据

实验类型总迁移时间/ms停机时间/ms空载47634723音频流52335211视频流56495431UDP数据报64236367

通过这组实验测量采用静态迁移对基站协议栈业务迁移的影响,从表3可以看出,基站协议栈进行4种业务处理时迁移,其总迁移时间与停机相差不大,在停机时间内,基站协议栈无法处理任何业务,这对于用户来说是无法接受的,显然静态迁移算法难以满足基站协议栈迁移要求。

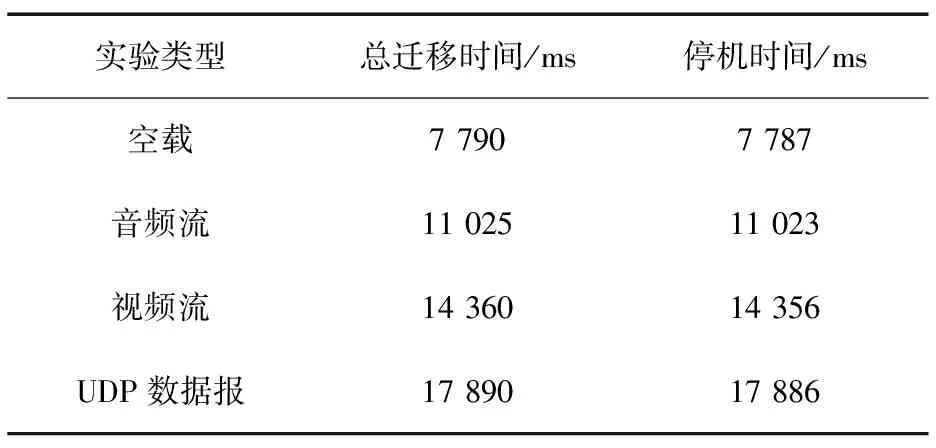

3.3 基于后拷贝迁移算法

基于后拷贝的协议栈迁移实验数据如表4所示。

表4 基于后拷贝的基站协议栈迁移实验数据

实验类型总迁移时间/ms停机时间/ms空载77907787音频流1102511023视频流1436014356UDP数据报1789017886

当前实验采用后拷贝迁移算法,基站协议栈处理空载、音频流、视频流和UDP数据报业务时,在迁移未完成期间,基站协议栈需要频繁的从源端获取内存页面,由于后拷贝迁移算法是基于按需取页机制,基站协议栈不能总是及时的获取相关页面,造成基站协议栈总时间过大。从表4还可以看出,基站协议栈总迁移时间与停机时间仅差3 ms左右,这是后拷贝算法首先传输的是为支持虚拟机及基站协议栈基本运行的最小工作集,这个最小工作集比较小且相对固定,但由于基站协议栈维持较多的定时器,且协议栈处理数据有1 ms调度周期的要求,后续从源端取页引发的缺页中断造成了基站协议栈反复的中断,从基站协议栈日志里看出存在大量的丢包现象,显然后拷贝迁移算法并不符合基站协议栈迁移需求。

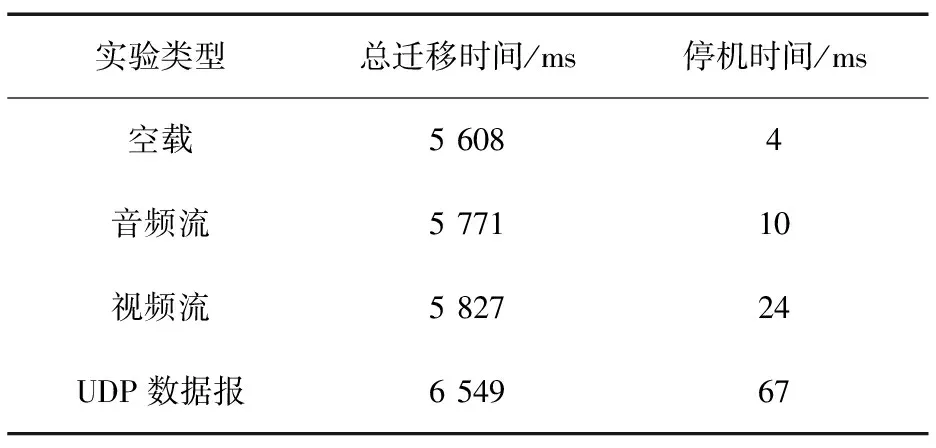

3.4 基于预拷贝迁移算法

基于预拷贝的协议栈迁移实验数据如表5所示。

表5 基于预拷贝迁移协议栈迁移实验数据

实验类型总迁移时间/ms停机时间/ms空载56084音频流577110视频流582724UDP数据报654967

从表5可以看出,基站协议栈在处理空载、音频流、视频流和UDP数据报等不同业务时,其总迁移时间、停机时间也相应增加,这是因为协议栈处理空载、音频流、视频流和UDP数据报时负载是逐渐上升的,在协议栈处理数据量增大时,需要对内存进行频繁读写操作,显然随着内存读写操作增加,源主机将虚拟机的所有内存页面复制传送到目的主机的数据量也相应增大,即增大了迁移数据传输量,由于迁移数据传输量和总迁移时间成正比例关系,故总迁移时间也相应增大。此外,预拷贝停机时间主要以数据传输时间为主,而数据包括两部分:剩余的内存脏页以及CPU、外设状态。CPU、外设状态是某些寄存器的信息,数据量极少,因此剩余内存脏页将对停机时间起决定性作用,当协议栈处理数据量增大时,需对内存进行频繁的读写操作,显然这会使得剩余内存脏页也相应增加。

3.5 实验结果分析

基站协议栈迁移过程中,总迁移时间与停机时间不能过长,需要以LTE的1 ms的调度时延要求来看待;由于LTE数据处理的两端都会维持较多的定时器来控制数据处理的时延,而一旦超过数据处理时延会引起控制交互,以及数据重传,进而会造成链路中断,则会直接体现影响用户的使用。预拷贝迁移算法很好地平衡了二者的关系,在迁移过程稳定性高且停机时间基本不影响基站协议栈正常处理业务。

4 结束语

本文重点研究了以超级基站为基础的基站协议资源的动态管理。对超级基站协议计算资源采用KVM虚拟化技术,在此基础上采用虚拟机迁移技术进行基站协议任务迁移。在超级基站硬件平台进行了测试,验证了预拷贝迁移算法的可用性和可靠性。仿真结果表明,基站协议栈在处理空载、音频、视频和下载任务时,迁移所用的总时间不大,且导致的停机时间并没有严重影响基站协议栈业务处理。未来,将重点改善基站协议栈迁移的停机时间,如选择更加高效的压缩算法对内存页面进行压缩,以尽可能减少停机时间对基站协议栈处理数据的影响。

[1] LIN Y,SHAO L,ZHU Z,et al.Wireless Network Cloud:Architecture and System Requirements[J].IBM Journal of Research & Development,2010,54(1):4:1-4:12.

[2] WU J,ZHANG Z,HONG Y,et al.Cloud Radio Access Network (C-RAN):a Primer[J].Network IEEE,2015,29(1):35-41.

[3] LIU L,ZHANG R.Optimized Uplink Transmission in Multi-Antenna C-RAN With Spatial Compression and Forward[J].IEEE Transactions on Signal Processing,2015,63(19):5083-5095.

[4] ZHAI G,TIAN L,ZHOU Y,et al.Real-time Guaranteed TDD Protocol Processing for Centralized Super Base Station Architecture[C]∥Wireless Communications and Networking Conference.IEEE,2015:989-994.

[5] QIAN M,WANG Y,ZHOU Y,et al.A Super Base Station Based Centralized Network Architecture for 5G Mobile Communication Systems[J].Digital Communications & Networks,2015,1(2):152-159.

[6] 田霖,翟国伟,黄亮,等.基于集中式接入网架构的异构无线网络资源管理技术研究[J].电信科学,2013,29(6):25-31.

[7] LIU J,KATO N,MA J,et al.Device-to-Device Communication in LTE-Advanced Networks:A Survey[J].IEEE Communications Surveys & Tutorials,2017,17(4):1923-1940.

[8] MA Z,ZHANG Y,ZHENG K,et al.Performance of 3GPP LTE-Advanced Networks with Type I Relay Nodes[C]∥International ICST Conference on Communications and Networking in China.IEEE Xplore,2010:1-5.

[9] GARCIA V,ZHOU Y,SHI J.Coordinated Multipoint Transmission in Dense Cellular Networks With User-Centric Adaptive Clustering[J]. Wireless Communications IEEE Transactions on,2014,13(8):4297-4308.

[10] 方义秋,唐道红,葛君伟.云环境下基于虚拟机动态迁移的调度策略研究[J].微电子学与计算机,2012,29(4):45-48.

[11] LIU L,ZHOU Y,GARCIA V,et al.Load Aware Joint CoMP Clustering and Inter-cell Resource Scheduling in Heterogeneous Ultra Dense Cellular Networks[J].IEEE Transactions on Vehicular Technology,2017,PP(99):1-1.

[12] ZHOU Y,LIU H,PAN Z,et al.Two-Stage Cooperative Multicast Transmission with Optimized Power Consumption and Guaranteed Coverage[J]. IEEE Journal on Selected Areas in Communications,2014,32(2):274-284.

[13] ZHAI G W,TIAN L,ZHOU Y Q,et al.Load Diversity Based Optimal Processing Resource Allocation for Super Base Stations in Centralized Radio Access Networks[J].Science China Information Sciences,2014,57(4):1-12.

[14] LOMBARD P,DENNEULIN Y,VALENTIN O,et al.Improving the Performances of a Distributed NFS Implementation[J].Lecture Notes in Computer Science,2017,3019:405-412.

[15] 刘鹏程.云计算中虚拟机动态迁移的研究[D].上海:复旦大学,2009.

[16] JIN Hai,DENG Li,WU Song,et al.Live Virtual Machine Migration with Adaptive Memory Compression[C]∥Cluster Computing and Workshops.Wuhan,China:IEEE,2009:1-10.

[17] HINES M R,DESHPANDE U,GOPALAN K.Post-copy Live Migration of Virtual Machines[J].Acm Sigops Operating Systems Review,2009,43(3):14-26.

[18] HIROFUCHI T,NAKADA H,ITOH S,et al.Reactive Consolidation of Virtual Machines Enabled by Postcopy Live Migration[C]∥International Workshop on Virtualization Technologies in Distributed Computing,2011:11-18.

[19] CLARK C,FRASER K,HAND S,et al.Live Migration of Virtual Machines[C]∥Symposium on Networked Systems Design and Implementation.DBLP,2005:273-286.

[20] WU T Y,GUIZANI N,HUANG J S.Live Migration Improvements by Related Dirty Memory Prediction in Cloud Computing[J].Journal of Network & Computer Applications,2017,90:83-89.