离散型Hopfield神经网络学习算法

2018-03-19朱丽萍王锋辉李洪奇SikandarAli

朱丽萍,王锋辉+,李洪奇,吕 洁,Sikandar Ali

(1.中国石油大学(北京) 石油数据挖掘北京市重点实验室,北京 102249;2.中国石油大学(北京) 地球物理与信息工程学院,北京 102249)

0 引 言

离散型Hopfield神经网络是递归型神经网络中最基本的模型之一,广泛用于联想记忆[1]和二值无约束二次规划问题[2,3],其研究具有深刻意义。权值求取方法的改进对其它复杂递归型神经网络权值的求取具有启发式作用。诸多学者通过改变网络结构[4,5]、改进权值设计算法[4,5]、设置时延[6]等方法使得递归神经网络具备更强的联想记忆能力,稀疏性的递归网络和迭代学习算法得到了普遍的认可。笔者以外积和法求取的权值作为网络权值的初始值,然后通过定义损失函数,使用梯度下降算法,将样本数据和网络的能量最低点对应起来,在一定程度上优化了网络的联想记忆能力。

1 离散型Hopfield神经网络概述

1.1 相关研究

Hopfield神经网络的联想记忆能力被认可后,对递归神经网络性能的研究也越来越多。Pershin等[7]使用忆阻器等电子元件模拟了神经元的联想记忆能力。Hillar等[1]利用自然图像训练递归Hofield神经网络,实现了对自然图片的高效压缩和恢复。Wang等[2]利用离散型Hopfield神经网络结合分布式估计算法解决NP二值无约束二次规划问题,分布式估计算法用于克服离散型Hopfield神经网络的极小值问题,相对模拟退火等非启发式算法分布式估计算法具有更好的表现效果,随后在文献[3]中改变了离散型Hopfield神经网络网络的结构,取得了更好的实验效果。Karbasi等[8]探讨了在记忆模式并未随着噪音降低到一个固定的阈值的时候,联想记忆内部噪音可以改善联想记忆能力。Danesh等[9]通过收集社交网站的言论、标签等资料利用递归自联想记忆网络对情感检测进行了研究。

也有不少学者从改善网络结构的角度入手探讨网络性能。受到大脑中模块化以及稀疏性的启发,Tanaka等[4]提出了具有稀疏性模块化的Hopfield联想记忆网络,介绍了一种依赖于网络拓扑结构的迭代学习算法改变连接权值,并得出每个神经元连接数目较为一致的时候网络才具备较好的联想记忆能力。Salavati等[10]指出非二值的联想记忆具有指数级别的恢复能力,考虑了非二值神经网络的神经联想问题,二值联想记忆网络的记忆能力和神经元数量成线性相关,而非二值神经网络的联想记忆与神经元数量指数相关。没有时延的离散型Hopfield神经网络可以收敛到一个稳定的状态,这条性质早已被证明,对于具有时延的离散型Hopfield神经网络Runnian等[6]详细考虑了其稳定性,研究了基于新的更新算法具有时延的离散型Hopfield神经网络的收敛定理。理想的神经联想记忆网络可以记住学习模式的同时,又可以对有噪音的输入进行恢复,而且能够在保障吸引域的同时记住更多的模式,Karbasi等[5]找到了一种基于卷积的神经联想记忆网络,并提出一种迭代学习算法可以学习模式间的冗余,这种网络的效果达到了上述3个要求。虽然基于卷积的联想记忆网络,但是在噪声恢复的时候依然可以在线性时间内完成。Mofrad等[11]将编码技术嵌入到神经联想记忆中,提高了网络恢复能力。在这篇文章中,笔者提出了一种学习算法,来改善网络的联想记忆能力。

1.2 网络结构

离散型Hopfield网络权值的设计一直围绕着一个问题在求解:每组训练数据输入网络后,输出和输入完全相等。但是由于激励函数为取符号函数sgn,无法进行求导,所以严重限制了问题的求解。如果在求取权值的时候,可以利用另一个连续的函数f(x)代替sgn,而且仍能满足sgn函数的性质,那么对于权值的求解就变得简单很多。笔者通过比较线性函数、tansig函数和sgn函数的区别,替换sgn函数,通过梯度下降进行求取权值。通过对结果对比发现替换之后求出的权值表现效果明显优于传统算法计算得出的结果,略微差于Matlab自带函数求解结果。除此之外严格证明了可导函数替换sgn函数求解结果的正确性和在求解过程中面对无解情况的优势,并在结论中对离散型Hopfield神经网络权值设计进行详细分析。

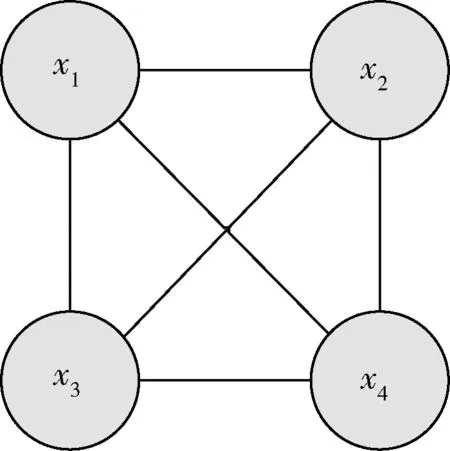

离散型Hopfield神经网络(DHNN)网络结构为一个全连接无自环的无向图,也就是n个节点之间的权值满足wij=wji、wij=0(i=1…n),如图1所示。若以xj表示神经元j的输出(也称为神经元的状态),wij表示神经元i与神经元j的连接权值,θj表示神经元j的阈值。则神经元的净输入sj和输出xj分别用式(1)和式(2)计算

(1)

(2)

图1 HDNN结构

离散型Hopfield神经网络的状态由n个神经元的状态集构成,离散型Hopfield神经网络是反馈型网络,也就是t时刻的网络状态会成为t+1时刻网络状态的输入,直到网络状态不再变化为止,此时的网络状态作为网络原始输入的结果。在网络状态变化的过程有同步和异步之分,但是可以证明,无论是同步还是异步,每次网络状态变化,网络的能量值都会变得更小,等到网络状态不再变化的时候,说明能量函数已经降到极小值。网络能量函数定义如式(3)所示

(3)

2 设计网络权值的新学习方法

为了使离散型Hopfield神经网络具有联想记忆功能,在求取网络权值和阈值的时候要满足两点要求[5]。第一点:尽可能多的将训练样本分布在能量函数的极小值点,分布在能量函数极小值点的训练样本被称为吸引子。第二点:每个吸引子的吸引域不能太小。本方法有效地解决了第一点,为了满足第二点要求,权值和阈值的初始值需要选取适当的值。对于权值的初始值设置为外积和法求取的结果,阈值的初始值为零。

求取的权值和阈值需要满足下面的条件:样本数据输入网络之后,网络已经达到了能量函数的极值点,状态不再发生变化。转化为数学问题就是:在满足式(4)的情况下,求W和θ。假设标准输出和实际输出的误差满足高斯分布,则根据极大似然估计可以导出损失函数如式(5)所示

(4)

(5)

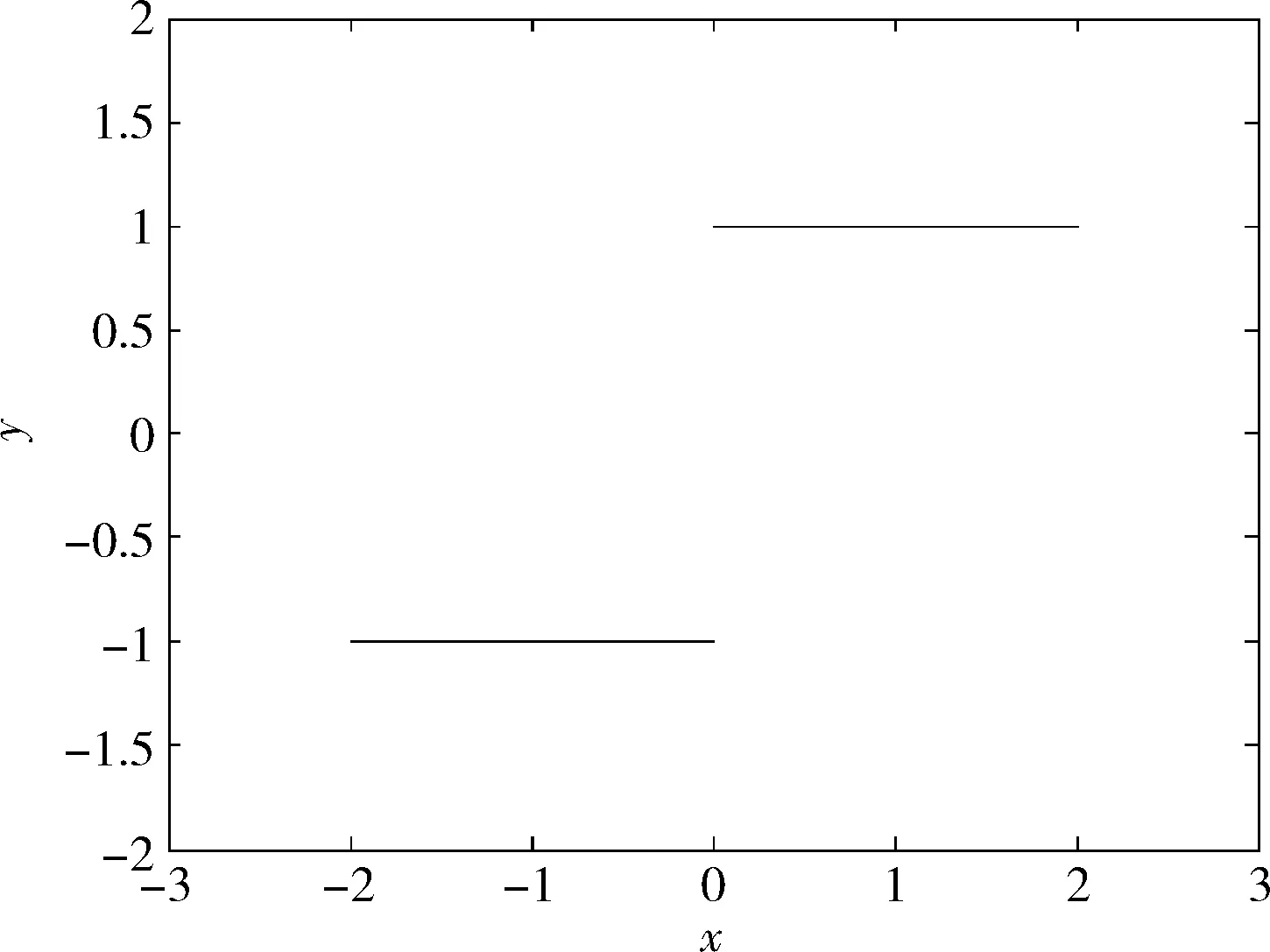

如果损失函数为零,说明结果已经严格满足式(4)。由于取符号函数sgn的不可求导特性,所以直接将Yi带入式(5)进行求取对W的偏导数不可行。观察sgn函数性质如图2所示。

图2 sgn函数

Xi=Yi

(6)

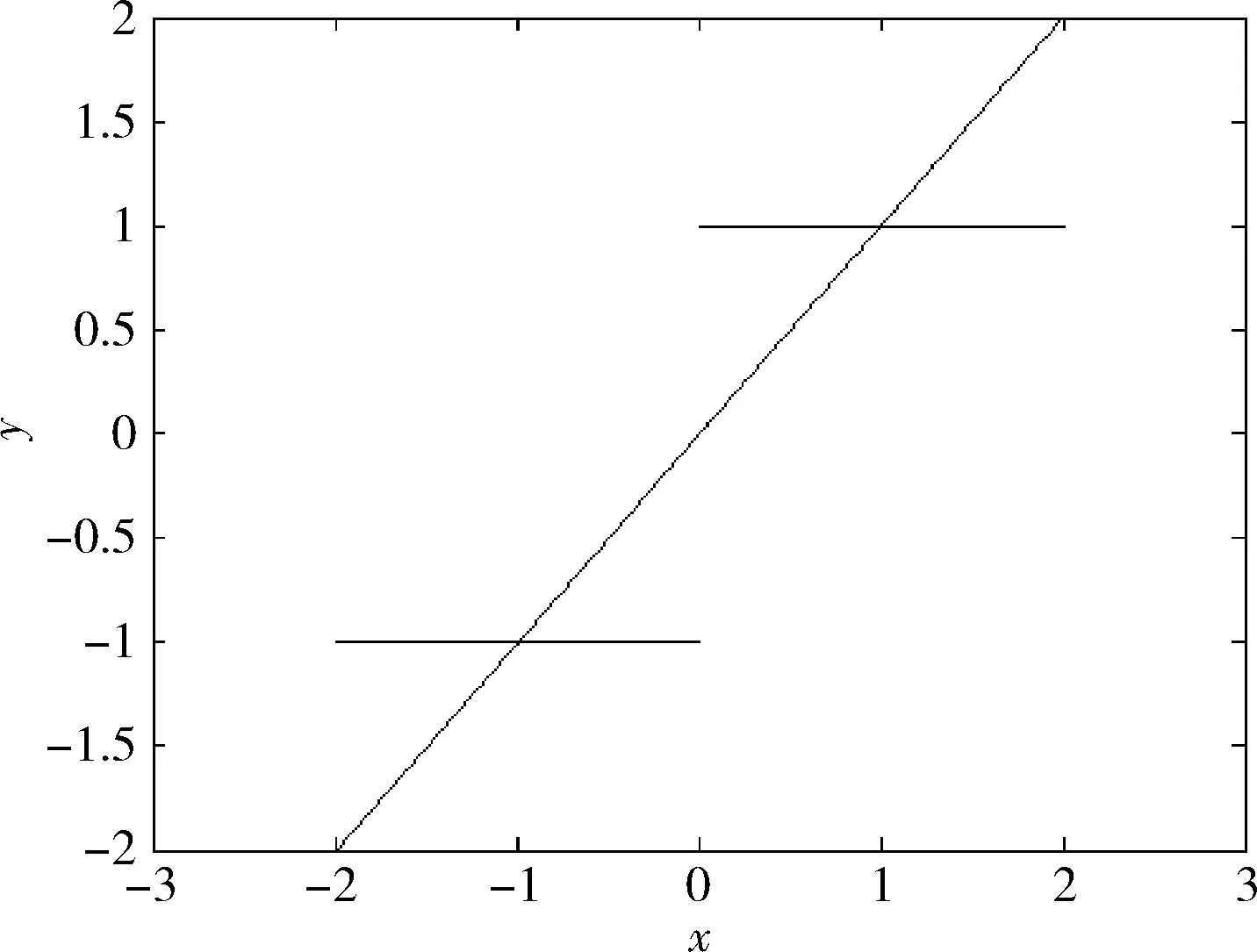

图3 sgn、线性函数

如果直接把式(6)化为Xi=WXi+θ来进行求解,未知参数W和θ一共有n(n+1)个参数,而等式一共有n×m组,如果m

(7)

接下来只需要进行不断求取W和θ的偏导数并且定义步长,一步步将损失函数降低到最小点即可。当使用线性函数y=x来代替sgn函数的时候,并没有详细讨论为什么是一次函数而不是其它函数,当然如果用f(x)=tansig(βx) 代替sgn函数,图4是β=10的曲线图像,通过观察图4,可以知道f(x)=tansig(βx) 对sgn的模拟会更好。此时的损失函数如式(8)所示

(8)

图4 tansig函数

3 实验验证及结果

实验中使用的训练图片具有统一的模式,存储信息的不一致性会导致网络的联想记忆能力急剧下降,文献[12]改变稀疏联想记忆网络结构改善在存储信息格式不统一时网络的表现。下面通过逆梯度下降算法,对式(6)以及式(8)进行求解,对于式(8)中β的设定,考虑到梯度下降不能太快也不能太慢,太快容易错过极小值点,太慢不适合实际应用,所以选取β=5来做实验。对式(7)求取wkj和θj的偏导数

(9)

(10)

(11)

由于要求wkj与wjk相等,但是式(11)中不能保证wkj与wjk同时发生变化,可以采用折中处理,在变化的时候仅对其中一个进行改动,但是要对wkj与wjk都有顾及

(12)

(13)

如果对式(8)进行求偏导得到

(14)

在实际的变化中权值阀值变化如下

(15)

(16)

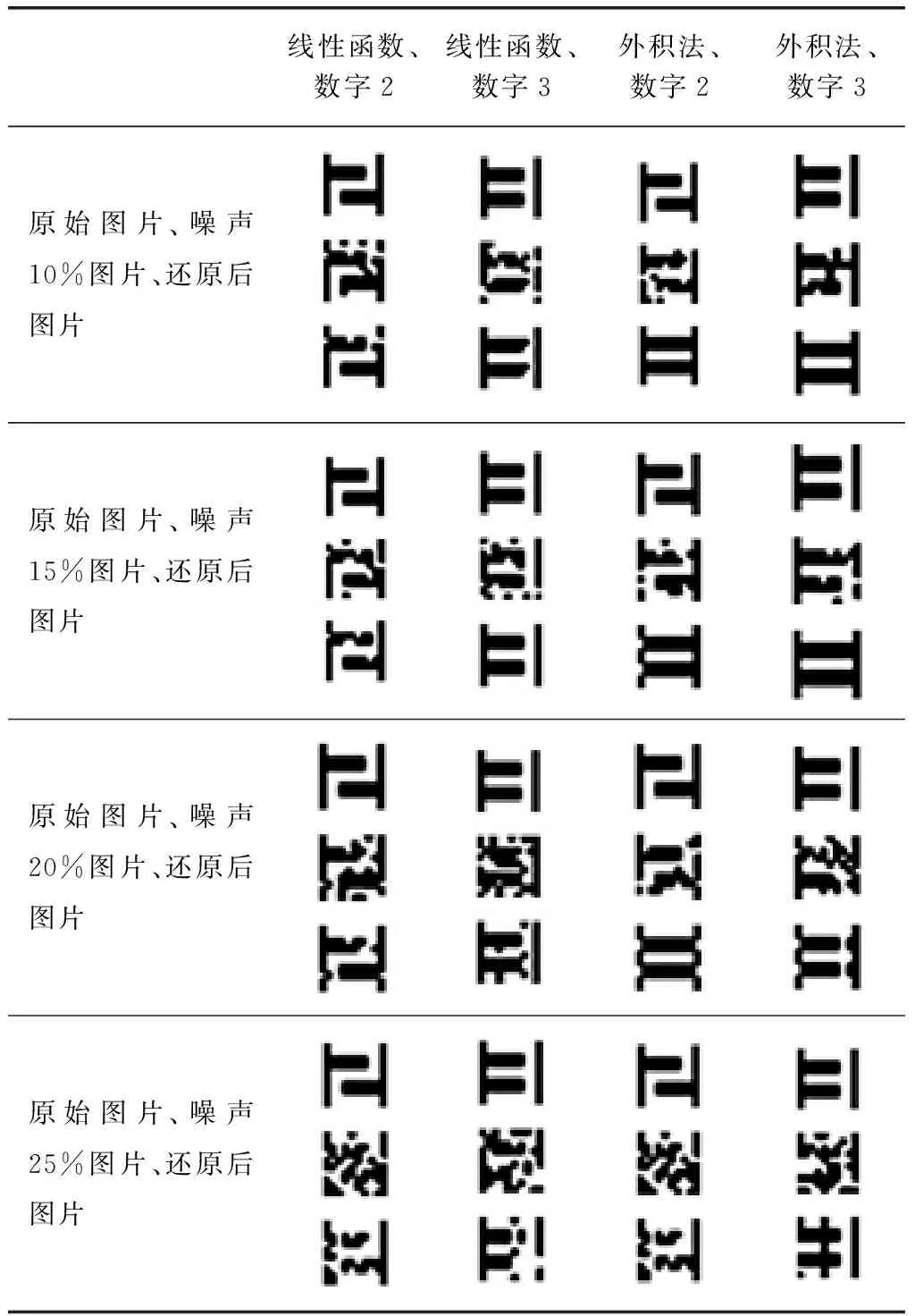

对于权值和阈值的初始值设定不可以采用随机值,对于随机值,虽然上述方法可以将样本中的数据分布在能量函数的极值点,但是并不能保证这些极值点(吸引子)分布均匀,也就不能保证每个极值点(吸引子)的吸引域足够大。所以对于权值的初始值,可以采用以往的经典算法进行设定,比如外积法等。下面实验结果均是以外积法求得权值作为初始值,阀值采用-1到1之间的随机值,对单一模式进行联想记忆的结果。测试数据分别为目标数据噪声的10%、15%、20%、25%,测试数字为2和3。每张图片上的3个数字分别为标准记忆数字、噪声数字、对噪声数字记忆联想后的数字。

实验结果对比见表1。

碍于篇幅限制,tansig 函数替换sgn函数实验结果没有显示,tansig函数更加接近于sgn函数,理论上表现效果会更好一点,由于tansig函数的运算复杂度远大于线性函数,因而在梯度下降的过程中迭代次数不高,而且阈值初始值为随机值,所以每次实验结果的好坏情况也不尽相同。但是tansig函数的实验结果整体上还是优于直接使用外积法的结果。

表1 实验结果对比

4 结 论

通过实验结果可以发现在用外积法、线性函数替换sgn、tansig函数替换sgn这3种方法中,线性函数替换sgn方法取得的结果最好,由于tansig函数的计算复杂性,实验次数有限,通过表现出来的实验结果可以发现。使用线性函数替换sgn优于使用tansig函数替换sgn,tansig函数替换sgn优于直接使用外积法。可以看出此算法求取而来的权值比目前其它方法在联想记忆方面有较大改进。

当决定用一个可以求导的函数替换sgn函数的时候,在实验中选用了线性函数和tansig函数。通过观察式(4)可以发现,需要找这样一个函数f(x),这个函数必须使得式(18)是式(17)的充分条件,也就是如果式(18)成立,那么式(17)也成立。不难发现,当式(17)恒满足时,式(18)就是式(4)的充分条件。证明如下

f(x)x>0

(17)

(18)

当满足式(18)

由式(17)的性质,可知

在直角坐标系内可以满足式(17)的函数有无数个,具体哪个函数的表现效果更好还无法定性判断,只能根据实验结果来进行比较。该方法围绕一个问题讨论:式(4)的求解方法。在二维坐标系中,我们无法找出一个函数f(x)使得式(18)是式(4)的充分必要条件,只能够找出一些函数f(x)使得式(18)是式(4)的充分条件。对于式(4)的求解,理想中应该找到一个f(x)使得式(18)是式(4)的充分必要条件,只有当式(18)与式(4)互为充分必要条件的时候,问题才完全等价。这样通过对可求导函数f(x)通过梯度下降算法求得的解才完全是式(4)的解。对这样一个函数f(x)的寻找仍是目前需要做的工作,也是以后需要改进的地方。

5 结束语

离散型Hopfield神经网络权值求取是关乎记忆能力好坏的关键,在保证吸引域的情况下,将记忆对象和能量极值点一一对应起来是一个复杂的工作。文献[11]中基于卷积的联想记忆网络通过合理利用网络的冗余实现了在保证吸引域的情况下有较好的记忆效果。笔者通过对多篇网络权值求取文献的阅读,提出了基于连续可导函数替换原来不可导函数进行求解的方法。不过替换函数并不能完全等价于原来sgn函数,在结论里面给出了充分的分析,而且一个好的解应该保证每个极值点的吸引域不会太大或者太小,该方法只是在权值初始化的时候保证初始值尽可能均匀分布,并没有对最终结果吸引域大小给出保证。

[1]Hillar C,Mehta R,Koepsell K.A hopfield recurrent neural network trained on natural images performs state-of-the-art image compression[C]//IEEE International Conference on Image Processing,2014:4092-4096.

[2]Wang J.Discrete Hopfield network combined with estimation of distribution for unconstrained binary quadratic programming problem[J].Expert Systems With Applications,2010,37(8):5758-5774.

[3]Wang J,Zhou Y,Yin J,et al.Combining tabu Hopfield network and estimation of distribution for unconstrained binary quadratic programming problem[J].Expert Systems With Applications,2011,38(12):14870-14881.

[4]Tanaka G,Yamane T,Nakano D,et al.Hopfield-type associative memory with sparse modular networks[C]//International Conference on Neural Information Processing,2014:255-262.

[5]Karbasi A,Amir H,Salavati,et al.Iterative learning and denoising in convolutional neural associative memories[C]//International Conference on Machine Learning,2011:445-453.

[6]Runnian M A,Sheping L,Naigong L,et al.Stability of discrete Hopfield neural networks with delay[J].Journal of Systems Engineering and Electronics,2012,16(4):937-940.

[7]Pershin Y V,Ventra M D.Experimental demonstration of associative memory with memristive neural networks[J].Neural Networks,2010,23(7):881-886.

[8]Karbasi A,Salavati A H,Shokrollahi A,et al.Noise facilitation in associative memories of exponential capacity[J].Neural Computation,2014,26(11):2493-2526.

[9]Danesh S,Liu W,French T,et al.An investigation of recursive auto-associative memory in sentiment detection[C]//International Conference on Advanced Data Mining and Applications,2011:162-174.

[10]Salavati A H,Kumar K R,Shokrollahi A,et al.Nonbinary associative memory with exponential pattern retrieval capacity and iterative learning[J].IEEE Transactions on Neural Networks,2014,25(3):557-570.

[11]Mofrad A A,Parker M G,Ferdosi Z,et al.Clique-based neural associative memories with local coding and preceding[J].Neural Computation,2016,28(8):1553-1573.

[12]Boguslawski B,Gripon V,Seguin F,et al.Twin neurons for efficient real-world data distribution in networks of neural cliques:Applications in power management in electronic circuits[J].IEEE Transactions on Neural Networks,2016,27(2):375-387.