改进的核相关滤波器的目标跟踪算法

2018-03-19郭克友暴启超

郭克友,暴启超

(北京工商大学 材料与机械工程学院,北京 100048)

0 引 言

近年来,各大城市中交通拥堵现象尤为突出,在上下班高峰期最为明显,而解决交通拥堵问题的一个重要方面就是解决顺利停车问题,由此提出由目标跟踪实现停车位的寻找。目标跟踪即为在视频的初始序列中给定目标的初始状态,在随后的视频序列中进行目标状态的评估。而影响目标跟踪因素很多,例如遮挡、光照变化、尺寸的变化等。

Bolme提出最小输入平方误差和(minimun output sum of squared error,MOSSE)的跟踪算法,具体定义参见文献[1];Mean Shift是一种密度梯度的无参估计方法[2],由Fukunaga提出,Cheng[3]将其引入到计算机视觉领域,定义参见文献[2]。Frag由运行的连续性,在当前帧中目标区域周围遍历所有的候选位置,由相似度最大原则确定当前帧中目标的最佳位置,定义参见文献[4]。Henriques等提出了循环结构的检测跟踪算法(circulant structure of tracking-by-detection with kernel,CSK),CSK算法定义参见文献[5],对训练样本循环移位得到新的样本训练分类器[6],同样对候选目标区域循环移位作为检测样本,并且训练和检测过程均利用傅里叶变换在频域实现快速计算。核相关滤波器(kernelized correlation filter,KCF)跟踪在CSK跟踪的基础上,采用方向梯度直方图特征代替CSK跟踪中的灰度直方图特征,KCF定义参见文献[7]。以上算法中,Frag算法在受较大面积遮挡时,即会出现跟踪失败的情况,且处理速度较慢;Mean Shift算法在光照导致的颜色变化较为明显时,也会跟踪失败;MOSSE跟踪算法以及传统KCF均无尺寸自适应策略[8],因此在尺度发生较大变化时,即会跟踪失败。本文提出改进的KCF,首先,采用HOG特征与HIS特征相融合的多特征,可以避免颜色以及光照变化导致的跟踪失败;其次,提出尺寸自适应策略,可以更好适应尺寸变化,尤其对运动目标的跟踪,效果尤为明显;最后针对遮挡尤其是大面积遮挡时,提出检测遮挡并处理的策略,可以更好适应遮挡对目标跟踪的影响。

1 改进的KCF

1.1 传统KCF算法简介

1.2 特征提取

本文首先将颜色信息与梯度角度直方图信息融合,得到一种新的色度饱和度-梯度角度直方图特征;然后,将其应用在KCF目标跟踪过程中;最后,在检测阶段采用尺寸自适应策略。采用文献[1]中提出的HOG特征,该HOG特征统计并提取每个cell的梯度信息作为图像特征。主要提取步骤如图1所示。

图1 提取HOG特征的主要步骤

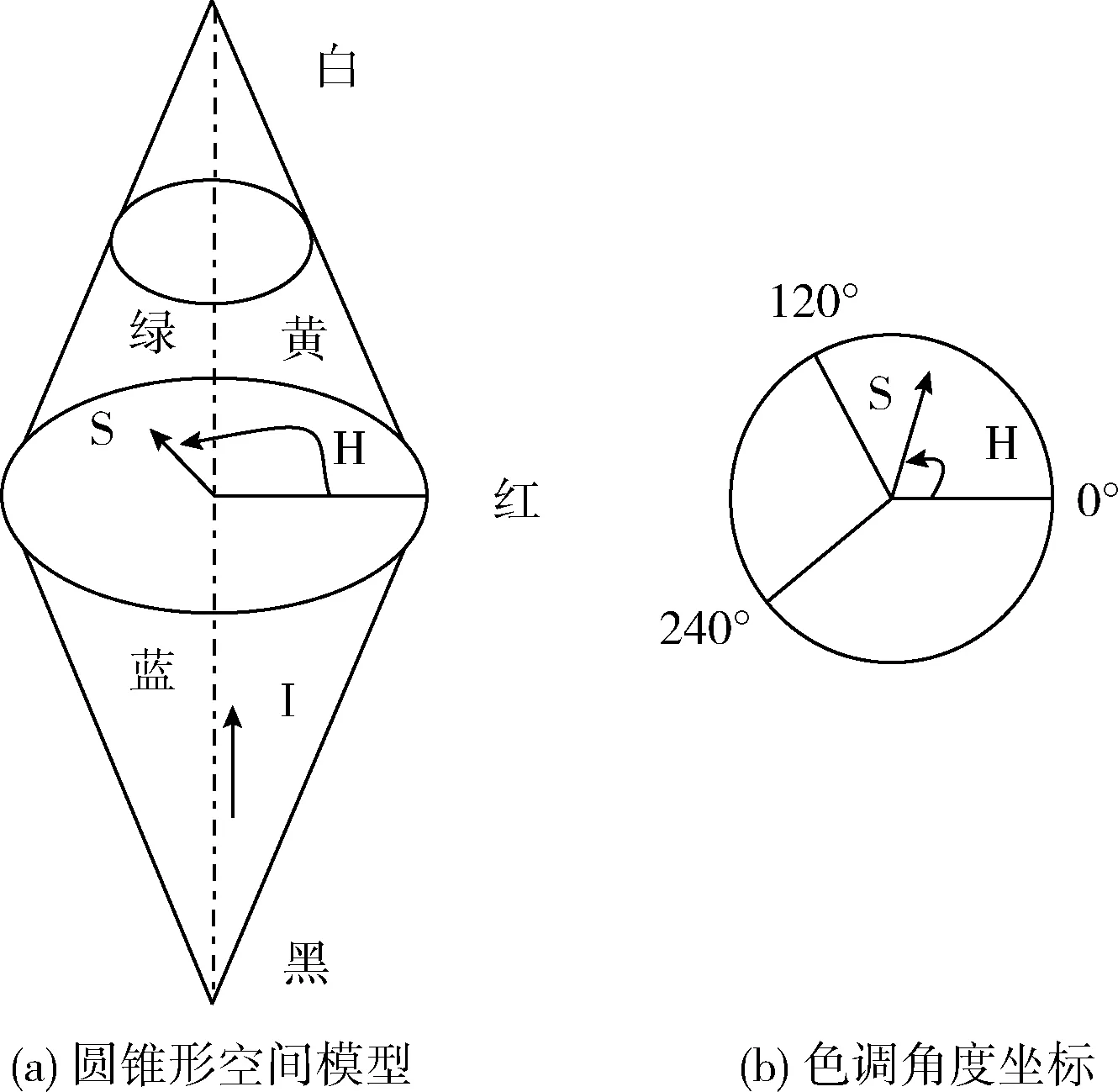

HIS颜色空间是一种符合人类视觉特点的颜色表达[12],文献[13]通过实验验证了HIS在跟踪方面的性能优于RGB。因此,本文将HIS和HOG特征融合[14,15]应用在KCF跟踪中。

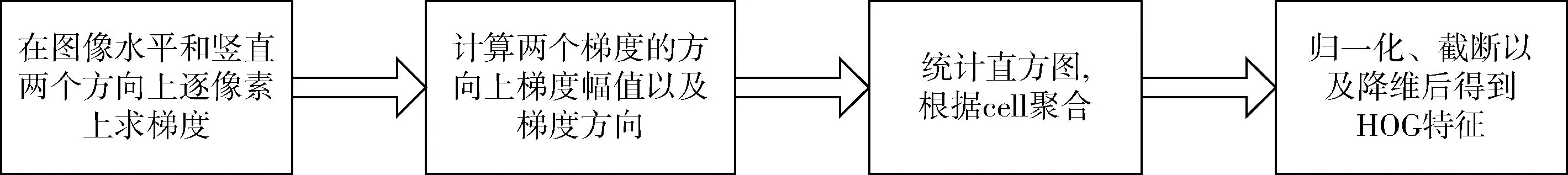

在HOG特征提取时采用了亮度信息,为避免冗余,仅对HS通道信息分析和提取。由图2所示,HIS颜色空间中H和S通道构成极坐标,将色度饱和度分别看作是极坐标中的角度与梯度值。色度计算式为

(1)

(2)

饱和度计算式为

(3)

则特征提取流程为,首先将图像划分成小cells;然后,每个cell上统计梯度角度直方图以及色度饱和度直方图;进而将每个block内所有的cell直方图串联,即可得到该block的梯度角度直方图以及色度饱和度直方图;最后,将图像内所有的block直方图串联,即可得到image的色度饱和度角度梯度直方图。

图2 HIS颜色空间原理

1.3 自适应尺寸

视频序列中目标的尺寸会发生变化,而传统的KCF是固定维度滤波器,因而其输出的跟踪结果尺寸固定不变[16]。为解决这一问题,本文采用如下的尺寸自适应方案。

假设KCF算法得到的当前目标区域为x″,对其进行多尺度变换得到不同尺寸的目标区域

Ii=si·x″,si∈{s1,s2,…,si}

(4)

式(4)中si为尺度因子,设fi为对区域Ii提取色度饱和度-梯度角度融合特征。由相关滤波知识[17]可得,尺度估计的相关滤波器模板为h,其频域为H=Γ(h), 计算公式如下

(5)

1.4 遮挡检测及模型更新

遮挡检测及处理对分类器以及尺寸滤波器h的更新都有至关重要的影响。当遮挡出现时,对模型尺寸估计的可信度降低。因此遮挡是否存在的判断至关重要,而传统的KCF算法本身并未提供遮挡判断及处理机制。本文计算目标区域以及候选区域内RGB这3个通道的直方图特征,然后计算二者之间的巴氏相似度Bat。设定阈值为BatT=0.286。

遮挡检测算法:

输入:候选区域与目标区域的三维直方图计算,并计算二者之间的巴氏系数

输出:用于分类器检测过程中用到的模型参数a

(1)计算第一帧中目标区域的三维直方图为Hist1;

(2)计算候选区域的三维直方图为Hist2;

(3)计算Hist1与Hist2之间的巴氏系数Bat;

(4)当巴氏系数Bat小于阈值BatT=0.286时,判断为遮挡出现,此时学习速率η取值0;否则,判断为未被遮挡,学习速率η取值为0.02。

(5)遮挡处理机制:当遮挡出现时停止对模型的更新,当未出现遮挡时,更新下一帧中用于分类器检测过程中用到的模型参数a。

2 目标跟踪结果及分析

本文将从定性性能评测与定量性能评测两个方面进行跟踪结果的分析。

2.1 定性性能评测

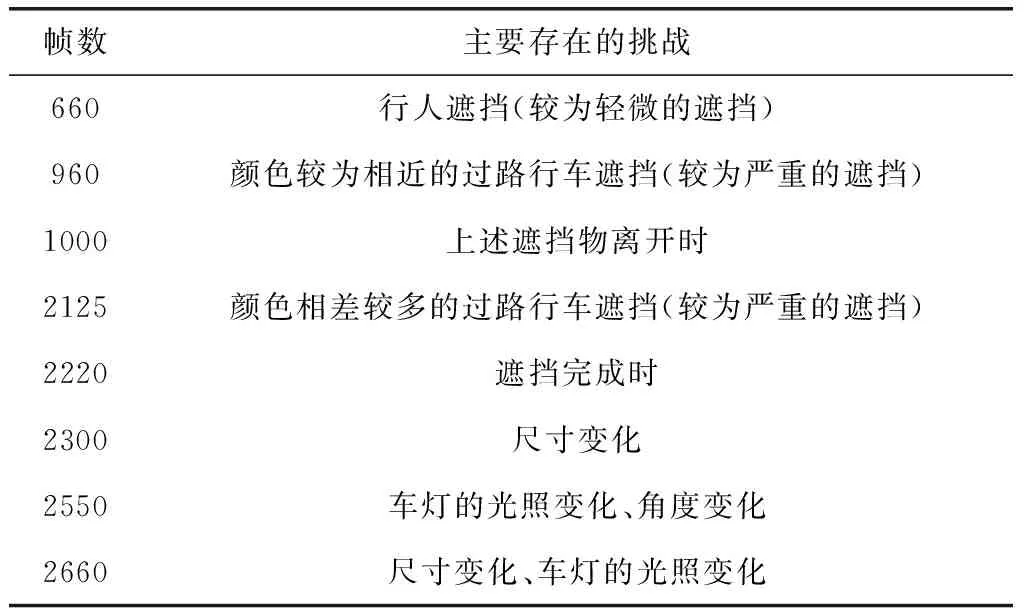

视频目标跟踪中主要存在的挑战见表1。

跟踪结果如下:

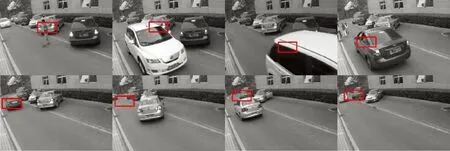

(1)改进的KCF与几种典型的跟踪算法对比

文中视频存在光照变化、目标尺度变化以及背景变化等干扰因素,由图3~图6可知:通过改进的KCF、Mean shift、Frag以及传统KCF这4种算法跟踪视频中同一目标,只有改进的KCF跟踪效果较好。由于改进的KCF能够根据目标尺寸的变化自动调整跟踪窗口的大小,从而减少了背景干扰,进而可以一直对目标的位置以及尺度进行准确评估。

表1 视频存在主要问题

图3 改进的KCF跟踪效果

图4 Mean Shift跟踪效果

图5 Frag跟踪效果

图6 传统 KCF跟踪效果

由图3中的第660帧显示,视频中第660帧中出现了行人遮挡,而改进的KCF跟踪结果表明,该视频跟踪过程并不受背景的干扰;由图4中的第660帧显示,Mean shift算法在视频跟踪过程中受行人遮挡时,跟踪效果出现剧烈变化;由图5中的第660帧显示,Frag在该视频跟踪过程中受行人遮挡时,同样没有受较大影响,依旧可以准确对目标进行定位。由图3第960帧以及第1000帧可知,出现颜色相近的过路行车的较大面积遮挡且遮挡离开时,改进的KCF跟踪在视频跟踪过程并未受到颜色相近的过路行车大面积遮挡的影响,依旧可以准确的锁定目标位置;由图4中的第960帧及第1000帧可知,Mean shift跟踪视频同一目标,受较大面积遮挡且当遮挡离开时,并不能较好锁定目标位置;由图5第960帧及第1000帧可知,Frag在跟踪过程中遮挡物经过时,跟踪框已远离目标,即为跟丢。由图3第2125帧可知,出现颜色相差比较大的过路行车的严重遮挡,改进的KCF跟踪在视频跟踪过程并未受到背景变化影响,依旧可以准确的跟踪目标位置。同时视频中第2220帧显示,改进的KCF跟踪过程,当遮挡目标已经经过,目标并未被跟丢。由图4第2125帧可知,Mean shift跟踪在第660帧出现行人部分遮挡时,目标已经跟丢,并且之后无法重新成功跟踪;由图5第2125帧可知,Frag跟踪在受颜色相近的过路行车的较大面积遮挡时,也已经被遮挡物带走,而无法重新成功跟踪目标。由图3第2300帧中目标尺寸以及角度均发生变化,改进的KCF跟踪结果并未受到较大影响,且能较好适应目标尺寸的变化,准确定位目标;由图4以及图5第2300帧可知,Mean shift及Frag跟踪均无法成功跟踪目标。图3第2550帧中目标自身导致的光照变化以及角度的变化,改进的KCF跟踪结果显示,仍能成功跟踪;由图4及图5 显示, Mean shift以及Frag跟踪均无法成功跟踪目标。图3第2660帧,目标自身引起的光照变化以及尺寸的变化,改进的KCF跟踪结果显示,跟踪结果并未受到影响,仍能较为准确锁定目标位置,并能适应目标尺寸的变化。同样Mean shift以及Frag跟踪均无法成功跟踪。

(2)改进的KCF与传统KCF结果对比

由图6可知,传统KCF跟踪在第1000帧即大面积严重遮挡出现时,且遮挡物与目标颜色相近,进而导致跟丢的情况发生,并且此后无法成功跟回。

2.2 定量性能评测

通常在OTB中均采用精确度和成功率进行定量评估[20,21]。

(1)精确度即为中心误差(center location error,CLE))表示为

(6)

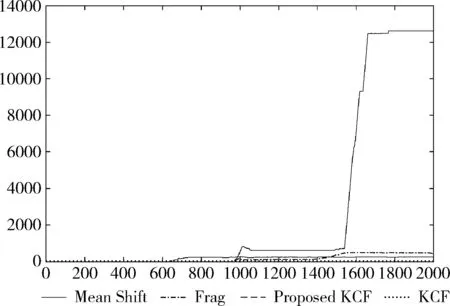

图7 3种跟踪算法精确度

图8 4种跟踪算法的精确度

由图7可知,在Mean Shift算法、Frag算法以及改进的KCF跟踪算法中,改进的KCF算法精确度值趋近于0,且稳定在0附近,因此改进的KCF算法精确度最高,即跟踪效果最好。由图8可知经典KCF算法的精确度值在1000帧之后即出现较大波动,且精确度逐渐降低。从而由图7、图8可知,改进的KCF跟踪算法精确度最高。

当中心位置误差小于某一固定阈值时(一般取该阈值为20像素),增加一次m,n表示视频总帧数

(7)

式(7)表示距离精度。4种跟踪算法中同一视频的总帧数相同,中心位置误差小于该阈值的帧数越多,表明跟踪效果越好,而此时距离精度越大。即DP值越大,表明跟踪效果越好。

(2)重叠率(overlap rate)即为

(8)

(9)

OR值越大,表示跟踪算法得到的跟踪框与手动标记的跟踪框的重叠部分越大,从而表示跟踪效果越好。当OR大于某一阈值时(一般取该阈值为0.5),增加一次sn,SR表示成功跟踪的次数。3种算法在同一视频跟踪中总帧数相同,重叠率大于该阈值的帧数越多,表明跟踪效果越好,因此SR值越大表明跟踪效果越好。

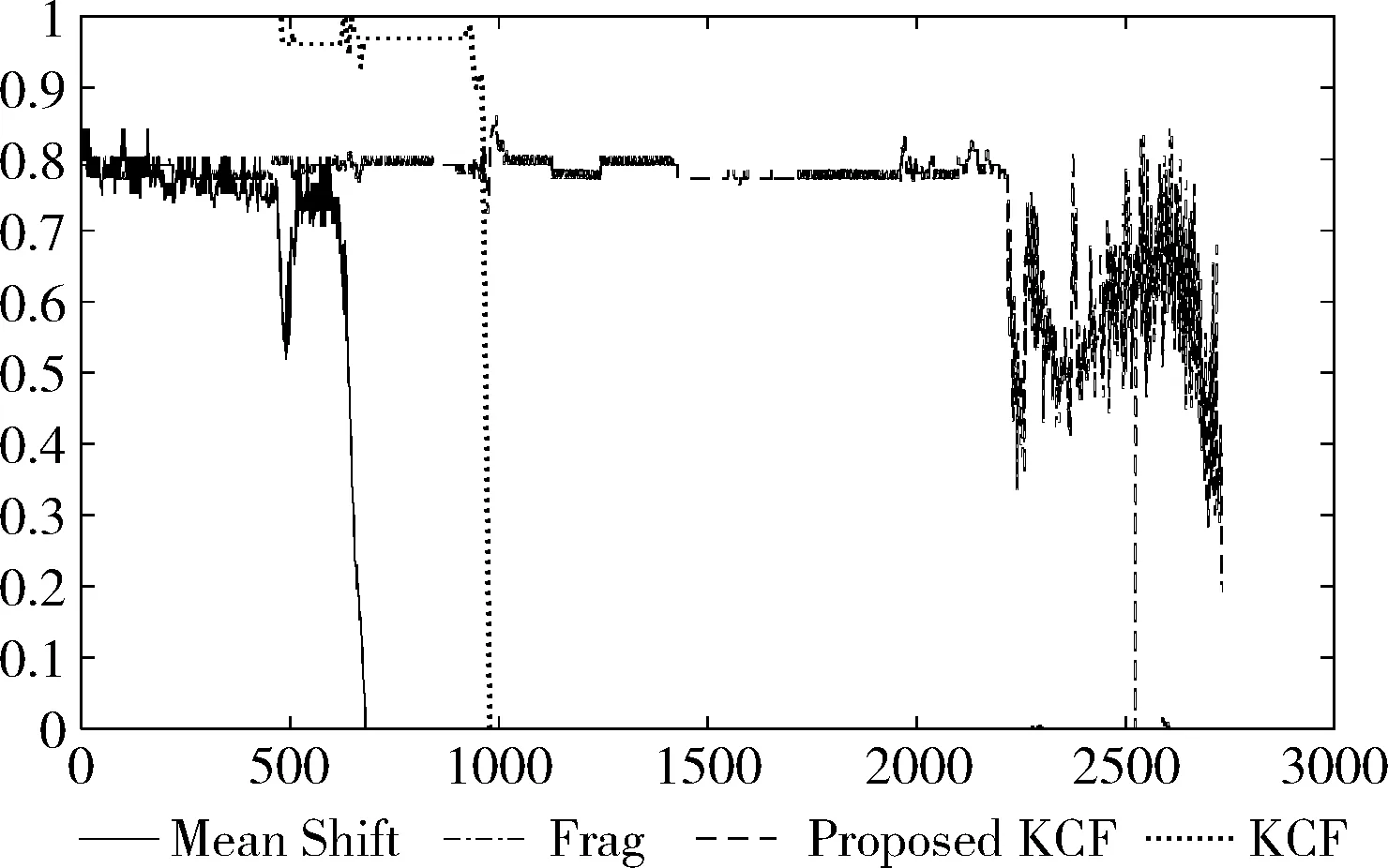

由图9可知,改进的KCF跟踪重叠率值维持在0.8附近且较稳定,而经典KCF算法在0~1000帧出现最高重叠率即为1,而1000帧之后出现较大波动,且重叠率维持在0附近。Mean Shift 算法的重叠率在700帧之后亦出现较大波动,且在700帧之后的重叠率维持在0值附近,Frag算法的重叠率一直维持在0值附近。从而对比4种算法重叠率可知,改进的KCF跟踪效果最好。综合图7~图9可知,与传统的其它3种算法比较,精度值以及重叠率值均取得最佳,即改进的KCF均取得最好的跟踪效果。

图9 4种跟踪算法的重叠率

表2为计算改进的KCF及其它两种算法的SR值,DP值,MCLE值。

表2 定量评价指标值

由表2可知:成功率SR、平均中心误差MCE、以及距离精度DP这3个定量评测标准表明,改进的KCF跟踪效果最好,且平均帧率较高,运算速度较快。

3 结束语

本文使用Window7操作系统,Intel(R)Core(TM)2 Quad CPU 处理器,2.83GHz,4GB内存配置的电脑上运行,采用MATLAB与VS2013混合编写,为便于比较,实验中所有的视频尺寸统一为720×480。

针对传统算法不能很好处理目标跟踪中出现的遮挡、角度变化、尺寸变化以及光照变化引起的跟踪失败问题,采用HOG特征与HS特征相融合的多特征,利用尺度自适应的KCF算法,可以较为准确的将背景与目标分离,同时加进遮挡判断以及处理机制,当出现遮挡时,及时进行遮挡判断及处理,进而达到更好的跟踪效果。并且该算法通过循环移位运算不仅保证较高的帧率,而且提高了算法的准确性与鲁棒性。但该算法存在的缺点是当出现长时间且大面积遮挡或者出现全遮挡时,跟踪效果较差,因此该跟踪算法仍有待改进。

[1]Liu T,Wang G,Yang Q.Real-time part-based visual tracking via adaptive correlation filters[C]//Computer Vision and Pattern Recognition.IEEE,2015:4902-4912.

[2]Duin R P W,Fred A L N,Loog M,et al.Mode seeking clustering by KNN and mean shift evaluated[J].Springer-Verlag Berlin Heidelberg,2012,7626(1):51-59.

[3]GUO Jingming,HE Xin,WEI Zhonghui.New Mean Shift tracking forcolor image based on online support vector machine[J].Chinese Journal of Liquid Crystals and Displays,2014,29(1):120-128(in Chinese).[郭敬明,何昕,魏仲慧.基于在线支持向量机的Mean Shift彩色图像跟踪[J].液晶与显示,2014,29(1):120-128.]

[4]Electrónicas R.Robust fragments based tracking using the integral histogram[J].International Journal of Std & Aids,2014,26(8):321-325.

[5]Henriques J F,Caseiro R,Martins P,et al.Exploiting the circulant structure of tracking-by-detection with kernels[G].LNCS 7575:Proceedings of 12th European Conference on Computer Vision.Berlin:Springer,2012:702-715.

[6]Zhang K H,Zhang L,Yang M H.Real time compressive tracking[J].European Conference on Computer Vision,2012:7574(6):864-877.

[7]Henriques F,Caseiro R,Martins P,et al.High-speed trac-king with kernelized correlation filters[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3):583-596.

[8]Pahikkala T,Airola A,Gieseke F,et al.Unsupervised multi-class regularized least-squares classification[J].Journal of Computer Science & Technology,2014,29(1):585-594.

[9]Takai R,Uchida S,Sato A,et al.Experimental investigation of signal sensing with overlapped FFT based energy detection[C]//International Symposium on Intelligent Signal Processing and Communications Systems.IEEE,2014:225-229.

[10]Zhang N,Donahue J,Girshick R,et al.Part-based R-CNNs for fine-grained category detection[C]//European Confe-rence on Computer Vision.Springer,2014:834-849.

[11]Ling H.Online robust image alignment via iterative convex optimization[C]//IEEE Conference on Computer Vision and Pattern Recognition.IEEE Computer Society,2012:1808-1814.

[12]Joao H,Rui C,Pedro M,et a1.Exploiting the circulant structure of tracking by detection with kernels[C]//Euro-pean Conference on Computer Vision,2012:702-715.

[13]Jiang Y S,Ma J W.Combination features and models for human detection[C]//IEEE Conference on Computer Vision and Pattern Recognition,2015:240-248.

[14]Martin D,Fahad SK,Michael F,et al.Adaptive color attributes for real-time visual tracking[C]//IEEE Conference on Computer Vision and Pattern Recognition,2014:1090-1097.

[15]ZHU Qiuping,YAN Jia,ZHANG Hu,et al.Real-time tracking using multiple features based on compressive sensing[J].Optics and Precision Engineering,2013,21(2):437-444(in Chinese).[朱秋平,颜佳,张虎,等.基于压缩感知的多特征实时跟踪[J].光学精密工程,2013,21(2):437-444.]

[16]ZHANG Lei,WANG Yanjie,SUN Honghai,et al.Adaptive scale object tracking with kernalized correlation filters[J].Optics and Precision Engineering,2016,24(2):448-459(in Chinese).[张雷,王延杰,孙宏海,等.采用核相关滤波器的自适应尺度目标跟踪[J].光学精密工程,2016,24(2):448-459.]

[17]Boddeti V N,Kanade T,Kumar B V K V.Correlation filters for object alignment[C]//Proceedings of the IEEE Confe-rence on Computer Vision and Pattern Recognition.Pisa-taway:IEEE,2013:2291-2298.

[19]Danelljan M,Häger G,Khan F S,et al.Accurate scale estimation for robust visual tracking[J].British Machine Vision Conference,2014,65(2):1-65.

[20]Wu Y,Lim J,Yang M H.Online object tracking:A benchmark[C]//IEEE Conference on Computer Vision and Pattern Recognition.IEEE Computer Society,2013:2411-2418.

[21]Everingham M,Winn J.The PASCAL visual object classes challenge 2010 (VOC2010) development kit contents[C]//International Conference on Machine Learning Challenges:Evaluating Predictive Uncertainty Visual Object Classification.Springer-Verlag,2011:117-176.