iWrite 2.0在线英语作文评分信度研究

2018-03-13李艳玲田夏春

李艳玲 田夏春

iWrite 2.0在线英语作文评分信度研究

李艳玲1田夏春2

(1.天津师范大学 外国语学院,天津 300387;2.北京外研在线教育科技有限公司,北京 100089)

随着国内自动评分技术的飞速发展,写作自动评分方法不断涌现,iWrite英语写作教学与评阅系统2.0应运而生。该系统拥有包含写作教学系统、智能批改引擎和自动评分引擎在内的多项自主知识产权技术,能够实现对英语作文的语言、内容、篇章结构和技术规范四个维度的机器智能评阅。文章从真实语言测试中获取了大量英语作文语料,充分利用一致性和一致率算法,将作文的人工评分与iWrite 2.0的机器评分做了多角度对比,并对iWrite 2.0在线英语作文评分的信度进行了实证研究。

英语写作自动评价系统;iWrite 2.0;信度;一致性;一致率

现代社会的进步和学生数量的大幅度增加,让英语教学和考试中的作文判卷工作成为目前教育系统亟须解决的难题。如何将英语作文的批阅工作即时化、标准化,使之既具有科学性、严谨性,又具有适应性和灵活性,帮助广大教师降低劳动强度、提高工作效率,使学生得到的评分更公平、更公正,是教育工作者需要攻克的难题。

一写作自动评价系统发展历程及研究现状

写作自动评价系统(Automated Essay Scoring,AES)被定义为“给作文评价和评分的计算机技术”[1],它的诞生为上述问题提供了解决方案,其发展大致可分三个阶段:第一阶段是在20世纪60年代,美国杜克大学的Page教授等应美国大学委员会请求研制出Project Essay Grade(PEG),它可以基于一篇文章表面语言特征的分析来评估作文的水平[2]。第二阶段是在20世纪90年代,美国的ETS和Vantage Learning分别开发了E-rater、Intellimetric,它们包含更多有关词法、句法、语篇内容和结构的元素,分析更加复杂;智能论文评估(Intelligent Essay Assessor,IEA)是美国科罗拉多大学的Landauer等研发的成果,是一种基于潜在语义分析(Latent Semantic Analysis)的作文自动评分系统[3]。第三阶段是在21世纪初,由以上评分引擎衍生的自动评价系统,如My Access!、Criterion、Holt Online Essay Scoring和Writing Roadmap等。

在实际可操作性上,以上国外比较成熟的自动评分系统的最大相似之处是:它们都需要利用作文训练集对自动评分系统进行培训[4]。谢贤春[5]认为:“写作自动评价系统再怎么聪明,再怎么具有人工智能,在评判作文时,也毫无例外地要参照人工预先输入的作文样本。”就大规模考试而言,写作自动评价系统的实际可操作性尚可,而在日常作文训练中运用这样的写作自动评价系统,其样本输入的操作难度无疑加大。就目前来看,用在高风险考试中进行实际评分和用在英语教学中对学生的写作能力进行诊断“几乎处于同等重要的地位”[6]。

受国外作文自动评分技术的启发,再根据日常教学的实际需求,国内一些专家学者改进研制了适合中国英语学习者的自动评价工具。2015年,由北京外国语大学中国外语与教育研究中心梁茂成教授及其研究团队和第二语言写作研究、语料库研究、自然语言处理、机器学习等多个研究方向,与外语教学与研究出版社一起,设计并开发了iWrite英语写作教学与评阅系统2.0。

作文作为一种典型的主观题型,判定其评分结果的可靠性程度,即信度(Reliability),是任何一个评价系统存在的重中之重,也一直是测试界的一个研究重点和难题。与国外相比,国内对写作自动评价系统的实证研究数量还十分有限。本研究将从机评与人评的打分结果出发,对iWrite 2.0的信度进行实证研究,以期对产品的进一步优化提供数据支持,并为高校英语写作教师、学生和语言测试人员在使用该系统时提供一定的数据参考。

二研究过程和方法

本研究的文本数据全部来自于2016年11月26日中国外语测评中心举办的“国际人才英语考试”(English Test for International Communication,ETIC)的645篇实考作文。参加本次考试的考生来源广泛,既有高校在读学生,也有来自跨国企业、大型国企、事业单位的职场人士。他们需在指定的25分钟内完成了一篇150词左右的命题作文。作文题目及写作说明如下:

The graphs below show the breakdown of ABB Group revenues in 2015 and 2016. Using the information from the graphs, write a report describing and comparing the changes in the various sectors of ABB Group’s revenues.

图1 2016年11月26日“国际人才英语考试”作文题目及写作说明

1 人工评分

自动评价系统存在的意义在于能够利用多学科技术有效地模拟人工评分,以达到快速评定作文质量的目的。也就是说,人工评分的信度起着举足轻重的作用,只有有效地拟合了具有较高信度的人工评分,iWrite 2.0的评分才有价值。

在本研究中,参加此次作文评分的两位评分员均为具有丰富写作教学和评分经验、多次参加全国性外语考试作文阅卷的教师,能够积极地参加评分方案(Marking Scheme)的制定和讨论工作。根据考试组委会规定,作文满分为15分,考生的最后得分将取两位评分员的平均分。当两位教师所评的总分之差≥5分时,则由第三位评分员对作文进行第三次评分,最终取三个分数中两个最接近的分数的平均值——这契合了Johnson等的观点,即如果各评分员评出的得分具有可接受的信度,将各评分员的评分结果进行平均处理,得到的均值将更加可靠[7]。

语言测试领域的作文评分方法主要有整体评分(Holistic Scoring)和分析型评分(Analytical Scoring)两种。根据Weigle[8]的分析,虽然分析型评分方法耗时长、开支大,但在信度方面往往要高于整体评分方法。本次考试为了尽可能地保证人工评分的信度,排除了时间、成本的困难,采用了分析型评分方法,具体包括内容、结构、语言三项。

2 机器评分

iWrite 2.0广泛汲取了智能化英语作文自动评阅(Diagnostic Readers)研究的多项成果,以语言测试学和二语写作理论为基础,利用多元回归的统计技术、智能化自然语言处理技术和信息检索技术等其它可能利用的技术,完成机器学习训练集的过程,使一篇未评分的作文和基于语料库建立的评分模型分数量表上的某个数值形成对应关系,从而能够为待评分作文进行自动评分。经过对桂诗春等[9]、文秋芳等[10]几百种作文评价标准的调研和上万次作文的试测,iWrite 2.0确定了从作文的语言、内容、篇章结构和技术规范四个维度进行全方位考察的评价构念。在利用iWrite 2.0为本次的645篇作文批量跑分之前,本研究布置了写作任务,设定了作文题目、字数和格式要求,并围绕主题输入了五个英文关键词:Revenue、Change、Subscription、Advertising、Sponsorship。

本研究将非纯文本格式的文档转换为通用的纯文本格式,通过iWrite 2.0的后台对所收集到的645篇语料进行了批量跑分、统一导出和预处理。最终,每一篇作文都得到1个总分和4个维度下各自分项的小分。根据研究需要,本研究把机评总分从百分制换算成15分制,将机评结果同人评结果一一对应,并保存为Microsoft Excel格式,以便用于数据清理和统计软件读入。

三数据分析

作为一种面向市场的自动评价系统,iWrite 2.0的评分信度应该满足统计学和测试学的要求。本研究中的信度分析是指组间信度(Inter-rater Reliability)分析,即:将计算机视作一个评分员,将其评分结果与其他人工评分员的评分结果进行对比,以确定机器评分是否可靠。在这种情况下,采用一种科学的、能够衡量评分员间信度的指标对测量结果的评价是非常重要的。

本研究将利用社会科学统计软件包SPSS 17.0对所收集的数据进行分析,所用的算法包括一致性方法和一致率方法。二者是一对相仿的概念,但有不同的测量工具,能从多个层面对信度进行说明,具有很好的互补性。

1 一致性方法(Consistency Estimates)

一致性方法既是“统计学中最常用的信度测量方法”[11],也被认为是“测试学中最常用的信度测量方法”[12]。常见的一致性分析方法包括皮尔逊相关系数和克隆巴赫系数。

(1)皮尔逊相关系数(Pearson Correlation Coefficient)

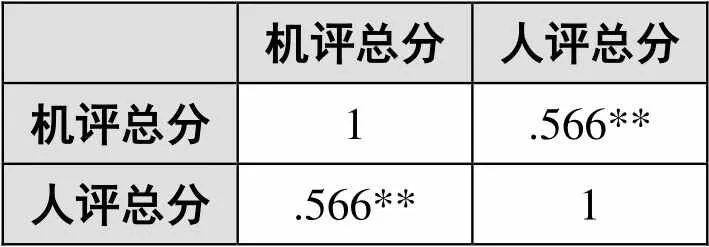

皮尔逊相关系数是一种线性相关系数,用来反映两个变量线性相关强弱的程度。相关系数用r表示,值介于1和-1之间;r的绝对值越大,表明相关性越强。在本实验中,将机评总分和人评总分作为变量,求得二者的相关系数,如表1所示。

表1 iWrite机器评分与人工评分之间的皮尔逊相关系数

表2 iWrite机器评分与人工评分之间的克隆巴赫系数

通过相关性来检验评分信度,当被检视的变量的案例数大于统计学常规要求的30时,其测量出来的结果就具有可推广性。在本研究中,作文样本已达到645,每篇作文均有机器评分与人工评分,如果验证结果表明两组评分结果的相关性可以稳定在r=0.70以上,则可以认为iWrite 2.0机器评分系统是可靠的。从表1可以看出,二者的皮尔逊相关系数已经达到了0.566,说明二者具有较强的相关性,结果可以接受。

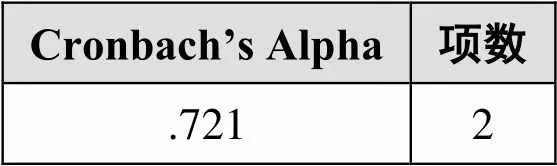

(2)克隆巴赫系数(Cronbach’s Alpha)

克隆巴赫系数作为信度的指标,是目前社会科学研究最常使用的信度评估工具,依一定公式估量测验的内部一致性。一般来说,该系数越大,表明被检试对象的信度越高。在本实验中,求得机评总分和人评总分的可靠性统计量结果如表2所示。

在基础研究中,信度至少应达到0.80才可接受;在探索性研究中,信度只要达到0.70就可接受;介于0.70~0.98均属高信度,而低于0.35则为低信度,必须予以拒绝。根据表2可得,iWrite 2.0机器评分的信度达到了0.721,这是一个令人十分满意的结果,如此高的信度在大部分主观题考试评分中可能很难达到。

2 一致率方法(Consensus Estimates)

除计算一致性外,国外作文自动评分系统(如E-rater、IEA)还常常通过测量一致率来报告信度。常见的一致率分析方法包括完全吻合率、完全及相邻吻合率和卡帕系数。

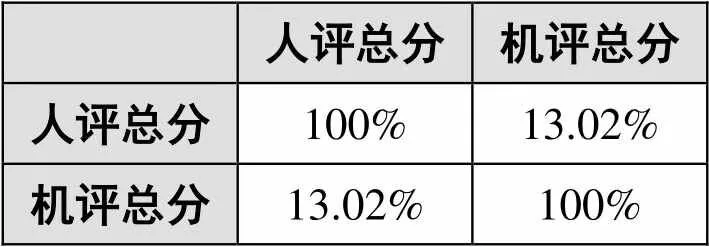

(1)完全吻合率(Exact Agreement)

完全吻合率是一种备受推崇的信度测量方法,代表两评分员给出的得分完全相同的案例数占总案例数的百分比。比如两评分员按照1~10的评分量表对100篇作文进行评分,对于其中的50篇论文,两评分员给出了相同的评分结果,此时完全吻合率则为50%。为了便于比较,本研究分别采用了0~15的评分量表和0~5共6个等级的评分量表(GMAT标准),求得完全吻合率的结果,如表3、表4所示。

表3 0~15评分量表上iWrite机器评分与人工评分之间的完全吻合率

表4 0~5评分量表上iWrite机器评分与人工评分之间的完全吻合率

由表3、表4可得,在0~15评分量表上,iWrite 2.0与人工评分间的完全吻合率达13.02%;而在0~5评分量表上,则达到了38.45%。此结果令人满意,信度指标达到了统计学和测试学的要求。

表5 0~15评分量表上iWrite机器评分与人工评分之间的完全及相邻吻合率

表6 0~5评分量表上iWrite机器评分与人工评分之间的完全及相邻吻合率

(2)完全及相邻吻合率(Exact-Plus-Adjacent Agreement)

完全及相邻吻合率扩大了一致率的范围,它方便计算,也易于解释。如两评分员按照1~10的评分量表对100篇作文进行评分,如果两位评分员对同一篇作文分别给出了5分和6分,那么仍然可以认为两者之间具有一致性。本研究参照完全吻合率的评分量表,求得人评总分与机评总分的完全及相邻吻合率,如表5、表6所示。

由表5、表6可得,在此次研究中,iWrite 2.0与人工评分间的完全及相邻吻合率最低是40.62%(在0~15评分量表上),最高达到了97.98%(在0~5评分量表上),这是很高的信度。

(3)卡帕系数(Kappa Statistics)

与吻合百分率主要适用于分类数据(Categorical Data)不同的是,卡帕系数是一种计算分类精度的方法。它通常落在0~1间,0.0~0.20是极低的一致率(Slight)、0.21~0.40为一般的一致率(Fair)、0.41~0.60代表中等的一致率(Moderate)、0.61~0.80表示高度的一致率(Substantial)、0.81~1.0则说明几乎完全一致(Almost Perfect)。本研究参照吻合百分率的评分量表,求得人评总分与机评总分的卡帕系数,如表7、表8所示。

表7 0~15评分量表上iWrite机器评分与人工评分之间的卡帕系数

表8 0~5评分量表上iWrite机器评分与人工评分之间的卡帕系数

由表7、表8可得,在0~15评分量表上,iWrite 2.0与人工评分间的卡帕系数是0.1280;在0~5评分量表上,卡帕系数达到了0.3518,表明iWrite 2.0与人工评分结果高度一致。

综上所述,无论是从皮尔逊相关系数、克隆巴赫系数、完全吻合率、完全及相邻吻合率来看,还是从卡帕系数来看,iWrite 2.0作文评分的信度都是非常理想的。

四结语

通过对645篇实考作文的机评、人评总分的一致性和一致率的计算,本研究获得了关于iWrite 2.0作文评分信度的实证数据。数据分析结果表明,iWrite 2.0机器评分几乎可与人工评分相媲美。本研究认为,iWrite 2.0的评分信度已经达到可推广水平,可以在考试及日常写作教学中使用。全面助力教师提升写作教学效果,真正实现学生写作水平的提高,是拥有领先的团队阵容、强大的研究支撑和雄厚的技术支持的iWrite 2.0的长期努力方向。

[1]Shermis M D, Burstein J. Automated essay scoring: A cross-disciplinary perspective[C]. Mahwah, NJ: Lawrence Erlbaum Associates, 2003:7-16.

[2]Page E. Project essay grade: PEG[A].Automated Essay Scoring: A Cross-disciplinary Perspective, 2003:43-54.

[3]Landauer T K, Laham D, Foltz P W. Automated scoring and annotation of essays with the Intelligent Essay Assessor[A]. Automated Essay Scoring: A Cross-Disciplinary Perspective, 2003:87-112.

[4]葛诗利,陈潇潇.大学英语作文自动评分研究中的问题及对策[J].山东外语教育,2009,(3):21-26.

[5]谢贤春.英语作文自动评分及其效度,信度与可操作性探讨[J].江西师范大学学报(哲学社会科学版),2010,(2):136-140.

[6]韩宁.几个英语作文自动评分系统的原理与评述[J].中国考试(研究版),2009,(3):38-44.

[7]梁茂成.大规模考试英语作文自动评分系统的研制[M].北京:高等教育出版社,2011:21-22.

[8]Weigle S C. Assessing writing[M]. Cambridge: Cambridge University Press, 2002:1-282.

[9]桂诗春,杨惠中.中国学习者语料库[M].上海:上海外语教育出版社,2003:710-714.

[10]文秋芳,刘润清.从英语议论文分析大学生抽象思维特点[J].外国语(上海外国语大学学报),2006,(2):49-58.

[11]Stemler S E. A comparison of consensus, consistency, and measurement approaches to estimating interrater reliability[J]. Practical Assessment, 2004,(4):13-49.

[12]McNamara T. Measuring second language performance[M]. New York: Addison Wesley Longman Limited, 1996:310-323.

编辑:小西

An Empirical Research into the Reliability of iWrite 2.0

LI Yan-ling1TIAN Xia-chun2

iWrite English Writing Assessment and Evaluation System 2.0, an online tool for evaluating students’ English written work, is grounded on the early works of Automated Writing Assessment and the theories of Second Language Writing. It contains sophisticated Natural Language Processing techniques,Supervised Machine Learning, etc. Therefore, it is designed to evaluate all major constructs of writing quality, including language, content, organization, and mechanics as well. Through analyzing a large amount of natural English writing materials with algorithms of both consistency and consensus, the present study gave a multi-perspective comparison between the manual evaluation and iWrite 2.0 evaluation, and from which the evaluation reliability of iWrite 2.0 was demonstrated.

Automated Essay Scoring; iWrite 2.0; reliability; consistency estimates; consensus estimates

G40-057

A

1009—8097(2018)02—0075—06

10.3969/j.issn.1009-8097.2018.02.011

李艳玲,副教授,博士,研究方向为英语教学评价体系和西方文化史,邮箱为maggielee1010@163.com。

2017年6月10日