蜂窝式立体元图像阵列的生成

2018-03-10王世刚

武 伟,王世刚,赵 岩,韦 健,钟 诚

(1.吉林大学 通信工程学院,长春 130012;2.长春工业大学 计算机科学与工程学院,长春 130012;3.长春工业大学 人文学院,长春 130012)

0 引 言

组合成像技术是目前3D领域中研究的热点,属于真三维立体显示技术,最早由Lippmann[1]于1908年提出,由于当时制造工艺相对落后,此技术一直停滞不前[2-4]。近年来,随着工业生产的发展以及3D影片的热播,立体显示技术又一次成为国内外学者研究的重点。在众多的3D显示方法中,组合成像技术的应用前景最广,它可以为观看者提供连续视差和全真色彩的图像,而且不需要佩戴任何装置,记录和重现的三维场景都是以二维图像的方式存储,使得组合成像技术可以使用现有的图像处理方法来传输和处理。

传统组合成像系统中均使用圆形孔径透镜阵列,随着微透镜阵列制作工艺的发展,已出现六边形孔径透镜阵列[5]。因此,探索六边形孔径透镜阵列在组合成像系统中的应用,具有重要的研究意义。首先要生成可用的视频源即立体元图像阵列。

立体元图像的生成可以采用真实拍摄和计算机虚拟生成两种方法[6]。真实拍摄有两种,一种是将相机以阵列的形式排列来模拟微透镜阵列的排列结构[7-9]。该方法需对相机进行标定以保证所有相机的光轴都相互平行且在同一平面,随着相机数量的增加,标定的难度也加大。真实拍摄的另一种是透镜阵列直接获取立体元图像阵列,这种方法简单、易实现,但存在空间反转和串扰等问题[10,11]。

本文采用计算机模拟组合成像系统的记录过程,利用虚拟相机模拟透镜阵列生成立体元图像阵列,每个透镜元相对独立,可以有效避免串扰,且虚拟相机可以直接生成无反转的图像,因而避免了真实立体显示时的空间反转问题。综上,利用计算机虚拟生成蜂窝式立体元图像阵列,可以推进蜂窝式透镜阵列在组合成像系统中应用的研究,节约成本。

1 基本原理

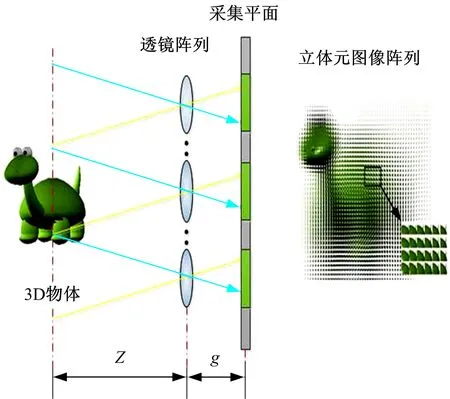

理想的组合成像系统主要有记录和显示两部分组成,如图1所示。在记录阶段,微透镜阵列从不同角度获取物体的三维信息,并将信息以二维图像的形式记录在成像平面上。在显示过程中,将成像平面放置在微透镜阵列的焦平面上,根据光路可逆的原理就可以重建物体的三维信息[12]。

图1 理想组合成像系统Fig.1 Ideal integral imaging system

计算机虚拟生成立体元图像阵列的基本原理如图2所示。通过计算得出虚拟3D物体对应每个虚拟透镜元中的视点图像。在计算中,不考虑有限孔径引起的衍射和离焦引起的模糊。因此,计算生成的视点图像就是3D物体通过小孔在采集平面的投影。为了避免串扰,需将计算的视点图像根据虚拟透镜元的大小进行裁剪。通常每个立体元图像的位置和大小与透镜元一致。

图2 立体元图像阵列的生成Fig.2 Elemental image generation

2 本文方法

2.1 建立虚拟相机阵列

蜂窝式透镜阵列的每一个透镜元均为六边形,并以蜂窝状结构紧密排列。传统立体元图像阵列都是采用水平或垂直方向上直接投影的方式,这对于蜂窝式透镜阵列是不可行的。因此要生成可以用于蜂窝式透镜成像系统的立体元图像阵列,首先要分析蜂窝式透镜阵列的结构。

图3 蜂窝式透镜阵列排列结构Fig.3 Structure of hexagonal lenslet array

(1)

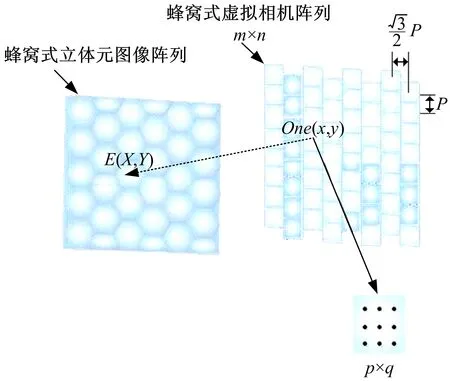

生成的蜂窝式虚拟相机矩阵如图4所示。

图4 蜂窝式虚拟相机阵列Fig.4 Hexagonal virtual camera array

虚拟相机的焦距、视角与显示平台中蜂窝式透镜阵列的光学参数一致。虚拟相机的分辨率r为:

(2)

式中:M×N、H×W分别为显示设备的分辨率及外形尺寸。

2.2 参数设置

根据显示过程所需的立体元图像阵列的数量、分辨率以及景深等相关参数,设置物距、虚拟相机的相机间隔、焦距、立体元图像分辨率等参数。具体方法如图5所示。

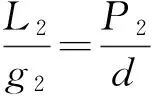

根据光线光学可以得到:

图5 采集端与显示端的关系Fig.5 Relation ship between acquisition and display

(3)

(4)

(5)

式中:L1、g1、P1、D为采集端的物距、相机焦距、相机阵列镜头间距、相邻立体元图像间视差;L2、g2、P2、d分别为显示端的像距、透镜到显示平面的距离、透镜阵列间距、相邻立体元图像间视差;β为放大系数。

将其带入组合成像系统横向分辨率RI、可观测视角θ和景深ΔZ的关系式中,即可得到相机阵列记录物距L1、相机间隔P1与三维再现像显示特性的关系为:

(6)

(7)

L2=Nf2

(8)

式中:Rd是显示平面的分辨率;f2是透镜阵列的焦距。可以由上式建立组合成像系统显示端与采集端的联系,根据显示端参数设置采集端立体元图像阵列的生成。

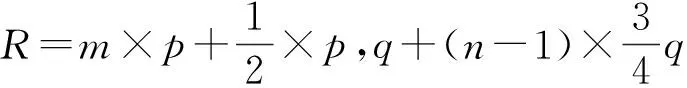

2.3 建立投影模型

建立蜂窝式透镜阵列的投影模型,如图6所示。设相机矩阵为m×n,单个立体元图像的分辨率为p×q,则投影后的蜂窝式立体元图像阵列的分辨率R为:

(9)

虚拟相机中第(i,j)幅立体元图像中的像素点One(x,y)与蜂窝式立体元图像阵列中像素点E(X,Y)的投影关系为:

(10)

图6 虚拟相机阵列与蜂窝式立体元图像阵列的投影模型Fig.6 Pixel mapping between virtual camera arrayand hexagonal lenslet array

3 实验验证

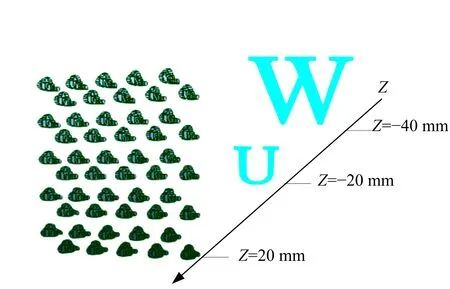

虚拟3D物体由字母“W”、“U”组成,距离虚拟透镜阵列的距离Z分别为60、40 mm,如图7所示。组合成像真实立体显示平台如图8所示。

图7 虚拟场景Fig.7 Virtual scene

图8 组合成像显示平台Fig.8 Integral imaging display plane

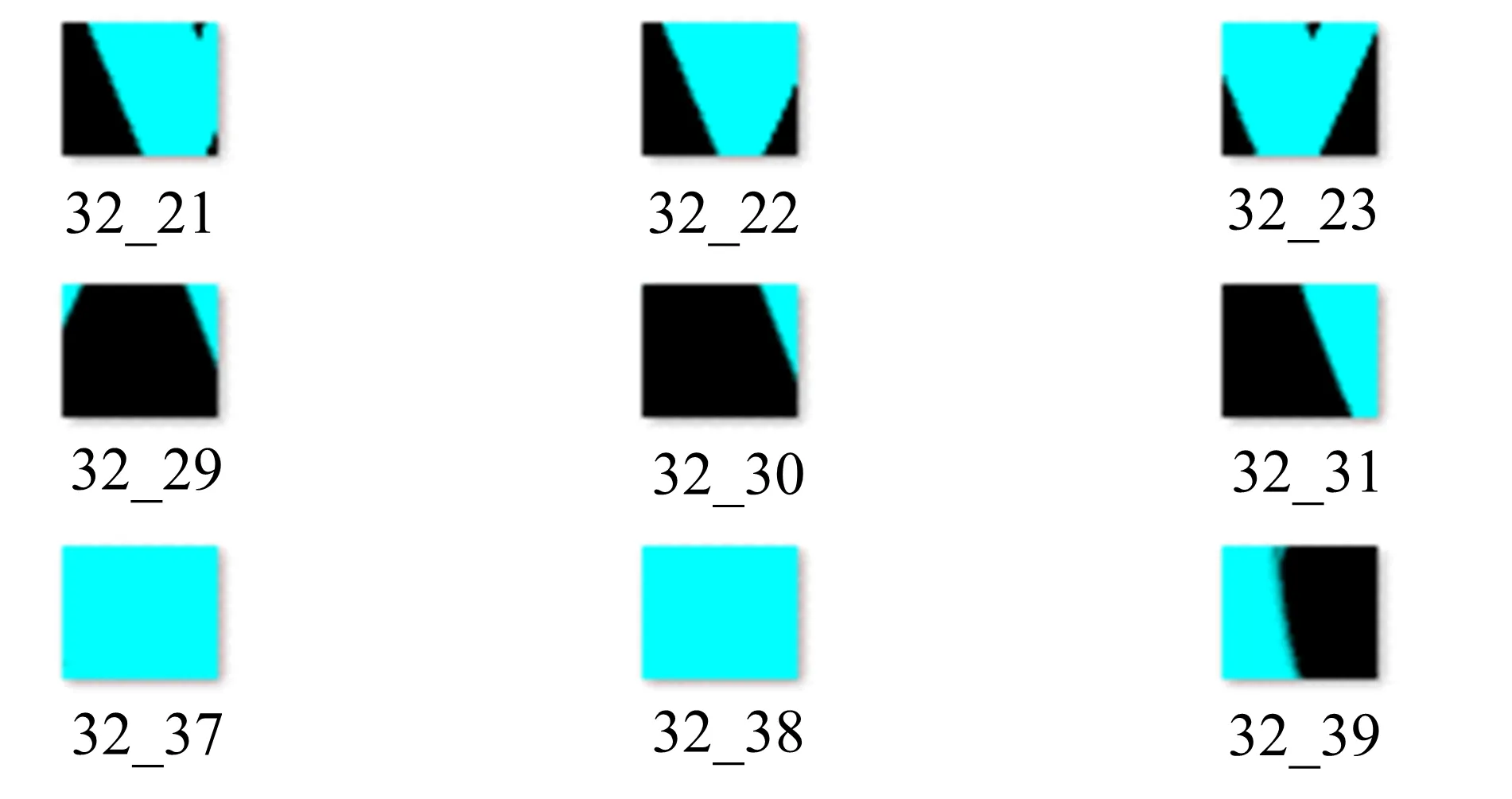

蜂窝式虚拟相机阵列生成的立体元图像如图9所示。

图9 立体元图像Fig.9 Elemental images

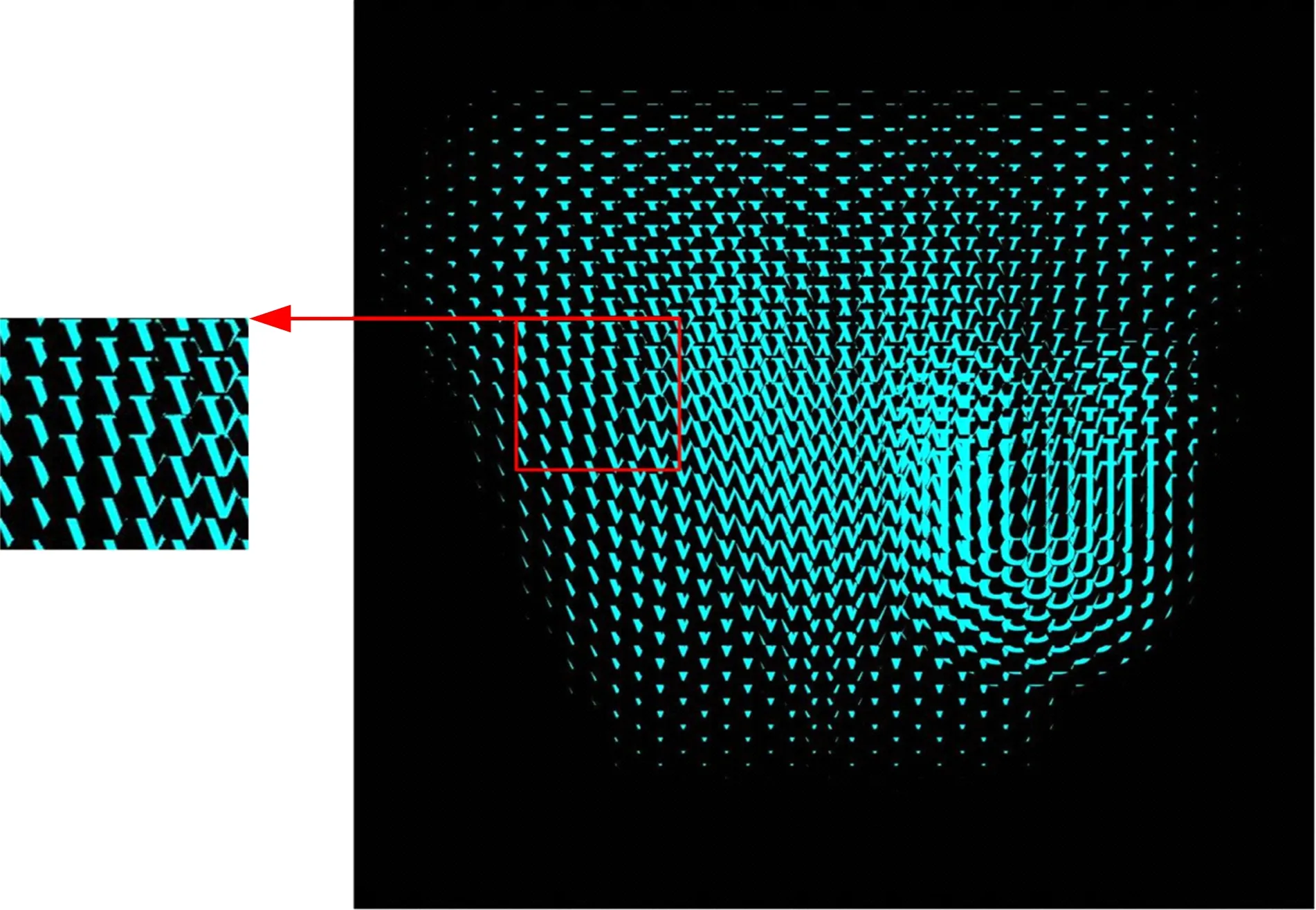

根据式(10)将所有立体元图像投影生成蜂窝式立体元图像阵列。

由于本文采用直接投影的方式生成蜂窝式立体元图像阵列,所以从图10的局部放大图中可以看出,每个立体元图像都是正立的,不存在反转,且立体元图像间也没有串扰的现象。

图10 蜂窝式立体元图像阵列Fig.10 Hexagonal elemental image array

将蜂窝式立体元图像阵列放置于组合成像真实立体显示平台,显示效果如图11所示。

图11 真实立体显示效果Fig.11 True stereo display

从真实立体显示效果中可以清晰看到不同视角下的立体图像,且各视角间的视差明显。例如左右视点间字母U与字母W的间距不同。上下视点间字母U与字母W的相对高度不同。以上实验结果说明,本文提出的基于蜂窝式透镜阵列的立体元图像阵列生成方法是正确、有效的。

4 结束语

本文提出了一种基于蜂窝式透镜阵列立体元图像阵列的生成方法。利用虚拟相机模拟组合成像系统的记录过程,根据显示端透镜阵列和显示器的参数设置虚拟相机的采集参数,采用直接投影的方式生成立体元图像阵列。实验结果表明,该方法能够生成具有连续水平和垂直视差的蜂窝式立体元图像阵列,能真实再现3D物体的空间信息。本文方法既克服了透镜阵列直接采集存在空间反转和串扰的问题,又为基于蜂窝式透镜阵列的研究提供了丰富的图像源。

[1] Lippmann M G. Epreuves reversible donnant la sensatioin du relief [J]. Journal of Physiology, 1908,1(7):821-825.

[2] 王琼华. 3D显示技术与器件[M]. 北京:科学出版社,2011.

[3] Ives H E. Optical properties of alippmann lenticulated sheet [J]. Journal of the Optical Society of America, 1931, 21(3):171-176.

[4] Okano F, Hoshino H, Arai J, et al. Real-time pickup method for a three-dimensional image based on integral photography [J]. Applied Optics, 1997, 36(7): 1598-1603.

[5] 刘德森. 微小光学与微透镜阵列[M]. 北京:科学出版社,2013.

[6] Hong J, Kim Y, Choi H J, et al. Three-dimensional display technologies of recent interest: principles, status, and issues [J]. Applied Optics, 2011, 50(34): 87-115.

[7] Javidi B, Sola-Pikabea J, Martinez-Corral M. Breakthroughs in photonics 2014: recent advances in 3-D integral imaging sensing and display [J]. IEEE Photonics Journal, 2015, 7(3): 0700907.

[8] Park S, Yeom J, Jeong Y, et al. Recent issues on integral imaging and its applications [J]. Journal of Information Display, 2014, 15(1): 37-46.

[9] Luo C G, Wang Q H, Deng H, et al. Extended depth of field in integral imaging pick up process based on amplitude modulated sensor arrays [J]. Optics Engineering, 2015, 54(7): 073108-14.

[10] Kishk S, Javidi B. Improved resolution 3D object sensing and recognition using time multiplexed computational integral imaging [J]. Optics Express, 2003, 11(26): 3528-3541.

[11] Hong J, Park J H, Jung S, et al. Depth-enhanced integral imaging by use of optical path control [J]. Optics Letters, 2004, 29(15): 1790-1792.

[12] Arai J, Okano F, Hoshino H, et al. Gradient-index lens-array method based on real-time integral photography for three-dimensional images [J]. Applied Optics, 1998, 37(11): 2034-2045.