面向高级辅助驾驶雷达和视觉传感器信息融合算法的研究

2018-01-25杨鑫刘威林辉

杨鑫,刘威,林辉

(1.东软集团股份有限公司,辽宁 沈阳 110179;2.东北大学 辽宁 沈阳110819)

引言

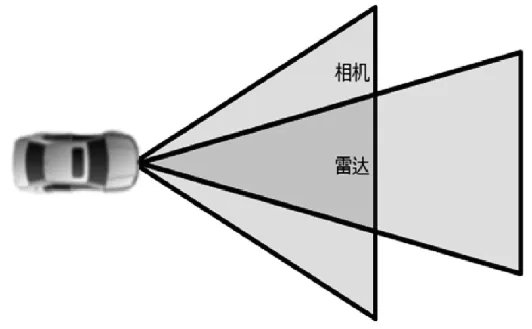

随着人们对汽车安全技术的日益重视,高级辅助驾驶系统的研究与应用得到了快速的发展。环境感知技术是高级辅助驾驶系统的重要研究内容,对于减少车辆碰撞交通事故,提高车辆的道路行驶安全性具有重要意义。雷达传感器和视觉传感器作为环境感知系统的重要组成部分,被广泛应用在多种汽车高级辅助驾驶系统中。

雷达传感器对环境适应性强,对距离信息与速度信息提取方面具有优势,然而其存在原始数据噪声较大,漏检率与误检率较高,角度分辨率不高的劣势。视觉传感器获取信息丰富,成本较低,尤其在目标识别分类具有较大优势,但其存在实时性较差,易受环境影响等不足[1]。为此,本文提出了一种基于毫米波雷达与高清相机信息融合的目标识别算法。

雷达和视觉传感器融合算法利用雷达与视觉不同测量结果,通过对两种传感器检测信息的比较分析处理,提取出前方道路的目标信息,用于对车辆当前行驶环境做出最佳的估计。该算法可弥补单传感器在获取道路环境感知信息量不够丰富的缺陷,尤其在复杂交通工况下,极大地提高了车辆环境感知系统的可靠性、准确性与适应性。

图1 雷达与视觉融合系统功能图

1 ADAS系统的数据融合结构模型

雷达和视觉传感器融合分为数据级融合、特征层融合和决策层融合[2]。数据级的信息融合是最基本的融合方式,即对传感器信息进行简单预处理后就进行融合,其运算量较大实时性较差,但可以最为完整的涵盖各信息源。特征级的信息融合将信息源提取其特征信息然后进行融合,其优点在于提高了信息融合的效率。决策级的信息融合是一种高层级的融合方式,按照一般来讲需要对决策可信度进行评价,综合各优化指标得到决策结果。各级融合的详细指标对比见表1。

表1 不同层级融合算法比较

图2 雷达与相机数据融合流程图

本文的雷达传感器和视觉传感器融合是决策级的信息融合,信息融合流程如图2所示。根据雷达和摄像机安装相对位置,建立雷达坐标系和摄像机坐标系转换关系,构建数据空间融合模型。将雷达和视觉传感器得到的观测值预处理后,与上一个周期的目标值相匹配,对已经确认的雷达和图像的观测值进行融合,得到当前目标值,构建数据时间融合模型。对融合的目标进行多周期管理,进行目标滤波处理。

2 ADAS数据融合算法

雷达与视觉传感器融合算法主要结合雷达与视觉两个常用传感器的目标探测各自优点,使得被探测的目标能够被更加精确和及时地识别。整个算法的实现主要由三个部分组成:时间空间同步、数据匹配关联、目标滤波。

2.1 雷达传感器和视觉传感器的数据同步

2.1.1 雷达与视觉传感器空间同步

毫米波雷达的扫描平面为二维平面,先确定雷达安装在车辆的位置,然后将雷达测量的点转化为车辆坐标系中的某点。本文采用三线式激光仪找出车辆的中轴线,使雷达中心轴线与车辆中心轴线重合,然后安装雷达时需要确保其水平角度、横摆角度和俯仰角度满足安装要求。其中水平角度和俯仰角度可以通过角度尺和重锤等工具进行测量,并通过调整雷达安装机构来满足雷达安装的角度要求。横摆角误差需要以截面积较小的锥状障碍物作为雷达探测目标,通过标定软件,进行误差补偿。

相机标定包括内参标定和外参标定。相机内参由其硬件特性决定,外参获得需先调整相机俯仰角、侧倾角和横摆角,然后测量相机距离车辆后轴的距离、水平高度和横向偏移距离,并将其结果与车辆坐标系进行坐标转换,即可完成相机标定。

雷达与视觉传感器空间同步就是将不同传感器坐标系的测量值转换到同一个坐标系中。由于毫米波雷达位于前保险杆中心,只需将视觉的测量点通过坐标系转换到该位置即可。

图3 雷达与相机空间同步

2.1.2 雷达与视觉传感器时间同步

雷达和视觉信息在除在空间上需要进行融合,还需要传感器在时间上同步采集数据,实现数据时间上的融合。

多传感器信息融合的时间配准就是将各传感器关于同一目标的时间异步测量数据通过某种算法处理统一到同步的融合处理时刻。在同一时间片内对各传感器采集的目标观测数据进行内插、外推,将高精度观测时间上的数据推算到低精度时间点上,以实现各传感器时间上的匹配。其算法为:先取定时间片,对应融合时间片可以选为毫秒级;然后再将各传感器观测数据按测量精度进行增量排序;最后将各高精度观测数据分别向最低精度时间点,按照运动状态进行内插、外推,从而形成一系列等间隔的目标观测数据以进行融合处理。

图4 内插外推法的传感器采样序列图

设传感器A和传感器B对同一目标进行观测,在同一时间片内的采样数据序列如图1所示,传感器A在Tai时刻的测量数据为(Xai,Yai,Vxai,Vyai),传感器B在Tbj时刻的测量数据为(Xbj,Ybj,Vxbj,Vybj),设由传感器 A 向传感器 B的采样时刻进行时间配准,配准后的数据用(Xaibj,Yaibj,)表示。

内插外推法的配准公式为:

由于雷达和摄像机工作频率不同,以频率较低的雷达数据为基准,采用多线程同步程序设计方式,构建多传感器数据时间融合模型[3]。每次当毫米波雷达数据刷新时,采录当前帧的图像数据,即完成共同采样一帧雷达与视觉融合的数据,从而保证了毫米波雷达数据和视觉数据时间上的同步。

2.2 数据匹配关联

在获得了决策级的视觉和雷达目标后,将单独传感器(毫米波雷达或高清相机)测量的目标进行预处理,对已经挑选出的雷达信号和视觉信号进行关联性和区分性计算,辨识两组独立来源的信息是否指同一目标。

2.2.1 传感器数据预处理

视觉传感器目标分类为车辆和行人,将检测结果按照行人和车辆进行分类数据预处理,可以减小融合算法数据处理计算量。

按照雷达传感器相邻采集周期内目标运动状态变化具有一定极限范围原则,进行有效目标一致性检验;采用生命周期算法,通过对有效目标设置生命阈值进行有效目标决策,消除虚假目标、漏检现象、车辆颠簸和横摆等对有效目标选取的干扰[4]。

2.2.2 目标关联

目标匹配门限设定是根据视觉检测目标的结果,按照测量目标纵向距离的不同进行匹配门限的设定[5][6]。该门限设定是在统计雷达与相机传感器标准差的基础上,综合考虑匹配结果进行的数据统计结果。

将满足门限条件的雷达与视觉目标进行配对,根据配对的结果将匹配的雷达和视觉目标进行融合。

图5 目标关联

2.3 目标滤波

对匹配关联的目标进行多周期管理,对跟踪的目标进行删除、新建、跟踪处理,维护有效目标库。雷达和视觉传感器融合后输出的目标属性信息根据视觉和雷达检测目标的方差和评价值进行不同权重的计算。

3 仿真分析

为验证车辆识别算法的性能,开发了软件程序,实现了雷达和视觉传感器数据同步在线显示与离线数据分析功能。该程序可实现视频信息与雷达数据的同步采集与存储,用于进行离线分析,也可将视频信息与雷达数据融合结果实时在线显示。本论文仿真分析主要针对单传感器存在虚检、漏检场景进行数据分析,并评价融合算法在该场景下的检测效果。

3.1 传感器虚假目标检测

在有减速带的城郊道路上,跟踪前方车辆行驶。雷达传感器与相机传感器的检测结果如图6所示,雷达检测目标存在虚假目标较多,不能对目标信息进行分类。相机传感器能够正常检测车辆,输出目标宽度信息,但是距离误差较大。

图6 融合检测结果

基于影响本车正常行驶考虑,分别采集了基于单雷达传感器和融合算法的本车道最近目标,从目标输出属性进行了数据分析。

图7 传感器数据分析

由图7可以看出,单独雷达目标纵向距离有扰动点,将检测减速带作为目标输出,影响本车正常行驶。而融合算法输出目标纵向距离输出稳定,能够对前方车辆目标进行稳定跟踪。融合算法解决了单独雷达传感器存在的虚假目标问题。

由于雷达传感器的检测特性,除了道路设施对传感器检测有影响外,对于隧道有限空间目标检测,也存在虚假检测结果且侧向距离测量不准,如图8所示。

图8 传感器检测结果

针对本车道的前方目标,进行数据分析如下:

图9 传感器融合结果

由上图数据分析可以看出,应用单独雷达传感器会存在虚假检测目标,且侧方位存在扰动较大,而单相机传感器则存在距离输出结果有跳变,而融合目标输出的信息解决了单独传感器存在的问题,并且能正确的检测目标。

3.2 传感器漏检

在交通复杂的城市环境道路中,传感器检测结果如图10所示。本车右车道黑色车辆在相机传感器检测过程中存在漏检问题,且本车道雷达传感器检测存在虚假目标。

针对该目标存在的相机漏检问题,对检测目标的纵向距离、宽度信息进行数据分析如图所示。其中相机存在漏检现象,纵向距离输出为 0,融合目标输出结果平稳,正常输出目标距离信息。融合算法对宽度信息进行了滤波平滑处理,对于相机目标短暂丢失情况能够正常输出宽度信息。

图11 融合前后对比结果

融合结果在相机漏检情况下仍能正常跟踪目标,并输出目标的宽度信息,且纵向输出结果稳定,解决了单一传感器存在的目标漏检问题。

4 结论

本文提出了毫米波雷达传感器与视频传感器数据融合的技术和方法,融合后得到的目标参数可应用于车辆运动控制命令生成;初步的仿真分析,验证了模型和算法的可行性与有效性。由于数据融合算法充分利用了毫米波雷达与摄像头这两类得到广泛应用的传感器的各自优点,融合后的目标信息有助于生成更为准确和及时的车辆运动控制指令,使得车辆ADAS(高级辅助驾驶)系统具有更好的性能表现。

[1] 王宝锋,齐志权,马国成,陈思忠.一种基于雷达和机器视觉信息融合的车辆识别方法[J].汽车工程,2015.

[2] 肖斌.多传感器信息融合及其在工业中的应用[D].太原理工大学,2008.

[3] 李鹏,王军宁.摄像机标定方法综述[J].山西电子技术,2007(4):77-79.

[4] 韩星.基于毫米波雷达的汽车主动防撞预警目标识别[D].吉林大学,2013.

[5] G.Alessandretti,A.Broggi and P.Cerri,"Vehicle and Guard rail Detection using Radar and Vision Data Fusion," TEEE Transactions on Tntelligent Transportation Systems, Vol. 8, no. 1, pp.95-105, 2007.

[6] X. Liu, Z. Sun and H. He, "On-road Vehicle Detection Fusing Radar and Vision," in Vehicular Electronics and Safety (ICVES), pp. 150-154.201l.