电子音乐交互思维的溯源及演化①

2017-11-16南京艺术学院传媒学院江苏南京210013

范 翎(南京艺术学院 传媒学院,江苏 南京 210013)

电子音乐交互思维的溯源及演化①

范 翎(南京艺术学院 传媒学院,江苏 南京 210013)

电子音乐发展至今,其形态已从原先纯粹的声音艺术逐步过渡到复杂的多媒交互艺术,而其交互思维的形成过程无疑是当代艺术创作思维演化的一个缩影。本文立足于不同时代背景下的声音艺术观念,从创作理念、技术、形式等多方面对电子音乐交互思维的形成过程进行探讨,试图理清其发展与演化的历史脉络。

电子音乐;交互;交互音乐;作曲;计算机音乐

引 言

数字技术与信息技术为当今的社会生活带来了革命性的变化,其对人类的思维方式、行为构架以及人际交往等诸多方面产生了巨大的影响。随着网络通讯技术的不断发展,计算机、手机与互联网所提供的主动信息交互模式为人类打开了一扇全新的认知世界的大门,直观而又便捷的信息交互体验成为人们日常生活不可或缺的组成部分。我们可以通过电脑、手机等信息终端完成包括通讯、学习、购物、娱乐等一系列社会活动,“交互式生活”已然成为了信息社会最基本的生活模式。

20世纪以后,西方社会由“大神学体系”过渡到“大哲学体系”,人们开始以现代哲学的方式思考各类客观存在以及世界的本质,特别是当无序美学、结构美学等美学观念进入到公众视野之后,艺术的内涵及外延被无限放大。在表现主义、未来主义、偶然主义等现代艺术思潮的影响下,人们在思考“什么是艺术”“艺术的本质是什么”这些本源性哲学问题的同时,甚至出现了“一切都是艺术”的极致观念。思想的解放引发了科学与艺术的深度联姻,科学技术逐渐成为艺术作品的重要构成要素,它以观念所承载的主体、象征标识以及组织构架模式等多元化形态成为现代艺术作品不可或缺的表现方式,也成为艺术家在现当代艺术创作中最为重要的创作载体。在此背景下,源于现代社会生活方式的“交互”逐渐成为艺术家通过艺术作品表现个体观念的重要方式,各类科技手段也不再仅仅扮演幕后技术支持的角色,而真正成为了将多种艺术媒介与创作主客体链接融合的核心。

在音乐领域,随着电声技术与录音技术的不断成熟,电子音乐的出现为革新派音乐家实现了精神救赎。由于电子音乐从诞生之日起便具有技术与艺术并重的鲜明特质,电子音乐作曲家兼具艺术修养与技术内涵的知识结构特点为实现“交互音乐”的创作提供了可能。目前,“交互音乐”的创作与展演主要集中于“计算机音乐”与“电子音乐”领域。由于在长期的发展与演变过程中,这两种音乐体裁在创作工具与表现形式等多方面逐渐趋同,因此,目前国际上对于专业层面的“交互音乐”的称谓两者皆可。

近年来,电子音乐的形态结构已逐渐由单一的声音媒体逐步转化为多媒体,而媒体间所构建的信息交换及相互转化已成为电子音乐全新的创作语汇及表现手段。目前,包括国际计算机音乐会议、法国布尔奇斯国际现代电子音乐节、北京国际电子音乐节、上海电子音乐周等重要电子音乐活动纷纷以“交互”“融合”为主题,其所包含的论文、讲座及电子音乐作品大量涉及多媒交互。仅以2015年召开的第41届国际计算机音乐会议为例,其所征集的论文与作品可涉及的专题包括“数字社区、大数据、远程音乐信息处理、跨媒介、新媒体、虚拟现实、未来主义、机器人、移动音乐计算等”[1]。因此,最终入选的论文及展演作品中,超过半数以上涉及交互技术。由此可见,电子音乐的交互特质日益彰显,其创作与科研的重点已由原来单一的“声音艺术”拓展为“多媒互动艺术”,而交互思维已成为当今电子音乐创作观念中最为重要的组成部分。

一、时代变革背景下的音乐思维嬗变

19世纪中后期,资本主义经济的迅猛发展,但随之而来的产能与需求之间的矛盾最终导致经济危机的不断发生。与此同时,国家间经济政治发展的不平衡最终导致了第一次世界大战的爆发,而战争虽然带来了科技方面的长足进步,但也给民众造成了巨大的物质和精神损害。面对政局动荡、矛盾激化和环境恶化等社会现状,人们逐渐对固有的社会价值观产生了质疑,甚至动摇了对“宗教”的信仰。“科学”和“理性”不再是一成不变的真理,对客观世界的迷茫和恐惧导致了对现实的逃避和批判。在焦虑、迷茫和绝望的同时,人们开始寻求新的精神寄托,这直接导致许多新的哲学思潮和流派在这一时期大量产生,一场划时代的观念革命应运而生。

从本体论来看,西方现代哲学流派大多具有唯心主义色彩,这种在特定历史背景下所产生的悲观主义人生哲学逐渐成为了20世纪西方文学与艺术的主流观念。在众多的哲学流派中,叔本华的悲观主义、克罗齐的表现主义、尼采的超人哲学、弗洛依德的精神分析学、柏格森的生命哲学、萨特存在主义哲学等都对艺术领域产生了及其深远的影响。与其他时代相类似,这一时期多元化的哲学思潮也引发了不同流派的艺术思潮,而同时期艺术作品则可以被看作是西方现代哲学思想的物化体现。新观念引领下的艺术创作更着眼于对主观精神世界探索,反对一切传统观念的束缚,强调全新个性化的艺术语言,并强调科技与艺术的结合。

20世纪初,传统乐器在功能及演奏技法方面的发展几近穷尽,作曲家们在配器方面也很难再有重大的突破。与此同时,随着勋伯格十二音体系的建立,传统和声体系被打破,调式概念被不断弱化,音乐的可能性被极大地放宽,这些都预示着音乐的划时代变革即将到来。1911年,意大利作曲家普列特拉发表了《未来主义音乐家宣言》,他呼吁人们:“将个人的音乐灵感从对过去的模仿中解放出来……摒弃偏执的‘制作精良’的音乐,奉行未来主义音乐的独特理念……坚决打击一切历史的重建和传统的舞台布景……”受其影响,未来主义作曲家鲁索洛随后提出了体系化的噪音艺术理论,他认为:“随着机器的产生,噪音也产生了,我们必须突破这种纯粹音乐的狭窄圈子,掌握噪音的无限变化的可能性。”[2]鲁索洛的观念为20世纪音乐材料的拓展与革新了开辟了无限的发展空间,在他的影响下,作曲家们纷纷将注意力转向对新音色的开发运用,如奥利弗·梅西安(Olivier Messiaen)在《杜朗加利拉交响曲》中加入马特诺电子琴的音色,阿洛斯·哈巴(Alois Hába)用四分音创作歌剧《母亲》,以及埃德加·瓦列兹(EdgardVarèse)在其实验音乐作品中大量运用打击乐音色等等。随着各种新音色的不断问世,由听赏习惯所导致的音乐材料观念的转变使更多的作曲家将噪音引入音乐创作。

在达达主义、偶然主义、未来主义等观念的综合影响下,利用噪音拼贴实现偶然化音响的“具体音乐”于20世纪中叶诞生。

电子音乐学界通常将1948年由法国电子工程师皮埃尔·舍费尔(Pierre Schaeffer)创作的“具体音乐”《火车头练习曲》(Etude aux chemins de fer)作为现代电子音乐诞生的标志,其主要原因在于,该作品“最早把噪音全面纳入到音乐的表现范围,极大地扩展了音乐的表达空间;最早使用电子技术直接创造音乐,改变了千百年来作曲家写乐谱、演奏家奏音符的音乐创作流程;最早实现了现场无人演奏的音乐会形式;”[3]作为“具体音乐”的开山之作,《火车头练习曲》一方面改变了千百年来以乐音作为主要音乐创作材料的传统思维,更为重要的是,它史无前例地将现代科技作为音乐创作的主要手段,利用录音技术、电声技术完成了从音响材料的获取、到加工、直至组织结构的全部流程,可以说,它“为后人打开了一扇新音乐领域的大门,引发了人们把电子科技作为音乐创作和音乐发展的强大动力。”[4]

早期的电子音乐创作手法较为单一,主要运用重叠、剪接、循环、拼贴、变速、逆行等手段组织声音素材。当电子技术应用于声音素材时,作曲家对于其所能产生的艺术效果只能做出粗略地估计,特别是当多重技术手段同时作用时,作曲家并不能够完全把控作品的每一个细节,而只能通过不断的实验以获取理想的结果,因此,利用电子手段进行音响组织的过程事实上饱含实验性特质。虽然早期的电子音乐并不存在现代普遍意义上的交互,但从创作行为方式上看,电子音乐改变了自农耕时代以来逐步形成的依赖人声演唱和器乐演奏进行谱面写作的传统音乐创作模式,实质上已形成了全新的“人机交互”的创作模式,而随后出现的“混合音乐”将真实乐器与电子音乐结合,将交互拓展至现场表演的环节。

二、电子音乐交互观念的出现

早在电子音乐出现之前,特列门琴、马特诺琴等电子乐器以富于奇幻想象的形态横空出世,直到今天,其极富临场感的演奏形式仍令无数观众啧啧称奇,而它们的设计理念也直接影响了后世声音合成以及交互界面的设计思维。1939年,约翰·凯奇(John Cage)率先在音乐会中使用电子乐器进行现场表演,并在其作品《假想景观》中依靠录音及放大技术将极微小的声音元素融入其中。虽然此时的电子乐器或电子触发装置是从模拟传统乐器功能的目的出发研制和使用的,但其演奏的方式以及声音触发的理念却对后世的现场实时电子音乐产生了巨大的影响。可见,在“具体音乐”出现之前,电子音乐现场交互的萌芽就已经产生了。

在录音技术出现之前,从某种程度上说,传统音乐的呈现方式一直是交互的。不论是舞台上多个表演者之间,还是表演者与观众之间,双向或多向的信息交互构成了传统音乐的现场实时传播方式。录音技术问世以后,科技拓宽了人们欣赏音乐的途径,也削弱了传统意义上现场交互式的音乐呈现。人们更多选择惬意地在家中通过广播、唱片、磁带等媒介欣赏音乐,而不必特意到音乐厅正襟危坐,受到音乐会礼仪的束缚。多轨录音技术出现以后,录音棚里乐队成员之间的交互也被削弱甚至消亡了,而录音师和音乐监制成为了乐手的交互对象。随着大量的流行音乐通过多轨技术录制生产,在流行音乐会上,歌手只需根据录制好的伴奏现场演唱甚至假唱。至此,音乐的现场交互已变得可有可无,传统的音乐呈现方式发生了巨大的改变,而采用不包含现场交互,以回放式作为呈现方式的电子音乐也逐渐为人们接受。

现代主流观念认为,早期电子音乐作品主要追求全新的声音形态构成,而不存在交互性。但不可忽略的是,新技术改变了传统音乐的创作模式,从而为音乐创作的过程带来了全新的交互体验。自电子音乐诞生之日起,电子音乐家们总是善于运用其时代最先进的媒介技术进行创作,包括具体音乐时期的铝箔录音技术、磁带音乐时期的音频调制和多轨合成技术以及当代电子音乐创作所采用的数字录音技术与多媒交互技术等。依照传统方式,作曲家将作品以谱面形式记录,然后交由他人演唱或演奏,在此过程中,信息的传递往往以单向性为主,即从作曲家-表演者-观众,多数情况下无法形成双向性或互动性。而电子技术手段使早期的电子音乐作曲家能够直接面对声音素材进行创作,创作材料由音符变为音响,通过剪辑、拼贴等创作技术所实现的最终结果也能为作曲家直观地听到。在此过程中,作曲家通过各类技术手段实实在在地与声音产生了交互。虽然早期电子音乐创作以追求新颖地音响为最终目的,但在创造全新声音地过程中,作曲家必然要经历实验—判断-选择-构建-成型的过程,而在此过程中,新技术带给作曲家不计其数的各类全新的音响可能,作曲家对这些声音素材进行赏鉴、调整、判断而最终做出选择,在此过程中,作曲家与原始的声音素材分别作为交互的两端,而交互的平台则为电子技术手段,这样的过程无疑是一种交互的过程。由此看来,“交互”伴随电子音乐诞生伊始便已存在,而“交互”的创作过程也成为电子音乐不断向前发展的重要推动力量,它促使电子音乐以前所未有的速度成长,使电子音乐迅速成为20世纪之后极为重要的音乐门类。

随着磁带录音技术的发展成熟,“磁带音乐”逐渐取代“具体音乐”而成为电子音乐的主要形式。然而,由于“磁带音乐”与“具体音乐”均采用录音回放作为音乐会的主要呈现形式,对于习惯了传统音乐听赏模式的观众而言,舞台表现的缺失所导致的视觉体验匮乏难免会造成一定程度的不适,因此,作曲家们开始思考如何将现场表演与电子音乐相结合,从而形成一种具有丰富舞台表现力的全新形态的电子音乐。1956 年,德国作曲家卡尔海因茨·施托克豪森(Karlheinz Stockhausen)首次将人声演唱引入电子音乐作品。他所创作的《青年之歌》第一次将电子音乐与童声男高音相结合,通过多种电子手段对人声进行分解、变形和重组,并将所形成电子音乐部分与人声演唱有机结合,从而形成了后世称之为“混合音乐”的新型电子音乐,这种以同质素材构建混合类电子音乐的模式一直沿用至今。“混合音乐”的出现打开了电子音乐的交互之门,它将人的表演行为引入电子音乐范畴,形成了两个或多个信息交换的主体;它开创了以演唱或演奏所产生的音响作为电子音乐声音来源的创作模式,构建了真实乐器或人声与电子音乐之间相互转化的桥梁,从而为电子音乐日后实现真正意义上的“现场实时交互”提供了可能。

由于“混合音乐”的创作需要同时具备传统音乐与电子音乐的写作能力,因此,大量的电子音乐作曲家开始寻求与传统音乐作曲家之间的合作。“混合音乐”的出现吸引了包括奥利弗·梅西安(Olivier Messiaen)、皮埃尔·布列兹(Pierre Boulez)、克里斯托弗·潘德雷斯基(Krzysztof Panderecki)在内的一大批著名现代音乐作曲家投身到电子音乐的创作领域,他们的参与促使电子音乐逐渐进入到专业音乐领域,从而成为现代音乐的重要分支。可见,“混合音乐”在丰富电子音乐舞台表现,进而拓展电子音乐类型范围的同时,也推动了电子音乐的长足发展。

“混合音乐”将电子声响与实时的演唱演奏相结合,将传统音乐写作及电子音乐的创作手段相融合,由此产生的美学观念宽泛而多样。它热衷于使用类似十二音序列音高及节奏的复杂特性进行写作,并关注于由幻听而形成的精神世界的反应。“混合音乐”通常利用乐器的常规或非常规演奏技法产生丰富的音响素材,进而将预先录制的或对实时演奏或演唱加以变形的电子音响作为补充,从而将现场演奏与电子音乐相结合。早期的“混合音乐”代表作品包括布鲁诺·马德尔纳为长笛、钹和磁带音乐而作的《音乐的两个维度》(Musicasu due dimensioni I,1952)、皮埃尔·舍费尔与皮埃尔·亨利(Pierre Henry)为女高音与磁带音乐而作的歌剧《奥菲安53(Orphée53,1953)以及卡尔海因茨·施托克豪森为钢琴、打击乐和电子音乐而作的《联系》(Kontakte,1959—1960),等等。这些作品通常以人声或乐器的写作为基础,通过特殊的记谱方式将真实的演奏、演唱与电子音乐相结合。表演者需要充分了解作品的电子音乐部分,在表演过程中仔细聆听,依照预置的电子音乐进行演奏。在此过程中,乐谱成为了信息通讯的主要平台,而信息的传递多为单向,因此,送信与受信在多数情况下不能实现相互转化。

“混合音乐”的乐谱通常以复杂的图形符号表示电子音乐部分。在不同的作曲家手下,这些图形符号形象地表述了各种天马行空的声音想象,而乐谱本身已然成为具有艺术家鲜明气质的艺术佳作。比较典型的电子音乐图谱写作方式包括:频率图表和动态图表相结合;不同密度的抽象或具象的纹理化图形;带注释的分层图形;仅在乐器谱上标注电子音乐播放的时间。

以上几种方式需要视现场表演的同步形式而定。对于需要演员自行判断与电子音乐间的时间关系的情况,方式3更为有效;对于由作曲家控制电子音乐启停以配合台上演员的情况,则方式4更为简洁。

然而,由于“磁带音乐”的“混合音乐”均采用了预置的电子音响,其在现场表演的随机性方面受到了极大的限制。当表演者希望按照个人的想法对乐句结构或速度进行处理时,面对在时间方面已无法更改的电子音乐部分只能做出妥协。单向的信息传递方式极大地限制了表演者的即兴发挥,这种缺乏“不确定性”的表演形式未能从根本上解决电子音乐舞台表现力的问题。二十世纪六七十年代,模拟调制技术被应用到电子音乐会现场。电子音乐家们得以通过基于模拟电路的混响、延迟、失真等电子模块,对录制的声音素材或现场演奏演唱的音响进行实时处理,而并不仅限于在特定的时间点播放预置的录音,电子音乐部分的实时可控性大大增强。至此,现场表演与电子音乐之间构成了双向的信息通讯,表演者与电子音乐家之间形成了良性的互动关系,其送信与受信的身份也能够实现转化。更多的即兴演奏和实时调制使电子音乐变得分外鲜活,观众在感受传统音乐表演所带来的丰富视觉信息的同时,也能体验由声学乐器与电子技术共同诠释的音响的解构与重组,更能体验到实时交互所形成的偶然主义美感,电子音乐的交互构架基本形成。

在以约翰·凯奇为代表的“偶然主义”思潮的影响下,自20世纪六十年代起,越来越多的音乐家们开始从事关于“现场实时电子音乐”的实验,他们对于即兴创作和“偶然音乐”的不断追求促成了首个“交互式电子音乐系统”的问世。哥顿·穆玛(Gordon Mumma)于1967年创作的《角笛》(Hornpipe)呈现了一种具有前瞻性的音乐思维,他定义该作品是“为独奏号手、赛博声音控制系统以及表演空间设计的交互式实时电子音乐作品”。《角笛》所使用的“赛博声音控制系统”是一台能够实时产生扩展性电子音响的模拟计算机,在演奏时可以拴在乐手的皮带上。该系统通过麦克风拾取并分析由号角演奏所引发的实时空间声学反应,并利用电路的自适应系统对空间中的共鸣产生补充性的电子音响。不同的实时演奏产生不同的电子音响,而由扬声器所发出的多种类型的电子音响又反作用于实时演奏,在此过程中产生了三类不同的声音交互关系:号角声与电子音响,电子音响与由其所产生的新的序列化电子音响,号角声与新的序列化电子音响。由此可见,“赛博声音控制系统”所实现的并不是简单的声音转换,而是由单一来源所引发的三个交互主体之间的彼此作用。在表演过程中,电子手段在一定程度上实现了音乐创作的功能,同时,由于受到乐手、表演空间以及电声设计的多重影响,这种创作有别于既定式的传统纸面创作,它是通过交互具备了更多的“即兴化”和“不确定性”。

三、电子音乐交互技术的进一步发展

1960年代中期,随着电压控制技术被应用于电子声音合成,电子音乐在交互技术方面形成了全面发展的新格局。模拟合成器中几乎所有的可控因素都能被电压所控制,电压的强度和持续时间成为了一种抽象的、模拟的控制参数,从而可用以控制声音的频率、振幅甚至是音色变化。对于电子音乐而言,在电压控制技术的支持下,电压既成为控制电子音响各类参数的工具,更成为现场表演与电子音响间交互的平台与纽带。演奏或演唱所产生的声音通过话筒转换成模拟的电信号,而对应声音包络所形成的电信号的连续电压变化能够作为声音合成控制的某一项参数,从而控制电子音响部分的各种可变因素,从而形成音乐表演与电子音响之间的信息通讯。借助电压这一中介,实时演奏与电子音响之间构建起了多元化的映射关系,电子音乐形成现场交互的可能性被极大地拓宽。1970年,马克思·马修斯(Max Mathews)和理查德·摩尔(Richard Moore)于贝尔实验室发明了首个专门用于交互作曲和实时表演的操作平台—“可控电压实时输出系统”(简称GROOVE)。该套系统以Honeywell DDP-24计算机为核心,由显示器、磁带播放器、模数/数模转换器、扬声器、键盘、存储器以及按键和摇杆构成。由于当时计算机的运算速度非常有限,该系统只能通过计算机控制电压的实时变化,然后利用电压控制模拟的滤波器、包络发生器、振荡器的各项参数,从而产生声音。虽然GROOVE并未实现计算机对于声音的直接控制,但由此开始,计算机程序设计被引入电子音乐领域,利用数字技术实现声音控制的理念自此发轫,这无疑为日后电子音乐的发展开辟了广阔的前景。

从1970年代中后期至80年代,计算机与电子音乐的关系日趋紧密,以计算机为核心进行的各类声音交互实验成为了这一时期电子音乐的鲜明特征。最早利用微型计算机进行交互实验的戴维·贝尔曼(David Behrman)在谈到如何对声学乐器进行实时电子化处理时曾说到:“我使用计算机作为交互界面,用它来控制我为电子音乐所设计的各类电路以及一个能够判定声学乐器音高的传感装置。”[5]他同时强调自己的作品是建立在“电脑程序和硬件相结合的形式”之下的。被誉为“交互音乐系统先驱”的乔尔·查德贝(Joel Chadabe)在谈及其于1980年发行的作品集唱片《Rhythms》时这样描述他的创作方式:“计算机能够自动产生的旋律和节奏模式,……我可以通过在键盘改变和弦结构、进行和弦移调、触发旋律变化,改变节奏模式以及重叠各类声音。虽然我触发了每一个变化的开始,但我无法预知每一个变化的细节。我必须对所听到的结果做出反应,并决定下一步该做什么。”[6]1979年,乔治·路易斯(George Lewis)开发了运行于KIM-1计算机平台上的软件“Voyager”,通过对Moog合成器的各类控制,该软件不仅能够对乐器的现场演奏进行实时响应,而且也能进行自动化的即兴创作,这标志着建立在计算机平台之上的演唱演奏与电子音乐之间的实时交互关系正式确立。虽然这一时期的电子音响合成主要还是建立在计算机数控模拟技术之上的,但全新开发的计算机程序使创作过程中的“不确定性”大大增强,表演者表演行为的各项细节变化都能够作用于实时电子音响的生成机制,从而产生的形态万千的即兴化电子声部。计算机自动作曲技术对音乐创作形成了本质性的影响,电子音乐的内在结构不再仅仅依照人的主观意愿进行组织,对由随机运算所生成的范本进行“选择—加工—合成”成为了作品组织的全新方式。通过计算机程序,人的控制行为与计算机自动作曲之间形成了双向的信息通讯,现场演唱演奏与计算机即兴创作构成了可以实时转化的送信与受信的交互主体,并且能够在一定程度上实现对交互过程的控制,自此,人机交互式的电子音乐创作与实时表演成为了现实。

进入1980年代,随着个人计算机的逐步普及以及商业化音乐软件的出现,音乐交互技术的研究不再仅仅依赖于实验室团队,而呈现出多样性的个体化趋势。Max、Jam Factory、Interactor等音乐软件为个人用户提供日益完善的交互作曲功能,包括如何让计算机辨识音乐信息的输入、如何实时安排音乐信息以及如何让计算机读谱等一系列问题被逐一解决。与此同时,为解决数据指令的通用性问题,电子乐器制造商联合创立了MIDI(Musical Instrument Digital Interface)标准,确立了以五针DIN为接口的音乐信息交互平台。通过MIDI这一数字通讯协议,利用计算机程序对音高、音量、颤音、截止频率以及混响延迟等效果的实时控制变得极为便捷,作曲家利用键盘、旋钮、推子等便携式设备能够线性的控制音乐表现的各个方面,同时,多台计算机与合成器之间的集群化交互的功能也能够通过MIDI得以实现,这些显著的优势使得MIDI很快便成为各类电子音乐演出中最为重要的信息通讯方式之一。虽然量化后的MIDI信息所形成的极微小的数据量保证了那一时期计算机的正常运算,但与此同时,出于商业化目的而设立的MIDI通用数据标准所包含的音乐控制信息种类极为有限,特别是对音色进行本质性改变的开放化数据过少。与此同时,其量化为128级的数据层次也不足以表现声音的各类细腻而丰富的动态变化,且声音调制的可变范围还受到受控硬件处理能力的极大限制,这些因素都限制了电子音乐以探索个性化声音为目的的创作诉求,因此,一部分软件研发团队开始探索如何利用MIDI作为数据来源,创造各种富于个性张力的全新电子音响。

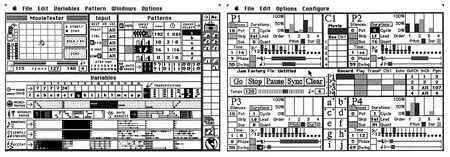

图1.软件“M”和“Jam Factory”早期版本的操作界面.

1986年,由乔尔·查达贝(Joel Chadabe)和大卫·兹卡莱里(David Zicarelli)共同研发的“M and Jam Factory”软件套装问世,它运行于配备了MIDI端口的苹果操作系统下,用户可以通过MIDI设备或苹果的鼠标和键盘对一个类似于飞机控制面板的图形界面进行实时控制,而软件所提供的控制范围灵活而宽广(图1)。通过基于“马尔科夫链”的转换算法,计算机能够针对由具体操作所产生的MIDI数据进行实时响应,在音乐进行的过程中“即兴创作”出各类MIDI事件,用户在听到运算的结果以后,也能够实时对软件的具体操作进行各项调整,从而在交互的过程中完成整个音乐作品的实时创作。

“M and Jam Factory”软件套装为实时电子音乐的创作和表演提供了可视化的操作与运算环境,这一创举一方面实现了数字环境下的直观化的实时声音控制,更为重要的是,它标志着利用计算机算法进行即兴创作表演理念的正式确立,从而进一步拓宽了电子音乐、计算机音乐以及算法作曲未来的发展道路。

几乎在同一时期,拉里·波兰斯基(Larry Polansky)、菲尔·伯克(Phil Burk)和大卫·罗森伯姆(David Rosenboom)在米尔斯学院创立了一种名为“音乐层次规范化语言”(Hierarchical Music Specification Language,简称HMSL)的全新音乐编程语言。它基于福斯(Forth)语言之上,是一种以“物件”为主导思想的程序语言,主要针对实验音乐的创作与展演开发设计。它包含算法作曲、MIDI控制与响应、智能化实时交互音乐设计以及音乐识别系统于一身,是一种高度集成化的音乐信息处理语言,其功能主要包括六个方面:作曲相关事件信息的分层与调度;可运行于Mac和Amiga系统下的便携式用户界面;功能完备的MIDI信息处理的工具套装;基于文本的功能强大的乐谱输入系统;算法作曲与实时交互工具套装;数量巨大的实例与教程。

1980年代中后期至90年代,在“图形界面”与“实时算法”等软件设计理念的影响下,基于MIDI技术的音乐交互软件系统层出不穷,最具代表性的包括:罗伯特·罗开发的由信息辨识系统、实时创作表演系统和数据修正系统三部分组成“Cypher”系统;托德·麦乔弗(TodMachover)开发的由计算机分析程序与传感器所构成的,用于增强乐器演奏表现力的“Hyperinstrument”系统;丹尼尔·奥本海姆(Daniel Oppenheim)开发的建立在物件基础之上,能够通过图形界面进行实时交互声音编辑的“Dmix”系统;卡拉·斯卡拉蒂(Carla Scaletti)所开发的专注于高品质电子声音开发与交互创作的“Kyma”系统。以上这些系统除“Kyma”还另外附带了音频处理与合成工具以外,都能够通过“即兴创作”生成MIDI信息。它们利用直观而友好的图形操作界面替代了抽象而晦涩的计算机编程语言,基于MIDI技术所实现的便捷的操作方式有利于作曲家迅速地捕捉音乐创作的灵感,也有利于现场实时对各类音乐数据进行细腻而准确的把控。

虽然经过转换的MIDI数据能够实现众多声音外化结构的控制功能,但电子音乐家们对于声音解构与重组的关注依然热切,他们希望能够随心所欲地控制声音的内在层次,并通过声音的分解与再造形成更多具有个性色彩的创作元素。1986年,在巴黎的“音乐与声学研究所”(Institut de Recherche et Coordination Acoustique/Musique,简称IRCAM),以米勒·浦科特(Miller Puckette)为核心的研发团队开始为名为“4X”的合成器开发控制软件。这款名为“Max”的控制软件通过设计各种复杂的信号流程,能使4X合成器实时生成不同的合成音色。这套系统问世以后,很多作曲家对于其所具备的信号处理流程产生了浓厚的兴趣,他们希望能够通过某些特殊的方式,将乐器实时演奏所产生的声音代替合成器中原始的简单波,从而将这种基于不同物件的信号处理流程施加到乐器的实时演奏上,这样一方面能够产生更多不可预知的声音可能,另一方面也能使音乐的现场表演与同源的电子音响形成自然的交互关系。1990年代,IRCAM发布了新加入实时音频处理功能的“Max/ISPW”系统(图2),该系统运行于“NeXT”计算机平台,通过最多能扩展至三张的DSP运算卡进行音频和MIDI的实时处理,其音频处理依然采用物件化的信号流程处理方式,并加入了可视化操作界面、多元化的MIDI处理功能、多媒体功能等许多新增特性。但由于该系统只能运行于价格昂贵的“NeXT”计算机平台,“Max/ISPW”很快便无疾而终了。然而,ISPW的设计理念引领了Max后续发展的前进方向。在此基础上,IRCAM于1995年组建了“实时系统”研发团队,开始了以高度可移植性为目标的开发研究。

1990年代初,法国国家视听研究院电子音乐研究中心(INA-GRM)也在软件开发方面取得突破性进展,由修格斯·维内特(Hugues Vinet)等人开发的单机版GRM TOOLS问世。这套基于HyperCard工具所开发的声音处理软件凝结了GRM(Musical Research Group的简称)50多年的科研成果, 它为用户提供了多种能够运行于Digidesign音频加速卡的声音算法,实现了计算机程序对于音频数据内在结构的创造性处理。

1986年,借助成熟的Smalltalk-80程序设计语言,卡拉·斯卡拉蒂实现了多年的夙愿,完成了“Kyma”语言的研发,并于1987年发布了加载可视化图形控制界面的,集声音合成、计算机辅助作曲以及数字音频信号处理功能于一身的“Kyma”系统。对于运行于“Platypus”的第一代“Kyma”系统试图达成的设计目的,卡拉进行了如下描述:

1.一种理想的运行机制是,数字声音合成所需的巨大的数据量能够被整合到概念化的模块中,这些模块由作曲家设计发明,并且设计语言本身不会包含符号或风格等先入为主的观念。2.系统的反应时间尽可能短,但由于它是一种为创作而不是为现场表演所设计的语言,因此实时响应是不需要。 3.作曲的结构将会成为一个物件,一个对于其核心动机进行各类转化的过程的记录。与此同时,声音的转换并不是破坏性的声音的修改,而是通过滤波功能来以一种全新的方式看待声音。4.在此环境中的各类工作都是可以累积的,并且系统所包含的各项细节能够被逐一学习,只有这样才能获得用户的首肯。5.声音可以通过图形方式的进行合成,每个声音物件拥有多种视觉显示方式。6.作曲家能够通过它创造一个“声音的宇宙”,并对“宇宙”中所包含的众多物件赋予特定的属性和关系,然后以一种标准化的逻辑方式探索这个“宇宙”。[7]

和“Max”一样,“Kyma”的设计同样受到了“HMSL”的影响,采用了基于物件的流程化声音处理方式,这些开放可变的物件参数以及信号串联方式为作曲家提供了无限的声音创作可能,也为声音的合成与解构重组赋予了更多的个性化要素,从而为作曲家在探索个性化音乐素材与音乐语言方面开创了全新的创作领域。

图2.运行于“NeXT”计算机平台的“Max/ISPW”硬件系统.

1996年,由米勒·浦科特为主研发的“PD”(Pure Data)软件系统问世了。该系统继承了ISPW的一部分设计理念,并对Max在动态数据结构管理方面的缺陷进行了弥补。由于使用了更快速的处理器,PD系统将声音合成、音频信号处理、视频信号处理以及三维图形处理整合于同一软件环境下,这一创举为音乐家与视觉艺术家之间实现跨媒介合作构建了良好的机制。1997年,大卫·希卡瑞里(David Zicarelli)利用PD的音频处理部分开发了Max的扩展系统MSP(Max Signal Processing),在苹果公司的Macintosh平台下实现了实时音频合成与音频信号处理功能。

进入21世纪,在数字媒介与网络平台所构成的传播方式的影响下,电子音乐的发展开始呈现出多元与交互的时代特点。随着技术的不断进步,相关软件的发展也朝着实现多元化跨界交互的目标不断前行。新的Max软件逐渐发展为具有极强拓展性的开放式平台,与之相关的包括具有实时音频处理功能的“MSP”、能够实时处理视频信号和三维图形的“Jitter”以及针对现场演出和实时调控的“Ableton Live”等,而Kyma在提供更强大的声音运算引擎以及更多元化的声音物件的同时,也新增了与Wacom tablet、Ipad、EigenHarp等用于实时交互的外部的控制协议。友好的图形化的界面使得媒体间信息交互的构建变得愈加便捷,这也进一步促使多媒交互成为未来电子音乐创作观念发展长河中的重要支流。

结 语

随着艺术生态环境的不断变化,人与科技、硬件与软件、时间与空间、不同文化之间、不同观念之间所形成的交叉与碰撞体现了人类对未来的不断探索与憧憬,也促使艺术朝着跨学科、跨领域的多元化方向不断前行。电子音乐在观念、语汇、风格、样式等方面发生了一定的变化,形成了由单一媒介向多媒介、单一技术向多元技术转化的全新跨界式发展格局。媒体的交互构建了多维的表现力层次,而在融合的过程中,不同观念间的碰撞与交流更能激发出全新的创作灵感与火花,由此所产生的多媒交互式电子音乐具有异彩纷呈的独特魅力。诚然,“幻听电子音乐”凭借电子音乐原初的独特语汇,依然借助科技的力量而不断前行,而“交互电子音乐”的繁荣与发展则推动了电子音乐向着更广阔的领域不断拓展。

[1]范翎.以科技之名对话未来——第41届国际计算机音乐会议概览[J].人民音乐. 2016(1).

[2]钟子林,编.西方现代音乐概述[M].北京:人民音乐出版社. 1996.

[3]谢力荣,庄曜.新技术媒体环境下的音乐创作及现象分析[J].黄钟(武汉音乐学院学报),2012(3).

[4]张小夫.初创阶段的电子音乐——具体音乐[J].乐器,2001(2).

[5](美)Schaefer John.New Sounds: A Listener’s Guide to New Music[M].1987

[6](美)Chadabe Joel.Interactive Composing: An Overview[M].1984.

[7](美)Scaletti,C.1987“Kyma:an Object-oriented Language for MusicComposition”In J. Beauchamp, ed[M].Proceedings of the 1987 Intel Computer Music Conference, Computer Music Associatim,49-56.

J609;J611.1

A

1008-9667(2017)03-0107-08

2016-07-03

范 翎(1980— ),江苏无锡人,南京艺术学院传媒学院副教授,美国俄勒冈大学访问学者,研究方向:录音艺术。

① 本文为2015年江苏高校哲学社会科学研究项目《交互型电子音乐创作研究》(项目批准号:2015SJD175)阶段性成果之一。

(责任编辑:王晓俊)