基于深度卷积神经网络的番茄主要器官分类识别方法

2017-09-15周云成许童羽邓寒冰

周云成,许童羽,郑 伟,邓寒冰

基于深度卷积神经网络的番茄主要器官分类识别方法

周云成,许童羽,郑 伟,邓寒冰

(沈阳农业大学信息与电气工程学院,沈阳 100866)

为实现番茄不同器官的快速、准确检测,提出一种基于深度卷积神经网络的番茄主要器官分类识别方法。在VGGNet基础上,通过结构优化调整,构建了10种番茄器官分类网络模型,在番茄器官图像数据集上,应用多种数据增广技术对网络进行训练,测试结果表明各网络的分类错误率均低于6.392%。综合考虑分类性能和速度,优选出一种8层网络用于番茄主要器官特征提取与表达。用筛选出的8层网络作为基本结构,设计了一种番茄主要器官检测器,结合Selective Search算法生成番茄器官候选检测区域。通过对番茄植株图像进行检测识别,试验结果表明,该检测器对果、花、茎的检测平均精度分别为81.64%、84.48%和53.94%,能够同时对不同成熟度的果和不同花龄的花进行有效识别,且在检测速度和精度上优于R-CNN和Fast R-CNN。

目标识别;图像处理;像素;番茄器官;深度卷积神经网络;数据增广;深度学习

周云成,许童羽,郑 伟,邓寒冰. 基于深度卷积神经网络的番茄主要器官分类识别方法[J]. 农业工程学报,2017,33(15):219-226. doi:10.11975/j.issn.1002-6819.2017.15.028 http://www.tcsae.org

Zhou Yuncheng, Xu Tongyu, Zhen Wei, Deng Hanbing. Classification and recognition approaches of tomato main organs based on DCNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(15): 219-226. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2017.15.028 http://www.tcsae.org

0 引 言

从植株图像中检测出番茄的主要器官(花、果、茎、叶)是典型的目标识别问题,其对病虫害检测、靶向施药、日光温室场景理解,以及智能农机的发展都具有重要意义。利用颜色空间的差异进行图像分割是常采用的传统目标识别方法之一。文献[1-2]利用成熟番茄与背景颜色特征的差异,通过阈值分割的方法识别红色成熟番茄,但这种方法无法识别未成熟果。文献[3]通过分析番茄植株图像的HIS颜色空间分布特性,用Otsu分割算法突出红色吊蔓绳区域来间接识别番茄的主茎杆,该方法需要借助于红色吊蔓绳,有一定的制约性。用过滤器算子提取图像低等级特征后再用分类器分类是另一种传统目标识别方法。Haar[4]、HOG[5]、Sift[6]等是一些常用的过滤器算子。文献[7]用Haar-like提取成熟番茄的非颜色编码特征,结合AdaBoost算法构建识别成熟番茄的分类器。文献[8]提出一种融合Harris和Sift算法的荔枝采摘点计算与立体匹配方案。过滤器结合分类器的目标识别方法需要人工选择过滤器算子,算子类型和数量的选择需要结合大量的试验测试,适用性往往受到抑制。番茄器官,特别是果和花,其形态多样、颜色变化丰富、重叠遮挡严重、环境背景复杂,用传统方法识别的技术难度较大,且很难用一种方法同时识别所有类型的器官。

近年来发展起来的深度卷积神经网络(deep convolutional neural network, Deep CNN, DCNN)是一种新的目标分类识别方法。该方法能够实现自动化的图像特征提取,与分类识别过程融为一体,并通过数据实现自我学习。国内外学者在DCNN的基本理论[9]、分类网络[10-15]与识别网络[16-20]设计,以及大规模图像处理的应用[21]上开展了相关研究,取得了长足进展。DCNN在图像处理领域正得到越来越广泛的应用[22]。文献[23]用视频分析方法提取奶牛躯干图像作为DCNN的输入来识别奶牛的个体身份。Ouyang等设计了具有多分辨率图像输入的DCNN来分类浮游生物[24]。文献[25]用约简的AlexNet[10]识别茶园主要害虫。文献[26]设计了一个7层结构的CNN网络,用于鲜茶叶智能分选系统的茶叶等级筛选。文献[27]结合CNN和支持向量机(support vector machine, SVM)提出一种适用于空心村高分影像的建筑物自动化检测方法。这些研究表明CNN在图像多类型目标的分类识别中具有很好的适用性,克服了传统方法的不足。

为同时实现番茄不同器官的快速、准确检测,本文借鉴Fast R-CNN[18],提出1种基于DCNN的番茄器官分类识别方法。考虑番茄器官形态多样性,在不同环境光条件下采集番茄主要器官和植株图像,构建训练样本。基于VGGNet[13],以top-1错误率为判据,通过优化调整网络结构及输入图像维度,同时利用避免网络过拟合的数据增广(data augmentation)技术,设计、训练、筛选高性能分类网络。以筛选出的分类网络为基础,将其卷积部分用于番茄植株图像的特征提取与表达,建立番茄器官检测器,并通过检测试验检验本文方法的有效性。

1 番茄图像采集

图像数据采集自沈阳农业大学实验基地日光温室,主要采集番茄的花、果、茎、叶4类图像。为了将番茄植株和器官同环境背景区别开,采集温室背景环境(温室建筑、土壤等)作为第5类图像。使用高清摄像机和本文开发的快速图像获取程序采集图像,共采集30 000幅5种类型的RGB图像,用于网络的训练和测试。为降低训练样本的多样性不足导致的网络过拟合的概率,图像采集过程中采取了一些措施:考虑温室环境光条件的不同造成的成像结果的差异,分别在晴朗天气和阴天分时段采样;采样时考虑番茄器官的不同形态、遮挡情况,以果实部分为例,分别对不同果形、不同成熟度的果,从多个角度进行成像,以增加样本的多样性。同时采集了1 000幅番茄植株图像,用于识别网络的训练和测试。

2 基于VGGNet的番茄器官分类网络

网络变得更深是深度学习的本质[24],理论上,增加网络的宽度和深度,可提高网络的学习能力。尽管加深网络层次已成为通用的方法,但随着深度的增加,网络的训练成本也大幅增加,且有研究表明当网络增加到一定层数后,再增加深度,性能反而降低[14]。因此,为设计1个实用的番茄器官分类网络,需要结合理论分析和大量的试验验证。

2.1 VGGNet网络架构

VGGNet是DCNN的典型代表,其3×3小卷积核的设计思想使得网络的参数更少,且在具有1 000个分类的大规模图像数据集ImageNet[21]的分类和定位上的适用性已得到了充分的验证,因此许多网络均以此为基础进行设计。图1是含16个权重层的VGGNet网络结构(VGG-16)。

图1 16个权重层的VGGNet网络架构Fig.1 16 weight layers VGGNet architecture

VGGNet的输入为224×224 pixel的RGB图像,图像经过网络的处理,输出其属于每个类别的概率。VGGNet架构总体上由5个用于特征映射和降维的池化层分隔成6部分(6组),其中前5组分别由多个卷积核大小为3×3的卷积层构成,第6组为3个全连接(fully-connected, FC)层。VGGNet的每个卷积层卷积操作的滑动步长(stride)固定为1 pixel,并通过边界填充(padding)来保持输入/输出数据维数(宽高)不变。5组卷积层的通道数从64开始,后一组的数量是上一组的2倍,直至扩大到512。VGGNet的池化层均采用最大池化(max-pool),池化窗口大小为2×2。3个FC层的通道数分别为4 096、4 096和1 000,第3个FC层的1 000个出口(way)分别表示1幅图像属于每个类别的得分。VGGNet的最后一层为soft-max层,用于将得分转化为图像属于每个类别的概率。在VGGNet中,除池化层外,每个隐层后都设置1个修正线性单元(ReLU)做非线性变换,以加快网络收敛速度。

2.2 基于VGGNet的番茄器官分类网络配置

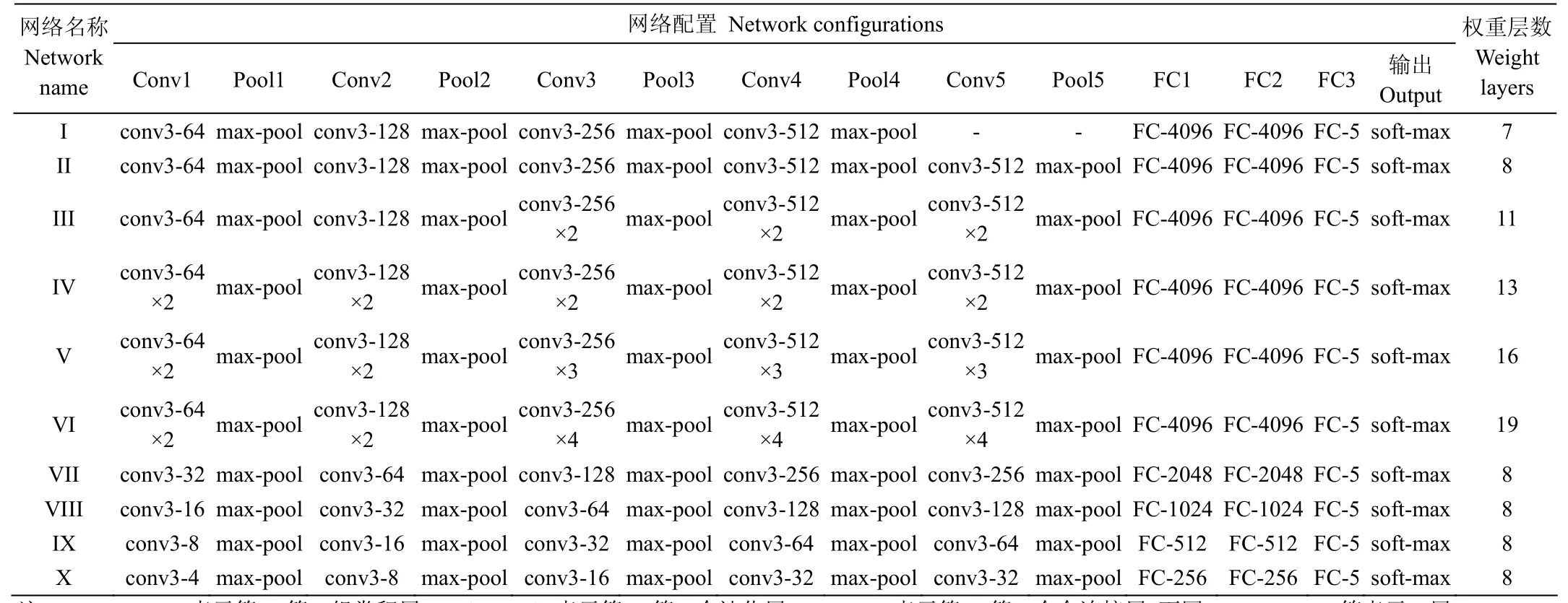

将VGG-16直接用于番茄器官特征提取与分类有许多不适用的地方。首先番茄的果、花在植株图像上的成像通常较小,因此选择128×128 pixel和64×64 pixel两种规格的RGB图像作为网络输入,并通过后续试验选择适宜大小。针对番茄花、果、茎、叶及背景图像的5分类问题,将VGGNet的第3个FC层的神经元数量(通道数)调整为5个。VGG-16的权重参数达65 M[13],是为解决类似ImageNet这种大规模图像任务而设计的DCNN,其训练和应用过程中的计算量庞大。番茄器官的分类识别在类型和样本数量上都远小于ImageNet。为提高计算效率,在保持VGGNet基本架构不变的前提下,本文通过调整VGG-16的网络深度和宽度,配置了10种类型的番茄器官分类网络(表1),通过后续试验选择高性能的网络,每种网络需训练的参数数量如表2。

VGGNet的权重参数主要集中在FC层。表2说明,随着网络深度的增加,网络参数的数量逐渐增加,但增加的幅度要远小于通过增加网络的宽度带来的参数增加量。

3 番茄器官分类网络的训练与分析

3.1 图像数据增广与预处理

表1中网络需要128×128或64×64 pixel大小的输入图像,由于番茄器官样本图像大小不同,在输入前,要对读入的每幅图像进行预处理。在预处理中,除了将图像缩放/裁剪为合适的大小,还需要利用数据增广技术来降低网络过拟合的风险。数据增广是指在保持图像数据类型(标签)不变的前提下,对原图像进行各种变换,以增加样本的多样性。

表1 基于VGGNet的10种分类网络配置Table 1 10 kinds of network configurations based on VGGNet

表2 网络参数的数量Table 2 Number of network parameters

本文首先采用的数据增广方法是对原图像随机旋转一定角度(0~180°)形成新的图像。番茄器官图像采集过程中虽然考虑了样本形态、角度等的多样性,但番茄的花、果、叶生长以及成像的角度具有随机性。通过对原图像进行随机角度旋转,可部分消除样本多样性不足的问题。

采用的第2种数据增广方法是平移和水平翻转图像。针对输入尺寸为128×128 pixel的网络,将矩形图像进行等比例缩放,使其短边长为150 pixel,然后从缩放后的图像中随机裁剪128×128 pixel的块作为结果,同时对裁剪结果做随机水平翻转。经过这种处理,会使训练样本数量进一步增加。对输入尺寸为64×64 pixel的网络,首先将图像等比例缩放到短边长为75 pixel,其余处理方法相同。

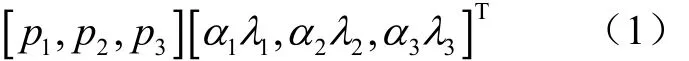

采用的另一种数据增广方法是改变图像RGB通道的强度[10]。由于光照强度和颜色的变化对成像结果有很大影响,采用这种方法,可在一定程度上消除光环境的影响。具体做法是通过对图像的RGB像素值做主成分分析(PCA),然后对图像中的每个像素添加一个随机倍数的主成分。

式中pi和λi分别为图像RGB像素值的3×3协方差矩阵的特征向量和特征值,αi是一个随机变量,αi的随机性符合平均值为0,标准偏差为0.1的高斯随机分布[10]。

由于成像传感器噪声、通道传输误差等,图像噪声难以避免,一定程度上影响了图像的特征提取。因此,除数据增广外,图像在输入网络之前还需要进行去噪处理,本文采用的图像去噪方法为中值滤波。

3.2 网络训练方法

采用带动量因子(momentum)的小批量(mini-batch)随机梯度下降法(stochastic gradient descent, SGD)对网络进行训练。每一小批量样本的数量为128,动量因子设置为固定值0.9[15]。权重的初始化影响网络的收敛速度,本文采用均值为0、标准偏差为0.01的高斯分布为网络所有层的权重进行随机初始化[13],所有卷积层和全连接层的偏置(bias)均初始化为0。对网络中的所有层采用相同的学习速率,初始学习速率设置为10-2,训练过程中,当验证集的分类精度停止增加的时候,则降低学习速率,降低的方式是将学习速率变为当前速率的1/10,直至通过调整学习速率不再提高分类精度为止。

在微软开源的深度学习计算框架CNTK2.0[28]基础上,利用BrainScript编写了针对表1不同网络配置的程序脚本,在一台配有4个Intel Xeon E7-4820 CPU、1个Tesla K40 GPU和128 GB内存的计算机上开展相关试验研究。

3.3 试验结果与分析

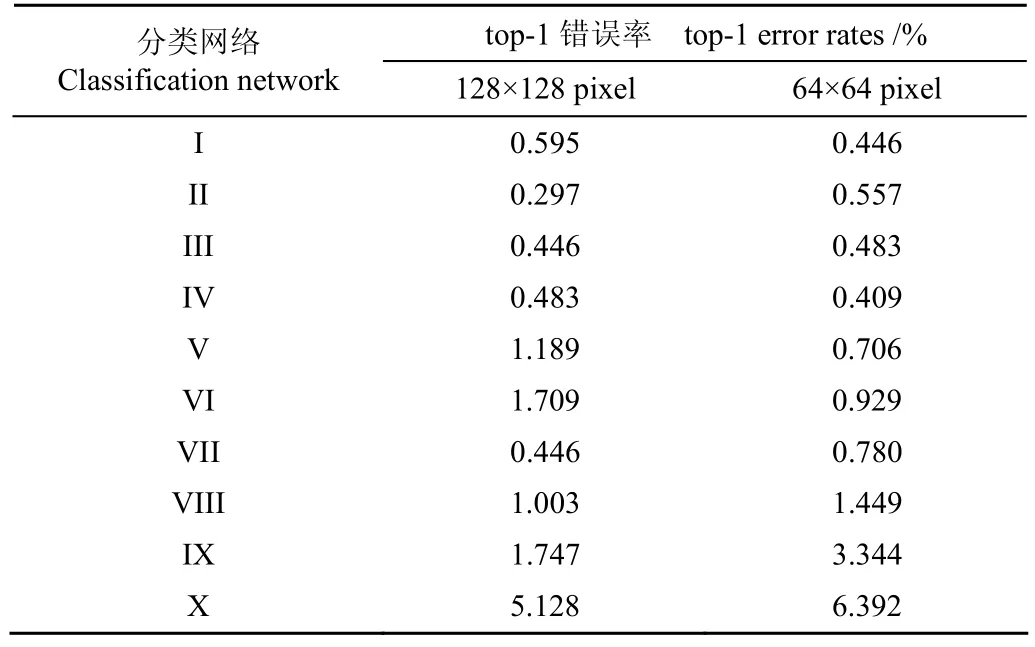

用采集的5分类30 000幅番茄器官图像数据作为样本,其中训练集20 000幅,验证集5 000幅,测试集5 000幅,针对表1中10种网络的2种输入规格,开展相关试验。借鉴ILSVRC的评判标准,使用top-1错误率(top-1 error rate,指没有被网络正确分类的图像的比例)评价各个网络的性能,结果如表3。

表3 2种输入规格下10种网络的分类性能Table 3 Classification performance of 10 networks under 2 input image size

由表3可知,10种网络都具有较高的分类性能,对输入尺寸为128×128 pixel的图像,网络II具有最高的分类精度,网络X的性能最差。针对番茄器官样本,在网络宽度相同的前提下,当CNN网络层数较少时,适当增加网络的层数,可提高网络的分类性能,如网络II的精度要高于网络I。但当继续增加深度时,网络的性能反而有所下降。这可能是由于随着网络深度的增加,前面卷积层的输出特征在向后传递过程中,部分特征被抑制[15],影响了全连接层的分类效果。

在网络深度相同(网络II、VII、VIII、IX、X)的前提下,当增加网络的宽度时,其分类性能有所提高。当宽度增加时,每个卷积层的卷积核数量也会增加,使其可以从输入图像中提取更多的特征,即特征提取更加充分,进而提高网络的分类性能。

从表3可以看出,针对2种网络输入尺寸,当网络的层数较多(网络IV、V、VI)时,64×64 pixel的图像输入比128×128 pixel的输入具有较高的分类性能。这可能是由于在图像缩放过程中,小尺寸的图像抑制了更多的图像噪声,尽管图像在输入网络之前进行了中值滤波,但这种方法并不能滤掉所有图像噪声。当网络较浅或网络的宽度较小(网络II、VII、VIII、IX、X)时,128×128 pixel的输入具有更高的分类性能。这是因为输入为128× 128 pixel的网络经最后一个池化层输出的特征数量是输入为64×64 pixel网络的4倍。据此推测,对于CNN来说,深度网络可能对输入图像的噪声敏感,而浅层网络对输入图像的尺寸敏感。

4 番茄器官的检测识别

番茄器官的识别可通过在一幅植株图像中定位并分割出器官(待检测目标)的矩形边界(候选区域),然后用检测器(识别网络)对候选区域内的图像进行特征提取和分类(检测)的方法实现。

4.1 候选区域选择方法

候选区域选择方法是在整幅番茄植株图像中确定待检测目标边界的方法。候选区域的选择方法和选择数量与目标检测过程中的特征提取的计算量相关,是影响目标检测性能的关键因素之一。本文采用Selective Search (SS)[29]作为番茄主要器官候选检测区域的生成方法。SS采用层次算法对图像进行像素级分割,形成小的区域,然后基于图像低等级特征(颜色、纹理、大小等)对小区域进行合并,生成高质量的、指定数量的目标候选矩形区域,该方法在PASCAL目标检测中取得了良好的效果[29],能够克服传统滑动窗技术生成大量候选区域、检测过程计算量巨大的问题。

4.2 番茄器官识别网络的设计与训练

4.2.1 识别网络设计

如果直接将前文的番茄器官分类网络用于从植株图像中识别番茄主要器官,需要根据Selective Search算法生成的目标候选区域,从植株图像中裁剪出每个区域图像,然后缩放为分类网络所需大小,送入分类网络进行分类识别,这也是R-CNN[17]的实现方式。这种方式需要对每个区域图像分别进行单独的卷积操作,存在大量冗余计算,检测速度慢。本文参考Fast R-CNN,用RoI(Region of Interesting)pooling取代分类网络的最后一个池化层,设计出番茄主要器官识别网络(检测器),命名为TD-Net(图2所示)。这种改进使得检测器只需对整幅植株图像进行一次连续卷积操作,可实现端到端的训练与测试。

图2 基于Fast R-CNN的番茄主要器官检测器(TD-Net)架构Fig.2 Tomato main organs detector (TD-Net) architecture based on Fast R-CNN

TD-Net通过卷积-池化层对输入的整幅图像进行特征提取,生成特征图(feature map, fm),并用Selective Search算法生成大量候选区域,如图2中的1个矩形候选区域覆盖了植株图像中的花。RoI pooling层根据候选区域到fm的坐标投影,从fm上提取各个候选区域特征,并归一化为H×W大小固定的输出特征,经由FC层和soft-max构成的分类器分类,实现每个候选区域的分类识别。

分类性能高的CNN网络,说明其具有强的特征提取和表达能力。表3数据表明输入大小为128×128 pixel的具有8层权重参数的网络II具有最高的分类性能,且与权重层数较多的网络III、IV、V、VI比较,权重参数相对较少、计算量较小,因此TD-Net选择网络II作为其基本结构,用RoI pooling替换网络II的最后一个池化层,并将输出维度H×W设置为4×4。

由于植株形态的原因,在番茄植株图像中,相互簇拥的叶片是图像中的主要部分,为了有效检测出果、花、茎主要器官,将叶片和植株生长环境背景作为果、花、茎检测的背景,即TD-Net需要识别4个分类(背景、果、花、茎)。据此将TD-Net网络的第3个全连接层FC3的神经元数量设置为4,其余2个全连接层保持不变,这种处理方法也可以降低人工标注训练和测试样本的工作量。

4.2.2 TD-Net的训练

随机选择800幅番茄植株图像作为训练集。通过人工对每幅图像进行标注,圈选出果、花、茎的真实区域(ground truth regions, GTRs),并标注区域类别。利用Selective Search方法为每幅图像生成1500个左右的目标候选区域(object region proposals, ORPs)。利用IoU(intersection over union)指标衡量ORP和GTR的吻合程度。

式中IoU表示ORP和GTR的交集面积比上其并集面积。

如果某个ORP和所有GTRs的最大IoU≥0.5,则该ORP被标记为对应GTR内的对象类别(正例)。如果ORP和GTRs的最大IoU<0.2,则该ORP被标记为背景(负例)。为每幅图像选择256个ORPs,其中正例占比不少于25%,其余为负例。由植株图像、图像对应的256个ORPs及其类别标记构成训练样本,用于训练TD-Net检测器。

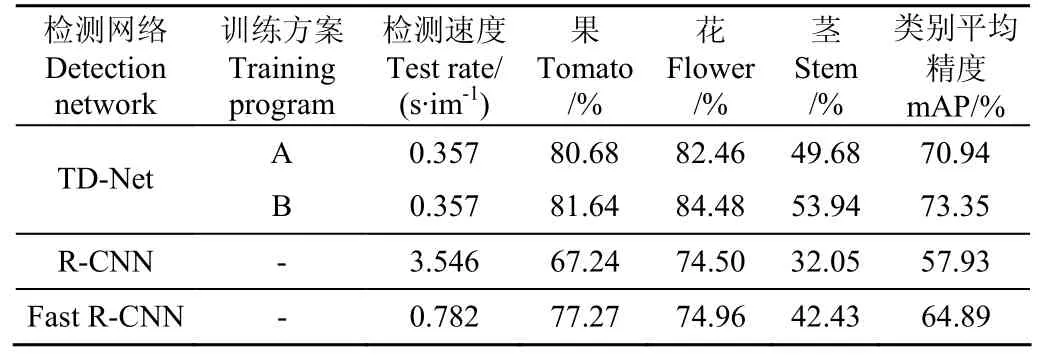

由于TD-Net继承了网络II的基本结构,对TD-Net的训练相对简单。已完成训练的网络II的卷积层能够提取图像特征,因此TD-Net的卷积部分共享网络II的卷积层的权重参数,全连接层FC1和FC2利用网络II的对应全连接层进行初始化,FC3利用均值为0标准偏差为0.01的高斯随机分布进行初始化,偏置初始化为0,并在训练中对各层参数进行微调。本文采用2种方案微调TD-Net:A方案直接将已训练的网络II用于TD-Net的初始化;B方案将植株图像的ORPs的正、负例区域图像截取出来混入网络II的训练样本,继续对网络II进行训练,利用再训练的网络II初始化TD-Net。TD-Net的训练超参数采用与3.2节相同的配置。经过20代(epochs)迭代,A、B方案训练的TD-Net的训练损失均收敛到稳定值。为比对本文方法的有效性,同时利用相同样本,按文献[16]、[18]方法分别训练R-CNN和Fast R-CNN两种检测网络,其中Fast R-CNN采用VGG-16作为基础网络结构。训练与测试环境与3.2相同。

4.3 识别测试与分析

同样用手工方式对由200幅番茄植株图像构成的测试样本进行标注,圈出GTRs并标注对应类别,采用Selective Search为每张图像生成1 500个左右的ORPs。将图像及ORPs作为TD-Net的输入,TD-Net通过soft-max层输出该图像的每个ORP分别属于背景、花、果、茎的概率,其中花、果、茎概率高的ORPs即为目标所在区域。

图像中的同一个目标可能被ORPs中的一个或多个区域完全或部分覆盖,需要对ORPs进行合并,以获得检测目标的数量和精确位置。采用非最大值抑制(non-maximum suppression,NMS)[30]算法对ORPs进行合并。NMS的基本思想是:如果多个ORPs相交,则选择得分最高的ORP作为最后结果,其他ORPs与该ORP的IoU如果高于一定阈值(本文为0.5),则被抑制;如候选区域与其他区域不相交,则直接将该区域作为最终结果。经NMS算法合并后的ORPs是本文方法的最终检测结果,记为LRs。

利用文献[31]的平均精度(average precision, AP)和mAP(mean AP)指标来评价番茄器官的检测效果。在计算AP时,需要获取LRs的真实类别。基于测试集的GTRs获得LRs的真实类别,当LR与GTRs的最大IoU≥0.5时,LR的真实类别与对应GTR相同。用Selective Search方法在测试集上生成相同的候选区域后,分别用TD-Net和上文训练的R-CNN、Fast R-CNN对测试样本进行检测,结果如表4。

表4 番茄器官检测速度及平均精度Table 4 Tomato organ test detection average precision and test rate

表4数据表明,与R-CNN和Fast R-CNN相比,TD-Net在果、花、茎器官的检测上具有更高的精度和速度,对果、花、茎的检测平均精度分别为81.64%、84.48%和53.94%。TD-Net参考Fast R-CNN,都使用了RoI pooling层,不同尺寸和纵横比的候选区域被其池化为统一尺度的特征,且全连接层经大量样本微调后,对不同尺度的候选区域具有一定的鲁棒性,而R-CNN的训练样本为番茄器官图像,图像尺度多样性相对较小,因此TD-Net和Fast R-CNN的识别精度均高于R-CNN。TD-Net使用分类精度更高的网络II作为基础网络,Fast R-CNN使用VGG-16(表1中网络V)作为基础网络,分类精度低于网络II,因此TD-Net的检测精度优于Fast R-CNN。R-CNN需要对每个候选区域分别执行卷积操作,因此R-CNN的检测速度远低于TD-Net和Fast R-CNN。同时TD-Net的卷积层数少于Fast R-CNN,因此TD-Net的检测速度也要高于Fast R-CNN。

试验结果同时说明,用B方案训练的TD-Net比A方案的类别平均精度(mAP)提高2.41%,说明增大样本量可进一步提高CNN的特征提取能力,进而提高TD-Net的检测性能。TD-Net对花的检测效果最好,茎的检测效果最差。由于花的颜色、纹理较单一,易于提取特征。不同成熟度的果颜色差异较大,对果的特征的提取主要以形态轮廓为主。茎的生长形态具有随机性,Selective Search生成的茎的ORPs和人工标注的GTRs吻合程度要小于果和花,因此在计算茎的AP时,一些被检出的茎的ORPs被误认为背景,导致茎的AP较低,但从TD-Net检测结果(图3)来看,本文方法生成的番茄器官候选检测区域(图3中紫色方框)能较好的覆盖植株图像中的主要器官,检测出方框内器官的类型及概率(图3中的flower: 0.96等),由检测结果可知,器官的检测概率均大于0.86,说明TD-Net可有效分类识别出候选区域内的器官类型。该检测器能够对不同成熟度的果和不同花龄的花进行有效检测。

图3 TD-Net检测结果示例Fig.3 Examples of TD-Net test results

4.4 叶子的检测

训练TD-Net时,叶和植株生长环境被合并为背景,因此用TD-Net无法直接识别叶子。可通过对TD-Net的输出中被识别为背景的ORPs做进一步处理来检测出叶片区域。如需检测叶子,可将被识别为背景的ORPs的区域图像从植株图像中裁剪出来,并缩放为128×128 pixel,输入到网络II,由网络II给出每个ORP属于叶片和环境背景的概率。

5 结 论

本文对DCNN在番茄主要器官的分类识别应用方面进行了试验研究和分析。在VGGNet基础上,设计了10种番茄器官CNN分类网络,在番茄器官训练样本上,通过利用多种数据增广技术,对每种网络分别进行训练,试验结果表明,10种网络都具有较高的分类性能,说明CNN网络能够有效地用于番茄器官的分类检测。参考Fast R-CNN,设计了番茄器官检测器TD-Net,用Selective Search算法生成目标候选区域,综合考虑计算时间和分类性能,选择8层CNN网络作为TD-Net基础网络结构,并用植株图像对其进行微调。对比试验结果表明,相较与R-CNN和Fast R-CNN,TD-Net具有更高的识别精度和速度,对果、花、茎的检测精度分别达到了81.64%、84.48%和53.94%,能够有效检测不同成熟度果和不同花龄的花。

[1] 郑小东,赵杰文,刘木华. 基于双目立体视觉的番茄识别与定位技术[J]. 计算机工程,2004,30(22):155-156,171.

Zheng Xiaodong, Zhao Jiewen, Liu Muhua. Tomatoes recognition and location from nature background based on binocular stereo vision[J]. Computer Engineering, 2004, 30(22): 155-156. (in Chinese with English abstract).

[2] 蒋焕煜,彭永石,申川,应义斌. 基于双目立体视觉技术的成熟番茄识别与定位[J]. 农业工程学报,2008,24(8):279-283.

Jiang Huanyu, Peng Yongshi, Shen Chuan, et al. Recognizing and locating ripe tomatoes based on binocular stereo visiontechnology[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2008, 24(8): 279-283. (in Chinese with English abstract).

[3] 王新忠,韩旭,毛罕平. 基于吊蔓绳的温室番茄主茎秆视觉识别[J]. 农业工程学报,2012,28(21):135-141.

Wang Xinzhong, Han Xu, Mao Hanping. Vision-based detection of tomato main stem in greenhouse with red rope[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2012, 28(21): 135-141. (in Chinese with English abstract)

[4] Papageorgiou C P, Oren M, Poggio T. A general framework for object detection[C]// International Conference on Computer Vision. IEEE Xplore, 1998: 555-562.

[5] Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[6] Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]//Computer Vision and Pattern Recognition, 2005. CVPR 2005. IEEE Computer Society Conference on. IEEE, 2005(1): 886-893.

[7] 赵源深,贡亮,周斌,等. 番茄采摘机器人非颜色编码化目标识别算法研究[J]. 农业机械学报,2016,47(7):1-7.

Zhao Yuanshen, Gong Liang, Zhou Bin, et al. Object recognition algorithm of tomato harvesting robot using non-color coding approach[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(7): 1-7. (in Chinese with English abstract).

[8] 郭艾侠,熊俊涛,肖德琴,等. 融合Harris与SIFT算法的荔枝采摘点计算与立体匹配[J]. 农业机械学报,2015,46(12):11-17.

Guo Aixia, Xiong Juntao, Xiao Deqin, et al. Computation of picking point of litchi and its binocular stereo matching based on combined algorithms of Harris and SIFT[J]. Transactions of the Chinese Society for Agricultural Machinery, 2015, 46(12): 11-17. (in Chinese with English abstract)

[9] Lecun Y, Boser B, Denker J S, et al. Backpropagation applied to handwritten zip code recognition[J]. Neural Computation, 1989, 1(4): 541-551.

[10] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]// International Conference on Neural Information Processing Systems. Curran Associates Inc, 2012: 1097-1105.

[11] Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]// Computer Vision and Pattern Recognition. IEEE, 2015: 1-9.

[12] Srivastava R K, Greff K, Schmidhuber J. Highway networks [EB/OL]. https://arxiv.org/abs/1505.00387

[13] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]// International Conference on Learning Representations (ICLR), 2015.

[14] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition(CVPR). IEEE Computer Society, Las Vegas, NV, United states, 2016.

[15] Redmon J, Farhadi A. YOLO9000: Better, Faster, Stronger[C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition(CVPR). IEEE Computer Society, Honolulu, Hawaii, United states, 2017.

[16] Girshick R, Donahue J, Darrell T, et al. Region-based convolutional networks for accurate object detection and segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2016, 38(1): 142-158.

[17] He K, Zhang X, Ren S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(9): 1904-1916.

[18] Girshick R. Fast R-CNN[C]// Proceedings of IEEE International Conference on Computer Vision. IEEE Computer Society, Santiago, Chile, 2015: 1440-1448.

[19] Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector[C]// Proceedings of European Conference on Computer Vision. Springer International Publishing, Amsterdam, The Netherlands, 2016: 21-37.

[20] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, Las Vegas, NV, United states, 2016: 770-778.

[21] Deng J, Berg A, Satheesh S, Su H, et al. ImageNet Large Scale Visual Recognition Competition 2012(ILSVRC2012) [EB/OL]. http://www.image-net.org/challeges/ISVRC/2012/.

[22] Silver D, Huang A, Maddison C J, et al. Mastering the game of Go with deep neural networks and tree search[J]. Nature, 2016, 529(7587): 484-489.

[23] 赵凯旋,何东健. 基于卷积神经网络的奶牛个体身份识别方法[J]. 农业工程学报,2015,31(5):181-187.

Zhao Kaixuan, He Dongjian. Recognition of individual dairy cattle based on convolutional neural networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015, 31(5): 181-187. (in Chinese with English abstract).

[24] Ouyang P, Hu H, Shi Z. Plankton classification with deep convolutional neural networks[C]//IEEE Information Technology, Networking, Electronic and Automation Control Conference. IEEE, 2016: 132-136.

[25] 杨国国,鲍一丹,刘子毅. 基于图像显著性分析与卷积神经网络的茶园害虫定位与识别[J]. 农业工程学报,2017,33(6):156-162.

Yang Guoguo, Bao Yidan, Liu Ziyi. Localization and recognition of pests in tea plantation based on image saliency analysis and convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(6): 156-162. (in Chinese with English abstract)

[26] 高震宇,王安,刘勇,等. 基于卷积神经网络的鲜茶叶智能分选系统设计[J]. 农业机械学报,2017,48(7):53-58.

Gao Zhenyu, Wang An, Liu Yong, et, al. Intelligent fresh-tea-leaves sorting system based on convolution neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2017, 48(7): 53-58 (in Chinesewith English abstract)

[27] 李政,李永树,吴玺,等. 基于卷积神经网络的空心村高分影像建筑物检测方法[J]. 农业机械学报,2017,48(6):132-137.

Li Zheng, Li Yongshu, Wu Xi, et, al. Hollow village building detection using high resolution remote sensing image based on CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2017, 48(6): 132-137. (in Chinese with English abstract)

[28] Agarwal A, Akchurin E, Basoglu C, et al. An introduction to computational networks and the computational network toolkit[EB/OL]. https://www.microsoft.com/en-us/research/ wp-content/uploads/2014/08/CNTKBook-20160217.pdf.

[29] Uijlings J R R, Sande K E A V D, Gevers T, et al. Selective search for object recognition[J]. International Journal of Computer Vision, 2013, 104(2): 154-171.

[30] Neubeck A, Van Gool L. Efficient non-maximum suppression[C]//International Conference on Pattern Recognition, IEEE, 2006: 850-855.

[31] Everingham M, Gool L V, Williams C K I, et al. The pascal visual object classes (VOC) challenge[J]. International Journal of Computer Vision, 2010, 88(2): 303-338.

Classification and recognition approaches of tomato main organs based on DCNN

Zhou Yuncheng, Xu Tongyu, Zheng Wei, Deng Hanbing

(College of Information and Electrical Engineering, Shenyang Agricultural University, Shenyang 100866 China)

Recognition of the main organs of tomato from plant images has important significance for the detection of plant diseases and insect pests, the application of targeted pesticides, and the development of intelligent agricultural machinery. The traditional object recognition methods which are limited by hand-engineered features extraction process and the selection of filter operator types, have poor generality and low recognition accuracy. The convolutional layers of convolutional neural network (CNN) can achieve automatic extraction of image features. In view of this, we propose a tomato main organs recognition method which relies on deep convolutional neural network (DCNN) in this paper. Under different illumination conditions, and considering the morphological diversity of tomato organs, 5 kinds of images including flower, fruit, stem, leaf, and environment background and the plant images are collected, which are used as training and testing samples. Under the premise of maintaining the basic structure of VGGNet, by adjusting the number of convolutional kernels and the depth of convolutional layers, 10 kinds of tomato organs classification networks are constructed. To reduce overfitting on tomato organ image dataset, before using the dataset to train the individual network, we use many data augmentation techniques to enlarge the dataset such as label-preserving transformations, specifically image rotation at random angles, extracting random patches of one image, image flip horizontal, and altering the intensities of the RGB (red, green, blue) channels of training images. At the same time, the median filter is used to denoise image samples. We train our models end to end using stochastic gradient descent with input image size of 64×64 or 128×128 pixels, mini-batch size of 128 examples, and momentum of 0.9. The classification test results show that the 10 kinds of networks all have very good classification performance by top-1 error rate. Among the 10 kinds of networks, the 8-layer structure network’s top-1 error rate is 0.297%, which has the best classification performance. The results reveal that 8-layer structure network can satisfy the features extraction and classification requirements of tomato image dataset with fewer categories. Considering the classification performance and computing speed, referencing Fast R-CNN, with the 8-layer structure network as the basic architecture, and using the region of interest pooling (RoI pooling) layer to replace the last maximum pooling (max-pool) layer, a tomato main organ detector is designed, and named as TD-Net. The detector can output the category probabilities for each object proposal through the soft-max layer. The selective search algorithm is adopted for generating a large number of proposal regions for each tomato plant image, and the non-maximum suppression algorithm is used to suppress the outputs of the TD-Net. Using plant images and proposal regions as input, the detector is trained iteratively. The detection experiment results show that the detection average precisions (AP) of the DCNN-based tomato organ detector for the fruit, flower and stem are 81.64%, 84.48% and 53.94% correspondingly, and the detector can effectively identify the fruits of different maturity degree and the flowers of different flower age. On the same tomato plant image dataset, compared with R-CNN and Fast R-CNN, TD-Net has a better detection performance and detection speed, which illustrates that the method of this paper is effective.

object recognition; image processing; pixels; tomato organs; deep convolutional neural network; data augmentation; deep learning

10.11975/j.issn.1002-6819.2017.15.028

TP183

A

1002-6819(2017)-15-0219-08

2017-03-06

2017-07-25

辽宁省科学事业公益研究基金(2016004001);国家自然科学基金(31601218)

周云成,男,安徽阜阳人,副教授,博士,主要从事机器学习在农业信息处理中的应用研究。沈阳 沈阳农业大学信息与电气工程学院,100866。Email:zhouyc2002@163.com