基于视觉的机器人自主泊位系统研究

2017-06-29周菁

周菁

(中国电子科技集团公司第二十研究所雷达部西安710068)

基于视觉的机器人自主泊位系统研究

周菁

(中国电子科技集团公司第二十研究所雷达部西安710068)

针对日益增高的对机器人自主性的要求,以及视觉系统在自主泊位方面的研究还相对较少的现状,论文提出一种基于视觉的机器人自主泊位系统。该系统由视觉子系统、基于bang-bang控制方案的导航子系统、位姿校准子系统、和行为协调状态机组成。论文提出的机器人自主泊位系统能使移动机器人自主运动并停靠到由人工标识物指定的特定位置上。该系统的潜在应用包括机器人自行前往续能站以解决机器人能源自治问题,无人船到港泊位问题等,具有重要的军事和民用价值。物理实验结果表明,该泊位系统设计正确,满足实时性要求,易于实现。

视觉系统;自主泊位;位姿校准

Class NumberTP242

1 引言

轮式自主移动机器人是一个具备外部环境感知、自主决策和导航行驶的一体化综合系统。机器人对外部环境的感知按照传感器类型可分为被动感知和主动感知两种。其中依靠对可见与不可见光成像的方法进行感知的模式称为被动感知,例如使用CCD相机的视觉系统;而使用声纳、激光、雷达等主动收发脉冲信号的传感器进行探测的模式称为主动感知。基于视觉系统的主动感知具有信息量大、智能程度高的优点,即使经图像压缩处理丢弃大部分信息后,也比激光等主动传感器更精确[1]。因此,视觉系统在机器人焊接、分拣[2]、装配[3]、智能制造[4]等方面具有广泛的应用,但在自主泊位上的研究还相对较少。机器人自主泊位是指移动机器人自主运动到特定的位置和方向位姿的过程[5]。让机器人自行前往续能站进行自主泊位是机器人解决能源自治问题的关键环节,具有重要军事和民用价值。本文提出一种基于视觉的机器人自主泊位系统,该系统由视觉子系统、基于bang-bang控制方案的导航子系统、位姿校准子系统、和行为协调状态机组成。

2 机器人视觉子系统

1973年,Shirai和Inoue提出利用视觉系统采集的图像来获取关于某景物或动作的描述和控制数据的概念[6]。本文所设计的机器人视觉子系统完成对图像的自动采集与分析,将获得的泊位标识物位置作为反馈信息以完成机器人泊位任务。

2.1 视觉子系统的组成

机器人视觉子系统的组成如图1所示。

原始图像由视觉子系统逐步处理和分析,完成对标识物的分割、提取、定位、符号性描述等,最终生成机器人执行泊位任务时所依赖的信息。该子系统由四个模块组成,按照从左到右的顺序依次为:

1)图像金字塔模块:压缩图像以提高信息处理速度;

2)反向投影模块:基于颜色直方图的目标分割;

3)外接矩形模块:目标提取;

4)行为信息生成模块:生成与标识物方位相关信息。

图1描述的视觉子系统具有瀑布式信息获取模式,体现在每个模块的输出都会服务于下一个模块。设视觉传感器获取的一帧原始图像表示为FS,令FS作为输入信号进入管道,经过模块1-2之后,机器人完成了目标分割工作F′S=δ1-2()

FS,产生目标的反向投影图像F′S输入下一模块;经过模块1-2-3之后,机器人完成了目标提取工作F″=δ(F′),产生目标的轮廓和外界矩形的图像S3SF″输入下一模块;经过模块1-2-3-4之后,产生S标识物位置数据。

2.2 行为信息生成模块

本文中行为信息指由机器人所在出发地运动到标识物所在目的地的导航信息。它定义在机器人的图像平面(Image plane)中,依靠几何原理计算而得。将图2中左边的真实图像至于如右图表示的图像平面中分析。

在机器人图像平面中,点R=(Rx,Ry)表示机器人中心,点I=(Ix,Iy)表示图像平面中心,点T=(Tx,Ty)表示目标坐标,其中目标坐标定义为目标的外接矩形边界框的中心点坐标。行为信息N=[α,δ]由图像平面中心I和机器人中心R两点决定的线段与机器人中心R与目标坐标T两点决定的线段之间夹角∠IRT(简称∠α)的大小和方向定义。

1)运动角度

角度变量∠α的值由余弦定理计算得到:

2)运动方向

方向变量表示为δ,规定-1表示机器人的运动方向向左,+1表示机器人的运动方向向右:

3 基于bang-bang控制方案和行为的导航子系统

如图2所示,已知机器人行为信息中运动角度∠α是由视觉系统得到的当前图像中机器人R与目标T之间的夹角。机器人要驶向并最终停在泊位,必须实现自主导航,让自己在靠近泊位T的同时不偏离。规定在行驶过程中R与目标T之间的偏差不大于临界值φ*=10°,否则R就要进由控制器C修正R的位姿,C的输入控制量pv的赋值由bang-bang控制方案决定,导航子系统的工作原理由如下算法表示:

算法1基于bang-bang控制方案和机器人行为的导航算法

其中机器人Do_adjustment行为由姿态校准子系统控制,设原始角集合X={α},校正角集合Y={φ||φ|≤φ*},姿态控制C由映射C:X↦Y表示。

4 位姿校准模块

为了使机器人R能够运动到标识物T所在的目的地,本文设计控制器C来校正机器人的位姿,因此控制器C称为“位姿校准”(Pose-Adjustment,PA)控制器,它使得机器人的位姿在校正后能够正面对准目标。PA控制器方框图由图3给出,由PID控制实现闭环控制。PA控制器第一次运行时的控制流与后续不同,在第一次循环时,开关S1处于开状态,开关S2选择路径a-b1;在后续控制中,控制器的输入增加了由上一次循环产生的误差,因此开关S1处于闭状态,开关S2选择路径a-b2。

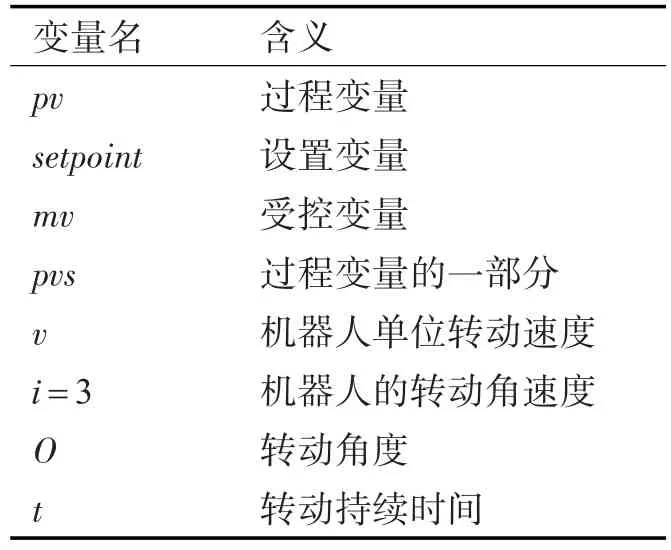

PA控制器作为每次循环的最终输出控制信号的是机器人的旋转时间。机器人的转动速度表示为ω=α·v,其中α为运动信息角的大小,v表示机器人的单位转动速度,所以PA控制系统本质上是通过控制转动时间来控制转动角度的。PA控制系统的具体实现由算法2阐述,系统所涉及参数如表1所示。其中i代表循环次数,O(i)代表第i次循环的旋转角度,t(i)代表旋转的持续时间,ω是机器人的转动速度,与角度α成正比,α越大转动速度越大,反之亦然,ceil(x)表示上取整函数。

算法2位姿校正PID控制算法

表1PA控制系统参数说明

5 行为协调状态机

机器人通过行为状态机来描述其边走边看(Look_then_move)的行为逻辑,去协调其在泊位过程中的姿态调整行为、前进直行行为、泊位完成行为、和失败放弃行为。

5.1 图像特征提取

在机器人导航行驶的中判别自己是否到达泊位标志物位置是自主泊位的重要环节。因此需要定义图像特征,将由视觉系统实时获取的图像特征信息与预先给定的图像特征信息直接进行在线比较,根据误差来判断任务的完成。因此首先需要在图像中定义出机器人成功完成目标任务的一组特征。

在目标图像(goal image)的特征参数选择上,视觉系统具有处理大量图像数据的压力,而机器人终端执行器的反应确是实时的,因此视觉系统采用目标原语特征,如目标轮廓(contours)[7~9]或者区域(regions)、中心(centroid)等[10~11],以达到加快视觉系统处理速度的目的,缩短机器人反应时间,达到实时性要求。

定义1图像特征是指一组在图像平面上定义的原语,表示为V=[p1,p2,p3,…,pm]。在本文中令m=3,(p1,p2)表示任务的中心坐标,p3表示任务的面积,设目标图像的特征向量表示为V*=[Tx,Ty,TA],当前图像的特征向量表示为V=[tx,ty,tA]。

5.2 示教策略

本文通过示教策略(Teach-by-showing strategy)对直接定义在图像特征空间中的目标特征信号赋值,需要人为定义泊位完成场景和示教图像,由图4所示。定义1已经选择泊位标识物的中心坐标和面积作为图像特征。对目标图像特征信号赋的值是人为教授给机器人的泊位成功时的图像特征值。图4(a)表示的是泊位完成的场景,相应的图4(b)表示的是用于教授机器人泊位完成的示教图像,记录此时目标图像的特征信号值,作为示教值。

已知目标图像的特征向量为V*=[Tx,Ty,TA],当前图像特征向量为V=[tx,ty,tA],机器人将实时测量得到的图像特征与由示教图像赋值的目标图像特征直接进行在线比较,得到误差E,用以确定机器人是否达到泊位控制效果。设,误差定义为

5.3 行为状态机

机器人在进行泊位的过程中,按行为的不同将机器人划分为处在四种不同的状态中,即S={S1,S2,S3,S4}。其中状态S1表示姿态校正,S2表示前进,S3表示泊位完成,S4表示失败放弃,行为之间的转移由状态转移条件T={T1,T2,T3}决定。有限状态机∑=(S,S0,T,F)是根据机器人Look_then_move策略建模的,其中S0={S1}表示初始状态是姿态校正行为,F={S3,S4}表示最终状态的集合,即机器人成功泊位或丢失目标泊位失败。

由式(3)可知,机器人通过比较目标图像特征V*和实时图像特征V的差距来判断是否已经成功泊位,差距表示为两种特征之间的加权欧氏距离η(V,V*),定义为

其中fi1是标识物在图像平面的坐标,fi2是标识物在图像平面的的面积,wi是相应的权重,i=1,2。

图5所示的有限状态机描述了机器人在四个状态之间的转换,其中Tj(j=1,2,3)表示状态转换的条件,分别为T1:|α|≤φ*,ξ(t),T3:A≡0,其中lt→im∞P(t)=[μ1,μ2,…,μj,…,μN]是当前图像中机器人与目标之间的夹角,d是差距阈值,A是目标的面积,状态之间的转移由表2描述。

表2 状态转移表

6 结语

本文提出一种基于视觉的机器人自主泊位系统,该系统由视觉子系统、基于bang-bang控制方案的导航子系统、位姿校准模块和行为协调状态机组成。过程演示如图6所示,其中参数的赋值如下:w1=0.4,w2=0.6,f21=[40,40],f22=600,d= 10。机器人首先需要发现绿色泊位标识物,驶向目标,最终完成泊位。机器人在判断出自己成功地完成任务之后,做一个大转弯的动作表明已经成功了,因此物理实验结果证明了该方法的有效性。

[1]丁辉,付梦印.基于标志点识别的自主车视觉导航[J].光学技术,2005,31(6):864-867

[2]倪鹤鹏,刘亚男,基于机器视觉的Delta机器人分拣系统算法[J].机器人,2016,38(1):49-55.

[3]郑魁敬,潘春莹,机器人装配中的视觉引导定位技术研究[J].制造技术与机床,2016,3:84-90,.

[4]王耀南,陈铁健,智能制造装备视觉检测控制方法综述[J].控制理论与应用,2015,32(3):273-286,.

[5]陈凤东,洪炳镕,一种基于图像的移动机器人泊位方法[J].机器人,2010,32(2):166-170,.

[6]Y.Shirai and H.Inoue.Guiding a robot by visual feedback in assembling tasks[J].Pattern Recognit.,1973,5:99-108.

[7]B.Espiau and P.Rives,Closed-loop recursive estimation of 3D features for a mobile vision system[C]//Proc.IEEE Int.Conf.on Robotics Automat.(Raleigh,NC),1987,3:1436-1443.

[8]C.L.Fennema and W.B.Thomson.Velocity determination in scenes containing several moving objects[J].Computer Graphics Image Process,1979,9:301-315.

[9]A.L.Gilbert et al.,A real-time video tracking system[J]. IEEE Trans.Pattern Anal.Machine Intell.,1980,1:47-56.

[10]P.Rives,Dynamic vision:Theoretical capabilities and practical problems[C]//Proc.NATO Workshop Kinematic and Dynamic Issues in Sensor Based control(Italy),Oct.1987:251-280.

[11]L.E.Weiss,Dynamic visual servo control of robots:An adaptive image based approach[R].Carnegie-Mellon Univ.,Pittsburgh,PA,Tech.Rep.CMU-RI-TR-84-16,1984.

Research of Vision-based Robot Autonomous Docking System

ZHOU Jing

(Radar Department,20th Research Institute of China Electronics Technology Group,Xi'an710068)

A vision-based autonomous docking system is proposed is this paper in view of the increasing demand for robot autonomy and the research of autonomous docking based on vision system is relatively few.The proposed system consists of a vision subsystem,a navigation subsystem based on the bang-bang control scheme,a pose-adjustment subsystem,and a state machine for behavior coordination.In this paper,the autonomous docking system can make the mobile robot move and dock to the specific location autonomously,which is specified by the artificial marker.The potential applications of the system include to allow the robot go to the renewable energy station by itself to solve the energy autonomy,and the problem of unmanned ship autonomous docking and so on.The experimental results show that the system is correct and meets the real-time requirements。

vision-based system,autonomous docking,pose adjustment

TP242

10.3969/j.issn.1672-9730.2017.06.008

2016年12月7日,

2017年1月18日

自然科学基金(编号:61403311)资助。

周菁,女,博士,助理工程师,研究方向:多智能体系统。