体感操控多臂棚室机器人作业决策规划算法研究

2017-04-19权龙哲李成林冯正阳刘佳伟

权龙哲 李成林 冯正阳 刘佳伟

(东北农业大学工程学院, 哈尔滨 150030)

体感操控多臂棚室机器人作业决策规划算法研究

权龙哲 李成林 冯正阳 刘佳伟

(东北农业大学工程学院, 哈尔滨 150030)

针对目前棚室内机器人作业分析算法智能性不足、准确作业率较低,且一次巡航过程只能进行单一作业,存在使用效率不高的问题,提出了一种搭载在三臂棚室机器人上,基于体感操控作业的决策规划算法,用Kinect采集含操作人员位姿信息的深度图像,结合随机森林统计学习理论和基于高斯核函数的Mean shift算法,确定了代表人体位姿的20个关键骨骼点坐标,在此基础上提出了一种基于模式切换的三臂映射关系,将骨骼点信息映射到机器人工作空间,使人的两只手臂能自如的控制三臂机器人,在一次巡航中完成多种棚室作业;此外,还提出了一种结合骨骼追踪技术和YCbCr颜色空间的手势特征分割方法,实现了用手势控制机器人末端执行器作业。最后,搭建了用于测试体感决策算法的三臂机器人样机,进行了针对该决策算法的精确性试验,根据试验误差数据对肩部关节夹角采用离散化取值识别,解决了肩部关节识别误差,结果表明:测试者被捕捉到的关节处夹角和机器人对应关节夹角的最大映射误差为1.90°,上位机发送夹角值与机器人实际转动的夹角值最大误差为0.80°,在误差允许范围内,同时在该精度下完成一套采摘加喷施作业指令,平均耗时13.34 s,且操作者还可通过体感操控训练进一步提高机器人作业性能,表明该算法具有准确性和实用性。

多臂温室机器人; 决策规划; 体感技术; Kinect传感器

引言

现代智能棚室及植物工厂多为闭锁式农产品生产系统,为避免作物大面积染病,进入厂区的工作人员需更换无尘服并接受全面除菌消毒,另外人员长期处于密闭环境中开展采摘、喷施等棚室作业不利于身体健康[1-2],利用农业机器人代替人工作业是有效的解决途径[3-4]。国内外学者在基于自主视觉的基础上,对葡萄喷药、收获[5-6],番茄采摘、分拣[7-9],草莓[10]、黄瓜采摘[11-12],猕猴桃收获[13]等农业机器人进行了研究,取得了较大进展,但为适应复杂的田间环境及多变的作业需求,目前相关研究人员正致力于进一步提升机器人的智能性。

目前在工业领域,国内外学者[14-21]设计并研制基于Kinect体感操作的机械臂或机器人,可由人直接远程操控,实时模仿人体动作,代替人完成某些繁重、危险的作业,具有较高的实用价值;但经查阅资料发现,该应用思路在农业领域未见报道。针对上述传统智能棚室或植物工厂人工作业模式存在较多弊端,而智能农业机器人系统的普适性尚需完善的现状,本文设计一种基于 Kinect 的远程体感操控农业机器人,将远程体感操控技术应用于无人棚室及植物工厂中,避免人员的频繁进出及辛劳作业;由人代替智能算法进行识别,运用体感技术使机器人模仿操作人员的动作进行采摘、喷施等棚室作业,达到整个运动规划过程由人完成,且该过程对于人来说是极其容易的;考虑到当前棚室机器人在一次巡航过程中基本为单一作业,存在效率较低的现状,为机器人设计三臂结构以提高效率,并针对此结构提出一种基于模式切换的三臂映射关系和结合骨骼点信息与YCbCr颜色模型的手势特征提取算法,使操作人员可轻松操控三臂机器人在一次棚室巡航中完成如采摘、施肥等多种作业。

1 基于体感操控的三臂机器人

1.1 机械构型

图1所示是用于搭载体感决策算法的三臂棚室机器人样机。该机器人由三臂作业机构、自锁升降机构、履带底盘、机器人控制系统、视觉系统5部分组成。三臂结构中的右臂末端执行器可对目前棚室或植物工厂种植的大部分果蔬进行采摘,并将采摘后的果蔬放入左臂末端的果蔬收纳盒中,从而使机器人在一次棚室巡航作业中能采摘更多的果蔬,提高机器人的工作效率;后臂末端的三通道喷洒机构能分别喷洒水、营养液、农药,以满足智能棚室或植物工厂作物在不同生长时期的需求。自锁升降机构使机器人能适应不同高度的棚室作物。旋转圆盘承载整个机器人上半身,使机器人上半部分能够旋转,是实现三臂模式切换和全方位作业的基础。履带底盘由2个直流无刷电动机驱动,能够实现原地转向和无级变速。

图1 三臂多功能棚室农业机器人机构简图Fig.1 Structure diagram of three-arm multi-function greenhouse agriculture robot1.旋转底座 2.剪切器 3.右臂 4.可更换式抓持器 5.储液罐(共3个) 6.自锁升降机构 7.履带底盘 8.旋转圆盘 9.果蔬收纳盒 10.三通道喷洒机构 11.左臂 12.后臂 13.无线摄像头

1.2 工作原理

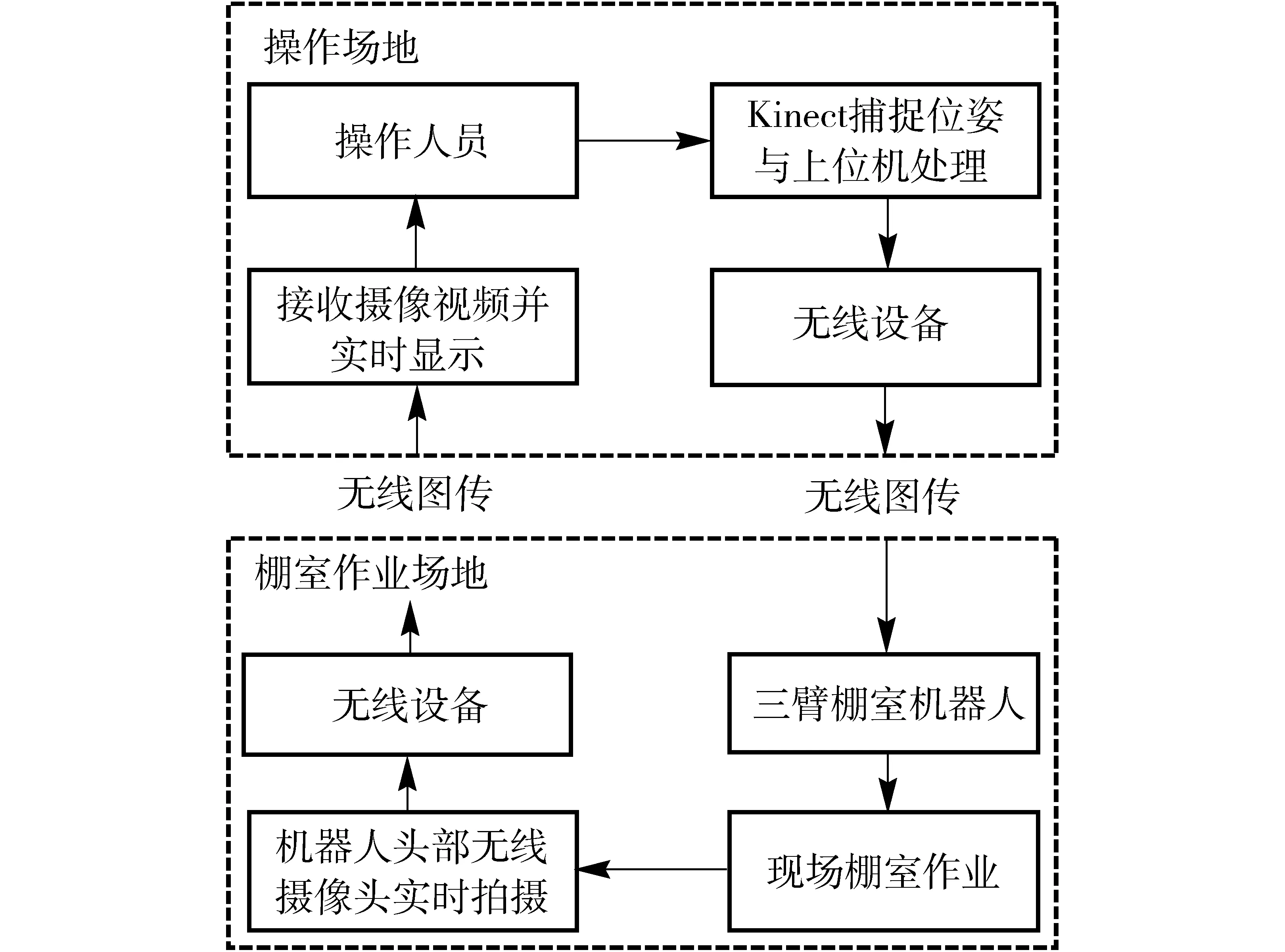

机器人控制系统通过无线设备接受上位机的命令,控制各关节伺服电动机转动。机器人视觉系统由无线摄像头、Kinect体感摄像头和上位机组成,Kinect采集人体动作信息,通过无线设备将信息发送给机器人,使机器人模仿人体动作进行作业,实现人员对机器人的远程体感操控;机器人头部装有无线摄像头,摄像头底座为旋转底盘,可扩大视角,负责对棚室或植物工厂内工作环境进行实时监控,并用无线设备将摄制的视频回传到上位机,整个机器人工作流程如图2所示。其中,欲实现机器人在体感操控下的棚室作业,首先需使用Kinect采集人体动作信息并映射到机器人工作空间,因而人体信息的准确采集和映射关系的对应建立是实现三臂机器人棚室作业的基础。

图2 三臂多功能棚室农业机器人工作流程图Fig.2 Work flow of three-arm multi-function greenhouse agriculture robot

2 面向三臂机器人操控的人体动作信息采集

2.1 骨骼点数据预处理

由深度图像得到面向三臂操控的骨骼点数据,本文采用Kinect获得操作人员的深度图像。Kinect由红外线发射器、RGB摄像头、红外线接收器和麦克风阵列组成,采用光编码技术进行景深成像,生成操作人员所在场景的深度信息[22]。得到深度图像后,计算出每个像素点归一化的深度差信息作为该点的特征量,即

(1)

其中

θ=(μ,v)

式中dI(x)——包含操作人员的图像I中像素x的深度

μ、v——偏移量

使用随机决策树和森林分类器对该深度图像像素点的特征向量与决策树的阈值τ进行比较,根据结果往左或右划分,算出x像素在t棵树中的条件概率分布,最后得到所有树的分布平均值P(L|I,X)为

(2)

式中T——决策树的个数Pt(L|I,X)——图像I中x像素在第t棵树中的条件概率分布

将其值作为最终的分类依据,把像素点划分到对应骨骼点的归属集合,在此为能够表示操作人员位姿且考虑到三臂操控的需要,将集合数设定为20个(即最后得到的骨骼点数为20)。此后,还需从这些集合中找到概率分布峰值对应点,将其作为被捕捉的操作人员骨骼点坐标[23]。在此,本文采用引入高斯核的Mean shift算法,其主体公式为

(3)

其中

wic=P(c|I,xi)dI(xi)2

2.2 骨骼点数据规划

经上述算法得到骨骼数据后,将其导入到上位机中,将得到的骨骼点数据转化为一个20×3的矩阵,该矩阵中每行的数据分别对应一个骨骼点的x、y、z坐标,坐标单位为m,骨骼点坐标的建立方式如图3所示,其中z轴坐标表示人到Kinect的距离,y轴坐标表示各个骨骼点与xOz平面的距离,x轴坐标则表示骨骼点与yOz平面的距离。

图3 Kinect骨骼点世界坐标系建立示意图Fig.3 Schematic of Kinect of skeletal points in WCS

然后把具有三维坐标的20个骨骼点经坐标变换,对应映射到RGB摄像头所摄图片的二维像素坐标系中,最后绘出操作人员操控三臂机器人所需的20个骨骼点坐标在RGB图片中的分布位置,如图4所示,且对各个骨骼点进行命名,以便表达。

图4 面向三臂机器人操控的骨骼架构示意图Fig.4 Schematic of skeletal point for three arms robot1.头部 2.肩部 3.右肩 4.右肘 5.脊椎 6.右腕 7.右手8.右髋 9.右膝 10.右踝 11.右脚 12.左脚 13.左踝 14.左膝 15.左手 16.左腕 17.左髋 18.臀部 19.左肘 20.左肩

3 骨骼点信息与三臂机器人映射关系的建立

将Kinect骨骼点数据导入上位机初步处理后,接下来便将含人体动作特征的骨骼点信息对应映射到机器人工作空间,该步骤正是实现体感操控机器人的关键。但考虑到机器人具有三臂结构,且3个机械臂对应不同的棚室作业类型。如何使人两臂能自如控制棚室三臂机器人作业是保证其功能与效率的前提。在此,提出一种基于模式切换的三臂映射关系,以实现人体两臂控制机器人三臂作业。

3.1 骨骼点数据处理

根据三臂机器人结构特点,把机器人作业的模式分为作业模式和巡航模式。其中作业模式又分为采摘模式和喷施模式,采摘模式指机器人在无人棚室或植物工厂中对已成熟的作物进行采摘作业;而对于其中未成熟、营养不足或出现病虫害的作物,体感操控机器人切换到喷施模式,对作物进行浇水或施肥或除虫作业。机器人的巡航模式则对应在棚室或植物工厂中移动、转向。对于机器人前进、后退、转向、作业状态之间的切换,本文根据人相对于Kinect空间位置的不同,作为进入不同模式的依据,该位置量化为向量

(4)

其中α为体感算法捕获到人体骨骼点舍去y值后的坐标,用以表示操作人员在xOz平面中与Kinect的位置关系,这样可使切换模式不会受人身高和Kinect竖直摆放位置的影响,使整套控制决策算法具有普适性。而对于具体使用哪个骨骼点(x,z)作为人体空间位置的表示,考虑到脊椎点处于Kinect骨架的中间部分,且该点对操作人员身高、姿态、外界干扰等各种因素具有较小的敏感性,能很好的表示人体在xOz平面的位置信息,因此本文采用脊椎的x、z坐标来表示人体相对于Kinect的位置。同时对于模式切换时的阈值规划,本文将Kinect视野范围划分为如图5所示的若干个区间,机器人根据人体脊椎点所属区域不同而进入不同的工作模式。将各个区间的长宽值整合为一个阈值矩阵

(5)

其中,l1=100 cm,l2=50 cm,l3=100 cm,l4=50 cm,l5=50 cm,l6=60 cm,l7=50 cm,l8=250 cm。

在此,为方便说明,将阈值矩阵T中的各个长度元素看成1个长度区间的集合。

图5 体感操作区域平面示意图Fig.5 Schematic of Kinect operation area

由此可得,当满足

(α(3)∩T(1,2))∩(α(1)∩T(2,2))≠∅

(6)

时,参照图5可知,人体被上位机识别为进入前进区域;此时机器人开始向前直线运动,即进入巡航模式。其他模式的切换同理。

3.2 基于模式切换的三臂映射关系

考虑到划分过多、区域过小时可能出现识别跳变,导致模式切换稳定性较差,本文将采摘模式和喷施模式都集成为作业模式,根据上述阈值判断法,若满足

(α(3)∩T(1,3))∩(α(1)∩T(2,2))≠∅

(7)

时,则被识别为进入作业区域,此时机器人只能在采摘模式和喷施模式之间切换,进行采摘或喷洒作业。因此需设定一个特征量作为模式切换决策阈值,该特征量需具有以下特点:①特征量对周围环境干扰具有较强的鲁棒性。②不与三臂体感操作相干扰。以保证模式切换的准确性和处在某一模式作业时的稳定性。

3.2.1 基于统计方法寻找模式切换最优特征量

考虑到该机器人上部为三臂结构,下部为履带式移动平台的特点,人体上部的骨骼信息映射数量较多,而下部则仅由脊椎骨骼点空间坐标便可控制机器人底盘运动,造成下部分的骨骼点都未得到利用。因此,可将人体下部分的骨骼点构成一个可作为模式切换的特征量。本文从骨骼点架中左腿选取2个骨骼点,再从右腿中选取与之对称的2个骨骼点,共4个骨骼点分别组成代表左右腿的两向量,将其称为1个向量组,用其夹角表示人两腿之间的夹角,并以此作为模式切换特征量,但如何选取出夹角值不受其他动作干扰的向量组合是保证模式切换效率与稳定的关键。在此,本文随机征集了身高范围在165~190 cm,体重范围在45~90 kg的10位测试者,收集了他们在较长时间(5 min)进行采摘或喷洒作业时腿部骨骼点坐标数据。取时间步长为1 s,利用分别位于两腿对称位置的骨骼点组合出6组能表示双腿夹角的向量组合,计算出5 min内每1 s每个向量组合夹角,每人1个向量组合,300组夹角数据,再对每人6个向量组合的300组夹角分别求方差,最后把10位测试者对应每个组合的向量夹角方差求平均值,得到表1所示数据。

表1 测试者Kinect骨骼点向量夹角方差统计Tab.1 Statistics of variance in testers’ Kinect skeletal joints

注: H-K表示骨骼点右髋与骨骼点右膝形成向量与右腿对应骨骼点左髋和骨骼点左膝形成向量的夹角,其余向量组合均用此方法解释。

表1中,H-K向量组合的夹角方差平均值最小,表明这4个骨骼点表示的夹角几乎不会受其他作业动作影响,能够满足棚室作业时对模式切换稳定性的要求。于是用这4个点像素坐标构成向量组合的夹角,作为模式切换的特征量,从图4可看出,该特征量对应的人体特征为操作人员左右髋部骨骼点到两膝骨骼点之间形成的向量组在空间上的夹角,空间上的夹角稳定也就意味着其在xOy与yOz平面上夹角的稳定。设Kinect骨骼点中右髋、 左髋、 右膝、 左膝在平行于xOy平面上的骨骼点坐标分别为(x1,y1)、(x2,y2)、(x3,y3)、(x4,y4)。

设模式切换特征量为

(8)

其中

(9)

(10)

本文设定一个阈值Tτ=12°,当T1>Tτ时,机器人处于采摘作业模式,其左右两臂根据人体映射到机器人工作空间的骨骼点信息进行采摘作业,反之则进入喷施模式。同样,再将H-K向量组合在yOz平面上的夹角定义为一个特征量

(11)

其中

(12)

(13)

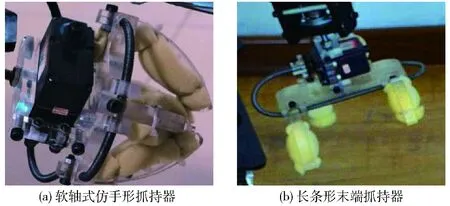

设定一个阈值Tξ=14°,当T2>Tξ,且保持该状态超过4 s时,头部摄像头下面的伺服电动机便开始转动,以增大视角范围,T2 3.2.2 肩部关节映射关系的建立 机器人的手臂构造与人臂不同。如图6所示,机器人的肩关节只有2个空间自由度;而对于人臂,在只考虑肩关节和肘关节时,人臂有5个自由度。在此,先设β0为右肩关节与右肘关节骨骼点构成的向量,β01、β02分别表示β0在xOy平面和yOz平面投影得到的向量,于是把人的右肩部运动位姿分解为向量β01与平面β1以及β02与平面β2的夹角,设右肩关节与右肘关节点的坐标分别为(xs,ys,zs)、(xe,ye,ze),则 (14) (15) (16) 把β01与β1面夹角映射到机器人工作空间作为轴C2的转角。且由于β1面平行于骨骼点坐标空间的yOz平面,因此,向量β01与平面β1夹角即为β01与yOz平面的夹角,可求得 (17) 其中 同理,β2面平行于骨骼点坐标空间的xOy平面,可求得β02与β2平面夹角,即对应C1转角 (18) 右肩关节与右肘关节组成的向量与平面夹角为0°时,对应机器人相应关节处伺服电动机的零位。 图6 人体肩关节运动信息到机械臂关节的映射Fig.6 Mapping of Shoulder in motion information to joint of robot arm 3.2.3 肘部关节映射关系的建立 人的肘关节为球销副,具有2个空间自由度,但绕手臂自身轴线旋转的动作无法被Kinect识别。因此,Kinect只能捕获到1个自由度的肘关节信息,但恰与肘部为转动副连接的机器人运动特点相对应。但是由于肘关节和腕关节相对于世界坐标系的位置由肩关节的位姿决定,造成了表示肘部关节位姿时无法像上述肩关节夹角一样与某固定平面形成夹角即可描述对应关节点的运动姿态。因此本文建立如图7所示采用空间向量的右肘关节映射关系,直接根据3个骨骼点在世界坐标系中的坐标组成2个向量,用其构成的夹角描述该运动位姿。 图7 肘关节映射Fig.7 Mapping of Elbow 右肘关节分别与右肩关节点和腕关节点组成向量β3、β4,即 (19) (20) 其中,腕关节点的坐标为(xw,yw,zw)。根据空间向量夹角计算公式 (21) 即可算出肩、肘、腕三关节之间形成的夹角,并将其映射为机器人右肘部关节运动角度。至此,整个机器人的右臂便与Kinect捕捉的人体骨骼点之间建立了相应的映射关系;由于机器人3只手臂结构只有各自的末端执行器不同,其余构造均相同,因此机器人后臂、左臂与上述映射关系一致,此处便不再赘述人体动作和其运动关系之间的映射情况。后臂是在切换到喷施模式时才能由人体右臂驱动,采摘模式时,只有左右两臂才能运动,而且换到喷施模式时,左右两臂又被锁死。 3.2.4 三臂机器人末端执行器的映射控制 三臂机器人具有针对不同作业类型的末端执行器,能够完成多种棚室作业。其中,机器人右臂末端是1个软轴式仿手形抓持器(图8a),能够有效地对类椭球形果蔬进行抓取;此外,还可将其更换为面向长条形果蔬的末端抓持器(图8b)。右臂手上还装有1个由伺服电动机驱动的剪切器,与抓持器集成在右臂上(图1中部件2、4),协同工作,减少操作人员的操作负担,提高采摘效率。 图8 右臂可更换式末端执行器Fig.8 Replaceable end effector in right arm 由于本文使用的是Kinect第一代设备,其深度图像得到的骨骼点信息对于手势识别误差较大。为提高本系统的可操作性与稳定性,本文采用基于骨骼点信息和YCbCr颜色空间结合的手势分割法提取操作人员的手势特征,再用其控制3个末端执行器。该手势特征提取方法为:得到手部骨骼点后,分割出一个以该点为中心的图像。而且经测得,在总图像尺寸为640像素×480像素时,尺寸为50像素×50像素的分割图像基本能囊括整个手部。得到分割图像后,接下来便是提取手部特征,本文采用基于YCbCr空间的手部提取方法,即先把分割出的基于RGB空间的手部图像转化到YCbCr颜色空间,其中Y为颜色的亮度成分,Cb和Cr则为蓝色和红色的浓度偏移量成分,而且经统计表明不同人种肤色主要受亮度信息影响,而受肤色信息的影响很小,所以直接考虑YCbCr空间的Cb、Cr分量,映射为CbCr空间,在该空间下,受亮度变化的影响小,而且发现肤色在CbCr空间的分布呈现良好的聚类特性,统计分布满足[26] 77≤Cb≤127 (22) 133≤Cr≤173 (23) 基于此分布得到聚类分割出的手部二值图像后,将二值图像面积与分割出的图像面积相比,当比值大于0.8便识别为手掌张开状态,反之则为握拳状态,如图9所示。 图9 结合Kinect骨骼点信息与YCbCr颜色模型的手势 特征分割方法流程图Fig.9 Flow chart of combinating skeleton point information and YCbCr color gesture feature segmentation method 本文规定,在采摘模式时,人的右掌张开对应抓持器张开状态,握拳则对应抓持器闭合抓取。左手手掌握拳时剪切器执行摘剪果蔬动作,把果蔬从作物上剪断,左手张开时剪切器复位后停止运动。当处于喷施模式时,右手掌张握动作对应喷施的开关,左手手势动作则对应喷施液种类之间的切换。 建立操作人员位姿信息与机器人工作空间的映射对应关系之后,对该决策算法的精准度和棚室作业效果进行了试验。 4.1 试验平台的搭建 本试验用Matlab开发上位机程序,在东北农业大学农业机器人研究室内搭建三臂棚室农业机器人样机和棚室作业环境。试验场地分为两处,即远程操控场地和棚室作业场地,棚室作业场地情况由机器人头上的无线摄像头进行实时拍摄并回传到远程操控场地的显示终端上。操作人员只需通过显示终端界面便能观察机器人的实时动作,从而远程操控机器人作业,以验证体感决策算法的可行性和精准性,试验平台如图10所示。 图10 远程操控场地Fig.10 Remote control1.上位机 2.Kinect 3.显示终端 4.操作人员 图11 误差数据采集流程Fig.11 Processing of error data acquisition 4.2 精准性试验 完成试验平台的搭建后,对该体感决策算法映射误差进行试验,分析可知该系统的误差主要有2个来源:一个是Kinect捕获操作人员动作时产生的误差,另一个为骨骼点数据映射到机器人工作空间时产生的误差。根据建立映射关系时对关节点夹角的定义,需要对肩关节部位分别与本文定义的2个平面之间夹角及肘关节夹角的3个值进行测量,以确定误差大小,这3个值分别为操作人员实际位姿值、体感算法捕捉值、机器人实际动作夹角。首先让之前的10位测试人员穿戴上采用光洋单圈绝对值编码器的关节夹角测试仪(图11a),其测试精度为0.05°,用其测得人体肩、肘关节的实际运动夹角,并与体感捕获关节夹角做比较,以检验体感技术捕获角度值的精准性;参照关节夹角测试仪的示数,测试人员用肩关节分别做出与图6所示β1、β2面夹角依次为10°、20°、30°、…、90°的位姿,且本文编写了用于显示人体被捕捉到的骨骼点关节角度的界面显示程序(图11b),记下人手臂关节做出某个角度时对应体感算法捕捉并显示在界面的角度。记录该角度的同时,用遥控装置关闭机器人控制系统与上位机通信的串口,确保机器人此刻的位姿是与显示界面上记录的关节点数据同时刻映射,用万能角度尺对机器人手臂对应位置夹角进行测量(图11c),得到机器人对应转角角度。得到以上3组数据后便能求出上述分析的误差。10个测试者都测试后,对体感算法捕捉到的10个测试者的肩关节角度及量得的机器人实际动作角度分别求平均值,同理,与肩关节角度误差测试步骤类似,再对肘关节的夹角进行相同步骤的试验,但由于结构上的区别,人体肘部夹角变化范围取为90°~180°,并绘出所有差值折线图。 图12 人体关节夹角与机器人关节夹角映射误差统计折线图Fig.12 Curves of mapping error between human and robot joint angle 图12a中肩部关节与β2夹角折线图表明,当人体关节点夹角越大时,体感算法捕捉到的误差绝对值越大,到90°时出现了误差的最大值5.80°,这是因为当人肩部关节与β2之间的夹角为较大值时,手臂指向Kinect摄像头方向,造成肩部及肘部关节被遮挡而导致深度信息被干扰,从而引起骨骼点识别偏差,导致相对较大的误差;而图12c中,人肘部关节夹角越小时,误差绝对值越大,最大误差绝对值为1.90°,同理肘部夹角较小时,若手腕指向Kinect方向,也会出现肘关节视觉遮挡,从而导致误差的出现;同时捕获夹角映射到机器人实际工作空间的电动机转角误差最大差值为0.80°,主要是由手臂装配间隙及为提高单片机运行效率采取角度取整导致的,对基于体感操作的控制方式,该误差满足体感操作要求;但对于人体肩关节大角度时产生的人体实际关节夹角和体感捕获夹角最大误差5.80°,则可能出现误差跳变影响远程棚室作业效果;考虑到在体感操作过程中,三臂机器人大臂主要确定工作区域、小臂负责后续定位采摘的特性,将大臂转动角度规划为以15°为步长、0°~90°的离散转动区间,当体感算法捕捉到操作人员手臂关节角度为0°~7.50°时,机器人对应电动机转角为0°,当人体关节角度为7.50°~22.50°时,机器人对应电动机转角为15°,以此类推当体感算法捕捉到人体关节角度为82.50°~90°时,机器人电动机转角为90°。再次进行误差测试,体感算法映射的最大绝对误差出现在肘关节处,其值为1.90°,肩关节由于采用上述规划后理论上已不存在识别误差,故误差较未规划之前得到了较好的消除。 4.3 试验平台的搭建 在上述规划基础上,让10位测试者模拟在无人棚室或植物工厂下作业,用于测试决策算法性能。每人在远程操控试验场地通过观察显示终端实时传回视频,了解目标对象和机器人的动作情况,进而通过体感技术远程操控三臂机器人,进行采摘单个黄瓜作业和喷施作业,其喷施作业面积为1 m2。由于本文采用的是基于体感技术的机器人,在进行体感操控作业时,操作人员观察显示界面实时回传视频完成机器人的目标定位和采摘运动规划,若操作人员定位果蔬出现位置误差时,通过显示界面的实时视频反馈的情况,在采摘运动过程中人员可主动纠正,以适应复杂多变的作业环境,记录完成单次作业指令的时长,作为衡量体感决策算法作业性能的标准,并再做1组10个测试者用人工完成相同采摘喷施作业的试验,记录下所用时间;将所有试验数据列于表2中。 表2 测试者远程棚室作业耗时统计Tab.2 Statistics of working hours in greenhouse s 由表2可得,测试者操控机器人完成每套棚室作业指令的平均耗时为13.34 s,其中采摘耗时6.36 s,喷施耗时6.98 s;人工作业耗时为11.57 s,其中采摘耗时为4.87 s,喷施耗时为6.70 s。表明该体感决策算法具有较好的效率,而且操作者可通过体感操控训练进一步提高机器人作业性能;而对于6号测试者出现采摘耗时8.64 s及喷施耗时8.27 s,明显高于试验平均值的情况,通过骨骼点捕捉软件记录下的数据分析可知,其主要时间耗费在手势识别上,进一步观察可知该测试者在进行试验时右手掌为指向Kinect的摄像头姿态,导致Kinect无法正确捕获其手势。因此在操作时应注意让手掌面向摄像头,以增加手势识别的效率和准确率。 相对于人工作业,操作人员可在一个舒适环境中完成远程体感操控,对智能棚室及植物工厂实施“无人化管理”,降低对作物及健康的损害;此外经精准性测试后采用大臂离散区间转动方法,允许人体肩部关节有一定的姿态改变而不影响机器人动作位姿,缓解了长时间体感操控可能出现的关节酸痛的情况,而且整个作业过程只需运动肢体和改变相对于摄像头的位置,省去了在棚室行走和采摘时的体力损耗。 图13 远程操控采摘作业Fig.13 Picking works with remote operation (1)将基于Kinect体感技术的决策算法应用在操控多臂棚室农业机器人上,操作人员能够通过无线设备远程操作机器人进行多种棚室作业,并在实验室搭建的棚室环境下取得了较好的作业效果。 (2)通过Kinect采集包含操作人员动作信息的深度图像,提取每个像素点与邻域的全局均一化深度差值作为该点特征量,利用随机树和森林对其进行分类,最后采用引入高斯核的Mean shift算法迭代得到了20个能代表人体位姿的关键点;在此基础上,建立了一种基于骨骼点追踪技术的人体两臂与机器人三臂的映射关系,还结合骨骼点信息与YCbCr颜色空间模型,准确的定位了手掌位置,分割出包络手部的图像部分,经形态学处理后得到效果较好的手势特征。在实验室搭建的棚室环境内,实现了测试人员远程操控三臂机器人进行多种棚室作业。 (3)搭建了用于试验Kinect三臂决策算法的三臂机器人样机,对决策算法映射动作的精准性和作业性能进行了试验。试验结果表明,体感捕捉人体关节角度最大误差为5.80°,出现在肩关节处,本文通过对机器人肩关节转动转角的离散化规划后,肩关节夹角识别误差相当于消除,识别误差主要产生在肘部,最大误差绝对值为1.90°;而捕捉到的关节夹角值到机器人实际转动夹角值的最大绝对误差为0.80°,在此精度下,人员远程操控机器人能自如的进行工作模式切换,完成一套棚室作业指令平均耗时13.34 s,能满足无人棚室或植物工厂复杂环境作业需要。 (4)针对上述传统智能棚室或植物工厂人工作业模式存在较多弊端,而智能农业机器人系统的普适性尚需完善的现状,该决策算法的提出可为农业机器人的操控方式提供一种新思路,能加快智能棚室及植物工厂“无人化管理”及棚室机器人实用化、高效化的步伐。 1 王凯, 么鸿雁, 刘剑君. 蔬菜大棚微环境对人体健康的影响[J]. 疾病监测, 2015, 30(6):507-512. WANG Kai, YAO Hongyan, LIU Jianjun. Progress in research of impact of greenhouse microenvironment on human health[J]. Disease Surveillance,2015,30(6):507-512. (in Chinese) 2 CECCHINI M, COLANTONI A, MASSANTINI R, et al. Estimation of the risks of thermal stress due to the microclimate for manual fruit and vegetable harvesters in central Italy[J]. Journal of Agricultural Safety & Health, 2010, 16(3):141-159. 3 朱凤武, 于丰华, 邹丽娜,等. 农业机器人研究现状及发展趋势[J]. 农业工程, 2013, 3(6):10-13. ZHU Fengwu, YU Fenghua, ZOU Li’na,et al.Research status quo and future perspective of agricultural robots[J].Agricultural Engineering,2013,3(6):10-13. (in Chinese) 4 DONG F, HEINEMANN W, KASPER R. Development of a row guidance system for an autonomous robot for white asparagus harvesting[J]. Computers & Electronics in Agriculture, 2011, 79(2):216-225. 5 OBERTI R, MARCHI M, TIRELLI P, et al. Selective spraying of grapevines for disease control using a modular agricultural robot[J]. Biosystems Engineering, 2016,146:203-215. 6 罗陆锋, 邹湘军, 杨洲,等. 基于改进人工蜂群模糊聚类的葡萄图像快速分割方法[J/OL]. 农业机械学报, 2015, 46(3):23-28. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?file_no=20150304&flag=1. DOI:10.6041 /j.issn.1000-1298.2015.03.004. LUO Lufeng,ZOU Xiangjun YANG Zhou,et al.Grape image fast segmentation based on improved artifical bee colony and fuzzy clustering[J]. Transactions of the Chinese Society for Agricultural Machinery,2015,46(3):23-28. (in Chinese) 7 尹建军, 武传宇, YANG S X,等. 番茄采摘机器人机械臂避障路径规划[J/OL]. 农业机械学报, 2012, 43(12):171-173,157. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?file_no=20121231&flag=1. DOI:10.6041/j.issn.1000-1298.2012.12.031. YIN Jianjun, WU Chuanyu, YANG S X, et al. Obstacle-avoidance path planning of robot arm for tomato-picking robot[J/OL].Transactions of the Chinese Society for Agricultural Machinery,2012,43(12):171-175,157. (in Chinese) 8 赵金英, 张铁中, 杨丽. 西红柿采摘机器人视觉系统的目标提取[J]. 农业机械学报, 2006, 37(10):200-203. 9 刘继展, 李萍萍, 倪齐,等. 番茄采摘机器人真空吸盘装置设计与试验[J]. 农业机械学报, 2010, 41(10):170-173. LIU Jizhan, LI Pingping, NI Qi,et al.Design and test of the vacuum suction device for tomato harvesting robot[J]. Transactions of the Chinese Society for Agricultural Machinery,2010,41(10):170-173. (in Chinese) 10 张凯良, 杨丽, 张铁中. 草莓收获机器人采摘执行机构设计与试验[J]. 农业机械学报, 2011, 42(9):155-161. ZHANG Kailiang, YANG Li, ZHANG Tiezhong. Design and experiment of picking mechanism for strawberry harvesting robot[J].Transactions of the Chinese Society for Agricultural Machinery,2011,42(9):155-161. (in Chinese) 11 冯青春, 袁挺, 纪超,等. 黄瓜采摘机器人远近景组合闭环定位方法[J]. 农业机械学报, 2011, 42(2):154-157. FENG Qingchun, YUAN Ting, JI Chao, et al.Feedback lacating control based on close scene for cucumber harvesting robot[J]. Transactions of the Chinese Society for Agricultural Machinery,2011,42(2):154-157. (in Chinese) 12 HENTEN E J V, SCHENK E J, WILLIGENBURG L G V, et al. Collision-free inverse kinematics of the redundant seven-link manipulator used in a cucumber picking robot[J]. Biosystems Engineering, 2010, 106(2):112-124. 13 傅隆生, 张发年, 槐岛芳德,等. 猕猴桃采摘机器人末端执行器设计与试验[J/OL]. 农业机械学报, 2015, 46(3):1-8. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?file_no=20150301&flag=1.DOI:10.6041/j.issn.1000-1298.2015.03.001. FU Longsheng, ZHANG Fanian, GEJIMA Yoshinori, et al. Development and experiment of end-effector for kiwifruit harvesting robot[J/OL]. Transactions of the Chinese Society for Agricultural Machinery,2015,46(3):1-8. (in Chinese) 14 AFTHONI R,RIZAL A,SUSANTO E. Proportional derivative control based robot arm system using Microsoft Kinect[C]∥2013 IEEE International Conference on Robotics, Biomimetics, and Intelligent Computational Systems (ROBIONETICS), 2013: 24-29. 15 AMATYA S, PETCHARTEE S. Real time kinect based robotic arm manipulation with five degree of freedom[C]∥2015 Asian Conference on Defence Technology (ACDT), 2015:982-990. 16 JIMENEZ MORENO R. Tracking of human operator arms oriented to the control of two robotic arms[C]∥2014 XIX Symposium on Image, Signal Processing and Artificial Vision, 2014: 1-4. 17 DU G, ZHANG P. Markerless human-robot interface for dual robot manipulators using Kinect sensor[J]. Robotics and Computer-Integrated Manufacturing, 2014, 30(2):150-159. 18 LIN H B, MEI W L, ZHANG Y. Implement of robot arm body feeling interaction system based on the Kinect skeletal information[J]. Applied Mechanics & Materials, 2012, 220:1203-1206. 19 LALLEE S, LEMAIGNAN S, LENZ A, et al. Towards a platform-independent cooperative human-robot interaction system: I. perception[C]∥IEEE/RSJ 2010 International Conference on Intelligent Robots and Systems, 2010:4444-4451. 20 LALLEE S, PATTACINI U, BOUCHER J D, et al. Towards a platform-independent cooperative human-robot interaction system: II. perception, execution and imitation of goal directed actions[C]∥IEEE/RSJ International Conference on Intelligent Robots & Systems, 2011:2895-2902. 21 LALLEE S, PATTACINI U, LEMAIGNAN S, et al. Towards a platform-independent cooperative human robot interaction system: III an architecture for learning and executing actions and shared plans[J]. IEEE Transactions on Autonomous Mental Development, 2012, 4(3):239-253. 22 GARCIA J, VALENCIA E S, ZALEVSKY Z, et al. Range mapping using speckle decorrelation: US,7433024B2[P]. 2008-10-07. 23 LEPETIT V, LAGGER P, FUA P. Randomized trees for real-time keypoint recognition [C]∥2005 IEEE Computer Soeiety Conference on Computer Vision & Pattern Recognition, 2005, 2:775-781. 24 COMANICIU D, MEER P. Mean shift: a robust approach toward feature space analysis [J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 24(5):603-619. 25 SHOTTON J, FITZGIBBON A, COOK M, et al. Real-time human pose recognition in parts from single depth images[C]∥2011 IEEE Conference on Computer Vision and Pattern Recognition, 2011:1297-1304. 26 AIBINU A M, SHAFIE A A, SALAMI M J E. Performance analysis of ANN based YCbCr skin detection algorithm[J]. Procedia Engineering, 2012, 41:1183-1189. Algorithm of Works’ Decision for Three Arms Robot in Greenhouse Based on Control with Motion Sensing Technology QUAN Longzhe LI Chenglin FENG Zhengyang LIU Jiawei (CollegeofEngineering,NortheastAgriculturalUniversity,Harbin150030,China) There are many problems in the current greenhouse and plant factory. It’s an effective solution to work by robots. However, because of the limit of the intelligent algorithm at present, the robot’s works are imprecise.And they can just complete single job in once cruise which cause the inefficient using. Aiming at the problem, an algorithm which based on the motion sensing of Kinect and used in three arms robot was proposed, by using the Kinect to collect the depth image, including the operating personnel and combining the Random forests of statistical learning theory with the mean shift algorithm based on the Gauss kernel function which acquired 20 skeletal joints that can standard the human motion. On this basis, a mapping relation was put forward in innovation of three arms based on the mode switching to achieve that the two arms of the man can freely control three arms of the robot and perform several works in greenhouse. In addition, a way of gesture features segmentation was proposed which based on skeletal tracking technology in Kinect and YCbCr color space, realizing the aim that using the action of the palm to control the robot’s end effectors. Finally, a prototype of three arms robot was built to test the decision algorithm of motion sensing and its accuracy. A discrete value was taken for the angle in shoulder joint to recognize the error data in experiment, so eliminated errors in the shoulder joints. The results showed that the maximum mapping error of joint angle was 1.90° between human and robot. The maximum error of the host computer sending angle and the real angle by robot was 0.80°, which was within the margin of error. Meanwhile, the average time of completing an order of picking and spraying was 13.34 s, the picking time was 6.36 s and the spraying time was 6.98 s. And the performance of the robot can be boosted by training the manipulator. It was indicated that this algorithm had a great practicability and can work accurately. multi-arms robot in greenhouse; decision programming; motion sensing technology; Kinect sensor 10.6041/j.issn.1000-1298.2017.03.002 2016-07-15 2016-08-15 黑龙江省普通高等学校青年创新人才培养计划项目(LR-356214)、国家自然科学基金项目(51405078)、黑龙江省博士后基金项目(LBH-Z13022)和东北农业大学“青年才俊”项目(518020) 权龙哲(1980—),男,副教授,主要从事农业智能装备研究,E-mail: quanlongzhe@163.com S24 A 1000-1298(2017)03-0014-10

4 三臂棚室机器人作业试验

5 结论