一种改进的HEVC帧内预测算法*

2017-02-09顾梅花马蒙蒙

谌 博 顾梅花 马蒙蒙

(西安工程大学电子信息学院 西安 710048)

一种改进的HEVC帧内预测算法*

谌 博 顾梅花 马蒙蒙

(西安工程大学电子信息学院 西安 710048)

针对高效视频编码(HEVC)帧内预测中编码单元(CU)划分复杂度过高的问题,提出了一种改进的HEVC帧内预测算法。该算法根据视频帧的时间相关性和时空相邻CU的相关性,通过比较当前CU与已编码帧图像对应位置CU和邻近CU的深度,可以跳过不必要的整块预测和子块预测,加速帧内预测过程。实验结果表明,与HM10.0相比,该算法峰值信噪比(PSNR)平均下降了0.04dB,比特率(BitRate)平均增加1%,平均编码时间能够缩减30%,能够在保证编码图像质量的情况下有效的降低编码复杂度。

HEVC; 帧内预测; 编码; 邻近CU

Class Number TN919.81

1 引言

高效视频编码(HEVC)是由ITU-T视频编码专家组(VCEG)和运动图像专家组(MPEG)组建的视频编码联合组(JCT-VT)共同开发产生的新一代视频编码标准[1]。针对高清以及超高清的视频图像,HEVC编码标准的主要目标是在H.264/AVC标准[2]的基础上,将高分辨率/高保真度的视频图像压缩效率提高一倍。即在保证相同视频图像质量的前提下,使视频流的码率减少50%[3],进而更好地适应各种不同的网络环境,同时能够支持多核并行编解码。然而,HEVC在获取高性能的同时也带来了极高的计算复杂度这一问题,这对于视频编码技术的长期发展来说显然是不利的。因此,如何在保持HEVC编码效率的前提下,显著地降低算法复杂度,减少编码时间就变得尤其重要。帧内预测是HEVC的重要部分之一,它是HEVC编码框架中复杂度较高的模块,难以满足实际应用的需求。因此,针对帧内预测的优化算法尤为必要。

目前的帧内预测快速算法的研究主要集中在两个方面: 1) 在帧内预测前,利用块类型预判或者提前终止的思想,对当前编码图像所适合的编码单元类型进行预判断,跳过一些不适合此图像纹理的编码块类型的编码过程,从而降低算法复杂度,节省编码时间。 2) 针对当前编码单元的众多预测模式,通过低复杂度的方法提前排除一些可能性小的预测模式,从而缩小在RDO模式选择过程中的候选帧内预测模式数目,降低算法复杂度。文献[4]利用Hadamard代价函数模型来预先选出N种预测模式。文献[5]提出了相邻块最优预测模式MPM,并将其加入到RDO候选模式列表,利用空间上相邻的CU的方向信息来进一步加快帧内模式决策过程。文献[6~9]通过图像的纹理复杂度分析最终减少进行RMD和RDO过程的模式数量,降低计算复杂度。文献[10]根据对图像内容的相关性进行分析,在CU层进行深度划分时,参考周围CU的深度范围,减少不必要的深度划分。文献[11]根据视频帧的相关性,通过前一帧相同位置CU的划分深度和当前CU运动矢量差值和预测残差系数来确定当前CU的深度范围,以此跳过不必要的整块预测和子块预测。文献[12]根据时空相邻CU的相关性,利用已编码单元CU的深度范围和深度值来预测当前CU的深度范围和深度值,减少不必要的块划分计算。以上算法虽然考虑了CU的相关性和视频帧的相关性,但没有将两者结合起来对算法进行优化。本文结合以上研究成果,提出了一种同时利用视频帧的相关性和时空相邻CU相关性的帧内预测快速算法。

2 HEVC帧内预测

2.1 HEVC编码结构

新一代视频编码标准HEVC采用基于块的混合编码方案[13],不同于以往的混合编码方案,HEVC的块划分结构更加的灵活,主要由CU(编码单元),PU(预测单元)和TU(变换单元)组成。其中最大的编码单元(LCU)为64×64,最小的编码单元(SCU)为8×8。预测单元是进行帧内/帧间预测的基本单元,变换单元是进行变换和量化的基本单元[14~15]。这三个单元的划分,不仅使得变换、预测和编码各个处理环节更加灵活,也使得各环节的划分更加符合视频编码的纹理特征,最终能够实现编码性能的最优化。

2.2 HEVC帧内预测过程和编码复杂度

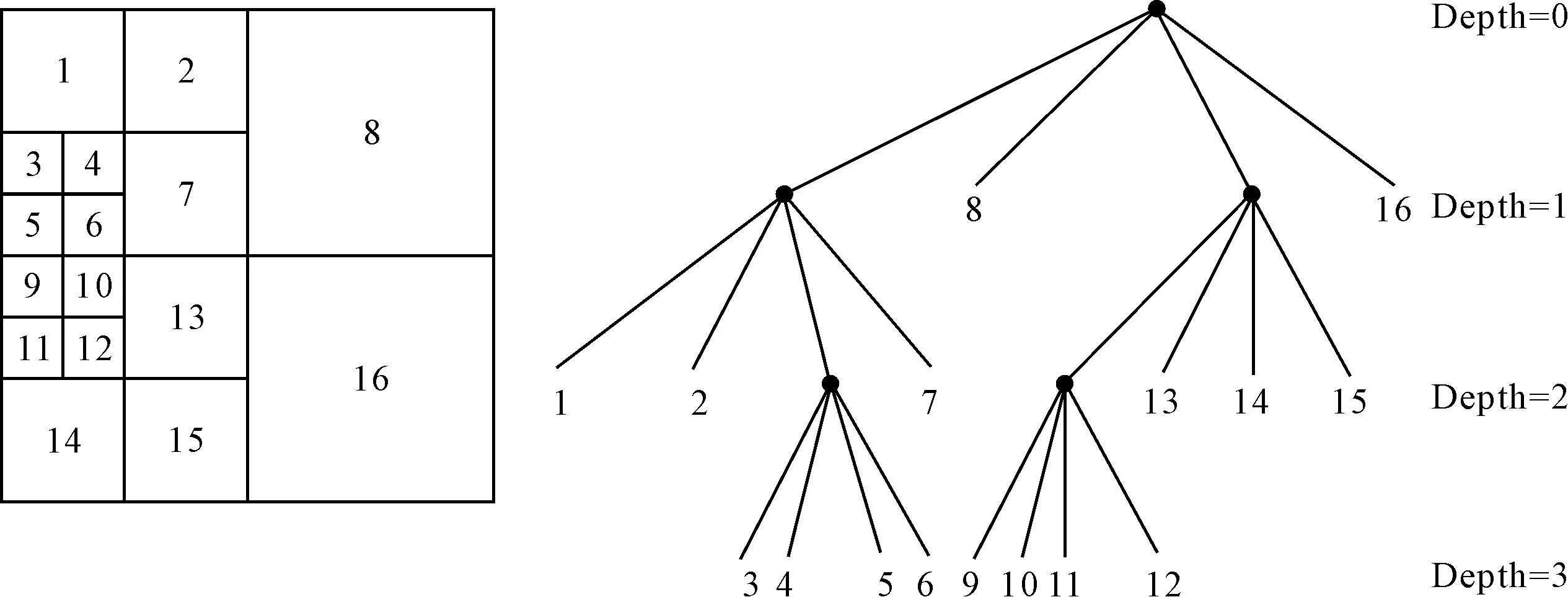

HEVC的编码单元CU采用四叉树递归划分,以CU的尺寸和深度Depth来表征CU的两大特征。如图1所示,当LCU不划分时,定义深度Depth=0;当LCU划分为四个子块,为四个32×32时,定义深度Depth=1,以此类推,直到划分到CU的最小尺寸为8×8时不再划分,此时深度为Depth=3[8]。

图1 HEVC帧内预测块划分

HEVC采用了与H.264类似的率失真优化技术(RDO)[16~17],为每一种模式计算率失真代价,有效的提高了编码性能。率失真代价函数模型如式(1)所示:

J=D+λ*R

(1)

其中,D表示当前预测模式下的失真,R表示编码当前预测模式所需的比特数,λ为拉格朗日因子。首先获取最大编码单元LCU(64×64),深度Depth=0,进行帧内预测,计算这时的率失真代价定义为RDcost_0;然后将LCU进行划分获得四个子CU(32×32)。接着对每一个子CU进行帧内预测并计算出它们的率失真代价和定义为RDcost_1。对比RDcost_0和RDcost_1,若RDcost_0小于RDcost_1,说明当前尺寸CU不需要进行划分。否则,对当前CU进行划分,Depth+1。按照这种方法依次类推直到Depth=3,找到最小的率失真代价值对应的最优CU划分方式。这一过程的计算量非常庞大耗时,如此高复杂度的计算过程给实际应用增加了困难。

3 帧内预测快速算法

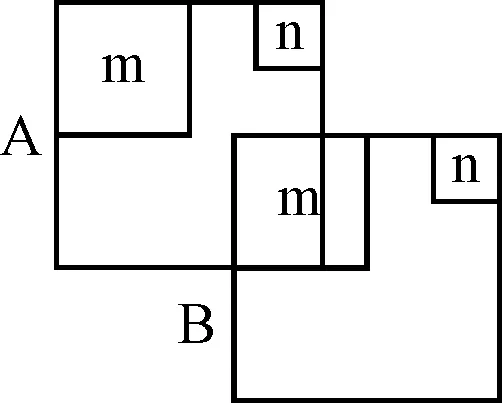

视频序列具有连续性和空间相关性,因此相邻帧相同位置处的CU尺寸近似。如图2,A和B是相邻的两帧图像,m处纹理较为平坦,最佳尺寸块为64×64或32×32,那么B中m处的纹理与A中近似,尺寸块大小有较大可能为64×64或32×32;同理,A中n处的纹理复杂,尺寸块较小,那么B中n处的尺寸块也应多为8×8或16×16。

图2 相邻两帧图像及 相同位置CU

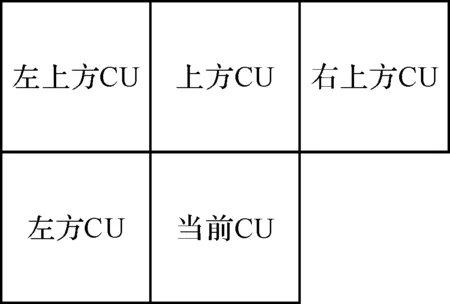

图3 当前CU与 邻近已编码CU

图3为图2中图像B中n处的编码块。图像存在内容的相关性,空间相邻CU的划分深度也存在相关性。当前CU与邻近已编码CU(左方CU,上方CU,左上方CU,右上方CU)如图3所示。邻近已编码CU的深度可以为当前编码单元的划分提供参考。若邻近已编码单元的深度都大于当前CU的深度,并且A中n处与待编码CU相同位置的CU的深度也大于当前CU的深度,则可跳过当前CU的帧内模式搜索,直接对当前CU进行分块,并且深度值+1。

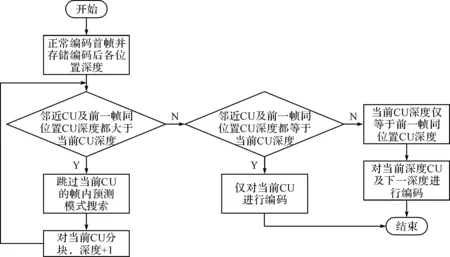

图4 算法流程图

正常编码首帧图像并对各位置的CU深度进行存储,对于当前编码单元,初始深度Depth=0,比较邻近CU及前一帧对应位置CU的深度与当前CU深度:若大于,跳过当前CU的帧内预测模式搜索,同时Depth+1;若等于,仅对当前CU进行编码并结束当前CU的划分;否则对当前深度CU及下一深度进行编码并结束CU的划分。其他情况,按照原算法进行计算。

对于纹理相对平坦的图像,提前终止对小尺寸块的划分,能够减少计算量,提高编码效率;而对于纹理相对复杂,细节丰富的图像,能够跳过大尺寸CU的帧内预测模式搜索,同样能够起到降低编码复杂度的效果。本文算法对这两种情况都能起到良好的效果,有效降低编码复杂度。

4 实验结果及分析

为验证本文提出的优化算法的性能,将本文优化方案在HEVC参考软件HM10.0上实现,实验平台的硬件配置为:AMD A8-7100 Radeon R5CPU,主频为1.8GHz,内存为8.00GB,操作系统为Windows8 64位,开发工具为VS2010。测试序列为高分辨率1280×720标准YUV测试序列,主要实验参数为:MaxPatitionDepth=4,IntraPeriod=1(即All Intra编码),CABAC熵编码,编码帧数为20帧,QP(量化参数)分别为24,30。通过下面的公式来评价本文算法的性能:

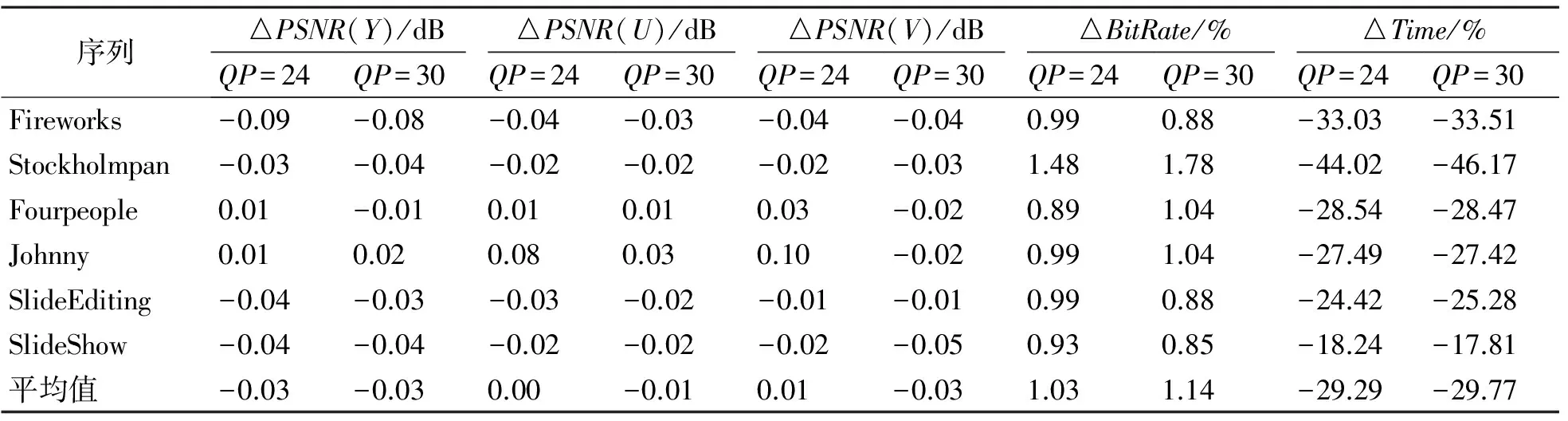

ΔPSNR(dB)=PSNR(proposed)-PSNR(HM)其中ΔBitRate(比特率增加幅度百分比)、ΔPSNR(峰值信噪比差值)、ΔTime(时间增加幅度百分比)。数据为正表示与HM10.0相比增加,反之表示减少。 表1 实验结果对比

本文挑选的六个测试序列分为三类,其中Fireworks和Stockholmpan的纹理比较平坦,Fourpeople和Johnny的纹理相对正常,而SlideEditing和SlideShow细节比较丰富,纹理比较复杂。由表1的实验数据可以看出,本文算法对纹理相对平坦的Fireworks和Stockholmpan,编码时间缩减的最多,达到了33%和46%;而对于纹理适中的Fourpeople和Johnny,编码时间缩减的也适中,为28%和27%;而SlideEditing和SlideShow细节比较丰富,缩减的编码时间也相对最少,分别为24%和18%。总体来说编码时间缩减比较明显,平均达到了30%。而编码图像的质量方面,PSNR平均下降0.04dB,BiteRate平均增加1%。

5 结语

为了降低HEVC编码复杂度,减少编码时间。根据图像的空间相关性和时间相关性,提出了一种帧内预测快速算法。实验结果表明:对比于原算法HM10.0,本文算法在对图像质量影响很小的情况下,对于纹理平坦图像的编码,编码时间缩减较多,而对于纹理复杂的图像,编码时间缩减适中,具有一定的实用价值。

[1] Sullivan G J, Ohm J R. Recent developments in standardization of high efficiency video coding(HEVC)[J]. Proc Spie,2010,7798(1):731-739.

[2] Wiegand T, Sullivan G J, Bjon tegaard G, et al. Overview of the H.264/AVC video coding Standard[J]. Circuits and Systems for Video Technology, IEEE Transactions on,2003,13(7):560-576.

[3] 蔡晓霞,崔岩松.下一代视频编码标准关键技术[J].电视技术,2012(36):80-84. CAI Xiaoxia, CUI Yansong. The key technology of the next generation video encoding Standard[J]. TV Technology,2012(36):80-84.

[4] Encoder Improvement of Unified Intra Prediction[C]//document JCTVC-C207, JCT-VC of ITU-T SG16 WP3 and ISO/IEC JTC1/SC29/WG11, Guangzhou, China,2010.

[5] L. Zhao, L. Zhang, S. Ma, et al. Fast mode decision algorithm for intra prediction on in HEVC[C]//Proc. IEEE Vis. Commun. Image Process. (VCIP),2011:1-4.

[6] Jiang W, Ma H, Chen Y. Gradient based fast mode decision algorithm for intra prediction in HEVC[C]//Consumer Electronics, Communications and Networks (CECNet), 2012 2ndInternational Conference on. IEEE,2012:1836-1840.

[7] Chen G, Liu Z, Ikenaga T, et al. Fast HEVC intra mode decision using matching edge detector and kernel density estimation alike histogram generation[C]//Proceedings of IEEE International Symposium on Circuits and Systems(ISCAS),2013:53-56.

[8] Silva T L D, Agostini L V, Cruz L A D S. Fast HEVC intra prediction mode decision based on EDGE direction information[J]. Nihon Naika Gakkai Zasshi the Journal of the Japanese Society of Internal Medicine,2012,86(12):2239-40.

[9] Fang C M, Chang Y T, Chung W H. Fast intra mode decision for HEVC based on direction energy distribution[C]//Proceedings of IEEE 17th International Symposium on Consumer Electronics (ISCE),2013:61-62.

[10] L. Shen, Z.zhang, P. an. Fast CU size decision and mode decision algorithm for HEVC intra coding[J]. IEEE Trans. Consumers Electronics,2013,59(1):207-213.

[11] 李维,张和仙,杨付正.高效率视频编码快速模式判决算法[J].西安交通大学学报,2013,8:104-109,140. LI Wei, ZHANG Hexian, YANG Fuzheng. A Fast mode decision algorithm for high efficiency video coding[J]. Journal of Xi’an Jiaotong University,2013,8:104-109,140.

[12] 晏轲,滕国伟,胡锦雯,等.一种基于时空相关性的编码单元深度快速分级判决算法[J].光电子·激光,2014,1:156-162. YAN Ke, TENG Guowei, HU Jinwen. A rapid classification algorithm on CU depth based on temporal-spatial correlation[J]. Photo-electron and Laser,2014,1:156-162.

[13] 甘勇,赵晓荣,李天豹,等.基于图像特征的HEVC快速帧内预测算法[J].郑州轻工业学院学报(自然科学版),2014,1:90-93. GAN Yong, ZHAO XiaoRong, LI TianBao, et al. Fast intra prediction algorithm based on picture feature for HEVC (Natural Science)[J]. 2014,1:90-93.

[14] Jani L, Frank B, Woo-Jin H, et al. Intra coding of the HEVC standard[J]. IEEE Transaction on on Circuits and Systems for Video Technology,2015,12(22):1792-1802.

[15] Architectural Outline of Proposed High Efficiency Video Coding Design Elements[C]//document JCTVC-A202, ITU-T SG16 WP3 and ISO/IEC JTC1/SC29/WG11, 1st Meeting, DrEsden, Germany,2010.

[16] G. J. Sullivan, T. Wiegand. Rate-distortion optimization for video compression[J]. IEEE Signal Processing Magazine,1998,15(6):74-90.

[17] A. Ortega and K. Rate-distortion methods for image and video compression[J]. IEEE Signal Processing Magazine,1998,15(6):23-50.

An Optimized Algorithm for HEVC Intra Prediction

CHEN Bo GU Meihua MA Mengmeng

(School of Electronic and Information, Xi’an Polytechnic University, Xi’an 710048)

In order to solve the problem of the high complexity of CU division in HEVC intra prediction, an optimized intra prediction algorithm of HEVC is proposed. Based on the time relativity of the video sequence, the algorithm can compares the depth of CU of the current coding unit with the adjacent CUs as well as the same position CU of the previous frame, skips unnecessary block prediction and sub block prediction. This process can accelerate encoding time. The experimental results show that the algorithm provides averagely 30% reduction of intra coding time compared with the one accepted by HM10.0 with drops of 0.04dB PSNR and increase of 1% BiteRate, which can ensure the encoding quality and reduce the encoding time.

HEVC, intra prediction, encode, neighbouring CU

2016年7月1日,

2016年8月10日

国家自然科学基金资助项目(编号:61401347);陕西省教育厅科学研究项目(编号:16JK1329)资助。

谌博,男,硕士研究生,研究方向:高效视频编码算法。顾梅花,女,博士,副教授,研究方向:视频图像编码算法。马蒙蒙,女,硕士研究生,研究方向:图像边缘检测。

TN919.81

10.3969/j.issn.1672-9722.2017.01.028