精准空间透视融合手术导航

2017-01-05范真诚张欣然廖洪恩

范真诚,张欣然,廖洪恩

清华大学 医学院 生物医学工程系,北京 100084

精准空间透视融合手术导航

范真诚,张欣然,廖洪恩

清华大学 医学院 生物医学工程系,北京 100084

面对大众对创伤性小、恢复期短、更安全高效的微创手术需求,手术导航的临床重要性日渐显著。如何使用医学影像信息指导术前手术规划,在术中引导实时诊断、精确操作与高效治疗,提高手术效率、精度与安全成为研究关注热点。本文针对临床需求提出一种基于高性能立体全像技术的新型精准空间透视融合手术导航系统,并且介绍了该导航系统涉及到的关键技术。基于该系统能够实现对微创手术器械追踪与手术感兴趣区域中关键解剖组织的三维立体增强显示,为医生提供精确直观的透视融合引导。

微创手术导航;增强现实;实时立体全像;空间定位

1 研究背景

微创手术中,如何在局限的手术空间下避免对微小复杂生理组织伤害,并准确抵达病灶区域,是临床医学中亟待解决的问题。随着计算机断层扫描(CT)、磁共振成像(MRI)等医学影像技术的快速发展,医生可以更详细的了解解剖结构与生理结构信息。在医学影像信息的引导下,医学计算机辅助手术可以辅助医生实时了解关键区域的空间结构、靶向区域与介入工具之间的关系[1],有效进行术前路径规划,术中精准治疗与术后观察。

在传统计算机辅助导航系统中,图像导航界面与手术操作区域分离,医生需要在屏幕和患者病灶区域之间进行视野切换,以确认手术入口、工具和目标之间的位置。手眼无法协调的问题会显著降低操作的效率和准确性[2]。并且,传统导航界面仅供医生进行二维观察,缺乏对病灶区域的整体空间信息显示。因此,如何解决手眼协调问题、实现精准立体空间定位与图像引导是精准微创手术领域的研究重点与难点。为解决上述提及的两个主要问题,许多研究提出图像增强导航的解决方案。增强现实(AR)作为一种能够将虚拟计算机数据准确融合到实际手术场景的可视化技术[3],无需医生在图像显示器和实际操作区域进行视野切换,改善医生的手眼协调问题,提高图像引导手术的精度[4]。医疗中对于增强现实装置有两个关键要求——准确的时间和准确的位置。这两者能够保证实际手术区域和虚拟影像的动态配准融合。为实现这些目标,三维定位技术、术中成像与三维可视化技术等等应用于医疗增强现实系统中[5]。针对医疗增强现实技术的研究通过光学投影、光路变换等技术完成影像融合,多集中于二维投影增强、手术显微镜、头戴式三维显示器(HMD)、和原位透视融合显示[6]的研究。

二维投影显示系统需借助投影装置将医学影像数据叠加到人体上实现影像增强手术引导。二维投影显示实现方法简单,无需借助复杂设备即可完成增强现实的需求,设备空间体积小。因为投影需被实物呈接后才能可视化,投影图像通常为二维图像,无法实现三维图像投影融合显示,无法提供深度信息,在复杂区域手术中并不适用。此外,术中人体组织表面将产生形变,为得到无畸变的准确投影图像,需要根据人体表面形态对被投影图进行形变处理。

头戴式三维显示器通过向观察者左右眼视野分别提供不同的影像构建视差感,人眼通过双目视差图在空间中聚焦得到三维立体场景。研究者在头戴式显示器用于医疗教学、内窥镜手术等方面进行了大量研究。头戴式三维显示器能构建高清晰度三维场景,通过增强现实或虚拟现实的方式提高手术的准确性与效率。然而同时,头戴式三维显示器通过两幅二维图像构建的三维场景与观察者视点位置相关,在不同观察者的使用中其精度存在个体性差异。为得到准确融合图像,需要对医生进行位置追踪。此外,其装置本身以及观察过程中的辐辏反射不一致性问题易令观察者产生晕眩的感受以及视觉疲劳的问题。

立体手术显微镜也是采用双目视差图构建立体场景,并通过光学叠加的方法把引导信息叠加至手术显微镜成像视野中。将MRI或CT扫描数据传送到左右视野中实现增强显示,通过光学追踪装置可以定位显微镜和患者位置,显示准确的增强图像。在增强显示的同时获取更为清晰的术中场景。

与头戴式三维显示器、立体手术显微镜等相比,基于半透半反镜的原位透视融合显示系统无需追踪观察者的位置或佩戴附加辅助观察装置[2]。利用原位透视融合显示技术,医生能够穿透半透半反镜观察到叠加到真实场景中的医学影像信息。医学影像信息可以是二维横断面图像、三维面绘制或体绘制结果和立体医学影像。通过患者-影像注册以及调整影像与半透半反镜的光学对应关系可保证图像能够融合到目标空间位置。利用该系统能够将患者信息与术前术中信息相融合,用于术前规划和术中引导。评估实验证明,与常规方式相比,采用原位透视融合显示系统进行脊椎穿刺针的位置更加准确。目前,原位透视融合显示已经应用于膝关节[7]、导针穿刺[8]、牙科[9]和其他微创手术的模型及动物实验。

叠加影像的空间精度与融合精度是确保手术安全性和高效性的主要因素。由于二维平面显示不能提供足够的空间精度,因此三维可视化与三维空间透视融合技术得到越来越多的重视。相较于二维投影缺乏立体信息、头戴式三维显示器和立体手术显微镜体积大且深度信息不精确[10]等问题,利用三维空间透视融合系统不仅能够显示具有立体视差、运动视差且空间位置准确的三维影像,而且能够准确叠加融合到真实场景中起到增强现实的作用,是实现增强现实图像引导手术的重要解决方案。

为满足临床对三维原位可视化的需求,实现精确三维影像叠加融合显示,解决手眼协调问题,本文提出一种基于高性能立体全像技术的新型空间透视融合精准定位导航系统,实现对微创手术器械追踪与靶向区域的三维立体增强显示。并且对其临床应用和研究应用进行分析与探讨。

2 新型空间原位透视融合精准定位导航系统

为提高手术导航系统信息的可靠性与精确性,解决现有系统中手眼协调与缺乏立体引导信息等问题,我们提出基于高性能立体全像技术的立体空间影像原位透视融合精准定位导航系统,为医生提供一个立体、精确、直观的增强现实手术导航场景。本系统基于实时立体全像技术与新型光路结构,设计空间透视融合装置,完成裸眼三维立体影像在实际患者的叠加显示;基于立体全像技术设计紧凑式空间标记物,对用于微创手术狭窄区域的手术器械进行精确定位追踪。基于高性能立体全像技术的新型空间透视融合精准定位导航系统,能够为医生提供可视化引导,有效了解患者解剖结构与手术器械空间姿态。

2.1 实时立体全像技术

与前文所述二维影像或双目立体影像增强现实导航相比,自由立体全像能在无需佩戴眼镜或其他设备的情况下为观察者提供引导信息。自由立体全像可通过透镜阵列、光栅、体显示器、全息成像等方法实现。其中,实时立体全像技术(IV)能生成几何位置信息准确的全真彩色、全视差立体影像。与实物一样,立体全像在空间中有固定的位置,在不同的视角下,观察者能看到不一样的影像,且可供多人同时裸眼观察。实时立体全像的数据源可以是术前或术中医学影像数据、计算机模型或立体相机、激光扫描等设备采集的三维信息,能方便重建生理结构和手术器械立体影像,为医生提供精确直观的引导。

立体全像的原理是空间物体的三维信息能被一组微型凸透镜阵列记录在其焦平面上,焦平面上记录到的影像称为基元图像。由此,三维信息能通过基元图像和对应微透镜阵列恢复出来。基元图像上每个像素点发出的光线穿过对应透镜中心,并在不同位置相交会聚,在对应的空间位置上重现立体影像。实时立体全像技术通过计算机仿真基元图像生成过程,并将基元图像显示在二维平面显示器上,以实现动态重现。基元图像的计算方法可分为面绘制与体绘制两大类。面绘制方法通过计算多个视点下表面模型到基元图像平面的反向映射确定基元图像上各像素值,其计算过程服从像素分配算法[11-12],见图1。体绘制方法假设基元图像中每个像素点均发射出一条穿过对应微透镜中心的光线,通过计算每条光线方向上体绘制结果确定其像素值。

图1 实时立体全像面绘制方法原理

手术场景发生变化时,引导影像需实现实时渲染,以进行同步更新。然而,立体全像渲染过程包含大量的计算,例如一次渲染包括大量面片绘制(面绘制)或光线追迹计算(体绘制)(图2)。为保证渲染速度符合临床需求,可以使用基于图形处理器(GPU)并行加速的立体全像渲染流程[13],使用商用级GPU便可实现高分辨率实时立体全像渲染。

图2 立体全像显示在各个视角下的不同效果

2.2 立体影像增强现实导航关键技术

影像引导手术[14]主要涉及四个主要技术。首先,术前路径规划与优化是手术成功的保证。根据精确引导信息,医生可以决定手术器械的入口和路径,以避免损伤周围的高风险结构。第二步是在手术过程中实时跟踪检测手术器械的位置,确定其与病灶区域的空间位置。同时,辅助进行注册。第三,结合患者术前医学图像选择不同的注册方法,完成术前医学图像与实际患者的统一。第四,直观的人性化友好界面能够为医生提供可视化引导。其中,为实现准确三维影像空间融合增强显示与术中器械追踪,需要选择合适的患者-医学影像注册与空间定位方法。下文将详细介绍立体影像增强显示导航涉及的注册与空间定位技术。

2.2.1 空间定位技术

在影像引导手术中,空间定位系统能提供成像设备、手术器械与患者的实时位姿,以保证增强现实引导影像显示位置的精确性与可更新性。临床常用的定位系统包括基于框架的立体定位、光学定位、电磁定位与术中影像设备。立体定位通过框架规定参考坐标系,患者与器械需固定在框架上并通过机械的方式实现定位。虽然基于框架的立体定位在刚性结构定位上有很高的精度,但框架结构总易影响手术操作。光学定位系统通过可见光或红外光范围内进行对标志点的识别实现空间定位。光学定位拥有较高的精确度与稳定性,但需保持标志点始终处于定位系统的有效范围内且不存在遮挡。电磁定位可以很好地解决光学定位中存在的遮挡问题,可实现体内目标的跟踪。电磁定位通过检测位于磁场中电磁线圈中感应电流变化判断其位姿。然而,电磁定位系统中磁场的稳定性易受外界环境干扰,导致定位精度不及光学与机械定位方法。术中影像设备通过影像处理方法获取手术器械或生理结构的实时位置,并能很好地诠释器械与生理结构间的关系。此外,术中影像还可用于实时诊断与治疗效果评估。

目前临床使用的大多数定位系统需要借助特定的标志点,但这个方法有明显的局限性。首先是标志点固定可能对患者造成的损伤和感染;再次,标志点仅能反应有限个数点的位置,难以精确反映非刚性的定位目标的准确位姿。为解决上述问题,需要使用无需标记的空间定位方法。基于图像特征分析与运动检测方法、医学成像与可见光双目相机都可用于目标定位[20]。目前,在以介入器械、牙科、软组织等为目标的无需标记空间定位研究已获得了良好的结果,但依然受到定位精度、定位速度及鲁棒性等方面的局限。随着医学影像、模式识别、计算机视觉等领域的发展,无需标记空间定位将拥有更大的临床应用潜力。

因为不同空间定位方法均有各自的优缺点,复合型空间定位系统通过结合不同方法,实现精度更高、有效范围更大、更可靠的空间定位。

2.2.2 患者-立体医学影像的三维注册

导航系统中,患者与医学影像的三维注册技术能实现医学影像数据和实际患者间在空间位置上的有效关联,保证立体影像能在目标解剖结构上精准呈现。患者-立体医学影像三维注册基于两组分别位于立体影像与患者数据上,且相互对应的外部特征点集或自然解剖结构特征点集,确定患者坐标系与立体影像坐标系间的转换关系。从数学角度而言,三维注册过程是基于基准点集对求解从立体影像坐标系到患者坐标系的转换矩阵的过程。其中刚性转换关系可以表示用一个4×4矩阵表示,其中包括一个3×3旋转矩阵和一个3×1平移向量。基于最小二乘拟合算法,此转换矩阵可通过最小化特征点集之间的距离求解。

(1)基于标志点的患者-影像注册方法

特征点的定位与识别精度是影像注册精确性的主要因素。立体定向手术中的参考定位仪是一个在早期临床应用中进行对标志点进行精确定位的方法。然而,立体框架在成像过程中可能会产生伪影而降低患者-影像注册精度。此外,立体框架会引入患者不适与医生操作不便。

为了减轻患者负担与提高手术操作便捷性,可以使用标志点代替立体框架进行定位。标志点可以固定在患者、探针或成像设备上,借助定位系统便可确定上述目标的空间位姿。获取两组相对应基准点集位置的方法有两种。第一种方法是使在皮肤上或骨骼上固定标志点的位置。这些标志点能够在医学影像中精确识别,同时也能通过定位装置被跟踪。术中对标志点的实时跟踪可在患者位姿变化时实现引导图像的相应更新。第二种方法是使用在医学影像及直接观察中均易于分辨的人体解剖特征点作为基准点,例如鼻尖、眉心等内外部特征。这些特征的位置可以通过定位探针记录,由此无需在患者身体上固定任何标志点,避免对患者的损伤。

(2)无需标记的患者-影像注册方法

尽管基于标志点的注册方法在很多应用中都得到了很好的效果。但是在某些手术场景下,基于标志点的注册方法会受到一定的局限。出于尽量避免患者损伤和感染的考虑,大多数解剖目标不适合提前安置标志点。无需标记的患者-影像注册方法将能有效解决上述问题。

无需标记的患者-影像注册可通过三维表面匹配方法实现。一个解剖结构表面可以在医学影像坐标系及患者坐标系中分别使用点集进行描述。医学影像表面点集到实际患者表面点集间的变换关系可以通过面匹配算法求解。由此即可完成患者-影像注册。目前有多种算法可以点集间变换关系,其中最常用的算法是迭代最近点(ICP)算法[15]。医学影像信息通过CT、MRI等影像采集获取,实际患者数据可以通过利用多种影像采集设备在术中获取。根据影像采集设备的不同,可以分为二维场景采集与三维场景采集。

二维场景采集多采用单目相机,且获取的图像为平面投影信息,缺乏空间结构信息。为将二维平面信息同三维术前医学影像信息配准融合,Liao等[16]在2004年提出一种基于二维图像的表面匹配方法。从三维表面模型中提取的二维渲染表面模型,利用此二维表面模型与术中采集的二维平面信息进行配准融合。最后将裸眼三维立体医学影像准确透视融合到实际病灶区域。

三维场景可以由立体相机三维重建,激光表面扫描重建与结构光重建获取。通过多种方式获取三维表面数据后,基于表面匹配方法可以将三维表面数据同术前CT、MRI的表面数据进行匹配,完成无标志点的患者-医学影像注册。基于立体相机的三维重建是通过相机标记获取立体相机的内外参数,并根据此参数与左右视差图重建得到三维场景。而已有研究表明激光表面扫描没有侵入性、且具有足够的精度[17]。因此,激光扫描分辨率越高,激光表面扫描重建精度越高,无标志点的患者-医学影像注册结果越好。目前,此概念方法已应用于商业设备且在口腔颌面外科[18]得到了广泛应用。基于结构光的表面重建[19]技术则可利用结构光投射到患者并基于光学设备进行计算重建患者表面数据。除基于表面进行患者-医学影像注册外,还可以基于解剖轮廓进行配准。Wang等[9]提出一种基于立体追踪和三维轮廓配准的自动无标志点配准方法。该方法主要包括四个主要步骤。首先,在立体图像的首帧左视图中手动选择图像模板,以用于采集牙科手术场景。其次,右视图的对应区域可以根据模板匹配获取。第三步,在左右视图感兴趣区域中,根据牙齿和口腔的强对比度提取二维牙齿边界。并且基于极限约束搜索算法进行立体配准。最后,根据相机标定结果完成三维轮廓重建并且进行实时更新。基于ICP算法实现三维轮廓与术前CT、MRI等数据提取到的模板进行注册。根据三维图像融合增强现实,能够增加牙科手术的准确性。

2.3 立体全像原位透视融合导航系统构成

立体全像原位透视融合导航系统主要包括基于立体全像的紧凑式定位器械追踪系统和导航系统两部分。

2.3.1 基于立体全像的紧凑式定位器械追踪系统

当患者、手术器械与导航装置移动时,立体全像导航信息需实现同步更新,这时需要术中实时精确空间定位系统。然而,微创手术感兴趣区域小,因此如何实现狭窄空间下器械的有效追踪亟需解决。传统的光学空间定位主要基于近红外光(例POLARIS, Northern Digital Inc)和可见光(例MicronTracker, Claron Technology Inc)完成。同时为检测出整个手术器械在空间的姿态变换,需要在器械上安装三个或三个以上能够保证空间自由度的标记物。因此,其空间设计和安装复杂且空间体积较大,在一定程度上影响手术操作。

为解决上述问题,我们提出了基于立体全像技术的紧凑式空间定位器械追踪方法。利用立体全像技术对初始棋盘格状标记物进行渲染,得到具有空间信息的二维基元图像。并利用具有相同参数的微型凸透镜阵列进行三维标记物再现[23](图3)。为保证追踪到探针的整个自由度,至少需要三个标记物构成三角形形状,因此,整个探针上棋盘格状标记物的空间几何排列如图所示。三个二维基元图像与透镜阵列组合共线排列,实际在空间中生成的棋盘格状标记物构成非特殊三角形。

图3 紧凑式定位器械

基于立体全像技术的紧凑式定位器械占有空间体积小,能够满足在微创手术狭窄区域的有效空间定位与跟踪,保证手术导航信息的精确可靠[23](图4)。

图4 紧凑式定位器械应用场景

2.3.2 基于立体全像的导航系统构成

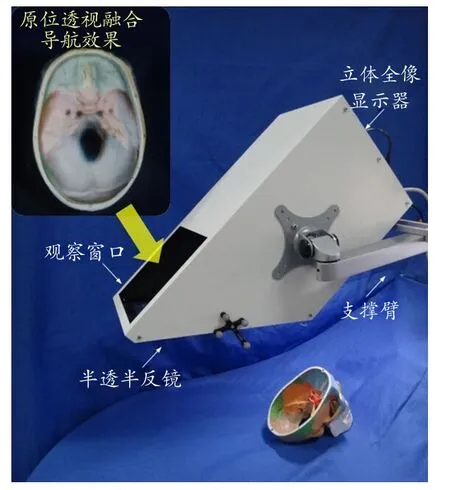

立体全像原位透视融合导航装置由立体全像显示器、半透半反镜与支撑臂构成,见图5。

图5 立体全像原位透视融合导航装置框架

观察者透过半透半反镜观察手术区域,同时,观察者还能看到经半透半反镜反射后的立体全像,这样立体全像便能叠加在手术区域上。因为渲染的立体全像与最终观察到的立体全像间满足光学透镜的缩小成像与半透半反镜的镜像关系,通过对光路的精确建模与计算,我们能够通过调整立体全像渲染参数,保证立体全像能与患者目标生理结构在空间中精确融合,见图4。这样,医生能直观精确地获取被遮挡生理结构的位置与形态,以更好地保证手术安全性与效率。此外,医生能根据手术操作需求方便地调整导航装置位置与观察角度,对不同的手术目标进行引导。

在精细手术中,引导影像应具有很高的分辨率,保证医生能够分辨微小重要组织。然而,立体全像的分辨率受基元图像分辨率和透镜阵列密度限制。这里我们提出了一个高效灵活的基于光学透镜的高分辨率实时立体全像系统。此系统由光学透镜组成,放置于观察者与立体全像之间。此系统能实现立体全像几何尺寸的缩小,同时保持影像的像素数,从而提高影像像素密度,提高立体全像单位体积内的分辨率。与此同时,为补偿透镜成像中存在的光学畸变,我们还提出了立体全像预畸变校正算法。通过仿真或实验标定的方法确定透镜的光学畸变模型,并在立体全像渲染过程中将光学畸变考虑在内,补偿光学元件畸变对成像精度的影响,以满足临床安全对立体全像分辨率的需求[22]。

3 系统搭建与实验结果

我们搭建立体全像原位透视融合导航原型系统,并在膝关节手术领域进行了志愿者实验。实际搭建的系统见图6。

图6 立体全像原位透视融合导航原型系统

膝盖部位的手术是一种针对骨头/软骨损伤的微创手术。作为抑制伸展过度的重要内部稳定部位,膝关节很容易在超过生物力学限制的时候受到损伤。因此,医生需要重建膝关节以对其进行治疗。手术中,外科医生通过股骨和胫骨的空隙中进行操作。为更好的实现术后康复,保证腔道位置精度是很重要的。在传统的手术中,外科医生使用X射线或CT得到的医学图像进行引导操作。将立体全像原位透视融合导航系统应用于前交叉韧带重建能够实时显示静脉建立股骨、胫骨和手术器械[21],直观生动地显示三维膝关节内部结构(图7)。在光学跟踪系统和半透半反镜的辅助下,骨头的CT数据和三维手术器械能够引导外科医生观察到膝关节结构和手术病人的体内工具位置,进而完成手术操作。

图7 立体全像原位透视融合导航系统在膝关节手术志愿者实验与结果

4 结论

图像增强现实技术能够解决手眼协调问题,辅助医生在观察实时场景的同时获取医学影像信息,从而保障手术安全、提高手术精度。

本文介绍了目前可用于图像引导手术中的多种增强现实系统,简要介绍各种增强现实系统的研究进展并对其优缺点进行对比。相较于二维投影缺乏立体信息、头戴式三维显示器和立体手术显微镜体积大且深度信息不精确等问题,利用三维空间透视融合系统不仅能够显示具有立体视差、运动视差且空间位置准确的三维影像,而且能够将三维医学影像准确叠加融合到真实场景,是实现增强现实图像引导手术的一种重要解决方案。本文着重介绍了三维空间透视融合系统的关键技术,包括三维影像可视化、精确的患者-立体医学影像的三维注册与有效的器械追踪。并针对于微创手术的实际临床应用需求,提出一种基于高性能立体全像技术的新型空间透视融合精准定位导航系统。基于光学透镜实现高分辨率实时立体全像显示,提高三维融合影像性能。同时基于立体全像技术设计紧凑式定位器械,实现在微创手术狭窄区域的定位追踪。

相较于软组织,骨科中的结构变形小,因此,对于骨科的三维空间透视融合系统更容易实现,且目前的临床实验显示了良好的应用前景。然而,目前的三维空间透视融合系统依旧存在一定技术上的制约。例如,其具有较高的空间精度,但其平面精度需要进一步的改善。为获得清晰的立体视觉图像和较宽的显示视角,需要利用高性能微型凸透镜阵列和高分辨率显示器。同时,也需要更多的临床试验对系统的效率和可行性进行评估。

三维空间透视融合已经成为图像引导手术的重要发展趋势,将会为精准微创诊疗提供有效可视化平台。

致谢

本课题受国家自然科学基金(81427803, 61361160417, 81271735),北京市科委《生命科学领域前沿技术》专项(Z151100003915079)及科技支撑计划项目(2015BAI01B03)项目等资助。

[1] Cleary K,Peters TM.Image-guided interventions:technology review and clinical applications[J].Annu Rev Biomed Eng, 2010,12:119-142.

[2] Peters T,Cleary K.Image-guided interventions:technology and applications[M].US:Springer,2008.

[3] Liao H,Edwards PJ.Introduction to the special issues of mixed reality guidance of therapy-Towards clinical implementation[J].Comput Med Imaging Graph,2013,37(2):81-82.

[4] Suenaga H,Tran HH,Liao H,et al.Real-time in situ threedimensional integral videography and surgical navigation using augmented reality:a pilot study[J].Int J Oral Sci,2013,5(2):98-102.

[5] Lamata P,Ali W,Cano A,et al.Augmented reality for minimally invasive surgery:overview and some recent advances[J].Minerva Chir,2010,65(4):451-462.

[6] Sauer F,Vogt S,Khamene A.Augmented reality.Image-Guided Interventions[M].US:Springer,2008:81-119.

[7] Tran HH,Suenaga H,Kuwana K,et al.Augmented reality system for oral surgery using 3D auto stereoscopic visualization.Medical Image Computing and Computer-Assisted Intervention-MICCAI 2011[M].Berlin Heidelberg:Springer,2011:81-88.

[8] Fichtinger G,Deguet A,Masamune K,et al.Needle insertion in CT scanner with image overlay-cadaver studies.Medical Image Computing and Computer-Assisted Intervention-MICCAI 2004[M].Berlin Heidelberg:Springer,2004:795-803.

[9] Wang J,Suenaga H,Hoshi K,et al.Augmented Reality Navigation with Automatic Marker-Free Image RegistrationUsing 3D Image Overlay for Dental Surgery[J].IEEE Trans Biomed Eng,2014,61(4):1295-1304.

[10] Liao H,Sakuma I,Dohi T.Development and Evaluation of a Medical Autostereoscopic Image Integral Videography for Surgical Navigation[C].Complex Medical Engineering,2007. CME 2007[A].IEEE/ICME International Conference on, IEEE,2007.

[11] Lippmann G.La Photographie integrale,Comtes Rendus[M]. Academie des Sciences,1908:446-451.

[12] Liao H,Nakajima S,Iwahara M,et al.Intra-operative realtime 3-D information display system based on integral videography.Medical Image Computing and Computer-Assisted Intervention-MICCAI 2001[M].Springer Berlin Heidelberg,2001.

[13] Liao H,Dohi T,Nomura K.Autostereoscopic 3D display with long visualization depth using referential viewing area-based integral photography[J].IEEE Trans Vis Comput Graph,2011, 17(11):1690-1701.

[14] DiGioia III AM,Jaramaz B,Colgan BD.Computer assisted orthopaedic surgery:image guided and robotic assistive technologies[J].Clin Orthop Relat Res,1998,(354):8-16.

[15] Eggers G,Mühling J,Marmulla R.Image-to-patient registration techniques in head surgery[J].Int J Oral Maxillofac Surg,2006, 35(12):1081-1095.

[16] Liao H,Inomata T,Hata N,et al.Integral videography overlay navigation system using mutual information-based registration. Medical Imaging and Augmented Reality[M].Springer Berlin Heidelberg,2004:361-368.

[17] Luebbers HT,Messmer P,Obwegeser J A,et al.Comparison of different registration methods for surgical navigation in cranio-maxillofacial surgery[J].J Craniomaxillofac Surg,2008, 36(2):109-116.

[18] Marmulla R,Hassfeld S,Lüth T,et al.Laser-scan based navigation in cranio-maxillofacial surgery[J].J Craniomaxillofac Surg,2003,31(5):267-277.

[19] Nicolau S,Soler L,Mutter D,et al.Augmented reality in laparoscopic surgical oncology[J].Surg Oncol,2011, 20(3):189-201.

[20] Liao H,Hata N,Nakajima S,et al.Surgical navigation by autostereoscopic image overlay of integral videography[J].IEEE Trans Inf Technol Biomed,2004,8(2):114-121.

[21] Liao H,Nomura K,Dohi T.Autostereoscopic integral photography imaging using pixel distribution of computer graphics generated image[C].ACM SIGGRAPH 2005 Posters,ACM,2005.

[22] Zhang X,Chen G,Liao H.A High-accuracy Surgical Augmented Reality System Using Enhanced Integral Videography Image Overlay[C].37th Annual International Conference of the IEEE Engineering in Medicine and Biology Society (EMBC'15),2015[A].

[23] Fan Z,Wang J,Liao H.A spatial position measurement system using integral photography based 3d image markers.1st Global Conference on Biomedical Engineering & 9th Asian-Pacific Conference on Medical and Biological Engineering[M]. Springer International Publishing,2015:150-153.

High-precision Three-dimensional Space See-through Surgical Navigation

FAN Zhencheng, ZHANG Xinran, LIAO Hongen

Department of Biomedical Engineering, School of Medicine, Tsinghua University, Beijing 100084, China

Image guided surgery has shown increasing importance as the public is in need of a surgical procedure that is minimally invasive, requires short recovery time, and can be performed in a safer and more efficient way. Current researches focus on how to utilize medical images to guide preoperative planning and to intraoperatively ensure real-time diagnosis, high-accurate operation, and high-efficient treatment. This paper proposed a surgical navigation technique and system for specific clinical scenarios, and provided an integral videography three-dimensional (3D) image based high-precision augmented reality. Key technologies involved in the surgical navigation system were also introduced. The surgical tools can be tracked in real time and updated in 3D display. Using 3D image overlay system, 3D autostereoscopic images of critical anatomy structures and tools can be observed with naked eyes in surgical scene. The proposed system can provide intuitive and precise guidance for surgeons by providing a “see-through” 3D augmented scene.

minimally invasive surgery navigation; augmented reality; integral videography; spatial tracking

R197.39

A

10.3969/j.issn.1674-1633.2016.03.005

1674-1633(2016)03-0026-07

2015-10-07

2016-01-13

国家自然科学基金国家重大科研仪器研制项目(81427803);国家自然科学基金(61361160417, 81271735);北京市科委《生命科学领域前沿技术》专项(Z151100003915079);科技支撑计划项目(2015BAI01B03)等支持。

廖洪恩,教授。

通讯作者邮箱:liao@tsinghua.edu.cn