粒子群优化算法的性能分析和参数选择

2016-11-10王东风孟丽

王东风 孟丽

粒子群优化算法的性能分析和参数选择

王东风1孟丽1

惯性权重和加速因子是影响粒子群算法优化性能的重要参数.基于常用的12个测试函数,本文通过实验研究了不同参数组合下粒子的探索能力和算法的优化性能,在此基础上推荐了一组固定的参数组合.通过惯性权重和加速因子的不同变化策略组合对算法性能影响的实验分析,推荐了一种变化的参数设置方法.基于CEC2015发布的15个基准函数进一步验证了本文推荐的参数选取方法的有效性.最后讨论了粒子群优化(Particle swarm optimization,PSO)算法在连续优化和离散优化方面的应用问题.

粒子群优化,探索能力,算法性能,参数选取

引用格式王东风,孟丽.粒子群优化算法的性能分析和参数选择.自动化学报,2016,42(10):1552-1561

粒子群优化(Particle swarm optimization,PSO)算法是Kennedy和Eberhart在1995年提出的一种群智能优化算法[1],源于对鸟群捕食行为的研究.1998年,Shi等[2]在原始PSO中引入了惯性权重,后来被称为标准PSO.由于PSO结构简单、易于实现,且不需要借助问题的特征信息,已受到众多学者的关注,在算法的性能改进和分析方面不断取得新的成果[3-4],在多个领域得到广泛应用[5].

在PSO算法中,有一些需要调节的参数:种群规模(种群的个体数目)N,速度限值位置限值惯性权重w,加速因子c1和c2.其中,w,c1和c2对算法性能的影响较大,目前有很多学者对其设定和调节方式进行了研究.在参数选取方面,文献[6-9]通过实验或理论分析,推荐了一组固定参数值.在时变参数的调节方面,对于惯性权重的调整,文献[2,10]提出了随迭代次数减小惯性权重,文献[11-12]给出了随机惯性权重策略,文献[13-15]根据种群的信息自适应地调节惯性权重;对于加速因子的调整,文献[16]提出在迭代的过程中,c1和c2线性递减,文献[17]则提出c1线性递减、c2线性递增,文献[18]基于个体的更新信息给出了一种c1和c2的自适应调整策略.以上这些参数的调整方法,都在一定程度上提高了算法的性能,但是,当涉及到时变参数时,并没有考虑到惯性权重和加速因子之间的配合作用.单独依靠调整惯性权重或加速因子,并不能在种群的局部开发能力(Exploitation ability)和全局探索能力(Exploration ability)之间进行平衡.事实上,各个参数之间需要相互配合,才能够达到预定的效果.本文考虑了各个参数之间的配合,基于在感兴趣的参数范围内进行的优化测试实验数据,通过定义最优解超越次数,推荐了一组固定和时变的参数值.

本文其余部分安排如下:第1节先给出标准粒子群算法的形式;第2节通过仿真实验研究不同参数对粒子探索能力、算法成功率和算法性能的影响,推荐一组固定参数值;第3节研究算法中的认知参数c1和社会参数c2的变化策略对算法性能的影响,并推荐一组变参数的组合设定方式;第4节基于CEC2015发布的15个基准函数进一步验证本文推荐的参数选取方法的有效性;第5节讨论PSO算法在连续优化和离散优化方面的应用问题;第6节对全文进行了总结.

1 标准粒子群(SPSO)算法

在粒子群算法中,每个粒子代表寻优空间中一个潜在的解,有一个由被优化的函数决定的适应值.在每一次迭代进化中,粒子通过自身和群体的历史最优位置更新当前的速度和位置.在任意t+1时刻,粒子群算法中第i个粒子第d维的速度和位置更新公式为

其中,vid和xid分别为粒子的速度和位置,w为惯性权值,c1和c2称为加速因子,分别为认知参数和社会参数,pid和pgd分别为个体和群体的历史最优位置,r1d和r2d为两个相互独立的服从[0,1]之间均匀分布的随机数,正是这两个随机数的引入,使得算法的进化过程具有一定的不确定性,也因此赋予了算法一定的空间探索能力,从而有利于找到问题的最优解.

2 粒子群算法的性能分析

下面通过实验说明粒子的探索能力和算法的性能与参数之间的关系.我们感兴趣的参数区域是w∈[-1,1],c1+c2∈[0,8],这也是绝大多数文献研究的区域.所有的实验都基于以下12个常用的基准函数,由于这些基准函数被普遍应用,在此只给出函数的名称,即:Fun1:Sphere;Fun2:Rosenbrock;Fun3:Schwefel′s P2.21;Fun4:Schwefel′s P2.22;Fun5:Schwefel′s P1.2;Fun6:Rastrigin;Fun7:Griewank;Fun8:Ackley;Fun9:Schwefel;Fun10:Weierstrass;Fun11:Penalized1;Fun12:Penalized2.

2.1参数对粒子探索能力的影响

粒子群算法参数w,c1,c2的选取对算法的优化性能有很大影响.不同的参数组合下,粒子的轨迹形式是不同的,决定了粒子探索能力的大小.在种群进化过程中的第t代,若粒子能够找到比t-1代的全局最优解更好的解,那么则认为粒子具有一定的探索能力.我们通过以下实验观察不同的参数对粒子探索能力的影响.设种群规模为N,为每个粒子设置不同的参数,设置变量Pnumi记录具有不同参数的粒子i在进化的过程中超越上一代的全局最优解的次数:

其中,t=2,3,···,tmax.

将上面定义的Pnumi称为粒子i的第t代最优解超越次数,它表征了粒子探索能力的大小.显然,探索能力大的粒子更有可能找到全局最优解.

对于所有的粒子设置相同参数的粒子群算法,则所有的粒子在统计意义上具有相同的探索能力;随着算法进化进程的推进,具有不同的状态的粒子在当前迭代步则具有不同的探索能力;被设置不同参数的粒子,一般则具有不同的探索能力.这已得到作者们进行的大量仿真优化计算实例的证实.图1为4组不同的PSO种群在优化函数Sphere时每个粒子的Pnum值:种群大小均为50,函数设置为10维,最大迭代次数为500,每组种群运行50次,记录每个粒子Pnum值的平均值.图1(a)为种群中粒子设置为相同的参数时(w=0.6,c1=c2=1.7)每个粒子的Pnum值;图1(b)、图1(c)和图1(d)为种群中粒子设置不同参数时每个粒子的Pnum值,其中图1(b)中,第1~50个粒子的w值均为0.6,c1=c2为0.04:0.04:2;图1(c)中,第1~50个粒子的w值均为1.7,c1=c2分别为0.02:0.02:1,图1(d)中,第1~10个粒子的w值均为0.2,c1=c2分别为0.2:0.2:2,第11~20个粒子的w均为0.4,c1=c2分别为0.2:0.2:2,依此类推,第41~50个粒子的w均为1.0,c1=c2分别为0.2:0.2:2.

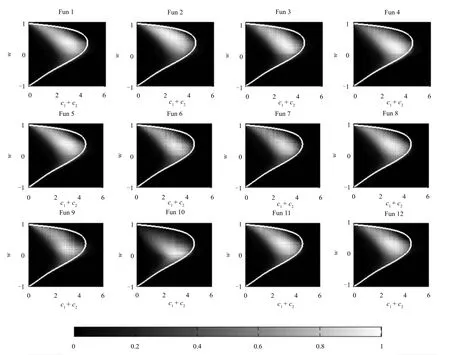

在w∈[-1,1],c1+c2∈[0,8]的参数区域上对所用的12个基准函数进行蒙特卡罗实验.每个函数进行两组实验:1)种群中的个体取相同的w,c1=c2则取不同的数值.本组实验中,根据种群参数w的值分为51组子实验,w的取值按0.04的间隔从-1~1,每个子实验中,种群大小均为81,c1=c2按0.05的间隔从0~4取81个值分配给不同的粒子,函数运行50次,记录不同粒子在50次运行中的Pnum的平均值.2)种群中的个体取不同的w,而c1=c2取相同的固定值.本组实验中,根据种群参数c1(c2)的值分为81组子实验,c1=c2的取值按0.05的间隔从0~4,每个子实验中,种群大小均为51,w按0.04的间隔从-1~1共取51个值分配给不同的粒子,函数运行50次,记录不同粒子在50次运行中的Pnum的平均值.将两组实验中得到的相同参数组合下粒子i的Pnumi进行求和,得到此参数组合在不同种群环境中的综合探索性能,进而得到整个参数区域内不同参数组合的综合超越次数.相比于超越次数的绝对值,我们更关心不同参数组合下粒子探索能力的相对关系,因此对每个函数得到的结果分别进行归一化处理,结果如图2所示.值得注意的是,在6<c1+c2≤8的区域中,对于任意的w运行结果Pnumi均为0,因此,6<c1+c2≤8的区域并未在图中进行展示.从图2可以明显地看到粒子群算法的参数取值对不同基准函数的优化性能的共性和特性,即对每个基准函数来说,算法的探索能力对参数的取值表现出明显的区域性,总体来说大同小异,这为PSO的参数选择提供了很好的指导作用.

2.2参数对算法成功率的影响

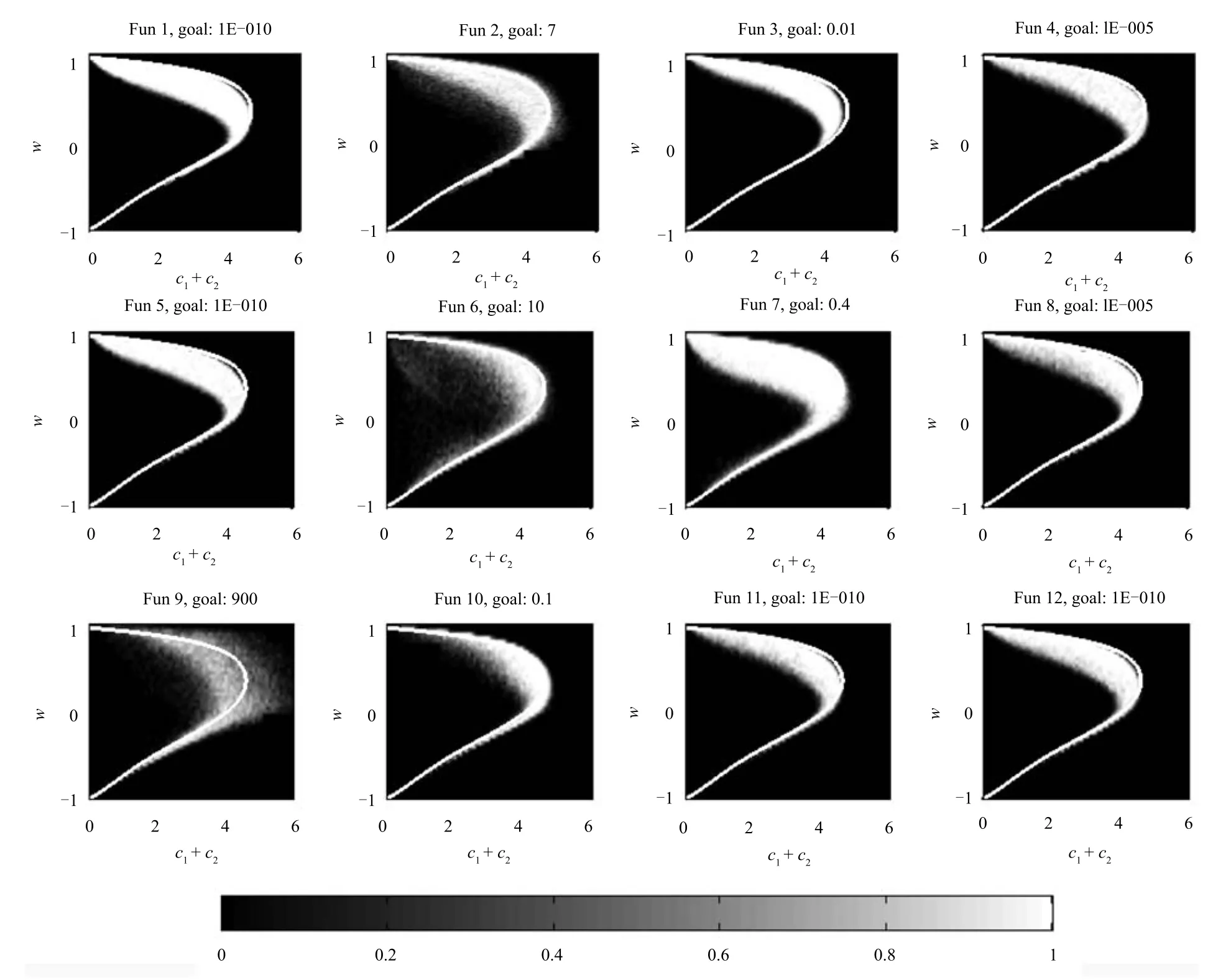

在w∈[-1,1],c1+c2∈[0,8]矩形域上按照等间隔的网格取点,(c1+c2)轴取点间隔为0.02,共101点,w轴取点间隔为0.04,共201点,共可得到20301组不同的参数组合.对每一组参数组合进行蒙特卡罗仿真实验,优化12个基准函数.种群规模N为50,最大迭代次数tmax为500,每个函数独立运行50次.为每个函数设置寻优精度goal,记录不同参数组合下达到所设置寻优精度的成功率,绘制成灰度图像.每个函数的寻优精度为图中的goal所示,是通过实验测试得到的,原则是不会使测试结果得到的最佳参数组合区域过大而失去指导意义,也不会使其过小而失去一般性参考价值.设置一定的寻优精度,实验结果如图3所示.

由图3可以看到,除了Fun2、Fun6、Fun7和Fun9,其他8个函数的最优参数区域在形状上非常相似,并且都出现在靠近过渡区域的边界部分.这一部分的参数使得粒子轨迹能够以一定的幅值振荡,使得探索能力和开发能力获得很好的平衡.对于Fun2、Fun6、Fun7和Fun9这4个函数,Fun2为很难极小化的典型病态二次函数;Fun6、Fun7为典型的具有大量局部最优点的复杂多峰函数;Fun9的全局最优点与第2最优点相距很远,算法往往朝着错误的方向(第2最优点)收敛.这4个函数只靠调节算法参数很难得到满意的解,运行结果的规律性没有其他函数那么明显.

将图2与图3对比可以看到,图2和图3并不是完全对应的.图2中展示的粒子的探索能力为粒子的局部探索能力和全局探索能力的总和,而不同的函数具有不同的特性,对群体的局部探索能力和全局探索能力的要求是不同的.虽然总的探索能力与寻优性能并不是完全对应的,但是,没有探索能力的参数区域,基本上是不可取的.

2.3几种典型参数选取策略的性能对比及一组固定参数推荐值

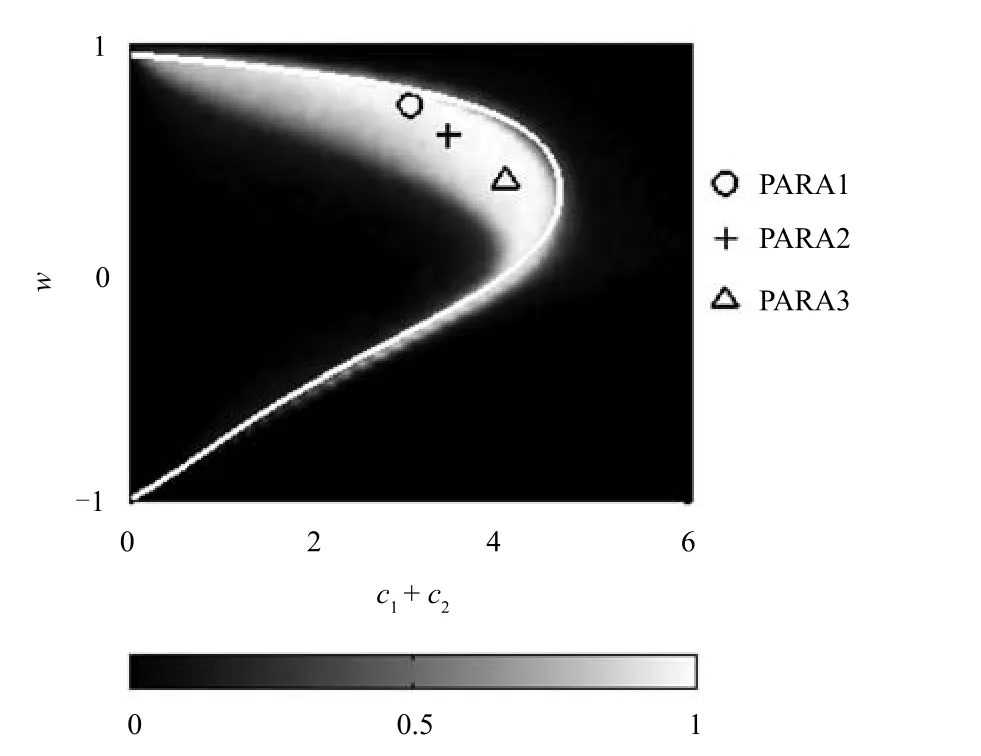

由图3可以看到,使得算法获得优良性能的参数区域因函数的不同而有一些差异,基本上没有一组参数能够使得所有的函数同时获得最优,尤其可以看到,Fun2和Fun9的较优参数区域的交集部分是非常小的.尽管如此,仍然可以选择出一些参数,使算法在所有函数上获得比较令人满意的综合性能.为了能够更加容易地选择出在12个函数上综合性能较优的参数,我们将不同函数下得到的运行结果进行整合,得到算法在不同参数下的综合性能的示意图,见图4.

图2 粒子探索能力与参数的关系Fig.2 Relationship between particle exploration ability and its parameters

图4中标示的PARA1和PARA2分别为文献[6]和文献[7]推荐的参数取值.其中,参数组合PARA1(w=0.7298,c1=c2=1.49618)是Eberhart等[6]将带有惯性权重和带有收缩因子的两种形式的粒子群算法进行比较后推荐的一组参数;参数组合PARA2(w=0.6,c1=c2=1.7)是Trelea[7]在分析粒子轨迹收敛域的基础上推荐的参数.参数组合PARA3是我们根据性能综合图,即图4推荐的一组参数:w=0.4,c1=c2=2.在另外的工作中,Samal等[8]在理论分析的基础上给出了一组具有较快收敛速度的参数:w=0.6,c1r1=0.103,c2r2=2.897(参数组合PARA4);Carlisle等[9]在文献[6]的基础上进行了进一步的实验,考虑了的情况,通过仿真实验得到,当时,算法的性能较优,即w=0.7298,c1=2.0434,c2=0.9487(参数组合PARA5).我们将这5组参数在12个函数上进行测试,种群规模、最大迭代次数和每个函数独立运行的次数都与第2.2节一致.记录运行数次结果中的最小值(min)、最大值(max)、平均值±标准差(mean ±std),以及优化成功率(Success rate,SR),并且记录了不同参数在每个函数指定寻优精度下的成功率,结果列于表1中.为了清晰地显示参数对算法性能的影响,此处为12个函数指定的寻优精度依次为:10-20,3,10-5,10-10,10-20,5,10-1,10-10,500,10-3,10-20,10-20.以下各测试试验中所用的寻优精度均与此相同.首先来看参数PARA1~PARA3的运行结果,这三个参数组合基本上都在图4中的较优区域里.三组参数在Fun1,Fun3,Fun4,Fun8,Fun11和Fun12上的运行结果差别不大.在Fun2,Fun5,Fun6,Fun7,Fun9和Fun10上的差别相对较大,参数PARA1在Fun2,Fun7上表现较优,在Fun5上表现较差;参数PARA2在Fun6,Fun9上表现较差;参数PARA3在Fun6,Fun9和Fun10上表现较优,在Fun2,Fun7上表现较差.正如从图3中看到的,每组参数都有其适应的函数.再来看参数PARA4和参数PARA5,同样的,每组参数在不同函数上表现出的性能也是有差别的.参数PARA4的综合性能在所有的参数中是比较差的.参数PARA5是在参数PARA1的基础上发展而来的,保持c1与c2之和不变,改变c1和c2的比例,除了在Fun2上,参数PARA5的性能要优于参数PARA1.

图3 算法成功率与参数的关系Fig.3 Relationship between the algorithm success rate and particle parameters

图4 算法在12个测试函数上的性能总和Fig.4 Total optimization performance on the 12 test functions

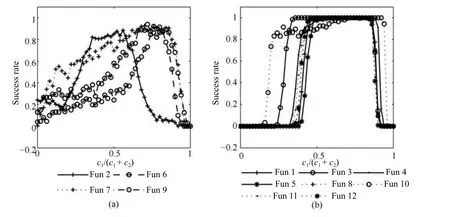

为了能够比较全面地了解c1和c2的比例对算法的影响,我们保持参数PARA1中的w=0.7298,c1+c2=2.992,将c1在c1+c2的总和中所占的比率由0逐渐增加到1,在12个函数上的运行结果如图5所示.Fun2,Fun6,Fun7和Fun9在整个比率范围内的变化情况较为复杂,图5(a)为这4个函数的变化情况,另外8个函数的优化情况展示在图5(b)中.当c1在c1与c2之和中所占比例c1/(c1+c2)在0.6~0.8之间时,图5(b)中的8个函数都获得了很好的性能,而图5(a)中,算法在Fun6,Fun7和Fun9上的成功率随c1/(c1+c2)的增加而增大,在0.8附近到达最好值;Fun2则相反,成功率随着c1/(c1+c2)的增加而减小,在0.8时的成功率非常低.当c1/(c1+c2)取为0.683时,便可得到参数组合PARA5,对于图5(b)的8个函数来说,是最好的选择.而对于图5(a)的4个函数来说,是综合考虑的折中选择.

图5 c1所占比率对算法成功率的影响Fig.5 The influence of ratio c1on algorithm′s success rate

表1 5组参数的运行结果对比Table 1 Comparison of running results on 5 parameters

3 几种典型参数变化策略的性能对比及一种变化参数推荐值

以上的实验和讨论都是基于在种群进化过程中c1和c2为定值的情形下进行的,从表1和图5的运行结果可以看到,无论c1和c2是否相等,采用c1和c2定值的调节算法在算法性能上是有局限性的.为了进一步提高算法的性能,下面观察在迭代的过程中c1和c2按照不同的方式变化时对算法性能的影响.实验仍然基于12个测试函数,对于固定的w,c1和c2有9种不同的调整策略,为简洁表示,引入3个符号:“→”表示参数c1或c2保持不变,为1.5;“↑”表示参数c1或c2在迭代的过程中线性地由0.5上升到2.5;“↓”表示参数c1或c2在迭代的过程中线性地由2.5下降到0.5.则c1和c2的9种调节策略表示为:

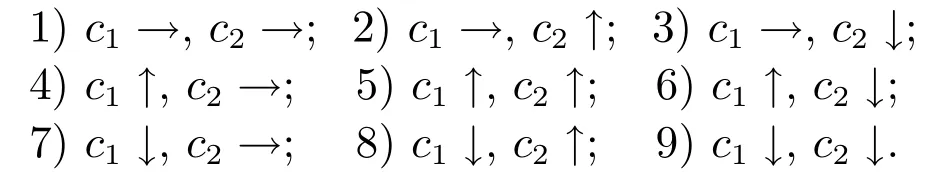

对于每个函数,进行如下实验:w从0逐渐增加到1,对于每个w的值,分别用以上9种策略进行实验.每个优化实验运行50次.记录最终结果到达指定精度的成功率.运行结果如图6所示,纵轴为算法寻优的成功率,横轴为w值,每个子图中的9条曲线,分别对应上述c1和c2的9种取值策略.

图6 变化的c1和c2取值策略对算法成功率的影响Fig.6 The influence of varying c1and c2on algorithm′s success rate

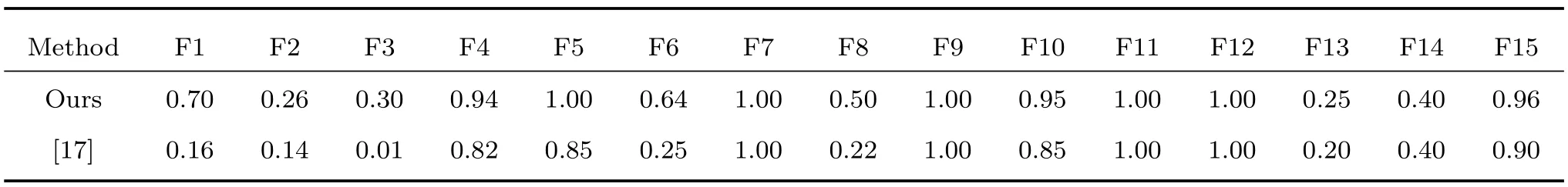

由图6可以看到,每一种c1和c2的取值策略都有与其对应的w的最佳取值范围.除了Fun2,Fun6,Fun7和Fun9,各种策略的性能随着w的变化情况是类似的,即:沿着w轴的正方向,w的整个区间可以分为5个区域:1)初始阶段,成功率几乎为0;2)紧随其后的很小的区域内,成功率由0迅速上升达到曲线的最大值;3)在一段区域内,成功率保持为最大值;4)紧随其后的很小的区域内,成功率迅速下降;5)最后区域,成功率几乎为零.区域1和区域3的大小与参数的取值策略紧密相关.而所有的策略在w>0.68时,成功率几乎均为0.区域3正是我们需要的部分.在这8个函数上,策略3、策略7和策略9使得区域3较为宽广.再来看Fun6,Fun7和Fun9,策略2取得了最好的成功率,其次为策略8.在Fun6和Fun7上,对于某些c1和c2的取值策略,w的取值可以比较小,也能够使算法获得不错的性能.在Fun2上,各个策略相适应的w值范围都很小.相比较而言,不论是从w的适用范围的大小还是从成功率的高低来看,策略4、策略5和策略6都是不可取的,即增大的调节方式总是不可取的.综合12个测试函数来看,策略8在Fun6,Fun7和Fun9上,在w=0.68时具有很突出的效果,并且,在其他8个函数上,虽然策略8的w的适用范围并不宽广,但在w=0.68时,恰恰都具有很好的性能,因此,w=0.68,c1在迭代过程中由2.5线性减小到0.5,c2由0.5线性增加到2.5,是一种很好的参数设置方式.这与Ratnaweera等[17]提出的c1递减和c2递增的调整策略是相符的,在文献[17]中,c1和c2的变化范围与本文相同,而w的取值由0.9随迭代线性减小到0.4.本文提出的和文献[17]中的参数设置方法在12个函数上的运行结果如表2所示.在表2中,Method-ours指本文推荐的w=0.68,c1在迭代过程中由2.5线性减小到0.5,c2由0.5线性增加到2.5.Method-[17]是指文献[17]给出的w的取值由0.9随迭代线性减小到0.4,c1和c2的变化范围与Method-ours相同.由表2的运行结果可以看到,本文的参数设置方法要优于文献[17]中的方法.值得注意的是,c1和c2的变化范围,与使其获得较优性能的w也是相互配合的,在我们的实验中发现,当变化范围为[0.5,2.05]时,w取0.75的性能要优于0.68.因此,3个参数之间的相互配合是非常重要的.

表2 本文与文献[17]参数设置的优化结果比较Table 2 Comparison of optimization results between the parameters set in this paper and[17]

4 本文参数设置方式优化性能的进一步验证

为进一步验证本文参数设置方法的有效性,将第2节的一组固定参数推荐值和第3节的时变参数设置方式,应用于2015年的进化计算世界大会,即CEC2015发布的15个基准函数[19].

对于参数优化能力的验证,种群大小与前面所有试验设置相同(设置为50),函数维数为10,最大迭代次数为5000,每个函数运行次数为100.试验仅记录达到指定精度的成功率(Success rate,SR),其中,F1~F15的指定精度分别为:3000,1500,20,10,500,1000,10,200,110,1000,500,110,30,3000,110.

对图4给出的3种典型固定参数,即文献[6]和文献[7]推荐的参数取值PARA1和PARA2,以及本文的参数推荐取值PARA3,表3给出了应用于CEC2015的15个基准函数上运行结果的对比.可以看出,本文的参数推荐值PARA3在15个函数上的表现略优于PARA1和PARA2.

对第3节推荐的时变参数设置方式和文献[17]的参数设置方式,表4给出了应用于CEC2015的15个基准函数上运行结果的对比.可以看出,本文推荐的时变参数设置方式在15个函数上的表现优于文献[17]的参数设置方式.

5 本文推荐的PSO参数应用于连续优化问题和离散优化问题的讨论

PSO算法最初是针对连续优化问题提出的,相关研究也主要集中在连续函数优化方面[20-22],即第1节描述的标准算法被广泛研究和应用.本文研究的出发点也主要是针对连续优化问题,文中给出的12个标准测试函数和CEC2015发布的15个基准函数[19]的优化测试,验证了本文方法在连续优化问题上的有效性.

表3 本文给出的固定参数推荐值在CEC2015基准函数F1~F15上的运行结果Table 3 Running results on CEC2015 Benchmark functions F1~F15 with fixed parameters

表4 本文给出的时变参数设置方式在CEC2015基准函数F1~F15上的运行结果Table 4 Running results on CEC2015 Benchmark functions F1~F15 with time-varying parameters

对于离散优化(或组合优化)问题而言,解空间是离散点的集合,而非连续区域,因此利用PSO算法解决离散优化问题,一般需要修正位置和速度更新公式,或者对问题进行变形,这方面的工作大致可分为如下三类[21-22]:1)直接将连续PSO用于离散优化问题的求解;2)将速度作为位置变化的概率;3)重新定义PSO算法的操作算子.对于前两种情形,本文推荐的参数取值方法仍然适用,因为算法在本质上依然遵从标准的PSO连续问题求解规则.但对于第三种情形,一般都是针对要求解的具体问题,定义不同的PSO操作算子,使得PSO算法在形式上与标准PSO算法差别较大,从而本文推荐的参数取值方法难以保证其优化效果,这方面的问题有待进一步研究.

6 结论

粒子群算法的可调参数共同影响着算法的优化性能,本文将研究重点放在了惯性权重w和加速因子c1,c2的设定和调节上.基于12个常用的、不同类型的基准函数,在w∈[-1,1],c1+c2∈[0,8]的参数区域内进行了全面的仿真研究.通过实验结果可以看到,常常被提到的“惯性权重起着调节种群全局搜索能力和局部搜索能力”的说法是欠全面的,种群的搜索能力和算法的性能,是依靠w,c1和c2的相互配合来调节的,并不是仅靠一个参数可以决定的.在对固定参数的情形进行仿真并给出参数推荐值后,还研究了时变参数对算法的影响,给出了一种推荐的时变参数设置方法.最后通过CEC2015发布的15个基准函数进一步验证了本文推荐的参数选取方法的有效性,并讨论了PSO算法在连续优化问题和离散优化问题方面的应用.

References

1 Kennedy J,Eberhart R.Particle swarm optimization.In: Proceedings of the 1995 IEEE International Conference on Neural Networks.Perth,Australia:IEEE,1995.1942-1948

2 Shi Y,Eberhart R.A modified particle swarm optimizer. In:Proceedings of the 1998 IEEE International Conference on Evolutionary Computation.Anchorage,AK,USA:IEEE,1998.69-73

3 Zhang Yong,Gong Dun-Wei,Zhang Wan-Qiu.A simplex method based improved particle swarm optimization and analysis on its global convergence.Acta Automatica Sinica,2009,35(3):289-298(张勇,巩敦卫,张婉秋.一种基于单纯形法的改进微粒群优化算法及其收敛性分析.自动化学报,2009,35(3):289-298)

4 Pan Feng,Zhou Qian,Li Wei-Xing,Gao Qi.Analysis of standard particle swarm optimization algorithm based on Markov chain.Acta Automatica Sinica,2013,39(4):381-389(潘峰,周倩,李位星,高琪.标准粒子群优化算法的马尔科夫链分析.自动化学报,2013,39(4):381-389)

5 Liu Zhao-Hua,Zhou Shao-Wu,Liu Kan,Zhang Jing.Permanent magnet synchronous motor multiple parameter identification and temperature monitoring based on binary-modal adaptive wavelet particle swarm optimization.Acta Automatica Sinica,2013,39(12):2121-2130(刘朝华,周少武,刘侃,章兢.基于双模态自适应小波粒子群的永磁同步电机多参数识别与温度监测方法.自动化学报,2013,39(12): 2121-2130)

6 Eberhart R C,Shi Y.Comparing inertia weights and constriction factors in particle swarm optimization.In:Proceedings of the 2000 Congress on Evolutionary Computation.La Jolla,CA:IEEE,2000.84-88

7 Trelea I C.The particle swarm optimization algorithm:convergence analysis and parameter selection.Information Processing Letters,2003,85(6):317-325

8 Samal N R,Konar A,Das S,Abraham A.A closed loop stability analysis and parameter selection of the particle swarm optimization dynamics for faster convergence.In:Proceedings of the 2007 IEEE Congress on Evolutionary Computation.Singapore:IEEE,2007.1769-1776

9 Carlisle A,Dozier G.An off-the-shelf PSO.In:Proceedings of the 2001 Workshop on Particle Swarm Optimization.Indianapolis,USA,2001.1-6

10 Hu Jian-Xiu,Zeng Jian-Chao.Selection on inertia weight of particle swarm optimization.Computer Engineering,2007,33(11):193-195(胡建秀,曾建潮.微粒群算法中惯性权重的调整策略.计算机工程,2007,33(11):193-195)

11 Yan Li-Ping,Zeng Jian-Chao.Particle swarm optimization with self-adaptive stochastic inertia weight.Computer Engineering and Design,2006,27(24):4677-4679,4706(延丽平,曾建潮.具有自适应随机惯性权重的PSO算法.计算机工程与设计,2006,27(24):4677-4679,4706)

12 Chalermchaiarbha S,Ongsakul W.Stochastic weight tradeoff particle swarm optimization for nonconvex economic dispatch.Energy Conversion and Management,2013,70:66-75

13 Ao Yong-Cai,Shi Yi-Bing,Zhang Wei,Li Yan-Jun.Improved particle swarm optimization with adaptive inertia weight.Journal of University of Electronic Science and Technology of China,2014,43(6):874-880(敖永才,师奕兵,张伟,李焱骏.自适应惯性权重的改进粒子群算法.电子科技大学学报,2014,43(6):874-880)

14 Zhan Z H,Zhang J,Li Y,Chung H S H.Adaptive particle swarm optimization.IEEE Transactions on Systems,Man,and Cybernetics,Part B(Cybernetics),2009,39(6):1362-1381

15 Alfi A.PSO with adaptive mutation and inertia weight and its application in parameter estimation of dynamic systems. Acta Automatica Sinica,2011,37(5):541-549

16 Suganthan P N.Particle swarm optimiser with neighbourhood operator.In:Proceedings of the 1999 Congress on Evolutionary Computation.Washington DC,USA:IEEE,1999.1958-1962

17 Ratnaweera A,Halgamuge S K,Watson H C.Self-organizing hierarchical particle swarm optimizer with time-varying acceleration coefficients.IEEE Transactions on Evolutionary Computation,2004,8(3):240-255

18 Yamaguchi T,Yasuda K.Adaptive particle swarm optimization:self-coordinating mechanism with updating information.In:Proceedings of the 2006 IEEE International Conference on Systems,Man,and Cybernetics.Taipei,China: IEEE,2006.2303-2308

19 Liang J J,Qu B Y,Suganthan P N,Chen Q.Problem Definitions and Evaluation Criteria for the CEC 2015 Competition on Learning-based Real-parameter Single Objective Optimization.Technical Report 201411A,Computational Intelligence Laboratory,Zhengzhou University,Zhengzhou China,and Technical Report,Nanyang Technological University,Singapore,2014.

20 Cui Zhi-Hua,Zeng Jian-Chao.Particle Swarm Optimization.Beijing:Science Press,2011.(崔志华,曾建潮.微粒群优化算法.北京:科学出版社,2011.)

21 Wang Ling,Liu Bo.Particle Swarm Optimization and Scheduling Algorithms.Beijing:Tsinghua University Press,2008.(王凌,刘波.微粒群优化与调度算法.北京:清华大学出版社,2008.)

22 Guo Wen-Zhong,Chen Guo-Long.Discrete Particle Swarm Optimization Algorithm and Its Application.Beijing:Tsinghua University Press,2012.(郭文忠,陈国龙.离散粒子群优化算法及其应用.北京:清华大学出版社,2012.)

王东风博士,华北电力大学控制与计算机工程学院教授.主要研究方向为群智能优化算法和智能控制.

E-mail:wangdongfeng@ncepu.edu.cn

(WANG Dong-FengPh.D.,professor at the School of Control and Computer Engineering,North China Electric Power University.His research interest covers swarm intelligence-based optimization and intelligent control.)

孟 丽华北电力大学控制与计算机工程学院博士研究生.主要研究方向为智能优化算法及其应用.本文通信作者.

E-mail:mengli2014@163.com

(MENG LiPh.D.candidate at the School of Control and Computer Engineering,North China Electric Power University.Her research interest covers swarm intelligence-based optimization and its application. Corresponding author of this paper.)

Performance Analysis and Parameter Selection of PSO Algorithms

WANG Dong-Feng1MENG Li1

Inertia weight and acceleration factors have significant impact on the performance of particle swarm optimization(PSO)algorithm.Through simulation experiments on twelve classical benchmark functions,this paper studies the algorithm′s exploitation ability and optimization performance with different parameters.Based on the experimental results,we recommend a setting for fixed parameters.Furthermore,we study the situation where inertia weight remains unchanged and acceleration factors change with iterations.Then a setting for varying parameters is recommended.The recommended parameters setting methods are verified through 15 benchmark functions that were published in CEC2015. At the end of the paper,a discussion of the PSO application issue on continuous optimization problems and discrete optimization problems is given.

Particle swarm optimization(PSO),exploitation ability,optimization performance,parameter selection

Manuscript November 18,2015;accepted March 26,2016

10.16383/j.aas.2016.c150774

Wang Dong-Feng,Meng Li.Performance analysis and parameter selection of PSO algorithms.Acta Automatica Sinica,2016,42(10):1552-1561

2015-11-18录用日期2016-03-26

国家自然科学基金(61203041),教育部高等学校博士学科点专项科研基金(20120036120013),中央高校基本科研基金(20140139)资助

Supported by National Natural Science Foundation of China(61203041),Specialized Research Fund for the Doctoral Program of Higher Education(20120036120013),and the Fundamental Research Funds for the Central Universities(20140139)

本文责任编委董海荣

Recommended by Associate Editor DONG Hai-Rong

1.华北电力大学自动化系保定071003

1.Department of Automation,North China Electric Power University,Baoding 071003