内容中心网络中能效感知的概率性缓存机制

2016-08-30安莹王建新刘耀中南大学信息科学与工程学院长沙410083中南大学信息安全与大数据研究院长沙410083湖南警察学院信息技术系长沙410138湖南商学院计算机与信息工程学院长沙410205

罗 熹 安莹 王建新 刘耀(中南大学信息科学与工程学院长沙410083)(中南大学信息安全与大数据研究院长沙410083)(湖南警察学院信息技术系长沙410138)(湖南商学院计算机与信息工程学院长沙410205)

论文

内容中心网络中能效感知的概率性缓存机制

罗熹①③安莹*②王建新①刘耀④①

①(中南大学信息科学与工程学院长沙410083)

②(中南大学信息安全与大数据研究院长沙410083)

③(湖南警察学院信息技术系长沙410138)

④(湖南商学院计算机与信息工程学院长沙410205)

内置缓存技术是内容中心网络(Content Centric Networking,CCN)的核心技术之一。现有的研究大多主要针对网络资源利用率的优化,而忽略了网络能耗的问题。该文首先建立了一个能耗模型对CCN的网络能耗进行分析,并设计了一个能效判决条件来优化缓存过程的能效性。进而,在此基础上综合考虑内容流行度和节点中心性等因素提出一种能效感知的概率性缓存机制(E2APC)。仿真结果表明,该机制能在保证较高的缓存命中率和较小的平均响应跳数的同时有效地降低网络的整体能耗。

内容中心网络;能效性;内置缓存;概率性缓存

近年来,研究人员已经对CCN的缓存机制开展了大量的工作。如文献[3]提出了一种基于内容年龄的协作缓存机制,通过为流行度高且位于网络边缘的内容设置更长的年龄来减小内容获取延迟和网络流量。但是该文假设网络拓扑和内容的流行度是已知的,而实际上这两种信息的获知并不容易。文献[4]在同质化缓存分配的基础上,提出一种基于替换率的缓存空间动态借调机制。该机制根据节点对缓存资源的需求程度,动态地将空余缓存分配给需求更大的节点,从而有效地提升网络的缓存性能。文献[5]综合考虑了路径上各节点的缓存容量以及内容的流行度来实现选择性的内容缓存,从而有效地实现缓存负载的合理均匀分布,缓解短期用户突发性访问对网络性能的负面影响。文献[6]则提出了一种分布式的协作缓存机制,该机制中每个节点将缓存空间划分为两部分以实现对不同流行度内容的区分处理,同时结合内容的访问频率和缓存副本数量来进行缓存决策。此外,文献[7]认为社会关系更广泛的节点在网络中更具影响力,其发布的内容被其他用户关注的可能性更大。因此,他们根据网络节点的社会关系提出一种社会感知的缓存策略,将影响力较大的节点生成的内容预先复制到与其社会邻居的最短路径上,从而加快用户响应速度并减少用户请求的数量。其他如文献[8-10],均从网络用户社会属性的角度来设计和优化CCN的缓存策略。

然而,现有的研究工作大多围绕优化网络资源利用率来设计CCN的缓存决策和替换策略,而对网络能效方面的关注还十分有限。据有关报告显示,当前Internet产生的能耗占世界总能耗的10%,同时这一比例仍在持续、快速地增长[11]。因此,网络的能耗成为了CCN缓存机制研究中一个不容忽视的重要问题。文献[12]从能耗的角度分析了不同缓存策略对CCN性能的影响,并对相关的一些开放性问题进行了讨论。文献[13]综合考虑了内容流行度随时间和空间变化的动态性以及网络资源的异质性,首先提出了一种基于整数线性规划的离线缓存放置策略,利用用户请求和网络资源的全局知识获得最大的效率收益;在此基础上又提出了一种在线分布式算法,网络节点根据可用的本地信息实现对全局能效的估计并做出相应的缓存决策。文献[14]将CCN缓存能效的最优化转化为一个最小化平均用户响应跳数的问题,并据此提出了一种基于时效流行度的能效缓存机制APC。文献[15]将CCN的缓存内容的放置问题形式化为一种非合作博弈,提出了一种基于能效的分布式缓存机制,各网络节点结合缓存能耗和传输能耗自主地作出内容的缓存决策。这些研究工作主要从降低内容缓存和获取过程中能耗的角度出发来实现CCN网络能效的优化,但是对节点和内容本身特性对内容获取延迟、缓存命中率以及资源利用率等网络性能的影响缺乏足够的考虑。

对于CCN的缓存决策来说,内容的缓存位置越靠近用户端,内容的获取延迟将越小;而另一方面,将内容缓存在更接近内容服务器的高层节点,产生的内容副本数量更少,则缓存能耗相应更小。因此,权衡缓存性能和网络能耗两方面的因素来设计CCN的缓存机制就显得尤为必要。本文提出一种新的分布式缓存机制(E2APC),综合了能效、内容流行度以及节点重要性等多种因素实现内容的缓存决策,在保证较小的能耗的同时获得较大网络性能增益,达到网络能效性与缓存服务质量之间的合理平衡。与现有的研究工作相比,本文的主要贡献如下:

(1)针对CCN内容获取过程的能效问题进行了建模分析,并设计了一个能效判决条件来降低网络的整体能耗。

(2)提出了一种能效感知的概率性缓存机制,在满足能效判决条件的前提下,利用用户请求的到达频率和新近性估计内容的流行度,并结合节点本身的介数中心性实现内容副本的概率性缓存,从而达到网络能效性和缓存性能的有效均衡。

2 系统模型

2.1网络模型

2.2能耗模型

下面我们来对CCN网络的能耗进行建模分析。CCN网络的能耗主要来自对内容的缓存和传输,因此,CCN网络的总能耗Etot也主要包括两部分:缓存能耗Ec以及传输能耗Et,即对于任意路由节点vi以及内容对象Ok,令sk表示内容Ok的大小,表示观察时间t内节点vi处收到的关于Ok的请求次数。同时我们定义为路由节点缓存内容的功率密度(即缓存单位比特数据所消耗的能量),rω表示每个路由节点的功率密度,1ω表示每条链路的功率密度。利用文献[14]中的能耗模型,节点vi缓存内容Ok的缓存能耗可表示为

对于任意请求用户节点vj,令hij表示节点vi到vj的距离(跳数),则内容Ok从节点vi返回到vj的传输能耗可表示为

因此,节点vi缓存和传输内容Ok的总能耗为

通常,由于缓存机制的作用,用户请求大多通过中间缓存节点提供响应,而对OCS的直接访问频率相对较低,因此,为了简化分析过程,这里我们不考虑OCS上的能耗。那么,用户vj直接从OCS获取内容Ok的总能耗totE′则由内容返回路径上链路和各中间节点的传输能耗构成。若内容Ok的OCS与其请求用户节点vj的距离为hsj,则可表示为

3 E2APC缓存机制

CCN内置缓存技术的目的是利用网络中间节点的缓存能力来加快对未来潜在用户访问的响应速度,提升整体的网络性能。这不可避免地导致了缓存空间需求和缓存能耗的增加。因此,在设计缓存机制时,应该将二者结合起来实现网络性能和缓存能效的有效均衡。E2APC机制主要包括两部分:一方面利用上面的能耗模型确定内容缓存决策的能耗判决条件,优化内容缓存过程的能效性;另一方面,通过内容的流行度以及节点的中心性实现缓存节点的概率性选择,进一步来保证网络系统的缓存性能。下面具体介绍E2APC机制的基本原理。

3.1能效判决条件

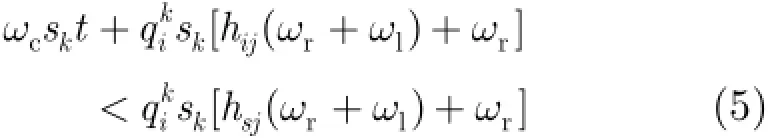

CCN通过内容缓存实际上是缩短了今后用户到内容对象的访问距离。从能耗的角度上看,是以缓存资源和能量消耗为代价降低未来用户获取内容所需的传输能耗和响应延迟。若要使得某个中间节点vi对内容Ok的缓存达到降低内容获取总能耗的目的,就要求若vi成为新的缓存节点,那么未来用户从vi获取内容的传输能耗与存储内容的缓存能耗之和totE应小于用户直接从OCS获取内容的总能耗根据2.2节中的能耗模型,有

化简后可以得到:

根据各变量的物理意义,不等式(6)的左边即为节点vi处收到的关于Ok的请求频率,可用表示;而不等式右边,hsj-hij即为内容服务器与中间节点vi的距离,用hsi表示。ωc, ωr和ω1均是与硬件有关的常量参数。文中我们仅考虑缓存设备为DRAM,传输链路采用波分多路复用时的情况,其取值参照文献[14]如表1所示。这样,不等式(6)可表示为

E2APC机制中,我们在每个内容分组头部增加一个跳数字段hops,当用户请求在某个节点发生命中时,该节点生成指定的内容分组,并将其hops字段值置0。在该内容分组沿着用户请求的反向路径传播的过程中,其hops字段值逐跳加1。这样,节点可以从收到的内容分组中读取hops的值从而得到该内容的响应服务器到当前节点的距离。因此,我们将式(7)作为能耗判定条件,在进行缓存决策时,节点统计当前指定内容的请求频率以及自己与内容源节点间的距离,若不满足条件,则不对内容进行缓存。

3.2概率性内容缓存

如果上节的能耗判定条件成立,则表示当前节点作为内容的缓存节点将能降低下次获取该内容的总能耗。那么,我们再进一步结合节点和内容相关的属性实现内容的概率性缓存。

从内容的角度考虑,内容的流行度越高表示对其感兴趣的用户越多,下次被访问的可能性越大。因此,缓存决策时,节点应选择流行度更高的内容进行缓存。在已有的相关研究工作中,大多假设内容的流行度为一个预先确定的属性,然而,实际上用户对内容的感兴趣程度是随时间变化的,而这种变化也导致内容的流行度出现相应的变化。因此,在E2APC机制中,我们采用了文献[16]中的方法,每个节点利用内容请求在本地的到达频率和新近性来估计各内容的流行度,具体估算方法如式(8):

这里,Pk表示内容Ok在当前节点的流行度估计值。表示当前时间,tj表示在过去的时间里Ok的第j个请求的到达时间。λ为调节参数且满足用于权衡内容的访问频次和新近性。根据文献[16]中的分析结果,本文中λ的值取为e-4。内容在当前节点处的流行度估值越高,则其被节点缓存的概率越大。

从节点本身的角度来看,网络中中心性较高的节点通常具有更强的连接其他节点的能力,它们收到来自不同节点请求的机会更多。将内容缓存在高中心性节点上,发生缓存命中的概率将会更高,同时响应速度也更快。因此,我们选择自我中心网络(ego network)的介数中心性作为概率性缓存决策的另一依据。介数中心性越大的节点,成为内容的缓存节点的概率也就越大。于是,当内容Ok到达节点vi时,我们再根据vi估算的Ok的流行度Pk以及vi的介数中心性值确定vi缓存Oi的概率pc(k),计算方法如式(9),

其中,θ为权重系数,用来调节内容流行度和节点介数中心性对缓存概率的影响程度。本文中,θ取值为0.5。Pmax表示节点vk上缓存内容的流行度最大值。Bi表示节点vi的介数中心性值,Bmax则表示内容Ok返回路径上节点的最大介数中心性值。由于CCN中,内容分组是通过其请求分组的反向传播路径返回用户端的。因此,我们记录内容请求分组传输路径上节点的最大介数值,当发生缓存命中时,命中节点再将该介数最大值写入相应的内容分组。这样,内容返回路径上的各个节点即可从收到的内容分组中得到相应的Bmax值。

3.3算法描述

E2APC算法的执行过程简单描述如下。

步骤1若内容Ok到达节点vi,vi首先从Ok的内容分组中读取内容服务器到当前位置的跳数hsi以及Bmax值;

步骤2若vi统计的Ok的请求到达频率满足如式(7)所示的能耗判决条件则继续执行步骤3;否则,vi不对Ok进行缓存,直接转发到下一跳;

步骤3 vi根据公式(9)以概率pc(k)缓存内容Ok;

步骤4若vi成为Ok新的缓存节点,则复制一份内容Ok的副本缓存在vi上,并将其跳数字段hops以及最大介数值清零;同时,将接收到的Ok原始内容分组中的跳数字段重置为0(记录的最大介数值不变),然后继续向下一跳节点转发。

4 性能评估

本文选择了处处缓存的LCE[2]以及基于时效流行度的能效缓存机制APC[14]作为E2APC的比较对象,并利用ndnSIM[17]模拟器对算法进行仿真和性能分析。实验中,我们采用GT-ITM下的Transit-Stub模型构建了一个由210个路由节点构成的网络,其中包含第1层Transit域9个,每个第1层Transit域又连接2个第2层Transit域,每个第2层Transit域连接2个Stub域。每个域(Transit域或Stub域)均包含10个节点,仿真拓扑示意图如图1所示。同时,我们假设用户请求的到达过程服从λ=50的泊松分布,用户的访问模式服从参数为α的Zip f分布。各路由节点缓存容量相同,且初始状态下节点缓存为空。内容大小均为1MB,请求分组采用洪泛方式进行转发,默认缓存替换策略为LRU,其他的主要实验参数如表1所示。

图1 仿真实验网络拓扑示意图

表1 实验参数设置

仿真过程中,我们通过分别改变节点缓存容量、网络中的内容个数以及Zipf参数α等网络参数的大小,来观察不同参数对网络性能的影响。本文采用的主要性能指标包括:

(1)缓存命中率:用户请求由缓存而非原始内容服务器响应的概率。

(2)平均响应跳数:内容响应分组从原始内容服务器或内容缓存节点返回用户请求节点所需的平均跳数。

(3)节能率:某种内置缓存机制的节能率定义为:与无内容缓存机制下的网络总能耗相比,采用该缓存机制节省的能耗所占的比例。

4.1缓存大小的影响

本节首先研究不同缓存机制下节点缓存大小变化对主要网络性能的影响。图2(a)反映了缓存命中率随缓存大小变化的情况。由于缓存空间的增长,节点能够缓存的内容数量增加,同时缓存替换频率降低,因此,3种缓存机制的缓存命中率均随着节点缓存空间的增大而逐渐提升。其中,由于LCE缺乏对缓存内容以及缓存位置的合理选择,因此缓存命中率最低。而E2APC综合考虑了内容以及节点相关的多种关键因素,使得节点的缓存决策更加合理,从而获得了三者中最高的缓存命中率。在节点缓存为5 MB时,E2APC的缓存命中率仍然到达了22.4%,相比LCE(3.4%)和APC(13.5%)分别高出了约558.82%和65.93%。

图2(b)给出了平均响应跳数随节点缓存变化的情况。由图易见,随着缓存空间的增大,通过缓存节点响应用户请求的机会增多,大大缩短了用户获取内容的跳数距离,因此,图中3种缓存机制的平均响应跳数均随节点缓存的增加而出现下降趋势。其中,APC对内容流行度及其时效性的考虑,提高了缓存决策过程的有效性,显著地降低了内容获取的平均跳数。因此,APC的平均响应跳数明显低于LCE。以节点缓存为100MB时为例,其平均响应跳数为7.42,比LCE(9.69)低了近23.4%。E2APC在缓存决策过程中,利用能效判决条件将内容的缓存位置限制在靠近用户节点的一侧,同时结合内容流行度和节点中心性实现了内容的概率性缓存,使缓存副本不断趋近用户端,因此获得了三者中最低的平均响应跳数。在节点缓存从5MB增加到1000MB的过程中,其平均响应跳数较之APC平均降低了近14.54%。

最后,与不进行内容缓存相比,3种缓存机制的节能率随节点缓存的变化如图2(c)所示。随着节点缓存的增加,用户请求通过距离更近的缓存节点得到响应的机会大大增加,这导致查找和返回请求内容所需的能耗明显降低。因此,3种缓存机制的节能率均随着缓存大小的增加而逐渐增大。其中,LCE由于对经过节点的每个内容都进行缓存,过多的冗余缓存和内容替换必然导致额外的能量开销,因此节能率最低。而E2APC通过能效判决条件降低了内容访问的总能耗,优化了缓存决策过程的能效性,因此获得了三者中最高的节能率。如图所示,在缓存大小为1000 MB时,E2APC的节能率达到了62.3%,相比APC(55.6%)和LCE(30.1%)分别提高了约12.1%和107.0%。

4.2内容数量的影响

接下来,分析内容数量对不同缓存机制主要性能的影响。在节点缓存一定的情况下,网络中内容对象的数量一定程度上就是网络资源稀缺程度的反映。随着内容数量的增加,相对于内容的缓存需求,节点的缓存能力越发的不足。这样,缓存内容的替换频率相应增加,内容的缓存时间相对缩短,从而导致内容缓存在减小后续用户请求的响应距离和整体能耗、提高缓存命中机会方面的作用逐渐减弱。因此,从图3我们可以看到,在内容数量从100个逐渐增加到5000个的过程中,3种缓存机制的节能率和缓存命中率曲线均出现明显的下降,而平均响应跳数则不断增加。其中,E2APC和APC的各项性能均远远优于LCE,这主要得益于它们对缓存内容和缓存节点的合理选择,避免了LCE相对激进的缓存策略所导致的缓存冗余和额外开销过大的问题。而由于E2APC利用用户请求的到达频率和新近性对内容流行度更准确的估计,以及基于节点介数的缓存节点选择,使其能够有效地将用户请求更频繁的流行内容缓存在合适的位置,因此,获得了最高的缓存命中率和最小的平均响应跳数。如图3(a)和图3(b)所示,在内容数量为2000个的情况下,E2APC的缓存命中率达到57.8%,比APC(43.7%)高出近32.3%,而平均响应跳数仅为6.54跳,比APC减少了约11.86%。再加上根据能耗模型对系统能效的优化,E2APC使得系统的整体能耗大大降低,从图3(c)的结果可以看出,其节能率明显优于其他两种缓存机制。以2000个内容时的情况为例,E2APC获得了43.6%的节能率,比APC和LCE分别高出约25.3%和177.7%。

图2 节点缓存对网络性能的影响

图3 内容数量对网络性能的影响

4.3用户访问模式的影响

目前,现有的研究普遍认为用户对内容的访问存在一定的偏好性,并且这种偏好服从Zipf分布。在不同的网络应用中,用户偏好的分布参数α是存在差异的。α值越大,则表示用户对内容的偏好越集中,反之亦然。因此,本节通过改变Zipf参数α的大小来比较3种缓存机制在不同网络应用环境下的性能表现,结果如图4所示。

当α取值较小时,用户对内容的请求相对分散。在节点缓存有限的情况下,多样化的内容请求和内容缓存导致频繁的缓存替换更新。过短的缓存时间使得内容缓存无法产生明显的积极作用,因此,3种缓存机制的缓存命中率和节能率均较低,平均响应跳数较高。随着α值的增加,用户请求的偏好越发集中于高流行度的内容,流行资源在缓存中的驻留时间延长,响应用户请求的概率增大,因此,缓存命中率和节能率显著提高而平均响应跳数则逐步减小。如图4(a)所示,由于E2APC和APC在缓存决策时均通过对内容流行度的估计来保证流行内容获得优先的缓存服务,因此其缓存命中率远远高于LCE。以1α=时的情况为例,LCE的缓存命中率仅为43.2%,而APC则达到了57.6%,E2APC更是获得了三者中最高的69.5%的缓存命中。此外,图4(b)中E2APC的平均响应跳数也明显低于其他两种缓存机制,1α=时其平均响应跳数仅为5.43,而APC和LCE则分别达到6.37和8.21。得益于E2APC较高的缓存命中率和较小的平均响应跳数,其同样获得了三者中最佳的能耗性能。由图4(c)可见,在1α=时,E2APC的节能率达到61.6%,比APC和LCE分别高出近21.0%和124.0%。

5 结束语

为了在保证CCN缓存性能的同时提高缓存系统的能效性,本文提出了一种能效感知的概率缓存机制E2APC。该机制通过对CCN网络能耗的分析,设计了一个缓存能效判决条件来降低内容缓存和获取过程中的总能耗,同时,在此基础上结合内容流行度和节点重要性来进一步优化缓存内容和缓存节点的选择。仿真结果表明,E2APC能有效地降低网络能耗和平均响应跳数,并提升系统的缓存命中率。在后续的工作中,我们将考虑拓扑结构、带宽以及节点社会性等因素对缓存机制性能的影响,并尝试将E2APC扩展到移动网络环境以及其他类型的实际应用场景以进一步验证其有效性。

图4 用户访问模式对网络性能的影响

[1]XYLOMENOSG,VERVERIDISC N,SIRISV,et al.A survey of inform ation-centric networking research[J].IEEE Comm unications Surveys&Tutorials,2014,16(2):1024-1049. doi:10.1109/SURV.2013.070813.00063.

[2]JACOBSON V,SMETTERSD K,THORNTON J D,et al. Networking named content[J].Communications of the ACM,2012,55(1):117-124.doi:10.1145/1658939.1658941.

[3]M ING Z,XU M,and W ANG D.Age-based cooperative caching in information-centric network[C].Proceedings of the 23rd International Con ference on Com puter Communication and Networks(ICCCN),Shanghai,China,2014:1-8.doi: 10.1109/ICCCN.2014.6911725.

[4]葛国栋,郭云飞,兰巨龙,等.CCN中基于替换率的缓存空间动态借调机制[J].通信学报,2015,36(5):120-129. doi:10.11959/j.issn.1000-436x.2015115.

GE G D,GUO Y F,LAN J L,et al.Dynam ic cache size transfer scheme based on replacement rate in content centric networking[J].Journal of Communications,2015,36(5): 120-129.doi:10.11959/j.issn.1000-436x.2015115.

[5]K IM D,LEE S W,KO Y B,et al.Cache capacity-aware content centric networking under flash crowds[J].Journal of Network and Computer Applications,2015,50:101-113.doi: 10.1016/j.jnca.2014.06.008.

[6]MAJD N E,M ISRA S,and TOURANI R.Split-Cache:A holistic caching framework for imp roved network perform ance in w ireless ad hoc networks[C].Proceedings of IEEE Global Communications Conference(GLOBECOM),Austin,TX,USA,2014:137-142.doi:10.1109/GLOCOM. 2014.7036797.

[7]BERNARDINI C,SILVERSTON T,and FESTOR O. Socially-aw are caching strategy for content centric networking[C].Proceed ings of the 2014 IFIP Networking Conference,Trondheim,Norway,2014:1-9.doi:10.1109/ IFIPNetworking.2014.6857093.

[8]ZHANG N,GUAN J,XU C,et al.A dynam ic social content caching under user mobility pattern[C].Proceedings of the 10th International W ireless Comm un ications and M ob ile Com puting Con ference(IWCMC),N icosia,Cyprus,2014: 1136-1141.doi:10.1109/IWCMC.2014.6906514.

[9]IQBAL J and GIACCONE P.Interest-based cooperative caching in mu lti-hop w ireless networks[C].Proceedings of IEEE Global Communications Conference(GLOBECOM),A tlanta,GA,USA,2013:617-622.doi:10.1109/ GLOCOMW.2013.6825056.

[10]葛国栋,郭云飞,刘彩霞,等.命名数据网络中基于局部请求相似性的协作缓存路由机制[J].电子与信息学报,2015,37(2): 435-442.doi:10.11999/JEIT140246.

GE G D,GUO Y F,LIU C X,et al.Collaborative caching and routing scheme based on local request sim ilarity in nam ed data networking[J],Journal of Electronics& Inform ation Techno logy,2015,37(2):435-442.doi:10.11999/ JEIT140246.

[11]CHIARAVIGLIO L,MELLIA M,and NERI F.M inimizing ISP network energy cost:Formulation and solutions[J]. IEEE/ACM Transactions on Networking,2012,20(2): 463-476.doi:10.1109/TNET.2011.2161487.

[12]BRAUN T and TRINH T A.Energy E fficiency Issues in Information-centric Networking[M].Energy Efficiency in Large Scale Distributed System s.Berlin Heidelberg,Sp ringer,2013:271-278.doi:10.1007/978-3-642-40517-4_22.

[13]LLORCA J,TULINO A M,GUAN K,et al.Dynam ic in-network cach ing for energy efficient content delivery[C]. Proceedings of IEEE INFOCOM 2013.Tu rin,Italy,2013: 245-249.doi:10.1109/INFCOM.2013.6566772.

[14]LIJ,LIU B,and WU H.Energy-efficient in-network caching for content-centric networking[J].IEEE Communications Letters,2013,17(4):797-800.doi:10.1109/LCOMM.2013. 022213.122741.

[15]FANG C,YU F R,HUANG T,et al.An energy-efficient distributed in-network caching scheme for green content-centric networks[J].Computer Networks,2015,78: 119-129.doi:10.1016/j.comnet.2014.09.017.

[16]LE T,LU Y,and GERLA M.Social caching and content retrieval in D isruption Tolerant Networks(DTNs)[C]. Proceedings of the IEEE 2015 International Conference on Com puting,Networking and Communications(ICNC),Garden Grove,CA,USA,2015:905-910.doi:10.1109/ ICCNC.2015.7069467.

[17]MASTORAKIS S,AFANASYEV A,MOISEENKO I,et al. ndnSIM 2.0:A new version of the NDN simulator for NS-3[R]. Technical Report NDN-0028,2015.

罗熹:女,1980年生,博士生,研究方向为新型网络体系结构设计、内容中心网络.

安莹:男,1980年生,讲师,博士后,研究方向为新型网络体系结构设计、内容中心网络、延迟容忍网络等.

王建新:男,1969年生,教授,博士生导师,研究方向为网络优化理论、参数计算理论、生物信息学等.

刘耀:男,1976年生,讲师,博士,研究方向为延迟容忍网络、社会网络等.

Energy-efficiency Aware Probabilistic Caching Scheme for Content-centric Networks

LUO X i①③AN Y ing②W ANG Jianxin①LIU Yao④

①(School of Information Science and Engineering,Central South University,Changsha 410083,China)

②(Institute of Information Security&Big Data,Central South University,Changsha 410083,China)

③(Department of Information Technology,Hunan Police Academy,Changsha 410138,China)

④(School ofComputer and Information Engineering,Hunan University ofCommerce,Changsha 410205,China)

In-network caching is one of the key technologies of Content-Centric Networking(CCN),which isw idely concerned recently.However,m ost existing works are targeted for op tim izing network resource utilization,and the energy consum p tion aspect is largely ignored.In this paper,first an energy consum p tion m odel for content distribution is built and a judging condition for energy efficiency optim ization in caching is designed.On this basis and in combination with content popularity and node centrality,an Energy-Efficiency Aware Probabilistic Caching(E2APC)scheme is p roposed.Simu lation results show that the proposed scheme can effectively reduce the whole energy consump tion,while guaranteeing com paratively high cache hit rate and few average response hops.

Content-Centric Networking(CCN);Energy efficiency;In-network caching;Probabilistic caching

1 引言

互联网技术高速发展的今天,新型网络应用层出不穷,信息服务的“内容化”、“个性化”成为了当前网络发展的主要趋势[1]。然而,传统的基于主机的Internet体系架构缺乏对面向内容的分发获取服务的原生支持,因此无法适应网络用户日益增长的数据内容访问需求。近年来,内容中心网络(Content-Centric Networking)[2]架构作为一种潜在的解决方案受到了国内外相关学者的极大关注。它采用内容数据的名称来完成对内容的标识、路由以及获取,从而实现了内容和物理位置的解耦。同时,为了缓解网络流量的快速增长对网络带宽造成的严峻压力,CCN网络架构中普遍采用了泛在化的网络内置缓存技术。它要求每个网络节点都具备缓存内容的能力,从而覆盖全网的缓存使得网络作为内容传输体的同时也成为了内容的存储体。然而,泛在缓存机制在提升了网络的内容分发获取性能的同时,也可能产生过大的缓存冗余而导致网络资源利用率和能效降低的问题。

s:The National Natural Science Foundation of China(61402541,61103204),The Scientific Research Fund of Hunan Provincial Education Departm ent(15B127)

TP393

A

1009-5896(2016)08-1843-07

10.11999/JEIT 151244

2015-11-05;改回日期:2016-04-13;网络出版:2016-05-25

安莹anying@csu.edu.cn

国家自然科学基金(61402541,61103204),湖南省教育厅科学研究项目(15B 127)