基于运动和空间方向一致性的视频显著性检测

2016-08-05陈耀武

韩 冬 田 翔 陈耀武

(浙江大学数字技术与仪器研究所 浙江 杭州 310027) (浙江省网络多媒体技术重点实验室 浙江 杭州 310027)

基于运动和空间方向一致性的视频显著性检测

韩冬田翔陈耀武

(浙江大学数字技术与仪器研究所浙江 杭州 310027) (浙江省网络多媒体技术重点实验室浙江 杭州 310027)

摘要根据人眼的视觉特点,提出一种基于对比运动和空间方向一致性的算法,用来检测视频序列的显著性区域。在该算法中,首先针对每一帧图像利用sobel算子计算其水平梯度、垂直梯度,然后用光流法计算运动矢量;接着构建三维张量结构,得到每个像素点与周围点的水平、垂直梯度和运动矢量一致性,并对比每个像素点与周边点的一致性;最后把对比结果转化为视频显著图。将该方法与已经存在的方法进行比较,实验结果表明,该方法可以很好地排除背景纹理区域的运动所带来的影响,能够准确地检测出各种运动场景的显著性区域。

关键词视频显著性空间方向梯度运动矢量三维张量结构一致性对比

0引言

视频显著性与人体视觉系统密切相关。它使得人们能够在一个视频场景中快速地找到所关注的区域,有助于我们对视频图像的理解,可以用于感兴趣区域检测、目标分割、识别与跟踪等[1]。目前,视频显著性分析已经成为了图像处理和计算机视觉领域的一个重要研究课题。

在过去的十几年里,研究者发明了许多应用于静止图像的显著性检测算法。Itti等人[2]于1998年提出了一种基于多尺度图像特征融合的显著性检测方法。Harel等人[3]于2006年提出了一种基于图的抖动的自底向上的视觉显著性模型。2007年Hou等人[4]通过计算傅里叶谱残差,得到了显著性图。2009年Achanta等人[5]结合颜色与亮度等信息来进行显著性检测。Cheng等人[6]在2011年提出了一种基于区域对比度的方法,利用直方图与空间信息得到了视频显著图。Perazzi等人[7]在2012年提出了一种基于对比的显著性模型,它抽取了图像的超像素成分,并通过对比其独特性和空间分布性来得到显著性图。

根据人体视觉系统的特性,人眼对正在运动的物体更加敏感,使得视频序列的显著性与静止图像的显著性有着一定的不同。对于视频序列来说,一个好的显著性检测算法应该更加关注于正在运动的物体。最早的方法是通过混合高斯模型[8]来得到显著性图。它用多个高斯模型来表征图像中各个像素点,在每一帧图像更新高斯模型,通过像素点与模型匹配得到视频显著图。Zhai等人[9]提出了一种基于时空信息的显著性检测方法。它通过图像的颜色距离差来计算空域显著性,通过SIFT点对来计算时域显著性,并将二者动态融合成为最后的视频显著图。Guo等人[10]计算每个像素点的灰度、颜色和运动特征,组成四元组,通过四维傅里叶变换的相位谱来得到视频显著图。Fang等人[11]于2014年提出了一种融合时空信息与统计学不确定性的显著性检测方法。它首先提取运动特征进行时间显著性评估,提取光照、颜色和纹理特征进行空间显著性评估;然后分别进行时间、空间不确定性评估;最终将时空的显著性、不确定性进行加权融合得到视频显著图。

本文提出一种基于对比运动和空间方向一致性的算法,计算每一帧图像的水平梯度、垂直梯度和运动矢量,并将每个像素点与周围像素点进行对比,把对比图转换成为视频显著图。实验表明,该算法能够很好地克服背景纹理区域的运动所带来的影响,准确地检测出各种运动场景的显著性区域。

1显著性检测

本文中视频显著性检测算法分为以下四个步骤:光流法计算运动矢量;利用Sobel算子计算图像水平、垂直梯度;利用三维结构张量模型计算每个像素点与周围像素点的水平、垂直梯度与运动矢量的一致性;通过对比一致性获得视频显著图。算法框架如图1所示。

图1 算法流程图

1.1计算运动矢量与空间梯度

通过光流法[12]计算输入视频每帧图像的运动矢量矩阵MVx、MVy,得到的运动矢量场与输入视频有着相同的分辨率。其中MVx表示水平方向运动矢量矩阵,MVy表示垂直方向运动矢量矩阵。计算运动矢量幅值,得到幅值矩阵,如式(1)所示:

(1)

为了方便后续处理,将运动矢量矩阵归一化,得到归一化后的运动矢量矩阵gt,如式(2)所示:

(2)

利用sobel算子[13]对输入视频灰度图像进行掩膜滤波,得到与输入视频有着相同分辨率的水平梯度矩阵gx和垂直梯度矩阵gy,同样进行归一化处理。用于水平、垂直滤波的sobel算子分别为:

(3)

(4)

1.2构建三维结构张量

基于Laptev等人[14]时空域中感兴趣区域点的特征的启发,对每一帧图像k中的每个像素点i,构建三维结构张量Sk(i),用来表示视频图像中的点在时空域的特征,如式(5)所示:

(5)

本文中使用三维结构张量矩阵Sk(i)的原因是:计算矩阵Sk(i)的最大特征值λ1和另外2个特征值λ2、λ3的差值,其差值可以表示局部区域中的像素点沿着三维时空方向(三个坐标轴分别为空间水平梯度、空间垂直梯度、运动矢量)分布的密集程度。差值越大,表示密集程度就越大,时空方向的一致性就越高。

因此,如式(6)所示,我们定义每个像素点的时空方向一致性c为:

c=(λ1-(λ2+λ3))2

(6)

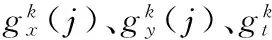

如图2所示,在输入视频灰度图像中选取两个矩形区域,船代表显著性运动区域,水波代表非显著性干扰区域。

图2 coastguard视频中选取的船和背景水波矩形区域

将所选取的两个矩形区域中各个点绘制在三维时空方向图中,三个坐标轴分别为空间水平梯度、空间垂直梯度、运动矢量。如图3所示,在显著性运动区域(船)中的像素点密集程度高,时空域方向的一致性高,而非显著性干扰区域(水波)像素点密集程度低,一致性低。

图3 船和背景水波中的点的分布以及一致性c的值

1.3一致性对比

为了减少背景局部区域动态变化带来的噪声,体现出局部区域的一致性,我们将每个像素点的时空域方向一致性与其周围像素点进行对比,得到对比值:

其中ck(i)、ck(j)分别为第k帧像素点i、j的时空方向一致性,Wi为以像素点i为中心的图像矩阵,在本文中取7×7矩阵。计算可得,图2中船的矩形区域V值为573.31,水波的矩形区域V值为145.38,二者的V值差异比一致性c差异更大一些。

2实验结果与分析

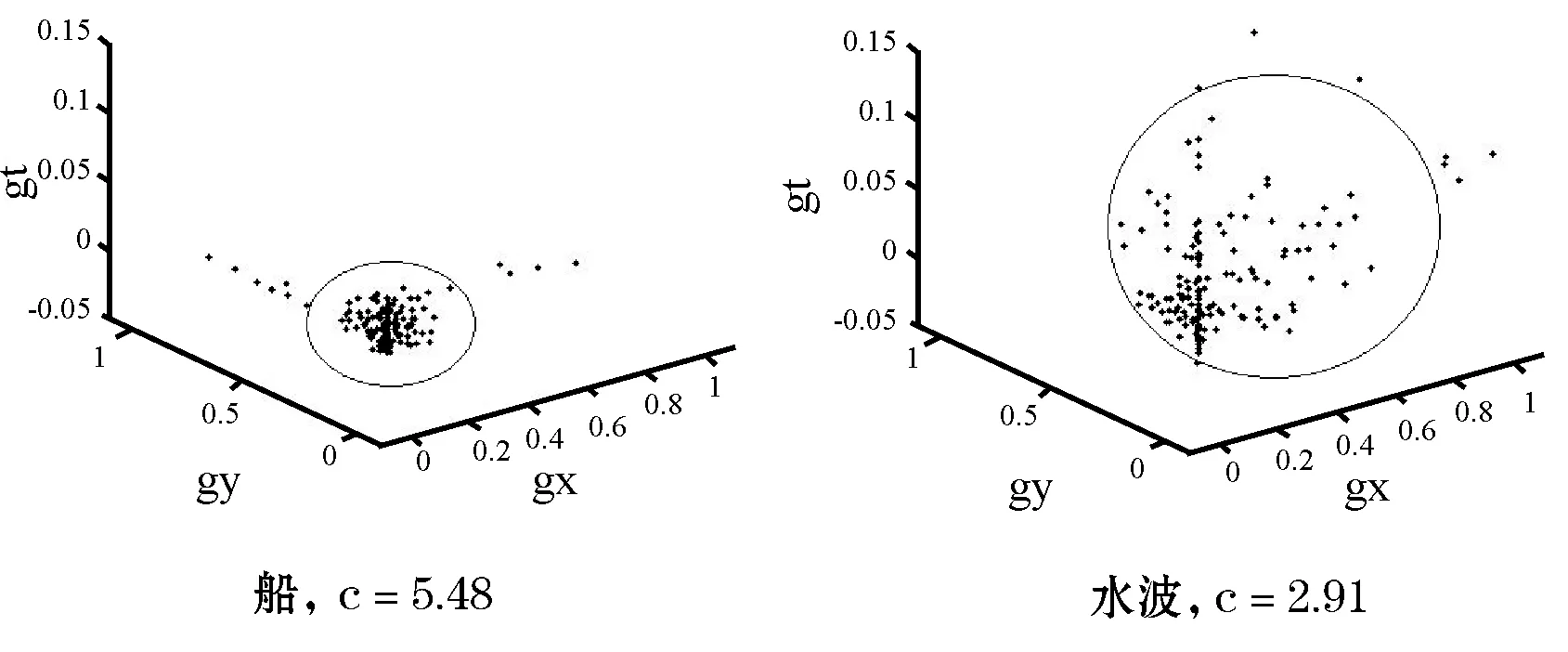

为了验证本文算法的有效性,将本文算法(MSC)与以下方法进行比较:基于谱残差的显著性模型(SR)[4]、基于空间区域对比度与颜色信息的显著性模型(RC)[6]、混合高斯模型(GMM)[8]。基于谱残差的显著性模型(SR)[4]是静态空间信息模型;基于空间区域对比度与颜色信息的显著性模型(RC)[6]是结合颜色信息的显著性模型;混合高斯模型(GMM)[8]是结合了时空信息的显著性模型。在本文实验中,选取5类不同场景的视频进行测试:(1)有单个运动的物体,背景不动,且背景包含大块平坦信息和纹理区域;(2)有2个运动的物体,背景不动,且背景纹理比较复杂;(3)有2个运动的物体,背景在运动,且背景纹理比较复杂;(4)有1个运动的物体,背景在运动,且背景纹理比较复杂;(5)镜头在运动,体现为背景在运动。实验结果如图4所示。

图4 实验结果

由图4可以看出,本文算法与其他方法相比,能够准确地检测出显著性区域,并能够很好地克服背景区域运动带来的影响。具体来看,由于背景纹理区域运动的影响,SR模型算法并不能很好地区分显著性运动的物体与背景;RC算法能够很好地区分颜色信息,但是对运动的物体并不敏感,也不能很好地将运动的物体分离出来;GMM算法结合了时间信息,相对SR和RC要好一些,能够检测出显著运动的物体,但是仍不能完全排除背景信息的干扰。这些算法并不能很好地排除背景区域运动带来的噪声,如水波和观众等。而本文算法结合了运动矢量和空间梯度,利用三维结构张量模型,对比运动与空间方向的一致性,能够很好地排除背景噪声。

为了更加直观地评价本文提出的方法,我们通过准确率(precision)、召回率(recall)、加权调和均值指标(F值)来比较本文算法与上述方法。其中准确率(precision)定义为检测到正确显著点的数目与检测到所有显著点的数目之比,召回率(recall)定义为检测到正确显著点的数目与实际显著点的数目之比。加权调和均值指标(F值)的定义如式(8)所示。

(8)

一般而言,准确率和召回率通常是矛盾的,所以采用F值来综合表示显著性检测结果。在本文中,与文献[6]相同,取λ2为0.3。检测结果如图5所示。我们可以看出,本文算法要好于其他方法。

图5 显著性检测结果

利用coastguard视频序列将本文算法的耗时与SR、RC、GMM算法进行比较,通过MATLAB 7.0计算各算法所耗时间。结果如图6所示。我们可以看出本文算法(MSC)比其他算法耗时都要长,这是因为针对每个像素点都要计算三维张量结构、三维矩阵特征值,并对比每个像素点与周围像素点的一致性,耗时较多。

图6 各算法耗时结果

3结语

本文提出了一种基于对比运动和空间梯度一致性的视频显著性检测算法。该算法首先用光流法计算运动矢量,接着计算每帧输入图像的水平、垂直梯度,通过构建三维张量结构,计算每个像素点水平梯度、垂直梯度和运动矢量三者与周围点的一致性,并通过对比一致性构建出显著性模型。实验结果表明,本文算法能够很好地排除背景纹理区域的运动带来的噪声,准确地检测出视频显著性区域,优于其他方法。本文算法中计算三维张量结构耗时比较多,如何改善该算法是后续的研究方向。

参考文献

[1] Liu T, Yuan Z, Sun J, et al. Learning to detect a salient object[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(2):353-367.

[2] Itti L, Koch C, Niebur E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(11):1254-1259.

[3] Harel J, Koch C, Perona P. Graph-based visual saliency[C]// Proceedings of Neural Information Processing Systems. Vancouver: MIT Press, 2006:545-552.

[4] Hou X, Zhang L. Saliency detection: a spectral residual approach[C]// IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis: IEEE, 2007:1-7.

[5] Achanta R, Estrada E, Wils P, et al. Salient region detection and segmentation[C]// International Conference in Computer Vision System. Santorini: Springer, 2008:66-75.

[6] Cheng M, Zhang G, Mitra N J, et al. Global contrast based salient region detection[C]// IEEE Conference on Computer Vision and Pattern Recognition. Colorado Springs: IEEE, 2011:409-416.

[7] Perazzi F, Krahenbuhl P, Pritch Y, et al. Saliency filters: contrast based filtering for salient region detection[C]// IEEE Conference on Computer Vision and Pattern Recognition. Providence: IEEE, 2012:733-740.

[8] Zivkovic Z. Improved adaptive Gaussian mixture model for background subtraction[C]// IEEE Conference on Pattern Recognition. Cambridge: IEEE, 2004:28-31.

[9] Zhai Y, Shan M. Visual attention detection in video sequences using spatiotemporal cues[C]// International Conference on Multimedia. Santa Barbara: ACM, 2006:815-824.

[10] Guo C, Ma Q, Zhang L. Spatiotemporal saliency detection using phase spectrum of quaternion Fourier transform[C]// IEEE Conference on Computer Vision and Pattern Recognition. Anchorage: IEEE, 2008:1-8.

[11] Fang Y, Wang Z, Lin W, et al. Video saliency incorporating spatiotemporal cues and uncertainty weighting[J]. IEEE Transaction on Image Processing, 2014, 23(9):3910-3921.

[12] Sun D, Roth S, Black M J. Secrets of optical flow estimation and their principles[C]// IEEE Conference on Computer Vision and Pattern Recognition. San Francisco: IEEE, 2010:2432-2439.

[13] Rafael C Gonzalez, Richard E Woods. 数字图像处理[M]. 阮秋琦,阮宇智,等译. 3版. 北京:电子工业出版社, 2011.

[14] Laptev I, Lindeberg T. On space-time interest points[J]. International Journal of Computer Vision, 2005, 64(2):107-123.

收稿日期:2015-02-10。浙江省重点科技创新团队项目(2011R0 9021)。韩冬,硕士生,主研领域:网络视频编解码。田翔,副教授。陈耀武,教授。

中图分类号TP391.4

文献标识码A

DOI:10.3969/j.issn.1000-386x.2016.07.037

VIDEO SALIENCY DETECTION BASED ON CONTRASTING COHERENCE OF MOTION AND SPATIAL DIRECTION

Han DongTian XiangChen Yaowu

(InstituteofAdvancedDigitalTechnologyandInstrumentation,ZhejiangUniversity,Hangzhou310027,Zhejiang,China) (ZhejiangProvincialKeyLaboratoryforNetworkMultimediaTechnologies,Hangzhou310027,Zhejiang,China)

AbstractAccording to the characteristics of human visual system (HVS), we proposed an algorithm to detect the salient region of video sequence, which is based on contrasting the coherence of motion and spatial direction. In this algorithm, it first uses Sobel operator to calculate the horizontal gradient and vertical gradient for each frame, and then calculates the motion vector by the method of optical flow. After that, it builds a 3D tensor structure to obtain the coherence of each pixel with its surrounding pixels in regard to the horizontal and vertical gradients and the motion vector, as well as contrasts the coherence of each pixel with its surrounding pixels. Finally it converts the contrasting results to video saliency map. Comparing this algorithm with existing methods, experimental result showed that it could well exclude the impact of motion in background texture region and accurately detect the salient regions of all kinds of motion scenes.

KeywordsVideo saliencySpatial directionGradientMotion vector3D tensor structureContrast of coherence